基于深度学习方法和RGB影像的玉米雄穗分割

2021-09-10余汛王哲景海涛金秀良聂臣巍白怡王铮

余汛,王哲,景海涛*,金秀良,聂臣巍,白怡,王铮

(1.河南理工大学测绘与国土信息工程学院,河南 焦作 454000;2.中国农业科学院作物科学研究所,北京 100081;3.成都理工大学能源学院,成都 610059)

玉米是全球三大粮食作物之一,玉米稳产是实现粮食安全的关键任务。玉米雄穗性状与产量密切相关,是玉米育种工作中重要的指标。因此,对玉米雄穗生长状况进行有效的监测,将有助于提高对优良品种的选育。目前,田间玉米雄穗生长状况的监测主要依靠人工,费时费力,并且会因人为因素而产生误差。随着遥感技术的迅速发展,高空间分辨率影像在大田条件下的玉米雄穗分割研究中得到了广泛应用[1-4]。但由于雄穗重叠、田间光照条件变化以及影像质量的差异,使得雄穗分割任务具有挑战性,难以扩展。

由于大型数据集的普及[5-6],在训练过程中特征提取的整合[7-8],以及计算机硬件性能的提升[9-10],深度学习方法在图像分割任务中展现出优越的性能。目前,深度学习方法已被广泛用于作物植株或器官的分割中。ZHANG 等[11]通过分割整个蓝莓果实的高光谱影像来量化蓝莓果实的擦伤情况。NI等[12]使用掩膜区域卷积神经网络(mask regions with convolutional neural network, Mask-RCNN)对蓝莓簇进行分割,并将结果映射到蓝莓簇的3 维图形中,实现了对蓝莓簇中蓝莓果实的分割。GE等[13]使用Mask-RCNN 模型在影像中分割草莓,然后利用深度相机定位水果。WU 等[14]先使用快速RCNN(Faster-RCNN)模型对苹果树进行检测定位,再使用U-Net 模型对苹果树冠层树干进行分割,从而提取出苹果树冠层信息。HUETHER 等[15]使用以Xception 网络为特征提取层的DeepLab V3+模型对实验室条件下的拟南芥进行分割,提取出拟南芥的表型信息。OH 等[16]使用不同的网络模型对高粱穗进行分割,并比较了不同深度学习模型对高粱穗的分割精度差异。在对玉米雄穗分割的研究中,LU等[4]提出了一种基于区域颜色建模的分割算法,包括融合超像素的区域生成和组合神经网络的颜色建模,实现了对雄穗的分割。由于在不同管理条件下,不同品种和不同发育阶段的玉米雄穗均存在一定差异,因此,这种方法在实际应用中还存在局限性。本文基于不同发育阶段和不同品种的玉米雄穗近地面高分辨率RGB影像,研究轻量级网络作为特征提取层的不同深度学习模型对玉米雄穗分割精度的差异,从而检验深度学习方法对不同品种玉米雄穗在不同生育时期的分割精度和稳定性。

1 材料与方法

1.1 试验场地

试验数据采集点位于河南省新乡市中国农业科学院试验基地(35°10′N,113°47′E)内。试验选用8 个不同的玉米品种:禾田1 号(HT1)、丰垦139(FK139)、京农科728(JNK728)、迪卡517(DK517)、郑单958(ZD958)、先玉335(XY335)、迪卡653(DK653)和泽玉8911(ZY8911)。每个品种分8 个播期播种,试验中仅使用6、7、8 号播期中的玉米穗图像,三者对应的播期分别为2019年6月13日、6月23 日和7 月3 日,每个品种的播种面积为162 m2(22.5 m×7.2 m),行距60 cm,株距22 cm,密度7.5万株/hm2。

1.2 影像获取及标注

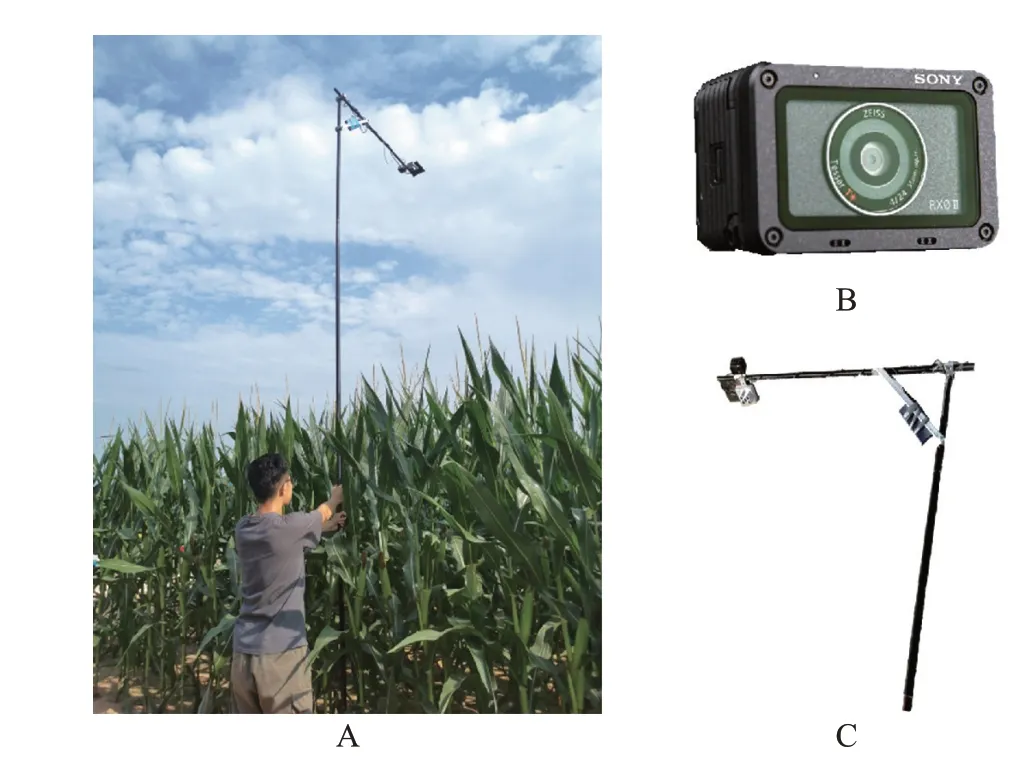

地面图像采集如图1所示。将相机固定在吊杆上,放置在距玉米穗冠层1.50 m 高处,相机焦距为24 mm(相当于35 mm等效焦距),设置为自动对焦,图像空间分辨率为0.52 mm。为保证采集到的图像具有代表性,在每个播期为每个玉米品种设置3 个固定的图像采集点,共72个小区。数据获取时间从雄穗抽穗开始到散粉结束,最终获得729 幅近地面图像,并对这些图像进行标注,命名为“全生育时期数据集”。

图1 地面图像采集场景及设备Fig.1 Ground image acquisition scene and equipment

1.3 数据处理

为了系统地研究深度学习方法对不同品种、不同生育时期玉米雄穗的分割精度,根据品种和生育时期建立不同的数据集(表1)。其中,未完全抽雄期(图2A)指处于完全抽雄状态的玉米雄穗占影像中所有玉米雄穗的比例少于50%,否则将影像划分为完全抽雄期数据集(图2B)。全生育时期数据集包括完全抽雄期数据集和未完全抽雄期数据集。最后,基于近地面RGB 影像,在全生育时期、完全抽雄期和未完全抽雄期数据集中分别标注了18 260、16 001和2 259个玉米雄穗。每个数据集按7∶3的比例分为训练集和验证集。利用训练集对模型进行训练,利用验证集检验模型的分割精度。为了研究语义分割模型对不同品种玉米雄穗的分割精度,在729 幅近地面影像中对8 个玉米品种的雄穗影像进行分类,建立了8 个品种数据集。使用Labelme软件对近地面影像中的玉米雄穗通过规则图形标注出来,命名为“tassel”,示例如图3所示。

图2 不同生育时期的影像划分示例Fig.2 Examples of image division of different growth stages

图3 使用Labelme软件对玉米雄穗的标注示例Fig.3 Examples of using the Labelme software to label image of maize tassel

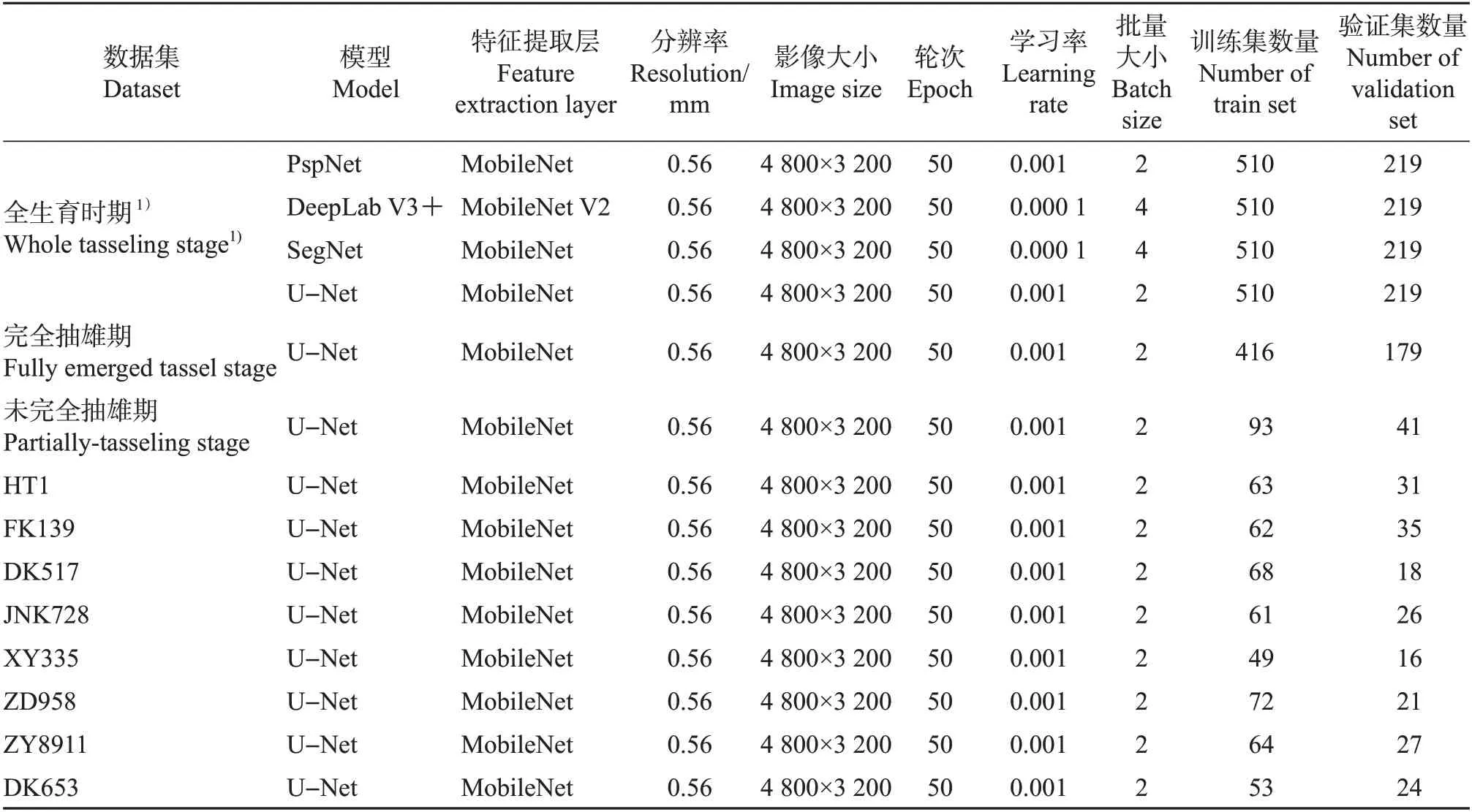

表1 本研究中使用的几个数据集的特征Table 1 Characteristics of the several datasets used in this study

1.4 分割方法

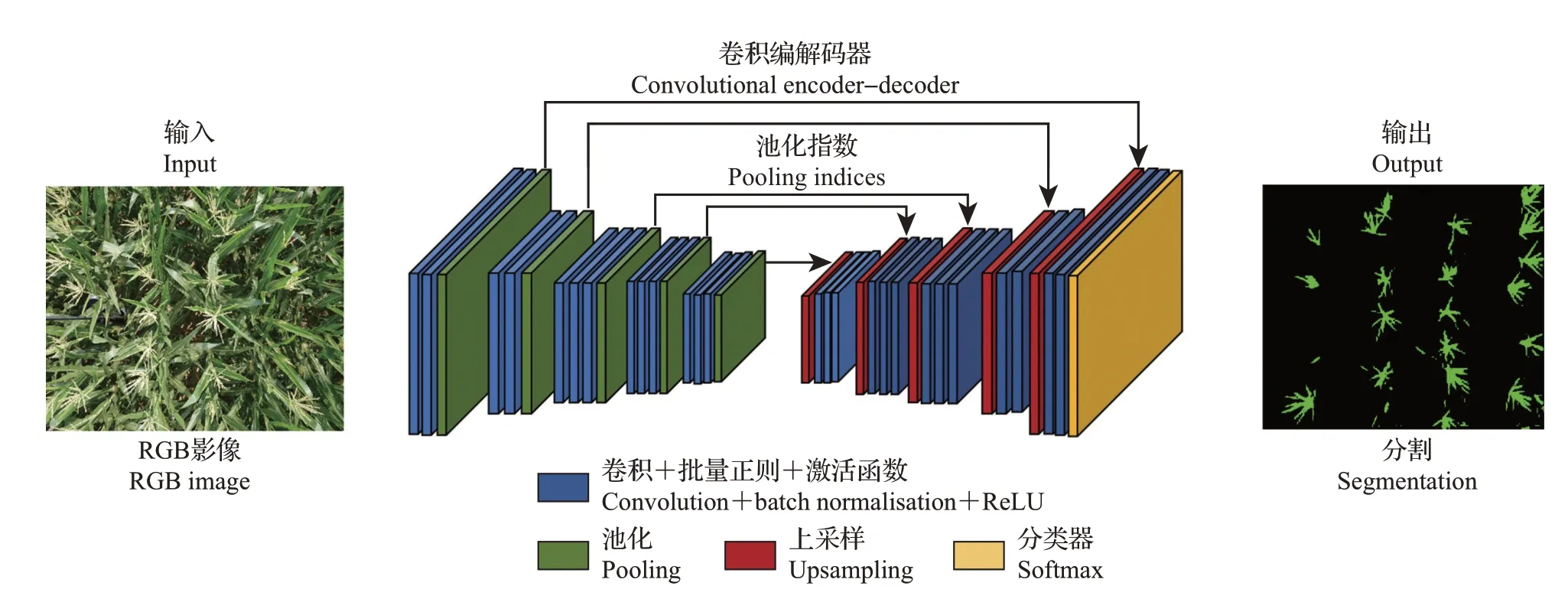

1.4.1 SegNet 模型

SegNet[17]模型的网络框架如图4所示:框架左边是卷积提取特征,通过池化(pooling)增大感受野,同时缩小图片的尺寸,该过程被称为编码(encoder);框架右边是反卷积(在这里卷积与反卷积没有区别)与上采样(upsampling),通过反卷积使得影像分类后的特征得以重现,并通过上采样(upsampling)还原到影像原始尺寸,该过程被称为解码(decoder);最后通过分类器(softmax)输出不同分类的最大值,得到最终分割图。

图4 SegNet模型的网络框架Fig.4 Network framework of SegNet model

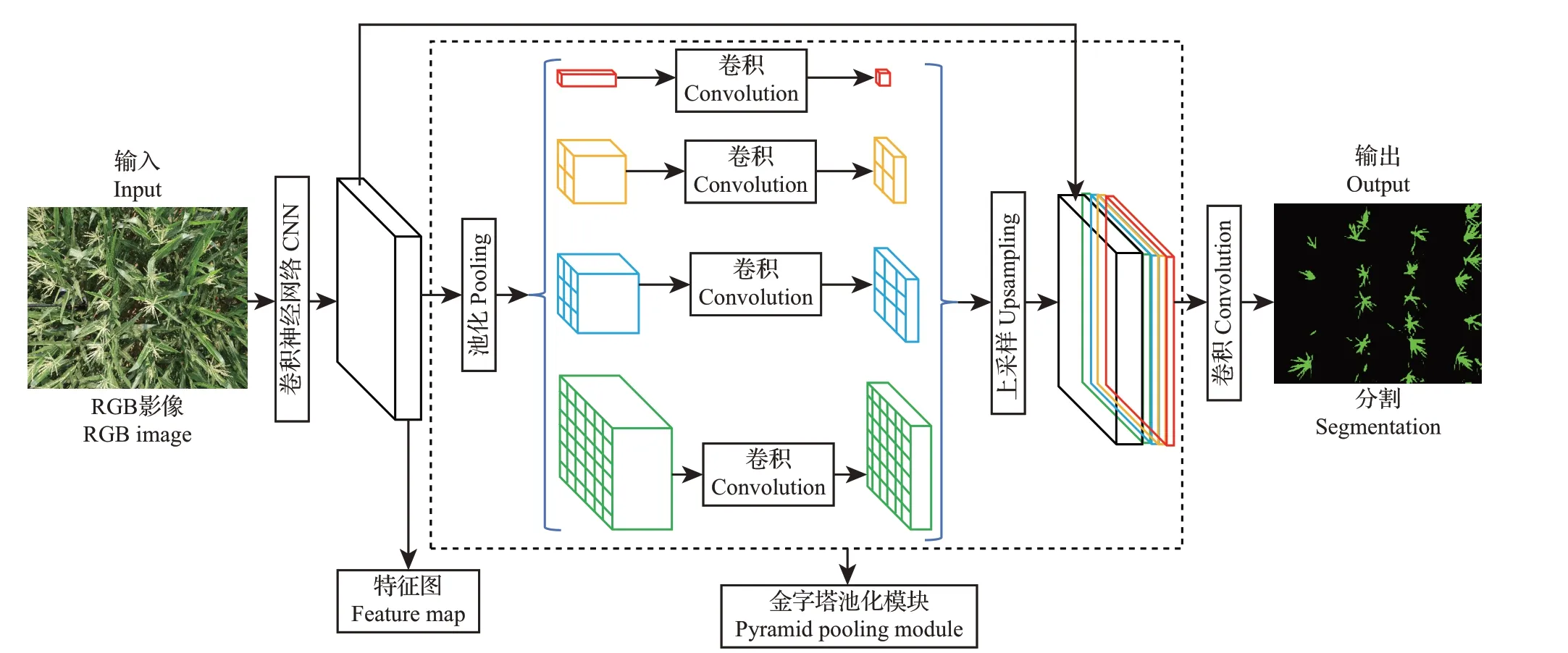

1.4.2 PspNet 模型

PspNet[18]模型的网络框架如图5 所示:影像输入后,使用卷积神经网络(convolutional neural net-works,CNN)提取特征图,经过池化(pooling)后,最终的特征映射大小是原始影像的1/8。红色方块代表在每个特征图上执行全局平均池的最粗略层次,用于生成单个bin 输出;橙色方块代表第2 层,将特征图划分为2×2 个子区域,然后对每个子区域进行平均池化;蓝色方块代表第3层,将特征图划分为3×3个子区域,然后对每个子区域进行平均池化;绿色代表第1 层,将特征图划分为6×6 个子区域的最细层次,然后对每个子区域执行池化。在金字塔池化模块(pyramid pooling module)部分,将之前的金字塔特征映射与原始特征映射连接起来而进行卷积,生成预测图。

图5 PspNet模型的网络框架Fig.5 Network framework of PspNet model

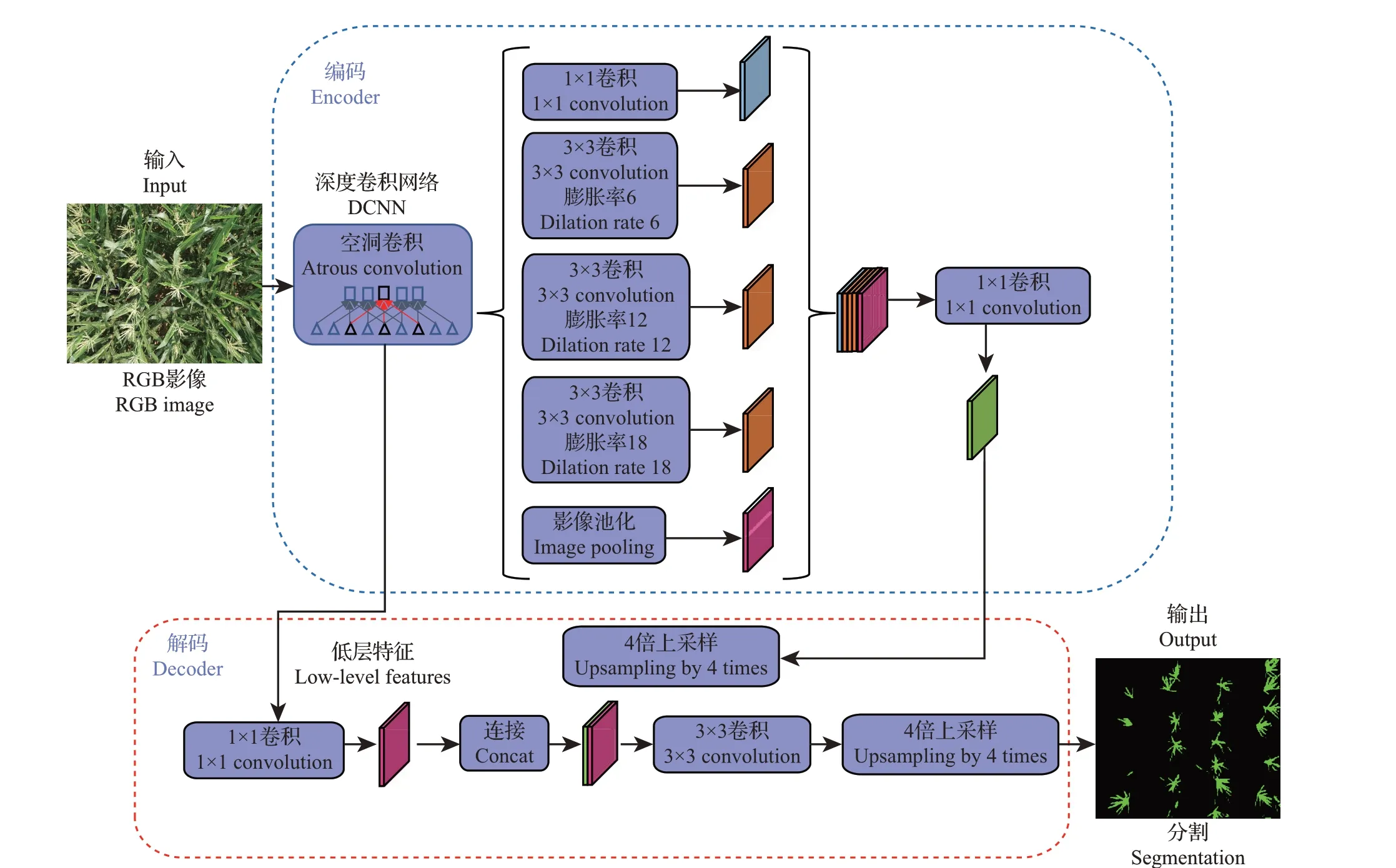

1.4.3 DeepLab V3+模型

DeepLab V3+[19]模型的网络框架如图6 所示。该网络采用了语义分割中常用的编码(encoder)-解码(decoder)形式。DeepLab V3+模型引入了空洞卷积,在不损失信息的情况下,让每个卷积输出都包含较大范围的信息,可以更有效地提取特征。DeepLab V3+具有以下2个特点:1)在主干深度卷积神经网络(deep convolutional neural networks,DCNN)里使用串行的空洞卷积(atrous convolution);2)将影像经过主干DCNN 之后的结果分为2 部分,一部分直接传入解码(decoder),另一部分经过空洞卷积,分别采用不同的膨胀率空洞卷积进行特征提取和合并,然后采用1×1的卷积压缩特征。其中,解码部分包含深度卷积网络输出的结果和深度卷积网络输出后经过空洞卷积的结果,最终经过双线性插值的上采样方法输出预测结果。

图6 DeepLab V3+模型的网络框架Fig.6 Network framework of DeepLab V3+model

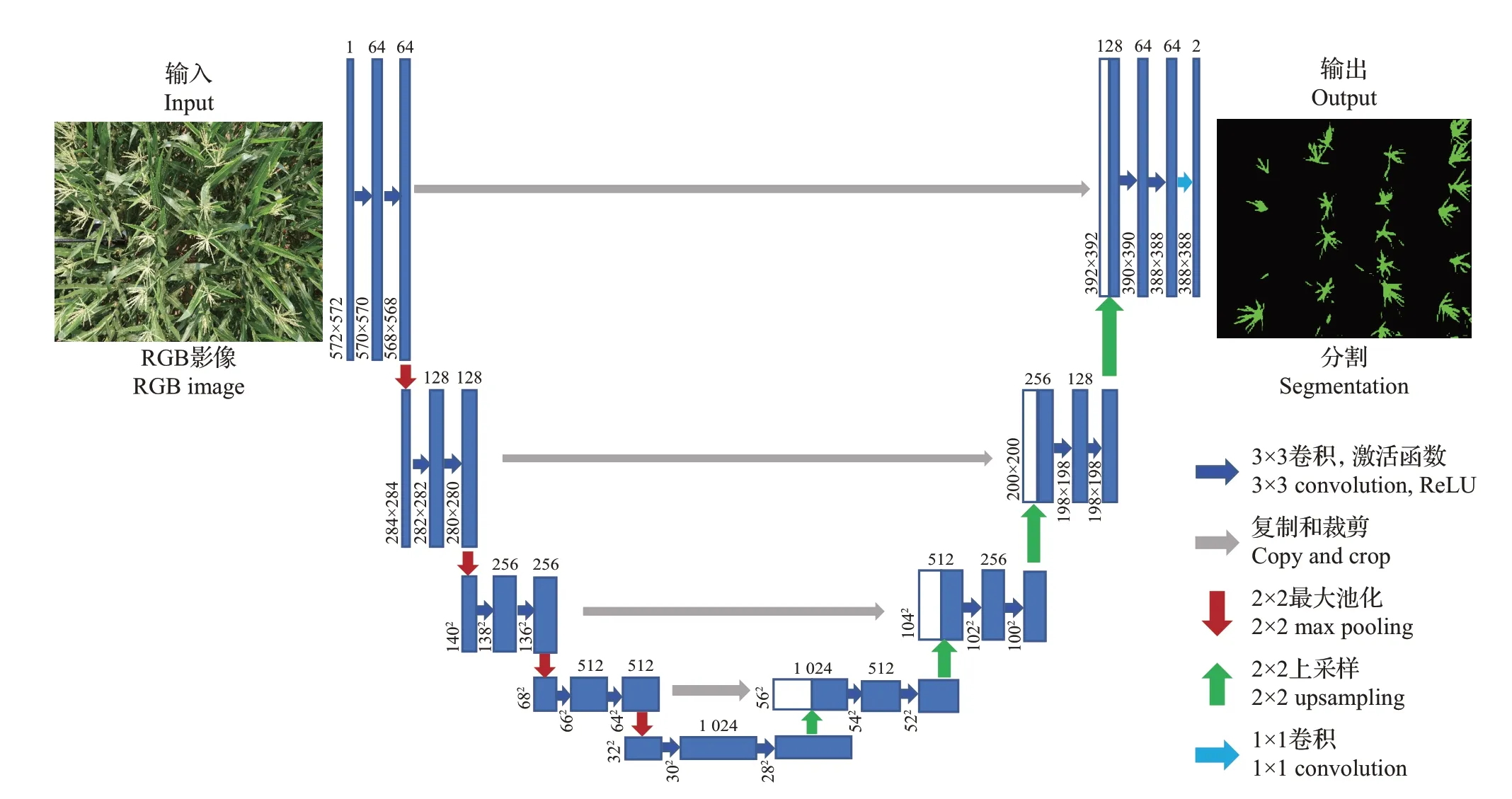

1.4.4 U-Net 模型

U-Net[20]模型的网络框架如图7所示,包含特征提取和上采样2 个部分。在特征提取过程中,经过一次池化产生一个尺度,加上原图尺度一共有5个。在上采样过程中,经过一次上采样,就与特征提取部分对应的通道数相同的尺度融合,在融合之前需将特征提取部分进行裁剪。网络由收缩路径和扩张路径组成,其中,收缩路径用于获取上下文信息,即局部特征,扩张路径用于精确的定位,且2条路径相互对称。最后融合之后输出预测的影像。

图7 U-Net模型的网络框架Fig.7 Network framework of U-Net model

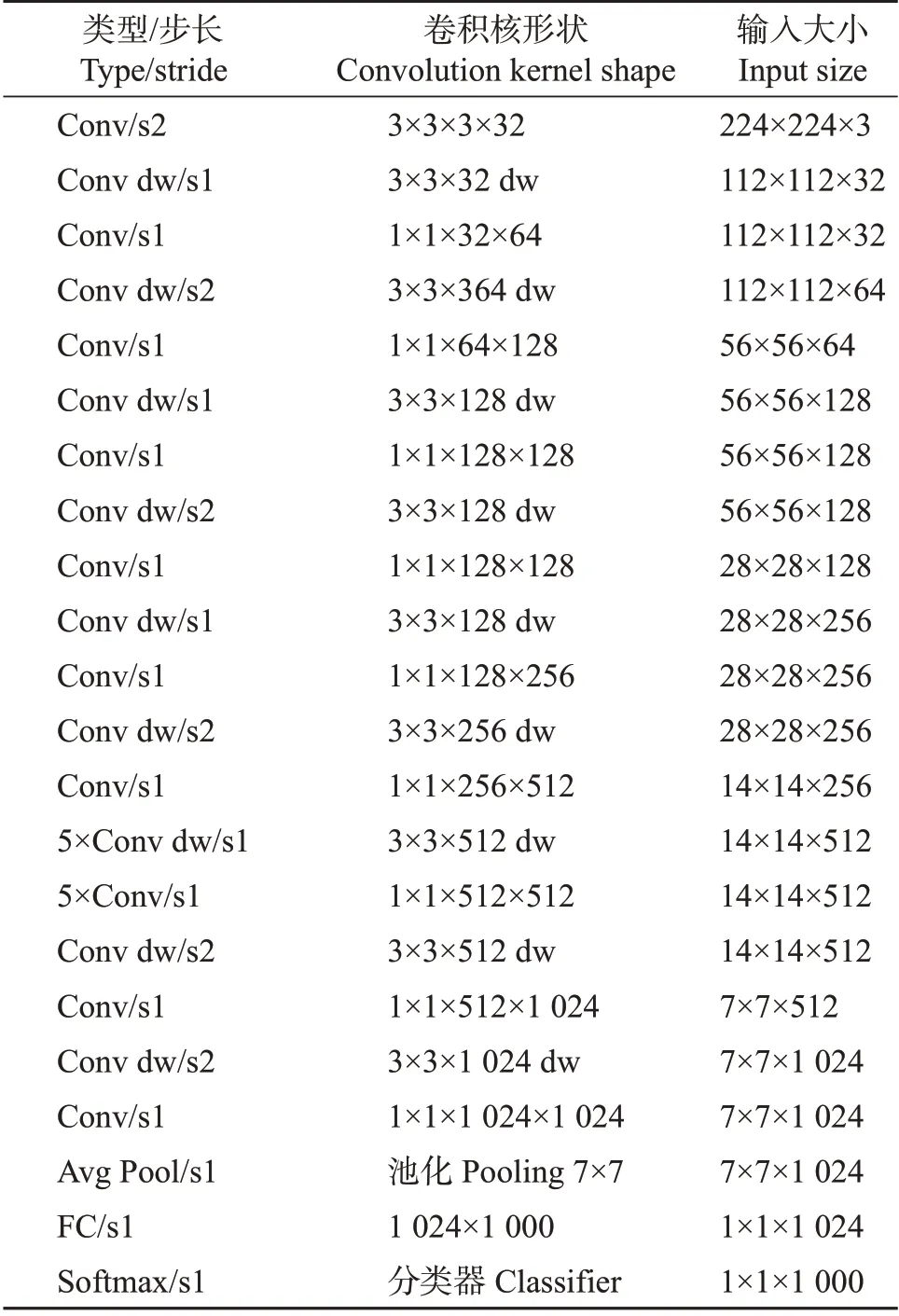

1.4.5 分割模型的特征提取层网络

1)MobileNet[21]。该模型是谷歌公司针对手机等嵌入式设备提出的一种轻量级的深层神经网络,其核心是深度可分离卷积网络(depthwise separable convolution)[22]。而深度可分离又可以分解为深度卷积(depthwise convolution)和点卷积(pointwise convolution)。其中,深度卷积针对每个输入通道采用不同的卷积核,一个卷积核对应一个输入通道。点卷积就是大小为1×1的卷积核。该模型在特征提取过程中会损失一定的精度,但大大减少了模型计算量和模型参数量。MobileNet 的网络结构如表2所示:首先利用3×3大小的卷积核进行卷积,然后堆积深度可分离卷积,其中部分深度卷积会通过步长(strides)为2进行下采样。然后采用平均池化将特征变成1×1,根据预测类别大小加上全连接层。最后是一个分类器。如果单独计算深度卷积和点卷积,整个网络有28层(平均池化层和分类器不计算在内)。

表2 MobileNet的网络结构Table 2 Network structure of MobileNet

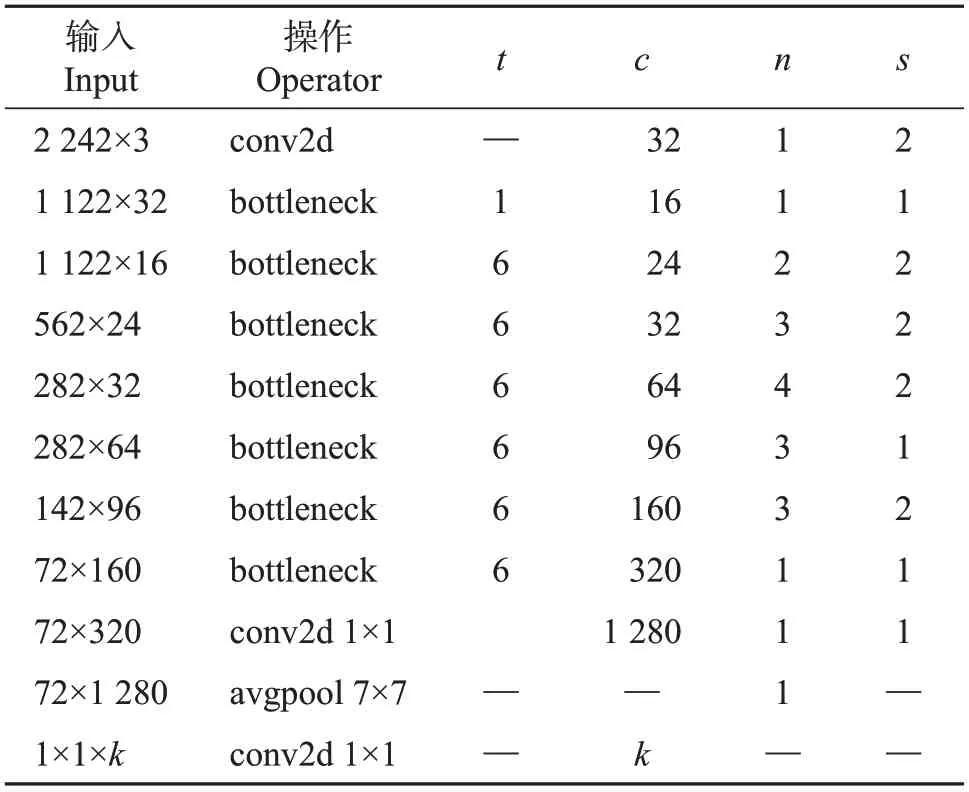

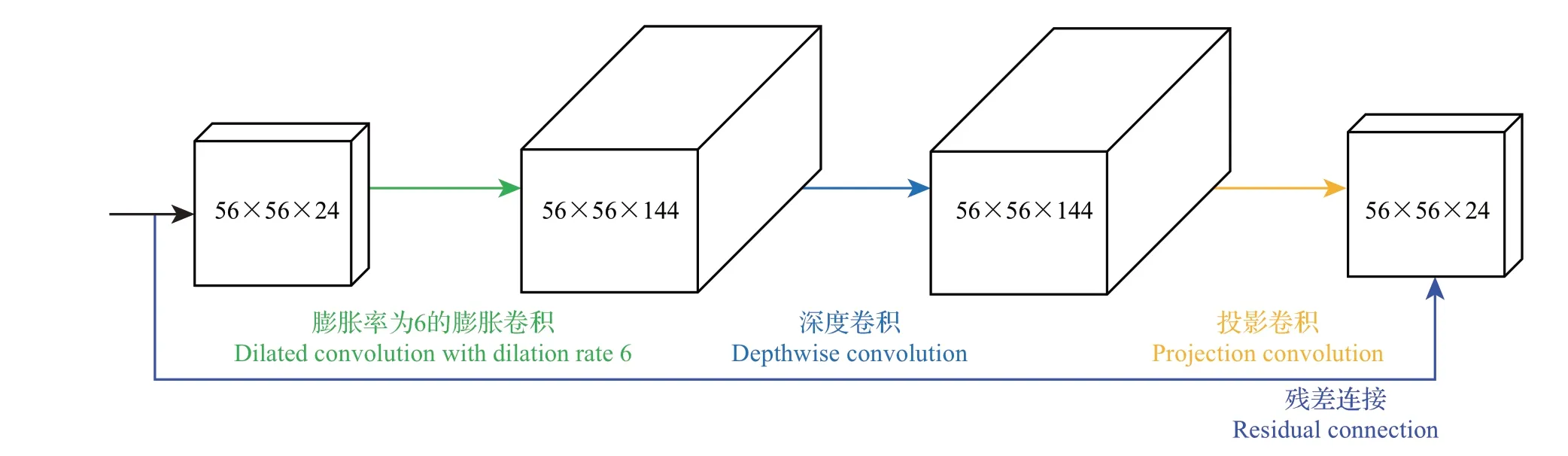

2)MobileNet V2。它是在MobileNet 基础上的改进版,主要特点如下:①使用线性瓶颈(linear bottleneck)层代替原来的非线性激活变换,防止非线性变化破坏太多信息;②使用倒置残差(inverted residuals)网络,整个网络呈现中间宽、两头窄的纺锤形结构,如图8 所示。整个MobileNet V2 的网络结构如表3 所示,初始的全卷积为32 个卷积核,后面连接了19个残差层。

表3 MobileNet V2的网络结构Table 3 Network structure of MobileNet V2

图8 残差网络结构Fig.8 Residual network structure

在本研究中,SegNet、PspNet、U-Net 模型均采用MobileNet 网络作为特征提取层,DeepLab V3+模型采用MobileNet V2网络作为特征提取层,各模型的学习率、世代和批量大小等参数如表1 所示。为减少训练所需的标注数据量,并减少训练时间,提高模型精度,在MS COCO(Microsoft Common Objects in Context,包含33 万张影像、150 万个对象实例和80个对象类别)数据集上进行预训练。然后将训练好的模型参数应用到玉米雄穗分割任务上作为初始参数,并利用不同的数据集对模型进行精细训练。

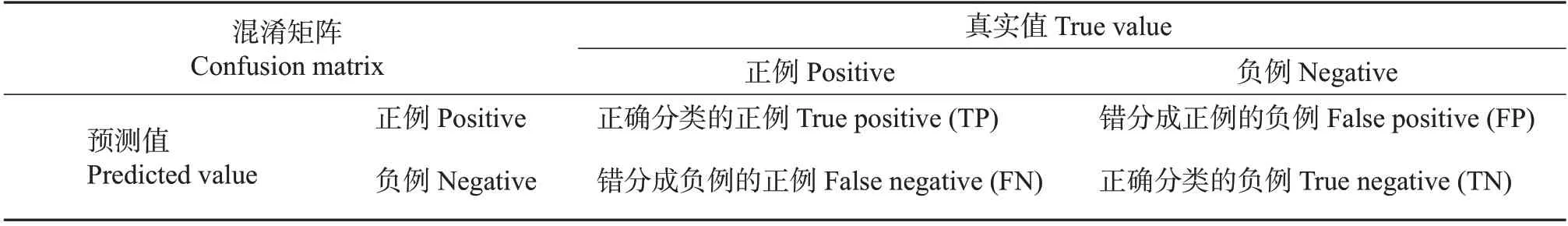

1.5 评价指标

本研究中采用准确率(precision)、召回率(recall)和平均交并比(mean intersection over union,mIoU)对分割精度进行评价。所用评价指标均由混淆矩阵(表4)中的参数计算得出。在模型精度评价中,混淆矩阵主要用于比较预测值和真实值,通过将每个真实像元的位置和预测像元的位置相比较而计算得到。

表4 混淆矩阵Table 4 Confusion matrix

准确率是指预测值为真实值的样本数在全部样本数中所占的比例,公式如下:

召回率是指预测值为真实值的样本数在全部正例数中所占的比例,公式如下:

交并比(intersection over union, IoU)是用于评价语义分割精度的标准度量,公式如下:

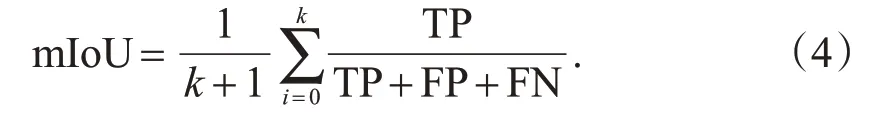

平均交并比(mIoU)是指所有类别IoU 的平均值,公式如下:

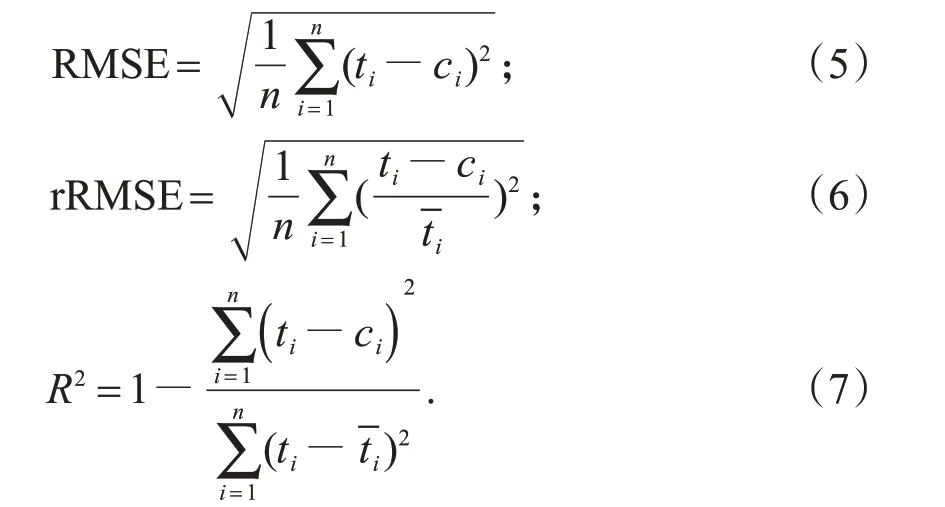

式(1)~(4)中:TP为正确分类的正例;TN为正确分类的负例;FP为错分成正例的负例;FN为错分成负例的正例;k为分割的总类别数。用于量化模型分割雄穗的精度指标包括均方根误差(root-meansquare error,RMSE)、相对均方根误差(relative rootmean-square error,rRMSE)和决定系数(R²)。

式中:n为验证影像的数量;ti和ci分别为模型分割的玉米穗的像元数和影像中玉米穗的实际像元数;-ti为影像中玉米穗的实际像元数的平均值。

2 结果

2.1 不同深度学习模型对玉米雄穗的分割结果

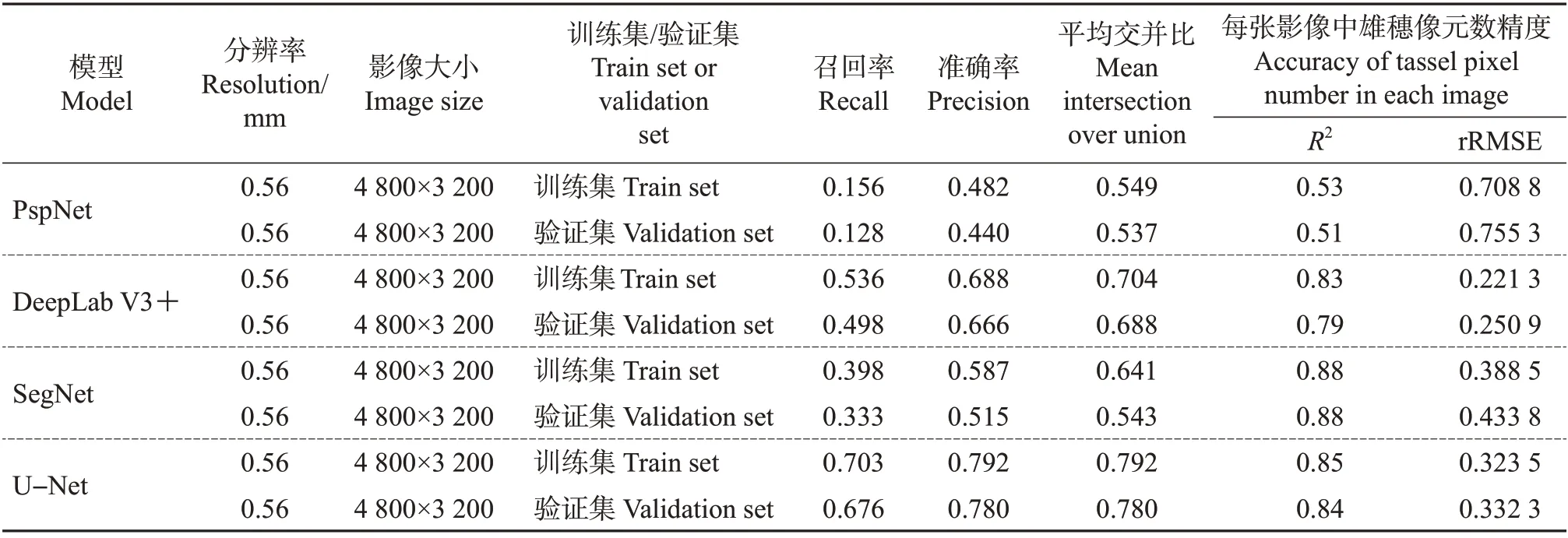

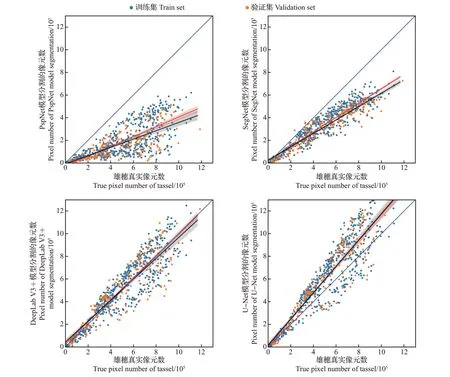

4种常规的语义分割模型对全生育时期数据集中玉米雄穗的分割精度结果如图9和表5所示。结果显示:以MobileNet网络为特征提取层的PspNet、SegNet、U-Net 模型和以MobileNet V2 为特征提取层的DeepLab V3+模型就全生育时期数据集中验证集的分割精度而言,U-Net 模型的分割精度最高(mIoU=0.780),DeepLab V3+模型次之(mIoU=0.688),PspNet模型最低(mIoU=0.537);每个模型对训练集的分割精度高于对验证集的分割精度。

表5 基于全生育时期数据集的各个模型精度评价Table 5 Accuracy evaluation of each model based on whole tasseling stage dataset

图9 4种不同深度学习模型对全生育时期数据集中玉米雄穗的分割结果Fig.9 Segmentation result of maize tassel in whole tasseling stage dataset by four different deep learning models

2.2 U-Net 模型对不同生育时期数据集的分割精度

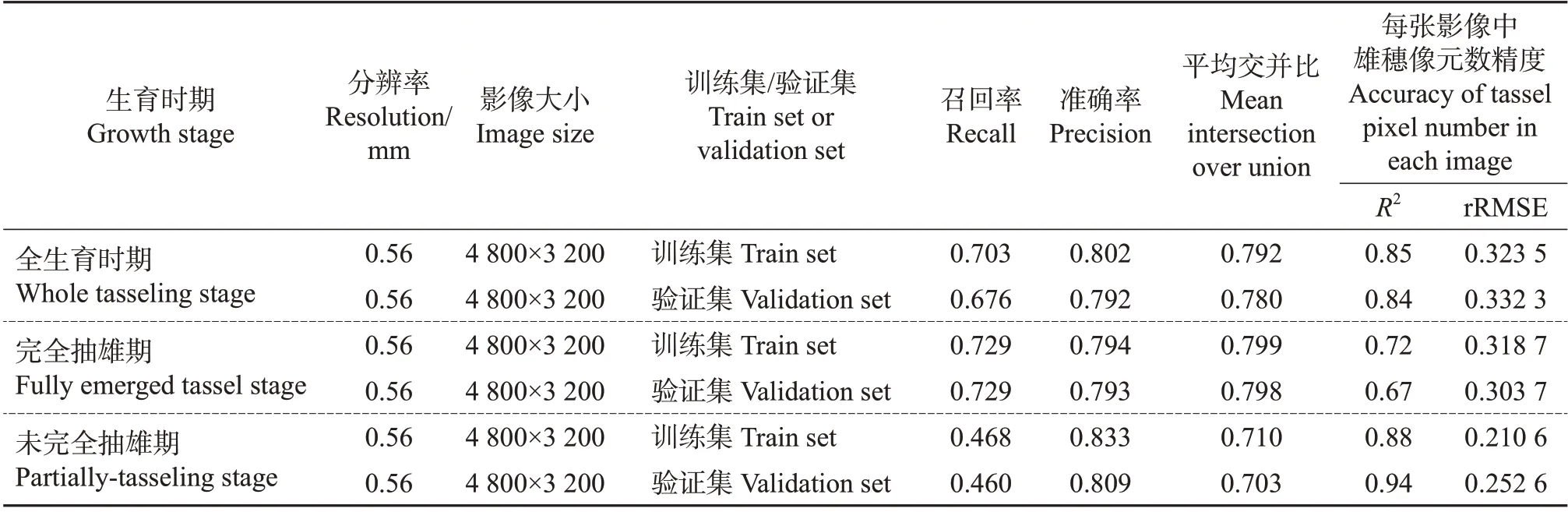

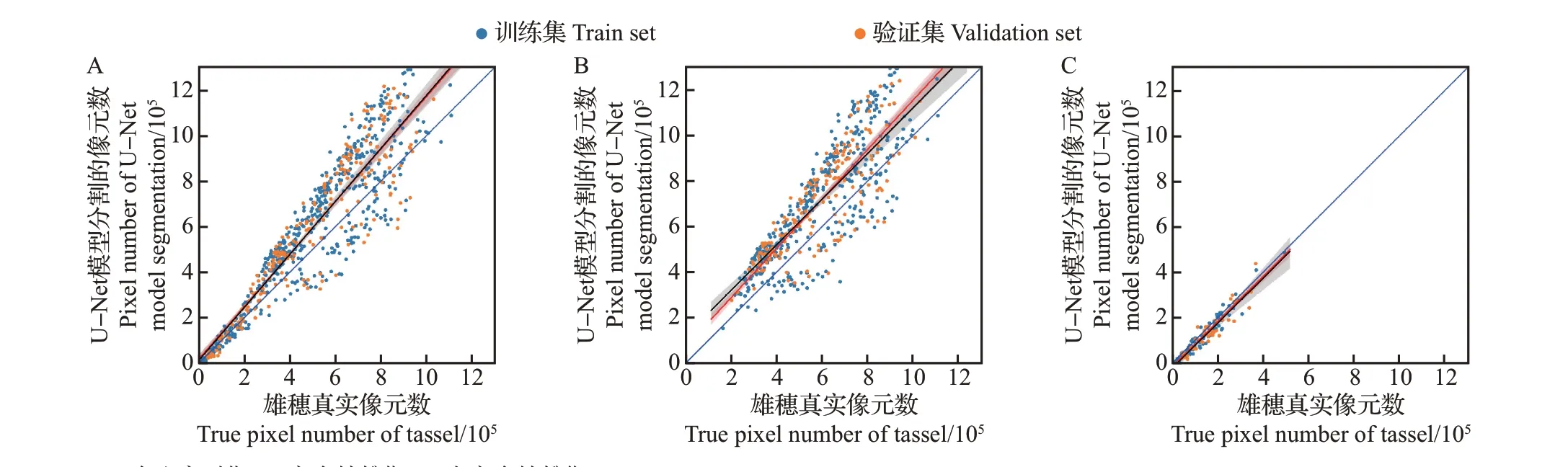

基于2.1节的结果,U-Net模型比其他3种网络模型获得了更好的分割精度。因此,进一步研究了U-Net 模型对不同数据集分割精度的差异,结果如图10 和表6 所示。从中可见:以MobileNet 网络为特征提取层的U-Net 模型对完全抽雄期数据集中验证集的分割精度最高(mIoU=0.798),对全生育时期数据集中验证集的分割精度次之(mIoU=0.780),对未完全抽雄期数据集中验证集的分割精度最低(mIoU=0.703);该模型对训练集的分割精度高于对验证集的分割精度。

表6 以MobileNet为特征提取层的U-Net模型对各生育时期数据集的分割精度评价Table 6 Segmentation accuracy evaluation of datasets at different tasseling stages by U-Net model with MobileNet as feature extraction layer

图10 以MobileNet为特征提取层的U-Net模型对不同生育时期数据集中玉米雄穗的分割精度Fig.10 Segmentation accuracy of maize tassel at different tasseling stage datasets by U-Net model with MobileNet as feature extraction layer

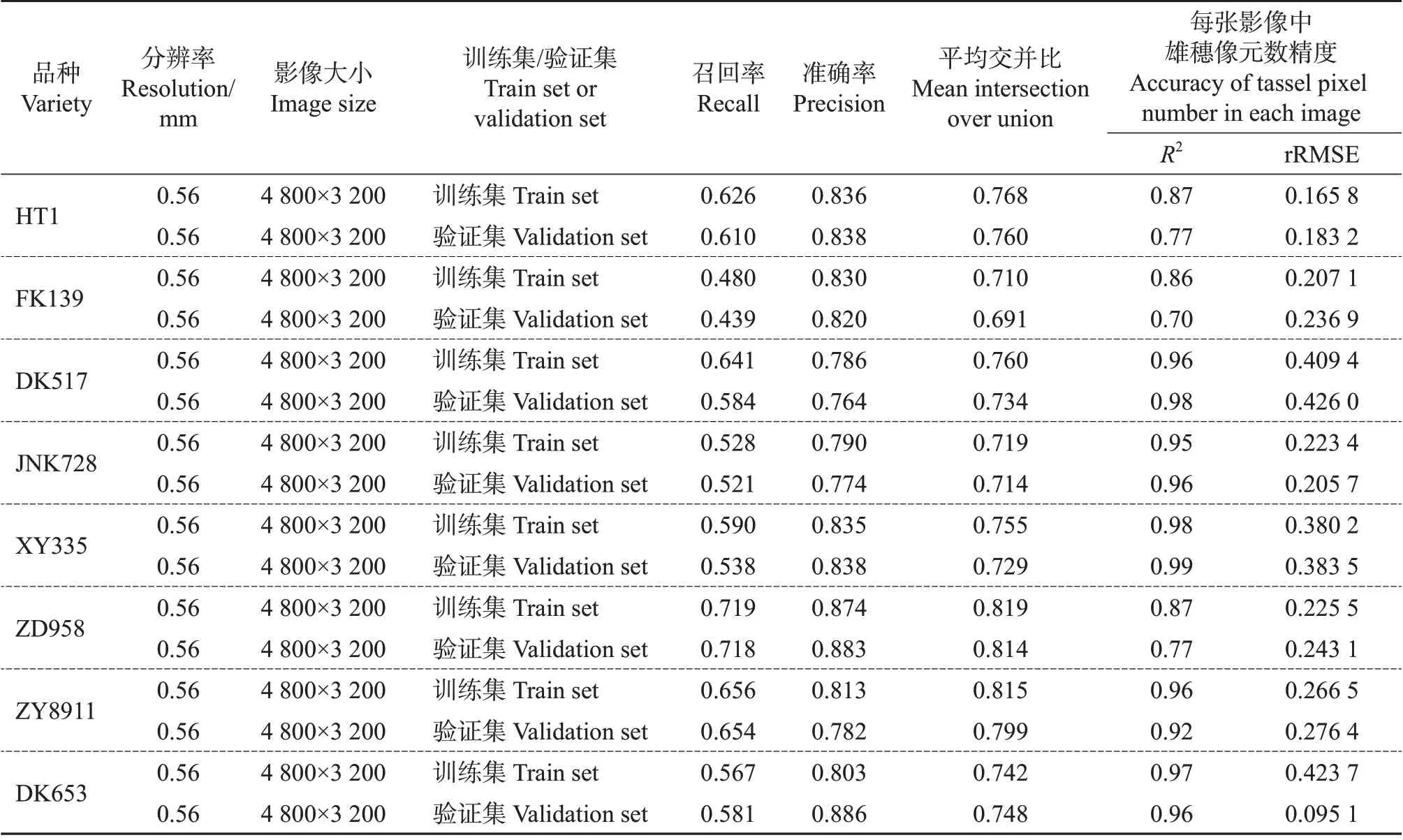

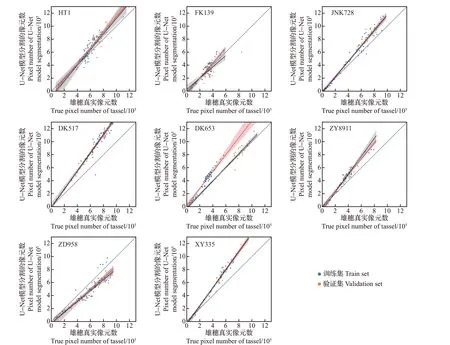

2.3 U-Net 模型对不同品种数据集的分割精度

由于完全生育时期数据集包含了各个品种的数据集,因此,使用完全生育时期训练后的模型去分割各个品种的数据集。结果(图11 和表7)表明:以MobileNet 网络作为特征提取层的U-Net 模型对ZD958 数据集中验证集的分割精度最高(mIoU=0.814),对FK139 数据集中验证集的分割精度最低(mIoU=0.691);除了品种DK653 数据集,U-Net 模型对训练集的分割精度都高于对验证集的分割精度。

表7 以MobileNet为特征提取层的U-Net模型对各品种数据集的分割精度评价Table 7 Segmentation accuracy evaluation of variety datasets by U-Net model with MobileNet as feature extraction layer

图11 以MobileNet为特征提取层的U-Net模型对不同品种数据集中玉米雄穗的分割精度Fig.11 Segmentation accuracy of maize tassel in different variety datasets by U-Net model with MobileNet as feature extraction layer

3 讨论

3.1 不同深度学习模型对玉米雄穗分割精度的影响

本文研究了以MobileNet网络为特征提取层的PspNet、SegNet、U-Net模型和以MobileNet V2为特征提取层的DeepLab V3+模型对玉米全生育时期数据集的分割精度差异。结果表明,以Mobile-Net网络为特征提取层的U-Net 网络对全生育时期数据集中验证集的分割精度最高(mIoU=0.780)。U-Net 模型与其他模型相比,保留了各个层的结构信息:在网络的上半层,模型获取了影像的细节信息。在网络的下半层,模型获取了目标影像的低频信息,即能够获取影像中目标物大的轮廓信息,然后将各个层次的信息连接起来,使得模型能够很好地获取图片中的信息。所以,U-Net 模型比其他模型表现出更好的精度。以MobileNet网络为特征提取层的PspNet 模型对全生育时期数据集中验证集的分割精度最低(mIoU=0.537)。这与本文使用的PspNet 模型只对最后一层的特征层进行高和宽的扩张有关,造成影像特征的丢失,使得模型的分割精度降低。在今后的试验中,可以对多个特征层进行特征提取与扩张,再将各个特征层进行连接,以提高PspNet模型的分割精度。HUETHER等[15]使用DeepLab V3+模型对拟南芥进行分割的精度(mIoU=0.968)远高于本研究中使用该模型对玉米雄穗进行分割的精度(mIoU=0.688)。主要原因在于:1)HUETHER 等[15]的研究是基于稳定的实验室环境,影像中的拟南芥特征明显;而本研究是在野外环境条件下,光照变化大,获取的影像背景复杂,干扰因素较多,造成DeepLab V3+模型对玉米雄穗的分割精度低于对拟南芥的分割精度。2)本文的DeepLab V3+模型是以MobileNet V2 网络作为特征提取层,而HUETHER等[15]是以Xception[22]网络作为特征提取层。然而,以MobileNet V2作为特征提取层比使用Xception网络作为特征提取层的参数量要少得多,因此,前者在特征提取过程中容易丢失信息,造成模型精度的下降。WU 等[14]使用U-Net模型对苹果树冠层树干的分割精度(召回率=0.941)要高于本研究中使用U-Net 模型对玉米雄穗的分割精度(召回率=0.676)。主要原因有:1)苹果树冠层树干面积大,影像中苹果树冠层树干与背景差异大,特征明显,因此,模型能够较好地提取出苹果树冠层树干信息;2)本文的U-Net 网络采用轻量级网络MobileNet作为特征提取层,在特征提取过程中,参数量较少,特征提取过程中信息容易丢失,导致模型精度不佳。

3.2 不同生育时期对U-Net模型分割精度的影响

本研究利用以MobileNet网络为特征提取层的U-Net模型对不同生育时期玉米雄穗的分割精度进行分析,结果显示,在不同生育时期U-Net 模型对玉米雄穗的分割精度存在一定的差异。其中在完全抽雄期表现最好,与LU等[23]的研究结果一致。主要原因是,在完全抽雄期数据集中玉米雄穗的颜色与玉米叶片差异明显,且玉米雄穗的大小均匀,特征明显,在特征提取过程中,模型能够较好地提取到玉米雄穗的特征,所以U-Net 模型对完全抽雄期数据集的分割精度最高。在今后的试验中,为了提高模型对玉米雄穗的分割精度,除扩充数据集之外,还需建立不同生育时期的玉米雄穗数据集。

3.3 不同品种对U-Net 模型分割精度的影响

由于不同玉米品种有不同形状、大小和重叠程度的雄穗,因此,相同模型对不同品种的玉米雄穗分割精度存在差异[24]。本研究结果表明,采用Mobile-Net 网络为特征提取层的U-Net 模型对郑单958(ZD958)的玉米雄穗分割精度最高,对丰垦139(FK139)的玉米雄穗分割精度最低。对比FK139和ZD958 这2 个品种的玉米雄穗的特征发现,ZD958的玉米雄穗呈团簇状,雄穗分支粗壮,其颜色与玉米叶片颜色差异大,而FK139 的玉米雄穗呈分散状,雄穗分支细长,其颜色与玉米叶片颜色差异小。因此,U-Net 模型对ZD958 数据集具有较高的分割精度是因为ZD958的特征明显,有利于模型在特征提取层获取玉米雄穗的特征,从而在模型训练过程中提高分割精度。除了迪卡653(DK653)数据集,U-Net模型对训练集的分割精度都高于对验证集的分割精度。通过查看DK653数据集发现,在DK653中,验证集的玉米雄穗绝大部分处于完全抽雄期,训练集的玉米雄穗绝大多数处于未完全抽雄期,因为U-Net 模型对完全抽雄期的玉米雄穗分割精度高,所以导致该模型对DK653验证集的分割精度高于对训练集的分割精度。

4 结论

本文基于近地面RGB影像,研究了以轻量级网络作为特征提取层的不同深度学习模型对不同品种、不同生育时期玉米雄穗分割精度的差异,得出如下结论:

1)SegNet(mIoU=0.543)、PspNet(mIoU=0.537)、DeepLab V3+(mIoU=0.688)、U-Net(mIoU=0.780)4个模型对近地面RGB影像中玉米雄穗的分割精度差异明显,其中U-Net模型在编码-解码过程中,保留了更多的形状特征,所以U-Net 模型对玉米雄穗的分割精度最佳。

2)U-Net模型对玉米全生育时期(mIoU=0.780)、完全抽雄期(mIoU=0.798)和未完全抽雄期(mIoU=0.703)的分割精度不同。由于完全抽雄期的玉米雄穗大小均一,雄穗与叶片颜色差异明显,有利于模型对雄穗的特征提取,提高模型的精度,所以U-Net模型对完全抽雄期的玉米雄穗分割精度最高。

3)U-Net模型为所有品种验证集提供了良好的分割精度(mIoU=0.749)。由于不同玉米品种的雄穗形状、分枝、成簇状特征不同,有利于模型在训练过程中的特征提取。在各个品种中,U-Net 模型对ZD958 的雄穗分割精度最高(mIoU=0.814),对FK139的雄穗分割精度最低(mIoU=0.691)。

本研究在数据预处理时,没有对原始图像进行校正,如颜色校正与畸变校正,这可能导致在不同时间段采集的影像出现光线变化以及影像边缘产生畸变,从而导致模型分割精度的降低。在今后的试验中,需进一步探讨影像校正对模型精度的影响。总之,以轻量级网络MobileNet 为特征提取层的U-Net 模型对复杂情况下玉米雄穗的分割保持了良好的精度,为今后田间玉米雄穗监测提供了技术与方法参考。