类脑计算研究进展

2021-07-29莫宏伟

莫宏伟,丛 垚

(哈尔滨工程大学智能科学与工程学院,哈尔滨 150001)

0 引言

当前信息科技正在向智能化不断迈进,这离不开人工智能、深度学习和云计算等技术的支持,同时在当前大数据背景下,对计算系统大规模信息处理能力提出了更大的挑战。当前计算系统在信息处理方式上受限于传统的冯·诺依曼结构,由于摩尔定律存在物理极限,因此芯片设计不具备通用性,无法实现真正的智能,使得研究学者向类脑研究方向进行探索,企图从人脑结构及信息处理方式上得到启发,创建不同于冯·诺依曼结构的类脑计算机,使其在低能耗的条件下实现强大的信息处理能力,且具备通用性以及一定的认知能力。类脑计算通常是指从硬件结构到模型算法,由大脑神经系统结构和信息处理机制所启发的新型计算方法。我们的大脑的确具备一些当前计算机无法企及的优点:我们的大脑中存在将近103亿个神经细胞和超过106亿个神经突触,大脑的日常功耗大约10~25W,而普通计算机的功耗则是大脑的10~20倍,图形处理器的功耗则是大脑的100倍以上,且大脑的生物神经元同时具备运算和存储能力。为此,类脑计算机可突破传统冯·诺依曼结构,提升信息处理效率。

特殊的大脑结构及脑内信息传递方式是大脑具备真正智能的关键,人类对于大脑结构及功能的探索从未止步:研究表明,大脑中的组织多以分层级结构存在,例如视觉皮层组织[1],组织中存在着功能不对称的正向和反向连接方式,正向连接(从低到高)有稀疏的轴突分叉,起源于大脑皮质的上颗粒层,主要终止于第IV层;另一方面,反向连接显示了丰富的轴突分叉,分布相较于正向连接更加分散,而且连接数量相当多[2]。反向连接与人工神经网络中的反馈相关,T. P. Lillicarp等[3]认为在脑中的反向连接引起的反馈可诱发神经活动,其反馈差值可用于逼近神经活动信号,从而驱动大脑深层网络的有效学习。其他方面,T. Hainmueller等[4]的研究表明,齿状回是海马记忆形成的关键部分,其在不同的认知功能中具有重要作用,包括辨别相似语境、将物体或事件与地点相联系以及整合记忆操作;K. A. Ferguson等[5]的研究表明,皮层的增益调节使神经元对变化的输入做出适应性反应,这种增益调节容易受到各种神经活动影响,包括注意力、学习和运动等,并且Y-氨基丁酸能抑制在皮层的增益调节,从而起到关键而复杂的作用;A. Bicanski等[6]通过调查研究提出了具有矢量感受野的细胞功能分类,包括边界矢量细胞、边界细胞、目标矢量细胞、跟踪矢量细胞和自我中心边界细胞等,这些神经元的响应为自底向上的环境布局表征和视觉空间意象生成以及导航规划提供了基本神经基础;J. Mcfadgen等[7]的研究表明,包含感知处理初始回路的皮层下区域可以确保处理效率并保障重要生命功能,而皮层下区域与大脑皮层区域间的交互作用促成了非典型的感知和认知加工;L. R. Taxier等[8]在研究中总结了雌二醇的信号传导机制及其在空间记忆、物体识别、社会记忆和恐惧记忆中的作用,越来越多的证据表明,雌二醇作为神经调节剂在女性和男性的学习记忆方面都起着至关重要的作用;J. Duncan等[9]在研究中表明,任何一种有组织的认知都来自于广泛分布的脑活动,流体智力与脑中的多需求(Multiple Demand,MD)系统相关,在皮层上可以看到9个MD活动斑块区域,主要分布在外侧额叶、背内侧额叶、外侧和内侧顶叶,以及颞枕叶皮层,在MD区域中算数活动最强,关系推理活动最弱。这些有关大脑探索得到的客观规律和机制,不仅作用于现代医学和神经科学领域,也可以作为类脑启发式应用于工程领域,促进认知智能。

类脑计算技术的研究路线可分为两大类:一种是自上而下,即先通过科学手段观察大脑内结构和功能运行机制,然后根据观察结果模仿大脑功能,例如欧盟的人类脑计划和美国的脑科学计划,以及目前各个国家都在推动的脑图谱和脑网络组图谱研究。脑图谱通过图像处理的方式按照不同的功能结构划分脑区,脑网络组图谱则在脑图谱的基础上提供脑区与脑区之间、脑区与全脑之间的连接模式。通过脑网络组图谱可以进一步对大脑局部功能进行探索,2020年蒋田仔团队利用脑网络组图谱发现了纹状体环路功能异常是精神分裂症精准诊疗的有效生物标志物[10]。另一种是自下而上的方法,即先构造大脑功能结构相关的假说和模型,然后验证假说和模型是否与真实神经结构、动力学规律相符,例如Friston的预测编码[11]和自由能假说[12]等。

总的来说,类脑计算技术首先借鉴大脑生理结构及功能,建立类脑模型,然后在硬件上参照脑内神经元结构创造实际的类脑元件,最终通过研究人脑学习、记忆和推理的运行机制,并应用于类脑模型中,使其具备人类智能甚至在某些层面上超越人类智能。

1 局部脑功能启发模型

研究学者通过各种科学手段,如脑电图(Electroencephalogram,EEG)[13]、功能性磁共振(functional Magnetic Resonance Imaging,fMRI)[14]和功能性近红外光谱(functional Near-Infrared Spectroscopy,fNIRS)[15]等对大脑的局部构造和功能进行探索,得到多种脑内神经元组织上和功能上的客观规律,如视觉皮层中大量的分层组织结构、大量的反馈调节机制以及具有特殊作用的脑内神经细胞等,并以此为灵感,融合进学科应用中。卷积神经网络(Convolutional Neural Networks,CNN)就是以人类视觉皮层的分层组织结构为启发的经典案例[16],分层级的组织结构在多个单元层级上对任务进行分解,使复杂任务得以简化,从而易于控制。反馈调节机制,如注意力机制等,则是脑内重要的信息处理机制,其和正馈处理一起形成了包括视觉感知过程在内的完整脑功能回路。大脑的神经可塑性以及脑内具有特殊功能的神经元则赋予人类灵活的学习、记忆以及特殊的认知功能。目前学者们发现和利用脑局部组织或功能的热点研究包括:注意力机制(Attention Mechanism)、基于空间导航细胞的类脑导航和长短期记忆网络 (Long Short Term Memory,LSTM)等。

1.1 注意力机制

注意力机制是大脑中存在的一种反馈机制,是研究人员在对人类视觉系统的研究中发现的。注意力机制体现在人类视觉系统对信息的有选择摄取。当将人眼接收的视觉信息传入视觉系统时,视觉系统并非照单全收,而是有筛选地关注更有价值的信息,并抑制对无关信息的关注。可以看出,脑中的注意力具有指向性与集中性,指向性主要指大脑有选择地关注感兴趣的事物,而集中性则是指大脑在关注了感兴趣的事物后抑制对其他无关信息的关注。注意力机制一直是心理学上的研究热点,与人类的学习行为有极大的关联,M. I. Ponser等[17-18]发展了注意力网络理论,将注意力看作多网络系统,包括警觉性网络、导向性网络和执行功能网络[19]。而且认知神经科学学者们通过功能磁共振发现,这些网络在大脑中具有相应的神经功能区域[20],警觉性网络对应的区域主要在丘脑,大脑额叶和顶叶也有部分相应区域,主要负责使个体保持警觉以便做出相应响应[21];导向性网络对应区域较广泛,包括顶叶上部、颞顶叶联合区、上丘脑和额叶眼动区,主要负责刺激选择,在给定所有刺激中选择最相关的[22-23];执行功能网络则主要对应于前扣带回和外侧前额叶等,主要负责监控大脑信息处理活动[24-25]。

注意力机制模型最早于20世纪90年代提出并应用于计算机视觉领域,现如今已经成为深度学习模型中应用最广泛的组件之一,其作用主要是判断输入数据的贡献,类似于传统的特征工程,但不同于传统特征工程的静态性,注意力机制是动态性地计算数据贡献。V. Mnih等[26]使用融合了注意力机制的循环神经网络(Recurrent Neural Networks,RNN)模型进行图像分类,每次只对具有高注意力的像素部分进行处理,从而使复杂的图像分类问题得以简化。D. Bahdanau等[27]首次将注意力机制引入自然语言处理(Natural Language Processing,NLP)领域中,并在基于编码-解码模型的机器翻译任务中取得了十分理想的翻译效果。以编码-解码模型为例,普通的编码-解码模型对于所有输入所分配的处理权重都是一样的,也就是说注意力是平均分配的,在引入了注意力机制后,不同的编码器输出根据匹配程度计算得到不同的处理权值,即注意力得分,从而得到相关的注意力,如图1所示。xi,i=1,2,3,4,为输入向量序列;hi,i=1,2,3,4,为编码器输出序列;yi,i=1,2,3,4,为解码器输出序列。注意力得分按式(1)计算

ASi=Similarity(hi,kj)

(1)

其中,ASi为第i个编码器输出的注意力得分,通常需要对其进行归一化

(2)

最后按照注意力得分对编码器输出进行加权求和

(3)

图1 加入注意力机制的编码-解码模型Fig.1 Encoding-decoding model with attention mechanism

注意力机制按照其技术延伸机理的不同,除软/硬注意力机制(Soft/Hard Attention)[28]、全局/局部注意力机制(Global/Local Attention)[29]和自注意力机制(Self Attention)[30]这些基本分类外,还有分层注意力机制(Hierarchical Attention)[31]和叠加式注意力机制(Attention Over Attention, AOA)[32]等组合式的延伸。A.Vaswani等[33]提出了多头自注意力机制(Multi-headed Self-attention),采用注意力机制代替传统的RNN构建编码-解码框架,其在WMT2014语料中的英德和英法任务上获得了令人满意的实验结果,并且训练速度比主流模型更快。Z. Qin等[34]提出了多频谱通道注意力机制(Multi-spectral Channel Attention),在频域上推广了现有的通道注意力机制的预处理,简单而有效地完成了图像分类、检测以及任务分割。

1.2 长短期记忆网络

记忆是大脑的重要功能,是行动、学习与认知的前提。所谓记忆,是大脑对于所接收信息的存储,脑内信息的存储。脑内信息的存储与神经突触的连接相关,这种突触连接分布于脑内的多个神经组织区域,包括海马体、杏仁核、前额叶以及小脑[35-39]等。按时间长短记忆可分为工作记忆、短时记忆以及长时记忆,也可按功能划分为从低到高的六种层次类型:由纹状体和小脑控制的程序性记忆;由大脑皮层控制的促发记忆;由海马体和大脑颞叶控制的语义记忆及情景记忆;由大脑皮层控制的短期记忆;由杏仁核控制的情绪记忆。

记忆使人类可以利用之前接收的信息对当前接收的新信息加以理解和处理,即结合上下文加工新信息。而在深度学习模型中,传统的神经网络并不具备记忆功能,无法结合早期信息处理新信息。考虑到神经网络的这种设计缺陷,S. Hochreiter等[40]在1997年提出了LSTM模型,经后来的学者改良,目前LSTM模型已经成为广泛应用于各种序列模型的基本框架。LSTM是一种特殊的RNN,通过门结构解决RNN中存在的长期依赖问题。LSTM主要构成包括细胞状态、遗忘门、输入门和输出门,如图2所示。xt为当前输入;ht-1为上一时间步的输出;ht为当前时间步的输出;Ct-1为上一时间步的细胞状态;Ct为当前时间步的细胞状态。LSTM的主要流程包括遗忘信息、更新信息以及输出信息。首先遗忘门决定哪些信息需要从Ct-1中剔除,根据ht-1和xt按式(4)计算

ft=σ(Wf·[ht-1,xt]+bf)

(4)

接下来确定新的信息,并更新细胞状态

it=σ(Wi·[ht-1,xt]+bi)

(5)

(6)

(7)

最后,基于Ct决定网络的输出ht

ot=σ(Wo·[ht-1,xt]+bo)

(8)

ht=ot*tanh(Ct)

(9)

目前,LSTM通常与注意力机制结合用于NLP任务中的序列到序列模型,并在该任务中获得出色的表现。然而需要注意的是,LSTM虽然借鉴了大脑记忆功能,但并不遵循实际大脑中的记忆实现机制,且目前LSTM模型的训练复杂度较高。

图2 LSTM网络结构Fig.2 LSTM network structure

1.3 基于导航功能细胞的类脑导航

人脑的海马体是具有空间定位和情景记忆功能的特殊部位,从1971年O’Keefe在对海马体的研究中发现了位置细胞后,奠定了海马体在大脑认知地图中的重要地位。此后,O’Keefe与其他学者相继在海马体及大脑其他部位发现了同样在空间导航中具有重要作用的方向、边界和网格细胞[41-43]。具体发现及应用的研究进展如表1所示。

表1 导航功能细胞研究进展

(1)类脑导航

研究人员从发现的这些具有导航功能的细胞上获得启发,结合认知地图理念及相关人工智能算法,将其应用于智能体导航中,类脑导航的研究主要包括环境感知技术、空间认知技术、目标导航技术以及群体导航技术。基于类脑的导航系统比一般系统在路径规划和决策方面更具主动性和灵活性。F. Yu等[54]将导航功能细胞的启发应用于SLAM系统中,使其能够在大型三维环境中进行导航,该NeuroSLAM系统结构如图3所示。整个系统包括连接位姿细胞、多层经验地图以及视觉模块3个主要部分。视觉模块提供局部视觉和自运动线索;连接位姿细胞模型的创建则基于三维网格细胞和多层头向细胞,其根据局部视觉和自运动线索整合路径;由局部视图细胞、三维网格细胞、多层头向细胞和三维视觉里程计的输出驱动多层经验地图的创建。

图3 NeuroSLAM系统结构示意图[54]Fig.3 NeuroSLAM system architecture schematic diagram

(2)认知功能拓展

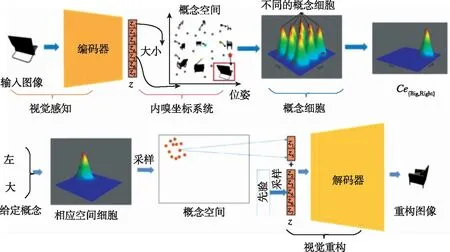

海马体的功能对研究者的启发并不限于空间导航,T. E. Behrens等[55]认为海马体导航功能的规划可推广至一般的抽象推理认知;J. C. Whittington[56]则将这种提取抽象结构信息的规划引入机器学习模型中,可以完成一定的推理任务。导航功能细胞的启发同样可用于视觉概念模型(Visual Concept Space Model,VCSM)的创建[57]。海马内嗅活动模式可以为生物相关的任意变量(如声音、气味和面孔)提供空间编码机制。该理论认为,内嗅网格系统为认知空间维度提供了坐标系统,位置细胞的活动可以代表认知空间中的特定位置。基于此,提出了视觉概念的空间表征,即为某一变量(如椅子和脸)构建一个空间,称为视觉概念空间。在概念空间中,视觉概念用概念细胞来表示。该VCSM的系统工作原理如图4所示。整个模型基于编码-解码网络,物体图像被编码为一系列属性向量,并投影至概念空间中的一点,概念空间中不同的点代表不同的概念细胞,投影至概念空间中的点会激活与其最匹配的概念细胞,最后激活的概念细胞决定了物体的概念;反过来,已知物体概念同样可以通过训练学习将物体从该模型中解码出来,即重构图像。

图4 VCSM原理结构示意图Fig.4 VCSM structure schematic diagram

有关脑内导航系统的研究仍在继续,X. Long等[58]发现除了海马-内嗅系统之外,躯体感官皮层中还存在另一种大脑导航系统。未来会有更多的研究来明确地揭示大脑导航功能的实现机制,并对当前的类脑导航以及更宽泛的认知推理给予启示。

2 神经形态计算

类脑计算的主要目的是创建不受限于冯·诺依曼体系的计算系统,通过借鉴大脑的结构和信息处理机制,实现低能耗、高效率的信息传递及处理,并支持具有大脑认知功能的神经网络模型运行[59]。神经形态计算是类脑计算的主要方法之一,Carver Mead在20世纪80年代提出了神经形态(Neuromorphic)一词,即通过模仿生物神经元特有结构功能,在神经网络模型中实现和生物神经元同等或相近的信息编码方式[60]。神经形态计算包括神经形态模型和神经形态芯片,所谓神经形态模型,是在现有计算机硬件系统上实施对生物脑神经网络的模拟;而神经形态芯片则是在硬件结构上,从神经元结构、信息编码方式到神经元群体组织结构、信息传递来逼近生物脑[61]。

2.1 神经形态模型

2.1.1 神经元模型

神经形态模型的基本组成单元是神经元模型,即模仿树突、轴突和突触结构的模型。1952年,A. L. Hodgkin和A. F. Huxley在进行乌贼动作电位发生机制研究时,发现了乌贼神经细胞在受到脉冲电流刺激后细胞膜上的电位变化规律[62]。大脑神经元之间的通信并非是数值形式的,而是依靠神经细胞膜电位的升降的脉冲,因此借鉴大脑神经元膜电位升降原理建立了人工神经元模型,使得其所组成的神经网络在响应速度和功耗上比一般的神经网络更具优势。研究学者提出了多种神经元模型,常见的神经元模型包括:

(1)Integrate-and-Fire(I&F)模型

I&F模型当属最典型的神经元模型之一,神经元膜电位Vm随着时间动态变化

(10)

其中,τm为电位下降的膜时间常数;I(t)为输入电流。

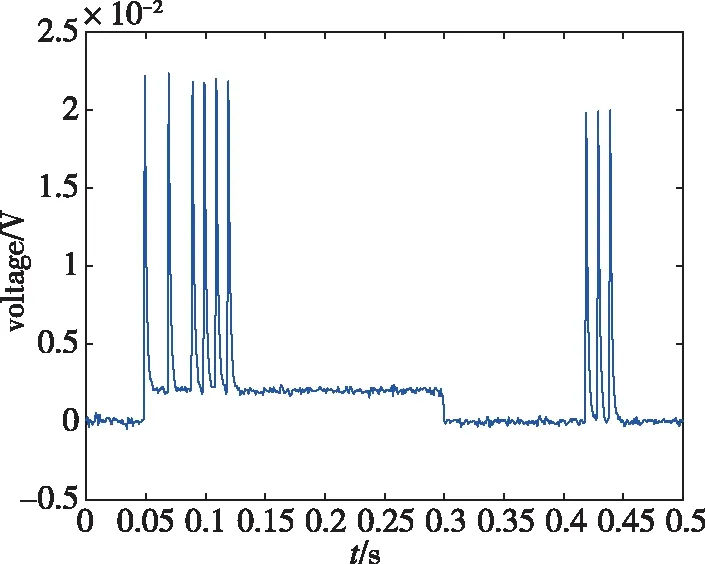

图5所示为I&F模型上电压变化过程,可以看出,当膜电位超过一定阈值时,神经元开始释放脉冲;然后膜电位则下降,当下降到一定值后会保持一段时期,在该时期内不再触发神经元。

图5 L&F模型电压变化过程示意图Fig.5 The scheme of voltage change process of L&F model

(2) Leak Integrate-and-Fire(LIF)模型

LIF模型相当于电容与电源及一个可变电阻并联,只考虑膜电位的被动特性以及动作电位的触发,其数学表达式如下

(11)

其中,Cm代表细胞膜表面电容;GL代表导纳;EL代表被动平衡电压;Iapp代表外界输入电流。

(3)Spike Response Model(SRM)模型

SRM是LIF模型的推广,将LIF模型转化为输入和输出脉冲的函数,其一般形式可写作

(12)

除此之外,还有更加复杂的Hodgkin-Huxley模型、Morris-Lecar模型、FitzHugh-Nagumo模型和Hindmarsh-Rose模型等,神经元模型越接近真实神经元结构特性,其模型就越复杂,模型应用效果也越好。传统的人工神经网络中的神经元就是极度简化的大脑神经元模型,同时考虑使用效果和结构复杂性,LIF模型是神经形态网络中最常用的神经元模型。

2.1.2 脉冲神经网络

脉冲神经网络(Spiking Neural Networks,SNN)作为第三代神经网络,相比于目前应用效果较好的CNN和RNN等第二代神经网络,更加贴近脑中神经元信息传递方式。1997年,W. Maass[63]提出了SNN,整个模型由脉冲神经元构成。与人工神经网络不同的是,SNN的输入信号是脉冲序列,这与人脑中的信号形式一致[64-65]。如图6所示,下游神经元由上游神经元驱动,且SNN神经元只有当接收和发射脉冲信号时才会被激活,这使其具备节约能耗的优势,其0,1输入形式也减少了点积和求和运算量[66]。

图6 SNN计算模型[66]Fig.6 SNN computational models

2.1.3 CA3模型

除了SNN以外,其他的神经形态模型也多以上述仿脑神经元结构的人工神经元为基本单元。Jensen等[72]采用SRM神经元模型创建CA3模型,海马体的一个关键功能是储存和回忆联想记忆。自联想是指从自身的一个部分或噪声样本中检索记忆,而异性联想指的是由另一个类别的线索而唤起的记忆。海马CA1区被认为是异性联想区域,海马CA3区可作为陈述性记忆的异性联想区域或自联想区域。

CA3系统作为一个自联想网络运行,通过内嗅皮层在进行部分线索的回忆过程中完成记忆的存储,CA3中的所有锥体细胞接收一个用于模拟θ节律的振荡输入,中间神经元对所有锥体细胞起反馈抑制作用。图7所示为基于SRM的CA3模型结构示意图,该网络由短时记忆(Short-Term Memory, STM)和长时记忆(Long-Term Memory, LTM)网络组成。STM重复每个周期中的记忆项。中间神经元提供反馈抑制,在每个周期的正部分产生γ子周期。LTM网络在可修改的循环突触中编码信息。CA3中的锥体细胞和中间神经元活动由SRM神经元模型来模拟。

图7 基于SRM的CA3模型[72]Fig.7 CA3 model based on SRM

当传统的深度学习融入了脑机制启发的模型后,网络模型在效率和能耗方面有大幅提升,但目前对于学习、记忆、认知和注意力机制的应用还有待进一步发掘,相关脑功能机理的后续研究仍在不断开展。M. F. Panichello和T. J. Buschman[73]最近的一项研究表明,工作记忆和注意力受同一脑区支配。工作记忆是一种特殊的短时记忆,是大脑对信息进行认知操作过程中对信息的临时存储,后续的信息加工都是在此基础上进行的。Panichello和Buschman对猕猴进行了回顾性和前瞻性记忆测试,通过对外侧前额叶皮层、额叶视区、顶叶皮层和中间视区V4这4个脑区神经元亚群的放电速率进行记录和研究发现,外侧前额叶皮层同时控制着工作记忆和注意力的编码,并且可以通过动态表征转化控制认知行为。T. Bonhoeffer等[74]同样针对前额叶皮层进行了研究,前额叶皮层是与复杂思维过程有关的脑区,脑区内细胞可通过学习具备类别选择能力,并且在改变学习规则后,细胞类别选择性也产生相应变化,这种灵活的表征能力是长期记忆的结果,当短期记忆转化为长期记忆时,前额叶皮层内的选择性细胞就会发挥作用。A. Libby和T. J. Buschman[75]的研究表明,为了使大脑接收的新信息和脑内短时记忆之间不会相互干扰或混淆,采用正交编码的方式存储信息,将记忆进行旋转,使信息间的存储相互分离,而这种旋转正交的存储机制有助于进一步研究大脑对并发事件的处理细节。对于脑区功能的研究有助于探索大脑全局运行机制,探索的过程往往伴随着神经形态模型的进一步完善,在研究脑区功能的基础上,各个区域间的连接作用及信息交互、协同运行的方式将是神经形态模型的研究重点。

2.2 神经形态芯片

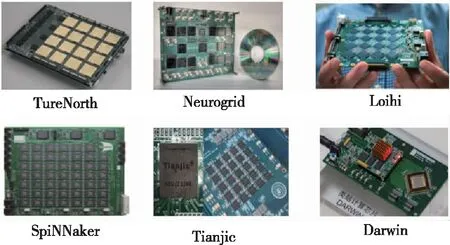

神经形态计算系统以模仿生物神经元的神经形态器件为基本单元,主体是与脑中神经元网络生理近似的SNN,与一般计算机遵循指令的工作方式不同,神经形态计算系统遵循并行式工作、分布式处理机制,以完成学习、记忆和推理等认知任务为目的[76]。当前国内外主流神经形态芯片及相应的神经形态计算系统如图8和表2所示。2014年,美国IBM公司推出了著名的真北(TrueNorth)芯片[77],采用28nm制造工艺,体积小,含有大量的可编程神经元,具有很好的可扩展性,不依靠全局时钟信号协调工作,也不会因为一个芯片损坏而影响整体工作。美国斯坦福大学开发的神经形态超级计算机Neurogrid能够模拟大规模脑内神经元以及突触连接,从而可应用于脑机接口[78]。英国曼彻斯特大学开发的SpiNNaker网络架构,基于ARM芯片实现了部分脑功能模型,可以模仿大脑区域功能,其通信机制适合实时建模[79]。Intel公司发布的神经拟态芯片Loihi,通过神经元之间的脉冲传输数据结合STDP模型,最与众不同之处在于该芯片拥有自主学习功能[80]。浙江大学使用792颗达尔文2代芯片,成功研发出类脑计算机Darwin Mouse[81],并助力实现了机器人协同工作和脑电信号电位解码等应用。目前的神经形态芯片,主要依从神经动力学原理建立仿脑神经网络,但对于已经成熟的ANN等模型并不兼容,对此清华大学研发了天机芯片(Tianjic),融合了神经科学和计算机科学两条技术路线,可并行运行神经网络模型,并在模型间无缝通信[82]。

图8 主流神经形态计算芯片Fig.8 Mainstream neuromorphic computing chip

表2 国内外主流神经形态计算系统及芯片

除了上述神经形态芯片外,还有支持神经网络和深度学习的非神经形态芯片,如寒武纪芯片[83-84]以及嵌入式智能芯片图形处理器(Graphics Processing unit,GPU)、现场可编程逻辑门阵列(Field Programmable Gate Array,FPGA)、专用集成电路(Application Specific Integrated Circuit,ASIC)[85]等。

3 人工大脑

除了神经形态计算外,人工大脑也是类脑计算的重要研究内容,仿脑模型是人工大脑的重要部分,包括加拿大滑铁卢大学开发的SPAUN仿脑模型[86]以及欧洲研究者设计的GENMOD人工神经网络。SPAUN脑模拟器具备约250万个虚拟神经元,可以完成一系列认知任务,例如识别和记忆数字、回答与数字有关的问题,以及完成一定难度的数学题目。SPAUN可以在记住数字后用机械臂将所记忆的数字重新写出来,当需要记忆的数字长度过长时,SPAUN脑模拟器会优先记住开头和结尾的数字,而且在回答问题时,它甚至会犹豫,这与人类智能的自然缺陷相吻合。而GENMOD人工神经网络则能够在不提前训练的条件下,自主培养数感,进行空间认知。除了仿脑模型这样的软件,人工大脑还有人造神经元和人工突触这样的硬件。

3.1 人造神经元

2016年,IBM公司设计出首个基于相变材料技术的人造神经元[87],由输入端、神经薄膜、信号发生器和输出端组成,如图9所示,分别相当于生物神经元的树突、双分子层、神经细胞主体和轴突。其中神经薄膜由锗锑碲复合材料制成,是一种相变材料,在人造神经元中,当信号到来时,锗锑碲薄膜从原本的无定形态到结晶态,从而导电;而当电流从薄膜通过产生信号并由输出端发射后,薄膜又会恢复原来的状态。这种人造神经元技术与人工突触的主要成分忆阻器是互补的,神经元产生的信号主要通过突触来传递。人工突触也是人工神经元重要的连接和信息传递器件。

图9 人工神经元示意图[87]Fig.9 Artificial neuron schematic diagram

3.2 人工突触

目前,人工突触的研究主体是忆阻器[88-90]。忆阻器作为第4个无源电子元件,从特性上看是最适合的天然突触模拟器件。如图10所示,从结构上看,忆阻器是2条相互垂直的金属线交叉处的一个氧化结,生物突触通过释放Ca和Na离子改变传导特性,而忆阻器则是通过释放氧离子改变传导特性,也就是说,忆阻器通过改变其电阻值模仿生物突触对学习行为的响应[91]。

图10 忆阻器结构Fig.10 Memristor structure

记忆功能是忆阻器的重要特征,具体表现为能够记忆流经它的电荷数量,这直接影响器件的存储能力,使其成为在促进类脑智能方面最具潜力的基础元件。2020年,清华大学和马萨诸塞大学共同提出了一种基于全硬件忆阻器实现的CNN系统[92]。系统组成如图11所示。该系统以ARM为控制核心,具有动态随机存储器和8个忆阻器阵列PE,每个阵列有2048个忆阻器。该系统具有5层CNN网络,采用不同卷积核和多个相同卷积核分别对共享输入和不同输入进行并行处理,通过混合训练方法可以进行MNIST(Mixed National Institute of Standards and Technology)手写数字识别,识别精度达到96%以上。总体来说,该忆阻器CNN系统能够适应设备缺陷,实现了存算一体结构,并具有良好的可扩展性。与Teala V100 GPU相比,功耗效率提高了2个数量级,性能密度提高了1个数量级。

图11 系统结构图[92]Fig.11 System architecture schematic diagram

除了忆阻器外,斯坦福大学和桑迪亚国家实验室的研究人员研发出一种人工突触[93],成功模仿了人脑中的突触传递信号的方式。其设计灵感源自电池,工作原理类似于晶体管,也具有3个电极,由于其材料与大脑组织成分的相似性,原理上这种人工突触甚至可以和生物神经元通信,这使其具有可观的脑机接口应用前景和研究价值。

4 中国类脑研究

类脑计算作为类脑智能的重要内容是人工智能发展的必然趋势,也是各国将展开激烈竞争的科技领域。国际上对大脑的研究从未停止,自从2013年美国脑计划提出以来,各国相继提出了正式的脑计划,国际上具有代表性的类脑研究项目及成果如表3所示。

表3 各国类脑研究项目及代表成果

中国脑计划已经酝酿了相当长一段时间,“脑科学与类脑研究”——中国脑计划,作为重大科技项目被列入国家“十三五”规划。脑科学的研究在中国拥有重要战略地位,目前我国已有包括北京脑科学与类脑研究中心、上海脑科学与类脑研究中心在内的超过20个研究机构及实验室,作为脑科学与类脑研究基地,积极推动中国脑计划。根据中国科学院上海神经科学研究所所长蒲慕明介绍,中国脑计划将遵从“一体两翼(One body twowings) ”布局,以研究脑认知的神经原理为主体,研发脑重大疾病诊治新手段和脑机智能新技术为两翼。在未来15年内,以在脑科学、脑疾病早期诊断与干预、类脑智能器件3个前沿领域取得国际领先的成果为目标[94]。

5 结论

从研究成果上看,国际上对于类脑研究的进展刚起步,各国都有各自的突破性自主类脑技术及产品,等同于处于同一起跑线,类脑计算领域的竞争主要集中在神经形态计算系统硬件及模型软件上。从目前来看,神经形态芯片研究的主要目的是避开原始的冯·诺依曼结构,以实现低功耗下信息高效传递及处理,各国研究的芯片主要支持的是符合生物神经动力学的SNN,但是似乎和当前深度学习等算法的研究拉开距离,神经形态芯片应该具有良好的兼容性,同步于主流算法的研究,从而得以大规模应用并相互促进。模仿生物神经元的人造元件性能从主体构造和材料选择上来说都有待提高,设计能与生物神经元交流的人造神经元是一个很有前景的计划。

对于神经形态模型则有更大的提升空间。首先类脑计算得益于人类对大脑生理构造运行机制等规律的运用,目前全球范围内,人类对于大脑的全局结构及功能包括信息传递、区域协调等尚未完全理解,而且对于目前已经探索得到的生物运行机制的发掘利用也仍有可提升的空间。就像对于类脑导航来说,我们知道位置细胞、边界细胞、方向细胞和网格细胞各自的功能及作用原理,但对于这4个细胞如何共同协作促成人类大脑导航活动的机理还不够明确,相关的研究及仿真相对较少,致使其在应用过程中不具备良好的可解释性。其他的研究亦然,目前的研究都是对于大脑局部功能的研究,如何对目前的研究进行从局部到整体的整合是未来的研究主题之一。我们一直希望了解的大脑的学习、推理和记忆等功能是在多区域共同协调控制下才出现的,脑中组织的功能具有相当大的复杂性,常常出现多对一以及一对多的情况,也就是多个组织区域共同实现同一功能或一个组织区域具有不止一种功能,这都为脑功能的整合带来困难,这种功能上的耦合性也是我们理解大脑认知功能本质的关键。