基于改进的Faster R-CNN模型的异常鳞状上皮细胞检测

2021-05-11尹远来赵磊

尹远来 赵磊

摘 要:宫颈癌是目前世界上最常见的妇科恶性肿瘤,患者死亡率非常高。新柏氏液基细胞学检测(TCT)是宫颈癌筛查的基本方法,病理医生在显微镜下观察子宫颈脱落的鳞状上皮细胞,查看是否存在异常鳞状上皮细胞进行诊断。TCT对宫颈癌的检出率为100%,同时还可以发现部分癌前病变和微生物感染。目前国内的病理医生只有10000人左右,而且培养周期长,需求缺口极大。本文使用经过病理医生标注的数字病理图像,训练目标检测模型。设计了基于FasterR-CNN的网络结构改进的模型,引入了可形变卷积网络和特征金字塔网络,实现了对宫颈数字病理图像进行自动识别,为临床宫颈疾病诊断提供辅助参考。实验结果表明,改进后的模型能快速收敛,在测试集上的测试结果mAP(meanAveragePrecision)可以达到0.29,已经基本满足辅助病理医生诊断的需求(实际医院临床使用的模型mAP为0.32)。

关键词:非典型鳞状细胞检测;FasterR-CNN;可形变卷积网络;特征金字塔网络

【Abstract】Cervicalcanceristhemostcommongynecologicalmalignanttumorintheworld,withaveryhighmortalityrate.ThinprepCytologicTest(TCT)isthebasicmethodforcervicalcancerscreening.Pathologistsobservesquamousepithelialcellsshedfromthecervixunderamicroscopetoseeifthereareabnormalsquamousepithelialcellsfordiagnosis.ThedetectionrateofcervicalcancerbyTCTis100%,andsomeprecancerouslesionsandmicrobialinfectionscanalsobefound.Atpresent,thereareonlyabout10000pathologistsinChina,andthetrainingcycleislong,withahugedemandgap.Inthispaper,theobjectdetectionmodelistrainedbyusingdigitalpathologicalimageslabeledbypathologists.AnimprovednetworkstructuremodelbasedonFasterR-CNNisdesigned,andadeformableconvolutionalnetworkandafeaturepyramidnetworkareintroducedtorealizeautomaticdetectionofcervicaldigitalpathologicalimages,providinganauxiliaryreferenceforclinicaldiagnosisofcervicaldiseases.Theexperimentalresultsshowthattheimprovedmodelcanconvergerapidly,andthemeanAveragePrecisiononthetestsetcanreach0.29,whichhasbasicallymettheneedsofauxiliarypathologistsfordiagnosis(themodelmAPusedinactualhospitalclinicalpracticeis0.32).

【Keywords】AtypicalSquamousCellsdetection;FasterR-CNN;DeformableConvoluationalNetwork;FeaturePyramidNetwork

作者簡介:尹远来(1995-),男,硕士研究生,主要研究方向:计算机视觉;赵 磊(1964-),男,博士,教授,主要研究方向:计算机应用。

0 引 言

液基细胞学筛查是宫颈癌早期筛查的重要手段[1]。子宫颈细胞学筛查时,主要存在4种子宫颈异常鳞状上皮细胞[2],下文简称阳性细胞,分别是:ASC-US(未明确诊断意义的非典型鳞状上皮细胞)、ASC-H(不排除高度病变的非典型鳞状上皮细胞)、LSIL(低级别鳞状上皮内病变细胞)、HSIL(高级别鳞状上皮内病变细胞)。

阳性细胞的检测属于计算机视觉中的目标检测问题。RetinaNet[3]、SSD[4]和YOLO[5]等一阶段的算法虽然有很高的检测速度,但是检测精度相对较低。Ren等人[6]提出的FasterR-CNN在目标检测任务上取得了良好效果,该算法被认为是二阶段目标检测任务中的代表性算法。因其在检测精度和速度上都有良好的表现,所以本文基于FasterR-CNN的思想,设计了改进的FasterR-CNN网络模型应用于阳性细胞的检测,其改进体现在以下2个方面。一是引入了可形变卷积网络(DeformableConvolutionNet,DCN),二是使用特征金字塔网络(FeaturePyramidNet,FPN)用于解决小尺寸阳性细胞检测精度低的问题。

DCN是由微软亚洲研究院视觉计算组的Dai等人[7]提出的。在FasterR-CNN的卷积网络部分中加入可形变卷积可以更好地提取各种形态的阳性细胞的特征,使得后续分类网络和位置回归网络有更好的精度。FPN是由FacebookAI研究中心和康奈尔大学的Lin等人[8]提出的。对于一张图像来说,引入FPN网络可以使目标检测网络学习到多个尺度的语义信息,有效地提升小目标的检测精度。

1 数据集与预处理

1.1 数据集

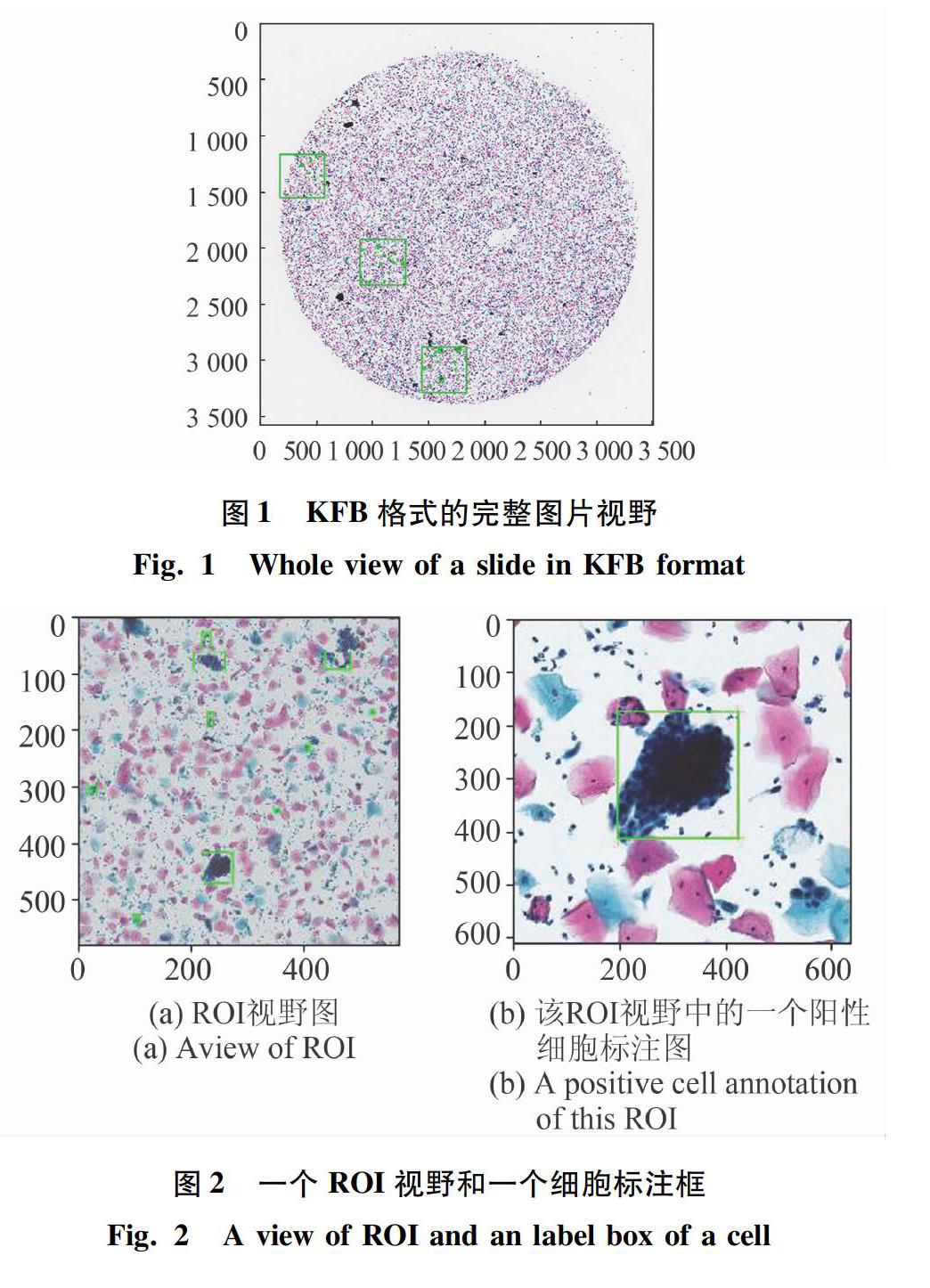

本文的实验数据是使用来自宁波病理中心的病理切片,通过全自动数字切片扫描仪扫描获得的数字病理图像,共2297例含有阳性细胞的阳性样本。病理图像以KFB格式存储,在文件夹中每个KFB文件都有一个同名的JSON文件。其中,KFB文件存儲的是宫颈脱落细胞的数字病理图像,KFB格式的完整图片视野如图1所示。由图1可看到用2.5倍率读取的KFB全片图像,JSON文件存储的是由病理医生标注阳性细胞的标注信息。由于全图标注耗费太多时间,所以每个KFB图像中都有由病理医生自行选择若干个尺寸不小于3000×3000像素的兴趣区域(RegionofInterest,ROI),即图1中绿色矩形框。一个ROI视野和一个细胞标注框如图2所示,病理医生只标注ROI中的阳性细胞。图2中,标注的形式是矩形框,包括矩形框左上角坐标(x,y)和矩形框宽高信息(width,height),以及该矩形框所属类别sub_class。在数据集所有KFB文件中,每一类阳性细胞的标注总个数统计如图3所示。

1.2 预处理

数据预处理首先是从KFB文件中裁出所有20倍率下读取的ROI,另存为JPEG格式的图片。由于ROI的面积较大,而阳性细胞尺寸普遍较小,若直接将ROI放入网络训练,训练得到的模型检测效果不理想。所以本文采用滑动窗口的方式对ROI进行切割,将切割后的小图作为训练样本进行训练。切割尺寸为1500×1500像素,切割步长为750像素。切割方式如图4所示。其次,训练之前需要将图像RGB每个通道的像素值进行归一化。计算图像每个颜色通道的图像(image)所有像素灰度值的均值(mean)和标准差(std),应用公式(1)得到每个通道的标准像素灰度值,即:

2 模型网络结构

2.1 FasterR-CNN网络模型结构

FasterR-CNN模型的网络结构如图5所示。网络分为2个主要部分,分别是:骨干网络(Backbone)和区域推荐网络(RegionProposalNetwork,RPN)。其中,Backbone是一个基础的卷积神经网络,对输入图像运用一系列卷积、ReLU激活、池化等操作后最终输出一张特征图,用于提取输入图像的特征。本文使用ResNet50作为整个检测器的Backbone。由图5可知,每个蓝色的长方体代表一系列卷积模块生成的特征图,最后一层特征图将被后续的RPN和全连接层共用。

RPN是FasterR-CNN核心组件,用来给后续的目标分类和预测框位置回归网络生成推荐区域。这是一个输入为特征图,输出为候选框的全卷积神经网络。训练图像输入网络,经过Backbone处理后,输出一张高维度的特征图。该特征图与RPN共享,即将这张特征图输入到RPN中,进行3×3的卷积,卷积之前先做了一次padding=1的边界填充操作,以此保证卷积后生成的RPN的特征图(featuremap)与Backbone的特征图有相同的尺寸。以该3×3卷积核的中心在RPN的特征图上对应的像素点坐标为基准,生成3种宽高比的Anchor。本文使用的anchor_scale为8,这个参数指定了感受野的区域尺寸为8×8像素,将这些8×8像素的候选框按照卷积和池化操作的下采样比例,对应回原图像上,生成一系列候选框。这些候选框与阳性细胞的标注框(GroundTruth)进行IOU(IntersectionoverUnion)计算。本文规定:任一候选框与标注框的IOU大于0.7,则认为是正样本,小于0.3的为负样本,这些正负样本将用来训练RPN的分类功能,正样本参与RPN推荐框回归功能的训练,负样本则不参与。训练好的RPN网络将为后续的全连接层输出精准的推荐区域。

2.2 FasterR-CNN结合图像金字塔(FPN)的网络结构

FPN是一种利用常规CNN模型来高效提取图片中各维度特征的方法,图6是在FasterR-CNN的基础上增加了FPN模块的网络结构。此时整个网络的特征提取部分被分成了2个过程,分别是:下采样和上采样加侧连接。FasterR-CNN+FPN模型结构如图6所示。

由图6可知,图像被传入卷积模块,进行常规的卷积、ReLU激活和池化等下采样操作,不断提取图像中阳性细胞的语义信息,此过程可得到一系列大小不同的特征图,把最后一层的特征称为顶层特征。由于阳性细胞的病理形态都较小,顶层特征虽然保留了阳性细胞的语义信息,但是在下采样的过程中,小目标的细节特征会被丢弃,导致模型对小目标的检测精度很低。FPN模块将顶层的小特征图按照下采样的倍率,利用最近邻插值法自顶向下进行上采样,生成一张与上一层特征图尺寸一致的特征图。侧向连接将上一层经过上采样后和当前层分辨率一致的特征,通过相加的方式进行融合,为了修正通道数的数量,将当前层进行1×1的卷积操作。再将融合后的每张特征图输入RPN网络进行区域推荐,生成的推荐区域经过池化操作后传入全连接层进行具体类别的分类和位置回归。结合FPN使整体网络不仅利用了顶层的语义特征,又利用了底层的高分辨率特征,最大限度提升了小目标的检测效果。

2.3 可形变卷积网络原理

本文在Backbone中添加可形变卷积模块,以适应不同形状的阳性细胞。标准卷积与可形变卷积示意如图7所示。标准的卷积对未知形状变化目标的建模存在固有缺陷,由图7(a)看到的标准卷积模块有固定的几何结构。例如在同一个卷积层中,所有的卷积核的感受野是一样的,但是由于不同位置可能对应着不同尺度和形变的物体,因此需要对尺度和感受野大小进行自适应进而做到精确定位。DCN基于一个平行网络学习偏移量,不需要额外的标注信息。由图7(b)看到,卷积核在输入特征图上的采样点发生偏移,从而使得卷积模块集中于感兴趣的区域或者目标,进而使得卷积模块更精准地提取到目标的特征。通过图7(c)和图7(d)可以直观地看出,标准卷积只能以固定的结构获取特征,包含了大部分背景的特征;而可形变卷积则可以完全捕获目标形态,保证网络提取到的特征更加地精准,提高网络的识别精度。

3 模型训练、预测与评估

3.1 实验环境与损失函数

本文实验是在64位Ubuntu16.04操作系统环境下的服务器上进行的,服务器配置见表2。

3.2 网络训练过程

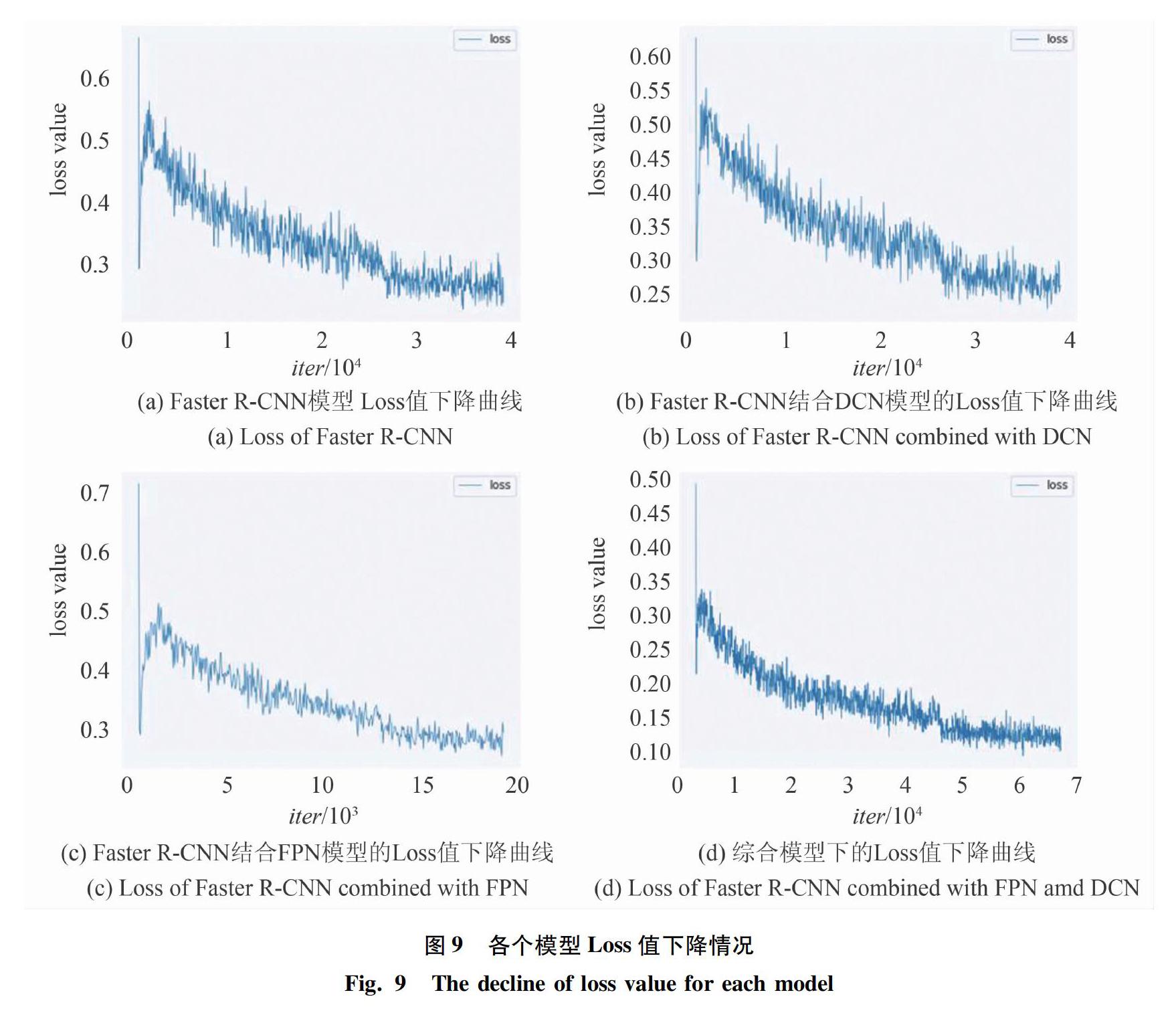

本文中使用了A、B、C、D表示不同的模型。A模型是FasterR-CNN网络模型,B模型是单独加入DCN的FasterR-CNN,C模型是单独加入FPN的FasterR-CNN,D模型是同时加入FPN和DCN的FasterR-CNN。4个模型使用相同的数据和训练参数,采用的优化器都是SGD(随机梯度下降),初始学习率为0.0025。

整体网络训练流程如图8所示。由图8可以看到,训练样本首先被输入到Backbone,输出一张Backbone特征图。此处的Backbone是由ResNet50在ImageNet数据集上训练得到的参数初始化的。该特征图经过一个卷积模块后,继续被输入到RPN中。此时在Anchor机制作用下,生成大量的Anchor,这些Anchor与GroundTruth进行IOU操作,筛选出等量的正负样本,用于训练RPN的分类网络,正样本用于训练RPN的预测框回归网络。这个过程中会根据公式(3)产生的损失值,通过反向传播机制,优化RPN的参数。接下来使用上一轮训练获得的RPN参数,进行下一轮的训练迭代,经过Backbone的特征图,使用初步训练的RPN推荐Region后,进行分类和预测框回归,此处在GroundTruth的作用下同样会产生损失值,这部分反向传播后用来优化Backbone的参数。由于DCN和FPN都

不需要额外的损失函数进行优化,所以这两个模块与检测模型共用同一个损失函数,进行DCN中像素偏移量的训练。如此循环训练后,网络会得出优化好的Backbone和RPN参数。

各个模型训练时的损失值下降情况如图9所示。从图9中可以看出,4个模型在训练初期,损失值 都有比较大的震荡幅度,但是在经过5000次迭代以后,总体呈现了比较稳定的下降趋势,40000次迭代后逐渐趋于平稳,说明模型已经收敛,训练完成。模型D收敛后的损失值可以达到0.15左右,优于其他三个模型,训练效果良好。

3.3 网络测试与评估

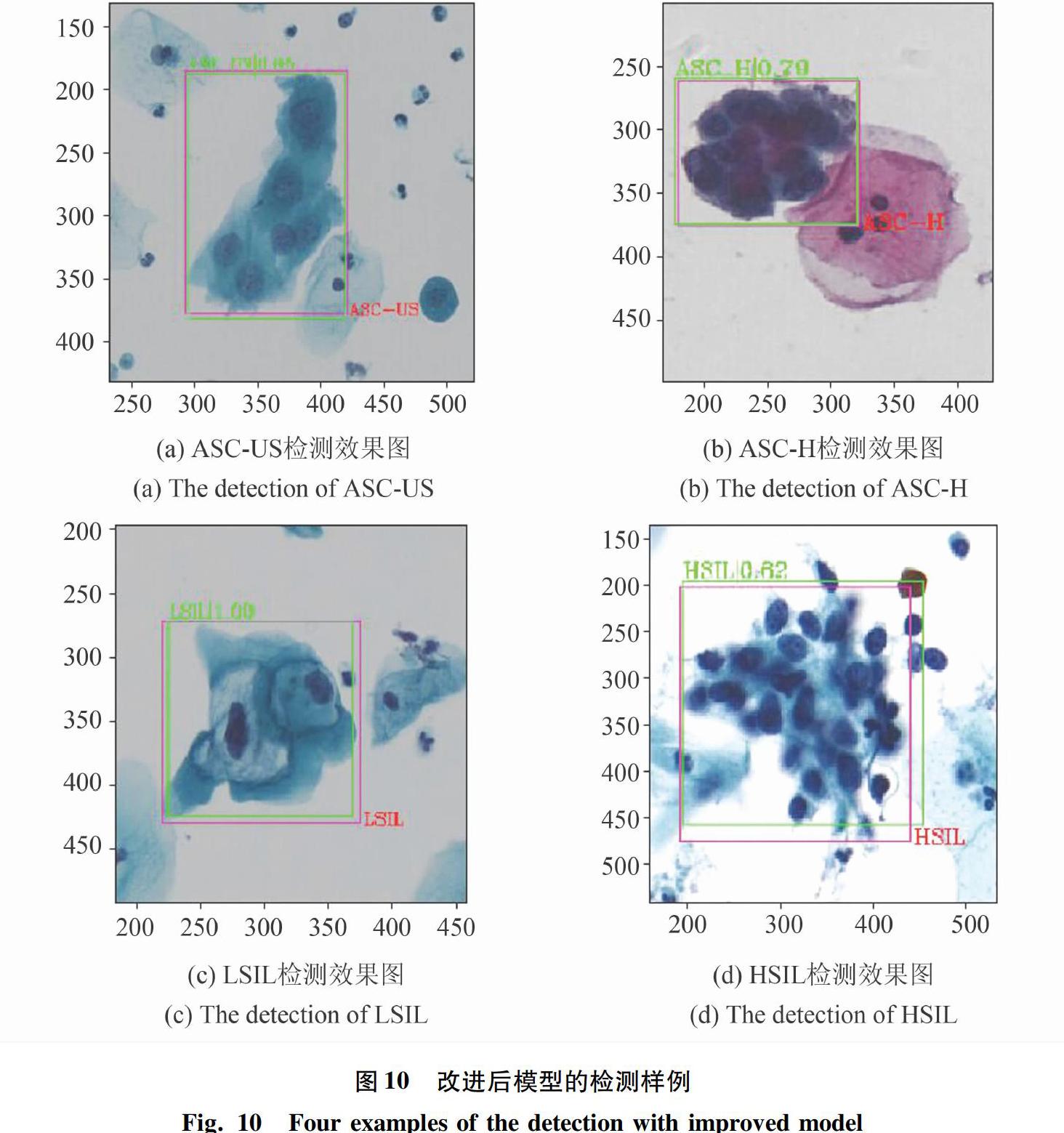

标注信息不参与模型预测过程,只参与模型评估过程。将一张测试图像输入网络,经过训练好的骨干网络提取特征,再将特征图输入到区域推荐网络,输出推荐区域,最后将推荐区域的特征图输入到后续的具体分类网络和检测框回归网络,输出细胞的具体分类和检测框。图10展示的是改进后的模型对测试集样本中4类阳性细胞的检测样例图。其中,绿色的框为模型检测结果,标记了阳性细胞的类别和识别置信度,分别是(ASC_US,0.85)、(ASC_H,0.79)、(LSIL,1.00)、(HSIL,0.62);红色框为标注框,是病理医生对该细胞的标注类别。

检测指标的定义见表3。由于目标检测任务不仅需要考虑检测框中的目标是否准确,还需要考虑检测框是否检测到足够全的目标,所以本文使用的模型评价指标是mAP(meanAveragePrecision),即各个类别AP的平均值。某个类别的AP值为该类别的P-R(Precision-Recall)曲线与横纵坐标轴围成区域的面积。查准率(precision)和查全率(recall)的数学定义如公式(5)和公式(6)所示:

precision= TP TP+FP ,(6)

recall= TP TP+FN .(7)

precision表示模型检测出的真正阳性细胞数与所有被检测为“阳性”的细胞数的比值;recall表示被检出的真正阳性细胞数与所有测试图片中医生标注的所有阳性细胞数的比值。目标检测任务通常使用一个置信度confidence∈[0,1]来表征模型对检測框中阳性细胞的置信度。可以自行设置一个置信度阈值(threshold),当某个检测框的置信度大于该阈值时,模型才认为该检测框为有效检测框。显然,如果threshold太高,模型的检测会非常严格,导致模型检测出的阳性细胞基本都是真实的阳性细胞,那么precision就会很高。同时,由于筛选条件过于严格,会漏检一些置信度比较低的真阳性细胞,导致recall变低。同理,threshold过低时,虽然recall很高,但是precision很低,所以precision和recall是一对在threshold的作用下互斥的指标。评价一个检测模型的效果,是能够找到一个合适的threshold阈值,使得precision和recall达到一个平衡的状态,这样的模型检测效果即准确又全面。P-R曲线即是以precision和recall这两个变量做出的曲线,横纵坐标分别为recall和precision。在本实验测试环节中,使用训练好的模型对14873张测试图像进行检测,取0到1(包括0和1)的置信度阈值,取值间隔为0.1。研究得到的P-R曲线如图11所示。由图11可知,从左到右第一个点和第二个点分别是阈值为0和0.1时对应的precision和recall值,以此类推,计算出11个阈值下的precision和recall值绘制P-R曲线。某一类阳性细胞的AP值即为对该类的PR曲线进行积分运算得到的数值。图11中的折线与坐标对角线(粉色实线)相交的点,即为precision和recall达到兼顾状态的平衡点,此时的threshold可以兼顾模型的查准率和查全率。由此可见,PR曲线的面积越大,AP越高,平衡点对应的precision和recall就越高,检测模型训练效果越好。

各个模型在测试集(14873张)上的各类阳性细胞的AP值和mAP值见表4。

4 結束语

基于改进后的FasterR-CNN的异常鳞状上皮细胞检测,其过程包含数据格式转换、数据预处理、创建实验数据集,设计基于FasterR-CNN结构不同的网络模型、训练不同的网络模型并进行评估和预测。针对阳性细胞的不规则形状和小尺度这两个检测难点,设计增加了DCN模块和FPN模块的检测网络。实验数据表明,改进后的网络也可以收敛,并且提高了模型的mAP指标,对阳性细胞有良好的检出效果。本文实验所用算法训练所得的模型,已经被应用在北京协和医院、潍坊市人民医院等三甲医院的病理科,并得到了病理医生的普遍认可。

参考文献

[1] 尤牧.宫颈液基细胞学检查(TCT)联合HPV筛查癌前期病变和早期宫颈癌的临床作用分析[J].名医,2020(13):89-90.

[2]龚平,张玲,赵廷宽,等.液基细胞学检查在宫颈病变筛查中的应用[J].长江大学学报自然科学版:医学(下旬),2014,11(24):40-41,4

[3]LINTY,GOYALP,GIRSHICKR,etal.Focallossfordenseobjectdetection[C]//2017IEEEInternationalConferenceonComputerVision(ICCV).Venice,Italy:IEEE,2017:2999-3007.

[4]LIUW,ANGUELOVD,ERHAND,etal.SSD:Singleshotmultiboxdetector[M]//LEIBEB,MATASJ,SEBEN,etal.EuropeanConferenceonComputerVision,LectureNotesinComputerScience.Cham:Springer,2016:21-37.

[5]REDMONJ,DIVVALAS,GIRSHICKR,etal.Youonlylookonce:Unified,real-timeobjectdetection[C]//IEEEConferenceonComputerVisionandPatternRecognition.LasVegas:IEEE,2015:779-788.

[6]RENS,HEK,GIRSHICKR,etal.Fasterr-cnn:Towardsreal-timeobjectdetectionwithregionproposalnetworks[C]//AdvancesinNeuralInformationProcessingSystems.Montreal:dblp,2015:91-99.

[7]DAIJ,QIH,XIONGY,etal.Deformableconvolutionalnetworks[C]//ProceedingsoftheIEEEInternationalConferenceonComputerVision.Venice,Italy:IEEE,2017:764-773.

[8]LINTY,DOLLRP,GIRSHICKR,etal.Featurepyramidnetworksforobjectdetection[C]//ProceedingsoftheIEEEConferenceonComputerVisionandPatternRecognition.Honolulu,HI,USA:IEEE,2017:2117-2125.