基于卷积神经网络的特征描述子学习

2020-12-26马正见文志诚

马正见 文志诚

【摘 要】随着深度学习的发展,作为图像任务基础的特征描述子开始倾向于通过卷积神经网络学习。目前的卷积神经网络模型大多采用交叉熵损失项进行约束,通过大量的输入数据训练网络。但由于缺乏细节上的约束,因此训练的网络模型特征提取能力并不优秀。针对以上问题,文章提出一种新的浅层神经网络模型,并在此基础上通过改进采样策略以获得更多的训练样本,使用复合的损失项对网络训练过程进行约束。实验表明,提出的神经网络模型能够获得更紧凑的特征描述子,特征提取的能力更强。

【关键词】卷积神经网络;特征提取;特征描述子;特征匹配

【中图分类号】TP391.41 【文献标识码】A 【文章编号】1674-0688(2020)07-0041-03

特征匹配是计算机视觉的基础任务,其中涉及的主要问题是对图像局部区域进行特征描述,以获得能更好表达图像局部区域信息的特征描述子。

早期的研究工作倾向于手工设计的描述子,包含SIFT[1]、SURF[2]、ORB[3]等。这一类描述子依赖人类对图像像素分布的认知,在早期的研究中占主导地位。

随着大规模带有标签的图像数据集的出现,神经网络开始广泛用于处理计算机视觉相关任务。其中,P Fischer等人在文献[4]中证明从ImageNet[5]神经网络最后一层学习到的特征描述子在性能上比传统SIFT更优秀。S Zagoruyko等人在文献[6]中对不同网络模型进行测试,实验证明基于学习方式获得的描述子性能优于手工设计的描述子。

1 基于学习的卷积神经网络

基于数据学习的方式从给定的数据集中训练一个能准确区分匹配与非匹配输入的神经网络。对于两个输入xi与xj,分别将它们通过初始的卷积神经网络后获得相对应的特征描述子yi、yj,将它们之间的匹配程度通过一个距离进行衡量,距离在阈值范围内则视为匹配,否则为非匹配。

输入的图像数据通过卷积神经网络进行特征信息提取,其中最关键的是卷积和全连接处理。卷积就是对输入进行局部特征提取,而全连接则是将提取到的局部特征进行组合描述,全连接层也可以视为一个特殊的卷积。

像素点在前一层图像的特征提取范围称为感受野。当像素点所处的层数越深,感受野越大,能获取的特征信息也越多。卷积过程如公式(1)。

xn+1=sign(f(w,xn)+b)(1)

其中,xn代表當前卷积层的输入,w与b是卷积层需要学习的权重和偏置,f为线性变换函数,sign为激励函数,xn+1为当前卷积层的输出。

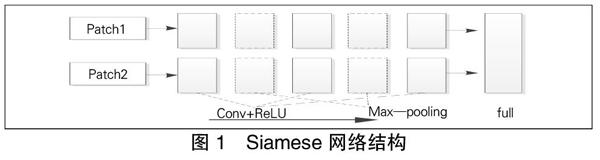

Siamese是一个学习阶段常用的网络模型,它由两个共享参数的分支构成。在训练时分别将两个训练图像数据通过网络的分支提取特征向量,最后一层以一个相似度函数对两个向量进行相似性评估。整个网络结构如图1所示。

图1由左到右分别为输入的图像patch、3个卷积层及2个池化层和1个相似度函数度量层,其中2个分支的卷积层与池化层的参数保持一致。另一种Siamese网络模型卷积与池化层中的参数由两个分支各自进行学习。文献[6]对网络结构进行了改进,引入中心环绕双流结构,将输入的64x64的图像数据分为中心裁剪的32x32和下采样的32x32两个输入,分别用两个Siamese网络模型进行计算,减少了输入数据的维度,加速了网络模型的学习速度。

为了加速学习到的特征描述子的匹配,X Han等人提出对MatchNet[7]网络将特征向量学习过程与特征向量匹配过程进行拆分,拆分后学习到的特征向量可以进行多次匹配。同时,他们还在特征向量学习网络的最后加入了一个瓶颈层,实现了参数降维的效果。

2 基于卷积神经网络的描述子学习

2.1 三元组样本采样策略

由上文可知,在训练过程中需要不断地使用训练样本来更新参数。基于之前研究者的经验,只有具有区分度的训练样本,才能促进参数的更新,而不具备区分度的样本,不仅对网络的训练毫无意义,还造成大量计算损失。

虽然类似于文献[8]提出的一系列采样策略能获得一些优质样本,但都需要大量的原始数据作为支撑。为了解决这个问题,本文提出一种新的采样策略,在这种策略下,即使在原始数据较少的情况下也能采集到足够多的训练样本。

记批次内样本为X={x1,y1,…,xm,ym,…,xn,yn},其中上标相同的两个样本为一对匹配的3D点。通过网络后的描述子为Y={x1,y1,…,xm,ym,…,xn,yn}。对应的点为正例样本,同批次中计算出距离最远的点为负例样本。两点间距离计算:

其中,q为描述子的维度。为了获得距离最大的硬性负样本,对样本点间距离计算结果以距离矩阵D表示。这里同类间的点不进行计算以免出现距离为零。距离矩阵D可表示:

式中的2为距离公式d中计算出的通项,后者为距离计算余项的向量表示。距离矩阵D对角线上的项为匹配点的距离,其余项为非匹配点距离。对任意一个锚点,可以从距离矩阵中获取它的匹配点及距离最小的非匹配点,这3个点组合即形成三元组样本数据。

这里本文引入两个额外的计算,即分别计算Y中x、y类别中点之间的相对距离,距离矩阵记为DX、DY。距离项越小,则说明两个描述子的位分布越相似,反之差异大。若两个描述子与锚点的距离都很近并且它两的位分布差异大,那么这两个描述子对应的点都可以作为非匹配点进行采样。因为位布差异大,所影响的参数位置不一样,所以都能很好地促进网络参数学习。

2.2 损失函数选择

描述子的相似性损失约束的是描述子提取特征信息的能力。具体体现为减小样本中匹配的点之间的距离,增加非匹配点间的距离。神经网络将调整参数满足这种结果。相似性约束项以公式可以表示如下:

描述子的匹配如图2所示。样本中的点视为同类的类内点和非同类的类间点,那么描述子的匹配就可以看做类间点的择优问题。之前的研究倾向于研究类间的关系,忽视了类内点蕴含的信息。本文将加深对类间点距离信息进行利用。

以图2中匹配对(x2,y2)为例。计算x2与其他类内点间的距离,比如与x1点间的距离为d1。y2为匹配点,则它与x2的类间距离小,描述子的位分布相似,与x1计算的距离也应当近似于d1。同理,作为x1类间匹配点的y1点到y2的距离也应当非常接近d1。本文将这种类内、类间关系进行如下约束:

这里的两个类间距离的值可以直接从“2.1”中计算的DX、DY获得。若两个锚点间的距离较大,那它们匹配点之间的距离也应该较大,类间约束项就是约束神经网络参数向这一目标进行更新。由于距离过大的类之间的作用并不明显,再进行约束反而会使结果变差,因此这里用U限定参与计算的类内点的范围。

描述子的紧凑性约束目的是使神经网络产生的描述子位分布均匀,这里设计的约束项:

其中,B为描述子的维度,S为每批次训练样本的数目。通过最小化描述子紧凑性损失项使描述子在维度较低的情况下携带更多的特征信息。

由于各个损失函数对训练过程的影响不同,因此需要对它们添加一个影响因子,于是完整的损失函数可以表示如下:

2.3 训练的卷积神经网络模型

由于输入的训练图像尺寸相对较小,因此选择的卷积神经网络层数较浅,其结构包括1个输入层、6个卷积层和1个全连接层,在池化层的选择上摒弃了传统的最大、平均值池化方式,选择的是能更好保留信息的跨步卷积。同时,为了加速网络学习速率,在每次卷积后进行归一化处理。优化器选择的是Adam[9]优化器。

3 实验与分析

用于实验的数據集有Brown数据集和Oxford数据集。用数据集中带标签的数据训练网络模型到收敛,再在数据集上对训练好的模型进行测试以检测描述子的各项能力。

3.1 描述子性能验证

用Brown数据集检验描述子的特征提取能力,它包含3个子数据集。用1个子集进行网络模型训练,然后在其他子集上测试。各类模型在召回率为95%的数据集上进行训练测试,测试结果见表1。

从表1的结果可以看到,基于学习方式获得的描述子性能远远优于基于手工设计的描述子。每个输入的样本都对卷积神经网络的参数进行调整,当进行多次的优化后网络参数达到一个稳定的值不再变动。通过不断地优化,使得网络拥有更强的图像细微特征提取、组合能力。

3.2 关键点匹配实验

衡量一个描述子性能最重要的一个部分就是描述子进行匹配的准确率。这里使用Oxford基准数据集。用特征点检测器提取特征点周围像素作为神经网络的输入,实验结果如图3所示。

基于学习方式获得的特征描述子总体的性能比手工设计的描述子要好得多。尤其是SIFT还作为最优秀的手工设计方法之一,在同样的实验环境下总体的表现相较于基于学习方式的描述子略差一些。本文的算法总体上的结果都有很好的表现,充分说明了使用的约束项加强了卷积神经网络的特征提取能力。

3.3 描述子的紧凑性

通常,优秀的描述子都应该具备紧凑性质,占用更少的空间并包含更多的信息。满足这样条件的描述子应当在每个位分布上居于一个平衡的位置,在某个信息位上不能总是出现固定的值,这样相同的值使描述子的区分性能有所降低。

这里通过随机选取的测试点对描述子的紧凑性进行实验。实验结果如图4所示。

由图4可以看到,随机挑选出来的测试点生成的描述子位的平均分布大体上靠近零,意味生成的描述子的各个位在零上下分布较为均匀,这样的描述子能携带的信息量大。形成这样均匀的位分布的主要原因是损失函数中对描述子紧凑性的约束,致使卷积神经网络学习到更优质的描述子。

4 总结与展望

本文提出一种新的采样策略获取更多数目的训练样本,同时引入多个损失项以约束卷积神经网络参数更新方向,提升了生成描述子的性能。实验表明,通过本文方法获得的描述子在匹配性能及紧凑性上比传统手工设计更好。但和大多数网络结构一样,未解决图像模糊带来的问题,这也将是下一步我们要解决的一个重要问题。

参 考 文 献

[1]Lowe D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Com-puter Vision,2004,60(2):91-110.

[2]Bay H,Tuytelaars T,Gool L V.SURF:Speeded up robust features[C].Proc of the 9th European Conferenceon Computer Vision,2006:404-417.

[3]Rublee E,Rabaud V,Konolige K,et al.ORB:An efficient alternative to SIFT or SURF[C].Proceedings of IEEE International Conference on Computer Vision,2012:2564-2571.

[4]Fischer P,Dosovitskiy A,Brox T.Descriptor mat-

ching with convolutional neural networks:a comparison to sift[J].arXiv preprint arXiv,2014: (1405):5769.

[5]Krizhevsky A,Sutskever I,Hinton G E.Imagenet classification with deep convolutional neural networks[C].Advances in neural information processing systems,2012:1097-1105.

[6]Zagoruyko S,Komodakis N.Learning to compare image patches via convolutional neuralnetworks[C].Proceedings of the IEEE conference on computer vision and pattern recognition,2015:4353-4361.

[7]Han X,Leung T,Jia Y,et al.Matchnet:Unifying feature and metric learning for patch-based matching[C].Proceedings of the IEEE Conference on Co-mputer Vision and Pattern Recognition,2015:3279-3286.

[8]Mishchuk A,Mishkin D,Radenovic F,et al.Wo-rking hard to know your neighbor's margins:Local descriptor learning loss[C].Advances in Neural Information Processing Systems,2017:4826-4837.

[9]Kingma D P,Ba J.Adam:A method for stochasticoptimization[J].arXiv preprint arXiv,2014(1412):6980.