多无人机监督控制系统设计与实践

2020-10-16吴立珍牛轶峰

吴立珍,牛轶峰,王 菖,方 斌

(1. 国防科技大学智能科学学院,长沙410073;2. 湖南警察学院交通管理系,长沙410138)

1 引 言

随着无人机系统技术的迅猛发展,其应用范畴不断拓展,应用样式呈现出由独立执行任务向多无人机协同、有人机/无人机协同加速发展的趋势,对多机指挥控制提出新的挑战[1]。一方面,随着传感器和数据链性能的不断提升,多机协同带来的海量信息叠加显示和融合处理难度不断增大,与操作员有限的信息关注能力形成矛盾;另一方面,多样化协同控制需求使操作员操作难度增大,需要将更多的精力用于处理多机冲突消解和任务协调。在这种情况下,传统的人在回路中(Man-in-the-loop)的交互控制方式显然已不能适应,极易出现操作员误判和误操作,从而导致事故发生[2]。

监督控制(Supervisory Control)作为一种人在回路上(Man-on-the-loop)的控制方式[3],能够支持操作员通过自主代理的方法实现上层操作员对底层多无人机平台的监督与管理,其核心是面向人机智能融合,根据多任务动态分配原则[4],通过操作员和自主系统二者决策等级的适时变化,实现人机之间的主动混合,达到少量操作员控制更多无人机的目标。本文在深入研究监督控制技术发展的基础上,设计和实现了一种基于多传感器测量和多模态交互的多无人机监督控制系统,并通过多机协同探测任务仿真试验验证了系统的有效性。

2 多无人机监督控制技术研究现状

随着无人机自主能力的提高,操作员对无人机的控制由低级的基于行为的控制转变为高级的基于知识的控制,这种基于知识的控制就是监督控制。在监督控制中,无人机的飞行控制基本由无人机系统自主完成,操作员主要负责高层的载荷管理和任务控制。监督控制使得单个操作员控制多架无人机成为可能,一方面平台自动化程度的提高为这种转变提供了技术支持,另一方面协同任务带来的交互需求为这种转变提供了动力。

监督控制技术的研究主要源于多无人机分布式作战的指挥控制需求。自2004年 起,Ruff[5]、Dixon[6]、Dunlap[7]等研究初步建立了监督控制的基本概念和体系架构,客观分析了自动化组件在监督控制中的作用以及对整体系统性能的影响。麻省理工学院的Cummings等[8-9]深入研究了单操作员能够控制无人机的最大数量问题,分析了制约操作员监督控制性能的关键因素。国内相关研究尚处于概念探索阶段,人(地面站操作员或位于有人机上的飞行员)在协同系统中的重要性及其同无人机之间的协作交互关系未得到足够重视。国防科技大学提出一种多无人机监督控制系统的混合三层结构[10],即可变自主级别控制器、任务管理系统、智能人-系统接口模块,用于降低地面站指挥控制无人机的人机比;同时,面向有人机/无人机协同任务控制设计了基于自然语言的交互接口[11]。空军工程大学的黄长强等[12]提出人机协同感知-决策-执行的半自主式武器控制思想,并设计了基于人机协同的无人攻击机武器控制系统框架。浙江大学[13]提出人机共商决策方法,将人的智慧与机器的智能融合一体,提高决策的可靠性,具有很好的借鉴价值。

在监督控制技术验证方面,美、欧等军事强国竞相开展了一系列试验项目,尤其在近年来呈现出加速发展的态势。按照监督控制系统部署方式的不同,大致可以分为基于地面站的监督控制以及基于有人机的监督控制两类。

(1)基于地面站的监督控制技术验证

早期验证项目主要聚焦于概念演示和技术探索,代表性的项目包括:波音公司开展的单操作员控制多架X-45A 无人作战飞机项目以及单操作员同时管理3 架扫描鹰无人作战飞机项目;诺斯罗普·格鲁门公司完成的航母空域内同时控制4架X-47B无人作战飞机模拟演练项目;洛克希德·马丁公司基于沙漠鹰III 型无人机演示的单操作员管理多无人系统项目;雷锡恩公司推出的能同时控制8 架无人机的通用控制系统(UCS)等[14]。

近年来,监督控制技术验证不断深化,最具影响力的是北约HFM-170 项目[15]。该项目由多个国家参与的15 个演示验证项目组成,旨在针对多无人系统监督控制框架下的一系列核心技术分别展开技术验证,具体项目情况如表1所示。

(2)基于有人机的监督控制技术验证

有人机/无人机协同是监督控制技术应用的重要载体和方向。英国QinetiQ 公司在2007年进行的狂风战斗机飞行员监督控制4 架无人机的飞行试验是典型的基于有人机的监督控制技术验证,该项目成功实现了操作员高层决策与无人机系统自主执行战术任务的有机结合。

德国慕尼黑国防军大学于2007—2011年间联合德国航空航天中心等开展了有人/无人编队(MUMT)项目[16],旨在利用无人机提高有人机态势感知能力、缩短任务完成时间、降低有人机风险。

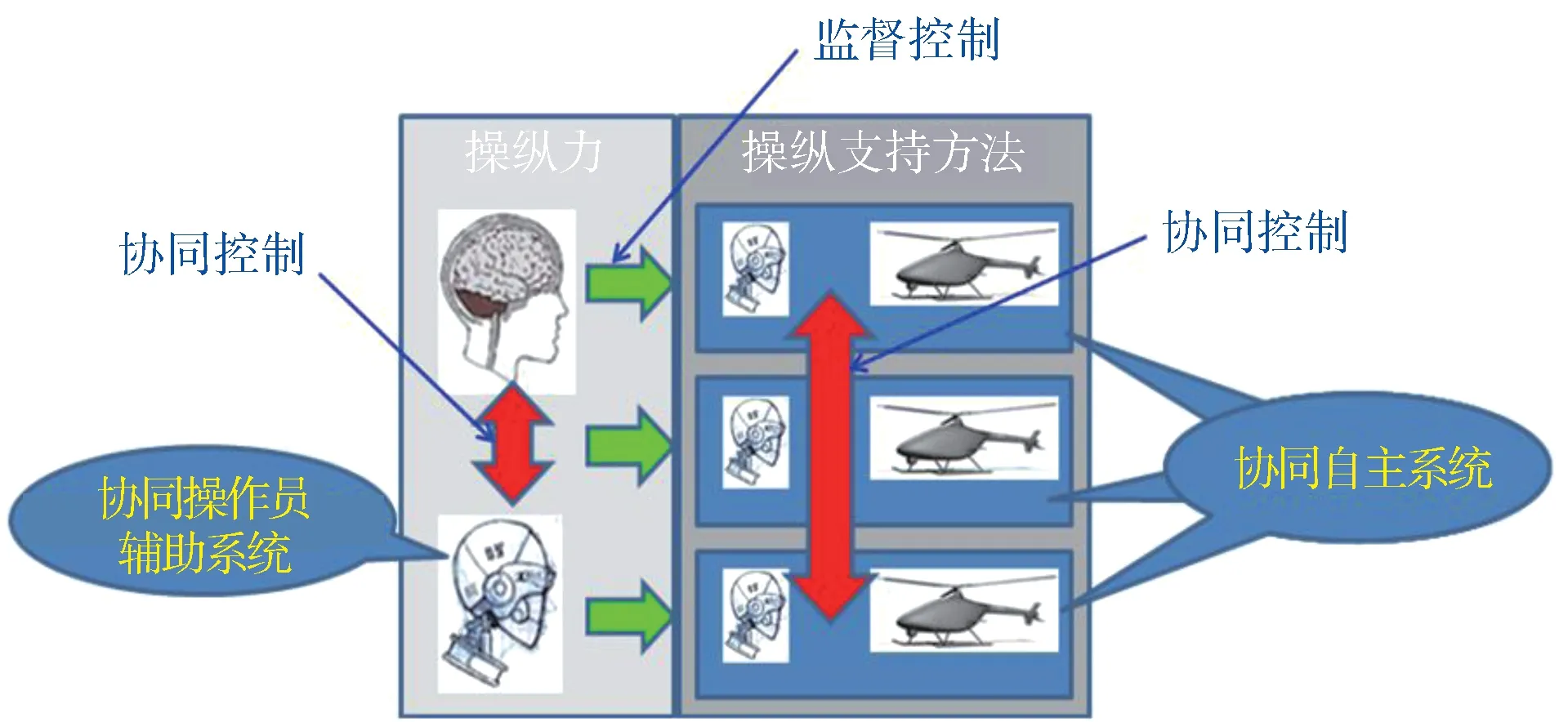

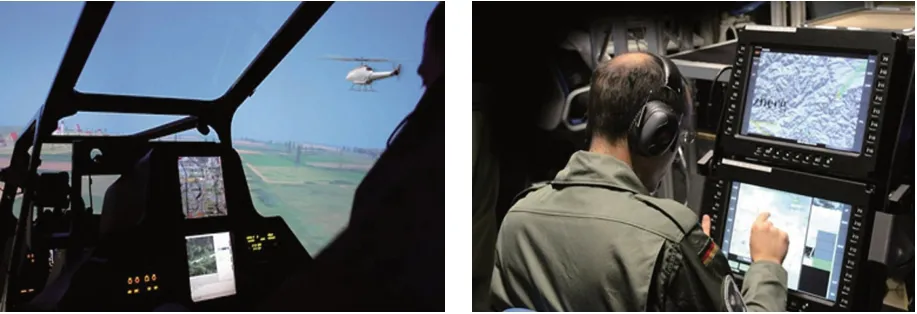

值得关注的是,该项目在设计操作员辅助系统时采用了协同控制和监督控制两种模式,提出一种双模式认知自动化方法,以替代传统的自动化方法(图1),使得操作员辅助系统具备了复杂任务决策能力。同时,设计了无人机人工认知单元(ACU),使无人机具备根据自身感知态势理解有人机指派的目标或任务能力。该项目实现了人-机器(无人机操作员辅助系统)、机器(ACU)-机器(ACU)之间的有效协同,通过双座模拟器(图2)完成了协同侦察/运输、协同防空压制/打击等典型任务的仿真研究。

表1 HFM-170项目情况Table 1 HFM-170 project

图1 双模式认知自动化方法Fig.1 Dual-mode cognitive automation

图2 德国MUM-T项目仿真环境Fig.2 Simulation environment for MUM-T

近年来,有人机/无人机协同作战模式的蓬勃发展进一步推动了监督控制技术的进步。美国通用原子公司提出了16 架捕食者C 复仇者(Avenger)无人机集群在2 架F-22 战斗机指挥下协同作战概念(图3),涉及的关键技术主要包括开放式的监督控制体系结构、人机交互以及多机集群控制等。

图3 捕食者C复仇者与F-22协同作战Fig.3 Cooperation between Avenger and F-22

在监督控制的技术框架下,2017年,美空军忠诚僚机项目开展了基于无人化F-16 战斗机的有人机/无人机编组技术演示,验证了有人/无人协同开放式系统架构、僚机自主规划并适应对地打击任务、以及意外事件处置等能力。2018年,美军拒止环境下无人机协同作战项目基于RQ-23 虎鲨无人机,开展了单操作员指挥无人机编队执行战术侦察、压制/摧毁敌防空系统等任务的技术验证[17]。2019年2月,完成了6 架虎鲨无人机和14 架仿真机的飞行试验验证。2019年5月,美国国防预先研究计划局(DARPA)为了实现其新型作战概念——马赛克战,而启动了空战演进(ACE)项目。该项目旨在通过建立操作员与无人系统之间可信任的互动,加速飞行员从操作员到任务指挥官的转变。

应当指出,国内外目前在监督控制方面取得了一定的研究成果,但主要是基于相对安全的空域或弱对抗条件。有人机/无人机在对抗空域协同执行作战任务,飞行员将面临更复杂的问题,比如:工作量大幅增加,环境压迫性和任务复杂度显著提升等。在这种复杂快变的战场环境中同时实现多无人机控制,现有的方法可能失效,需要深入研究如何能够充分发挥人和自主系统的各自优势,尽可能降低人的底层操作负担,实现基于人机认知模型的高效协同。

3 系统设计

本文设计的监督控制系统主要由无人机操作员状态监视模块和多无人机混合主动控制模块组成。前者主要用于实时评估操作员的工作状态,获取操作员当前适合的决策等级,并避免“人不在回路”事件的发生。后者则以操纵员状态为依据,实现人机多种权限的混合主动控制。

3.1 无人机操作员状态监视模块

现有操作员状态监视的研究主要集中在操作员生理特征方面,大多采用脑电图和心电图分析的方式。为了减少对操作员的干扰,减少接触式传感器的使用,本文设计了一种基于多传感器融合的无人机操作员状态监视模块。

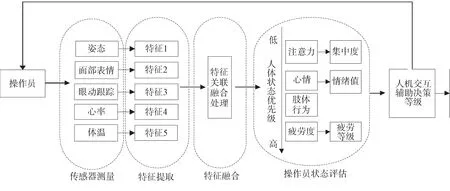

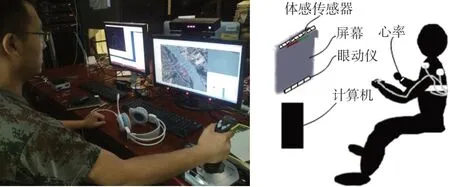

该模块主要采集的数据包括:姿态特征、面部表情、眼睛疲劳度、心率和体温特征等。通过对这些数据的实时测量和融合可分析得出操作员当前的状态、行为和注意力,输出操作员工作状态评估结果,最后给出人机交互中操作员的决策等级,为后续的监督控制提供依据。模块框架和信息流程如图4所示。

图4 操作员状态监视模块框架Fig.4 Framework of state monitoring module for the UAS operator

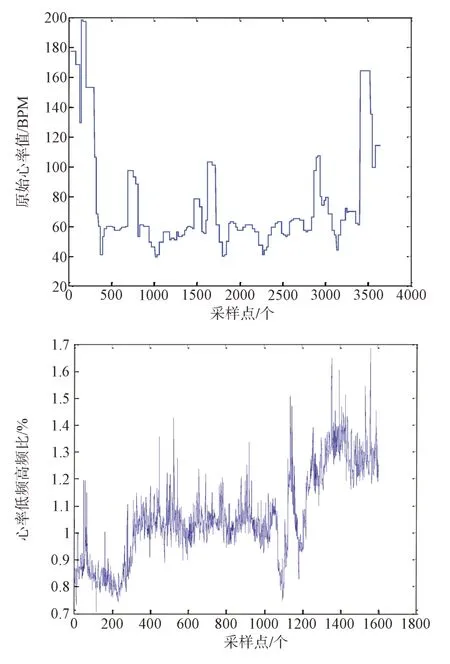

(1)姿态特征检测

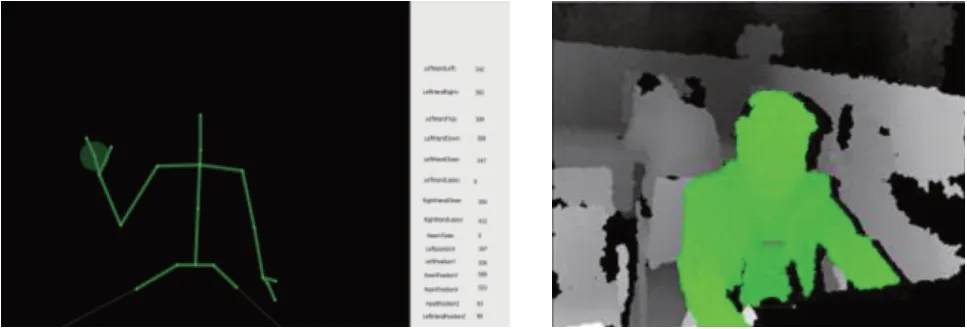

姿态特征主要采集面部以外身体其他部位(如手势、躯干、头部)的状态,可通过交互式传感器获取的深度图像进行检测(图5)。测量姿态特征的目的,主要是通过分析姿态动作的各种特性(如行为动作的方式、力度、频率等),判断操作员的工作状态。比如,当操作员疲劳的时候,头部的摆动频率会增加。同时,手势等特征也可用于交互控制。

图5 姿态特征检测Fig.5 Attitude feature detection

以头部姿态检测为例,可以假设头部位置为Head(x,y,z),脖子的位置为Neck(x,y,z),则计算头部水平姿态为

头部俯仰姿态为

对于无人机操作员,如果头部位置超过设定阈值则判断操作员离开了视场中心位置;如果头部俯仰姿态超过设定阈值,即βH>Tmax或者βH<Tmin,则认为操作员可能低头或者抬头幅度过大。系统根据一段时间的频率数据分析,可用于判断操作员的疲劳度。

(2)面部表情识别

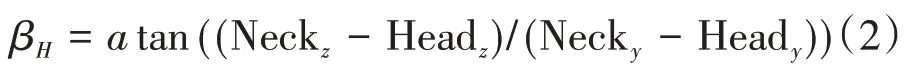

面部表情主要通过可见光图像进行检测识别。不同的表情会带来五官或者五官之间相对位置的变化,进而导致特征点连接形成的几何拓扑形状、大小、间距等发生相应变化。例如,当人惊恐的时候,嘴巴上的特征点会张开,眼睛上的特征点也会向上移动。识别出相应特征并依据人类情绪的相关模式进行归类分析,就可以基本实现情绪的把握。检测效果如图6所示。

图6 面部表情识别Fig.6 Facial expression recognition

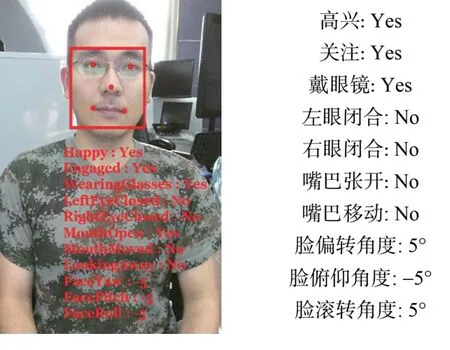

(3)眼睛疲劳度检测

系统通过眼动仪实现操作员的眼睛疲劳度检测。该设备的原理是采用近红外光源在眼睛和角膜上产生图像,进而进行检测识别和定位。眼睛疲劳度检测采用PERCLOS 指标,即单位时间内眼睛闭合的次数。相关研究指出,该指标是公认的疲劳检测的视觉参数,它反映了缓慢的眼皮闭合,可以有效表达精神疲劳程度。图7 给出了PERCLOS 检测示意。

图7 PERCLOS眼睛状态检测Fig.7 Eye state detection using PERCLOS

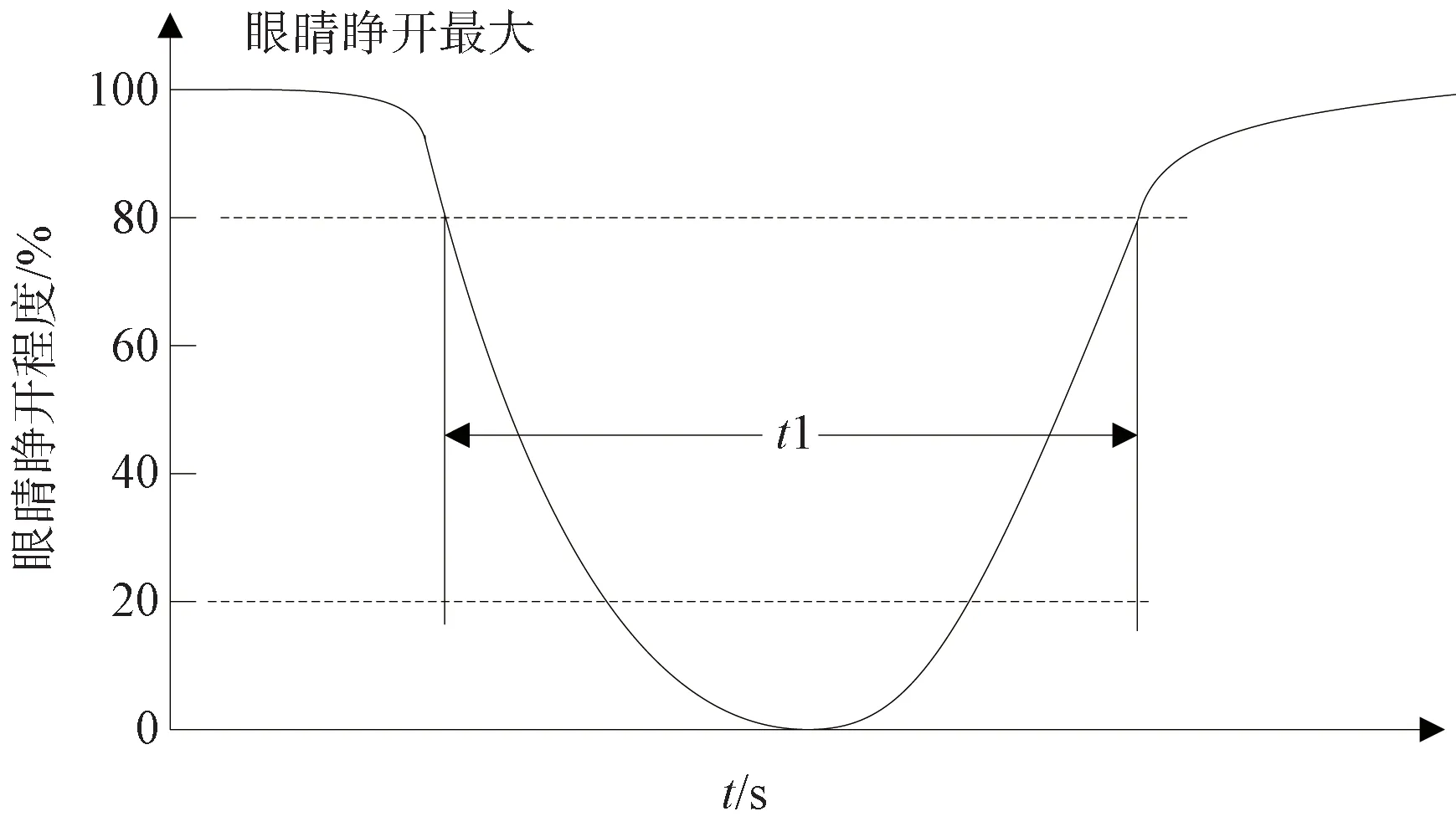

(4)心率和体温特征检测

心率变异性(Heart Rate Variability,HRV)与人的负荷水平、疲劳程度有关,主要用心率传感器进行测量[18]。通过一段时间内心率值的低频和高频数据的比值,可以估计操作员当前的身体状态。图8 为获取的操作员心率数据,其中上图为原始心率值,下图为心率低频高频的比值,可以明显看出操作员心率特征变化。

体温特征与操作员心情状态也存在相关性。相关研究表明,不同情绪下身体的热量分布存在一定的模式,比如愤怒时,头部和胸部的温度会升高;沮丧时全身体温会降低。根据测量身体多个部位的温度值,与相关模式对比分析,可用于估计操作员当前的身体状态和心情。

图8 心率检测Fig.8 Heart rate detection

(5)基于神经网络学习的操作员状态融合评估

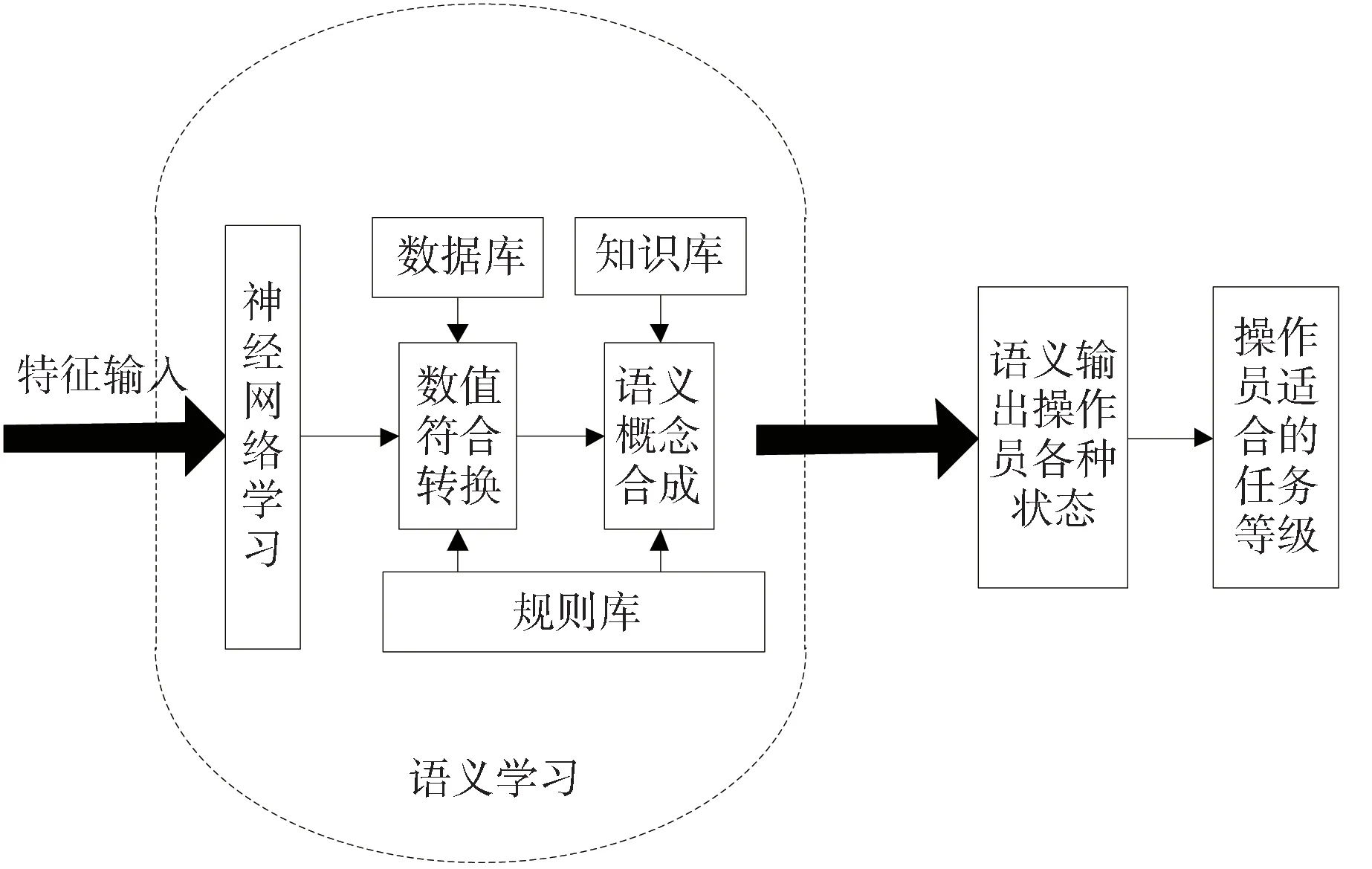

采用基于神经网络学习的操作员状态融合评估方法,结构如图9所示。

图9 基于神经网络学习的状态评估Fig.9 State evaluation based on neural network learning

主要步骤如下:

①根据传感器信息构建多维特征空间样本库。确定操作员状态特征输入矢量X(姿态、表情、眼动跟踪、心率、体温),目标矢量T(关注度、心情、肢体行为、疲劳度)。输入输出之间存在一定对应关系。

②设计神经网络训练学习感知器[19]。

③根据不同的操作员样本,进行训练,建立传感器特征与语义之间的映射关系。

首先,对状态模型进行语义量化,选择多对形容词用于建立操作员状态模型形容词集(表2),对每个形容词对进行多等级量化,并分别设定边界条件。如“疲劳的-平静的”,其评价可以是重度疲劳、轻微疲劳、良好、非常好。

表2 操作员状态模型形容词集Table 2 The adjective set of operator state model

其次,建立状态空间。按上述量化方法,获得操作员某一状态m的第n对形容词的评价量化值,得到一维矩阵按照下式标准化得到Xm,其中

设E为公共因子矩阵,Z为载荷矩阵,其中E的第m行em= (em1,em2,...,emn)对应操作员状态m在状态空间的坐标,载荷矩阵Z的第n行Zn=(Zn1,Zn2,...,Znk)对应形容词n在K维空间的坐标。

设U为独特因子,D作为独特因子的权值,对获得的矩阵Xm做因子分析:

通过以上步骤,将原先的N维状态空间降至K维,建立形容词与操作员向量的映射。

④建立语义组合构建的树形结构,采用D-S证据决策操作员的状态为:

其中,Ti为目标矢量T的分量,λi为各种状态的权值系数。

3.2 多无人机混合主动控制模块

混合主动控制是实现监督控制的核心。它通过综合考虑操作员实时状态(适合的决策等级)、无人机的自主能力、环境和任务的复杂程度等因素,实现人机之间多等级的、权限适时可变的控制模态。在上一节的基础上,本节建立了一种基于多模态交互的多无人机混合主动控制系统。

为了实现多无人机的同时控制,操作员必须以简单、直观的方式与无人机交互,将认知精力集中于关键活动和关键环节上,如目视确认、打击决策等。对此,设计了语音、眼动、手势、操纵杆、触摸屏等多模态的自然交互控制接口。不同的交互模态带来的操作员负荷不同,适应于不同的操作员状态和决策等级,并支持任务层、导航层、底层等多种控制模式。

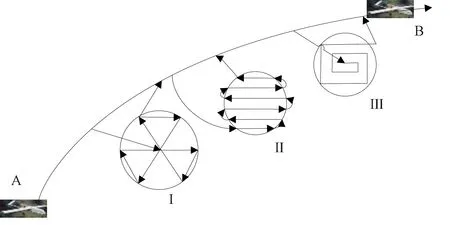

其中,语音控制模态用于控制无人机执行特定任务指令,眼动控制模态用于控制无人机实现目标锁定,二者都属于任务层控制;手势控制模态(如指向信号等)用于无人机飞行方向引导、编队避碰、编队变换等,属于导航层控制;操纵杆控制模态一般用于操纵无人机底层飞行控制。此外,操作员还可以利用触摸屏获取无人机状态、当前任务、操作状态反馈等信息,并进行载荷控制、路径规划、航点导航等任务。图10 展示了一种多模态控制过程。假设无人机当前从A 点到B 点运动,并执行沿途目标搜索任务。根据任务需求,Ⅰ和Ⅱ可以分别通过语音或者手势指令实现无人机进入区域搜索模式和平行搜索模式。当无人机需要进入指定区域的时候,可以采用操作杆进行精准控制。Ⅲ为目标发现后,可以利用眼动跟踪实现对目标的锁定。

图10 多模态控制过程Fig.10 Multimode control process

为了实现可变的自主权限控制,设计了无人机的四层控制模式:(1)自主控制模式:无人机不需要人的介入,自主完成任务,这种模式适用于简单任务,并且对无人机自主能力提出了很高的要求;(2)半自主模式:无人机具备一定程度的机载任务控制能力,可以在人给定抽象任务条件下自主完成复杂任务规划;(3)自主飞行模式:无人机在人给定导航目标、编队控制指令、飞行路径(由控制站完成重规划)等前提下,自主进行路径跟踪和飞行控制。(4)手动模式:人可以直接对无人机和传感器进行操纵,对操作员精力要求较高。四种控制模式根据监督控制需求动态切换。

结合不同的操作员控制权限和平台控制权限,同时考虑实际面临的环境/任务复杂度等因素,可以通过模糊认知图等方法实现人机控制权限的实时调节,进而实现人机混合主动控制(图11)。例如在目标检测时,系统可根据图像中的目标数量以及当前操作员状态等信息,自主提示用户可以采用什么样的控制模式,以最大化发挥人和机器的优势。

图11 混合主动控制模块框架Fig.11 Framework of mixed initiative control module

4 仿真结果及分析

4.1 实验环境

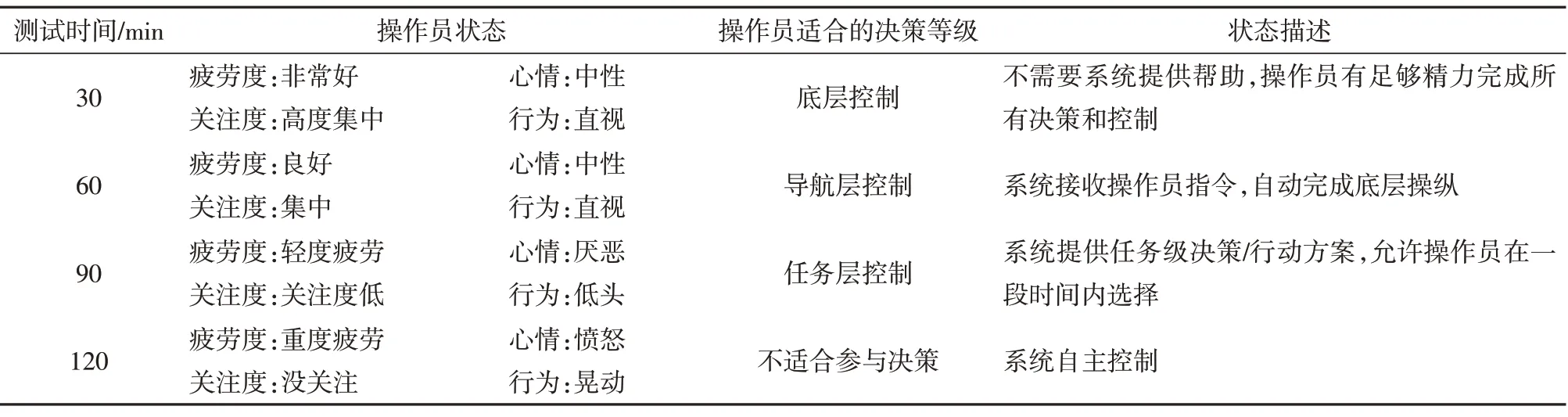

系统实验装置如图12 所示,采用了体感设备、眼动仪、心率和体温传感器等,所有传感器通过有线或无线的途径输入到计算机中。其中,体感设备采用了微软Kinect2,眼动仪采用Tobii eye X。

图12 监督控制系统实验装置Fig.12 Experimental devices of supervisory control system

实验任务设定为多无人机对地面多目标的协同搜索。任务区域如图13所示,其中C为待搜索区域的地图;A、B 分别为两架无人机机载传感器实时采集的可见光图像。图14 为多机协同路径规划获得的飞行航线,采用了凸多边形区域的无人机覆盖航迹规划算法[20],A、B 代表不同的无人机的飞行路径。

图13 多无人机协同目标检测场景Fig.13 The scene of multi UAS cooperative target detection

图14 区域搜索航线规划Fig.14 Path planning for regional search

4.2 仿真结果

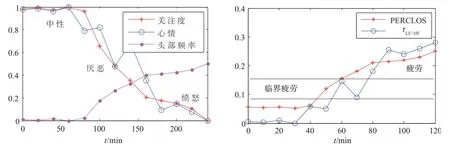

实验一:开展长时间工作情形下操作员状态的监视实验。设定姿态和表情检测频率为5Hz,眼动仪检测频率为20Hz,心率和体温检测频率为10Hz,通过融合评估,绘制出操作员状态随时间变化曲线,如图15 所示。其中,左图为关注度(注意力)、心情、头部动作频率等信息,右图为眼睛闭合PERCLOS 值、心率低频高频比等信息。可以看出,操作员随时间的变化,关注度会逐渐降低,心情变的厌恶和愤怒,头部的运动频率也相应的增加,反映了疲劳度的持续增加。

图15 操作员状态随时间变化的趋势图Fig.15 Operator status over time

表3为操作员状态与适合的决策等级随时间变化的情况。决策等级采用前文提出的四层划分。根据实验结果,在操作员连续紧张工作的情况下,工作能力会随着时间的变化而降低,决策等级也需要相应调整,以降低工作负荷。

表3 操作员状态与决策等级Table 3 Operator status and decision level

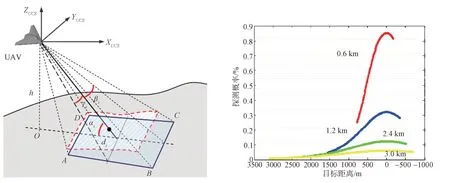

实验二:开展多目标协同探测实验。采用的传感器探测模型[21]如图16 所示。左图为无人机对地面目标探测的数学建模,其中传感器安装角度为斜向下30°;右图为无人机在不同高度探测目标的成功概率,横坐标0 点为目标位置,不同颜色曲线代表不同的飞行高度。无人机越靠近目标,目的探测概率越大;无人机飞行高度增加,目标探测概率减小。

基于上述探测概率模型,分别采用全自主控制探测以及混合主动控制探测展开实验比较,结果如图17 所示,不同颜色的方框代表目标点被探测的次数及探测位置。图17(b)中的蓝线和红线为无人机的飞行轨迹,其中蓝线为自动飞行轨迹,红线为手动飞行轨迹。M 区域为语音/手势指令控制的盘旋探测,N 区域为摇杆控制的目标探测。图17(c)中标示的Q区域对应图12任务环境的水域,不存在需要探测的目标,通过任务环境分析采用了绕行的方式提高整体效能。

图16 无人机地面目标探测概率模型Fig.16 Probability model for UAV ground target detection

针对特定目标P 和目标N 的探测结果如图18所示。其中,上图为目标P 的探测概率,下图为目标N 的探测概率,红色为混合主动控制的探测概率,蓝色为全自主控制的探测概率。可以看出,当P目标探测概率较低的时候,可以采用混合主动控制提高探测概率,针对N 目标探测概率较大的情形,自主探测效果更好,操作员可以给予系统足够的信任。

图18 特定目标的探测概率Fig.18 Detection probability of specific targets

5 结束语

本文针对无人机控制站操作员在操作控制多无人机时面临的工作负担过大、操作性能下降的问题,详细研究了多无人机监督控制系统的发展现状。从操作员状态评估和多模态自然交互出发,设计了一种基于多传感器的多无人机监督控制系统。系统通过传感器测量获取操作员相关状态数据,并利用神经网络方法实时评估操作员状态,获得当前人机交互辅助决策等级。根据该决策等级和多任务动态分配原则切换人的控制权限和无人机的控制权限,实现操作员对多无人机的混合主动控制。结果表明,该系统可实时评估操作员状态,并有效实现了多无人机的监督控制,相比于单纯自主控制能够有效提升人机协同系统的整体效能。

应当指出,多无人机监督控制在实际应用中仍然面临很大挑战:

(1)本文探索的基于多传感器测量的操作员状态评估受到监督控制系统部署环境的制约,嘈杂背景、复杂光照、以及有限空间等对语音、眼动、手势等交互手段形成干扰,测量存在不可预期的误差,需要进一步研究特定应用背景下的交互信息处理方法以提高测量结果的可信度。

(2)操作员状态的外在表现存在个性因素,也会伴随工作环境和工作压力的变化,呈现一定的差异。因此,传感器统计数据难以作为状态判断唯一的衡量标准,需要在应用环境中针对不同的操作员开展长时间适应性的学习和训练。

(3)复杂背景下多无人机监督控制面临高度的复杂性和不确定性,需要在混合主动控制框架下充分考虑各类动态意外事件,进一步深化研究控制权限的分配策略,既有限制的最大化自主系统的能力范围,又确保核心权限掌握在人类操作员手中。

(4)多无人机监督控制需要解决操作员对自主系统的信任问题。一方面要研究增强无人机自主系统的决策透明性、可解释性和可干预性,另一方面还要研究构建操作员对自主系统信任程度的模拟和度量手段,通过可量化的信任度建立和扩展人机互信,促进人机高效协同。