基于Transformer模型的机器翻译可解释性研究

2020-09-16官凤霞

官凤霞

摘要:目前而言,神经网络这项技术已经在机器翻译任务中取得了优秀的效果,但由于端到端模型的使用,虽然从翻译性能上看网络模型能够有效对跨语言信息进行捕获,但是对其中语义信息的学习方式始终少有了解,从而导致研究人员很难从外部对模型进行分析和改进。本文通过对目前主流的Transformer神经机器翻译模型方法进行实验,通过对训练得到的词向量进行分析,对神经机器翻译模型的可解释性进行研究。

关键词:机器翻译;可解释性;自然语言处理

1神经机器翻译模型

近年来,神经网络这项技术随着机器学习的广泛发展,在自然语言处理领域中取得了广泛的应用,其中机器翻译任务作为跨语言信息建模的重要方向之一,神经机器翻译技术也同样得到了众多的关注。但是由于目前的神经机器翻译模型往往采用的是端到端的模型,由于其黑箱性,内部如何对语言信息、跨语言互译关系进行捕获完全是通过数据驱动的方式训练而得的,最终导致所得到的模型如何实现机器翻译这个任务并不为外人所知,更进一步的影响就是如何改进这项技术、如何使用人类已有知识对其进行改进困难重重。因此,本文希望能够对目前所广泛使用的神经机器翻译模型进行分析,对训练好的模型可解释性进行分析,旨在帮助其他研究人员在后续更加方便地对模型性能进行改进。

目前而言,主流的神经机器翻译模型为谷歌团队提出的Transformer模型。Transformerkg型是一个基于注意力机制的神经机器翻译模型,它沿用了端到端机器翻译系统中的编码器解码器架构,在编码器、解碼器中通过相同的层堆叠的方式对源语和目标语进行建模。每一层中包括若干子层,如注意力子层、前馈神经网络子层等。其中自注意力子层主要用来对单语信息进行建模,而编码解码注意力子层主要用来对跨语言信息进行捕捉,即机器翻译的核心,找到源语片段如何翻译成对应的目标语译文。

2可解释性研究

本节将针对Transformer神经机器翻译模型的可解释性进行研究,主要从层堆叠模型中词向量信息的变化趋势以及注意力机制中学习到的句法信息两个角度出发对问题进行探讨。为保证分析实验的顺利进行,我们对方法中使用的分析方法也进行了介绍。

2.1分析方法

词向量信息的分析:为了对注意力权重中所包含的信息量进行分析,我们还使用信息熵来对当前词和其他词之间关联度的离散性质进行研究。信息熵值高表示关注程度不具体,低熵值表示关注相对来说更加明显,我们可以通过信息熵的变化来对训练好的模型中注意力机制部分进行分析。在注意力操作中的权重值可以告诉我们对于当前词汇而言哪个词更重要,我们可以通过对注意力机制中的权重进行排序,通过统计找出规律。

文本结构分析:由于Transformer结构中自注意力机制主要是对同一句子中不同位置的语言片段关联度进行建模,为了探索其中所学到的信息,我们可以将其与句法分析以及词性特征进行对比,探索词与词之间注意力权重的分布是否符合人类认知中的句法结构。例如,分析其中代词是否同其指代的词汇之间关联度更高等问题。

2.2实验设置

本文实验主要针对目前在神经机器翻译领域广泛使用的Transformer模型进行研究,具体代码使用的是Tensor2Tensor的开源项目。对于数据我们使用NISTl2的中英数据进行训练和分析。

2.3实验现象

词向量信息与模型层数的关系:

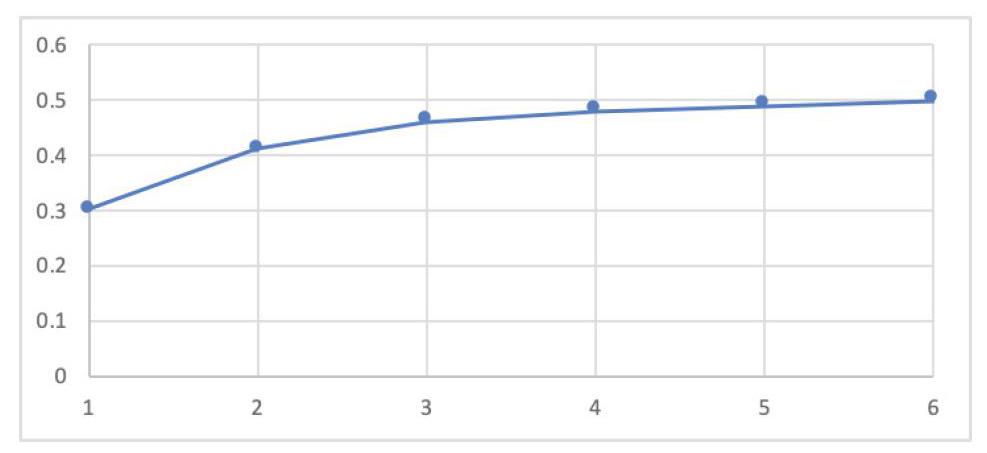

上图中横轴为Transformer模型中编码端的1-6层,纵轴表示的是测试集中相同输入句子中词向量的信息熵。我们可以看到随着层数的递增,词向量中所包含的信息实际上是越来越丰富的,其原因在于每个对应位置的词随着层数的递增均在不断从其他相关词汇中进行信息的提取。

词向量与句法结构的关联:实验中,我们还将注意与句法树进行了比较,希望找出注意力权重是否能反映一些语言规则。然而,权重与语法规则没有明显的相似性,但注意力权重仍然对一些句子成分表示更多的关注。在这部分实验里,我们发现了许多明显且有趣的对齐现象,不过我们还没有总结出清晰的语法规则,因此在这里不做过多解释。

3结束语

本文对基于Transformer模型的神经机器翻译系统可解释性进行研究,通过余弦相似度、句法分析等方式的研究对神经网络如何建模语言信息进行研究,发现随着模型中层数的递增,词向量中包含的信息量越来越大,这一点与人对其的认知相符。