P-R曲线与模型评估问题研究

2020-07-31张超

摘 要:现阶段深度学习作为一种实现机器学习的技术,在分析模型问题和评估模型的方法上基本一致。文章从评估模型的角度,以混淆矩阵为基础,通过常用的Accuracy,Precision以及Recall等衡量模型的预测能力。研究结合深度学习近几年的竞赛任务分析样本均衡与非均衡下几种评估模型方法的差异,从几种评估指标之间的联系讨论P-R曲线评估模型之间的相关性,以及P-R曲线在目标检测任务中作为评估模型方法的合理性。

关键词:评估标准;Accuracy;P-R曲线;mAP

中图分类号:TP181;TP311.1 文献标识码:A 文章编号:2096-4706(2020)04-0023-03

Abstract:At present,deep learning,as a technology to realize machine learning,is basically consistent in analyzing model problems and evaluating model methods. From the perspective of the evaluation model,based on the confusion matrix,this paper measures the prediction ability of the model from the commonly used Accuracy,Precision and Recall. This paper analyzes the differences of several evaluation models under the condition of sample equilibrium and non-equilibrium,discusses the correlation between the evaluation models of P-R curve from the relationship between several evaluation indexes,and discusses the rationality of P-R curve as the evaluation model method in the target detection task.

Keywords:model performance evaluation;Accuracy;P-R curve;mAP

0 引 言

在机器学习领域,模型评估的主流标准都以统计混淆矩阵下的TP(true positive)、FP(false negative)、TN(true negative)、FN(false positive)去评价模型的优劣,例如图像分类竞赛的ImageNet[1]中使用的Top-1、Top-5的Accuracy评估标准。笔者在建模研究中,发现在使用以上几种评估指标评估模型时,单性能指标不能准确地评估模型,如何更优地评估模型以及如何迭代地对模型进行优化成为了研究热点之一。本文针对各种数据集样本分布不均衡问题进一步分析,在针对多种深度学习技术应用中的目标检测、图像分割以及图像分类的模型评估方法的研究中,我们从模型评估的最优化的角度,研究模型判定标准以及怎样的标准才能最优评估模型,以混淆矩阵为基础,探究评估模型最优方法。

本文从多类问题分析时可以理解为对主类和从类(其他)两种角度,研究以两类问题下的P-R曲线,并结合竞赛任务中的应用分析P-R曲线在实际场景中的评估方法的最优性。

1 混淆矩阵与几种评估指标的关系

我们以汽车分类问题为例,假设汽车类型有A和B两类,我们在均衡比例A=5,B=5的测试集去测试车型分类对两类样本的识别能力。假设分類器对在测试集中识别A类汽车共预测7张,预测B类汽车3张,其中识别成A类中包含A类5个,B类2个,识别成B类中,实际包含2个B类和一个A类。根据以上模型预测输出能够得到对应的混淆矩阵如图1所示,本文从混淆矩阵进行分析几种评价指标之间的相互关系。

在图1汽车分类中,如果我们先以Accuracy评估模型为例,能够计算出Accuracy=0.60,Precision=0.71,Recall= 0.71。以上三种评估指标的计算是在样本均衡情形下得出的,假设样本中如果测试样本类是以9:1的方式呈现,预测结果A=7(预测A集合中A=6,B=1),在这种在数据不均衡的情况下,我们能够通过混淆矩阵计算Accuracy=0.60,P=0.86,R=0.67。从样本不均衡和均衡条件的计算,可以看出在两种样本分布下Accuracy表现结果相同,而Precision和Recall随样本分布变化呈现反差,类别不平衡问题会导致正样本或负样本的比例过多,当仅使用Accuracy去评估分类器性预测能力就不能合理地评估,在Everson R中对分类问题样本不均衡情况下如何进行合理评估方法的讨论以及Davis[2]证明了PR曲线相比于文献[2]在样本不均衡下更关注正样本,更能反映分类器的好坏的推理。当针对其他分类问题时,我们将预测类主类和其他类从类归纳为二分类问题,能够对混淆矩阵预测总结计算Accuracy公式(1)所示。

从上分析,以及几种竞赛的评估分析中能够看到,Precision和Recall是各种评估标准的基础,本文主要从P-R曲线在各种竞赛任务中的应用进行分析,论述P-R曲线的评估方法,并结合竞赛任务中的应用分析P-R曲线在实际场景中的评估方法。

2 P-R曲线分析

Davis[2]详尽地分析了通过P、R去关注分类器在预测主类的能力,能相对较好地忽略样本不均衡带来的问题(更关注于主类样本),能更有效地评估模型。本节主要从P-R曲线评估对象和在检测任务中通过两者之间的曲线去评估模型进行讨论,从坐标中的绘制方式到几种可能状态以及去分析如何获取理想条件下的最优P-R曲线,对比假设在P-R曲线在样本均衡时呈现。

2.1 Precision和Recall之间的联系

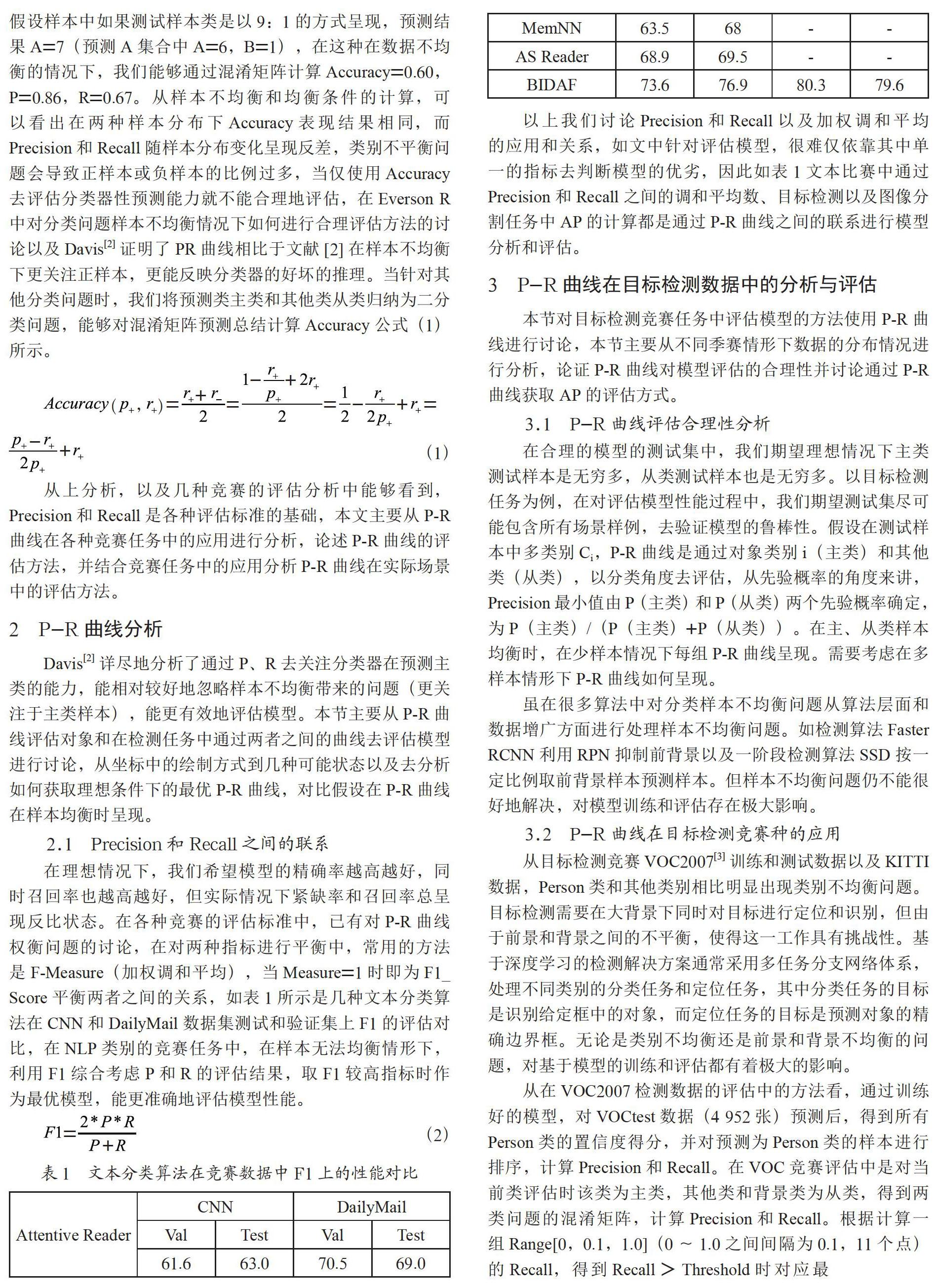

在理想情况下,我们希望模型的精确率越高越好,同时召回率也越高越好,但实际情况下紧缺率和召回率总呈现反比状态。在各种竞赛的评估标准中,已有对P-R曲线权衡问题的讨论,在对两种指标进行平衡中,常用的方法是F-Measure(加权调和平均),当Measure=1时即为F1_Score平衡两者之间的关系,如表1所示是几种文本分类算法在CNN和DailyMail数据集测试和验证集上F1的评估对比,在NLP类别的竞赛任务中,在样本无法均衡情形下,利用F1综合考虑P和R的评估结果,取F1较高指标时作为最优模型,能更准确地评估模型性能。

以上我们讨论Precision和Recall以及加权调和平均的应用和关系,如文中针对评估模型,很难仅依靠其中单一的指标去判断模型的优劣,因此如表1文本比赛中通过Precision和Recall之间的调和平均数、目标检测以及图像分割任务中AP的计算都是通过P-R曲线之间的联系进行模型分析和评估。

3 P-R曲线在目标检测数据中的分析与评估

本节对目标检测竞赛任务中评估模型的方法使用P-R曲线进行讨论,本节主要从不同季赛情形下数据的分布情况进行分析,论证P-R曲线对模型评估的合理性并讨论通过P-R曲线获取AP的评估方式。

3.1 P-R曲线评估合理性分析

在合理的模型的测试集中,我们期望理想情况下主类测试样本是无穷多,从类测试样本也是无穷多。以目标检测任务为例,在对评估模型性能过程中,我们期望测试集尽可能包含所有场景样例,去验证模型的鲁棒性。假设在测试样本中多类别Ci,P-R曲线是通过对象类别i(主类)和其他类(从类),以分类角度去评估,从先验概率的角度来讲,Precision最小值由P(主类)和P(从类)两个先验概率确定,为P(主类)/(P(主类)+P(从类))。在主、从类样本均衡时,在少样本情况下每组P-R曲线呈现。需要考虑在多样本情形下P-R曲线如何呈现。

虽在很多算法中对分类样本不均衡问题从算法层面和数据增广方面进行处理样本不均衡问题。如检测算法Faster RCNN利用RPN抑制前背景以及一阶段检测算法SSD按一定比例取前背景样本预测样本。但样本不均衡问题仍不能很好地解决,对模型训练和评估存在极大影响。

3.2 P-R曲线在目标检测竞赛种的应用

从目标检测竞赛VOC2007[3]训练和测试数据以及KITTI数据,Person类和其他类别相比明显出现类别不均衡问题。目标检测需要在大背景下同时对目标进行定位和识别,但由于前景和背景之间的不平衡,使得这一工作具有挑战性。基于深度学习的检测解决方案通常采用多任务分支网络体系,处理不同类别的分类任务和定位任务,其中分类任务的目标是识别给定框中的对象,而定位任务的目标是预测对象的精确边界框。无论是类别不均衡还是前景和背景不均衡的问题,对基于模型的训练和评估都有着极大的影响。

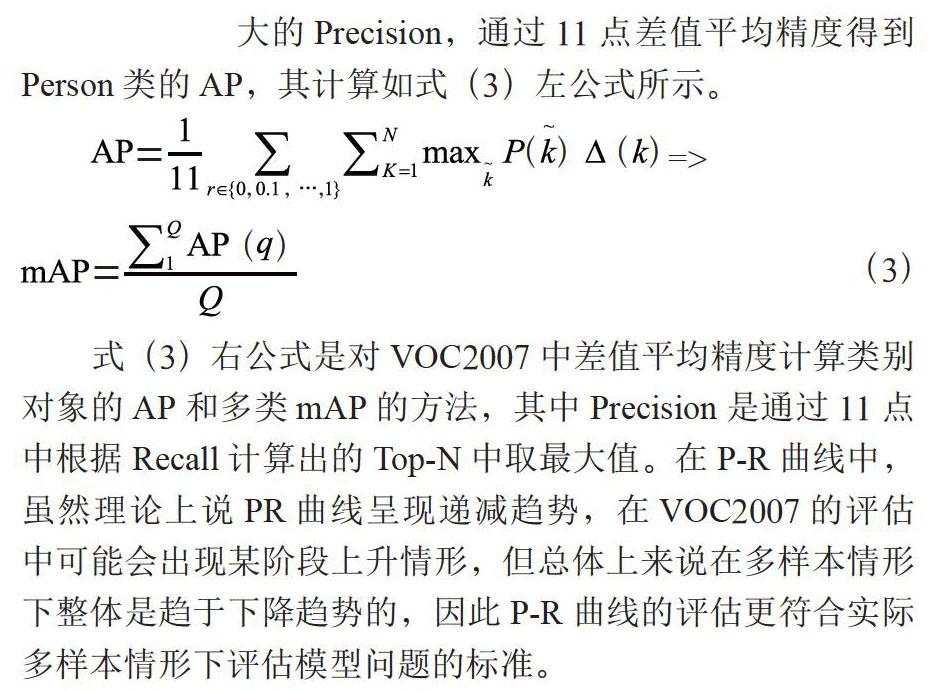

从在VOC2007检测数据的评估中的方法看,通过训练好的模型,对VOCtest数据(4 952张)预测后,得到所有Person类的置信度得分,并对预测为Person类的样本进行排序,计算Precision和Recall。在VOC竞赛评估中是对当前类评估时该类为主类,其他类和背景类为从类,得到两类问题的混淆矩阵,计算Precision和Recall。根据计算一组Range[0,0.1,1.0](0~1.0之间间隔为0.1,11个点)的Recall,得到Recall>Threshold时对应最大的Precision,通过11点差值平均精度得到Person类的AP,其计算如式(3)左公式所示。

式(3)右公式是对VOC2007中差值平均精度计算类别对象的AP和多类mAP的方法,其中Precision是通过11点中根据Recall计算出的Top-N中取最大值。在P-R曲线中,虽然理论上说PR曲线呈现递减趋势,在VOC2007的评估中可能会出现某阶段上升情形,但总体上来说在多样本情形下整体是趋于下降趋势的,因此P-R曲线的评估更符合实际多样本情形下评估模型问题的标准。

4 結 论

考虑到几种模型精度评价标准都基于混淆矩阵对模型预测能力的统计进行评估,本文主要从Precision和Recall之间的关系进行讨论,分析了分类以及检测任务中实际场景中样本分布的样本均衡和前背景均衡问题。本文从P-R曲线的角度分析了其在面对以上问题时评估方法的合理性。近几年学术研究中通过CNN模型的拟合评估角度思考的方式,通过P-R角度思考的AP-Loss[4]为一种新思路,这也将是我们后续探索P-R曲线与模型结合的优化方向。

参考文献:

[1] DENG J,DONG W,SOCHER R,et al.ImageNet:a Large-Scale Hierarchical Image Database [C]//2009 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR 2009),USA.IEEE,2009.

[2] DAVIS J,GOADRICH M.The Relationship Between Precision-Recall and ROC Curves [C]//ICML06:Proceedings of the 23rd international conference on Machine learning,2006:233-240.

[3] EVERINGHAM M,GOOL L V,WILLIAMS C K I,et al.The Pascal Visual Object Classes (VOC) Challenge [J].International Journal of Computer Vision,2010,88(2):303-338.

[4] CHEN K,LI J G,LIN W Y,et al.Towards Accurate One-Stage Object Detection with AP-Loss [J].[2019-12-26].https://arxiv.org/abs/1904.06373?context=cs.CV.

作者简介:张超(1992.06-),男,汉族,河南固始人,硕士在读,研究方向:模式识别。