一种卷积神经网络非合作目标姿态测量方法

2020-06-05徐云飞张笃周华宝成石永强贺盈波

徐云飞,张笃周,王 立,华宝成,石永强,贺盈波

(北京控制工程研究所空间光电测量与感知实验室,北京 100190)

0 引 言

随着航天技术的进步和空间任务的多样化发展,对于空间非合作目标位姿测量的需求日益迫切。目前用于非合作目标位姿测量的敏感器主要包括相机和激光雷达两大类。激光雷达的分辨率较低、硬件相对复杂,且功耗较高;相比之下单目相机硬件更为简单成熟。然而传统模式下单目相机无法获得深度信息、点线特征提取不稳定、适应性较差,这些因素使得当前非合作目标的相对姿态求解主要集中于立体视觉和激光雷达[1-2]。随着深度学习和高性能处理器的发展,为“单目相机+卷积神经网络”在轨实现姿态测量提供了可能。

德国宇航局开展的“实验服务卫星(Experi-mental servicing satellite, ESS)”项目[3],通过卫星机械臂上搭载的立体摄像机对目标卫星上的发动机喷嘴进行运动参数识别。美国的FREND机械臂上的立体视觉系统能够对分离螺栓孔和星箭对接环进行识别和抓捕[4]。王诗强等[5]提出一种通过纹理边界检测的椭圆特征提取方法,拟合出对接环的椭圆参数并进行相对姿态测量。徐文福等[6]利用Canny边沿检测算子提取目标滤波图像中的直线特征,再利用双目系统对直线特征形成的交叉点进行匹配,从而得到目标位姿。王志超等[7]利用双目相机识别目标航天器上矩形和椭圆形特征并进行特征匹配和位姿测量,利用PLK光流法对其动态轨迹进行跟踪。然而无论是关键点特征、直线特征还是矩形椭圆等,都是人工设计出的几何特征,难以适用于各类空间条件下,且目标卫星上的天线、帆板、对接环、喷嘴以及卫星本体会随着其位姿和所受光照条件的变化发生成像模糊,局部遮挡,以及出现阴影等情况。传统的特征点提取和匹配测量非合作目标姿态的方法难以应对各类工况。

深度学习方法的兴起,给目标位姿测量提供了新的思路。如基于稀疏特征[8]、基于稠密图像块[9-10]和基于模板匹配[11]等方法,以及基于卷积神经网络的目标姿态测量方法[12-14]。而针对非合作目标姿态测量问题,张浩鹏等[15]提出在核函数的基础上通过学习的方法,提取出卫星数据集图像特征,进而得到卫星姿态角。李想[16]提出利用深度学习方法对空间非合作目标进行三轴姿态估计,利用卷积神经网络InceptionV3模块对整幅图像进行特征提取,建立与三轴姿态角之间的关系,最终实现姿态估计。斯坦福大学Sharma等[17]提出基于卷积神经网络的非合作目标姿态估计方法,预先定义多种姿态作为图像标注信息,用AlexNet作为基干网络,将姿态估计问题作为分类问题处理。北京控制工程研究所王立等[18]提出基于特征建模的非合作目标点云智能化配准方法,利用神经网络学习点云协方差矩阵中6个参数与非合作目标三轴姿态的关系。

本文通过迁移学习方法减少了网络对数据集数量的过度依赖,并将姿态测量问题从分类问题转化成回归问题,对比了基于ResNet、MobileNet的姿态测量网络学习效果,能够保证检测精度、检测速度以及网络尺寸要求。

1 姿态测量网络架构

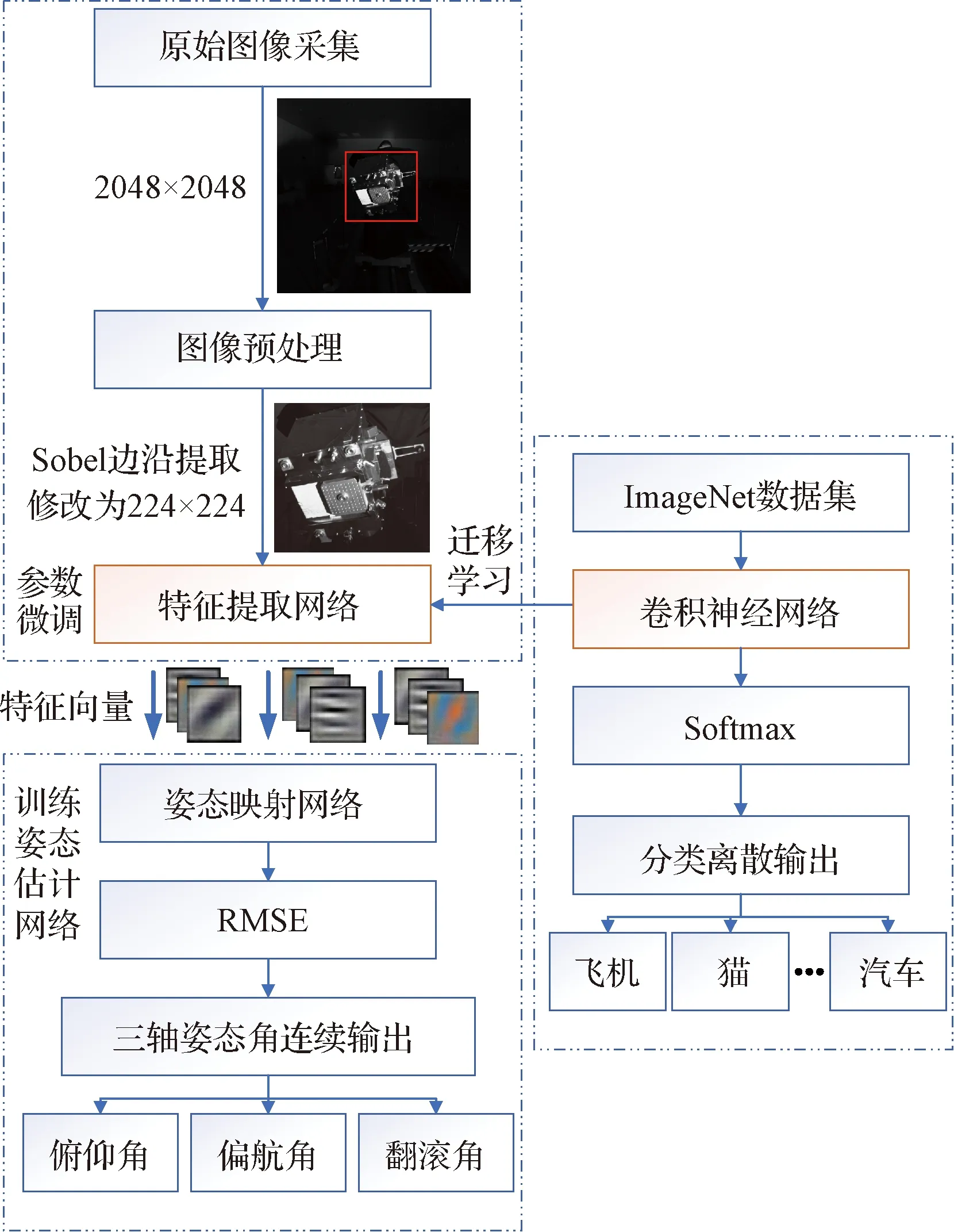

图1为空间非合作目标单目姿态测量总体技术路线图。首先在实验室采集空间非合作目标图像,并标注每一幅图像的俯仰、偏航和翻滚姿态角;对原始图像进行Sobel边沿提取,确定卫星在原始图像中的位置并截出,修改尺寸和通道数后送入特征提取网络进行特征学习;本文采用迁移学习的方法提取卫星图像特征,所用的特征提取网络来源于ImageNet大规模视觉挑战赛(ILSVRC)上表现优异的网络(ResNet, MobileNet等)。由于ImageNet上用大数据训练出的卷积神经网络,能对任意图像的底层特征至高维特征进行充分表征,因此可以将这些网络的卷积层提取出来作为姿态测量任务的图像特征提取网络,且只需少量图片训练便可对卷积核权重、偏置值完成微调。这一过程相当于对图像进行特征建模,最终输出得到了特征向量;之后本文设计了姿态估计网络并对其进行训练,构建输入特征向量到俯仰、偏航和翻滚三轴姿态角之间的非线性映射关系,且输出类型为连续输出,即将姿态测量问题设计为回归问题,相对于分类问题,可以获得更高的姿态分辨率。

图1 非合作目标姿态测量网络架构设计Fig.1 Architecture design of non-cooperative target attitude measurement network

1.1 特征提取网络选取

图2展示了不同特征提取网络在图像分类任务中准确率与相对检测时间差异,在空间非合作目标姿态测量任务中,期望网络在保证高准确率的同时具有相对小的计算量与存储空间开销(如表1所示)。以图中虚线为界,之上的网络兼顾图像特征提取能力和检测速度。因此本文对比两类网络,分别以残差网络ResNet和轻量化网络MobileNet作为特征提取网络。

图2 不同特征提取网络性能对比Fig.2 Performance comparison of different feature extraction networks

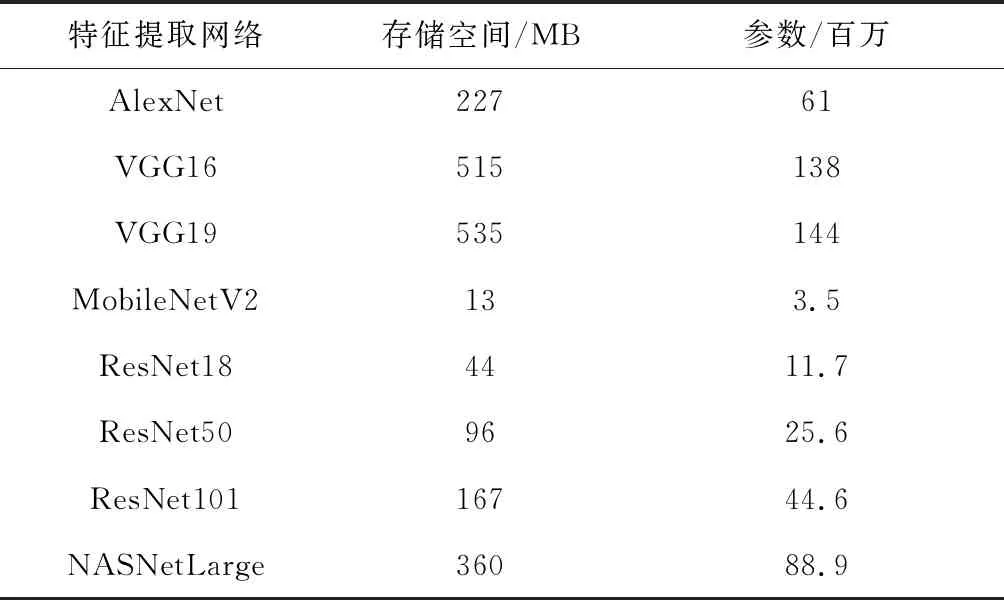

表1 不同特征提取网络存储开销与参数量Table 1 Storage overhead and parameter amount of different feature extraction network

残差网络ResNet最大的意义在于解决了随着网络深度增加,训练集上准确率下降的问题。相比于以往的卷积网络结构(AlexNet、Vgg等),残差网络引入了残差模块(如图3所示)。

图3 残差网络结构Fig.3 Structure of residual network

对于两层的残差网络有如下表达式:

G=W2σ(W1x)

(1)

式中:σ为激活函数ReLu,Wi(i=1,2)为卷积层Li权重。

之后x通过一个捷径(Shortcut),与第二个ReLu相加得到整个残差模块的输出:

y=G(x,{Wi})+x

(2)

残差模块的引入能够解决网络退化的问题,即随着网络层数的增加,输出误差逐渐增大,从而保证空间非合作目标姿态测量精度。

轻量化网络MobileNet_V1在模型结构上采用了逐通道(Depth wise, DW)卷积搭配逐点(Point wise, PW)卷积的方式来提取特征,这两个操作合起来被称为深度可分离卷积结构(Depth-wise separable convolution)。这种结构在理论上可以成倍地减少卷积层的时间复杂度和空间复杂度。由式(3)可知,因为卷积核的尺寸通常远小于输出通道数Cout,因此标准卷积的计算复杂度近似为DW+PW组合卷积的K2倍。

(3)

轻量化网络MobileNet_V2在延用MobileNet_V1深度可分离卷积结构的基础上融入了残差网络的思想,使用Shortcut将输入与输出相连接。与残差网络不同的是MobileNet_V2采用先升维再降维的方式,将图像特征提取放在高维进行,以适应DW结构。MobileNet_V2的使用可以在保证姿态测量精度要求的前提下减小模型尺寸,从而能在嵌入式系统中实时输出测量结果。

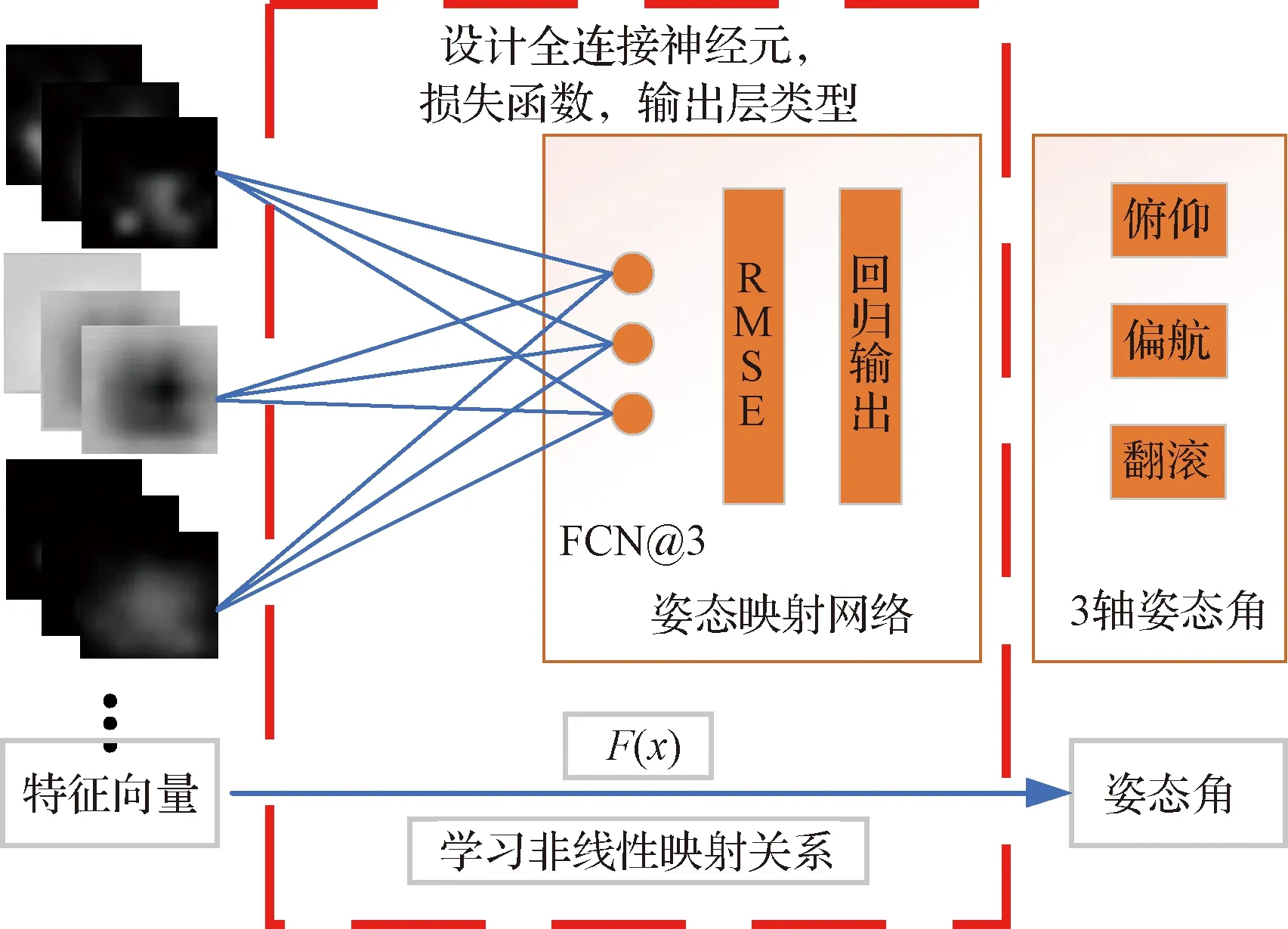

1.2 姿态映射网络设计

将姿态测量问题作为回归问题来处理,设计了基于回归模型的姿态映射网络。特征提取网络输出n维特征向量(n取决与特征提取网络的输出维度),对原始图像进行深层次高维表征,并作为姿态映射网络的输入。姿态映射网络是由三个神经元组成的全连接层,分别对应输出的俯仰、偏航和翻滚三轴姿态角A=[θψφ],并采用均方根误差(Root mean square error, RMSE)作为损失函数,如式(4)所示:

(4)

姿态映射网络结构如图4所示。

图4 姿态映射网络结构Fig.4 Structure of attitude mapping network

学习过程中三个神经元根据反向传播链式求导法,采用优化器对全连接层3n个参数进行自学习,经过训练能够学习到特征向量到姿态角之间的非线性映射关系,但由于姿态映射网络的“黑箱”问题,映射关系F(x)只能通过所学习的权重体现,而无法给出明确公式或直观的物理意义。

1.3 优化器设计

神经网络训练的本质为最小化损失函数,因此在定义好损失函数后,需选择合适的优化器对损失函数进行优化。经典的优化器包括批量梯度下降(Batch gradient descent, BGD)、随机梯度下降(Stochastic gradient descent with momentum, SGDM)、小批量梯度下降(Mini-batch gradient descent)等。然而这些优化器存在收敛速度慢、学习率不可调节、对噪声鲁棒性差等缺点,因此本文选取性能较优的自适应动量估计(Adaptive momentum estimation,ADAM)[19]优化器。

ADAM优化器相比于经典的优化器在更新参数时,学习率能够具有自适应性。除了存储历史梯度平方的指数衰减平均值vl(如Adadelta和RMSprop),ADAM还保持历史梯度的指数衰减平均值,类似于动量(Momentum)条件:

(5)

式中:m为梯度一阶矩(均值),v为梯度二阶矩(方差),β为衰减系数,取值范围[0,1]。

然而对于ml,vl初始化为零向量的时刻,会产生一个趋近于0的偏差,经偏差修正后的ml,vl如式(6)所示:

(6)

使用ADAM优化器得到的网络参数更新公式为:

(7)

ADAM优化器相对于传统优化器而言,能够根据训练参数修改训练时的学习率,并且对优化中的损失函数具有一定的自适应性。相对于其他自适应学习优化方法效果更优。

2 模型训练

2.1 数据集获取

针对某型号非合作目标模型建立数据集。三轴旋转角度区间为[-30°, +30°],用太阳模拟光源从不同位置进行照射。[-30°,+30°]区间每个轴间隔6°取样,总共得到113张图片并作为训练集;[-27°,+23°]区间每个轴间隔10°取样,总共得到63张图片并作为验证集。本文在原始图像预处理过程中利用Sobel算子提取原始图像中的边缘信息,并两次求取型心获得卫星在原始图像中的大致位置并以矩形框截取,从而能够滤除黑暗的空间背景以及其他物体的干扰,将有用的像素信息送入特征提取网络用以训练,如图5所示。

图5 图像预处理Fig.5 Image preprocessing

之后根据图片编号批量生成标注信息,完成数据集的构建(如图6所示)。

图6 部分图像与对应姿态角标注Fig.6 A part of images and corresponding attitude angle annotations

2.2 姿态测量网络训练

采用迁移学习的方法,利用预训练过的卷积网络提取非合作目标图像特征,得到高维特征向量。之后姿态映射网络,通过学习得到特征向量和俯仰、偏航、翻滚三轴姿态角之间的非线性映射关系。以ResNet101为基干设计的姿态测量网络结构如表2所示。

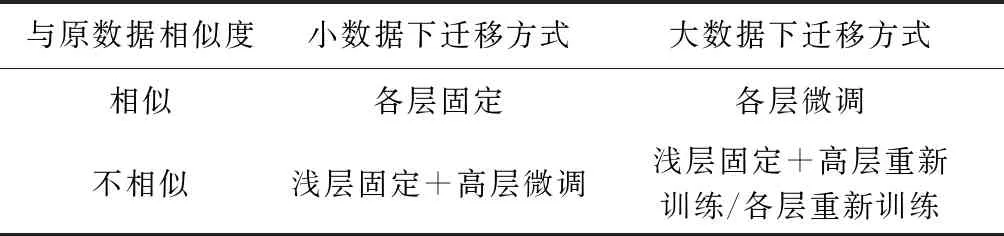

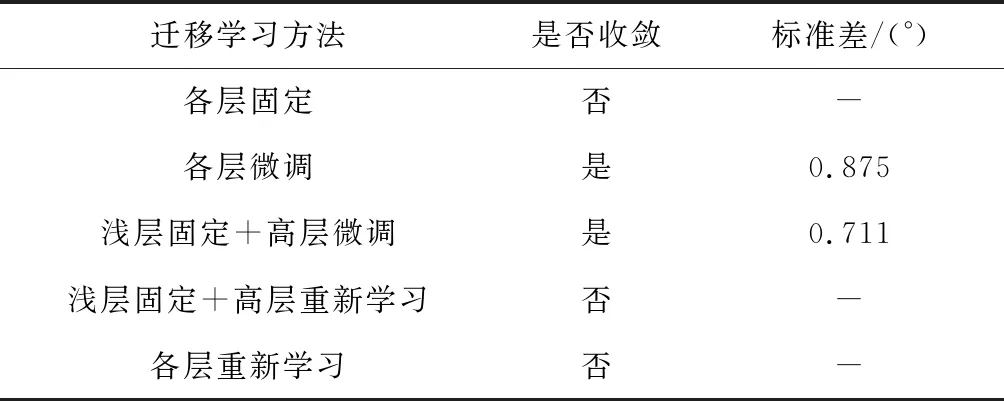

在使用迁移学习对特征提取网络进行参数微调时,应根据实际任务情况考虑两点:训练数据量大小、与原数据集(ImageNet)相似程度。并参考不同的训练方式(见表3)。

表2 基于ResNet101的姿态测量网络Table 2 Attitude measurement network based on ResNet101

表3 不同任务迁移学习方式参考Table 3 Reference of transfer learning methods for different task

由于非合作目标数据集与原数据(ImageNet)相似度低,综合比较适用于“浅层固定(Conv1、Conv2)+高层微调”的迁移学习方式,浅层参数对边沿、纹理表征,具有通用性,因此可利用浅层参数并加以固定避免训练过程中微调带来的过拟合,高层参数微调可将原用于图像分类的高层特征调整为适用于姿态测量任务的高层特征;相对于“各层参数微调”方法,在一定程度上避免数据量不充足带来的过拟合问题。而“各层固定”、“各层/高层重新训练”方法可能由于高层特征不适用、数据量不充足导致模型训练无法收敛。

设置网络训练超参数,训练选用ADAM优化器,设置小批量尺寸大小为32,训练50代且每代训练结束后打乱训练集顺序重新训练,初始学习率为0.0001并每20代后调节学习率下降0.1倍。实验环境:CPU: Intel(R) Xeon(R) Silver 4114 CPU @2.20 GHz 20核; GPU: NVIDIA Quadro P4000(显存6 G);MATLAB R2019b, Deep Learning Toolbox, CUDA 10.1。训练结果如图7所示,从图中可以看出损失函数RMSE曲线通过训练可以收敛,验证集RMSE可收敛至0.711°,后验结果表明了姿态测量网络设计和训练的可行性。

图7 姿态测量网络训练曲线Fig.7 Training curves of attitude measurement network

2.3 权重可视化与特征分析

卷积网络在训练中学习到图像的底层至深层特征,并保留在卷积核权重中,将其中某些层可视化得到图8。

图8 姿态测量网络(左)与ResNet101(右)权重可视化对比Fig.8 Comparison of weights visualization between attitude measurement network (left) and ResNet 101 (right)

图8左侧为姿态测量网络卷积权重,右侧为预训练过的分类网络ResNet101卷积权重,分别对两个网络Conv1~Conv5中的部分卷积层进行了可视化。纵向比较发现Conv1中64个卷积核提取图像中点、线特征,Conv2、Conv3提取图像边沿轮廓特征,而Conv4、Conv5通过深层整合(Conv2~Conv5只显示了前30个卷积核),能够充分捕捉到图像丰富复杂的纹理特征;横向比较二者发现姿态测量网络的卷积层参数在预训练过的ResNet101卷积层上进行了微调,Conv1~Conv5层特征大体相似,只是由于空间非合作目标图像为灰度图像,整体颜色特征偏暗,可视化的结果证明迁移学习的可行性,预训练过的卷积网络适用于姿态测量任务。

输入一张空间非合作目标图像,可以查看图像在特定特征提取层的输出激活,如图9所示。

图9 各层输出结果可视化Fig.9 Visualization of output results of each layer

图9展示了输入图像在Conv2、Conv3层的激活输出,将Conv层内某个通道的特定输出激活提取并放大对比可以发现,网络能够提取出非合作目标局部特征。每层的1/2/3通道激活中,灰度高的区域为卷积核提取出的区域,灰度低的区域为卷积核不关注的区域,对比4通道原图发现1/2/3通道分别能够对非合作目标星体与支架上的横向边沿、柱状喷嘴及形体上零部件和星体中间区域的矩形等特征进行有效提取,且网络越深,提取出的特征更简明抽象,并最终化为特征向量送入后面的姿态映射网络中学习非线性映射关系F(x)。姿态映射网络的参数可视化分别对应了特征向量到俯仰、翻滚、偏航三轴姿态角之间的映射关系。

图10 特征向量与三轴姿态角的对应映射关系Fig.10 Mapping relationship between eigenvector and attitude angle of three-axis

按照表征学习观点,特征提取网络中的卷积层和池化层能够对输入数据进行特征提取,姿态映射网络中的全连接层作用则是对提取的特征进行非线性组合得到输出,即全连接层本身不具有特征提取能力,而是试图利用现有的高阶特征完成端到端的拟合。

3 实验结果与误差分析

实验对比了不同迁移学习方法以及不同特征提取网络在姿态测量任务中的性能差异。

表4 不同迁移学习方法训练结果对比Table 4 Comparison of training results of different transfer learning methods

训练结果证明采用各层微调和“浅层固定+高层微调”的方法模型能够收敛,且后者精度更高,证明迁移学习方法可行性,以及固定浅层参数避免过拟合方法的有效性。以标准差σ作为网络性能的评价标准。图7中RMSE曲线中的虚线表示网络在验证集上的标准差。图11分别展现了两种迁移学习方法标准差结果:两种方法1σ误差都在1°内,3σ误差在2°内。但其中红色离群点分布明显采用“浅层固定+高层微调”方法更优。具体误差分析如表5、表6所示。

图11 三轴误差分布Fig.11 Error distribution of three-axis

表5 各层微调验证集结果(基于ResNet101)Table 5 Validation results of fine-tuning on each layer (based on ResNet101)

表6 浅层固定+高层微调验证集结果(基于ResNet101)Table 6 Validation results of shallow layers freezed+fine-tuning on deep layers(based on ResNet101)

图12 部分测量结果Fig.12 Parts of the measurement results

由于空间非合作目标姿态估计工作最终需要在轨进行,因此卷积神经网络尺寸大小以及检测时间决定了网络能否部署在嵌入式系统以及进行在轨实时检测。本文对比了ResNet101、ResNet50、ResNet18、MobileNet_V2的网络大小、检测精度和检测时间,如表7所示。

本文利用测量精度相对较高的ResNet101网络测量姿态角精度为0.711°,优于文献[16]中的平均误差2.68°、文献[20]中的平均误差7.3°以及文献[6, 18]中的精度2°;与文献[16-18]相比,将姿态测量问题转化为回归问题而非分类问题,可得到连续准确的姿态角输出。横向比较不同的卷积神经网络可以看出,通过删减卷积层或提出新型网络结构后的轻量化网络尺寸更小、平均检测时间更短,但会损失一定的检测精度。本文算法不需要依赖于非合作目标人工特征的提取和匹配,而是对整幅图像底层边沿特征至高层抽象特征自动提取,相对而言此方法可用于各类型的非合作目标,且能够通过完善训练集来提高姿态测量精度和鲁棒性。

表7 不同预训练网络测量结果对比Table 7 Comparison of measurement results of different pre-training networks

4 结 论

本文给出了一种空间非合作目标姿态测量的方法。针对单目相机获取的图像,利用卷积神经网络对卫星姿态进行估计,标准差为0.711°,单幅图片的检测时间可达0.02 s。轻量化网络的检测精度虽有一定损失,但在模型存储大小和检测时间上存在明显优化,根据任务需求不同选取不同的卷积神经网络。本文方法在精度和检测时间上也优于一些既有的传统算法,且无需人工设计特征提取和特征匹配步骤。验证了利用“单目相机+卷积神经网络”方法进行空间非合作目标姿态测量的可行性。