基于图像语义分割的无人机自主着陆导航方法

2020-03-01尚克军王旒军扈光锋刘崇亮

尚克军,郑 辛,王旒军,扈光锋,刘崇亮

(1.北京理工大学 自动化学院,北京 100086;2.北京自动化控制设备研究所,北京 100074)

无人机安全着陆是其重复飞行的关键,在着陆过程中无人机与着陆平台间的相对位置、姿态等导航信息的性能直接决定着陆的成败,目前,导航信息的获取主要借鉴有人飞行器中采用的差分卫星(如美国JPALS)、仪表、微波、雷达等测量方式,需地面设备辅助,且在复杂电磁环境中易受干扰,影响着陆安全。

随着视觉导航、机器学习等技术的发展,基于视觉传感器的着陆导航技术利用机场跑道等特征,可在运动过程中确定无人机与机场跑道间的相对位姿等导航信息,具有结构简单、非接触、自主性强、成本低和近距精度高等优点,引起了广泛研究和关注[1]。Barber 等人[2]通过设置地面特殊视觉标志(Visual Marker)成功实现了微型固定翼无人机在固定和移动目标平台的降落;德国航空航天中心(DLR)的研究人员通过在车顶上布置数个光学二维码,成功将一款翼展3 m,重20 kg 的小型固定翼无人机(Penguin BE)降落在以75km/h 速度行驶的汽车车顶上[3]。Gui 等人[4]通过在无人机上安装可见光摄像机和一个940 nm 的滤光片,在跑道理想着陆点后放置4 盏发射波长为940 nm 的红外发光二极管(LED),实现复杂背景条件下的安全着陆。Miller 等人[5]利用跑道前视图像,使用图像配准(Image Registration)算法计算无人机与跑道之间的相对位姿;Vezinet 等人[6]基于跑道的参考图像执行图像配准以检测点特征进行着陆引导;Liu 等人[7]将跑道作为视觉标志,提出了一种着陆视觉导航P3P 问题唯一解的求解方法,实现了无人机与跑道之间六自由度位姿解算;慕尼黑工业大学(TUM)和布伦瑞克理工两所大学研制的C2Land 系统[8],采用模板匹配方法通过可见光和红外图像进行跑道识别,并于2019年5月在钻石DA42飞机上成功完成了一次完整的全自主着陆试验。

基于视觉传感器的着陆导航应用的前提是对着陆过程中获取的图像进行实时、准确、可靠的特征检测识别,但是受环境变化(如季节变化、光照等)、着陆过程尺度变化剧烈和计算复杂度等因素影响,视觉着陆导航的鲁棒性与实时性不能保证,极大地制约着视觉着陆相对导航技术的工程应用能力。

本文提出了一种基于深度卷积神经网络图像语义分割的无人机自主着陆导航方法,以机场跑道为视觉特征,设计构建了轻量高效的端到端跑道分割神经网络RunwayNet,通过主干网络、自注意力网络模块和解码器等设计实现对跑道区域精细地分割,在此基础上,通过跑道分割区域的边线提取,实现无人机与着陆跑道间相对位置和姿态信息的高精度、高可靠测量。系统流程如图1所示,本文导航方案在特征识别准确性、鲁棒性等方面展现了很大的优势,为无人机视觉可靠自主着陆导航提供了一种新的思路。

1 跑道分割网络设计

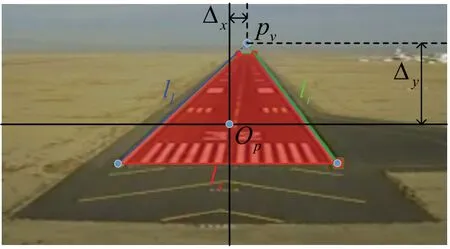

跑道区域定义为跑道左右边线、起始斑马线和终止斑马线之间的区域,如图2中红色区域所示。设计分割网络时,在重点兼顾计算实时性的同时,提升网络的分割精度和多尺度特征提取能力。

图2 跑道区域定义Fig.2 Definition of runway area

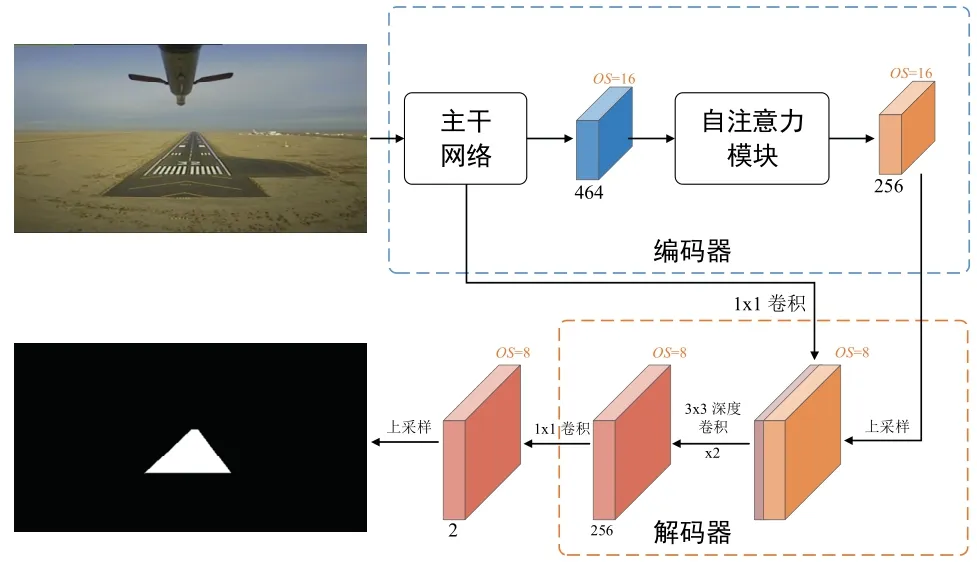

如图3所示,跑道分割网络(命名为RunwayNet)采用编码器、解码器结构,编码器由主干网络和自注意力模块组成。

图3 RunwayNet 网络结构Fig.3 RunwayNet network architecture

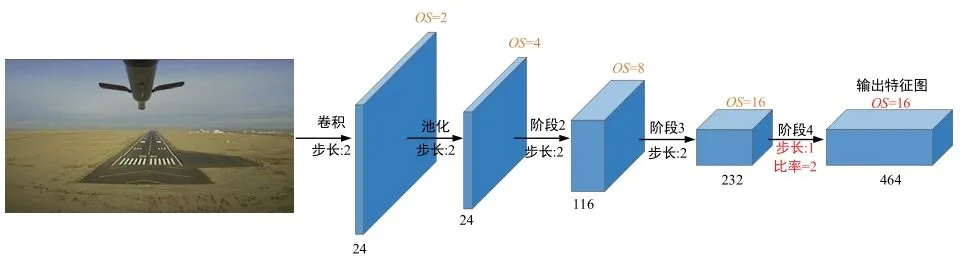

主干网络(Network Backbone)为采用空洞卷积[9](Atrous Convolution or Dilated Convolutions)进行改造的轻量级ShuffleNet V2[10],对输入的图像逐步提取抽象语义特征,最终输出464 通道OS=16(输出步长,Output Stride)的特征图;自注意力模块通过位置注意力和通道注意力两个子模块对主干网络输出的特征图进行特征变换,以捕获特征图空间维度和通道维度的相似性信息,提高网络的感受野和特征提取能力。解码器模块通过跳跃连接和双线性插值上采样实现网络浅层丰富细节、空间位置信息与顶层粗略、抽象语义分割信息的融合。最后,使用1×1 卷积将解码器输出特征图映射为两通道(分类类别数),上采样8 倍后在通道维度取最大值(ArgMax)获得最终的分割结果。

1.1 主干网络构建

以轻量级ShuffleNet V2"1×" 版本为基础构建主干网络。为获得精细的语义分割结果,同时提取抽象的语义信息,要求主干网络在输出较高分辨率特征图的情况下,顶层网络的感受野不能太小,而ShuffleNet V2 输出Output Stride 为32 的原始特征图不能满足要求,为此使用空洞卷积对ShuffleNet V2 进行改造。

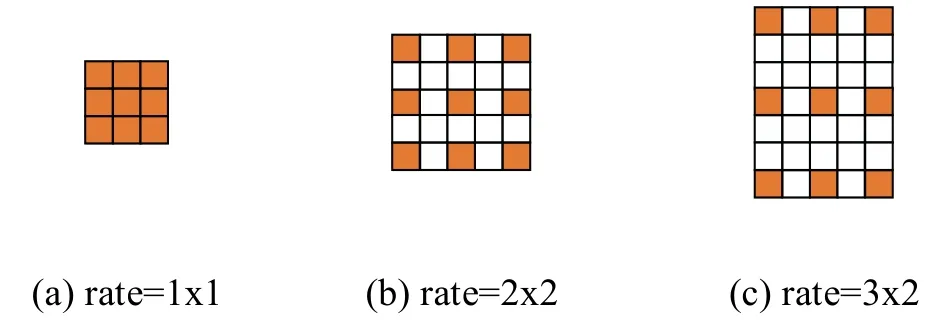

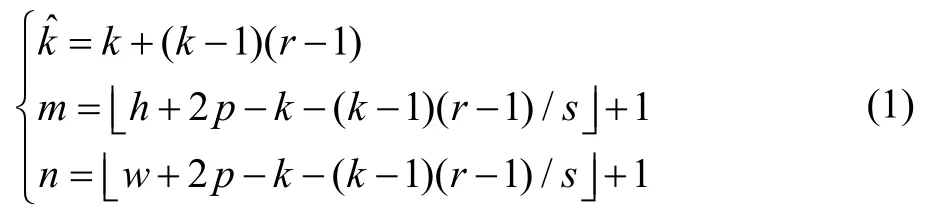

空洞卷积通过引入膨胀比率(Dilation Rate),在常规卷积核中插入空洞来构造空洞卷积核,不同膨胀比率rate 的空洞卷积核如图4所示。空洞卷积不增加卷积核参数量和卷积计算量,在保持输出特征图尺度的同时增大卷积核的感受野,从而提升主干网络的特征提取能力,有利于提高语义分割精度。

图4 空洞卷积Fig.4 Atrous Convolution

设常规卷积核尺寸为k×k,引入的膨胀比率为r,卷积层输入图像尺寸为h×w,滑动步长(Stride)为s,在边缘填充(Padding)零像素的圈数为p,则等效的空洞卷积核大小及输出特征图的尺寸m×n分别如下:

如图5所示,在进行主干网络设计时,去除ShuffleNet V2 网络“Stage4”网络块后的池化层和全连接层,构建为全卷积网络(Fully Convolutional Networks,FCN),设置“Stage4”网络块中第一层步长为1,并将随后的三个网络层改造为膨胀比率为2 的空洞卷积,在使卷积层感受野继续增大的同时,特征图尺寸不再减小。最终主干网络输出464 通道Output Stride 为16 的特征图,分辨率提高一倍。

图5 主干网络Fig.5 Network backbone

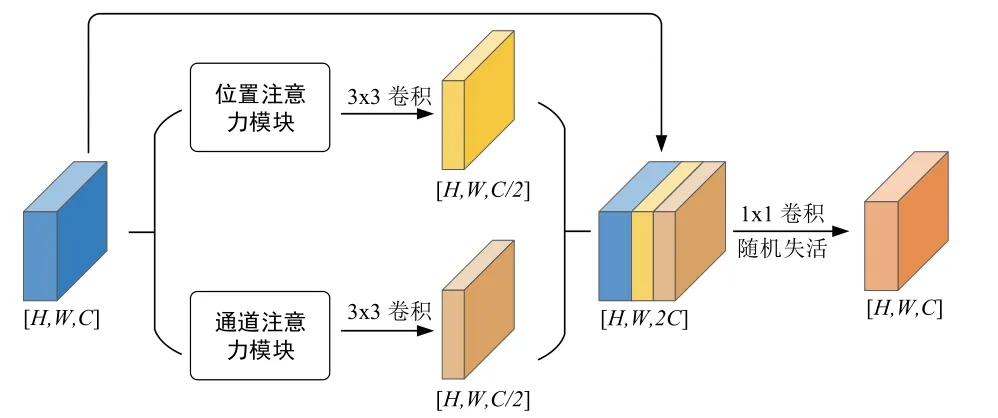

1.2 自注意力模块设计

基于自注意力机制[11-16],利用跑道成图像素值的相似性、空间位置坐标的相似性和连续性,设计自注意力模块(Self-attention Module),对跑道像素和空间位置的相似关系进行建模,在不需要外界信息辅助情况下通过特征图之间的特征变换,实现特征图空间维度和通道维度的大范围全局相似性信息的融合,从而提高网络语义分割精度。

如图6所示,设计位置注意力模块(Position attention Module)和通道注意力模块(Channel attention Module)对输入特征图进行特征变换,提取全局像素相似性和通道相关性信息;使用3×3 卷积核对两个模块输出进行操作后,直接与注意力模块输入特征图在通道维度进行拼接;使用1×1 卷积对拼接的特征图进行特征整合,通过迭代优化让网络自动选择特征,提高位置注意力和通道注意力特征融合得“自由度”;最后,使用失活概率为0.1 的随机失活层,随机失活一些特征,避免网络对某些特定特征的过度依赖,增强模块的鲁棒性。在这个过程中,为减少梯度消失等现象以加快收敛速度,自注意力模块中每层卷积操作后均使用了批量归一化和ReLU 激活函数。

图6 自注意力模块Fig.6 Self-attention module

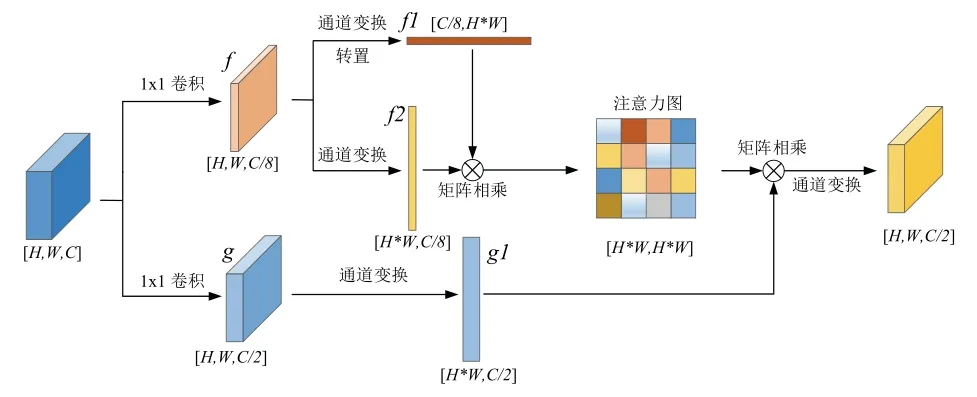

1.2.1 位置注意力模块

理论上网络中深层的卷积核具有很大的感受野,更容易抽象出高级语义特征,但实验证明深层网络的实际感受野远小于理论值,导致全局特征缺失。位置注意力模块通过特征图之间的特征变换计算像素之间的全局相似性关系,建模特征图中局部特征的全局位置上下文信息,从而增大网络的感受野,增强网络的全局特征表达能力。

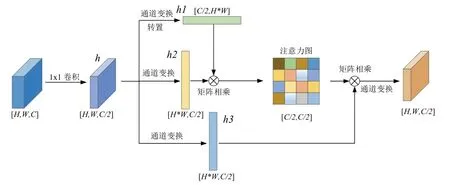

如图7所示,首先使用两路1×1 卷积压缩输入特征图的通道维度(不失一般性,未考虑网络训练时批量归一化“Batch”维度),第一路分支的通道压缩比为8,得到特征图为f,第二路分支的通道压缩比为2,可保留较多的原始信息,得到特征图为g;然后分两路对特征图f进行特征变换,一路进行维度变换和转置,合并高度和宽度维度,得到特征图f1,另一路只进行维度变换,合并高度和宽度维度,得到特征图f2;接着对f1和f2进行矩阵乘法,消去通道维度后使用 Softmax 函数进行归一化,获得尺寸为[H*W,H*W]的注意力图;同时,对特征图g进行维度变换,得到[H*W,C/2]的特征图g1 。最后,将注意力图与特征图g1 进行矩阵乘法,将获取的全局相关性权值信息重新分布到原始特征图中,恢复特征图高度和宽度维度后,获得尺寸为[H,W,C/2]的输出特征图。

图7 位置注意力模块Fig.7 Position attention module

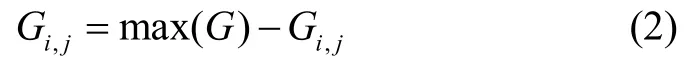

1.2.2 通道注意力模块

一般情况下,深度卷积神经网络中顶层不同的通道会关注不同的分割类别,通道注意力模块利用相似的特征变换操作,在保留通道维度的同时,使网络具有全局通道相关性表达能力[17]。

如图8所示,首先使用1×1 卷积压缩特征表达,得到特征图h;然后分三路对特征图h进行维度变换或转置操作,分别得到尺寸为特征图1h、h2 和h3 。对特征图1h和h2 进行矩阵乘法,消去H*W维度,保留通道维度,得到特征图G。为了防止训练期间的损失值不收敛[15],对特征图G中的像素点Gi,j按式(2)进行处理,然后用Softmax 函数进行归一化,获得尺寸为[C/2,C/2]的注意力图,其描述了通道之间的相关性,权值越大,通道特征相似度越高。

其中max(G) 表示特征图中像素最大值,i,j分别表示像素点坐标,i,j∈ [1,C/2]。

图8 通道注意力模块Fig.8 Channel attention module

最后,将注意力图与特征图h3 进行矩阵乘法,消去H*W维度,将全局通道相关性信息分布到原始特征图中,恢复特征图高度和宽度维度后,获得尺寸为[H,W,C/2]的输出特征图。

1.3 解码器设计

主干网络和自注意力模块编码了图像中丰富的语义信息,但输出特征图分辨率低,丢失了部分空间位置信息,设计解码器模块,使用上采样逐步增大特征图的尺寸,并使用跳跃连接融合主干网络浅层丰富的细节和空间位置信息,从而提取多尺度特征,恢复清晰的物体边缘,获得更加稠密、精细的语义分割结果。为降低解码器模块中卷积操作对网络实时性的影响,设计时使用了深度可分离卷积[18],错误!未找到引用源。错误!未找到引用源。(Depthwise Separable Convolution)。

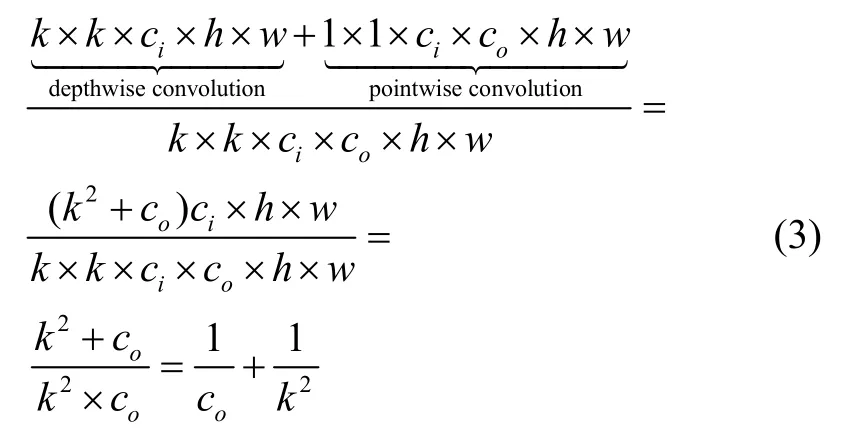

深度可分离卷积首先使用3×3卷积核(通常称为“Depthwise Convolution”)在输入特征图上逐通道进行卷积运算,然后使用1×1卷积(通常称为“Pointwise Convolution”)进行通道关系映射。深度可分离卷积与常规卷积的计算量之比如下:

其中h×w×ci为输入特征图尺寸,h×w×co为输出特征图尺寸,则k×k×ci×co为常规卷积核尺寸(co为卷积核个数),k×k×ci深度可分离卷积逐通道卷积核尺寸,1×1×ci×co为1×1卷积核尺寸。由于通常卷积核尺寸远小于输出通道数,所以深度可分离卷积与常规卷积的计算量之比约为 1/k2,当卷积核设置为3×3时,深度可分离卷积约可减少8~9 倍的计算量。

解码器网络结构如图3中所示,以编码器模块输出的OS=16特征图为输入,首先进行双线性插值2倍上采样,获得OS=8的特征图;然后引入主干网络中“Stage2”输出的相同空间分辨率特征图,并使用1×1卷积对其降维3 倍获得38 通道浅层特征,将两路特征图拼接后,使用两层3×3的深度可分离卷积整合细化深层和浅层特征,输出256 通道OS=8的稠密特征图。

2 相对位姿解算

2.1 着陆过程成像分析

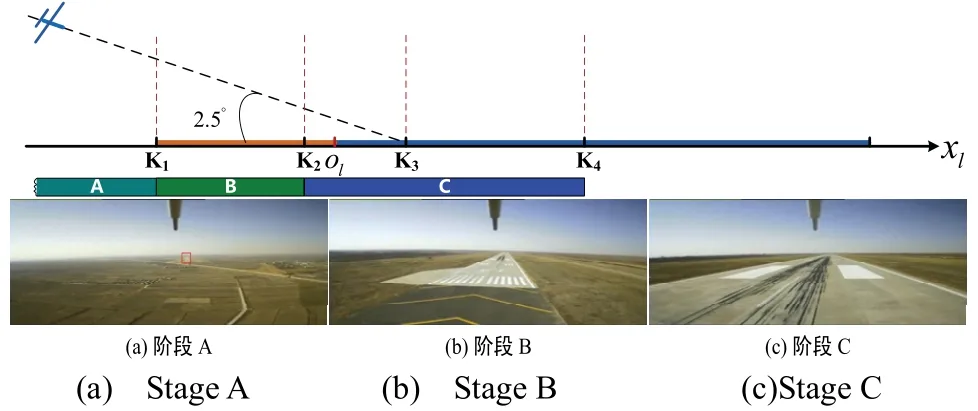

无人机着陆过程中跑道成像典型情况如图9所示,根据无人机与跑道相对距离的变化,将着陆过程分为A、B、C 三个阶段:

A 区:xl<K1,即K1点之前,由于无人机距离机场跑道较远,跑道成像表现为点目标,如图9(a)所示,不进行边线提取,在视觉传感器坐标系内不能解算相对位置/姿态信息;

B 区:K1≤xl<K2,即K1,K2点之间,机场跑道完整成像为梯形目标,如图9(b)所示,在视觉传感器坐标系内可以进行跑道辨识,提取左右边线和起始线,获得高精度相对位置/姿态测量信息,并与惯性传感器导航信息进行融合,提高着陆导航信息的测量性能;

C 区:K2≤xl<K4,即K2点和刹停点K4点之间,跑道成像不完整,如图9(c)所示,图像中无跑道起始线,可提取跑道的左右两条边线,视觉测量奇异,无法获得唯一解,可通过惯性传感器导航信息、无人机滑跑运动约束等辅助获取相对位置/姿态信息,保持着陆导航信息的测量精度。

图9 无人机着陆过程中跑道成像Fig.9 Runway images during landing process

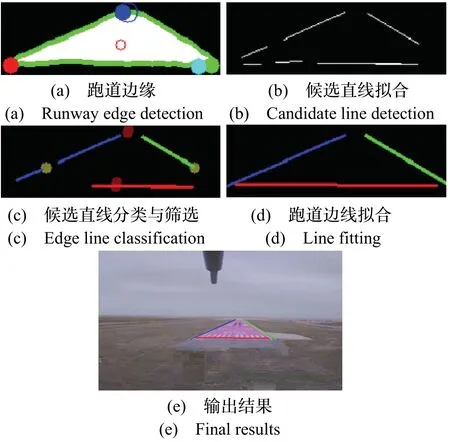

基于跑道分割网络输出的分割图,通过跑道轮廓检测、空间矩计算、跑道边缘检测、候选线段提取、边线筛选分类与拟合等步骤提取跑道左右边线和起始线(如图2所示),根据提取的跑道边线,分阶段计算无人机与机场跑道之间的相对位置和姿态参数。

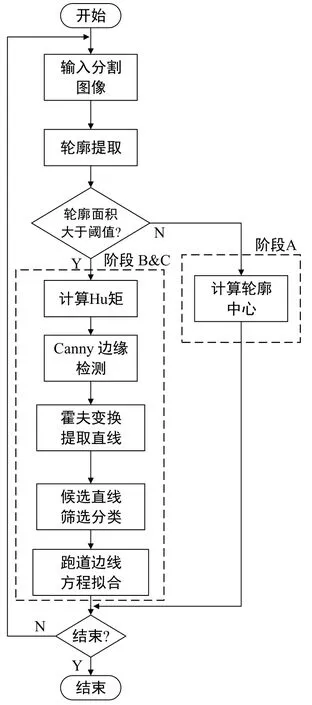

2.2 边线提取与位姿解算

跑道边线提取流程如图10所示。首先进行轮廓检测,以跑道分割网络输出特征图为输入,检测并计算所有轮廓面积,选取轮廓面积最大的作为跑道区域。根据跑道轮廓占比进行着陆阶段判断:设输入图像的宽和高分别是w、h,跑道轮廓宽和高w′、h′满足w′≤1 /15*w、h′≤1 /10*h,且跑道区域面积小于1 /150(w*h),认为处于A 阶段,否则认为处于B、C阶段。A 阶段只提取轮廓中心,不提取边线,B、C阶段提取边线。

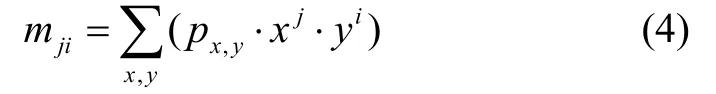

随后计算跑道区域的空间特征。对阶段B 和C 的图像计算最大轮廓的零阶和一阶空间矩:

其中i,j∈ (0,1),x,y表示图像像素列坐标和行坐标,px,y表示图像像素值。

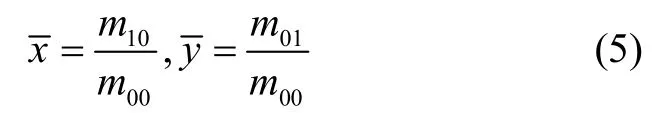

根据空间矩计算跑道轮廓的重心坐标pm(图11(a)中红色圆):

计算跑道轮廓的周长larc、轮廓最左侧点pl(图11(a)中红色)、最右侧点pr(图11(a)中绿色)、最顶端点pt(图11(a)中蓝色)和最底端点pb(图11(a)中青色)的坐标值。

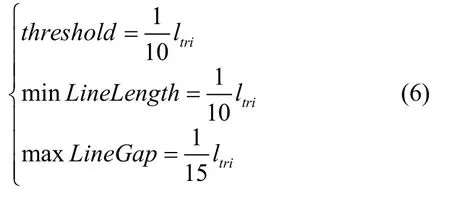

图10 跑道边线提取流程Fig.10 Flowchart of runway edge line detection

然后进行候选线段拟合。采用Canny 边缘检测算子对跑道轮廓进行边缘检测后,使用概率霍夫变换进行候选线段拟合。在无人机着陆过程中,跑道区域由小到大尺度变化较大,为此假设B、C 阶段跑道区域为等边三角形,则三角形边长ltri=1 / 3*larc,使用跑道轮廓周长更新概率霍夫直线变换参数,累加器阈值threshold、最小线长 minLineLength、最大线距maxLineGap,如式(6)所示:

拟合得到的候选线段如图11(b)所示。

然后进行跑道边线筛选与分类。定义跑道区域中线为轮廓重心pm和轮廓最顶端点pt的连线,记其斜率kmid,定义水平线为过轮廓重心pm斜率为零的直线。存在起始线时,起始线斜率与左右边线斜率相差很大,设ts为存在起始线的阈值,计算所有候选线段斜率k、中点pct,与中线的交点记为pmid,与水平线的交点记为phori,统计最小斜率kmin和最大斜率kmax的绝对值,根据跑道几何约束关系将候选线段分为左边线、右边线、起始线三类。

为了进一步消除错误分类进入跑道边线的线段,需要进行异常值剔除。计算每一类中所有线段的平均斜率和坐标作为该类参考线段,通过比较每条线段与参考线段的斜率差值和距离,剔除超过阈值的线段。候选线段辅助坐标点、分类结果和剔除异常值后的跑道边线如图11(c)所示。

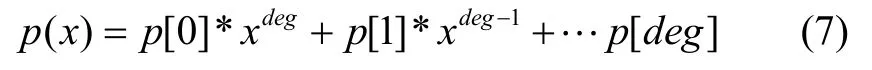

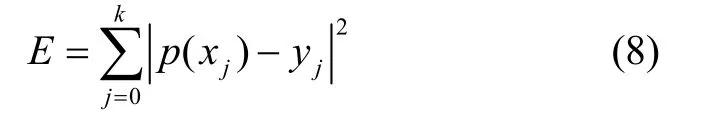

最后进行跑道边线方程拟合。经过以上步骤得到了各个类别的跑道边线线段,对每一类线段组进行一阶多项式拟合,得到相应直线的坐标方程。多项式方程为:

其中p[i]为多项式系数,deg为多项式阶次,文中取1。

通过迭代使平方误差最小化得到直线方程的最优解。目标函数为:

其中k为该类别边线线段数量。

跑道边线拟合结果如图11(d)所示,跑道区域检测结果、跑道边线识别结果与输入图像叠加效果如图11(e)所示。

获得跑道左右和起始边线原始特征后,无人机着陆过程中相对位姿信息解算算法详见团队之前的工作[7]。A 阶段跑道成像区域很小,将跑道视为点目标,粗略求得无人机在世界坐标系下的航向角ψ与俯仰角θ;B 阶段提取跑道三条边线,求解相对位置和相对姿态全部参数;C 阶段仅能提取跑道左右边线,求得航向角ψ、俯仰角θ、无人机侧偏tx,垂偏tz。

3 实验验证

3.1 传感器设置

以某型固定翼无人机为飞行载体,搭载FLIR BFLY-PGE-23S6C-C可见光相机、Mti-G 710和OEM615卫星接收机等对本文算法进行实验验证。FLIR 可见光相机采用 Sony IMX249 传感器,最大分辨率为1920×1200,其全局快门(Global shutter)设计有利于高速飞行时图像采集。相机镜头选择与可见光相机相匹配的VTS1614-M2,镜头为16 mm 焦距,试验时F 数(F No.)设为4。算法定位精度使用差分卫星(DGPS)接收机来评价,差分接收机由机载OEM615 移动站和地面OEM615 基站组成。

图11 跑道边线提取中间过程可视化结果Fig.11 Intermediate results of runway edge line classification.

3.2 数据集及训练细节

为使网络训练数据贴近真实机场场景下跑道分割、机场跑道检测的实际应用需求,收集了多个跑道不同季节、不同时刻、不同天气下的机场跑道图像序列,经过降采样和人工筛选得到1753 张跑道图像。此外,在互联网上搜集并筛选得到948 张着陆跑道图像,共计收集2701 张分辨率960×600图像。

设置“跑道”和“背景”两个类别语义标签:跑道区域定义为左右跑道边线、起始斑马线和终止斑马线之间的区域,其他图像区域划分为背景。以数据采集的季节、时刻、天气与跑道情况将数据划分为2124 张训练集和557 张测试集,命名为Runway 数据集。

采用两块Nvidia GTX 1080Ti GPU 的服务器(CPU型号为I7-8700K,32GB 内存)和Ubuntu 16.04 操作系统搭载训练平台,训练代码基于TensorFlow[20]开源框架实现。首先使用在ImageNet 数据集上预训练的ShuffleNet V2 来初始化主干网络权重,然后在MS COCO 数据集上对整个网络进行端到端预训练,最后在Runway 数据集上进行最终的迁移训练。

数据增强方面,首先使用缩放因子为[0.5,2.0],步长为0.25 的随机缩放操作。然后对训练输入图像进行961×609尺寸随机裁剪。最后对训练图像使用了概率为0.5 的随机左右翻转操作。

3.3 实验结果

首先进行 RunwayNet 各个模块的消融实验(Ablation Experiments),然后将自注意力模块中间结果进行可视化,最后给出RunwayNet 在英伟达Jetson AGX Xavier 嵌入式平台上的跑道检测效果图和三架次飞行试验位姿解算精度分析。

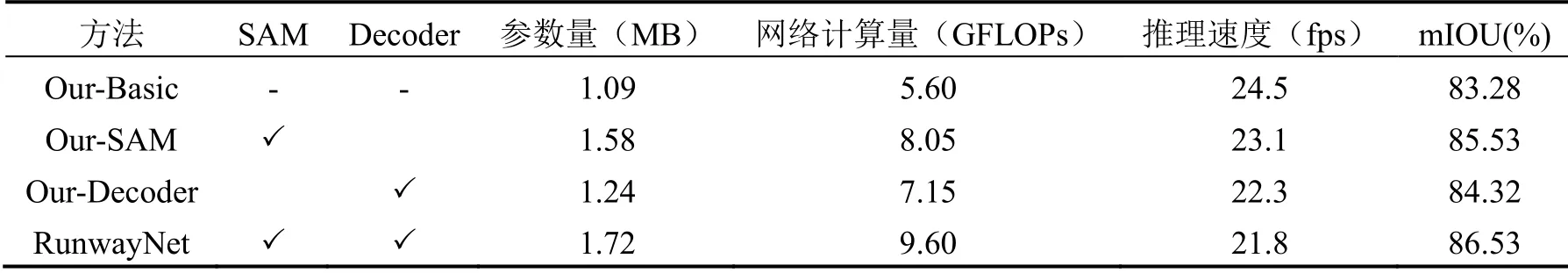

3.3.1 消融实验

在Runway 数据集上进行RunwayNet 各个模块的消融实验(Ablation Experiments),验证各个模块及其组合的性能、参数量和计算量。跑道分割精度用平均交并比[21](mean Intersection over Union,mIoU)来评价,参数量的单位为MB(兆字节),网络计算量用每秒浮点运动次数GFLOPs 表示,GFLOPs=1×1 09FLOPs,GFLOPs 在网络输入为961×609×3分辨率下测得。实验结果如表5所示,表中“SAM”和“Decoder”分别表示自注意力模块和解码器模块,“Our-Basic”方法表示只使用主干网络进行语义分割,推理速度用fps 表示,在英伟达Jetson Xavier 平台上测得(部署时使用Nvidia Tensor RT 库进行加速),mIoU 得分在Runway测试集计算得出。

表5 RunwayNet 网络各模块消融实验Tab.5 Ablation Study for RunwayNet Modules

由表5中数据可知:

“Our-Basic”网络配置在参数量仅1.09 MB,计算量仅5.60 GFLOPs 的情况下mIoU 得分已经达到83.28%,在Xavier 上推理速度达到24.5 fps;

“Our-SAM”网络配置在主干网络的基础上添加了自注意力模块,参数量略微增加0.49 MB,计算量增加2.45 GFLOPs,推理速度也略微下降到23.1 fps,mIoU 评分提升了2.25%达到85.53%;

“Our-Decoder”网络配置在主干网络的基础上添加了解码器模块,参数量略微增加0.15 MB,计算量增加1.55 GFLOPs,推理速度稍微下降到22.3 fps,mIoU 评分相比“Our-Basic”网络提升1.04%;

RunwayNet 网络整合了自注意力模块和解码器模块优点,参数量为1.72 MB,计算量为9.60 GFLOPs,在Xavier 上推理速度为21.8 fps,最终mIoU 评分达到86.53%,相比于“Our-Basic”网络评分提高了3.25%,验证了本文设计的自注意力模块、解码器模块和RunwayNet 跑道分割网络的优异性能。

3.3.2 数据可视化

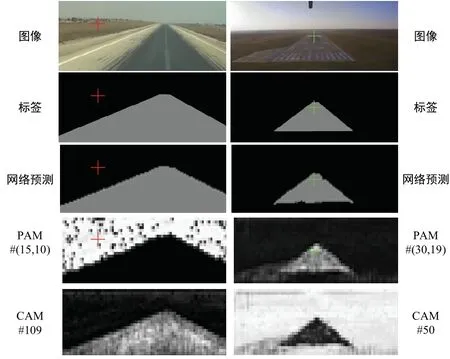

为了更好地理解注意力模型的原理并验证本文构建的自注意力模块的有效性,对图像标签、网络预测结果、位置注意力图和通道注意力图等网络中间结果进行可视化分析。在进行可视化分析时,说明如下:

1)通道注意力特征可视化时,对融合了原始特征图和通道相关性信息的通道注意力模块输出特征图进行可视化;

2)网络输入的原图和标签尺寸为961×609,网络预测结果OS=8,所以网络预测原始分辨率为121×77,而自注意力模块输入和输出特征图OS=16,所以注意力图实际分辨率为61×39,为了可视化方便,将各图像缩放至统一尺寸;

3)实际训练时标签图像和预测输出的像素值为其对应的类别,像素取值分别为0,1,可视化时将标签图像和预测结果进行了因子的加权,方便区分不同的类别标签。自注意力模块可视化结果如图13所示。

图13 自注意力模块中间层可视化结果Fig.13 Visualization of self-attention module intermediate layer

图中每一列对应一张图的可视化结果,第一行为输入原图,第二行为真值标签,第三行为网络预测结果。“PAM”表示位置注意力图,其标号对应图中像素位置(x,y),“CAM”表示通道注意力图,其标号对应通道号。由第四行第一列可见,红色坐标点(15,10)对应的位置注意力图提取了整个图中“背景”类别的信息,分类准确,边界清晰。第四行第二列绿色坐标(30,19)像素点对应跑道区域,其位置注意力图对整个标签真值定义“跑道”区域响应明显,对非标签定义但是人类认知上的跑道区域有所响应而且有较强的抑制作用,对“背景”类别没有任何响应。由最后一行可见,通道注意力图同样提取了不同类别清晰的分割区域,如第一列第五行中通道注意力图通道109 提取了“跑道”类别,第二列第五行中通道50 对“背景”类别响应强烈。

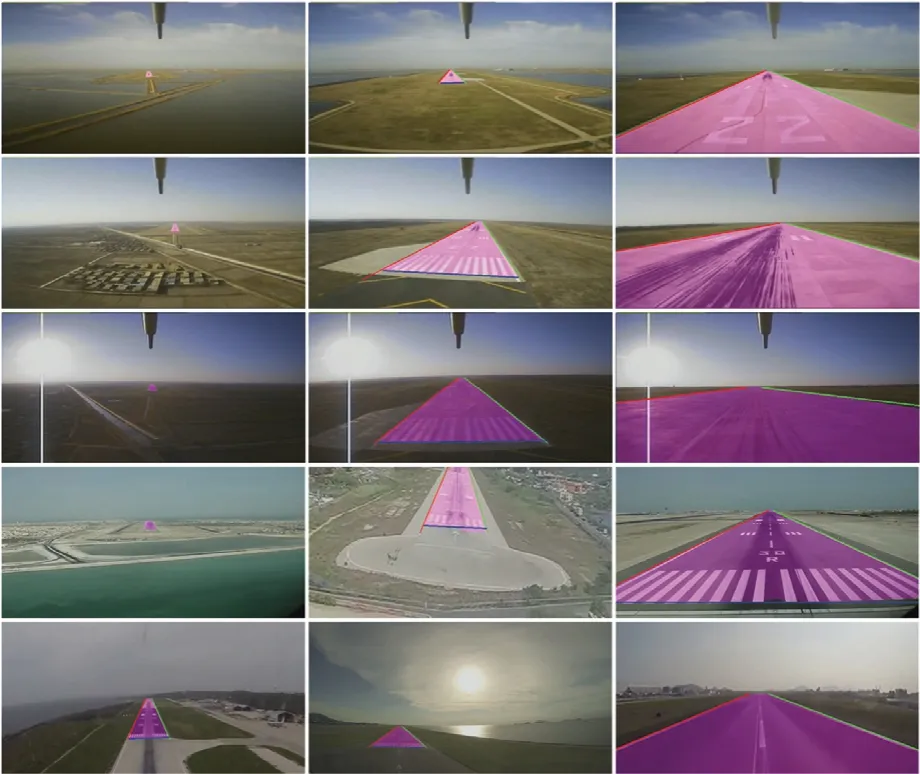

对设计的RunwayNet网络的整体有效性进行可视化分析,给出RunwayNet 在Runway 测试集上的分割和边线提取结果,如图14所示,跑道区域用紫色标记,前三行图像为机载实验采集所得,后两行图像由互联网搜集所得。由图中第一列结果可见,RunwayNet 网络在离跑道很远(大于3 公里)的距离就对跑道区域正确感知,人眼隐约看见跑道的时候网络即可大致识别出跑道区域。由最后一列结果图可见,从无人机即将着陆到完全降落到跑道上滑行,网络都准确地分割出了跑道区域。结合图中第一列、第二列和第三列结果可见,网络对由远及近着陆过程中各个阶段的跑道,对不同时刻、不同季节、不同背景、不同铺设条件的跑道都能准确进行分割检测。

图14 跑道分割与边线检测结果Fig.14 Segmentation and edge line detection results of Runway test set

3.3.3 定位精度分析

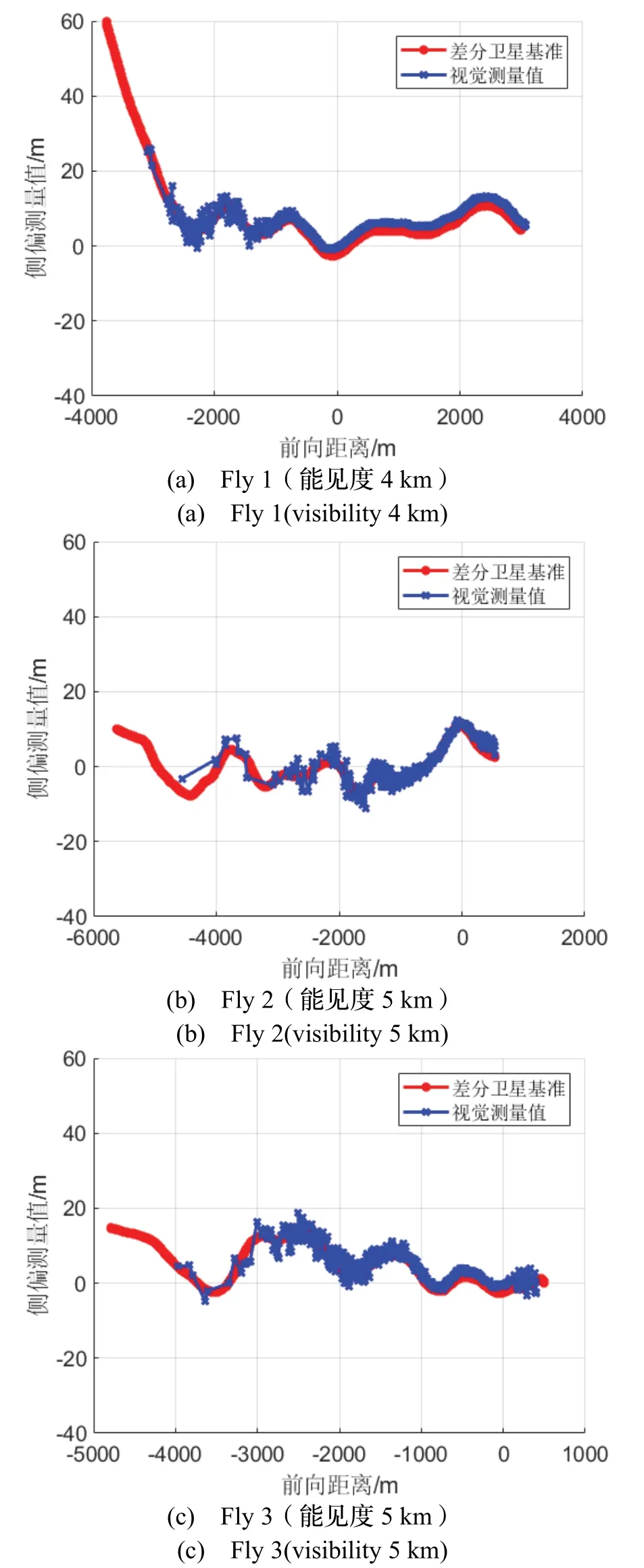

对三架次(Fly1- Fly3)飞行试验位置解算精度进行分析,如图15所示,红色曲线为差分卫星测量值,作为精度评价基准,蓝色曲线为本文算法输出测量值。从图中可以看到:

1)Fly1 作用距离为3091 m,Fly2 作用距离达到4555 m,Fly3 作用距离为3964 m,可以看出作用距离可达3~4 km;

2)在-2 km 后进入稳定跟踪阶段,特别是进入-1 km 后的近距离着陆段,着陆视觉算法的曲线与差分系统曲线高度吻合;

3)飞越跑道起始线后,依然可稳定输出侧向和垂向相对测量值。

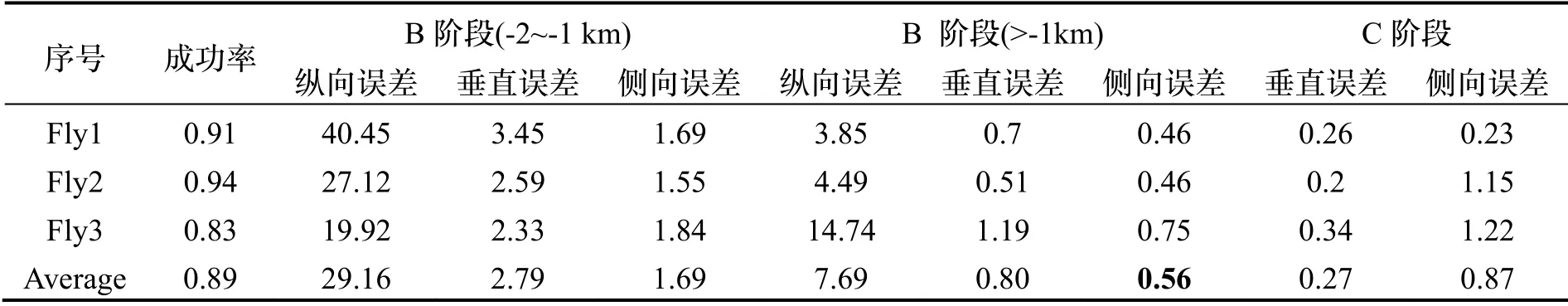

图15 系统定位精度曲线Fig.15 Accuracy of the positioning system

三架次数据位置测量误差及成功率分析见表6,其中识别成功率为分割出跑道并解算出位置信息的帧数与着陆过程总帧数的比值。可以看出,无人机进入-2 km 后,三架次识别成功率接近90%。B 阶段(-2~-1 km)垂向误差(Vertical error)平均值为2.79 m、侧向误差(Lateral error)平均值为1.69 m,进入-1 km后垂向和侧向误差分别减小到0.80 m 和0.56 m;C 阶段垂向和侧向测量误差分别为0.27 m 和0.87 m,完全满足无人机控制要求。

4 结 论

本文针对无人机在复杂环境下自主着陆应用场景,提出了基于深度神经网络图像语义分割的无人机着陆导航方法,构建了轻量高效的端到端跑道分割神经网络RunwayNet,通过主干网络与自注意力网络模块的设计,使网络具备全局像素和空间位置相似特征提取能力,同时设计了可融合网络浅层丰富的细节、空间位置信息与顶层粗略、抽象的语义分割信息的解码器模块,完成了跑道的实时、可靠、精细分割,在此基础上,设计基于跑道分割区域的边线提取和位姿解算算法实现了无人机着陆相对导航信息的解算。机载飞行实验结果表明,基于英伟达Jetson Xavier 嵌入式平台可实现21.8 fps 的处理速度,对陌生跑道的最远探测距离达到3 km 以上,末段侧向平均定位精度达到0.56 m。本文方法在大幅提高跑道检测精度、检测速度和检测距离的同时,可适用于背景改变、天气变化、季节变化和陌生跑道等情况,具有一定的实用价值。

表6 定位精度统计(单位:米)Tab.6 Precision statistics(Unit:m)