基于视点跟踪的人机交互技术的研究

2020-02-22王宇鸿王健庆

王宇鸿 王健庆

摘 要:为开展视点定位与跟踪研究,实现单摄无光源的基于视点跟踪技术的人机交互系统,文章利用质心法来进行瞳孔定位,并使用几何模型映射方式校准人眼状态和屏幕坐标的对应值,最后实现了较为准确的视点坐标提取与追踪及相应的应用功能。该算法简单易行,具有较高稳定性和准确性,可应用于AR、VR等设备进行辅助操控,也可应用于医疗护理等领域,辅助失能人士进行有效操控,提高其生活质量和便利性。

关键词:视点跟踪;瞳孔定位;人机交互

中图分类号:TP391.4 文献标识码:A 文章编号:2096-4706(2020)17-0020-04

Abstract:Objective to research on gaze positioning and tracking,and implement an human-computer interaction system based on gaze-tracking with a single camera of no light source. Method the average-force algorithm is used to locate pupils,and geometric model mapping is used to calibrate the corresponding value of human eye state and screen coordinates. Result the accurate gaze positioning and tracking with according application functions are implemented. Conclusion the proposed algorithms are easy to be realized with high stability and accuracy,with can be applied in AR,VR devices for auxiliary control,or in medical and nursing fields to facilitates the disabled to realize effective control,to improve their life quality and convenience.

Keywords:gaze tracking;pupil locating;human-computer interaction

0 引 言

視觉在大部分人机交互方式中都有着重要的地位,利用视点跟踪技术将视觉信号直接转换为对计算机的操作,将会使人机交互模式更加便利自然,同时也能够满足一些特殊人群的需求,这项技术目前在工业、游戏、医疗等领域都有着较为广泛的运用。在当前中国老龄化程度不断加深的情况下,本研究在本单位医学视觉、康复学、健康护理等研究的基础之上,面向无人照料的老年人等失能人群,开展基于视点跟踪技术的智能化健康护理技术的理论研究和相应的应用系统开发研究。现有研究中,大多数视点跟踪技术对设备的计算能力要求都比较高。本文中笔者利用了人眼图像处理结合几何模型的方式实现了对人眼视点的跟踪,算法可以使用较低的设备成本实现,同时有较高的用户自由度和精度,具有较好的实用性。

1 研究意义和现状分析

1.1 研究意义

视点跟踪技术正在快速发展,人类对新型人机交互的需求也在不断扩大,若能将两者结合,创造出一种以视点跟踪技术主导的新型人机交互系统,将会给计算机行业带来一场变革[1]。目前,视点跟踪技术以辅助现有技术的方式被广泛运用于各大行业。尤其是在医疗领域中,一些已经丧失操作传统设备能力的失能人士,如果使用集成视点跟踪技术的IO设备,用眼控的方法代替鼠标和键盘的输入方式,就有可能实现电子设备的无障碍使用,满足其日常人机交互需求。人的视线方向变化和视点轨迹还可以反映出人的心理状态与精神状态,若能将病人的视觉信息记录并加以分析,对一些有心理疾病的患者的治疗来说也是有益的[2]。显然,视点跟踪技术的发展与使用是大势所趋,越来越多的研究将其融入人机交互技术之中,使其成为一种新型的、自然的、高效的全新交互模式[3]。目前的视点跟踪技术为得到较高的精度,大多需要用户佩戴特殊设备,即常说的侵入式设备,这样的设备可能会给用户在心理层面上带来不适感[4]。笔者针对此问题提出一种非接触式且设备成本较低的基于视点跟踪技术的的人机交互系统。

1.2 视点跟踪技术

视觉信息在人与外界的交互中占比超过80%,视觉信息处理在人与外界交流时非常重要。人类对眼动的研究可以追溯到数百年前[5],但第一台眼动仪的诞生距今不到100年。视点跟踪技术的出现,突破了传统基于键盘鼠标的交互模式,以智能化的人机交互技术开创新的交互方式。目前视点跟踪技术日趋成熟,逐渐被广泛应用于各项领域。

视点跟踪技术一般可以被分为两种;一种是通过穿戴或配置特殊设备,使用红外线等一些特殊光源,通过瞳孔-角膜反射法等技术获取视线信息。这种方法一般精度较高,但对用户有一些限制;另一种则是基于图像处理技术,通过摄像头采集用户面部图像,再利用图像处理程序,估计用户视点位置,这种方法对用户限制小,但精度相对较低[6]。

目前,视点跟踪技术发展迅速,越来越多的研究成果不断出现,如张闯等利用亮瞳现象,提出了一种基于多通道图像的高精度亚像素特征参数提取方法[7],占艳团队实现了一种以Hough变换为基础的瞳孔定位算法[8],李擎团队提出了一种更精确的瞳孔检测算法[9]。

视点跟踪技术在快速发展的同时,目前仍面临着不少问题,主要有:

(1)数据采集的有效性无法保证,大量累积数据处理分析困难;

(2)程序对用户行为进行数据分析时,无法确定用户的具体目的,因为用户眼部动作并非每一个都是有意义的;

(3)大部分视点跟踪技术无法同时保证用户的自由度和视点的精度;

(4)视线信息与用户其他信息不能有效整合以进一步完善系统功能[10]。

现在看来,视点跟踪技术逐渐成熟,但仍有很大的完善空间,尤其是在商用、民用领域。未来视点跟踪技术的发展应该是向着高用户自由度、低使用成本、高反馈精度的方向进一步提升。

2 视点跟踪技术原理

2.1 质心法求瞳孔中心

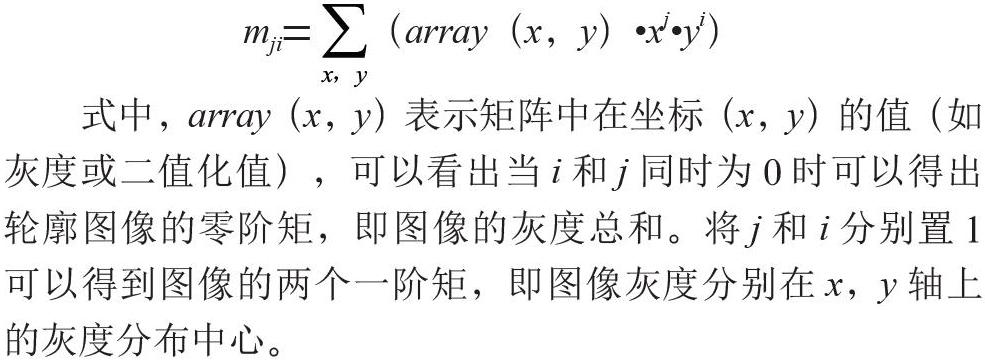

虹膜图像特征区域一般近似椭圆,其中心都可用质心来表示。首先利用轮廓检测算法对已获得的虹膜图像二值化图进行边缘检测,利用检测到的边缘计算轮廓围成区域的零阶矩和一阶矩,来计算质心。图像矩mji的计算公式为:

式中,array(x,y)表示矩阵中在坐标(x,y)的值(如灰度或二值化值),可以看出当i和j同时为0时可以得出轮廓图像的零阶矩,即图像的灰度总和。将j和i分别置1可以得到图像的两个一阶矩,即图像灰度分别在x,y轴上的灰度分布中心。

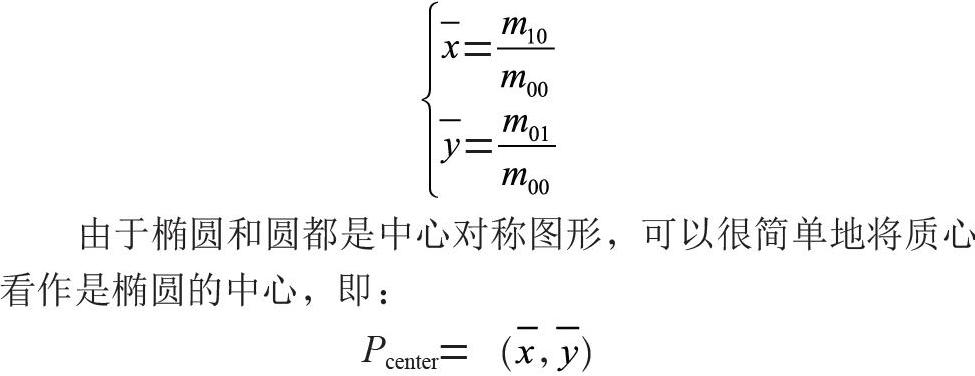

从如下公式中可以分别通过x与y的一阶矩和零阶矩的比来得出轮廓包含所有点横纵坐标的平均数,即质心的横纵坐标:

由于椭圆和圆都是中心对称图形,可以很简单地将质心看作是椭圆的中心,即:

2.2 视点估计方法

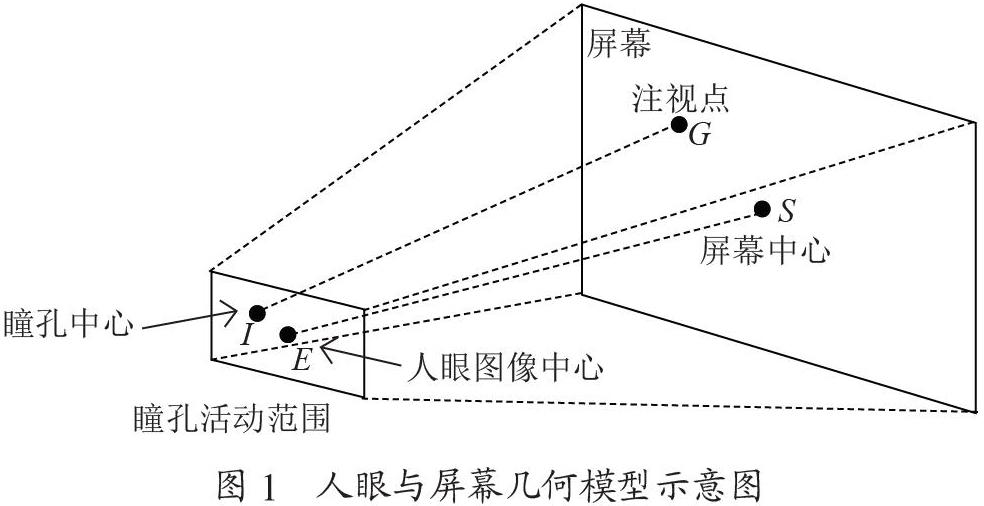

得到瞳孔中心坐标I(xI,yI)与人眼图像中心坐标E(xE,yE)后,可与屏幕参数建立关系模型,如图1所示。

人眼图像中心坐标可视为静止不动的参考点,当眼球运动时瞳孔位置相对摄像头图像中心位置就会发生改变,可以计算出水平、垂直方向上改变量,并对双眼同时进行处理,将求得改变量分别取均值得到水平、垂直方向的平均改变量H、V:

能够得到视线在水平、垂直方向上改变的单位值Hratio与Vratio,将这两个值视为视线方向。然后对单位值与屏幕进行校准,分别得到两个改变量的最大值max(Hratio)、max(Vratio)与最小值min(Hratio)、min(Vratio)。将两个方向上最大最小值的差与屏幕的长(Xscreen)、宽(Yscreen)的相除(单位为pixel),分别求得水平垂直两方向上眼球坐标改变量与屏幕上视点相对于屏幕中心改变量的比值RH与RV:

进而可得到注视点G的坐标:

G((max(Hratio)-Hratio)×RH(Vratio-min(Vratio))×RV)

3 系统实现与实验验证

3.1 系统结构与实现

系统采用了单摄像头无光源的模式,摄像头置于显示器顶部中央,用户配合系统提示进行参数校准后即可使用视点跟踪功能。系统结构如图2所示。

人在注视物体时,通过变动眼球方向,实现视点的改变,眼球的状态与视点的位置之间存在着映射的关系。因此,建立眼球状态与视点坐標模型,再将得到的模型与视点之间建立映射关系,就能实现利用视点进行人机交互。系统主要分为人眼图像分析处理和视点估计的映射算法两部分。

3.1.1 人眼图像分析处理

利用dlib的特征点提取器从摄像头获取图像中的脸部和眼部,并判断采集数据是否合理(如:眼部是否包含在脸部中,是否将嘴巴或鼻子识别为眼睛等),截取眼部图片。环境复杂光线会在虹膜上形成的亮斑,这些亮斑会影响瞳孔中心定位的准确,需要使用图像腐蚀的方法将其去除。得到如图3所示的虹膜图像。

摄像头记录的虹膜图像在眼球运动中大多以椭圆和圆的形状出现,且具有较低的灰度值(灰度值越低越黑)。首先用合适的阈值对虹膜图像进行二值化得到如图4所示的二值化图像,提取到虹膜区域,对于阈值的处理系统采用了阈值优化的方式来保证二值化图片的可用性。

使用质心法进一步处理图4即可得到瞳孔中心。至此,人眼特征参数提取完毕,图5为人眼瞳孔中心坐标参数提取结果。

3.1.2 视点估计功能实现

根据获取到的瞳孔中心坐标、摄像头图像中心坐标参数,与屏幕数据校准,瞳孔中心活动范围可视为平面,且与屏幕相对平行,将所得数据代入视点G坐标公式中,即可得到视点坐标。实验中笔者所用系统显示器分辨率为1 920 pixel ×1 080 pixel。

伪代码实现如下:

if ver_direction > min(VRatio):

gaze_y = (ver_direction – min(V))* RV

if hor_direction < max(HRatio):

gaze_x = (max(H)- hor_direction)* RH

3.1.3 张嘴点击检测实现

为实现系统操控功能,笔者通过张嘴检测实现在定位点相应的点击功能。dlib人脸姿势估计模型得到的68个人脸特征点中,序号为47~67的点位为嘴部特征,其中序号为60~67的点位为内嘴唇特征,可以有效判断嘴巴的开闭,47号点位与54号点位为嘴巴的左右两边的极点,利用内嘴唇特征与嘴部宽度的比值作为嘴部开闭的特征值,特征检测图像如图6与图7所示。

设置一个阈值t,当嘴部开闭的特征值超过t时,就触发点击功能。

3.2 算法精度测试

为了验证本系统的精度,笔者对系统屏幕进行定标,将屏幕平均分为9个部分,取每个部分的中心坐标,将九个定标点作为测试点,记录测试者看向各测试点时系统所得注视点坐标值。

共测试得到180组数据,计算(视点的实际坐标与测得坐标的差值为一组数据)得到x轴平均误差42 pixel,y轴平均误差21 pixel,x轴最大误差212 pixel,y轴最大误差170 pixel。

3.3 误差分析

3.3.1 输入图像质量造成的误差

传统摄像头通常成像质量不高,会出现眼部图像较为模糊的情况,这直接影响了人眼图像的处理过程,以及后续视点估计的准确性。

3.3.2 头部运动造成的误差

在测试的过程中,测试者头部位置多少会有些变动,此时将会造成人眼图像的偏移与变形甚至模糊,这将大大降低人眼检测的精度。本系统在设计原则上希望测试者将惯用眼置于校准时的位置,且不要有大的位移。

3.3.3 眼部图像处理阈值估计的误差

研究采用多次估计取平均值的方式来减小阈值带来的误差,但此方法不够稳定。

4 总结

视点跟踪技术已经有了不错的技术基础和用户基础,但由于现实情况的复杂多变以及视点跟踪技术自身的局限性,其在商业化和普及化的道路上还有很长的路要走。本文提出的一种基于视点跟踪的人机交互系统,在瞳孔定位分析算法,和视点估计算法进行了一些尝试,提出了可行的方案,本系统具有使用成本低、视点跟踪精度高、算法简洁的特点。

5 结 论

本文实现了一种基于图像处理的非接触式视点跟踪技术。该算法较为容易实现而且使用者不必花费过多的成本购买设备,并且实验也验证了本方法的可行性。在日常使用的环境下,系统有较高的稳定性和准确性。本研究可以较为便捷地满足失能人士对电子产品的一些基本操控需求。后续将进一步提高算法的精度,以实现更为精准的视点定位,以提高应用操控的准确性,同时将该技术与传统交互设备整合,提升系统的泛用性。

参考文献:

[1] 栗战恒,郑秀娟,刘凯.移动设备视线跟踪技术研究进展 [J].计算机工程与应用,2018,54(24):6-11+148.

[2] 周小龙,汤帆扬,管秋,等.基于3D人眼模型的视线跟踪技术综述 [J].计算机辅助设计与图形学学报,2017,29(9):1579-1589.

[3] JACOB R J K,KARM K S. Eye tracking in human-computer interaction and usability research:Ready to deliver the promises [J].Mind,2003,2(3):573-605.

[4] HENNESSEY C,NOUREDDIN B,LAWRENCE P D. A single camera eye-gaze tracking system with free head motion [C]//ETRA06:Proceedings of the 2006 symposium on Eye tracking research & applications. New York:Association for Computing Machinery,2006:87-94.

[5] 赵新灿,左洪福,任勇军.眼动仪与视线跟踪技术综述 [J].计算机工程与应用,2006(12):118-120+140.

[6] 冯成志,沈模卫.视线跟踪技术及其在人机交互中的应用 [J].浙江大学学报(理学版),2002(2):225-232.

[7] 张闯,迟健男,邱亚飞,等.视线追踪系统中特征参数提取方法研究 [J].中国图象图形学报,2010,15(9):1299-1308.

[8] 占艳,韦昌法,刘青萍,等.基于Hough变换的虹膜图像预处理研究 [J].软件导刊,2016(10):167-169.

[9] 李擎,胡京尧,迟健男,等.视线追踪中一种新的由粗及精的瞳孔定位方法 [J].工程科学学报. 2019,41(11):1484-1492.

[10] 李曉丽,黄敏,莫冰.视线跟踪法——网络用户信息行为研究的新方法 [J].图书馆理论与实践,2009(8):25-29.

作者简介:王宇鸿(1998—),男,汉族,浙江杭州人,本科生,研究方向:计算机科学与技术;通讯作者:王健庆(1975—),男,汉族,河北唐山人,讲师,博士,主要研究方向:计算机视觉、模式识别等。