无人机软管式自主空中加油视觉导航技术

2020-02-18许悦雷加尔肯别克

周 清,许悦雷,加尔肯别克

(西北工业大学无人系统技术研究院,西安 710072)

0 引言

无人机自主空中加油(Aerial Refueling, AR)导航主要包括对加油锥套的检测、跟踪、位姿计算三个方面。在加油过程中,加油机和受油机由远及近。在处于远端阶段时,加油锥套所占成像像素比重较小,锥套信息的获取更容易受到视野中干扰源的影响。由于此阶段还未涉及对接任务,主要工作在于检测和跟踪到加油锥套,从而进行靠近。当加油机和受油机距离较近时,在检测和跟踪的同时进行锥套的位姿计算,准确获取锥套与受油锥头的相对位姿,并反馈给飞控系统,引导受油机自主对接锥套。

目前,在航空航天领域的对接任务中,根据任务目标的不同,可分为合作目标对接任务和非合作目标对接任务。合作目标对接任务具有计算量相对较小、精度较高等优势。合作目标的相对导航技术发展已较为成熟, 目前包括美国的自主交会技术验证( Demonstration of Autonomous Rendezvous Technology, DART)试验和我国的空间站计划等均已实现了合作目标的自主相对导航。而对于非合作目标捕获技术,目前还没有找到公开报道的在轨演示验证[1-2]。而对于无人机空中加油任务,完全可以采取加油机和受油机合作的方式。通常事先对加油锥套进行光学特征点的标记(在加油锥套坐标系下的坐标已知),如LED灯、红外、人工特殊颜色等。

德州农工大学的Valasek等研究了VisNav系统,将红外LED安装在锥套上,采集红外LED的数据后,利用高斯最小二乘微分校正算法得到六自由度导航信息。图像处理简便,提高了测量精度及处理速度[3]。比萨大学的Pollini等研究了基于被动视觉传感器的相对导航系统[4]。该系统采用多个红外LED作为标志。他们建立了伪实时闭环仿真系统,经过特征点提取及正交迭代算法[5]处理后得到虚拟相机与锥套之间的相对位姿信息。在国内,西北工业大学的宋春华等将安装在锥套内环的4个近红外LED作为特征标志,通过近红外成像的方式提取锥套的特征红外LED标记圆,以其圆心作为特征点,利用4个特征点进行椭圆拟合,将拟合的圆心作为锥套的中心[6]。北京航空航天大学的解洪文及西北工业大学的纪超等为解决传统单目视觉导航算法更新速度慢、易受干扰等问题,分别提出了基于双目视觉的空中加油导航方法[7-8]。将布置在锥套端面上的多个光学标志作为目标特征,利用双目视觉系统计算出光学标志的空间位置,通过空间圆的圆心及法线方向可以计算出锥套的位置和姿态。仿真结果表明,该方法在距离较近时位置和姿态测量精度非常高。国内空军工程大学的王旭峰等建立了自主空中加油的一个视觉相对导航半物理地面试验平台,并在加油锥套断面区域加装了红色标识环带,利用颜色及锥套环带对锥套进行目标识别,通过Kalman滤波估计得到相对位姿[9]。

通过对加油技术发展现状的总结分析可知,无人机空中加油需要解决鲁棒性和精度问题。上文介绍的文献中均获得较好的精度,但这些传统的加油对接导航方法很难突破鲁棒性瓶颈。而近年来,深度学习在目标检测方面展现出很高的鲁棒性,且当前基于回归的目标检测方法(一步法)已展现出良好的实时性[10]。但位姿计算采用成熟的传统算法比神经网络算法可靠得多。所以本研究的思路为,采用深度学习方法进行锥套目标检测和跟踪,辅助传统方法进行位姿计算;神经网络可以很好地弥补传统方案中鲁棒性不高的缺点,因此先采用神经网络寻找到目标,再在目标的小范围内进行特征点的提取,发挥深度学习和传统方案的优势。

采用深度学习进行锥套目标的检测和跟踪,神经网络由于具有高鲁棒性特点可以很好地完成这一步骤。当检测到加油锥套后,对检测框内的目标采用传统算法进行特征点检测、提取和匹配以计算加油锥套的准确位姿。

检测跟踪算法的原型选择技术上较为成熟的yolov3算法。yolov3算法为单步检测算法,速度上比Fater R-CNN快10倍左右。鉴于本任务的特点,对此算法进行了一定的改进,适当减小通道和层数。为了节省资源,在检测到锥套目标后,切换为更加轻量和快速的跟踪算法。本方案跟踪算法为检测算法轻量化,同时其检测范围比检测算法小,能够在不失准确性的同时获得更高的速度。

双目视觉算法主要包括3个过程:特征点提取、三维重建、相对位姿计算。首先提取到红色人工标记点的像素坐标;然后利用左右图像标记点坐标的关系进行坐标点的特征点三维重建;进而求得锥套目标坐标系和受油机坐标系的转换关系,即为加油锥套的位姿。

1 锥套检测和跟踪

采用检测算法检测到加油锥套后,检测算法停止运算,将结果传递给跟踪算法,跟踪算法为检测算法轻量化,通道减半,检测范围缩小,速度为检测算法的2.5倍,以进一步提高程序的时效性。

网络为边界框预测4个坐标tx,ty,tw,th。如果方格从图像左上角偏移(cx,cy),并且先验边界框宽度和高度分别为pw和ph,则相应的预测如下

bx=σ(tx)+cx

(1)

by=σ(ty)+cy

(2)

bw=pwetw

(3)

bh=pheth

(4)

使用逻辑回归为每一个边界框预测目标分数。如果某个先验边界框与真实边界框重叠的部分比其他先验边界框大,则这个边界框的目标分数就设置为1。如果某个边界框不是最好的边界框,但是和真实边界框的重叠部分超过预设阈值(在该算法中这个预设阈值设置为0.5),则这个预测将会被忽略。为每个真实标记目标分配一个边界框,如果边界框没有被分配到一个真实标记目标上,则不会产生坐标或预测损失,只是说明有物体。

在3个不同的尺度上预测目标,用一个与特征金字塔网络类似的概念从这些尺度上提取出特征。在基础特征提取器上添加了几个卷积层,用最后几层预测一个三维张量来编码边界框,并进行目标识别。对从前两层中提取的特征图进行上采样至2倍,然后取一个网络早期的特征图,并用连接将它和上采样特征合并。这可以从上采样的特征中获取更丰富的语义信息,从早期的特征图中获取更多细粒度的信息。最后增加几层卷积网络来处理这个合成的特征图,并最终预测一个相似的张量。然后把同样的设计在最终尺寸预测框上重新执行一遍。因此,对第三尺度的预测受益于所有先前的计算和网络早期的细粒度特征。

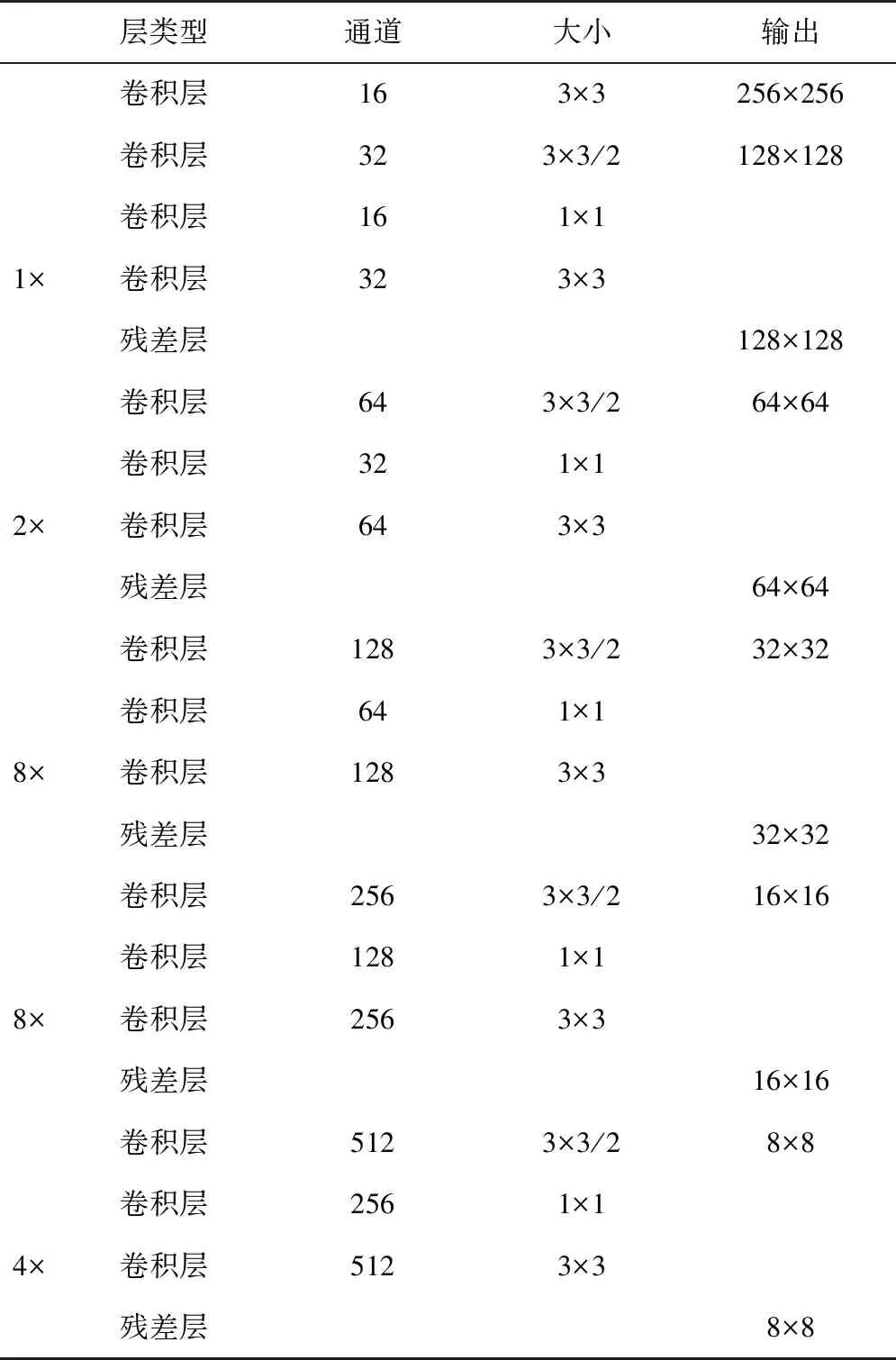

网络连续地使用3×3和1×1的卷积层,同时也有一些跨层连接,总共有42层。如表1所示。

表1 特征提取网络Tab.1 Feature extraction network

2 特征点提取

在完成对锥套的检测跟踪后,进行标记点的提取工作。标记点采用红色贴片,如图3和图4所示。从图中可见,摄像头左右照片曝光程度不同,左摄像头曝光低,右摄像头曝光高。为更加突出特征点的细节信息,可对照片进行修正。首先,采用伽马变换对左摄像头进行图像增强处理。由于左摄像头照片偏暗,需对灰度级较低的区域进行拉伸,因此将gamma值设置为小于1的数,此处设置为0.8,效果图如图6所示。另外,由于左右摄像头照片曝光程度不同,这可能造成后续左右特征点提取不对称。所以,以左摄像头伽马变换后的照片为基准,对这2张照片进行直方图规定化。加油锥套左图直方图如图7所示。图8为锥套右图以左图为基准的直方图规定化前后效果。

对于目标的颜色特征,采用HSV空间比RGB空间更易提取[11]。为了分割出有红色标记的图像区域,需要对HSV图片的色调、饱和度及亮度的上下限进行选择以进行阈值分割。从图9可以看出,分割效果十分理想。接着,需要进行轮廓检测,找到标记区域并以每个标记点的质心坐标作为特征点。这里,为了消除噪声干扰,需要对图片进行中值滤波和开操作、闭操作的形态学处理方法。另外,摄像头镜头并非理想的小孔成像模型,其本身带有一定的畸变。为了消除畸变,需要对特征点像素坐标进行校正,将提取的特征点按一定顺序以矩阵的形式保存。

3 特征点三维重建

由于左右特征点皆是按相同的顺序保存,这给特征点匹配工作带来了很大的便利。双目视觉三维重建原理如图1所示,用C1和C2这2台摄像机同时拍摄空间中一点P,通过图像匹配可以确定左、右成像平面上的投影点P1和P2为P的成像点。利用立体几何关系,有如下公式

图1 双目视觉三维重建原理Fig.1 Binocular vision three-dimensional reconstruction principle

(5)

(6)

式(5)和式(6)中分别消去Zcl和Zcr,得到关于[XbYbZb]的方程组

(7)

写成矩阵的形式为

AX=b

(8)

X代表P点在受油机坐标系下的坐标,理论上,式(8)有唯一解,但在实际应用中由于噪声的影响导致式(8)不一定有解,此时可以用最小二乘法求解,即

X=(ATA)-1ATb

(9)

4 相对位姿计算

位姿估计算法所要解决的根本问题是获取受油机和加油锥套之间的相对位置和相对姿态,即加油锥套和受油机相对位姿问题,实际上即是求解2个三维坐标系之间的平移和旋转问题。首先通过三维重建算法获得特征点的空间坐标。另外特征点在目标体坐标系下的坐标为已知量。于是可以根据特征点在2个坐标系下的坐标求得受油机和加油锥套的相对位姿。

设加油锥套开始的相对位姿为位姿Ⅰ,表示为(R,t);经过一段时间的相对运动之后,相对位姿变为位姿Ⅱ,表示为(R′,t′),如图2所示。

图2 加油锥套相对位姿示意图Fig.2 Drogue relative posture

旋转矩阵R是一个三维矩阵,它表示了2个坐标系各坐标轴之间的旋转关系。假设空间中的某点P在加油锥套坐标系和摄像机坐标系中的坐标分别为Pt=(Xt,Yt,Zt)T和Pc=(Xc,Yc,Zc)T,则有如下变换公式

Pc=RPt+t

(10)

常用的旋转矩阵的表示方法有欧拉角表示法和四元数表示法两种[12]。由于欧拉角在±90°位置存在奇异的问题,而且四元素具有4个自由度,任意旋转与单位四元数之间的关系都是一一对应的[13]。旋转矩阵与单位四元数的转换关系可以表示为

(11)

对于每个特征点其测量误差为

ei=Pci-(RPti+t)

(12)

解决位姿估计问题的方法之一就是通过各点误差平方之和的最小化来估计位姿参数(R,t),即将以下关于(R,t)的目标函数最小化

(13)

采用解析法对式(13)进行求解,即直接将特征点在2个坐标系下的坐标值代入式(13),建立关于(R,t)的方程组,然后解出位姿参数(R,t)[14]。从具体算法角度,采用单位四元数法对式(13)进行最小化问题的求解[15-16]。

由于坐标重心化转换模型可有效地解决法方程的病态问题。首先,将特征点在摄像机坐标系和目标坐标系下的坐标转换为重心化坐标,代入式(10)进行计算。通过化简,得到目标函数为

(14)

最小化式(12)相当于最大化式(13)。构造M矩阵后,对其进行特征值分解,求出最大的特征值及其对应的特征向量。

假设矩阵M的4个特征值为λi(i=1,2,3,4),与之对应的4个特征向量为ei(i=1,2,3,4),则有

定义2 端到端的时延:是指一个数据包从源节点到达目的节点所花费的时间,它是一个重要的衡量指标,因为它的大小能够直接反应出路由协议的性能,这里取平均值.

Mei=λiei,(i=1,2,3,4)

(15)

考虑是一个四维向量,任意的单位四元数q可以由线性表示出来。即

q=a1e1+a2e2+a3e3+a4e4

(16)

因为q是单位四元数,所以

(17)

假设最大的特征值为λi,则

(18)

故当a1=1,a2=a3=a4=0时,D可取得最大值。此时的单位四元数为q=e1,即为矩阵M最大的特征值所对应的特征向量。

求得了单位四元数q之后,将其代入式(11)即可求得旋转矩阵R,然后利用R和t的约束关系即可求出平移向量t。

5 实验结果

试验指标要求如下:稳定跟踪锁定目标距离范围应不小于40m;位置精度应满足与目标距离≤10m时,距离误差优于±10cm。

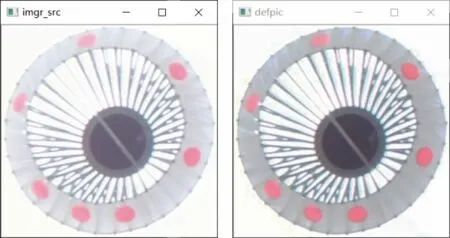

带标记的加油锥套原图如图3和图4所示。双目位姿计算仅需4个特征点即可,此处采用7个,通过最小二乘法拟合,还对遮挡情况具有一定的抗干扰性。图5所示为左摄像头图片的检测跟踪效果图,可见有比较好的检测跟踪效果,而且由于采用深度学习算法,鲁棒性也较好。

图3 加油锥套左摄像头照片Fig.3 Drogue left photo

图4 加油锥套右摄像头照片Fig.4 Drogue photo by right camera

图5 加油锥套左图跟踪效果图Fig.5 The tracking effect of drogue in left photo

图6 加油锥套左图增亮处理Fig.6 Image enhancement of drogue in left photo

图7 加油锥套左图直方图Fig.7 Histogram of drogue in left photo

图8 加油锥套右图直方图规范化Fig.8 Histogram specification of drogue in right photo

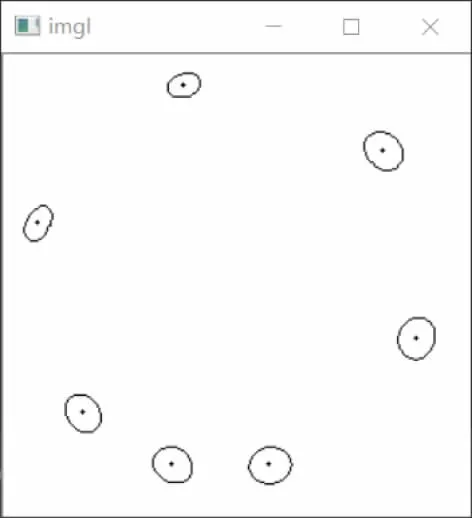

提取检测框内的图片内容进行图像分割处理,继而进行图片处理和特征点计算,并结合检测跟踪程序传递来的坐标,计算出左右图像特征点的坐标值。图9和图10所示分别为左摄像头照片特征分割和特征点提取效果图。由图可见,提取效果良好。

图9 左摄像头照片特征分割Fig.9 Feature segmentation in left photo

图10 左摄像头照片特征提取Fig.10 Feature extraction in left photo

最后,通过左右照片特征匹配即可得到特征点的空间坐标。并通过四元数计算加油锥套位姿。表2所示为计算得出7个特征点的空间坐标,表中数据为四舍五入后结果。

表2 特征点空间坐标Tab.2 Spatial coordinates of feature points

从表2可求得加油锥套和无人机相对位姿为:R=([0.92, -0.13, -0.38], [-0.21, -0.96, 0], [-0.34, 0.23, -0.91]),转化为欧拉角为:俯仰角θ=20.18°;偏航角ψ=-14.20°;滚转角Φ=-12.63°。t=([-0.40], [-0.10], [6.51])。

当捕获目标距离为40m时,垂直视场高46m。摄像机垂直分辨率为1080,故加油锥套在垂直方向占1080×0.6/46≈14个像素。同理,推理得水平方向亦占14个像素。经过实验表明,本文跟踪算法通过调整padding框的大小可以实现9×9个像素稳定跟踪,满足设计要求。

对第一个和第二个特征点真实距离采用激光测量,和本文算法得出的试验结果进行比较,距离精度如下。

表3 特征点距离精度Tab.3 Distance error of feature points

统计结果表明,在10m内,锥套位姿计算精度可达厘米级。

6 结论

本文针对无人机空中加油实际工程问题,提出了一种切实可行的技术思路。算法分析和实验结果表明:

1)加油锥套检测跟踪算法具有良好的鲁棒性和精度,为后续位姿计算带来了很大的方便。

2)采用标记点进行基于双目视觉的位姿计算方案计算简洁,精确度高。

3)为了提高识别效果,本方案特征点亦可采用LED灯或红外形式。