基于AI芯片和机器视觉的协同控制实现

2020-01-25王铖张真睿方超王琳娜张宝昌

王铖 张真睿 方超 王琳娜 张宝昌

摘 要:目前,对于如何实现无人集群在无网络、无GPS环境中的自主导航研究较少。因此,针对这种特殊的应用场景,基于机器视觉相关算法,本文创新性地提出了一套采用集中式编队方式的地空协同控制系统。该系统由空中侦察机、空中跟随机、地面侦察车和地面跟随车组成。空中侦察机采用VINS-MONO技术进行导航,提供位置基准;同时利用CVM-Net技术将空中侦察机与地面侦察车的拍摄图像匹配,得到二者相对位置,用于引导地面跟随车和空中跟随机。该系统采用YOLO-LITE检测算法,可实现实时目标检测;采用华为“麒麟970”智能芯片作为核心硬件,实现信息的实时无回传处理。利用该系统,地面与空中无人集群可在无网络、无GPS的环境进行自主导航定位与协同控制,在紧急搜救和军事侦察等领域具有广阔的应用前景。

关键词:无人集群系统;协同控制;AI芯片;GPS拒止环境;跨视角图像匹配;导航

中图分类号:TJ765; V249.32+9

文献标识码:A

文章编号:1673-5048(2020)06-0067-07

0 引 言

近年来,无人协同系统作为未来战争模式和智慧城市的发展方向,在军事、物流、紧急救援等领域得到了飞速发展。面对城市巷战、复杂区域反恐、偏远灾区救援等特殊任务场景,传统的地面设备由于视线限制难以直接搜寻到目标,而无人机航拍图像尺度大、视角广,可快速搜寻目标,并为地面设备提供位置信息,进行空中辅助导航。由此可见,多无人机与多无人车组成的地空无人集群系统具有重要的应用价值[1]。

协同系统的基础和关键是协同导航技术[2]。目前,协同导航大多采用捷联惯导系统,全球卫星导航系统(GPS)以及雷达、视觉/图像等技术,利用多传感器信息实现导航定位[2]。其中,GPS为室外无人机最常用的定位方式[3]。然而在城市建筑群、偏远山区和战场复杂电磁环境下,GPS信号受到障碍物遮挡或者电磁干扰,无法提供持续准确的定位信息。因此,如何在GPS拒止环境下实现无人集群的自主定位导航具有重要的研究价值[4]。

基于机器视觉的多传感器融合算法不受GPS信号限制,抗干扰能力强,在GPS拒止环境下具有独特优势。

另一方面,在通讯信号不良、实时性要求高的条件下,无人集群系统需要自主无回传地处理信息。其中包含大量的序列图像,这对于基于嵌入式系统的无人机、无人车而言,挑战巨大。

为了解决这一难题,国内中星微、寒武纪、华为等企业发展了搭载嵌入式神经网络处理器(NPU)的人工智能芯片。2016年6月,中星微电子公司发布了中国首款嵌入式神经网络处理器芯片——“星光智能一号”。2017年,华为海思发布了全球首款内置独立NPU的智能手机芯片——“麒麟970”。NPU芯片具有小型化、低功耗、低成本的优势,极大促进了人工智能技术在嵌入式平台的应用。将人工智能芯片应用于无人集群系统,使其无需将数据实时回传至服务器,而仅依靠芯片自身便可进行相应算法,大大提高了系统的自主性和智能化水平。

根据上述讨论,针对无网络、无GPS的复杂恶劣环境,本文创新性地提出了一套利用机器视觉相关算法和智能芯片,采用集中式编队方式的地空协同控制系统。该

系统可极大减少对于GPS和终端服务器的依赖,可充分体现智能硬件系统的自主性。

1 视觉导航技术

1.1 VINS-MONO算法

在无GPS信号的环境中,无人机需要进行自主导航。而常用的自主导航技术如惯性导航、视觉导航等都有着明显的缺陷。惯性导航存在积累误差,而视觉导航常由于照明变化、区域纹理缺失或运动模糊导致视觉轨迹缺失[4]。

2018年,Qin [4] 等人提出了一种多功能单目视觉惯性状态估计算法——VINS-MONO。该算法使用一个单目摄像头和一个低成本惯性测量单元(IMU)构成一个单目视觉惯性系统。采用低成本的单目摄像头和IMU单元,适合于无人机平台的自主导航定位。本系统将利用该技术进行无人机的自主导航。

VINS-MONO算法的核心是一個鲁棒的基于紧耦合滑动窗非线性优化的单目视觉惯性里程计(VIO)。单目VIO模块不仅提供精确的局部姿态、速度和方位估计,而且还以在线方式执行摄像机IMU外部校准和IMU偏置校正,再使用DBoW进行回环检测。重定位是在对单目VIO进行特征级别融合的紧耦合设置中完成。这使得重定位具有鲁棒性和精确性,且有最小的计算开销。最后几何验证回路被添加到姿态图中,可观察滚转和俯仰角,生成四自由度(DOF)姿态图以确保全局一致性。

1.2 CVM-Net算法

无人机航拍图像和地面图像视角跨度大,匹配难度高,基于SIFT[5]和SURF[6]特征的传统方法在这种情况下效果不佳。2018年,Hu[7]等人基于卷积神经网络提出了CVM-Net算法,在跨视角地空图像匹配上表现出了优越的性能。本系统将采用CVM-Net技术,用于地面设备的定位。

基于跨视图图像的地空地理定位的CVM-Net算法是将NetVLAD层与孪生网路相结合,进行匹配任务的度量学习。首先使用全卷积层提取局部图像特征,然后使用强大的NetVLAD将这些特征编码到全局图像描述符中[7]。作为训练过程的一部分,引入一个简单而有效的加权软边缘排序损失函数,不仅加快了训练的收敛速度,而且提高了最终的匹配精度。文献[7]表明,网络在现有的基准数据集上显著优于最先进的方法。

用全卷积网络(FCN)分别提取图像的局部特征向量。对于航拍图像Is,局部特征向量由

us=f L(Is; θLs)给出,其中θLs是航拍图像分支的FCN参数。对于地面图像Ig,局部特征向量由ug=f L(Ig; θLg)给出,其中θLg是航拍图像分支的FCN参数。

将FCN中得到的局部特征向量放入NetVLAD 层以获取全局描述符。结合孪生网络框架,使用两个独立的NetVLAD层分别从地面图像和航拍图像的局部特征中得到全局描述符。每一个NetVLAD层都会产生一个VLAD向量,又因为这两个向量是在同一空间,所以可以直接用来进行相似性比较。两个NetVLAD层有着相同的结构但参数不同。最后,来自两个视图的全局描述符的维度通过一个全连接层降低。

同时,采用CVM-Net-1和CVM-Net-2两种策略。CVM-Net-1通过两个对齐(没有权值共享)的NetVLAD层组成的深层网络,将来自不同视图的本地特征汇集到一个公共空间。CVM-Net-2具有两个权值共享的NetVLAD深度网络,将本地特征转换为公共空间,然后聚合来获得全局描述符。

训练完成后,每个航拍图像的形心都被唯一的一个地面图像的形心联系起来。由于每个视角图片的残差都只是关联到形心,每个残差对自己视角都是独立的,可与另一个视角相比较。

1.3 YOLO-LITE算法

2015年,Redmon J提出了YOLO检测算法[8-10]。作为一种轻量级目标检测算法,相比于传统方法,YOLO在保持较高准确度的前提下,实现了检测速度成倍的提高,可用于嵌入式系统的实时检测[11]。

为进一步提高YOLO算法的实时性,本文采用一种实时性的YOLO改进版本——YOLO-LITE[12]。相较于YOLO之前的版本,该算法的检测速度更快,且在无GPU的设备上也能很好运行,满足系统对于实时检测的要求。

在YOLO-LITE结构中,将原本的输入尺寸416×416替换为224×224,同时简化YOLO结构,使用更少的层数以及更浅的网络,极大减少weight数量[13]。此外,在模型网络层数很浅的情况下,BN层不能大幅度提升算法性能,却会增加计算开销。因此,为了保证算法的实时性,YOLO-LITE完全去除了BN层,并用剪枝算法进一步压缩模型[14]。

2 基于机器视觉的地空协同控制系统

标准的人工蜂群算法(ABC算法)[15]通过模拟实际蜜蜂的采蜜机制,将人工蜂群分为采蜜蜂、观察蜂和侦察蜂[16]。依据蜂群理论,本文应用计算机视觉相关算法具体模拟实现蜂群算法中各个蜜蜂的协调功能与通信功能。对于观察蜂,用地面主机模拟控制;对于侦察蜂,设计空中侦察机和地面侦察车来实现;对于采蜜蜂,采用空中跟随机和地面跟随车,其整体框架如图1所示。空中侦察机和地面侦察车分别随机寻找目标,互相配合實现无GPS定位和路径构建,记录具体目标的位置,以指令形式发送至若干空中和地面跟随机/车,地面跟随车通过目标识别和侦察机的指令相继发现目标,并将目标信息反馈回地面主机。地面主机分析数据后,规划调度信息。

2.1 VINS-MONO算法与蜂群算法

为使空中侦察机能够在无网络的情况下实时记录周边环境和所经路线,本系统使用了单目视觉惯性VINS-MONO算法。空中侦察机通过AI芯片强大的端测计算能力,将摄像头获得的数据进行处理并规划路径,通过控制芯片与跟随机通信,发送指令信息,使其向目标方向移动。

将VINS-MONO算法封装成库函数,主要完成路径记录和相对位置信息返回。

首先,AI芯片通过连接集成惯性导航的单目摄像头实时录制画面。设定侦察机开始运动的原点位置,并设定侦察路线。此时由于外界原因,侦察机并不能完全按照设定路线运行,因此不能以设定路线作为相对位置的依据。接着,创建一个进程运行VINS-MONO,将实时相对位置信息保存在json文件中,记录该时刻与原点位置的相对位置信息和相对运行时间。

另外,相对位置返回功能函数主要用于返回当前时刻相对位置以及与地面正视图相匹配的空中俯视图。

2.2 YOLO-LITE算法与蜂群算法

将YOLO-LITE算法移植到AI芯片中,用于侦察机/车和跟随机/车的目标识别。侦察机/车在随机向四处寻找目标的过程中,通过YOLO-LITE算法识别目标;而拥有AI芯片的跟随机/车,则通过该算法识别侦察机/车和其他跟随机/车,如图2所示。

对YOLO-LITE算法进行封装,主要分为两部分功能。一是侦察机寻找目标,输入参数主要是目标物的关键值,返回值为有无目标存在。当有目标存在时触发中断进行拍摄。二是跟随机/车追随目标,即用于寻找目标的侦察机/车本身也是跟随机/车的目标,输入参数主要为目标框面积占视区比例,以此与侦察机/车保持距离。

跟随机/车通过摄像头对寻找的目标进行搜索,获得采样信息。若当前帧中存在目标时,会在图片中标注一个方框,并记录方框的大小及位置,接着应用PID控制实现跟随机/车对目标的追踪。

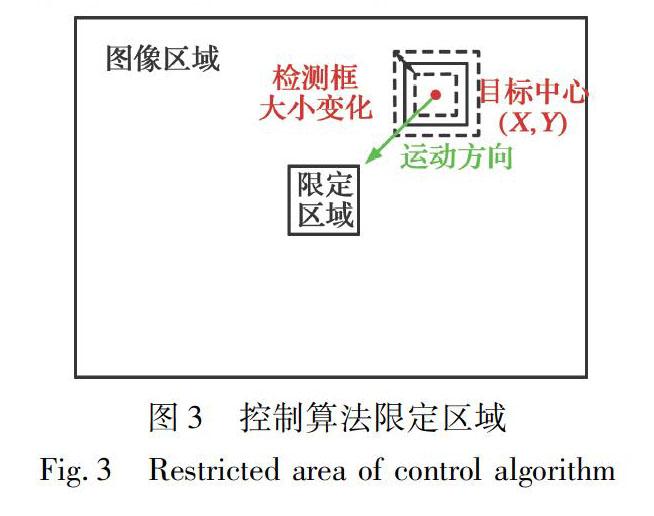

跟随机/车的控制主要包括运动方向和跟随间距的调节[17]。调节运动方向时,在序列图像的中心区域限定一定范围,如图3所示。当侦察机/车位于该限定区域内,则认为跟随机/车处于合理位置,无需调整位姿;而当其位于限定区域外时,则判断跟随机/车偏离合理区域,需要进行位姿矫正,并根据超出限定区域的方位进行运行方向的判断。当侦察机/车重新回到限定区域时,即停止运动。根据序列图像中目标检测框面积占视区比例判断跟随距离。当检测框尺寸变小,说明跟随距离变大,则增大跟踪速度;当检测框尺寸变大,说明跟随距离变小,则减小跟踪速度,使跟随距离始终在一定范围内[17]。算法控制流程图如图4所示。

2.3 CVM-Net算法与蜂群算法

为了在无GPS情况下,空中侦察机与地面侦察车能够协同定位目标的精确位置,本文采用CVM-Net算法。地面侦察车和空中侦察机随机向各个方向寻找目标,若地面侦察车发现目标,则发送其拍摄的正视图至空中侦察机。侦察机飞行的同时,记录地面俯视图,当收到地面侦察车发送的正视图后,应用移植了CVM-Net算法的AI芯片进行位置匹配,从而定位目标位置。同时利用VINS-MONO算法规划出起始点到目标位置的路径,并生成指令发送至其他跟随机,如图5(a)所示。

参考文献:

[1] 谢启龙,宋龙,鲁浩,等.协同导航技术研究综述[J].航空兵器,2019,26(4): 23-30.

Xie Qilong,Song Long,Lu Hao,et al. Review of Collaborative Navigation Technology[J]. Aero Weaponry,2019,26 (4):23-30. (in Chinese)

[2] 周思全,化永朝,董希旺,等.面向空地协同作战的无人机-无人车异构时变编队跟踪控制[J].航空兵器,2019,26(4): 54-59.

Zhou Siquan,Hua Yongzhao,Dong Xiwang,et al.Air-Ground Time Varying Formation Tracking Control for Heterogeneous UAV-UGV Swarm System[J].Aero Weaponry,2019,26 (4):54-59. (in Chinese)

[3] 唐鄧清.无GPS依赖的无人机定位方法及ROS实现研究[D].长沙:国防科学技术大学,2015.

Tang Dengqing.GPS Free Localization and Implementation in Robot Operating System for Unmanned Aerial Vehicles[D].Changsha:National University of Defense Technology,2015.(in Chinese)

[4] Qin T,Li P L,Shen S J. VINS-Mono:A Robust and Versatile Monocular Visual-Inertial State Estimator[J]. IEEE Transactions on Robotics,2018,34(4): 1004-1020.

[5] Lowe D G. Distinctive Image Features from Scale-Invariant Keypoints[J]. International Journal of Computer Vision,2004,60(2):91-110.

[6] Bay H,Tuytelaars T,Van Gool L. SURF:Speeded up Robust Features[C]∥European Conference on Computer Vision,2006:404-417.

[7] Hu S X,Lee G H. Image-Based Geo-Localization Using Satellite Imagery[J]. International Journal of Computer Vision,2020,128(5): 1205-1219.

[8] Redmon J,Divvala S,Girshick R,et al. You Only Look Once:Unified,Real-Time Object Detection[C]∥ Conference on Computer Vision and Pattern Recognition,2016:779-788.

[9] Redmon J,Farhadi A . YOLO9000:Better,Faster,Stronger[C]∥IEEE Conference on Computer Vision and Pattern Recognition,2017: 6517-6525.

[10] Redmon J,Farhadi A . YOLOv3:An Incremental Improvement[EB/OL].(2018-04-08)[2019-12-17]. https:∥arxiv.org/pdf/1804.02762.pdf.

[11] Wang X D,Zhang B C,Li C,et al. Modulated Convolutional Networks[C]∥ Conference on Computer Vision and Pattern Recog-nition,2018: 840-848.

[12] Pedoeem J,Huang R. YOLO-LITE:A Real-Time Object Detection Algorithm Optimized for Non-GPU Computers[EB/OL]. (2018-11-14)[2019-12-17].https: ∥arxiv.org/pdf/1811.05588.

[13] Gu J X,Li C,Zhang B C,et al. Projection Convolutional Neural Networks for 1-bit CNNs via Discrete Back Propagation[C]∥Conference on Artificial Intelligence,2019:8344-8351.

[14] Zhou L A,Zhang B C,Chen C,et al. Calibration Stochastic Gradient Descent for Convolutional Neural Networks[C]∥Proceedings of the AAAI Conference on Artificial Intelligence,2019: 9348-9355.

[15] Karaboga D. An Idea Based on Honey Bee Swarm for Numerical Optimization[D]. Kayseri: Erciyes University,2005.

[16] Karaboga D,Gorkemli B,Ozturk C,et al. A Comprehensive Survey:Artificial Bee Colony (ABC) Algorithm and Applications[J]. Artificial Intelligence Review,2014,42(1): 21-57.

[17] 朱晨阳,冯虎田,欧屹. 基于YOLO3的人脸自动跟踪摄像机器人系统研究[J]. 电视技术,2018,42(9): 57-62.

Zhu Chenyang,Feng Hutian,Ou Yi.YOLO3 Based Face Tracking Camera Robot System[J]. Video Engineering,2018,42(9):57-62.(in Chinese)

Implementation of Collaborative Control

Based on AI Chips and Machine Vision

Wang Cheng1,2,Zhang Zhenrui1,Fang Chao1,Wang Linna3,Zhang Baochang1,2*

(1. School of Automation Science and Electrical Engineering,Beihang University,Beijing 100191,China;

2. Shenzhen Academy of Aerospace Technology,Shenzhen 518057,China;

3.China Academy of Launch Vehicle Technology,

Beijing 100191,China)

Abstract: Currently,there are few studies on how to realize autonomous navigation ofunmanned cluster system in a networkless and GPS-free environment. For this special application scenario,this paper innovatively proposes a ground-air cooperative control system using a centralized formation approach based on machine vision.The system consists of air reconnaissance aircrafts,air-following aircrafts,ground reconnaissance vehicles and ground-following vehicles. The air reconnaissance aircrafts use VINS-MONO to navigate and provide a position reference. At the same time,the CVM-Net is used to match captured images of air reconnaissance aircrafts and ground reconnaissance vehicles to obtain the relative position ofthem,which is used to guide the ground-following vehiclesand air reconnaissance vehicles,and YOLO-LITE detection algorithm is used to realize target real-time detection. The system uses Huawei Kirin 970 as the core hardware,which can realize real-time and no-return processing of information. Through this system,the ground and air unmanned cluster can perform autonomous navigation and coordinated control in the networkless and GPS-free environment,which has broad application prospects in the fields of emergency search and rescue and military investigation.

Key words: unmanned cluster system; collaborative control;AI chip; GPS-free; cross-view image matching; navigation

收稿日期:2019-12-17

基金項目:深圳市科技计划项目(KQTD2016112515134654)

作者简介:王铖(1995-),男,浙江杭州人,硕士研究生,研究方向是边缘计算、嵌入式人工智能。

通讯作者: 张宝昌(1976-),男,吉林洮南人,博士,教授,研究方向是深度学习模型压缩、深度协同端计算。

E-mail:bczhang@buaa.edu.cn