基于深度学习的图像语义分割技术研究进展

2020-01-17梁新宇权冀川肖铠鸿高伟嘉

梁新宇,罗 晨,权冀川,肖铠鸿,高伟嘉

1.陆军工程大学 指挥控制工程学院,南京210007

2.陆军工程大学 通信工程学院,南京210007

3.中国人民解放军68023部队

1 引言

图像分割(image segmentation)技术已经成为计算机视觉领域的重要研究方向,是图像语义理解的重要环节,也是实现完全场景理解的重要方式之一。图像分割技术通常用于定位图像中目标和边界(线、曲面)的位置,为图像中的每一个像素打上标签,拥有相同标签的像素具有相同的特征,为进一步对图像进行分类、检测和内容理解打下良好的基础。

图像语义分割是对图像中的每个像素都划分出对应的类别,即实现图像在像素级别上的分类。如图1所示,根据需求划分的类别标签,将图中的“瓶子”“杯子”“立方体”实现像素级别的分类。

图1 图像语义分割

不同于图像分类和目标检测技术,在开始图像分割处理之前,必须明确语义分割的任务要求,即理解语义分割的输入和输出。语义分割的重要性在于越来越多的应用需要利用图像进行理解推断,包括人机交互[1-2]、自动驾驶[3-5]、医学影像[6-11]、计算摄影[12-13]、虚拟现实[14-16]、增强现实[17-18]等领域。

近年来,随着深度学习技术的逐步深入,图像语义分割技术有了突飞猛进的发展,相继涌现出了一批经典的语义分割模型和算法。本文从图像语义分割的技术发展视角,将其划分为传统图像语义分割技术与基于深度学习的图像语义分割技术两大类。重点对基于深度学习的典型语义分割网络架构进行了梳理总结,对于最近两年内提出的新型网络架构进行了综合分析。同时,从图像语义分割的性能评价需求出发,研究了常用的测试数据集和性能评价方法,对于主流的语义分割网络架构进行了性能对比分析,可为相关领域的理论研究和应用实践提供有价值的参考。

2 传统的图像语义分割技术

(1)基于阈值的图像分割技术

基于阈值的图像分割技术的基本思想是基于图像的灰度特征来计算一个或多个灰度阈值,并将图像中每个像素的灰度值与阈值进行比较,最后再根据像素比较的结果划分到合适的类别中。

阈值分割的优点是计算简单、运算效率较高且速度快。全局阈值对于灰度相差很大的不同目标和背景能进行有效的分割;局部阈值或动态阈值对于阈值差异不大的目标更为合适。虽然基于阈值的分割技术简单高效,但也有一定的局限性。这种方法只考虑像素本身的灰度值,一般不考虑空间特征,因而对噪声很敏感。在实际应用中,阈值法通常要与其他方法结合使用。

(2)基于边缘的图像分割技术

所谓边缘是指图像中两个不同区域的边界线上连续的像素点的集合,是图像局部特征不连续性的反映,体现了灰度、颜色、纹理等图像特性的突变。基于边缘的分割技术是根据灰度值进行边缘检测,将图像分割成不同的部分。它是建立在边缘灰度值会呈现出阶跃型或屋顶型变化这一观测基础上的方法。

基于边缘的分割方法的重点在于边缘检测对抗噪性和检测精度之间的权衡。若提高检测精度,则噪声产生的伪边缘会导致不合理的轮廓;若提高抗噪性,则会产生轮廓漏检和位置偏差。为此,人们提出各种多尺度边缘检测方法,根据实际问题设计多尺度边缘信息的结合方案,以较好地兼顾抗噪性和检测精度。该方法的不足之处在于,在划分复杂图像时边缘的连续性和完整性难以保证。

(3)基于区域的图像分割技术

基于区域的图像分割技术按照相似性准则将图像分成不同的区域。其主要利用了图像的局部空间信息,能够较好地避免其他算法带来的分割空间小的缺陷。

然而,这种分割技术在进行大区域分割时速度较慢,抗噪性差,往往会分割出无意义的区域或者造成图像的过度分割等。一般情况下,会与其他方法结合使用,发挥各自的优势以获得更好的分割效果。

(4)基于特定理论的图像分割技术

基于特定理论、方法的图像分割技术包括聚类分析、模糊集理论、图论等,这些理论为图像分割技术的难点突破和研究拓展了新的方向。

传统的图像分割技术在分割精度和分割效率上难以达到实际应用的要求,尤其是在实时场景理解和图像信息处理方面。而且,语义分割时,单独使用一种传统的图像分割算法,难以获得良好的分割效果。正确的思路是,不断将各种新理论和新方法引入图像分割领域。近年来,基于深度学习的图像分割技术很好地解决了上述问题。

3 基于深度学习的图像语义分割技术

深度学习(Deep Learning)[19]是机器学习的一个分支,也是近十年机器学习领域的研究热点。深度学习是利用多层神经网络结构,将隐含在高层中的信息进行建模的方法。

基于深度学习的图像语义分割技术(简称深度图像语义分割)的主要思路是,不需要人为设计特征,直接向深层网络输入大量原始图像数据,根据设计好的深度网络算法,对图像数据进行复杂处理,得到高层次的抽象特征;输出的不再是简单的分类类别或者目标定位,而是带有像素类别标签的与输入图像同分辨率的分割图像。

3.1 语义分割的经典网络架构

许多语义分割问题可以使用深度学习网络架构解决,这类网络架构在准确率和处理效率上都明显超越了传统的方法。本节阐述了图像语义分割处理的经典网络架构及其实际用例,并对这些架构的特性进行总结和分析。

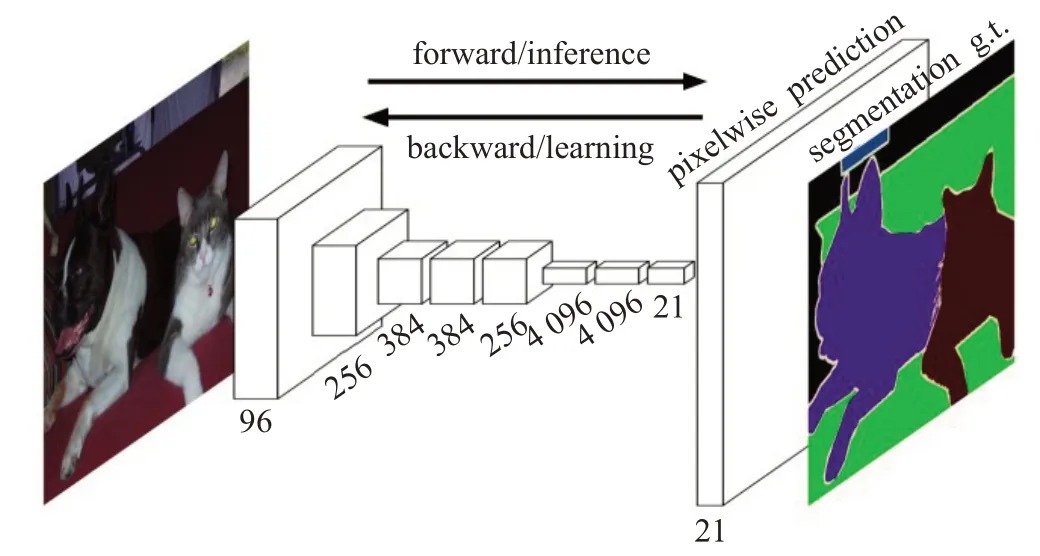

(1)全卷积网络

2014年,全卷积网络(Fully Convolutional Networks,FCN)[20]问世,其网络架构如图2所示。它是传统卷积神经网络(Convolution Neural Network,CNN)[21]的扩展,主要思想是利用全卷积网络取代原有架构的全连接层部分,以达到可以输入任意分辨率图像的目的。由于传统CNN的全连接层是针对固定长度的特征向量进行分类的,所以只能接受特定大小的输入图像。为了改变这种局限性,FCN 采用卷积和池化层,可以接受任意分辨率的输入图像。再利用反卷积层对最后一个卷积层的特征图进行上采样,使输出结果恢复到与输入图像相同的尺寸。FCN可对图像的每个像素产生一个预测,同时保留了原始输入图像中的空间信息,并在上采样的特征图上逐个像素进行分类和计算分类损失,相当于每个像素对应一个训练样本。所以,FCN通过对图像进行像素级的分类来解决语义级别的图像分割问题。

图2 FCN架构

FCN为语义分割引入了端到端的全卷积网络,同时重新利用预训练网络,结合反卷积层进行上采样,并引入跳跃连接改善上采样粗糙的像素定位。

FCN在处理室内场景分割任务中,较好地实现了视觉假体辅助盲人识别的应用[22]。除此之外,FCN在典型红外目标分割[23]以及输电线路航拍[24]等工程实践中取得了良好表现。

(2)SegNet

FCN 和SegNet[25]都是最先出现的编码-解码结构。FCN网络使用了反卷积层和少量跳跃连接,但是产生的分割图较为粗略。为了提升效果,SegNet引入了更多的跳跃连接。另一方面,SegNet 并没有复制FCN 中的编码器特征,而是复制了最大池化指数,这使得在内存使用上SegNet 比FCN 更为高效。因此,SegNet 比FCN 更节省内存。

在农业信息领域,SegNet在高分辨率遥感影像的农村建设用地信息提取任务中,总体的分类分割精度达到96.61%[26],效果明显。SegNet在工件表面缺陷检测[27]等工业工程领域中得以应用,并取得不错的效果。

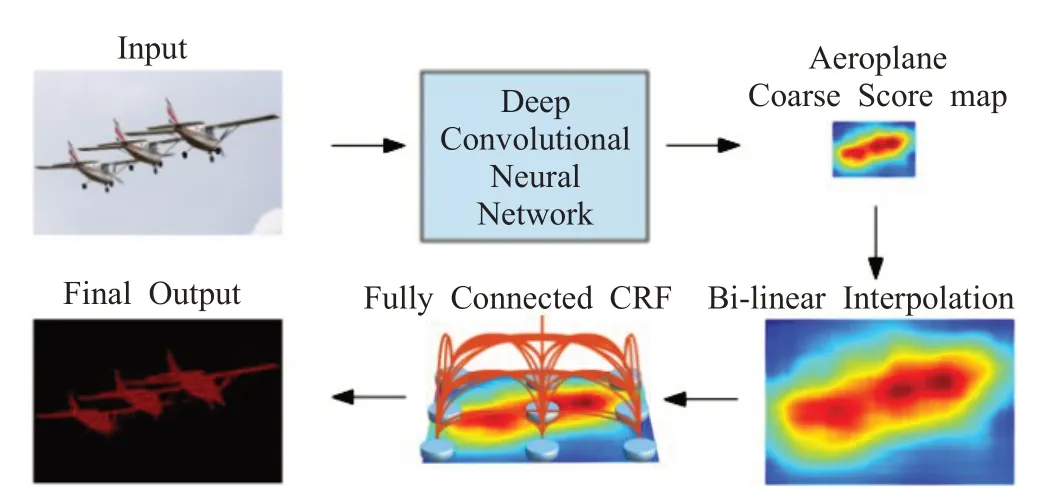

(3)DeepLab v1

基于CNN模型架构的图像分割技术是根据分类这种高层语义改进的,但CNN 具有的不变性特点会导致丢失位置信息,无法对像素点精确定位语义。如图3所示,DeepLab v1[28]是CNN 和概率图模型(Probabilistic Graphical Model,PGM)[29]的结合,利用空洞卷积(Atrous Convolution)增加卷积操作过程的感受野,保持分辨率。同时,对CNN最后一层增加全连接条件随机场(Conditional Random Filed,CRF)[28],使分割结果更精确。

图3 DeepLab v1架构

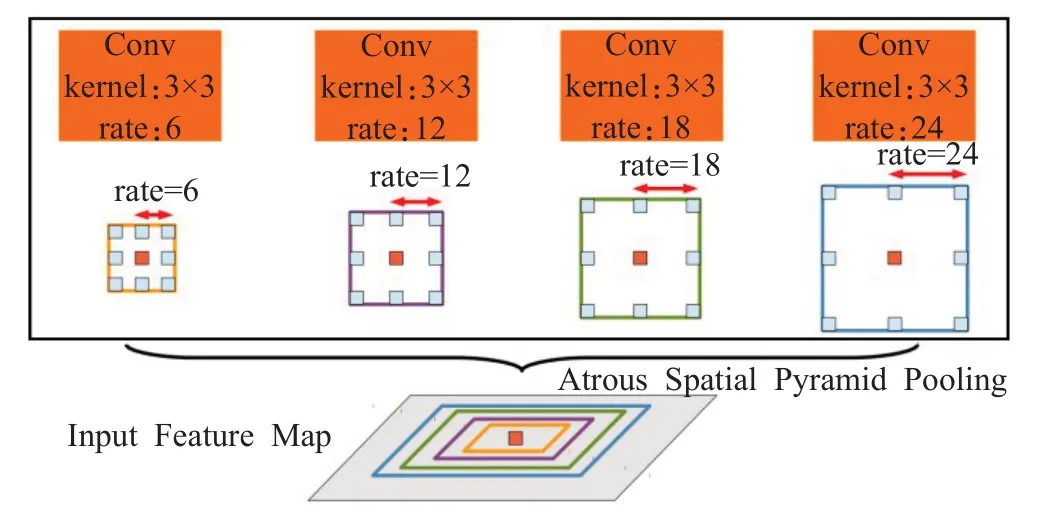

(4)DeepLab v2

DeepLab v2[30]在DeepLabv1的基础上进行了改进,引入了空间金字塔池化(Atrous Spatial Pyramid Pooling,ASPP)结构,以融合不同级别的语义信息,改进Deep-Labv1未融合不同层信息的不足。具体的处理方法是,选择不同扩张率的空洞卷积处理特征图,由于感受野不同,得到信息的层级也不同。ASPP 层把这些不同层级的特征图连接到一起,进行信息融合,如图4。

图4 ASPP结构

作为DeepLab系列中的经典网络架构,DeepLab v1和DeepLab v2已经在遥感影像处理[31]、城市街景解析[32]以及室内场景分析等实际场景中应用。

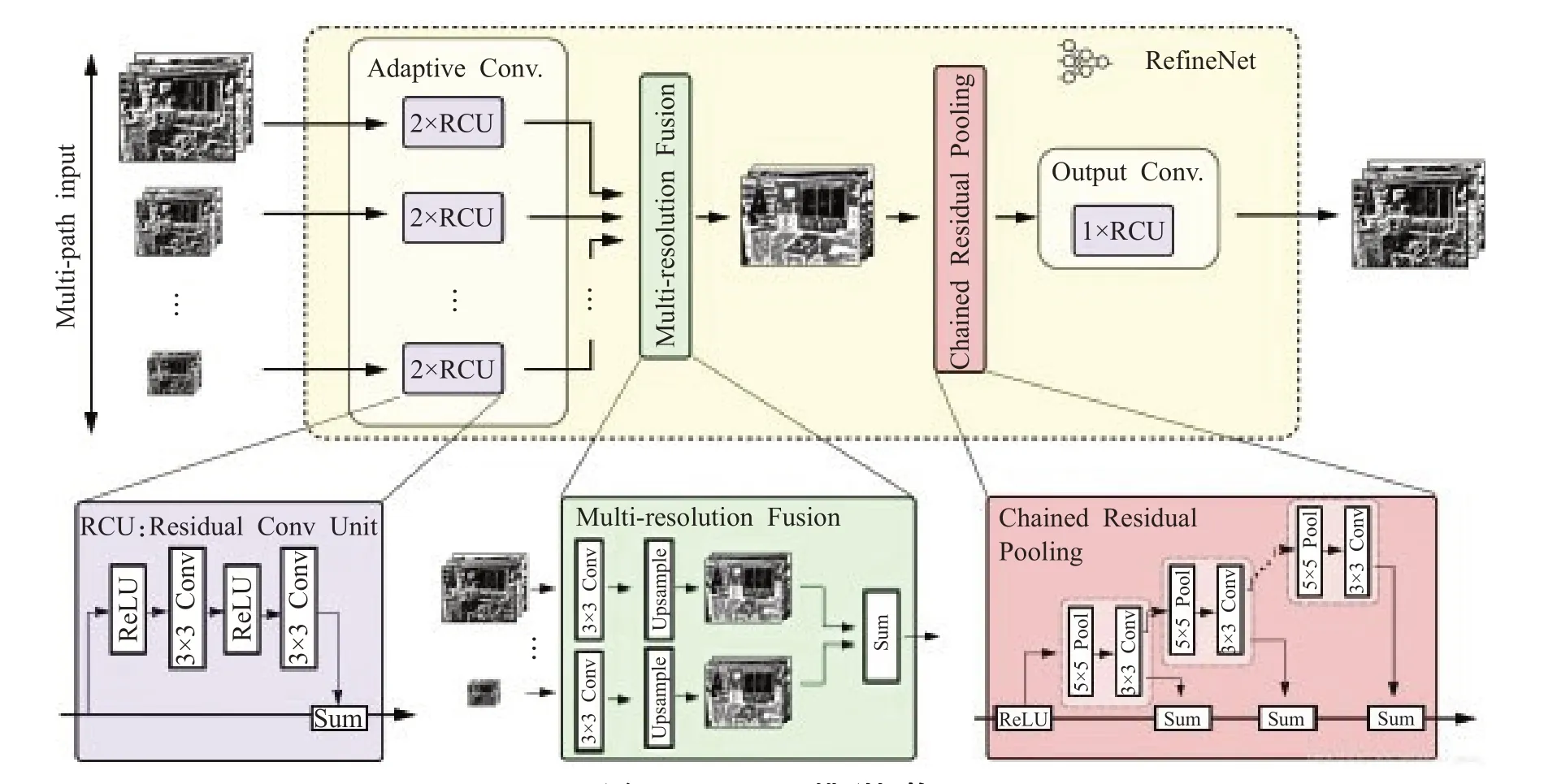

(5)RefineNet

在前述的几种语义分割架构中,为了提取更复杂的特征、构建更深的神经网络,许多算法往往会以牺牲空间分辨率的方式,在尽量少地增加计算量的前提下,换取特征通道数的增加。虽然这种方式有诸多优点,但是空间分辨率的下降是其明显的缺陷。

为了解决这一问题,同时更好地优化语义分割结果,RefineNet[33]提供了一个能够良好融合高分辨率语义特征和低分辨率语义特征的模块来生成高分辨率的分割图。RefineNet模型的整体架构如图5所示,RefineNet包括三大模块:残差卷积模块(Residual Convolution Unit,RCU)、多分辨率融合模块(Multi-Resolution Fusion)链式残差池化模块(Chained Residual Pooling)。

图5 RefineNet模型架构

残差卷积模块从不同尺度的图像中抽取底层特征;多分辨率融合模块,抽取中间层特征对多尺度的特征进行融合,以解决因为下采样导致的信息丢失问题;链式残差池化模块,抽取高层特征,不同池化相当于不同大小的窗口,在整合不同尺度特征后通过卷积加权在一起,从而捕获背景上下文信息。

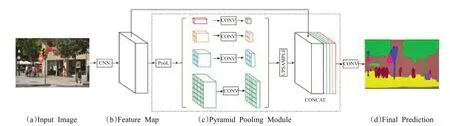

(6)PSPNet

语义分割过程中,对图像语义场景的解析或理解极为关键。然而,早期的多数架构都是基于FCN的,没有引入足够的上下文信息及不同感受野下的全局信息,容易导致错误的分割结果。PSPNet[34]提出了一个具有层次全局优先级、包含不同子区域之间不同尺度信息的模块,称为金字塔池化模块(Pyramid Pooling Module),如图6 所示。它充分利用全局特征层次的先验知识对不同场景进行理解,聚合不同区域的上下文信息以获取全局上下文的内容。同时,PSPNet 还提出了一个适度监督损失的优化策略,在多个数据集上表现优异。与全局金字塔池化不同的是,可以通过PSPNet 对不同区域信息的融合来实现全局上下文信息的融合。

总之,PSPNet 为像素级场景解析提供了有效的全局上下文先验,金字塔池化模块可以收集具有层级的信息,比全局池化更有代表性。并且,PSPNet和带空洞卷积的FCN 相比,并没有增加多少计算量。在端到端的学习中,全局金字塔池化模块和局部FCN 功能可以同时训练和优化。可以说,PSPNet 同时利用局部和全局信息,更好地提取全局上下文信息,使得场景识别更加可靠。

RefineNet 和PSPNet 已经应用在医疗影像[8]、农业信息[35-36]、遥感图像[37]等领域,通过特征融合的思想,对图像上下文语义进行捕获,实现不同尺度信息整合,获得了良好的性能表现。

3.2 语义分割的前沿网络架构

2017 年以来,在技术的推动下,经典网络架构有新的突破;同时,新的设计思想和观点又催生出新的网络架构。这些网络架构代表了语义分割的前沿方向。

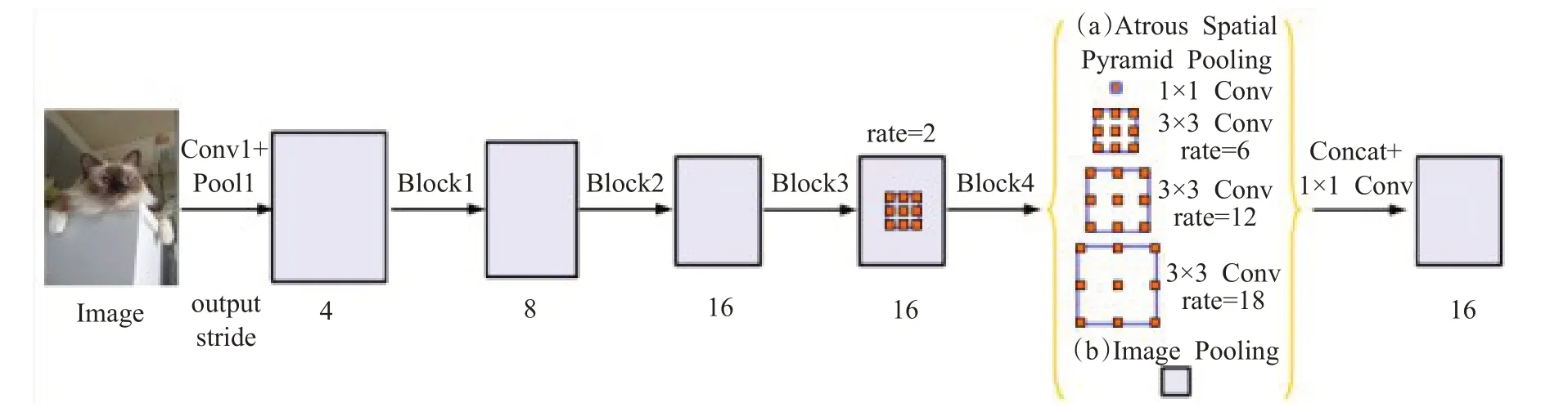

(1)DeepLab v3

如图7 所示,DeepLab v3[38]在DeepLabv2 模型的基础上,作了以下改进:①放弃了CRF 操作;②改进了ASPP 模块,加入了批规范化(Batch Norm,BN)操作;③为了防止空洞卷积感受野的扩张率过大导致的“权值退化”现象,增加了全局平均池化结构,利用全局信息,以强调和加强全局特征。

图6 PSPNet模型架构

图7 DeepLab v3模型架构

DeepLab v3 通过编码多尺度信息,增强图像级的特征,获得了比DeppLab v1、DeppLab v2 更加良好的实验效果,并取得了与其他先进模型相当的性能。

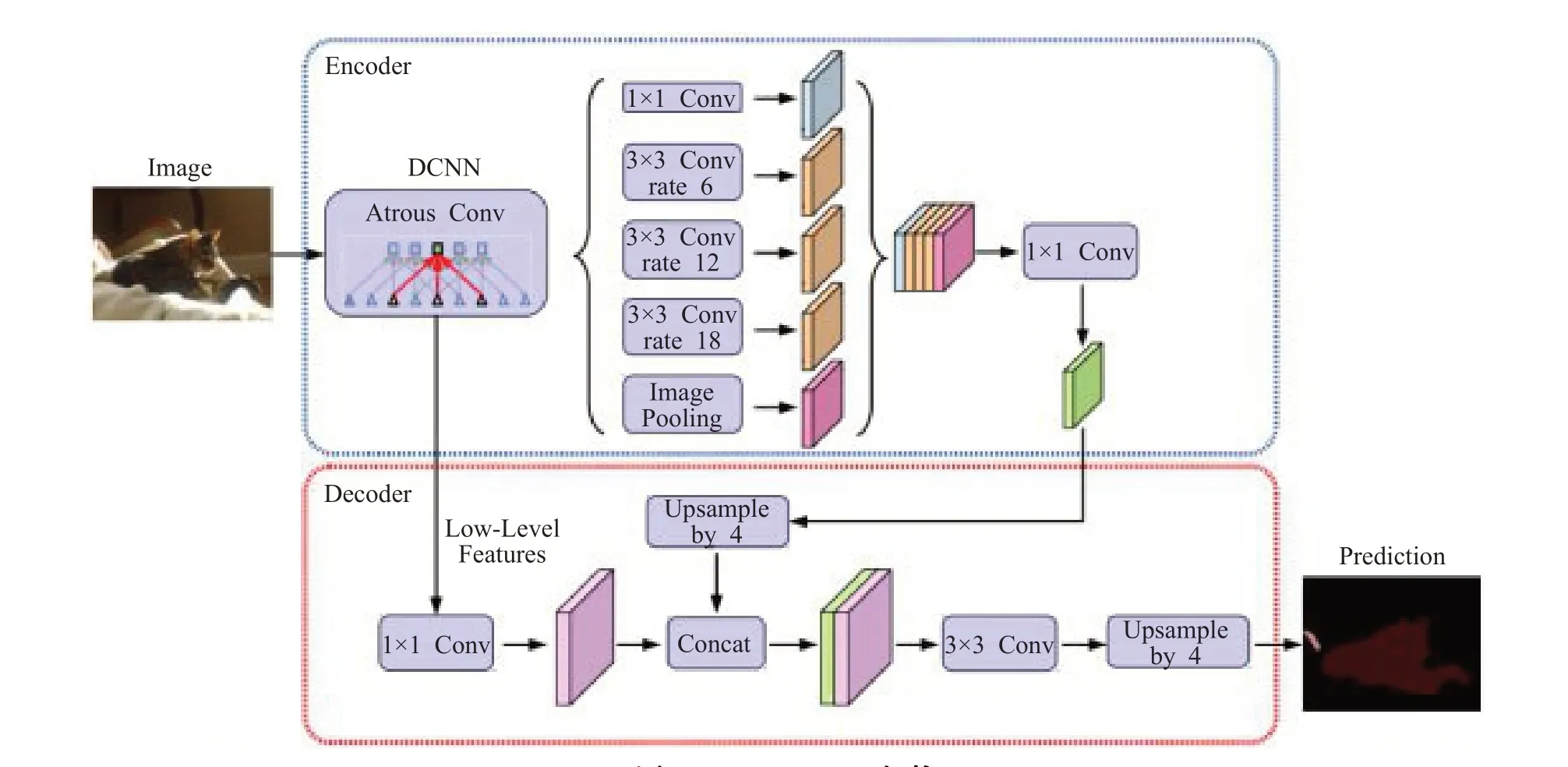

(2)DeepLab v3+

DeepLabv3+[39]提出了一个全新的编码-解码结构,如图8 所示。该模型使用DeepLab v3 作为编码器模块,并增加了一个简单却有效的解码模块,逐渐恢复空间信息以捕捉清晰的目标边界;并且在解码过程中对不同层级特征进行融合,进行多尺度上下文信息的探索。此外,对编码模块进行了优化处理,加入了Xception[40]结构以减少参数量,提高运行速度。

DeepLab v3+在提出的编码-解码架构中,通过空洞卷积直接控制提取编码特征的分辨率,在精度和运行时间之间寻找平衡点。将Xception结构应用于分割任务,在编码模块中的ASPP部分和解码模块分别加入深度可分卷积,在减少计算消耗和参数量的同时维持了相似的性能表现,得到了强大又快速的模型。

(3)Auto-DeepLab

Auto-DeepLab[41]是近期由李飞飞带领的团队提出的自动搜索图像语义分割架构的算法。该架构首次将神经架构搜索(Neural Architecture Search,NAS)引入到语义分割领域,自动搜索网络架构。利用研究提出的分层神经架构搜索方法确定最优网络架构和单元架构,完成图像语义分割任务,性能超越了很多业内主流的模型,甚至可以在未经过预训练的情况下达到预训练模型的水平。Auto-DeepLab 开发出与分层架构搜索空间完全匹配的离散架构的连续松弛结构,显著提高架构搜索的效率,降低计算需求。

(4)DANet

DANet[42]是一种新型的场景语义分割网络,利用“自注意力机制”捕获丰富的语义信息。如图9 所示,DANet在带有空洞卷积的ResNet[43]架构的尾部添加两个并行的注意力模块:位置注意力模块(Position Attention Module)和通道注意力模块(Channel Attention Module)。在位置注意力模块中,任一位置的特征更新是通过图像所有位置特征的加权聚合实现的,权重是由两个位置上特征的相似性决定的,即无论两个位置的距离多远,只要特征相似就能得到更高的权重。

在通道注意力模块中,也应用了类似的自注意力机制来学习任意两个通道映射之间的关系,同样通过所有通道的加权和来更新某一个通道。

图8 DeepLab v3+架构

图9 DANet模型架构

为了更好地利用两个注意力模块的全局语义信息,将模块的输出经过一个卷积层后进行逐元素的加和实现特征融合,最后通过一个卷积层得到最终的预测结果。

DANet在PASCAL Context[44]、MS COCO[45]和Cityscapes[46]数据集上取得的显著效果说明,该架构在处理图像语义的复杂场景方面更加高效灵活。该架构选择性地聚合了显著和不显著对象的相似语义特征,并从全局视角自适应地集成各种尺度的相似空间关系,将通道关系和空间关系有效结合,进一步增强了特征表示能力。

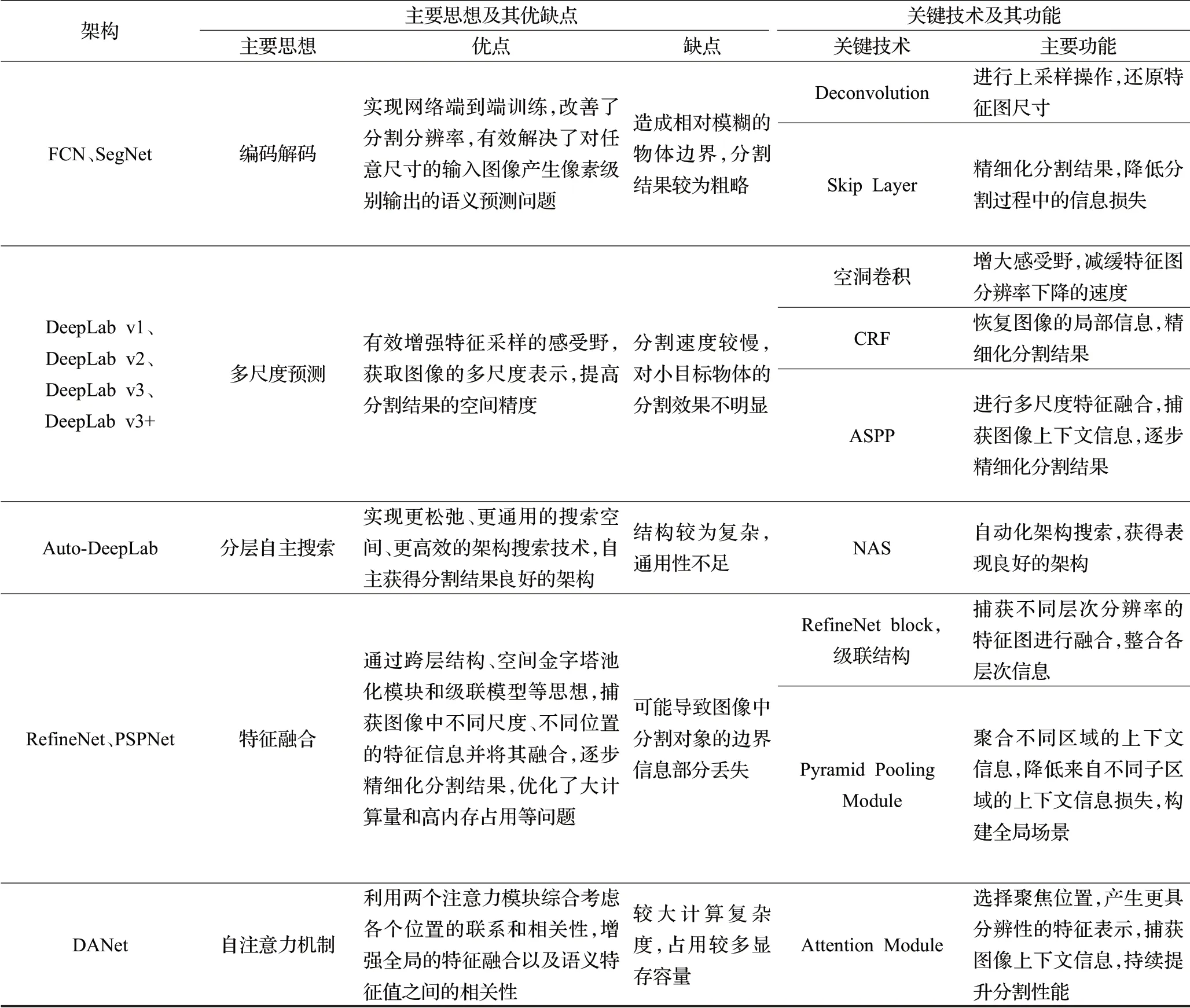

3.3 综合分析

语义分割的网络架构从FCN 开始,不断融入CRF、ASSP等行之有效的技术,在语义分割速度、准确度等方面不断提升。现阶段,语义分割的架构旨在优化分割结果的精确度和提高分割效率,以便在图像语义实时处理领域进行应用。对上述网络架构进行了综合分析,并从主要思想、优缺点、关键技术和主要功能等几个方面进行了对比总结,如表1所示。

4 常用数据集

在深度图像语义分割领域的实践中,收集并创建一个足够大且具有代表性的应用场景数据集,对于任何基于深度学习的语义分割架构都是极为重要的。这需要大量的时间、专业领域的知识,同时也需要相关的软硬件设施使得架构可以正确理解与学习捕捉到的数据。而且,使用一个现有的、有足够代表性的标准数据集可以保证架构之间的性能对比更加公平[47]。

下面介绍图像分割领域目前最受欢迎的大规模数据集,表2从数据集的应用场景、类别数目、发布时间以及训练集、验证集、测试集等方面进行了划分整理。

(1)Cambridge- driving Labeled Video Database(CamVid)[48-49]。是由Brostow 等人在2009 年建立的道路、驾驶场景理解数据集,从车载摄相机拍摄的5 个视频流中采样出了701 幅图像,共32 类物体,如建筑、墙、树、植被等。

(2)Semantic Boundaries Dataset(SBD)[50]。是PASCAL数据集的扩展,包含21类,共11 355张标注图像。数据集所提供的标注中除了有每个物体的边界信息外,还有种类级别及实例级别的信息。

(3)PASCAL VOC 2012[51]。是为图像分类和语义分割等任务发布的一套数据集。其中的图像主要是常见生活物体,共划分为21类,包括人、动物、植物和交通工具等。2014年,Mottaghi R等人在此基础上重新标注了约10 000 幅图像,将训练图像的数量提升到10 582个,称为PASCAL VOC 2012+[52]。

(4)NYU Depth Dataset v2(NYUDv2)[53]。是由微软Kinect 设备采集的室内的RGB-D 图像,由一系列表示各种室内场景的视频序列组成,共包含40 个类别的1 449张像素级标注的图像数据。但该数据集相对于其他数据集规模偏小,限制了其在深度网络中的应用。

(5)PASCAL Context[44]。由PASCAL VOC 2010数据集改进和扩展而来,数据集中增加了更多物体像素级别的标注和场景信息,共包含540个语义类别。虽然种类繁多,但是在算法评估时,一般选取前59类作为分割评判标准,其他类别标记为背景。

(6)PASCAL Part[54]。是PASCAL-VOC 2010 识别竞赛的扩展,在原有数据集基础上对图像中每个物体的部分提供了一个像素级别的分割标注,能够提供丰富的细节信息,可为物体解析和图像分割任务提供详细标注的样本。

(7)Microsoft Common Objects in Context(MS COCO)[45]。最初来自于微软图像测试的一个大型数据库,数据集规模巨大,内容丰富,共包含81种类别(包括背景)、328 000张图像、2 500 000个物体实例和100 000个人体关键部位标注,图像从复杂的日常场景中获取,图像中的物体具有精确的位置标注。

(8)Cityscapes[46]。是一个城市街道场景解析的大规模数据集,主要提供无人驾驶环境下的图像分割数据,用于评估算法在城区场景语义理解方面的性能。该数据集提供约5 000张精细标注的图片和20 000张粗略标注的图片,涵盖了30种语义、实例以及密集像素标注的类别,包括平坦表面、人、车辆、建筑等。数据是从50个

城市中持续数月采集而来,涵盖不同环境、不同背景、不同季节的街道场景,具有动态信息丰富、场景布局多样和街道背景复杂等特点。

表1 语义分割典型网络架构的对比总结

表2 深度图像分割常用数据集

(9)Karlsruhe Institute of Technology and Toyota Technological Institute(KITTI)[55]。包含市区、乡村和高速公路等真实场景图像,是近几年在智能机器人和无人驾驶领域广受欢迎的数据集之一。研究者使用高分辨率RGB、灰度立体摄像机和三维激光扫描仪等多种类型传感器采集交通场景数据,用于评测车载环境下路面分割、目标检测、目标跟踪等技术。该数据集并没有提供完整的语义标注,先后由Alvarez 等人[56-57]、Zhang 等人[58]、Ros 等人[59]为该数据集的部分数据手工添加语义标注以满足其问题的需求。

(10)SUN-RGBD[60]。图像由四个RGB-D 传感器得来,尺寸与PASCAL VOC一致,整个数据集均为密集标注,包括多边形、带方向的边界框以及三维空间,共包含10 000张RGB-D图像、146 617个多边形标注、58 657个边界框标注以及大量的空间布局信息和种类信息,适合于场景理解任务。

(11)ADE20K[61]。是一个场景理解的新的数据集,由151个类别(包括背景)、20 210张场景图片组成,包括各种物体(如人、汽车等)、场景(天空、路面等)。

(12)UESTC All-Day Scenery(UADS)[62]。旨在提供全天候道路图片以及对应的二值标签用以标识图像中的可行区域与不可行区域。整个数据集包含四种天候(黄昏天候,夜间天候,下雨天候和艳阳天候)共计6 380张图像。

5 图像语义分割的性能评价

5.1 性能评价指标

为使分割架构能够在特定领域发挥实际作用并产生重大贡献,必须对其性能进行严格评估。同时,为了对架构性能进行公平比较,必须使用标准的、被所属领域认可的指标进行评估[63]。评估的维度必须多样化,以证明架构的有效性和有用性。在实际应用中会根据需求或目的对相关指标进行取舍,如在实时应用场景中,更加关注处理速度,在一定程度上需要牺牲精度。然而,为了保证科学的严谨性,需要为架构方法提供所有可能的评价指标。下文从执行时间、内存占用和准确性三个方面对分割架构的性能指标进行阐述。

(1)运行时间

运行时间或处理速度是一个非常有价值的度量标准,因为绝大多数方法架构必须满足处理数据过程中花费时间的严格要求。但是,该评价指标非常依赖于硬件和后端实现,在某些情况下,为这些方法架构提供精确的时间的比较是毫无意义的[20]。

大多数情况下,运行时间可以用于评估架构对实际应用是否有用,并在相同条件下进行公平比较,以检查哪种方法最快。

(2)内存占用

内存占用是评估分割方法架构的另一个重要指标。尽管在条件允许的情况下可以通过扩展内存容量的方式使内存占用不像运行时间那样受限,但在某些特定情况下它也可能成为一个限制因素。实际应用场景中,内存配置是固定的,一般不会因为算法要求而动态调整,而且即使是普通的用于加速深度网络的高端图形处理单元(GPU)也不会搭载大容量内存。因此,详细记录方法架构在实验中占用的最大及平均存储空间是非常有用的。

(3)准确度

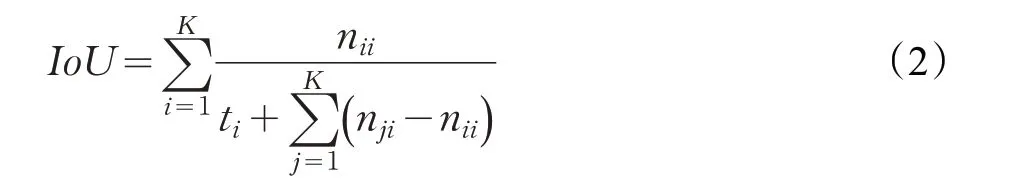

在语义分割领域中,有几项经典的用于评估方法架构准确度的标准。评估语义分割结果时,一般来说选取像素准确度(Pixel Accuracy,PA)[20]、平均准确度(Mean Accuracy,MA)[20]、交并比(Intersection over Union,IoU)[20]以及平均交并比(mean Intersection over Union,mIoU)[20]等几项评价指标进行综合分析。为方便理解,对以下公式中的相关符号做如下说明:K 表示图像像素的类别的数量;ti表示第i 类的像素的总数;nii表示实际类型为i、预测类型为i 的像素总数;nji表示实际类型为i、预测类型为j 的像素总数[63]。

像素准确度PA表示正确分割图像的像素数量与像素总数之间的比率:

交并比IoU 表示分割结果与原始图像真值的重合程度,在目标检测中可以理解为系统预测的检测框与原图片中标记检测框的重合程度,取值范围在[0,1]区间:

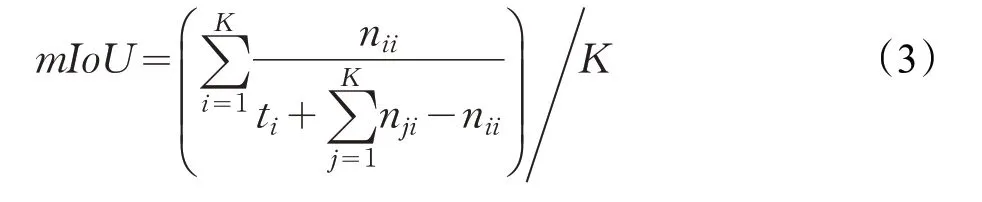

平均交并比mIoU表示图像像素的IoU在所有类别上的平均值:

其中,mIoU指标的代表性和简单性非常突出,是目前图像语义分割领域使用频率最高和最常见的准确度评价指标,大多数研究人员都利用这个指标来评判他们的语义分割结果。

5.2 实验分析与性能对比

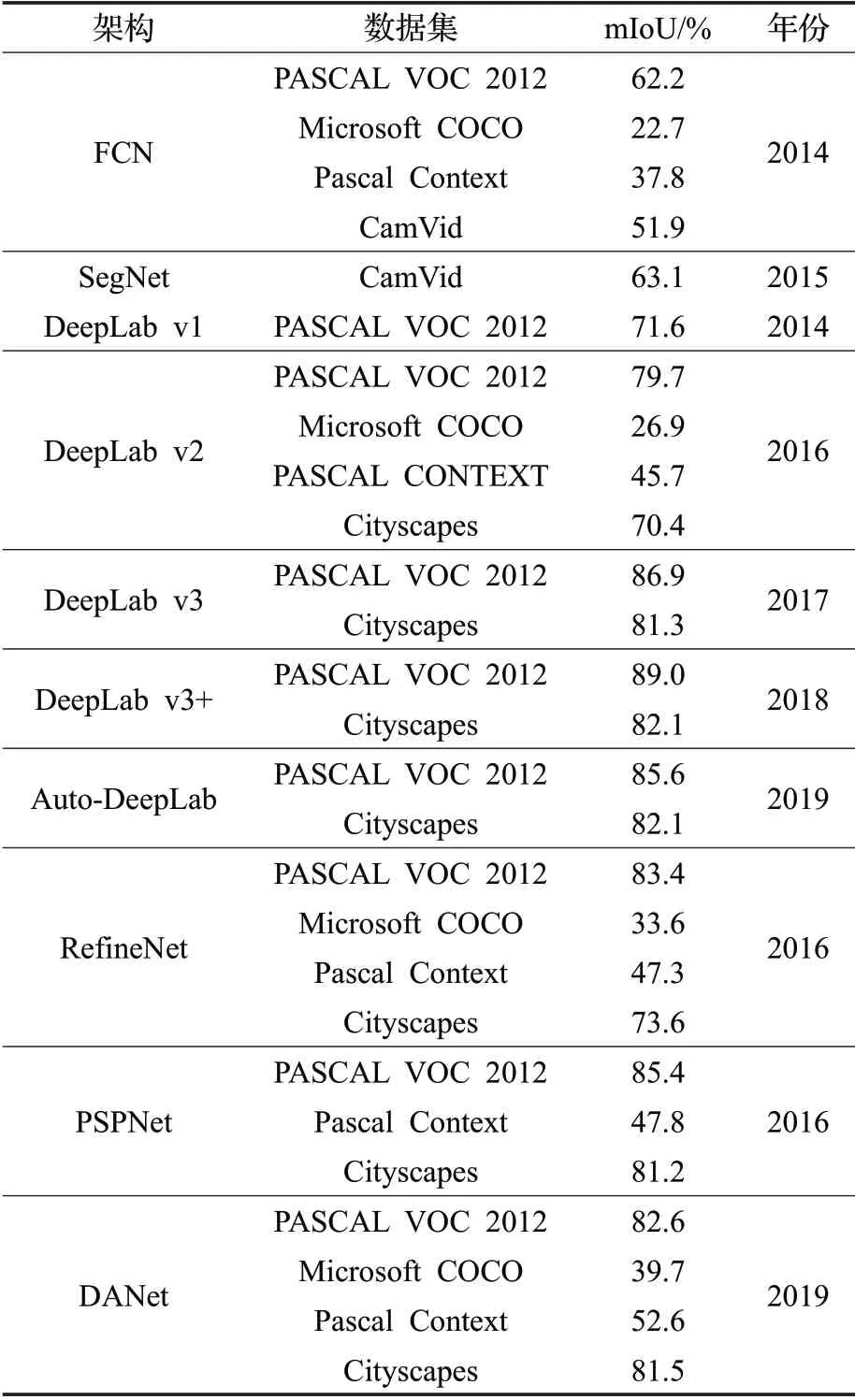

由于各个架构在功能侧重、改进技术和应用场景等方面都不相同,无法利用运行时间和内存占用指标进行统一衡量,但可以采用准确度评价指标横向对比不同架构的性能。下文以提升架构的分割准确度为研究重点,利用mIoU 评价指标,对上述语义分割典型网络架构在相应数据集上进行了测试实验和性能对比。

表3 是对各主流语义分割典型架构在PASCAL CONTEXT、MS COCO、Cityscapes 等数据集上的实验结果数据。

表3 深度图像语义分割网络架构的实验结果

从表3 可以看到,在数据集方面,不同的语义分割架构根据应用场景和分割特点的不同,选用的数据集也不同。PASCAL VOC 2012 作为静态图像进行语义分割的测试数据集,相较于其他数据集,语义分割架构在该数据集上的实验结果表现最佳;当进行实时图像语义理解或动态场景解析时,大多选用CityScapes作为测试数据集;多数分割架构在MS COCO数据集上的表现并不理想,一方面因为该数据集中图片的背景更复杂,每张图片上的实例目标个数多,小目标更多;另一方面,MS COCO评估标准比其他数据集更加严格。

在语义分割架构方面,PASCAL VOC 2012数据集上有相当一部分架构的mIoU 指标都超过了80%,如DeepLab v3+、RefineNet 等,这些架构对图像中不同尺度的物体有较好的识别效果,实验所得分割结果的边界比较接近真实分割边界,是最具代表性的图像语义分割架构。其中,DeepLab v2 由于性能稳定和分割准确率较高等优点,被广泛用于分割静态图像;DeepLab v3+架构因为集成了FCN、DeepLab v2等众多网络的优点,其mIoU 指标目前排名最高;PSPNet 与RefineNet 通过多尺度、多路径的技术对图像进行高效特征提取和融合,有效捕捉图像中丰富的上下文信息,分割效果良好,mIoU 指标得分也十分靠前。作为最新研究的架构,DANet 在Pascal Context 数据集上获得的mIoU 指标得分超过50%,这是之前的架构所达不到的;Auto-DeepLab作为语义分割架构的搜索架构,在PASCAL VOC 2012和CityScapes 数据集的上实验表现相当出色,mIoU 指标均达到了80%以上,效果甚至超越许多成熟架构,这也为语义分割架构的研究提供了新的思路。

6 结束语

随着计算机性能的提升和语义分割算法架构的不断优化,基于深度学习的图像语义分割技术在计算机视觉领域将发挥越来越大的作用,同时也面临着诸多挑战:

(1)轻量化的网络架构。随着移动端、嵌入式设备对语义分割技术的需求不断扩展,如何在简化架构、压缩和复用计算需求上生成更加轻量化的网络架构同时又能保证准确率,将是今后深度图像语义分割技术的重要发展方向。

(2)小数据集下的架构设计。在实际工程应用尤其是专有领域中,如医疗影像等,绝大多数情况下会面临目标数据来源少、规模小的情况。在没有大规模训练数据集的前提下,设计合理的网络架构以适应小规模数据集的现实情况尤为重要,这是技术与实际场景结合的重要环节。

(3)提升小目标图像分割的效率。目前,针对小目标图像语义分割的算法架构还不能完全满足实际场景应用的要求,依旧存在漏检测、分割边界模糊等问题。如何对小目标图像进行精确、高效分割是目前深度图像语义分割领域的重要研究方向。

(4)实现超大尺寸图像的分割[64]。随着图像采集技术的发展,图像分辨率将大幅提升,今后4K图像将成为主流。但目前的大部分深度图像语义分割框架还不能满足这一实际需要,在超大尺寸图像的处理方法与处理效率方面还存在很大的挑战。从技术的发展趋势来看,针对超大尺寸图像的分割也是深度图像语义分割领域未来的发展方向。

图像语义分割作为计算机视觉领域的重要技术,面对未来应用场景更加丰富、需求更加严苛的形势,也将面临更多的挑战。因此,对基于深度学习的图像语义分割技术的研究和探索任重道远。