融合短语知识的神经机器翻译方法

2019-10-21刘璐叶娜

刘璐 叶娜

摘 要:神经机器翻译是直接利用神经网络实现源语言文本到目标语言文本映射的一种机器翻译方法,翻译过程中不再需要人工设计特征。但神经机器翻译研究单元以词为基础,导致神经机器翻译的翻译模型对短语建模不充分。针对以上问题,本文提出融合短语知识的方法,利用传统机器翻译训练所得的短语表和句法分析结果,对翻译文本进行短语对抽取,将抽取的目标语言短语以后缀的形式添加到源语言端末尾。通过改变翻译语料的知识表示方式,使编码产生的句向量中包含更多有利于生成正确译文的信息,从而提升最终的翻译效果。实验结果表明,本文提出的方法相较于基线系统,BLEU值得到了提升。

关键词:神经机器翻译 短语知识 句法分析

Abstract: Neural machine translation is a kind of machine translation method that directly uses neural network to realize text mapping from source language to target language, and arti?cial design features are no longer needed in the translation process. However, the Neural machine Translation Research Unit is based on words, which leads to the translation model of Neural machine translation, which is not fully modeled on phrases. In view of the above problems, this paper proposes a method to fuse the knowledge of phrases, using the phrase table and syntactic analysis results obtained from traditional machine translation training, to extract the phrase pairs of translated text, and to add the form of the extracted target language phrase to the end of the source language end. By changing the knowledge representation of the translation corpus, the sentence vectors produced by the encoding contain more information which is conducive to generating the correct translation, thus improving the ?nal translation effect. Experimental results show that the BLEU value of the proposed method is improved compared with that of the baseline system.

中图分类号:TP391文献标识码:A文章编号:1003-9082(2019)10-0200-02

一、引言

神经机器翻译方法作为近年来受到广泛关注与运用的新型机器翻译方法,通常由编码器、解码器构成,编码器将源语句编码为实数向量表示,解码器基于源语言表示逐词生成对应的目标语言句子,在平行语料翻译任务上可以实现端到端的训练,大量实验数据显示其在机器翻译领域的极大优势。与传统的统计机器翻译相比,神经机器翻译通常会产生更流利的翻译译文,但由于神经机器翻译对短语建模效果不佳,会导致部分短语的翻译结果存在不足。针对神经机器翻译对短语建模效果不理想的问题,目前研究人员大多从解码角度提出改进方式,但这些方法均存在着原理复杂、实现困难的问题。本文尝试将神经机器翻译与短语知识的优势结合,提出一种融合短语知识的神经机器翻译方法。

二、相关研究

针对神经机器翻译对短语建模效果不理想的问题。大多研究人员尝试从解码器增强神经机器翻译的短语建模效果。

Shonosuke Ishiwatar等人提出了基于块的神经机器翻译解码器[8],将经典神经机器翻译解码器改进为短语解码器和字解码器共同组成的新型解码器,短语解码器模拟全局依赖性,字解码器决定短语中字的顺序。翻译效果在WAT16英语-日语翻译任务上得到验证。

Jingyi Zhang等人提出了通过基于短语的强制解码方式改进神经机器翻译方法[9],利用现有的短语统计机器翻译模型来计算基于短语的神经机器翻译输出的解码成本,然后使用该成本来重新排列n个最佳神经机器翻译输出,这种方法充分发挥了统计机器翻譯和神经机器翻译的优势。

Leonard等研究人员提出了在混合搜索中利用短语模型的神经机器翻译[10],该方使用统计机器翻译短语表中的短语翻译假设扩充了标准神经机器翻译搜索的范围,根据神经机器翻译模型的注意机制,决定短语翻译的使用,所有短语翻译都使用神经机器翻译解码器打分。

可以看出,目前在神经机器翻译系统中整合短语知识的方法主要集中于对解码器的改进,在解码器中集成短语生成模块。本文则是从知识表示方面着手,不需要改变解码器结构,且能将短语的翻译知识有效地编码和整合入神经机器翻译系统。

三、融合短语知识的神经机器翻译方法

目前的神经机器翻译方法研究单元以词为基础,并未显式地利用短语知识指导机器翻译的翻译过程,因此神经机器翻译的短语建模效果不佳。针对上述问题,本文提出一种融合短语知识的神经机器翻译方法。该方法主要基于神经机器翻译框架,对语料采用先抽取再后缀表示的方式重新构建双语文本,旨在使用更简便快捷的方式将更多的短语知识反映于编码过程中,生成知识更为丰富的向量,约束特定目标词的产生,从而达到提升译文质量的目的。

1.短语表生成

基于短语的统计机器翻译方法的主要优势之一在于对短语翻译的建模,该模型是反映统计机器翻译短语建模情况的概率模型。短语表的生成主要包括短语抽取和概率翻译估计两部分。

首先进行短语抽取,其算法的主要思想是遍历所有可能的目标语言短语,搜索与其相匹配的最小源语言短语。在匹配过程中需要注意目标短语为空时,则不能在源语言端找到与之对应的源语言短语;目标语言匹配的最小源语言短语中存在超出目标语言短语之外的对齐点,则不能进行短语对的抽取;与目标短语匹配的最小源语言短语和其词拓展,都可以视为对目标短语的一种翻译。经过抽取短语获得互译短语对后需要进行短语翻译概率估计,它的作用是对翻译短语对的正确性进行合理的评估。短语表中存在着四种翻译概率计算方法,分别是正向短语翻译概率、正向词汇化翻译概率、逆向短语翻译概率、逆向词汇化翻译概率。短语翻译表中,双语短语的翻译概率为以上4项概率的加权和。对于同一个源语言短语存在多个目标语言短语的情况,根据翻译概率进行排序。

2.融合短语知识的句子表示

2.1文本预处理

双语平行语料的获取与构建作为机器翻译过程的首步处理流程,其质量优劣对机器翻译质量有着不可忽视的影响。因此对于已经获取的双语平行语料还需要进行一些预处理,才能真正运用于翻译模型的训练。语料预处理过程包括分词、文本编码转换、删除过长或过短的句对。

2.2句法分析

句法结构分析是判断给定语句是否符合语法,并分析该语句句法结构的自然语言处理技术。常用的句法分析技术分为短语结构分析和依存关系分析两种。短语结构分析获取整个句子的短语构成及相关的句法结构。依存句法分析则通过分析语句内成分之间的关系解释其句法结构。

由于短语结构文法能够清晰地刻画出具有相对完整的语言学意义的短语成分边界,因此本文选择短语结构文法作为抽取双语短语的依据。

2.3双语短语的匹配与抽取

句法分析器的分析结果提供了源语句中各类短语的边界信息。本文基于短语结构句法分析树,从源语句中抽取候选短语,并与已有的短语翻译表进行匹配后获得具有较高概率的目标语言短语片段。

源语言短语的抽取过程为,首先遍历句法分析树,列举出其中的全部短语,然后根据以下条件对短语进行过滤:

(1)为避免短语过长,设置了最大短语长度阈值10,所有超出阈值的源语言短语将被丢弃。

(2)当短语长度在合理范围内时,对嵌套短语的处理方式是取最外层的短语。

源语言短语对应译文的抽取过程为,遍历所有保留下来的源语言短语,提取短语翻译表中相应的候选译文,从中选择最有可能的译文片段。筛选原则如下:

(1) 当抽取到的短语中存在禁用字符时,直接将其删除。保证抽取的短语尽量是语言学意义上的短语,如果包含这些字符,则该短语有很大可能不是正确的译文。

(2) 在余下的候选目标短语中,选择概率最高的短语,作为提供给神经机器翻译编码器的短语翻译指导信息。

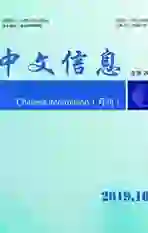

2.4基于后缀的短语知识表示方法

本文借鉴片段约束和短语知识在机器翻译中存在的优势,将概率较高的目标短语片段显式地添加到源语句的末尾,改变源语言的语句表示方式,使神经机器翻译解码过程能接收到部分短语在统计机器翻译的短语翻译模型中的高概率译文。图1给出了该表示方法的示意图。

在上图中,wi为源语句中的第i个词,#为原始语句和后缀的分隔符,图中共识别和抽取出两个双语短语片段{p1, s1}和{p2, s2},其中pi为源语言短语,si为对应的目标语言短语。本文将目标语言端的译文片段以后缀形式依次添加在源语句的结尾,告知神经机器翻译系统,分隔符“#”后是译文中应包含的短语片段。

四、实验结果与分析

1.实验设置

1.1语料设置

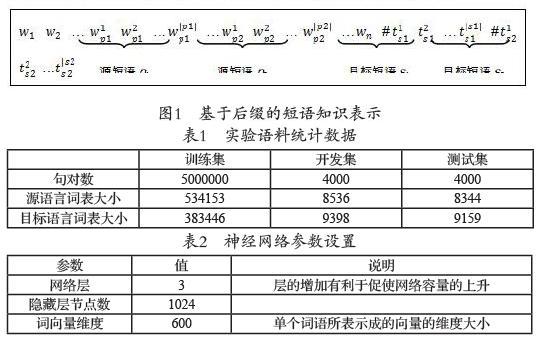

本实验语料数据来自于联合国公开语料库中英双语平行语料。获取的原始语料包括训练数据集15886041句,开发数据集和测试数据集均为4000句。

对原始训练语料进行清洗、去重、限制句长,再采用随机抽取的方式进行处理,获取5000000中英平行语句作为最终训练集;开发数据集与测试数据集保留原始结果,各个语料集的统计情况如表1所示。

1.2系统设置

本文的翻译系统,建立在基于注意力的神经机器翻译模型基础上,以Python作为开发语言。采用的操作系统环境为Linux系统,采用的深度框架为Theano框架,模型的构建使用的是纽约大学Cho实验室公布的开源代码dl4mt-master。表2给出了实验中神经网络的主要参数设置及部分说明。

本文实验系統采用的优化算法是随机梯度下降算法,测试方法使用的是束搜索方法且束大小设置为10,同时在编码器和解码器端均使用GRU门控机制,来缓解神经网络在训练过程中可能会面临的“梯度消失”问题,减少时空成本消耗。

2.对比实验结果

本文采用的基线系统为编码器-解码器框架的神经机器翻译系统,其中采用双向GRU进行编码,并带有注意力机制。Ch-enp为本文提出的方法。模型1和模型2分别为不同的随机初始化矩阵条件下的测试结果。

为了验证本文方法的有效性,我们在长度为20个词以下的句子上进行了对比实验。表3给出了实验结果。

可以看出,在融合了短语知识后,系统的翻译效果能够得到显著提升。由于句长较短,匹配上的双语短语比例相对较高,因此性能提升的幅度较大。该实验表明基于后缀的短语知识表示方法能够有效地指导神经机器翻译的编码和解码,并能够在训练过程中被模型充分学习,即模型能够理解源语句中提供的信息是目标译文中应该包含的翻译概率较高的片段。

五、总结与展望

本文提出了一種融合短语知识的神经机器翻译方法,从统计机器翻译生成的大规模双语短语表中,获取短语翻译知识,进行相应的表示后,融入编码器-解码器神经机器翻译框架,作为神经机器翻译译文生成的指导信息。该方法通过扩充源语言语句的知识表达方式,影响神经机器翻译的编码过程。在汉英双语语料库上进行的对比实验验证了所提出的方法的有效性。后续实验可以从加入其他语言学知识或短语之间的句法信息进行比较分析。

参考文献

[1]He K, Zhang X, Ren S, et al. Deep Residual Learning for Image Recognition[C]. Computer Vision and Pattern Recognition, 2016:770-778.

[2]Ghemawat S, Gobioff H, Leung S T. The Google file system[J]. Acm Sigops Operating Systems Review, 2003, 37(5):29-43.

[3]Schmidhuber J. Deep Learning in Neural Networks: An Overview[J]. Neural Networks, 2015:61-85.

[4]Krizhevsky A, Sutskever I, Hinton G E. ImageNet Classification with Deep Convolutional Neural Networks[C]. International Conference on Neural Information Processing Systems, 2012:1097-1105.

[5]Simonyan K, Zisserman A. Very Deep Convolutional Networks for Large-Scale Image Recognition[J]. Computer Science, 2014.

[6]Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2015:1-9.

[7]Xiong W, Droppo J, Huang X, et al. Achieving Human Parity in Conversational Speech Recognition[J]. IEEE/ACM Transactions on Audio Speech & Language Processing, 2016:99.

[8]Shonosuke I, Jing T Y, et al. Chunk-based Decoder for Neural Machine Translation[J]. 2017.

[9]Jing Y Z, ,Masao U, et al. Improving Neural Machine Translation through Phrase-based Forced Decoding[J]. 2017.

[10]Leonard D, Evgeny M, et al. Neural Machine Translation with External PhraseMemory [J]. 2017.