人工智能芯片发展态势分析及对策建议

2018-08-22

陈 丝 中国信息通信研究院信息化与工业化融合研究所助理工程师

1 人工智能浪潮催生芯片发展良机

1.1 人工智能应用爆发催生百亿规模芯片新市场

以图像识别、语音识别等为代表的智能化技术水平大幅提升和应用起步,掀起了新一轮人工智能研发和应用热潮,对底层芯片的计算能力需求呈现爆发式增长。据Tractica预估,全球人工智能芯片出货量持续走高,市场规模将从2016年的5亿美元增长至2025年的122亿美元,复合年均增长率保持超过40%的高速率。与此同时,伴随人工智能芯片技术不断成熟和应用落地,人工智能芯片占据人工智能总体市场规模的比例逐年递增,据CITICS预计将从2016年的8%提高至2020年的12%。现阶段,人工智能应用正处于应用起量阶段,产业链上下游企业纷纷结合自身优势加入芯片领域布局,试图抢占市场发展先机,围绕人工智能芯片领域的竞赛已经拉开序幕。

1.2 暴力计算型人工智能对芯片算力提出新挑战

本轮人工智能研究的关键词是基于概率统计学的深度学习,采用日益复杂的神经网络模型和更大规模数据样本实现识别精度不断突破,但同时产生的计算量也持续攀升,这种暴力计算模式对底层芯片的计算能力提出了更高要求并相应产生更多能耗。例如,2012年的ImageNet比赛中,采用8层神经网络的AlexNet网络取得16%的错误率,迭代一次的计算量约为1.4GFLOP(10亿次浮点计算);2015年,拥有152层神经元的ResNet网络错误率降至3.5%,但计算量为22.6GFLOP,大约达到AlexNet的16倍。与此同时,深度学习需要处理的数据规模及其庞大,如采用卷积神经网络基于ImageNet数据集训练模型,统计扫描100遍样本即达到E级计算规模,即使提供充足的计算资源,仍需几天甚至几周的训练时长。

1.3 深度学习算法对芯片技术创新提出新需求

深度学习算法区别于传统算法特征,既是计算密集型也是存储密集型运算,对芯片的专用计算能力和内存存取能效等提出新的升级需求。一方面,具备复杂的深度神经网络结构对卷积、矩阵乘加等线性代数类运算任务密集又频繁,因而集成矩阵乘加等专用运算单元的计算芯片能显著加速深度学习处理效率;另一方面,深度学习需要处理海量数据样本,强调芯片高并行计算能力,同时大量数据搬运操作对内存存取带宽等要求更高,而内存存取尤其是片外内存访问消耗的功耗要远大于计算功耗,因而高能效的内存访存架构设计对芯片应用尤其是端侧部署至关重要。

2 人工智能芯片技术路径百花齐放

2.1 人工智能芯片处于多技术路径竞相发展阶段

深度学习处理任务应用主要分为训练和推理两个阶段,实现高精度模型提取的训练阶段需快速处理海量数据,现阶段集中在云端执行,对芯片计算能力、通用性、扩展性有较高要求;实现模型最终应用部署的推理阶段既可以在云端执行,也可在智能手机、智能摄像头、智能汽车等终端操作,多样化细分场景对人工智能芯片性能、功耗、延时以及成本等标准需求各异。诸多差异化的应用阶段和细分场景导致人工智能芯片处于多种技术方案竞争发展起步阶段。

2.2 不同类型人工智能芯片各有所长

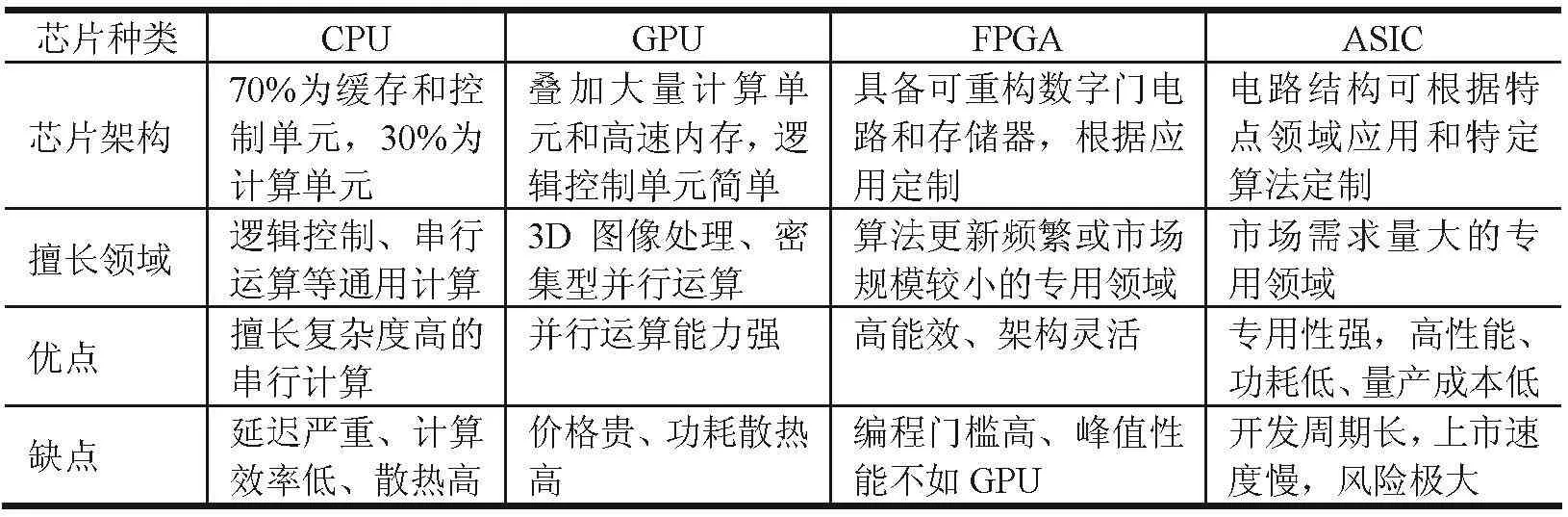

现阶段,常见的人工智能芯片类型包括GPU、FPGA、ASIC等芯片(见表1)。其中,GPU芯片集成大量计算单元和高速内存,通用性较强且适合大规模并行计算任务,能显著缩减数据的训练时长,但高能耗引发散热问题以及高售价限制,使其多应用于数据中心或自动驾驶场景。FPGA硬件配置灵活,能快速适应算法迭代更新,且能效优于GPU,但开发复杂度较高,开发者生态建设仍需增强。针对特定算法定制的专用ASIC芯片量产后性能、功耗、成本相对于FPGA具备更强优势,但人工智能算法仍处于快速演进阶段,定制化ASIC开发周期长、面临风险高。目前,深度学习训练任务多集中在云端执行,以GPU和ASIC芯片居多;推理芯片根据云端、终端场景区别,FPGA、ASIC和GPU芯片均有涉及。此外,CPU芯片架构绝大部分为控制和缓存单元,更擅长复杂的逻辑控制和通用类型数据运算,并行计算效率低,在人工智能任务中多用于样本数据预处理操作。

3 人工智能芯片领域竞赛群雄逐鹿

表1 常见人工智能芯片类型

3.1 云侧训练市场初步由GPU芯片取得优势

基于大数据量、复杂算法模型的人工智能模型训练阶段多集中在云端处理,需求高并行、高吞吐量的芯片架构。现阶段,英伟达凭借高性能的GPU芯片占据应用规模优势,快速推出业内高并行计算能力的Tesla GPU系列产品,其中V100 GPU芯片集成专为人工智能运算设计的大型矩阵乘加计算核心和16G的高带宽内存,实现每秒120万亿次的峰值运算能力。AMD也加速追赶,2018年6月初发布全球首款7nm制程的Radeon Instinct VegaGPU芯片产品,针对云端人工智能市场研发,设计引入可编程几何流水线、混合精度计算单元等架构技术,内置32G的高带宽内存,正式产品将于2018年下半年推出。

3.2 新兴力量借助ASIC芯片创新构筑竞争实力

谷歌面向谷歌云业务需求自研人工智能ASIC系列芯片TPU,并于2017年5月正式发布第二代产品Cloud TPU,采用了脉动阵列架构,增添了浮点计算单元和高带宽内存,同时具备深度训练和推理能力,Cloud TPU于2018年2月初通过谷歌云平台正式面向客户服务,但开放数量有限且按时收费,每小时成本为6.50美元。英特尔收购人工智能芯片初创企业Nervana后积极整合推广其训练芯片技术,推出面向人工智能计算密度优化的ASIC训练芯片,最新Spring Crest芯片产品将于2019年下半年向用户开放,功耗小于210W。

3.3 高能效、低时延芯片成为云端推理市场角逐焦点

云端推理平台需求高能效、高吞吐量或低延时的人工智能芯片,主要包括3类:一是英伟达针对推理市场需求推出TeslaP系列GPU芯片,可提供低时延或低功耗的推理性能;二是赛灵思和英特尔主导的FPGA芯片凭借灵活架构、高能效、低延时特性,吸引亚马逊和微软等云服务商进行部署。赛灵思推出基于FPGA架构的新型多核异构计算平台ACAP,可针对人工智能任务需求,实现硬件层面低至毫秒级别的高效灵活配置。英特尔收购FPGA厂商Altera后推出了基于FPGA的专用深度学习加速卡,结合自有CPU芯片打造可编程、高能效比的推理功能;三是以谷歌为代表的自研ASIC芯片阵营,谷歌于2016年5月最先发布专为数据中心推理任务定制的ASIC芯片产品TPU,计算核心是矩阵乘加单元,峰值计算能力达到每秒92万亿次计算操作。

3.4 终端人工智能芯片市场正在起步,涉及芯片类型多样化

伴随人工智能市场大幅扩张,实现应用部署的终端推理芯片将具备更广阔的市场前景和应用需求,其中智能手机、安防监控、自动驾驶等领域将成为市场首轮爆发焦点。在智能手机领域,苹果发布iPhone X智能手机内置A11bionic芯片,集成双核神经引擎,运算速度达到每秒6000亿次,支持快速人脸解锁、增强现实等功能。高通推出的骁龙845移动芯片基于CPU+GPU+DSP的移动异构计算平台,并重点提升DSP单元针对神经网络处理速度和能效至CPU的8和24倍。在安防监控领域,英特尔收购Movidius芯片厂商推出高速低功耗Mybriad系列视觉芯片,最新款Myriad X芯片具备每秒超过1万亿的次运算能力。在自动驾驶领域,英伟达推出高能效、高可靠性的车用Xaiver SoC芯片,性能达到每秒30万亿的次计算能力,功耗仅为30W,支持L3~L4级别自动驾驶。

4 我国人工智能芯片产业创新活跃

4.1 积极突破云端人工智能芯片领域

受限于国内在GPU和FPGA芯片领域基础薄弱,企业多采用ASIC路线布局云端谋求战略突破,参与企业包括百度、寒武纪、比特大陆等。百度面向自身业务需求开发云端人工智能芯片“昆仑”,峰值处理速度达到每秒260万亿次定点运算,可满足训练和推理的需求。寒武纪发布云端智能芯片MLU 100,最高峰值速度可达166.4万亿次定点运算,对应功耗110W,可支持各类深度学习和常见机器学习算法,满足计算机视觉、语音识别、数据挖掘等计算需求;同时,寒武纪联合联想、中科曙光分别推出深度学习专用服务器Think System SR650和PHANERON,可面向多类云处理任务提供服务。比特大陆针对云端推理任务设计专用处理器SOPHON,采用类似谷歌的脉动阵列架构,提供每秒2万亿次的计算能力,具备60W低功耗优势,支持CNN、RNN、DNN等常见深度神经网络算法的推理预测。

4.2 重点聚焦终端细分市场芯片布局

国内企业面向智能手机、安防监控、自动驾驶等终端重点细分领域加速人工智能芯片研发,试图抢占市场先机。在智能手机领域,华为发布麒麟970芯片集成寒武纪的深度学习IP内核,峰值计算能力达到每秒1.93万亿次运算,重点提升智能手机的图像识别、机器翻译、语音降噪等功能。紫光展锐针对中端智能手机开发SC9863处理器,应用ARM Dynam lQ技术和Cortex-A55CPU内核,支持智能场景检测识别、智能拍照增强、人脸识别等功能。在自动驾驶领域,地平线机器人开发嵌入式人工智能视觉芯片——征程处理器,具备每秒一万次运算性能,功耗低至1.5W,支持L2级别ADAS系统,可实时检测和识别行人、机动车、车道线等多类目标。在安防监控领域,深鉴科技发布听涛SoC芯片,基于自研架构提供4.1TOPS的峰值性能,功耗1.1W,可面向多类应用场景提供人脸检测识别、视频结构化处理等解决方案。此外,海康规划开发视觉加速芯片,由智能摄像头整机设备向底层芯片渗透,完善产业链布局。

4.3 我国人工智能芯片发展机遇与挑战并存

我国人工智能应用市场规模庞大,数据积累形成海量规模,为国内人工智能芯片发展提供巨大空间。现阶段我国企业紧跟人工智能芯片创新机遇,积极开展定制ASIC芯片研发,并在部分领域取得一定进展,为人工智能产业持续升级夯实基础。与此同时,我国集成电路产业基础薄弱问题再次凸显。一是国内企业在高性能GPU和FPGA芯片领域研发滞后,企业多采用ASIC芯片架构进行创新,影响国内人工智能芯片全产品线布局;二是国内布局人工智能芯片研发多为初创企业,缺乏长期芯片架构设计和软件编译等经验累积,应用生态尚未搭建完善,市场关系仍需持续开拓;三是现有人工智能芯片研发人员也远远不能满足需求,芯片产品创新发展源动力不足。

5 结束语

(1)强化核心技术攻关,优化产业发展环境。积极推动产、学、研、用各主体加强技术攻关,促进深度学习指令集、芯片体系架构等基础核心技术创新升级,鼓励技术新路径探索。促进人才、资金、资源等要素集聚,切实推进人工智能芯片产业发展。

(2)加强产业链上下联动,实现芯片、算法、应用、生态协同发展。推动人工智能应用企业、终端企业、平台企业、算法企业与芯片企业间的深度合作和协同创新,面向应用市场需求加快推动“芯片与算法”、“芯片与整机”、“芯片与应用”等各参与主体间的资源协调与协同设计优化。

(3)注重应用市场导向,推动人工智能芯片产业规模快速放大。积极把握人工智能的发展机遇,加快推进产品研发布局,发挥应用市场的带动效应,鼓励国际合作交流,促进人工智能芯片在安防、医疗、交通等多领域的推广应用。