改进GWO优化SVM的语音情感识别研究

2018-08-20RYADChellali

陈 闯,RYAD Chellali,邢 尹

CHEN Chuang1,RYAD Chellali1,XING Yin2

1.南京工业大学 电气工程与控制科学学院,南京 211816

2.桂林理工大学 测绘地理信息学院,广西 桂林 541004

1.College of Electrical Engineering and Control Science,Nanjing Tech University,Nanjing 211816,China

2.College of Geomatics and Geoinformation,Guilin University of Technology,Guilin,Guangxi 541004,China

1 引言

语音是人类交流的重要方式。语音信号中不仅传递了说话人的语义内容,也承载着说话人的情感状态。如何有效识别语音信号中的情感类型是近年来人工智能领域的一个研究热点。语音情感识别技术已经成功应用于辅助测谎[1]、远程教学[2]、临床医学[3]等领域。

目前常用的语音情感识别方法主要有支持向量机(Support Vector Machine,SVM)、人工神经网络(Artificial Neural Network,ANN)、隐马尔可夫模型(Hidden Markov Model,HMM)、混合高斯分布模型(Gaussian Mixture Model,GMM)等[4]。SVM是机器学习领域的一个热点算法,在解决非线性、小样本以及高维模式识别中体现出特有的优势,但其分类性能受其内部参数影响很大[5]。为此,许多学者提出将布谷鸟搜索算法[6](Cuckoo Search,CS)、差分进化算法[7](Differential Evolution,DE)、粒子群算法[8](Particle Swarm Optimization,PSO)等运用于SVM的参数寻优上,但这些优化算法对于提升SVM的性能仍比较有限。2014年,由Mirjalili等人[9]提出的灰狼算法(Grey Wolf Optimizer,GWO)在寻找最优解方面具备简单、高效的特点而备受关注。为了进一步提升GWO的寻优性能,各种改进的GWO算法也应运而生。文献[10]提出将极值优化算法融入GWO,增加了算法获得全局最优解的概率;文献[11]利用佳点集理论初始化种群,并对当前种群中最优个体使用Powell算法进行局部搜索,提升了算法的寻优性能,加快了收敛速度;文献[12]提出采用反向学习改进GWO,并将算法并行化;文献[13]提出采用非线性调整策略对GWO进行改进,平衡了种群全局搜索能力和局部搜索能力。

在前人研究的基础上,本文提出在基本GWO算法中嵌入选择算子和改进收敛因子,以此探索改进的灰狼算法(Improved Grey Wolf Optimizer,IGWO)的寻优性能。通过对10个基准测试函数的仿真实验,验证了IGWO算法寻优性能优于基本GWO算法。利用IGWO算法来对SVM参数进行优化,并采用优化后的参数建立了IGWO-SVM的语音情感分类模型。实验结果表明,IGWO-SVM模型在对语音情感的识别上体现出了优越性。

2 改进灰狼算法

2.1 基本灰狼算法

灰狼算法是一种模拟灰狼群体狩猎活动的智能算法。灰狼群中包含社会等级最高的α狼,其次分别为β、δ和ω狼。群体捕食时,由α狼带领,β和δ狼协助,ω狼追随,完成对猎物的包围、猎捕和攻击等行为。

灰狼群在狩猎中,首先对猎物进行包围,该过程的数学描述为:

其中,Xp表示猎物的位置;X(t)表示第t代时灰狼个体的位置;A和C为系数向量;r1和r2为[0,1]的随机数;a为收敛因子,a=2-2t/T,T为最大迭代次数。

其次,灰狼群进行猎捕。该过程由α、β和δ狼来引导,更新灰狼个体位置,数学描述为:

最后,灰狼群进行攻击,完成捕获猎物这一目标,即GWO算法获得的最优解。攻击行为主要依据式(3)中a值由2递减到0来实现。当时,灰狼群对猎物集中攻击,对应于局部搜索;当时,灰狼散去,进行全局搜索。

2.2 嵌入选择算子

Haupt等人[14]认为,多样性较好的初始种群对提高群体智能算法的寻优性能具有积极意义。基本灰狼算法以随机方式生成初始种群,初始种群虽然具备一定的种群多样性,但种群水平未必较好,影响算法的收敛速度和精度。在随机生成初始种群之后,嵌入选择算子[15],将有利于提升基本GWO的寻优性能,具体操作如下:

(1)随机生成初始灰狼种群,并计算每个个体适应度值。

(2)根据适应度值,由小到大排列,分为前、中、后三段。

(3)每段按照1.0、0.8和0.6的比例随机选择个体。

(4)对于损失的个体,以前段的个体进行补充,插入步骤(3)所选择的个体之后,形成新种群。

上述的选择算子采取优者多选、劣者少选的策略,提升了初始种群整体水平,同时兼顾了种群多样性,操作简单。

2.3 非线性收敛因子

群体智能优化算法一般面临着全局搜索与局部搜索能力平衡的问题。为了解决GWO在两者之间的平衡问题,文献[13]提出了一种改进的收敛因子a,具体公式如下:

其中,e为自然对数的底数;t为当前迭代次数;T为最大迭代次数。初始阶段a衰减程度降低,以便算法全局寻优;后期提升a的衰减程度,对应于算法精确局部寻优。但在实际使用中发现,a不同的衰减程度对应于不同的GWO搜索性能。为此,本文提出一种改进的非线性收敛因子如下:

其中,p为衰减阶数,在[0,10]之间取整数,p越大对应收敛因子a衰减越剧烈,如图1所示。

2.4IGWO算法实施步骤

(1)给定种群规模N,最大迭代次数T,初始化a、A和C等参数。

(2)根据2.2节中的选择算子确定新种群。

(3)根据式(13)计算a,更新A和C。

(4)根据式(5)~(11)更新个体位置。

图1 收敛因子对比图

(5)如果达到最大迭代次数,则输出最优个体位置和最优值;否则,返回步骤2。

3 改进灰狼算法优化支持向量机模型

3.1 支持向量机

支持向量机是一种基于统计理论的分类算法,在模式识别和数据挖掘领域有着广泛应用[16]。对于非线性可分样本,它的基本思想是引入核函数将输入特征样本映射到高维空间中,然后寻求此空间中的超平面使得样本线性可分。对于非线性可分的SVM优化问题可描述为:

式中,w为权系数向量;b为分类阈值;C(C>0)为惩罚因子,用来平衡分类误差与推广性能;ξi(ξi≥0)为松弛变量,用来衡量对应样本xi相对于理想条件下的偏差;L为训练样本个数;为类别标号。假设低维输入空间到高维特征空间的映射函数为Φ,应用核函数变换等式 (xi,xj)→K(xi,xj)=Φ(xi)⋅Φ(xj),得到最终的分类超平面函数为:

式中,ai为拉格朗日因子;K(xi,x)为核函数。目前常用的几种核函数有多项式核函数、RBF核函数、S型核函数。本文采用RBF核函数,对应公式如下:

3.2IGWO-SVM分类模型建立步骤

(1)初始化灰狼种群,每个个体位置由C和g组成。

(2)SVM依照个体位置中的C和g,对训练集进行学习,以测试集SVM分类错误率作为个体适应度函数。

(3)采用IGWO算法对灰狼群个体位置进行更新。进化过程结束时,返回最优个体位置,即C和g值。

(4)采用优化后的C和g建立SVM分类模型。

4 实验结果及分析

4.1IGWO算法性能分析实验

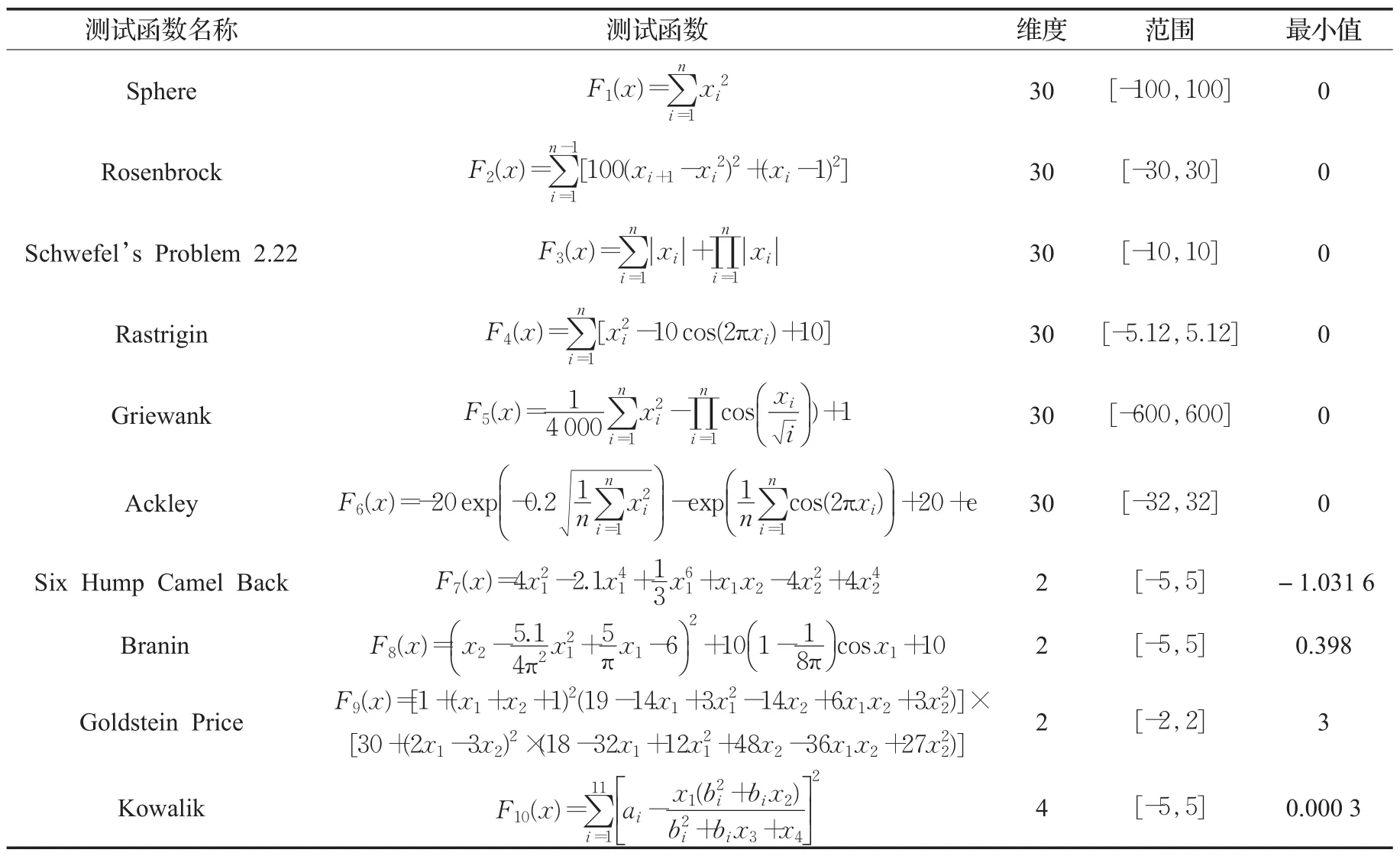

为了验证本文提出的两种改进策略的有效性,选取10个基准测试函数,见表1。表1列出了这10个函数的基本信息,包括3个单峰基准测试函数(F1~F3),3个多峰基准测试函数(F4~F6)和4个固定维度多峰基准测试函数(F7~F10)。为公平起见,所有算法的种群规模统一设置为30,最大迭代次数为500。

为了消除随机性对结果的影响,取30次运行结果的平均值作为最终结果。考虑到篇幅限制,选取Sphere、Schwefel’s Problem 2.22和Ackley函数考察不同衰减阶数对算法的影响,如图2所示。

表1 10个基准测试函数

图2 Sphere、Schwefel’s Problem 2.22和Ackley函数的不同衰减阶数寻优收敛曲线

表2 对10个基准测试函数的测试结果

从图2中可以看出,采用非线性收敛策略提升了GWO的寻优精度,且随着衰减阶数p的增大而增高,当p增大到4时,寻优精度稳定,说明p=4是一个较佳的衰减阶数。

为了说明IGWO的优越性,GWO、IGWO1、IGWO2和IGWO对10个基准测试函数的测试结果见表2。其中,IGWO1表示嵌入选择算子的改进GWO,IGWO2表示引入非线性收敛因子(p=4)的改进GWO,IGWO表示两种改进策略混合的改进GWO。

从表2中可以看出,对于单峰基准测试函数F1~F3,IGWO1和IGWO2在函数F1和F3上均表现良好;引入选择算子和非线性收敛因子的IGWO综合了IGWO1和IGWO2的优点,在函数F1和F3上将性能发挥至最大,寻优结果更接近目标函数最优值,且稳定性更好。对于多峰基准测试函数F4~F6,IGWO和IGWO2在函数F4上都寻找到了目标函数的最优值0,且标准差为0;对于函数F5和F6,IGWO都好于另外3种算法。对于固定维度多峰基准测试函数F7~F10,3种算法对于函数F7~F9的寻优效果相当;对于函数F10,IGWO2表现最好,更接近目标函数最优值。综上,IGWO在大多数函数上不仅提升了搜索精度,且寻优结果更加稳定。

为了直观地反映各算法的寻优性能,图3示例性地给出了各算法对于Sphere、Rastrigin和Ackley函数的寻优收敛曲线。

从图3中可以看出,IGWO1和IGWO2均提升了基本GWO的寻优性能,尤其是嵌入选择算子和引入非线性收敛因子的IGWO具有更高的收敛精度和更快的收敛速度。

4.2 语音情感识别实验

图3 Sphere、Rastrigin和Ackley函数的寻优收敛曲线

本文的实验样本来源于柏林情感语音库[17]。该语音库在语音情感识别领域应用广泛,许多语音情感识别研究成果均在此语音库上进行验证。本文选取其中生气、开心、平静、伤心和害怕5种常见情感,经过人耳的辨别试听,最终保留了400条语音样本,具体为生气126条,开心68条,平静78条,害怕66条,训练样本和测试样本以1∶1比例随机分配。实验中,选取短时能量、基音频率、共振峰和梅尔频率倒谱系数(Mel Frequency Cepstral Coefficient,MFCC)这4类语音情感特征构建实验数据,具体为短时能量、基音频率、第一二三共振峰、0~12阶MFCC及其一阶差分的最大值、最小值、均值和方差。具体计算方法详见参考文献[18]。将提取的语音情感特征按照式(17)进行归一化处理:

其中,x表示原始语音情感特征;xmin和xmax分别表示特征的最小值和最大值。

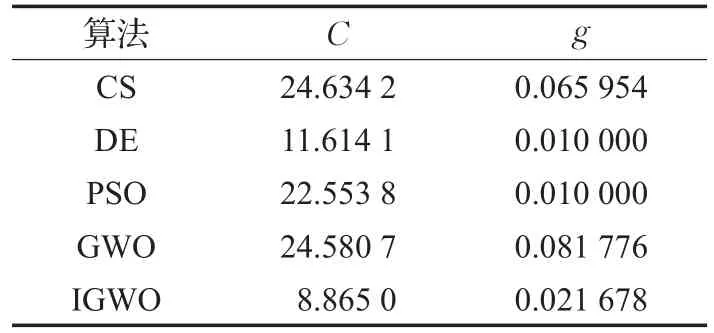

为了验证IGWO-SVM模型对于语音情感分类的优越性,分别采用布谷鸟搜索算法(CS)、差分进化算法(DE)、粒子群算法(PSO)、灰狼算法(GWO)和改进灰狼算法(IGWO)对SVM参数进行寻优。语音情感实验中,采用十折交叉验证技术,即将原始数据集随机分成10等份,其中9份用于SVM训练,剩下的1份用于验证。统一设置所有优化算法的种群规模为30,最大迭代次数为200,此参数设置均保证了各寻优算法达到收敛状态。其中CS被宿主发现概率为0.25;DE交叉概率因子为0.8;PSO加速因子均为1.5。SVM参数寻优范围设置为C∈[0.01,100],g∈[0.01,100]。各算法对SVM参数的寻优结果见表3。

表3SVM参数寻优结果

将表3中的C和g分别作为SVM参数,对训练集进行学习,分别建立CS-SVM、DE-SVM、PSO-SVM、GWO-SVM和IGWO-SVM语音情感分类模型。

IGWO-SVM模型的5种情感识别结果,如图4所示。其中横坐标表示测试集样本的样本序号,纵坐标类别标签1~5依次对应生气、开心、平静、伤心和害怕情感。统计5种模型的语音情感识别结果,见表4。从表4中可以看出,IGWO-SVM和CS-SVM模型的语音情感平均识别率最高,均为93.50%(187/200)。由表3可知,IGWO的参数寻优结果C=8.8650,小于CS的参数寻优结果C=24.6342,减少了SVM过学习的可能性。因此,采用IGWO对于SVM的优化是有效的,可以提升语音情感的识别率。

图4IGWO-SVM模型的语音情感识别结果

5 结束语

本文首先介绍了GWO的基本原理,并针对GWO在寻优过程中易陷入局部最优的缺点,提出嵌入选择算子和引入非线性收敛因子来提升GWO的寻优性能。通过对10个基准测试函数的仿真实验,验证了IGWO的优越性。采用IGWO对SVM的惩罚因子和核函数参数进行优化,并构建了IGWO-SVM的语音情感分类模型。相比于CS、DE、PSO和GWO优化的SVM模型,IGWOSVM模型有效提升了语音情感识别率。针对实验结果中伤心情感识别率偏低的情况,下一步将从特征提取角度提取短时能量、基音频率和共振峰的衍生参数,探讨对伤心情感识别的影响。

表4 不同模型的语音情感分类结果