自然场景图像中的文本检测综述

2018-04-23王润民桑农丁丁陈杰叶齐祥高常鑫刘丽

王润民 桑农 丁丁 陈杰 叶齐祥 高常鑫 刘丽

文本作为人类文明的标志、信息交流的载体,广泛地存在于自然场景图像中(如:路牌、商品名称、车辆牌照等),相较图像中的其他自然场景内容(如:树木、行人、建筑物等),自然场景文本具有更强的逻辑性与更概括的表达性,能更加有效地提供高层语义信息,准确地识别图像中的文本将有助于场景内容的分析与理解.

1 研究背景与意义

基于文本具有高度的概括性和抽象的描述能力,自然场景文本检测技术在智能交通系统[1−3]、视障人导盲[4−5]、基于内容的图像/视频检索[6]以及可穿戴/便携式视觉系统[7−10]等方面具有重要的应用.随着互联网技术以及便携式移动设备的高速发展,越来越多的应用场景需要利用图像中的文本信息.目前自然场景文本检测已成为计算机视觉与模式识别、文档分析与识别领域的一个研究热点,一些国际顶级会议,如:CVPR、ICCV、ECCV,已将自然场景文本检测列为其重要主题之一.特别是自2003年以来,作为文档分析与识别领域最重要的国际学术会议–文档分析与识别国际会议(International Conference on Document Analysis and Recognition,ICDAR)定期组织自然场景文本检测竞赛,通过竞赛对该领域研究现状、发展趋势进行分析,及时地跟踪并推动该技术的研究发展.

目前,自然场景文本检测问题已受到国内外研究人员的广泛关注,一些国外研究团队,比如牛津大学视觉几何组(Visual geometry group,VGG)、捷克理工大学机器感知中心Jiri Matas组、日本九州大学Seiichi Uchida组以及微软亚洲研究院等,在该领域取得了一些里程碑式的研究成果.国内研究机构与学者在文档分析与识别领域也发挥着举足轻重的作用[11−21].一些国内研究者,比如,中科院自动化所刘成林研究员、华中科技大学白翔教授、北京科技大学殷绪成教授、华南理工大学金连文教授、中国科学院大学叶齐祥教授以及中科院深圳先进技术研究院乔宇研究员、黄伟林博士等在历届ICDAR自然场景文本检测竞赛中获得了令人瞩目的成绩.特别是,华中科技大学白翔教授受邀作为ICDAR自举办26年来以来第一位来自中国的主讲嘉宾在日本京都举办的ICDAR 2017上作大会特邀报告,展现了中国学者在此领域的影响力.一些国内研究机构,比如中科院自动化所、北京大学、清华大学、华中科技大学、北京科技大学、三星中国研究院、腾讯、百度、旷视科技等,在ICDAR组织的一系列活动中表现活跃.2011年,由清华大学与中科院自动化所合办的第十一届文档分析与识别国际会议(ICDAR 2011)在北京举办(ICDAR首次在国内举办),清华大学丁晓青教授担任了大会主席.2017年,由华中科技大学白翔教授等组织了ICDAR 2017自然场景中的中文文本识别竞赛(RCTW-17),共有来自高校、企业的17支队伍参赛了RCTW-17竞赛1竞赛结果链接:http://mclab.eic.hust.edu.cn/icdar2017chinese/result.html.2017年,中科院自动化所刘成林研究员领导的模式分析与学习团队(PAL团队)与法国拉罗切尔大学、三星中国研究院等单位合作举办了多语言场景文本检测与语种判别的竞赛,发布了包括9种语言,18000幅图像的多语言场景文本数据库.

国内研究团队在包括 TPAMI、TIP、PR、CVPR等各类主流国际期刊、会议的投稿数量逐年增加[11−19],在本次ICDAR 2017会议中来自国内学者的投稿论文数高居第一.此外,国内研究团队在该领域各项竞赛中也取得了瞩目的成绩,在第14届国际文档分析与识别会议(ICDAR 2017)所组织的各项技术竞赛中,中科院自动化所刘成林研究员领导的PAL团队在页面目标检测、中世纪文档版面分析、视频阿拉伯文本检测与识别、中文场景文本阅读等竞赛中获得了8项任务的第一名、2项任务的第二名的突出成绩.华南理工大学金连文教授带领的团队,通过构建高性能的基于深度学习的文本检测与识别系统,在场景文本检测,端到端场景文本检测及识别两项任务中取得第一名的好成绩(后者较其他参赛团队具有明显的优势),在语种分类任务中以0.4%的微弱差距位居第二名.北京科技大学殷绪成教授团队再次(连续三届)荣获鲁棒阅读竞赛冠军.

尽管国内学者在自然场景文本检测领域取得了一些令人瞩目的成果,在本领域重要的外文期刊上也发表了英文综述性论文[22−25],然而我们以自然场景文本检测为关键词在国内中文期刊数据库中进行检索时却遗憾地发现,除了出现个别手写文本识别的综述[26]外,关于自然场景文本检测的中文综述几近空白.据我们所知,最近的英文综述[22−25]发表至今已逾两年,然而在这两年以来,一些新的测试数据库与一些新的检测结果的推出,以及一些新型深度学习方法在自然场景文本检测领域的应用都极大地推动了相关技术的发展.此外,计算机视觉领域中的一些新的研究成果,比如目标显著性检测、视觉上下文等,也被引入到自然场景文本检测领域,进一步提升了文本检测性能.基于上述情况,有必要对自然场景文本检测领域的相关研究工作进行全面综述和讨论.本文系统综述了自然场景文本检测技术的研究进展和目前面临的挑战与困难,以期为研究人员进一步深入研究自然场景文本检测以及拓展其应用领域提供帮助,并期待能够启发更多的创新性工作.

本文首先论述了自然场景文本检测的研究背景、现状、自然场景文本特点以及主要技术路线.接下来,梳理、分析并比较了各类自然场景文本检测方法的动机、原理、优势与不足,揭示了各类方法之间的区别与联系.本文还介绍了端对端文本识别技术,阐述并讨论了文本显著性、视觉上下文等其他领域知识在自然场景文本检测中的应用.此外,本文还论述了自然场景文本检测技术所面临的挑战,并探讨了相应的解决方案.列举了测试基准数据集、评估方法,将最具代表性的自然场景文本检测方法的性能进行了比较.最后,给出了我们对该领域发展的一些思考.

2 研究现状

相对人脸检测、印刷体文档中的光学字符检测等经典问题,自然场景文本检测研究还相对滞后,直到20世纪90年代中期才开始出现该领域的研究报道[27−29].目前,自然场景文本检测已成为计算机视觉领域的热门研究课题,吸引了国内外众多的研究机构与学者开展该课题的研究.特别是国际文档分析与识别会议(ICDAR)定期举办的各项技术竞赛极大地推动了该领域的发展,从而使得自然场景文本检测技术的瓶颈与难题不断地被突破.比如在2011年,ICDAR 2011自然场景文本检测竞赛冠军[30]所获得的结果为召回率(Recall)0.63,准确率(Precision)0.83,综合指标(F-measure)0.71.而在2017年,文献[31]公布其在ICDAR 2011自然场景文本检测数据库上所获得的指标为召回率(Recall)0.82,准确率(Precision)0.89,综合指标(F-measure)0.86.再如在2015年,ICDAR 2015非受限环境下的自然场景文本(Incidental scene text)检测(Task 4.1)竞赛冠军[32]的指标为召回率(Recall)0.37,准确率(Precision)0.77,综合指标(F-measure)0.50.在2017年,文献[33]公布对ICDAR 2015非受限环境下的自然场景文本检测(Task 4.1)所获得的结果为召回率(Recall)0.77,准确率(Precision)0.73,综合指标(F-measure)0.75.由此可见,自然场景文本检测技术在近几年取得了长足的发展.

目前针对自然场景文本处理的研究工作主要包括三个方面:自然场景文本检测、自然场景文本识别、以及端对端(End-to-end)自然场景文本检测与识别.分析2017年发表在CVPR、ICCV、NIPS、IJCAI、AAAI、ICDAR 等各类顶级会议上的相关论文,超过80%的自然场景文本检测论文主要关注多方向排列的文本检测问题,大部分文献主要处理英文文本,较少的文献涉及自然场景文本识别以及端对端自然场景文本检测与识别问题.从自然场景文本检测技术的处理对象来看,主要经历了水平方向排列的文本检测[34−37]到多方向排列的文本检测[15,33,38−42],从单一的英文、阿拉伯数字的文本检测[34−36]到多语种的文本检测[37,41,43−44].从自然场景文本检测所采用的描述特征来看,主要经历了两个阶段:首先是基于传统手工设计的特征(Handcraft features),然后在2014年前后出现了基于深度学习的自然场景文本检测方法[19,31,45−49].一些深度学习技术,比如:卷积神经网络(Convolutional neural networks,CNN)以及递归神经网络(Recurrent neural networks,RNN)等在自然场景文本检测领域得到了很好的应用,目前采用深度学习方法检测自然场景文本已成为了该领域研究的主要技术手段.

不同于印刷体文档中的文本,自然场景文本的字体大小、颜色、排列方向、稀疏性、对比度等有着很大的差异.与此同时,还受到光照变化、复杂背景、噪声干扰、拍摄视角等方面的影响.尽管对仅包含英文与数字的ICDAR 2011数据集已取得综合指标(F-measure)0.86[31]以及ICDAR 2015数据集已取得综合指标(F-measure)0.81的性能[50],但从最近刚落幕的ICDAR 2017自然场景中的中文文本识别竞赛(RCTW-17)[51]所公布的结果来看,竞赛冠军所取得的准确率为0.74,召回率为0.59,综合指标为0.66.从上述文本检测结果中不难发现,现有的自然场景文本检测技术受限于被检测文本的语种、排列方向、数据集公布的时间、数据集的规模等,由此表明该技术的成熟度、鲁棒性还远非达到实用水平.综上所述,基于自然场景文本检测技术的研究现状以及该技术广阔的应用前景,对该领域的深入研究具有重要的理论意义与应用价值.

3 自然场景文本的特点

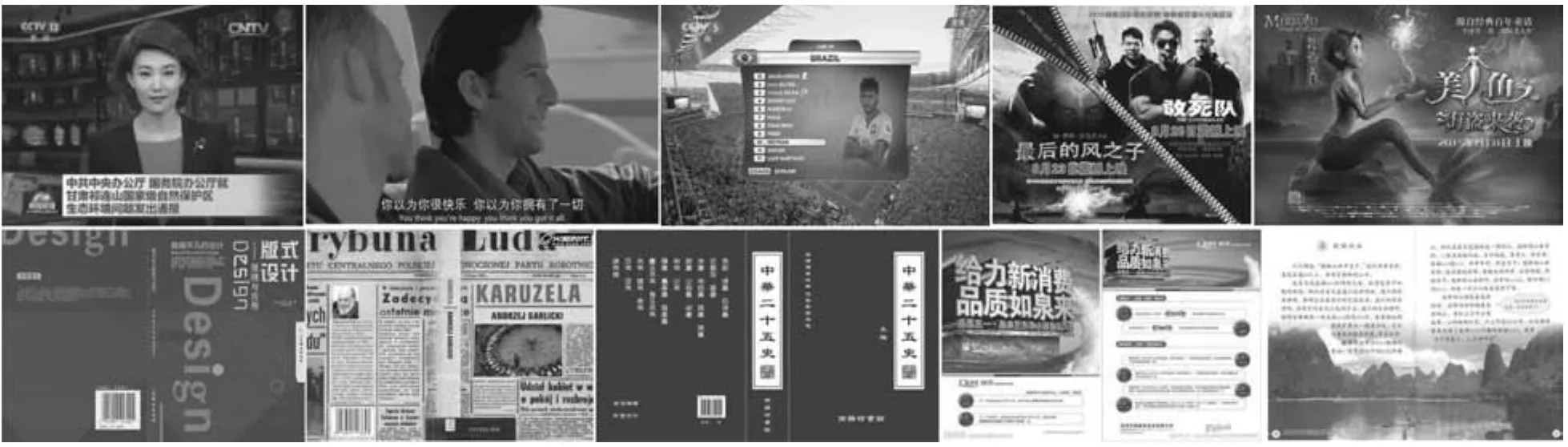

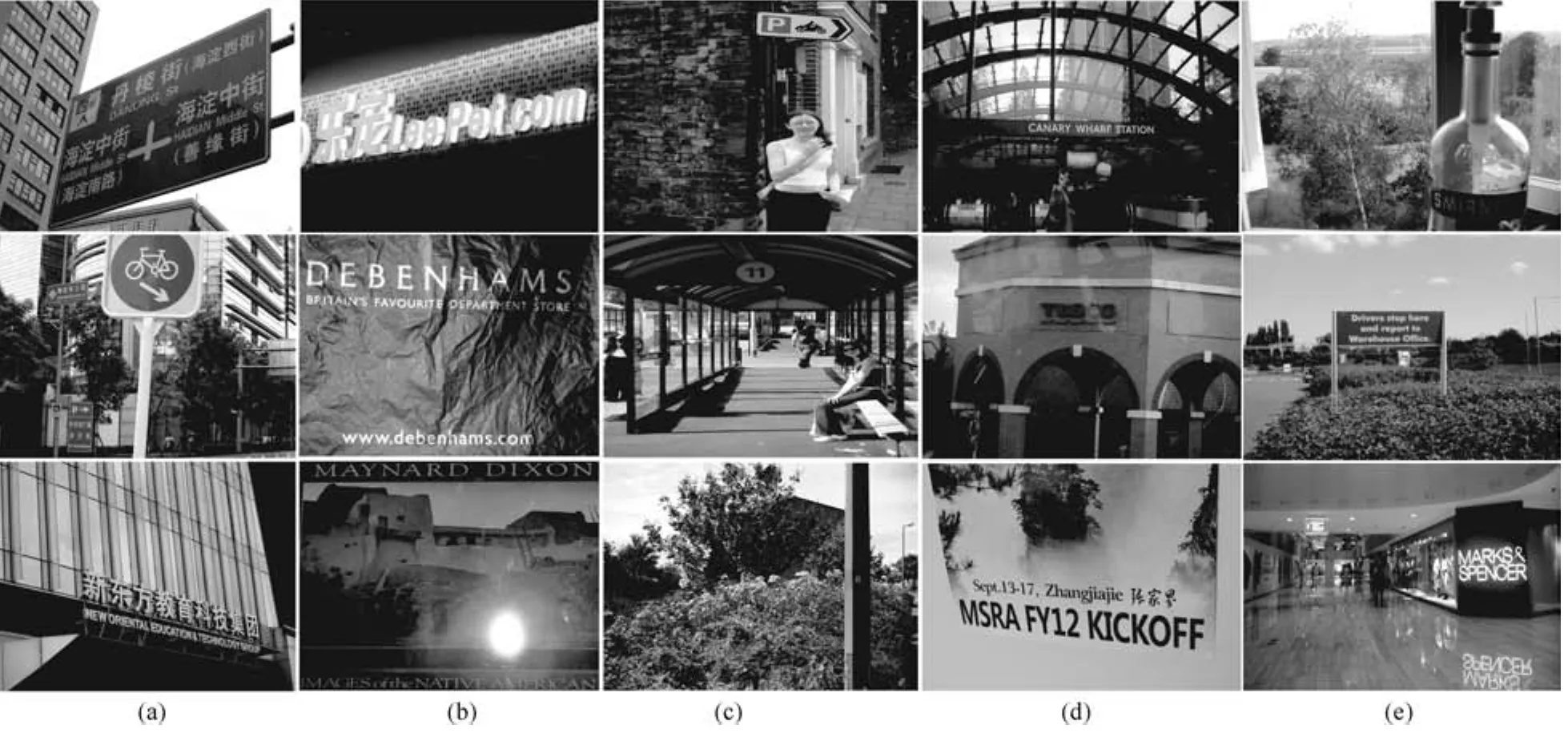

图像中的文本根据其形成方式可以划分为场景文本和叠加文本[52].叠加文本是人们为了某种目的而后期人为添加的注释性内容(比如新闻内容摘要、影视台词、体育赛况介绍等,如图1所示);场景文本作为固有的自然场景内容随机地存在于图像当中(比如道路指示牌、商品名称、广告牌等,如图2所示2示例图像源自ICDAR系列数据库以及MSRA-TD500数据库.).与叠加文本相比,自然场景文本在字体大小、类型、颜色、排列方向等方面具有更大的复杂性.自然场景文本区域的视觉特性主要体现在以下几个方面:

1)对比度属性:文本作为人类社会人际沟通的信息载体,可读性是自然场景文本具有存在意义的基本要求.自然场景文本相对其背景区域而言,其灰度、颜色信息往往具有较明显的对比度.

2)梯度、边缘属性:文本通常具有复杂的空间结构,因此文本区域往往存在相对密集的边缘以及较明显的梯度信息.

3)灰度、颜色属性:为了视觉上的舒适性,往往选择与背景有明显反差的颜色进行书写,且文本的颜色与灰度分布均匀.

4)笔画宽度属性:尽管文本由不同的笔画组成,但同一个文本中的笔画宽度近似相等.

5)几何大小属性:自然场景文本具有任意的尺寸大小,但为了满足人眼视觉要求,自然场景文本的尺寸通常满足一定的变化范围.

6)视觉上下文属性:在同一个文本行区域内,相邻文本之间具有笔画宽度、颜色、高度以及像素灰度值相近等特点.

7)空间分布属性:文本在图像中通常以文本行的形式存在,相邻文本之间的排列方式是任意的,其间隔距离通常满足一定的规律.

图1 叠加文本示例Fig.1 Examples of overlay text

图2 自然场景文本示例Fig.2 Examples of natural scene text

4 自然场景文本检测所面临的挑战

除了受到复杂背景、光照变化、拍摄视角等外界因素影响外,相比一般性物体检测问题,自然场景文本检测技术还面临着自身特征的诸多挑战.

1)从文本的种类来看:自然场景文本包含了不同的语种,每一种语种包含了数量规模不等的文本类型,比如英文包括了52个大、小写字母,而中文汉字所包含的文本类别则更多,仅1980年制定的国标GB2312-80编码就定义了多达6763类常用汉字,不同语种或者相同语种的不同文本类型之间的视觉特征具有很大的差异.

2)从文本排列方向来看:相邻自然场景文本之间的排列是沿任意方向的,从而导致很难找到合适的描述特征与边界框来表示文本区域.

3)从文本行的组成来看:自然场景文本行通常由不同类别的文本所构成,尽管每一种文本具有固定的空间结构,但是将不同类别的文本组合成文本行时就会呈现出杂乱的视觉特征.正因为不同文本行之间的结构共性很少,所以我们很难找到一个区分性好的描述特征来表达文本行区域.

4)从文本行的大小及长宽比来看:文本行大小不一,且其长度与宽度的比值也不确定.对文本行进行检测时,我们不仅需要考虑尺度大小问题,而且还需要考虑文本行长宽比问题,从而大大增加了文本行检测的难度.

5)从文本行检测结果来看:文本行检测通常需要检测一个文本序列.根据算法性能评测要求(比如ICDAR竞赛测评标准),所有的自然场景文本检测算法需要得到以单词为单元的检测结果,而不同单词包括的字符数有所不同,单词之间的间隔距离也会经常受到单个文本检测结果的影响,因此自然场景文本检测较传统的独立目标检测更具挑战性.

5 自然场景文本检测方法

20世纪90年代中期,文献[27−29]等率先开展了自然场景文本检测研究.经过20余年的发展,该领域涌现出大量行之有效的解决方法.特别是近年来目标检测技术与语义分割技术的快速发展使得文本检测领域取得了重大的突破.依据文本检测技术的发展历程及文本区域描述特征分类标准,自然场景文本检测方法大体上可以归纳为:1)传统的自然场景文本检测方法;2)基于深度学习的自然场景文本检测方法.

5.1 传统的自然场景文本检测方法

传统的自然场景文本检测方法主要沿用两条技术路线;基于连通域分析的方法和基于滑动检测窗的方法.该方法首先获得文本候选区域,然后采用传统手工设计的特征(Handcraft features)对所获得的候选区域进行验证,并最终获得文本位置信息.

5.1.1 基于连通域分析的方法

基于连通域分析的方法采用自底向上策略检测文本.从获得连通域的途径来看可以分为边缘检测方法和文本级检测方法,该类方法通常先检测得到单个文本,然后将相邻文本进行关联形成文本行.

1)边缘检测方法

考虑到自然场景文本具有丰富的边缘以及角点信息,该类方法主要通过检测边缘或者角点等方式来获得文本候选区域,然后对所获得的文本候选区域利用规则或者分类器进行分类.文献[38,53−57]等采用了一些边缘检测算子(如:Sobel,Canny等)检测出图像的边缘信息,然后对边缘图像进行形态学处理以剔除伪文本区域.文献[55]首先提取水平、垂直、左上、右上方向边缘图像,然后基于上述边缘图像采用K均值(K-means)聚类方法获得初始的文本区域检测结果,最后对初始的检测结果采用经验规则以及投影分析来进行验证.文献[38]采用K均值聚类方法对傅里叶–拉普拉斯滤波处理后的图像像素进行分类从而获得文本连通区域,通过对各个连通区域的骨架进行分析,将连通区域分为“简单”和“复杂”两类,保留简单的连通区域并对复杂的连通区域进行进一步分析,最后根据文本行平直度以及边缘密度等特征对文本候选区域进行判断以去除背景区域.文献[57]首先提取边缘,然后通过候选边缘重组以及识别的方法获得文本区域.Busta等在文献[53]中通过定制Fast角点使其更有利于场景文本检测,根据文献[53]报道的结果,该方法所获得的场景文本检测召回率(Recall)较传统MSER方法高25%,且速度是传统MSER方法的4倍以上.除此以外,Jiri Matas课题组还参与推出了COCO-Text自然场景文本数据集[58].

2)文本级检测方法

该类方法利用自然场景文本通常具有像素灰度值近似相等、颜色近似相同以及笔画宽度相近等特点,对自然场景图像进行特定处理后,文本中的相邻像素在其空间结构上表现出连通性,该类方法通过检测图像中的连通区域来获得文本候选区域.为了获得文本连通区域,该类方法采取了许多行之有效的手段,比如极值区域(Extremal regions,ERs)[47,49,59]、最大稳定极值区域(Maximally stable extremal regions,MSER)[18,60−64]、颜色对比度增强极值区域(Color-enhanced contrasting extremal region,CER)[47,65]、颜色聚类方法(Color clustering)[66−68]、笔画宽度变换(Stroke width transform,SWT)[34,69−71]、笔画特征变换(Stroke feature transform,SFT)[72]、级联空间变换[43]、图割二值化[35,73−74]、手工阈值分割[75]等.在文本级检测方法中,首先将图像分割成若干个连通区域,然后对每一个连通区域的几何特征进行分析,利用文本候选区域的边缘密度[38]、前景像素密度[18]、长宽比[34]、文本候选区域紧致度[13]、轮廓梯度[13]、笔画宽度变化率[18,34]、平均方向偏差[76]等特征通过设定判断规则,或者提取文本区域的描述特征并结合已训练好的分类器对其进行判断,从而将之分类为文本区域与背景区域.

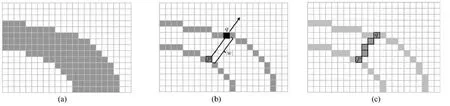

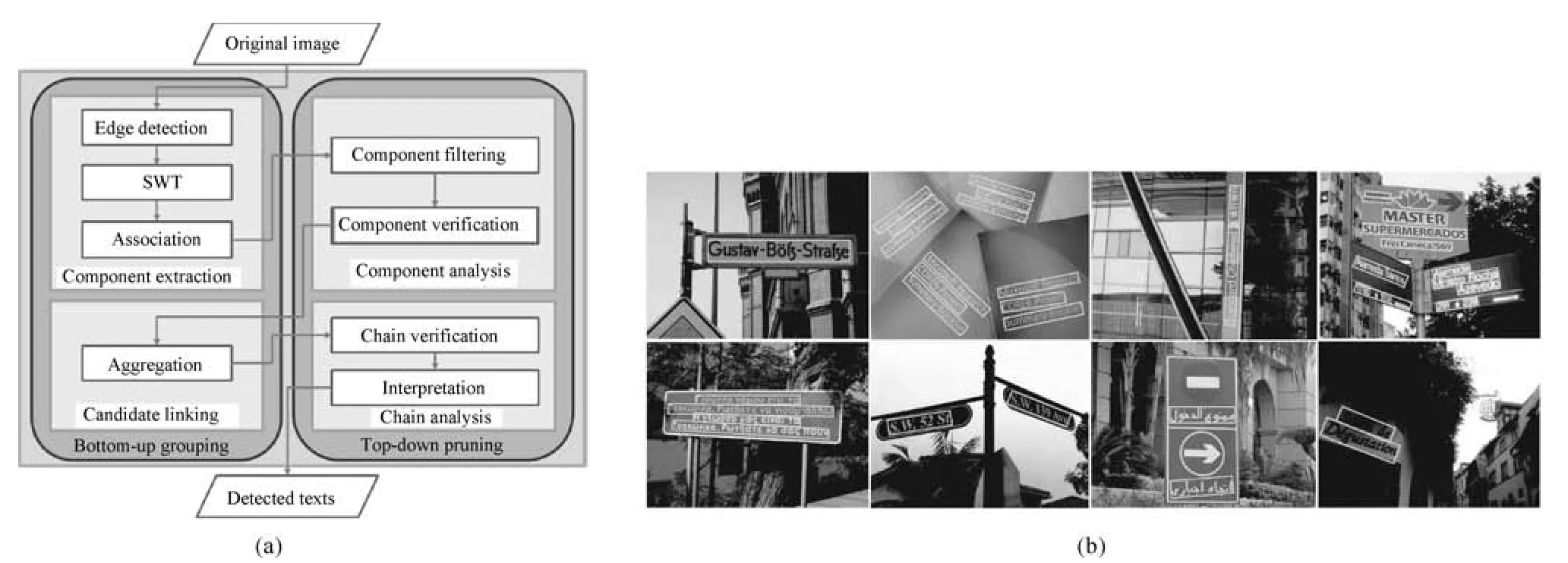

图3 基于笔画宽度变换的自然场景文本检测[34]Fig.3 Natural scenes text detection based on stroke width transformation[34]

图4 任意方向文本检测方法[39]Fig.4 Detecting texts of arbitrary orientations in natural images[39]

在文本级检测方法中,最为代表性的方法主要包括:笔画宽度变换(SWT)[34]、最大稳定极值区域(MSER)[60]等.笔画宽度变换算法由Epshtein等[34]于2010年首次提出(如图3所示),该方法主要利用了位于同一个文本中的笔画具有宽度近似相等的性质来获取文本候选区域.在实施笔画宽度变换的过程中,首先利用Canny算子对输入图像进行边缘检测,并计算边缘像素点的梯度方向,沿着梯度方向的路线寻找与之匹配的像素.匹配像素p与q之间搜索路线上的每一个像素值被指定为上述两个像素之间的笔画宽度(即像素点p与像素点q之间的欧氏距离).对于某个像素而言,若其属于多个搜索线路,则其像素值为上述搜索线路对应的最小笔画宽度值.文献[39]采用图4所示的检测框架,较早地实现了任意方向排列的自然场景文本检测任务.该文献通过笔画宽度变换(SWT)处理获得文本候选区域,用文本级分类器(简单特征+随机森林)过滤非文本区域;利用文本间的相似性连接成文本行,再用文本行级的分类器(简单特征+随机森林)进一步过滤背景区域.采用笔画宽度变换(SWT)处理可以提取出不同尺度和方向的文本候选区域,然而该方法在图像边缘检测不准确以及背景复杂的情况下鲁棒性较差,此外,笔画宽度变换的运算效率也受到图像边缘像素数目的影响.针对笔画宽度变换方法的一些不足,在后续研究[70,72]中也出现了一些笔画宽度变换的变体,比如文献[72]考虑到传统的笔画宽度变换方法在应对图像中包含一些具有不规则梯度方向的边缘时往往不能准确地计算出笔画宽度,该文献利用了颜色信息来改进笔画宽度算子并提出了笔画特征变换(Stroke feature transform)算子.最大稳定极值区域(MSER)基于分水岭的概念,该方法取[0,255]范围的阈值对图像进行二值化处理,所获得的二值化图像经历了一个从全黑到全白的过程(犹如水位不断上升的俯瞰图).在此过程中,有些连通区域面积随阈值上升的变化很小,定义该类区域为最大稳定极值区域(MSER).根据MSER的工作原理,检测得到的MSER内部灰度值是小于边界的,因此通过MSER方法检测不到位于黑色背景中的白色区域.在实际处理的过程中,通常需要对原图进行一次MSER检测后将其反转,然后再做一次MSER检测,上述两次操作分别称MSER+ 和MSER−.Neumann等[60]提出将MSER方法应用于自然场景文本检测(如图5所示),通过对图像中的一些最大稳定极值区域的检测来获得文本候选区域.最大稳定极值区域能够很好地描述文本内部颜色的一致性,且可以克服噪声和仿射变换等因素的影响.一些文献[18,62−64]采用MSER方法在复杂的自然场景图像上取得了优异的文本检测性能.此后,在文献[60]的基础上,最大稳定极值区域的一些变体[20,47,77−80]相继被提出,比如文献[20,80]利用梯度信息来增强MSER,并提出了Edge-preserving MSER算子.文献[81]采用局部自适应阈值方法来增强MSER.考虑到MSER在处理“低对比度”图像时不够鲁棒,Neumann等在文献[59]中提出直接用极值区域(ER)来作为文本候选区域,并设计了一套能够快速去除明显非文本区域的方法.Sun等考虑到文献[59]所获得的极值区域的数量过大,进而对后续的文本分类精度产生影响,因此在文献[82]中提出了对比极值区域(Contrasting extremal region,CER)方法.文献[82]所得到的CER是跟周围的背景有一定对比度的极值区域,其数量远小于极值区域(ER),略多于最大稳定极值区域(MSER),CER应对“低对比度”图像更为鲁棒.此后,Sun等在文献[83]中又提出了颜色增强的对比极值区域(Color-enhanced CER).

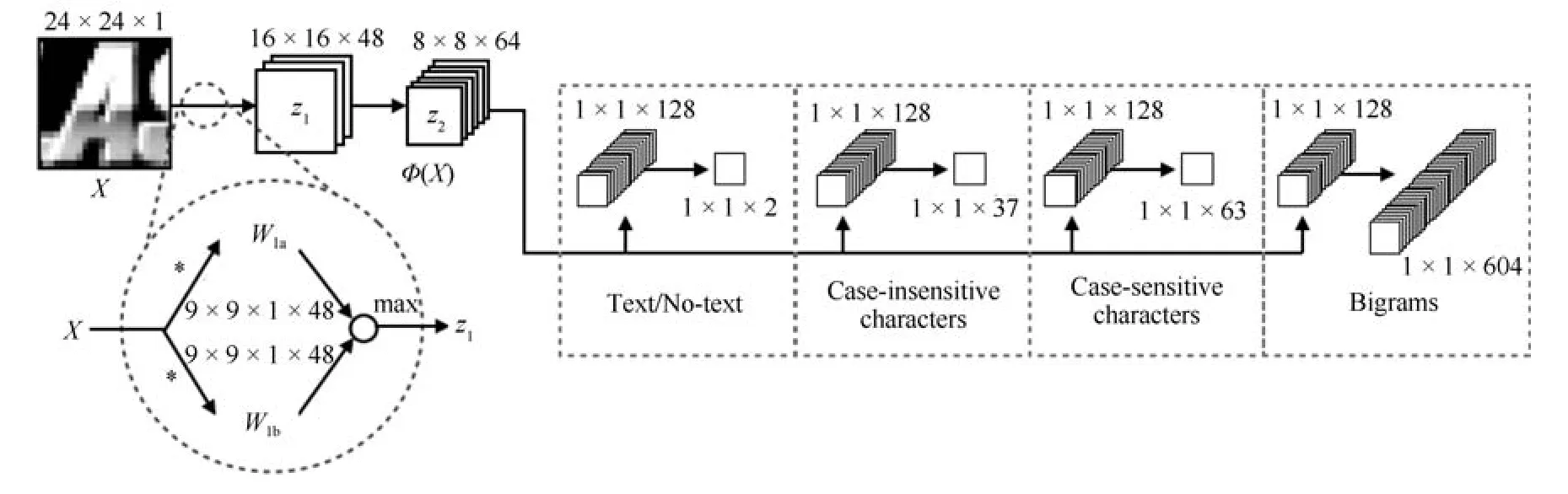

值得注意的是,区别于前述边缘检测方法以及文本级检测方法.一些文献[84−87]利用文本行上下边缘近似平行或者文本行的上下部分近似对称的性质,实现对文本行候选区域的检测处理,该类文本行级检测方法主要应用于印刷体/手写文档中的文本处理[84−86].文献[87]利用了自然场景文本行上下结构相似的特点,创新性地实现对场景文本的有效检测.文献[87]设计了一个具有对称性的模板(如图6(g)所示),通过该模板获得文本区域的自相似度与区分度,即:上半部和下半部的对称性、文本区域的上半部与背景的差异、文本区域的下半部与背景的差异等特征.该模板在不同尺度下扫描图像,通过其响应得到对称的中心点,在得到对称中心点后通过文本的高度和连通性得到候选区域.与传统的文本检测方法所采用的手工设计的特征所不同的是,文献[87]使用了卷积神经网络(CNN)进行后续处理.文本行级检测方法能有效地减少单个文本检测失误所带来的负面影响,但该方法对文本行的边缘检测结果以及边缘对称性较为敏感.

基于连通域分析的自然场景文本检测方法主要通过提取图像中的连通区域来获得文本候选区域,从而能有效地减少自然场景文本的搜索范围.该类方法依赖于文本连通区域的检测结果,连通区域的检测结果不仅影响文本检测召回率,而且还会影响文本轮廓的准确性.文本欠分割、过分割的处理结果将势必影响该文本候选区域的准确性,进而对整个自然场景文本检测结果产生负面影响,因此在保证文本连通区域检测高召回率的情况下,获得准确的文本轮廓是提高文本检测性能的重要途径.事实上,在复杂的自然场景图像中准确地检测出文本连通区域是一件非常困难的事情,光照变化、颜色褪色、噪声干扰等因素都将可能导致相邻文本出现粘连现象,从而极大地影响文本检测系统的性能.与此同时,对每一个作为文本候选区域的连通区域进行验证时,设计一个合理的连通区域分析器也是一件非常困难的事情.受上述因素的影响,基于连通区域分析的自然场景文本检测方法在背景复杂、噪声干扰、低对比度以及颜色多变等情况下难以鲁棒地检测自然场景文本.

5.1.2 基于滑动检测窗的方法

图5 基于最大稳定极值区域的自然场景文本检测[18]Fig.5 Natural scenes text detection based on maximally stable extremal regions[18]

图6 基于对称性的自然场景文本行检测[87]Fig.6 Symmetry-based text line detection in natural scenes[87]

基于滑动检测窗的方法采用了自顶向下策略检测文本,该类方法[88−92]通过采用滑动检测窗口的方式对整幅自然场景图像进行扫描,将每一个检测窗口所覆盖的图像区域视为文本候选区域,然后提取文本候选区域的手工设计的特征,结合已训练好的分类器获得该文本候选区域的置信度值,通过将所获得的文本候选区域的置信度值与所设定的置信度阈值进行比较,将文本候选区域分类为文本区域或者背景区域.为了有效地应对文本大小、文本行长度多变的情况,该类方法采用了多尺度滑动窗口的方式来得到文本候选区域.基于滑动检测窗的自然场景文本检测方法主要采用了二种技术途径:1)一般性滑窗方法;2)基于特定单词的方法.

自然场景文本检测属于一种特定目标检测,级联自适应增强算法(Cascaded adaboost)结合类哈尔(Haar-like)特征在人脸检测[93−95]领域获得了巨大成功,该技术方案为自然场景文本检测提供一种解决思路,比如文献[89,96−98]采用了Adaboost方法检测自然场景文本.文献[97]采用级联Adaboost方式从一组特征池中选择79个特征并训练得到4个强分类器.此后,在文献[96]中,他们进一步将文献[97]中的特征提取方法扩充至6种,即X−Y方向梯度信息、Gabor滤波器的局部能量、图像纹理的统计直方图、图像小波变换系数的方差、边缘间距以及连通区域分析等,进而使得检测性能得到了较大幅度的改善.然而值得注意的是,文献[93−95]之所以能够快速地实现人脸检测,主要依赖于其采用的两个关键技术:1)构建了一种有效的级联检测框架;2)使用了一种计算高效且对人脸分类性能好的类哈尔(Haar-like)特征.然而自然场景文本与人脸的视觉特性存在着较大的差异,文献[93−95]中所采用的类哈尔(Haar-like)特征虽然能很好地反映人脸特征,然而上述特征在描述文本区域时却表现差强人意.文献[88]提出一种基于特定单词的自然场景文本检测方法.该方法首先通过滑动检测窗口的方式获得单个的文本,然后根据相邻文本之间的结构关系对可能的组合进行评分,最后从给定的列表中选出最相近的组合作为输出结果.区别于前述一般性的基于滑动检测窗的方法,该方法只能检测事先给定列表中的单词,对于列表之外的单词则无能为力.然而,在现实中不可能为每一幅图像指定一个包含所有可能出现的单词列表,从而使得该方法的适用范围受到一定程度的限制.

基于滑动检测窗的自然场景文本检测方法的一个关键问题就是如何找到区分度好的描述特征来区分文本区域与背景区域.传统的自然场景文本检测技术主要选择了手工设计的特征,比如:梯度边缘特征[99]、局部二值模式(Local binary patterns,LBP)[100−101]、边缘局部二值模式(Edge local binary patern,eLBP)[102]、方向梯度直方图(Histograms of oriented gradients,HOG)[90,103−104]、共生方向梯度直方图(Co-occurrence histogram of oriented gradients,CoHOG)[105−106]、基于方向梯度直方图的纹理特征(HOG-based texture descriptor,T-HOG)[107]、边缘方向梯度直方图(Histogram of gradients at edges,eHOG)[20]、小波变换特征[17,108−109]、离散小波变换特征[101]等.相应地,为了分类文本区域与背景区域,一些监督学习方法广泛地应用于自然场景文本检测领域,比如支持向量机 (Support vector machine,SVM)[17,101,110−114]、自适应增强算法 (Adaptive boosting,Adaboost)[98,115−116]、随机森林 (Random forest,RF)[104,117−119]、以及人工神经网络(Artificial neural network,ANN)[120]等.大部分基于滑动检测窗的文本检测方法利用了文本候选区域的全局特征,而文献[121]则从文本的局部特征出发,提出了一种基于文本部件的树形结构模型(Partbased tree-structured models),该算法[121]能较好地适应文本的字体变化,对噪声、模糊等干扰因素也相对不敏感.然而该模型依赖于详细的标注信息,对不同语种文本的适应性也非常有限,不能直接推广到新的语种文本.若要处理新的语种文本,则需要重新设计字符模板以及标注文本部件.

基于滑动检测窗的自然场景文本检测方法无需通过提取文本边缘、角点、连通区域或者文本行边缘等方式来获得文本/文本行候选区域,该类方法在处理文本尺度较小或者对比度欠佳等情况具有较大的优势,能有效地避免相邻文本间的粘连现象对文本候选区域提取的影响.与此同时,该类方法通常采用了区分性能好的手工设计的特征来区分文本区域与背景区域,因此能较好地应对复杂自然场景中的文本检测问题.考虑到自然场景图像中的文本区域通常由单个文本或者由多个文本构成,除了文本位置随机分布以及相邻文本间隔距离多样化外,文本大小尺寸以及文本区域的长宽比也存在着多个自由度,此外,文本行的排列方向通常比较随意,有横行、竖行、斜行、甚至是弯曲的,这对检测窗口的选取带来了很大的难度.与此同时,检测窗口的滑动步长的选取也是一个棘手的问题,上述参数若设置不恰当将导致相当部分的文本漏检、欠分割、过分割以及出现虚警(如图7所示),从而影响文本检测性能.基于滑动检测窗的自然场景文本检测方法采用多尺度滑动检测窗口的方式遍历整幅图像来获得文本候选区域.为了有效地区分文本区域与背景区域,一些复杂的手工设计的特征被大量使用,从而增加了描述特征的计算复杂度,进而导致了该类方法的检测效率通常不尽人意.除此以外,基于滑动检测窗的自然场景文本检测方法除了需要获得一个分类性能好的描述特征外,还对正、负训练样本的规模以及训练集的完备性提出了严格的要求.不少算法的训练不仅需要知道每张训练样本中是否包含文本,而且还需要知道每个文本所处的位置.为了应对单文本与多文本情形,还需要建立单文本训练样本、多文本训练样本.与此同时,为了获得良好的学习效果,需要大量贴近真实场景的样本进行训练,增加了标注工作量与训练时间.尽管基于滑动检测窗口的方法在其他类型物体检测问题上取得了很好的结果,但从ICDAR 2011[122]以及ICDAR 2013[123]的“Robust Reading Competition Challenge 2” 的竞赛结果来看,该类方法尚逊于基于连通区域分析的方法,近几年基于滑动窗口的方法并没有成为文本检测算法的主流.

5.2 基于深度学习的自然场景文本检测方法

局限于手工设计的特征分类能力的不足,文本检测性能在较长的一段时间内难以取得较大突破,直至有了深度学习技术之后.深度学习作为神经网络模型的新发展[124],它模拟了人脑认识事物机理.与传统的浅层人工神经网络相比,深度学习含有多隐藏层的神经网络结构.区别于传统的“手工设计的特征提取+分类器”的目标识别框架,深度学习网络通过组合低层特征形成更加抽象的高层来表示属性类别,使计算机自动学习数据的有效特征表示,应用深度学习有一个很大的优势是可以避免繁琐低效的人工特征工程.深度学习通过对训练样本进行学习以自动地获取描述特征[125]的方式,特别适合于物体识别与语音识别等模式识别问题.典型的深度学习结构包括:深度置信网络(Deep belief network,DBN)[125−126]、卷积神经网络 (Convolutional neural network,CNN)[127]以及递归神经网络(Recurrent neural network,RNN)[128]等.

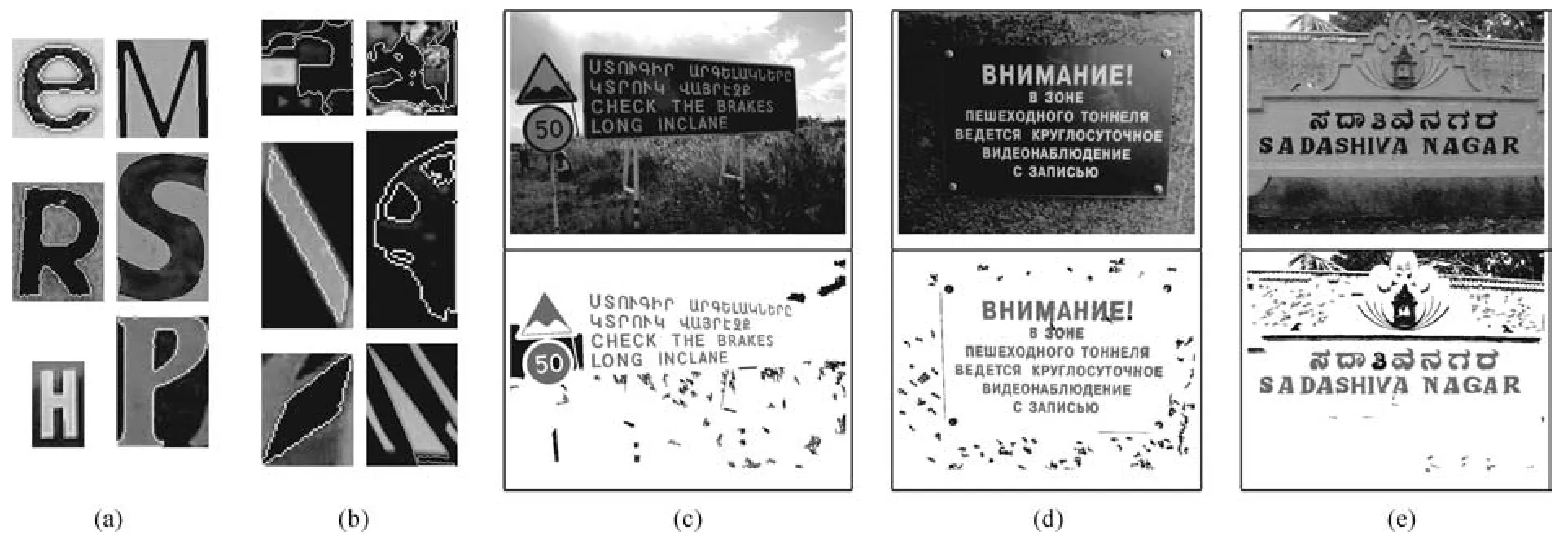

深度学习(如CNN/LSTM 等模型)在文本识别领域的应用有着较长的历史.上世纪90年代,深度学习的先驱者Lecun很早就用神经网络来解决文本识别,1998年,Lecun等合作设计了LeNet5模型[127],在MNIST数据集上的识别率高达99.1%;在加上变形样本训练后,其识别率进一步提升到99.2%.2003年微软研究院Simard等[129]引入弹性变形(Elastic distortion)及仿射变形(Affine distortion)两种数据增广(Data argumentation)技术,采用类似CNN的网络结构,在MNIST数据集上将识别率提升至99.6%,从而有效地解决了手写数字识别问题.牛津大学VGG组的Jaderberg等[48]较早地提出将深度学习方法运用于自然场景文本检测与识别领域,他们在2014年利用深度卷积神经网络构建了如图8所示的自然场景文本识别框架.在第一阶段,学习一个不区分大小写的CNN文本分类器;在第二阶段,根据需要将结果特征映射应用于其他分类问题,比如文本/背景分类器,区分大小写的文本分类器以及二元分类器等.

图7 基于自顶向下策略文本区域的错误提取结果[90]Fig.7 Error extraction result of text region based on top-down strategy[90]

图8 基于卷积神经网络的特征学习[48]Fig.8 Feature learning using a convolutional neural network[48]

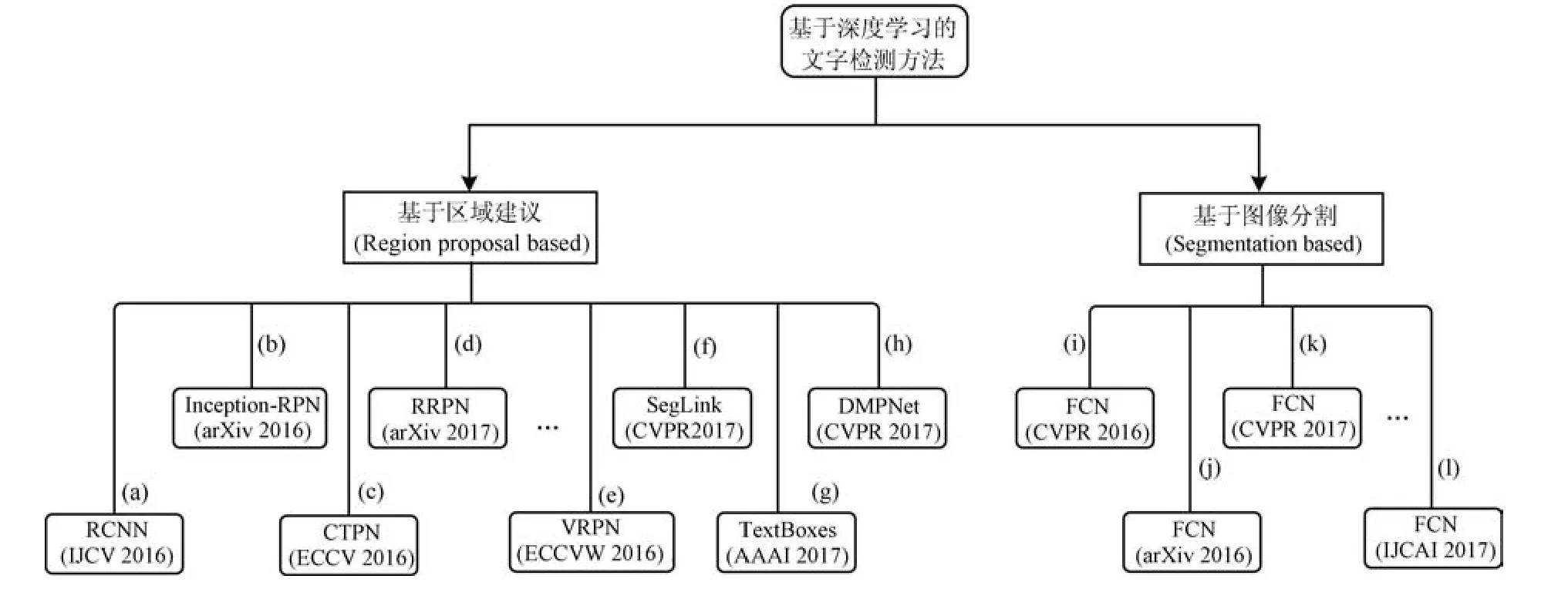

目前已涌现出大量的基于深度学习的自然场景文本检测方法[12,19,31,33,37,41,45−49],这些方法通过深度学习获得文本特征,并依据上述特征对自然场景文本进行检测.相比以前所使用的传统手工设计的特征,该类方法取得了更加令人鼓舞的检测结果.从检测文本对象的排列方向这一角度来看,基于深度学习的文本检测方法先后经历了水平方向排列的文本检测[31,130]、任意方向排列的文本检测[15,33,50,131−134]以及目前少数文献[135−136]所涉及的弧形排列方向的文本检测.在基于深度学习的自然场景文本检测方法中,基于文本区域建议(Text region proposal)的方法使用最为广泛,其次是基于图像分割的方法.主要的深度学习文本检测路线与一些代表性方法如图9所示.

5.2.1 基于区域建议的文本检测方法

图9 主要的深度学习文本检测路线与一些代表性方法((a)文献[137]方法,该方法采用CNN与ACF提取文本候选区域;(b)文献[130]方法,该方法对faster RCNN进行改进,并提出Inception-RPN方式提取文本候选区域;(c)文献[37]方法,该方法提出了Connectionist text proposal network检测文本候选区域;(d)文献[138]方法,该方法提出旋转区域候选网络(RRPN);(e)文献[139]方法,该方法提出了垂直回归建议网络(VRPN);(f)文献[33]方法,该方法采用Segment linking方式解决多方向排列的文本检测问题;(g)文献[31]方法,该方法以SSD作为基础框架,提出了一个端对端训练文本检测器(TextBoxes);(h)文献[15]方法,该方法创新性提出采用四边形窗口(非矩形)的方式检测任意方向排列的文本;(i)文献[41]方法,该方法提出采用Text-block全卷积网络获得文本候选区域;(j)文献[140]方法,该方法采用FCN综合多信息属性来获得文本候选区域;(k)文献[50]方法,该方法参考了DenseBox的架构,采用FCN网络检测任意方向排列的文本;(l)文献[141]方法,该方法采用深度卷积神经网络(DCNN)来学习文本的高级视觉表示+循环神经网络(RNN)处理文本序列.)Fig.9 The main deep learning text detection framework and some representative methods((a)method[137],the CNN and the ACF are integrated to obtain the text region proposal.(b)method[130],the inception-RPN has been proposed in this work.(c)method[37],the connectionist text proposal network has been proposed in this work.(d)method[138],the RRPN has been proposed in this work.(e)method[139],the VRPN has been proposed in this work.(f)method[33],the segment and linking has been proposed in this work.(g)method[31],the TextBoxes method has been proposed in this work.(h)method[15],the deep matching prior network(DMPNet)with tighter quadrangle has been proposed in this work.(i)method[41],the text-block FCN has been proposed in this work.(j)method[140],the FCN and multi-channel prediction method has been proposed in this work.(k)method[50],the DenseBox framework has been followed and the FCN has been proposed in this work.(l)method[141],the DCNN and the RNN has been adopted in this work.)

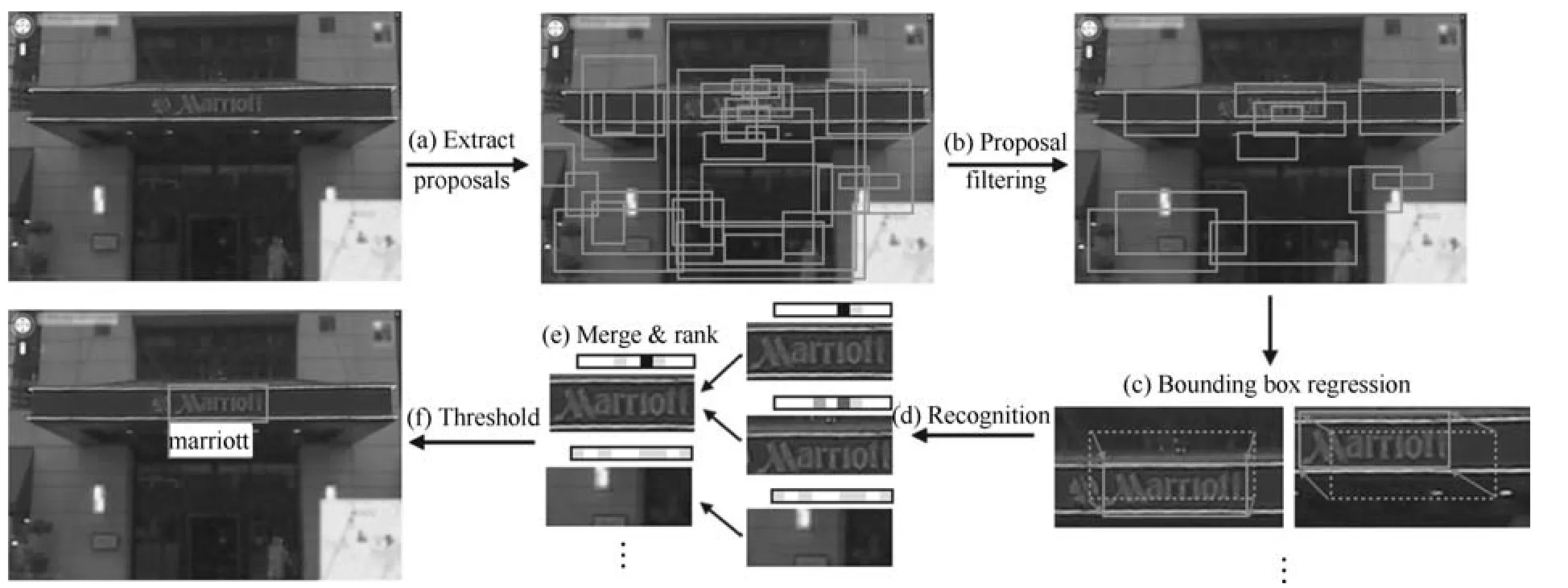

基于区域建议的文本检测方法遵循一般目标检测的框架,通常采用回归文本框的方式来获得文本区域信息.文献[119]提出了分层文本检测策略,该方法首先采用CNN提取特征,从所获得的最大稳定极值区域中获得种子文本并依据种子文本来定位其他退化的文本区域,然后采用随机森林结合文本行的上下文信息精细地分类文本候选区域.文献[130]对Faster RCNN进行改进,提出采用Inception-RPN方式获得文本候选区域,然后利用一个文本检测网络去除背景区域,最后对重叠的检测结果进行投票来获得最优的检测结果.文献[37]首次将RNN引入到场景文本检测当中,使用CNN得到深度特征,然后用固定宽度的Anchor来检测文本建议区域(Text proposal),将同一行Anchor对应的特征输入到RNN中进行分类,最后将正确的文本建议区域进行合并,该方法得益于使用子块(Block、Anchor)对文本进行表示,因此在一定程度上也能解决文本方向变化的问题.文献[12]针对单词的分类问题,将CNN与RNN进行联合训练,首先,采用标准CNN提取图像特征,并利用Map-to-sequence表示成特征向量;然后,使用双向LSTM(BLSTM)学习场景文本的空间上下文信息;最后,对特征进行编码并得到最终的预测结果,该方法将检测和识别模型结合之后得到了目前端到端模型中最好的文本检测结果.文献[33]通过加入方向信息使得SSD(Single shot detector)检测器可以应对任意方向排列的文本检测问题.该方法多尺度预测文本片段及其连接关系,将文本信息转换为两个局部可检测信息,即:文本级或者单词级的Segments以及Segments之间的Links.其创新之处在于把这些Links加入到网络中去学习,从而使得网络自动学习出哪些Segments属于同一个文本行(或者单词).文献[137]较早地开展了端到端(End-to-end)场景文本识别研究,该方法针对文本检测问题对R-CNN进行了改造,其工作内容主要分为二个部分:基于目标候选区域(Region proposal)的文本检测部分以及基于卷积神经网络(CNN)的文本识别部分.该方法获得了很好的场景文本识别效果,并且在其后两年内一直保持领先地位.文献[79]除了提出对比度增强的最大稳定极值方法(Contrast-enhancement maximally stable extremal regions,CE-MSERs)来提高文本检测召回率外,还提出了基于多任务学习的文本注意卷积神经网络(Text-attentional convolutional neural network,text-CNN)模型,该方法将底层像素级分割、高层的文本识别以及文本与背景分类融合到一个text-CNN模型中,从而获得了较强的文本检测器.传统的文本检测系统通常包含了多个处理流程,各处理环节的性能均将直接影响到最终的检测结果,文献[15]提出了一种深度匹配先验网络(Deep matching prior network,DMPNet),该方法考虑到原来的方法都专注于用矩形框来对文本进行定位,然而实际上自然场景图像中的文本图像可能存在透视变换等问题,从而导致图像中的文本区域并不是严格地呈现为矩形,若继续采用矩形框来定位将出现错误的结果,文献[15]创新性地提出采用四边形窗口(非矩形)来表示文本区域.文献[31]提出了Textboxes文本检测方法,该方法对SSD框架进行了改进,其目的能实现快速地计算文本在每个区域存在的可能性,文献[31]发现长条形的卷积核比常用的1×1或3×3卷积核更适合自然场景文本检测,该方法在设计默认框(Default box)时考虑了包含较长的形状,提出了一个实用的“检测+识别”框架对文本候选区域进行判断.其后,Liao等在文献[131]中对他们的前期工作[31]进行了改进,提出了Textboxes++文本检测方法,与前期工作Textboxes方法相比,文献[131]除进一步修改网络结构以外,其主要贡献是将Textboxes水平排列文本检测器扩展为任意方向排列文本检测器.文献[139]提出了垂直回归建议网络(VRPN).为了生成具有文本方向角信息的倾斜候选框用于检测任意方向文本区域,文献[138]提出了旋转区域候选网络(Rotation region proposal networks,RRPN).考虑到传统的RoI池化层只能处理轴对齐的候选框,该文献还提出了旋转RoI(RRoI)池化层来调整RRPN生成的面向任意的候选框.文献[134]为了检测任意方向的文本,在R-CNN[142]构架的基础上提出了一种新的旋转区域CNN(R2CNN)方法.该文献使用RPN来生成轴对齐的包围不同方向的文本边界框,通过合并RPN生成的不同大小的每个轴对齐文本框的特征来分类文本与非文本区域;文献[143]针对端对端文本识别问题提出了一个统一的网络结构模型,该模型主要包含了一个文本建议网络(Text proposal network,TPN)以及递归神经网络(Recurrent neural network,RNN),该模型可以直接通过一次前向计算就可以同时实现文本检测和文本识别任务.对该网络模型进行训练时,只需要输入图像、图像中文本的Bbox以及文本对应的标签信息.与此同时,文献[143]无需实施诸如文本行形成、单词分割等中间处理步骤,从而可以减少错误.文献[133]从实例感知语义分割(Instance-aware semantic segmentation)的角度提出了一种端对端训练框架(Fused text segmentation networks,FTSN)以应对多方向场景文本检测问题,该方法采用Resnet-101 backbone提取特征后利用区域建议网络(Region proposal network,RPN)同时检测与分割文本实例,通过非最大抑制方法(Non-maximum suppression,NMS)解决文本实例重叠的问题,最后生成适合每个文本实例区域的最小四边形边界框作为整终的检测结果.文献[144]为了应对任意方向的文本检测问题,创新性地设计RoIRotate算法将任意方向特征转换为轴对齐特征.近年来少数研究者基于深度学习方法对弧形排列方向的文本检测问题进行了研究.文献[136]提出了滑动线点回归(Sliding line point regression,SLPR)方法检测任意方向排列的文本(包括弧形排列方向文本),该方法首先采用区域建议网络(Region proposal network,RPN)生成包含文本的最小矩形框,然后分别沿着垂直方向和水平方向等距滑动线并回归文本的边缘点,最后基于这些点获得文本的轮廓.文献[135]提出了一种基于多边形的弧形文本检测算法(Curve text detector,CTD),此外该方法还提出了两个简单有效的后处理方法,即:非多边形抑制(NPS)和多边形非最大抑制(PNMS),以进一步提高文本检测精度.除此以外,文献[135]还推出了主要包含弧度方向排列文本的数据集(SCUT-CTW1500),该数据集共包含了1500张图片,其中1000张图像作为训练集,500张图片作为测试集,累积标注了约10000个文本区域.

5.2.2 基于图像分割的文本检测方法

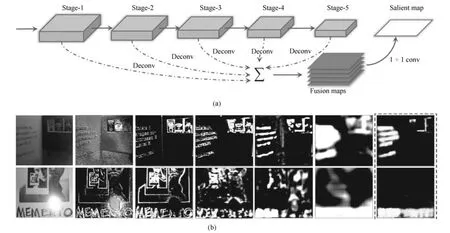

基于图像分割的文本检测方法[41,50,132,140−141]将文本检测视为一种广义的“分割问题”.该类方法通常利用语义分割中常用的全卷积网络(FCN)等方式来进行像素级别的文本/背景标注.文献[41]首次采用了全卷积网络(Fully convolutional network,FCN)从像素层面对图像进行处理,该方法首先利用Text-block FCN进行像素级的标定,从而获得每个像素属于文本的概率,进而得到文本区域显著图(Salient map),最后基于显著图得到文本候选区域(如图10所示).文献[145]提出了一种级联卷积文本网络(Cascaded convolutional text network,CCTN),该方法采用级联的方式检测文本,具体处理步骤主要包括:首先,采用一个Coarse-CNN进行检测得到粗略的文本区域,然后,对所获得的文本区域检测结果进行判断是否需要进一步处理(Refine),若需要,则采用Fine-CNN进行处理以得到更细致的文本线进行输出.文献[50]提出了一种基于全卷积神经网络(FCN)与非最大抑制算法(Nonmaximum suppression,NMS)的简单高效的文本检测框架,该方法首先通过全卷积神经网络输出文本区域像素级检测结果,然后将上述结果通过非最大抑制算法获得文本区域.文献[132]提出基于深度直接回归的多方向场景文本检测方法,该文献在其所提出的检测框架中对全卷积神经网络进行了端对端的优化并双任务输出,其中一个任务是对文本与非文本进行像素级分类,另一个任务则是采用该文献所提出的新贡献―直接回归的方式以确定四边形文本边界的顶点坐标.文献[141]中先采用深度卷积神经网络(DCNN)来学习文本的高级视觉表示,然后用循环神经网络(RNN)处理不规则文本(Irregular text)序列.为了获得文本候选区域,文献[141]采用了FCN网络来完成密集的文本检测任务.文献[140]方法基于全卷积网络,把“预测文本区域概率”、“预测字符概率”、“预测相邻字符连接概率”三个问题整合到一个网络中去进行整体学习以获得文本候选区域.

图10 基于全卷积神经网络的自然场景文本检测[41]((a)Text-Block全卷积神经网络结构;(b)Text-Block全卷积神经网络获得的结果)Fig.10 Natural scenes text detection based on fully convolutional networks[41]((a)The network architecture of the Text-Block FCN,(b)The illustration of feature maps generated by the Text-Block FCN)

绝大部分基于深度学习的文本检测方法主要包含了两个部分内容,即文本/非文本分类处理以及文本边界框回归处理,尽管文本边界框回归处理并不是必须的处理步骤,然而它对最终的检测结果产生重要影响.区别于绝大部分基于深度学习的文本检测方法,文献[146]直接通过实例分割处理来获得文本位置信息而无需进行文本边界框回归处理.受到SegLink[33]方法的启发,文献[146]所提出的PixelLink方法采用了一个深度神经网络(Deep neural network,DNN)来实现二种像素级预测,即文本/非文本预测以及连接预测,将所有文本实例中的像素进行标注并形成连通区域,最后从分割结果中直接提取文本边界框.文献[147]为了降低文本排列方向以及文本区域长宽比变化的影响,该方法首先检测文本角点,然后通过对角点进行采样和分组得到文本候选区域的边框,最后基于分割信息对所获得的文本候选区域的边框进行评价,并采用非极大抑制处理(NMS)来获得最终的检测结果.基于文本区域建议的文本检测方法[15,31,131,134]通常遵循一般目标检测的框架,采用回归文本框的方式来获得文本区域的位置信息,该类方法受到文本排列方向的任意性以及文本区域长宽比多样性的困扰.基于图像分割的文本检测方法[41,50,132,140−141]从另外的视角出发,视文本检测为一种广义的“分割问题”,可以较好地避免文本排列方向以及文本区域长宽比变化的影响,然而该类方法的后续处理通常比较的复杂.此外,由于目前绝大部分文本检测数据集的标注都是文本框类型,仅仅将文本标记在某一矩形区域内而没有详细地标注出哪些像素点是文本哪些是背景,因此基于图像分割的文本检测方法还面临着像素级别图像标注的困难.考虑到人工标注像素(Pixel)级别的标记(Label)代价很高,采用人工合成数据是一个值得尝试的替代手段.

为了获得较现有方法更优的检测结果,选择或者设计更有效的深度学习文本检测框架显得格外重要.仍然需要指出的是,尽管深度学习方法在基于大量训练样本的情况下获得了较传统的手工设计的特征更优的区分性能,但是自然场景文本检测系统通常包含了多个处理环节,任何环节的处理结果都将会影响整个系统的检测性能.深度学习方法虽然能很好地解决文本分类这一局部问题,然而较难有效地利用文本的上下文信息以及其他知识.虽然简单直接地应用深度学习技术可以达到还不错的检测结果,但依然有必要将深度学习方法与其他的领域知识或者技巧相结合来设计文本检测系统.此外,采用深度学习方法进行训练时,训练集的规模将对训练结果产生重要影响.训练样本规模小将容易导致训练过拟合,训练样本规模大则使得构建训练集及手工标注的工作量过大.为了构建大规模训练集,文献[137,141,148−149]等提出通过合成的方法生成含有文本信息的样本,进而为扩充训练集的规模提供了一种有效的解决途径.牛津大学VGG组的Jaderberg等除了在文献[149]中提出采用合成图(Synthetic image)的方式训练卷积神经网络(CNN)外,他们还在文献[148]中详细地介绍了如何通过合成的方法生成自然场景文本样本,文献[148]通过人工生成自然场景文本样本在ICDAR 2011数据集上获得了F-measure为82.3%的成绩.此外,文献[150]考虑到现有的真实文本数据集大多是在单词或文本行级别进行标注的,因此该文献提出了一个弱监督的框架,基于单词级训练数据库来训练文本检测器以解决文本训练数据集不足的难题.

6 端对端文本识别方法

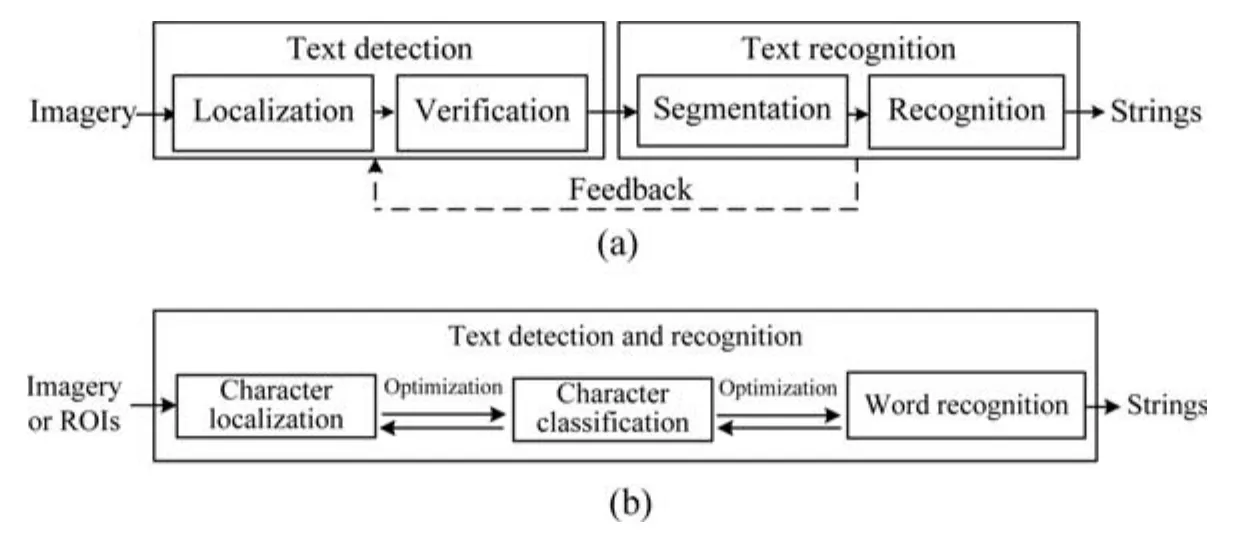

区别于单独的文本检测与单独的文本识别任务,端到端文本识别包含了从自然场景图像中检测和识别文本的完整过程(如图11所示).在端到端文本识别任务中,输入的是自然场景图像,输出结果为图像中的文本内容.从本质上来说,文本检测和文本识别同属于模式分类问题.文本检测的核心任务是区分图像中的文本和非文本成分,因此文本检测是一个粗略的二分类问题;而文本识别则需要在文本检测结果中进一步区分文本的所属类别,因此文本识别则需要完成更精细的分类任务.从针对自然场景文本检测与识别的研究内容来看,目前大部分工作将文本检测与文本识别作为两个独立的内容来展开研究,只有少数工作将文本检测与文本识别融合到一个框架中执行粗糙检测与精细化分类的两个任务,从而达到同时进行文本检测和文本识别的目的.相比单纯的文本检测与文本识别问题,端对端文本识别更加具有挑战性.从ICDAR 2015自然场景文本检测及识别竞赛[32]的结果来看:非受限环境下的自然场景文本(Incidental scene text)在无语料信息的真实环境下的端到端识别任务(Task 4.4)的最好识别率仅为34.96%,可见端对端文本识别技术具有很大的提升空间.

图11 端到端场景文本识别框架[22]Fig.11 Scene text end to end recognition framework[22]

文献[34,73,151−152]较早地提出了端对端文本识别系统,但这些系统主要关注文本检测部分,文本的识别则依赖于已有的光学字符识别引擎.文献[153]所提出的端对端文本识别系统则主要关注文本识别部分,其文本检测部分利用了文献[93,154]所提出的目标检测方法.与文献[34,73,151]方法不同,Wang等[91]和Neumann等[60]在他们所提出的端到端文本识别系统中并没有采用已有的光学字符识别软件,而是自主设计了自然场景文本识别方法.Wang等[91]将单词作为一种特殊的待检测目标,视字符为单词的组成部件,通过各个字符的置信度以及字符之间的空间约束关系搜索最可能的检测和识别结果.捷克理工大学Jiri Matas以及Neumann等[60]通过提取图像中的最大稳定极值区域作为文本候选区域,然后通过训练好的分类器剔除非文本区域,将余下的候选区域输入到字符识别模型屮进行识别.Neumann等在前期工作[60]的基础上,在文献[59]中提出一个实时的端到端场景文本检测和识别方法,其文本检测部分基于一种高效的序贯选择机制,从一个极值区域集合中挑选可能的文本区域,文本识别模型则由合成训练样本得到.需要指出的是,文献[59]是第一个在ICDAR 2011数据集上发布端对端文本识别结果报告的,该文献所述方法现已被OpenCV 3.0所采用.文献[34,59−60,91,151]只能处理水平方向或者接近水平方向排列的自然场景文本.考虑到上述方法的不足,华中科技大学研究团队Yao等在文献[76]中率先提出了一种可以处理自然场景中任意方向文本的端到端识别方法.该方法将文本检测和文本识别作为一个整体进行考虑,在统一的框架中利用相同的特征和分类结构同时完成检测和识别任务,此外该方法设计了一种基于字典搜索的纠错策略来提高文本识别准确性.

图12 基于卷积神经网络的端对端自然场景文本识别方法[137]Fig.12 Feature learning using a convolutional neural network[137]

由于传统手工设计的特征不能有效地区分文本区域,从而导致端对端文本识别性能在较长的一段时间里难以取得突破,直至2014年前后深度学习方法为端对端文本识别问题提供了全新的解决方案.在文献[48,137,143,148,155−156]等中设计了各种基于深度学习的端对端文本识别框架.牛津大学VGG组在2016年IJCV期刊的首卷首期发表了基于区域建议(Region proposal)的方法[137],该方法在端到端文本识别领域保持了近两年的领先地位.文献[137]从两个方面展开对端到端(Endto-end)场景文本识别的研究(如图12所示),即:基于目标区域建议(Region proposal)的文本检测部分以及基于卷积神经网络的文本识别部分.Shi等在文献[12]中针对图像中的序列物体的识别问题提出了Convolutional recurrent neural network(CRNN)端对端检测框架.针对单词的分类问题,该方法首先采用标准CNN提取图像特征并利用Map-to-sequence表示成特征向量,然后使用双向LSTM(BLSTM)学习场景文本的空间上下文信息,最后对特征进行编码并得到最终的预测结果,该方法得到了目前端到端模型中最好的文本检测结果.Alsharif等[157]采用了一种包含分割、矫正以及文本识别的CNN网络,结合使用固定词典的隐马尔科夫模型(HMM)来获得最终的识别结果.Liao等在文献[31]中对SSD框架进行了改进,针对水平方向排列的文本提出了一种“Textboxes”+“CRNN”的端对端识别框架,其中Textboxes用来实现文本检测,CRNN则用来进行文本识别;最近,Liao等在文献[131]中对其前期工作[31]进行了改进,提出了一种“Textboxes++”+“CRNN”的端对端的文本识别框架,文献[131]的主要贡献是将其前期工作Textboxes[31]进行了扩展,在其所提方法中设计了Textboxes++文本检测方法以应对任意方向排列的文本的检测问题.文献[158]借鉴人类阅读文本的认知机制,提出了一种基于卷积特征映射的端对端场景文本识别方法.该方法首先采用滑动检测窗口的方式对输入图像进行扫描,并将输入图像按照检测窗口大小切割出来,然后获得所有切割后图片的特征向量,由时序分类算法(Connectionist temporal classification,CTC)预测得到最终的识别结果.该方法表现出一些优势,比如避免了复杂的字符分割过程以及可以识别基于单词方法所不能识别的文本.文献[144]提出了一种任意方向排列文本识别方法(Fast oriented text spotting system,FOTS),该方法考虑到提取特征是一个较耗时的过程,为了加快系统的处理速度,该方法采用共享特征的方式同时实现文本检测与文本识别处理.为了应对文本排列方向的任意性,文献[144]设计了RoIRotate算法将任意方向特征转换为轴对齐特征.在文献[148]所提出的端对端文本识别方法中,首先训练了一个全卷积回归网络(Fully convolutional regression network,FCRN)以及文本位置回归的方式检测文本,然后通过文献[149]所采用的单词分类器(Word classifier)进行文本识别.Li等在文献[143]中提出了一种端对端文本识别网络结构模型,该模型主要包含了一个文本建议网络(Text proposal network,TPN)以及递归神经网络(Recurrent neural network,RNN),该模型可以直接通过一次前向计算就可以同时实现文本检测和文本识别任务.Patel等在文献[159]中提出了E2E-MLT多语言场景文本识别算法,该方法集成了多个卷积神经网络,有效地实现了自然场景文本检测、识别以及文种分类等任务.特别需要指出的是,文献[159]所提的E2E-MLT模型是迄今为止第一个面向多种语言的文本识别方法.与大部分传统的监督训练方式不同,Bartz等在文献[155,160]中对其提出的端对端文本检测与识别系统采用了半监督学习方法进行了训练.为了应对任意方向排列的自然场景文本,在文献[156]所提出的端对端文本识别系统中,首先采用了旋转文本建议网络(Region proposal network,RPN)来获得文本区域,然后采用基于合成文本样本训练后得到的文本分类器进行识别.对于单个文本的识别问题,基于深度学习文本识别方法的做法通常与传统方法类似,采用CNN获取文本的描述特征并进行分类[46];对于由多个文本构成的单词,主要采用了CNN+LSTM结构[12,16],首先利用CNN学习图像相邻像素之间的关系,然后利用长短期记忆神经网络(Long short-term memory,LSTM)学习较长跨度的上下文关系.

7 性能评估

7.1 测试数据集

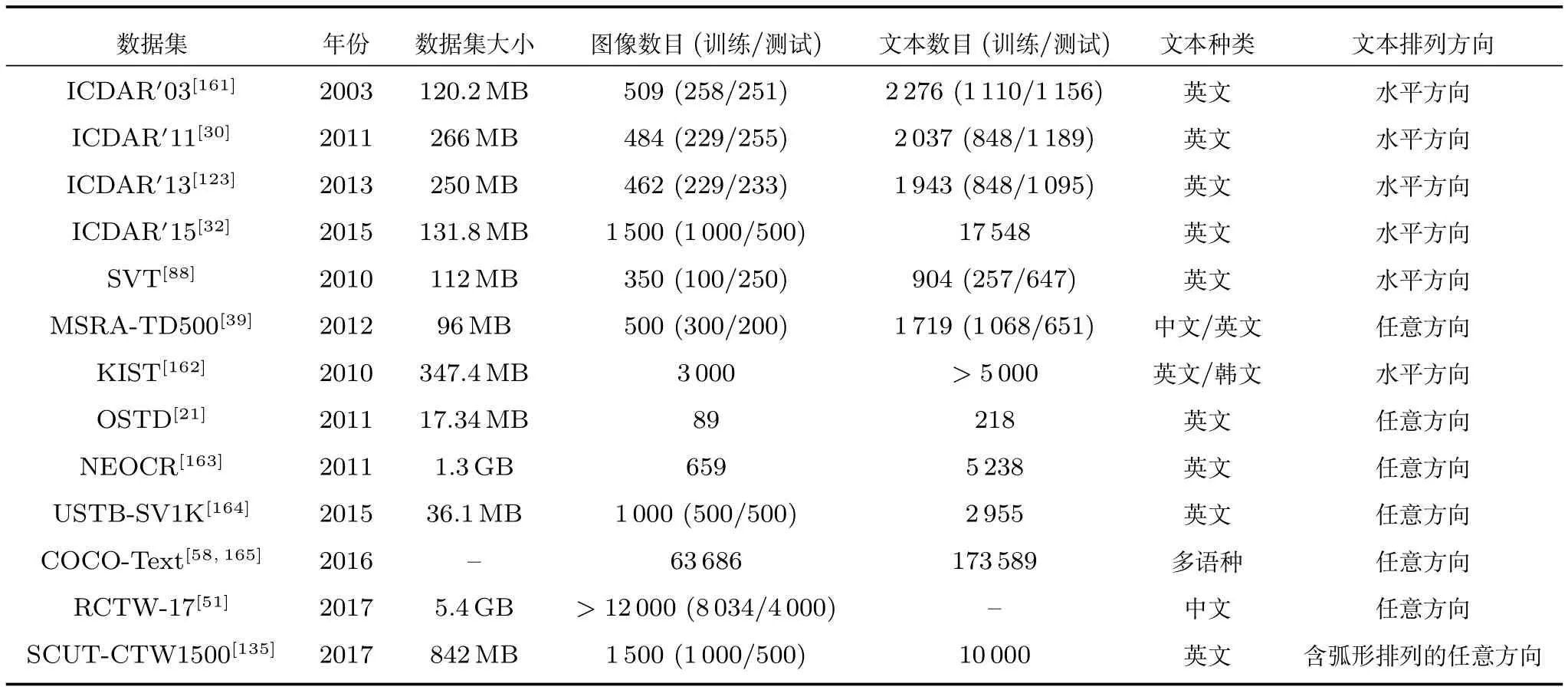

随着自然场景文本检测这一研究领域的不断发展,越来越多的文本数据集被推出以供研究人员来检验其方法的性能.最为常见且使用最为广泛的数据集有ICDAR自然场景文本检测竞赛的系列数据集.除此以外,自然场景文本检测数据集还包括了MSRA-TD500、SVT、COCO-Text等.上述各种数据集的特点如表1所示.

表1 常用自然场景文本检测数据集Table 1 Widely used natural scene text detection datasets and their download link

上述数据集的下载地址分别为:ICDAR0033Available at:http://algoval.essex.ac.uk/icdar/Datasets.html,ICDAR0114Available at:http://robustreading.opendfki.de/,ICDAR0135Available at:http://dag.cvc.uab.es/icdar2013competition,ICDAR0156Available at:http://www.iapr.org/archives/icdar2015/index.tml%3Fp=254.html,SVT7Available at:http://vision.ucsd.edu/~kai/grocr/,MSRA-TD5008Available at:http://pages.ucsd.edu/~ztu/Download front.htm,KIST9Available at:http://www.iapr-tc11.org/mediawiki/index.php/KAIST_Scene_Text_Database,OSTD10Available at:http://media-lab.ccny.cuny.edu/wordpress/cyi/www/project_scenetextdetection.html,NEOCR11Available at:http://www.iapr-tc11.org/mediawiki/index.php?title=NEOCR:Natural_Environment_OCRDataset,USTB-SV1K12Available at:http://prir.ustb.edu.cn/TexStar/MOMV-text-detection/,COCO-Text13Available at:https://vision.cornell.edu/se3/coco-text-2/,RCTW-1714Available at:http://mclab.eic.hust.edu.cn/icdar2017chinese/dataset.html,SCUT-CTW150015Available at:https://github.com/Yuliang-Liu/Curve-Text-Detector.

7.2 评估方法

为了客观地评测各种方法的检测性能,目前已推出了几种测评方法(后续小节中将对各种评测方法进行详细介绍).现有检测性能评测方法主要考虑三个性能参数,即:准确率(Precision,P)、召回率(Recall,R)、综合评价指标(F-measure,F).准确率(P)表示检测得到的真实文本与所有检测结果之间的比率,召回率(R)表示检测得到的真实文本和所有手工标注的真实文本之间的比值,综合评价指标(F)是准确率与召回率的调和平均值,该值是评价文本检测方法性能的综合指标.

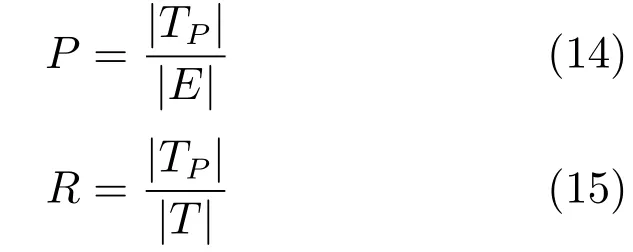

7.2.1 ICDAR 2003/2005评估方法

具体办法是通过将检测结果的最小外接矩形与手工标注的文本区域矩形进行比较以获得其公共部分面积,并通过公共部分面积计算出文本检测召回率、精确率以及综合评价指标,最后根据上述三个性能指标对检测结果的优劣性进行评价.匹配度mp定义为上述两个矩形之间的公共部分面积与包含上述两个矩形的最小外接矩形的面积之比.当两个矩形完全重合时,匹配度mp=1;当两个矩形之间无公共部分时,则匹配度mp=0.

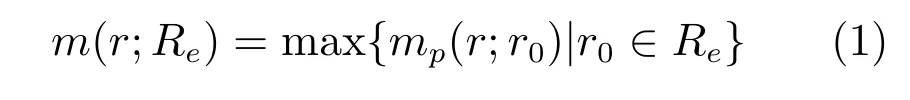

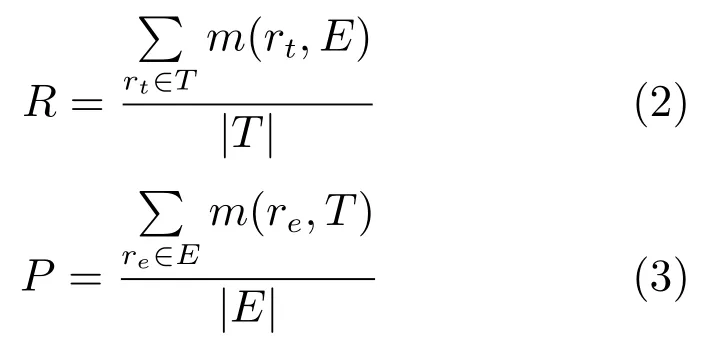

一个矩形r与一组矩形Re之间的最佳匹配度采用式1进行定义.

召回率(Recall,R)和准确度(Precision,P)分别采用式(2)和式(3)进行定义.

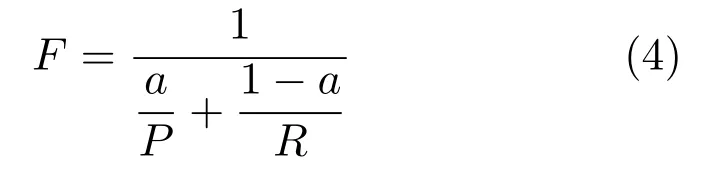

其中,T表示手工标注文本区域的矩形集合,E表示检测结果的矩形集合.综合评价指标(F-measure)为召回率(Recall)和精确率(Precision)的调和平均值,其定义如式(4)所示.

其中,参数α为检测召回率与准确率之间的权重,通常取值为:α=0.5.

7.2.2 ICDAR 2011/2013评估方法

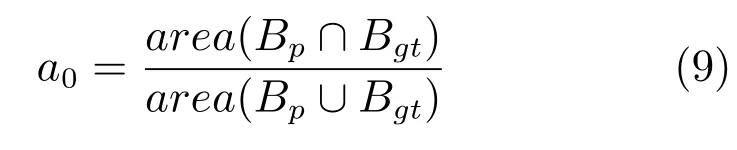

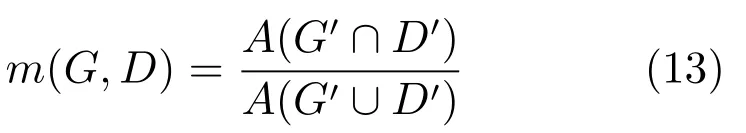

ICDAR 2003以及ICDAR 2005评估方法没有考虑检测结果与手工标注结果(Ground-truth)之间一对多(One-to-many)与多对一(Many-to-one)的匹配情形.事实上,检测结果与Ground-truth之间一对多(One-to-many)与多对一(Many-to-one)的匹配情形在实际检测结果中并不少见,因此在采用ICDAR 2003以及ICDAR 2005评估方法时容易低估自然场景文本检测方法的实际性能.考虑到上述情况,ICDAR 2011以及ICDAR 2013自然场景文本检测竞赛采用了文献[166]所提出的评估方法.需要指出的是,文献[166]认为多对多(Manyto-many)的匹配情形并不常见,因此在文献[166]中暂未考虑多对多匹配情形.

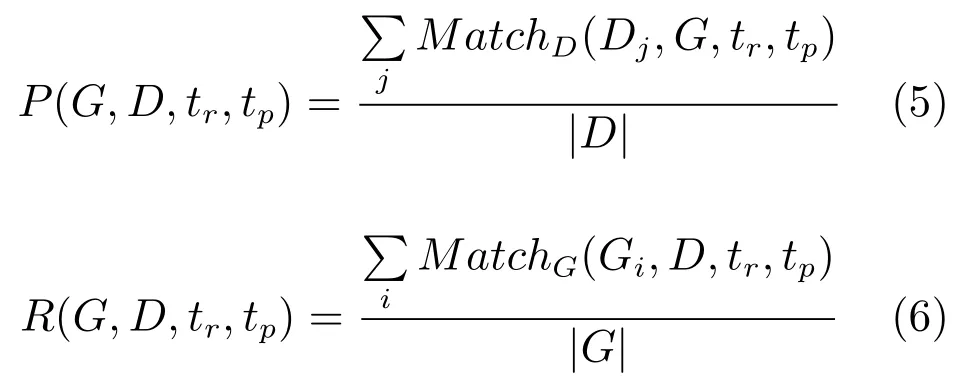

文献[166]所提出的评估方法主要考虑了检测结果与Ground-truth之间的三种匹配情形,即:一对一(One-to-one)、一对多(One-to-many)以及多对一(Many-to-one)(如图13所示).准确率(P)与召回率(R)分别定义为

其中,G,D分别表示Ground-truth与检测结果,tr∈[0,1]是召回率约束项,tp∈[0,1]是精确率约束项,其取值分别为tr=0.8,tp=0.4.函数MatchD与MatchP用来区分匹配类型,具体来说可以表示为

其中,fsc(k)为针对欠分割与过分割情况的惩罚函数,文献[166]取fsc(k)=0.8.

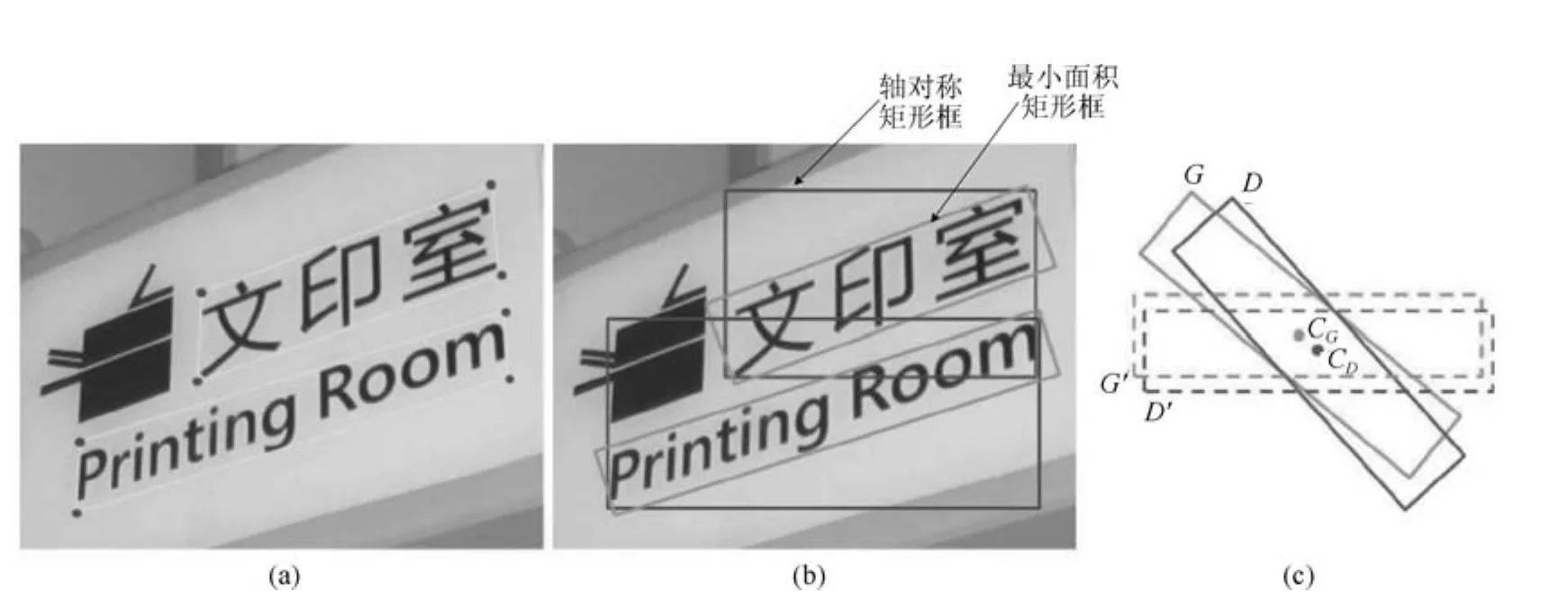

7.2.3 ICDAR 2015评估方法

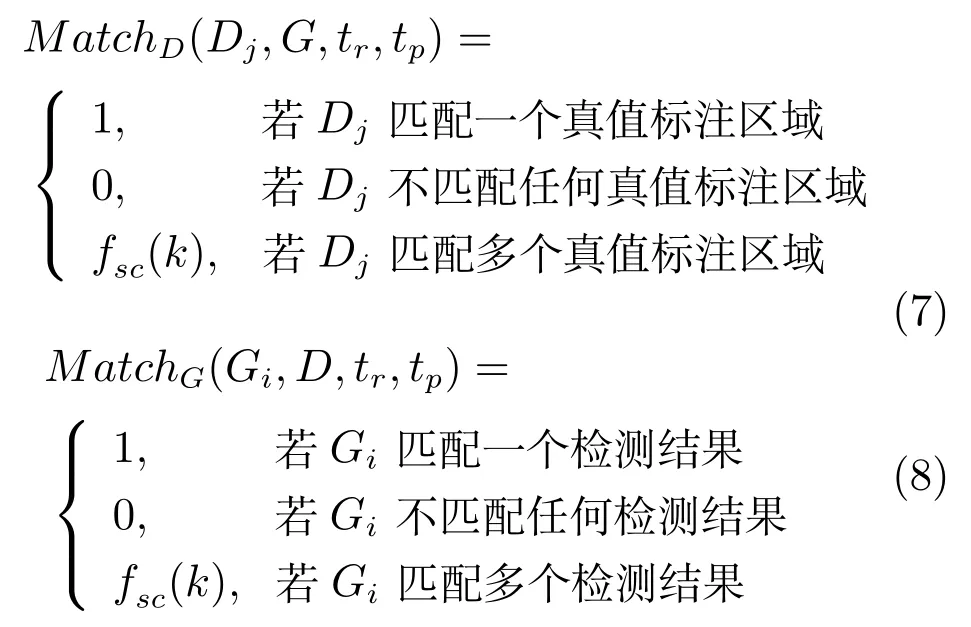

ICDAR 2015自然场景文本检测竞赛采用了文献[167]所提出的目标检测评价方法,通过比较检测结果矩形框与Ground-truth矩形框之间的公共区域与并集区域之间的比值来进行衡量.具体做法是,定义覆盖面积比值为

其中,a0为覆盖率,Bp和Bgt分别表示检测结果与Ground-truth,area(Bp∩Bgt)与area(Bp∪Bgt)分别表示Bgt,Bp之间的交集区域与并集区域.若检测结果与Ground-truth之间的实际面积覆盖率a0>0.5,则认为该检测结果为正确的;反之,则认为是虚警.当同一文本行出现多个检测结果时,根据降序顺序将除了第一个检测结果以外的其余检测结果视为虚警.准确率(P)与召回率(R)分别定义为

其中TP,E,T分别表示正确的检测结果集合,检测结果集合以及Ground-truth集合,综合评价指标(F)则定义为

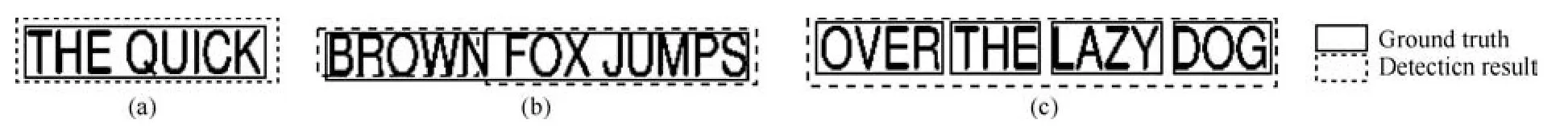

7.2.4 MSRA-TD500评估方法

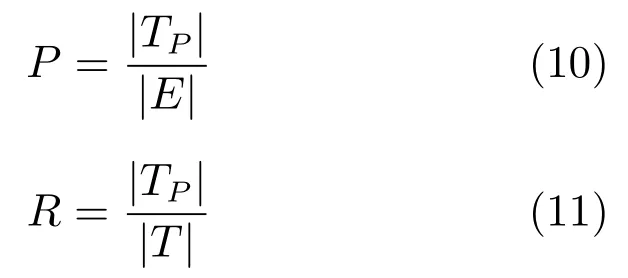

文献[39]针对任意方向自然场景文本检测提出了一种有效的评估方法.该方法采用了文献[168]所提出的最小面积矩形框对文本区域进行了标记,图14(a)为手工标记的结果.对于任意方向排列的文本而言,采用文献[168]所提出的最小面积矩形框相较轴对称矩形框更加紧致(如图14(b)所示).采用图14(c)所示方式计算检测结果与Ground-truth之间的覆盖率,其中G,D分别表示为Ground-truth与检测结果.考虑到在计算G,D之间的覆盖率时不够方便,文献[39]将G,D按照其中心点CG,CD进行旋转至G0,D0所示位置(如图14(c)所示).G,D之间的覆盖率定义为

图13 检测结果与Ground-truth匹配模式[166]Fig.13 Matching model of the detection results and ground-truth[166]

图14 MSRA-TD500数据集评估方法[39]Fig.14 Evaluation method of the MSRA-TD500 datasets[39]

A(G0∩D0)与A(G0∪D0)分别表示G0,D0之间的交集与并集区域,文献[39]借鉴了PASCAL目标检测性能评估方法[169],其具体做法是:当G,D之间的倾斜角之差小于π/8且覆盖率m大于0.5时,则认为D为一个正确的检测结果.对于同一文本行而言,若出现多个检测结果,则根据降序顺序将除了第一个检测结果以外的其余检测结果视为虚警.准确率(P)与召回率(R)分别定义为

其中,TP,E,T分别表示正确的检测结果集合,检测结果集合以及Ground-truth集合,综合评价指标(F)定义为

7.3 测试结果

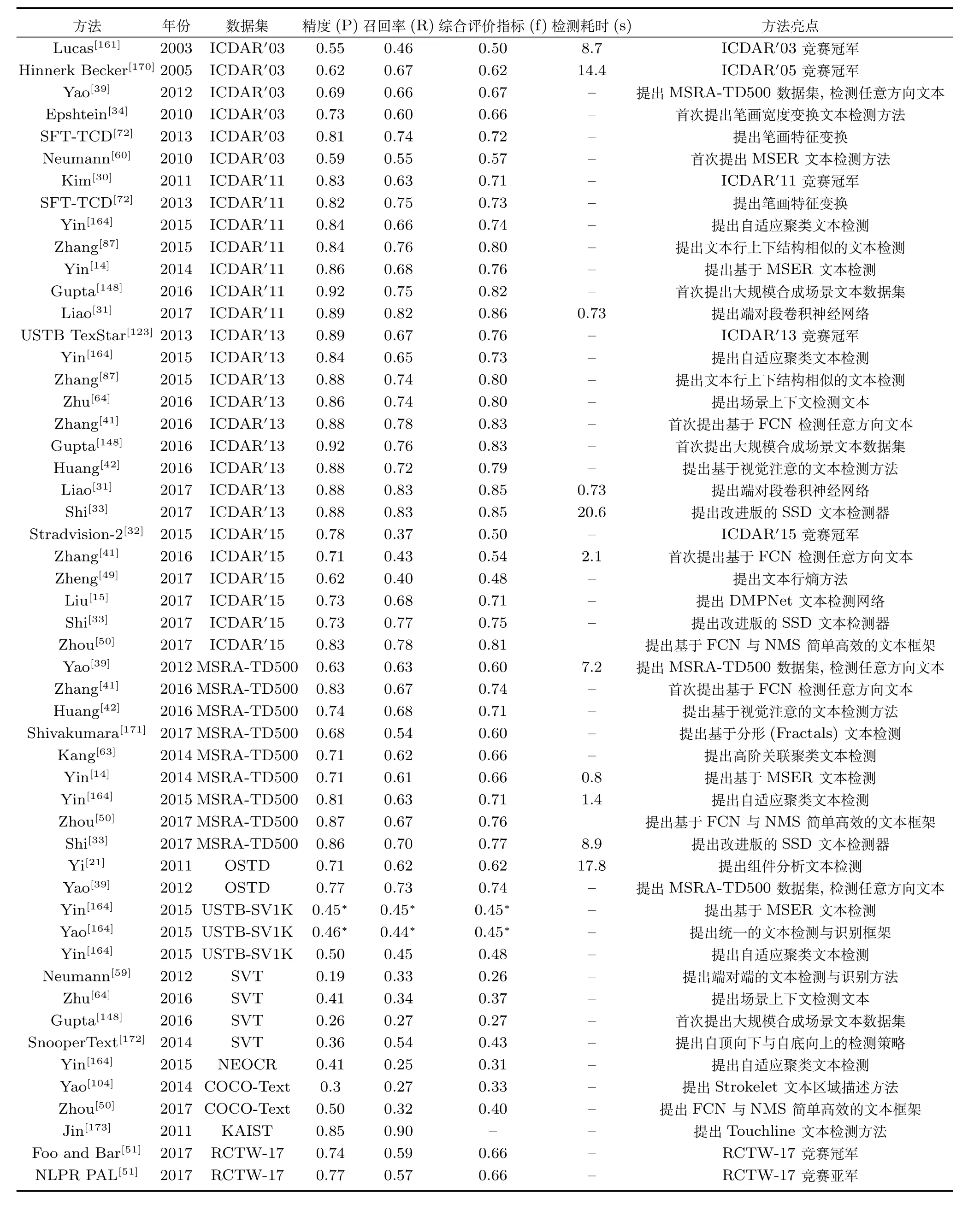

各种自然场景文本检测方法在各类公开数据集上进行测试,一些代表性的文本检测方法的测评结果如表2所示[170−173].由表2可知,自然场景文本检测技术在近几年得到了长足发展,比如在ICDAR 2011数据库上的综合标价指标从0.71上升到0.85(2011~2017年),在ICDAR 2015数据库上的综合标价指标从0.50上升到0.81(2015~2017年).

8 自然场景文本检测方法存在的问题

近年来,尽管不少行之有效的文本检测方法被提出,文本检测的性能也获得了大幅度提升,但自然场景文本检测技术依然存在着一些不足.

8.1 端到端(End-to-end)场景文本识别问题

端到端场景文本识别需要同时应对文本检测与文本识别双重任务(如图11所示),目前针对端对端自然场景文本识别的研究还相对的单薄;从已发表文献所采用的技术手段来看,大部分工作[34,49,79,88]将端到端场景文本识别的二个任务独立地进行处理,只有少数文献[59,137,143,174]将该问题作为一个整体来进行研究.从ICDAR 2015自然场景文本检测及识别竞赛[32]的结果来看,在无语料信息的真实环境下的端对端(End-to-end)场景文本识别(Task 4.4)的最好识别率仅为34.96%,由此可见端对端场景文本识别性能尚有很大的提升空间.

8.2 多方向与形变文本检测问题

从目前所提出的自然场景文本检测方法来看,大多数方法主要针对直线方向排列(即:水平排列、垂直排列以及斜线排列)的文本进行检测.然而对于自然场景文本而言,相邻文本之间的排列方向具有多样性,除直线方向排列外,还可能沿弧形等不规则方向排列.对于多方向排列的场景文本,其边界框可能是旋转的矩形或者四边形,因此很难设计有效的方法来统计相邻文本之间排列方向的规律性.此外,形变场景文本的视觉特征的不规则性也阻碍了该技术的进一步发展.

8.3 少语种与混合语种文本检测问题

根据2009年联合国教科文组织《濒危语言图谱》统计结果表明,全世界有7000种语言,其中有83种主要语言被80%的人所使用.目前大部分自然场景文本检测方法只能检测汉字、英文或者阿拉伯数字等单一语种文本或者极少数混合语种文本,而其他的少数语种以及混合语种的文本检测问题却关注很少.混合语种文本检测所遇到的挑战主要包括:文本种类繁多且不同种类文本的空间结构存在多样性,从而导致了文本区域的视觉特征具有很大的差异,以致很难找到区分性好的描述特征来分类文本区域与背景区域,此外,构建多分类的识别框架也是一件困难的工作.

8.4 文本检测结果评价方法问题

目前的评价方法主要采用交并比(Intersectionover-union,IoU)指标来评价文本检测结果,然而该方法并不能很好地反映文本检测方法的性能.对于一般性的目标检测问题,如果能检测出超过50%的IoU,则表明获得了很好的检测结果,然而对于文本检测问题而言,即使IoU获得了大于50%的结果,也不能保证在后续的文本识别与语义理解中能得到很好的结果,检测框内的内容和细节同样对后续处理产生很大的影响.目前绝大部分自然场景文本检测方法采用了ICDAR性能评价标准,在特定的、小规模的公开测试数据集上进行评估,因此方法性能的鲁棒性还有待于进一步验证.

8.5 文本检测研究内容与创新性问题

对2017年在 CVPR、ICCV、NIPS、ICDAR等顶级会议上发表的自然场景文本相关论文进行分析后发现,超过80%的自然场景文本检测论文主要关注多方向排列的场景文本检测问题,较少文献涉及自然场景文本识别与端对端自然场景文本检测与识别问题,从而导致了目前该领域的研究工作重检测轻识别;另外,目前所提出的大部分文本检测方法主要在一些公共数据集上测试性能,相当一部分方法为了获得更高的测试性能,往往简单地堆积一些领域知识与反复调整参数(比如采用Faster R-CNN,SSD,FCN,RNN等模式识别领域知识),从而导致缺乏创新和深度思考,没有形成文档分析领域特色.

表2 近期主流自然场景文本检测方法性能总结(数据都是原文报道的结果,带(*)标记的数据是引自相关论文)Table 2 Performance summary of recent dominant natural scene text detection methods(All results are quoted directly from original papers,except for those marked with(*),which are from a recent related paper.)

9 发展趋势及应用

9.1 任务实施步骤层面的几点思考

从自然场景文本检测任务的实施步骤来看,主要需要解决三个问题:如何获得文本候选区域、如何验证文本候选区域以及如何得到以单词为分割单元的检测结果.

对于第一个问题,可以考虑将自顶向下检测方法与自底向上检测方法进行综合运用.因为我们欣喜地发现,文本在自然场景中通常表现出聚集性,相邻文本往往具有高度、宽度与颜色的相似性,即便是任意方向排列的文本区域,其相邻文本间的排列方向也具有一定的规律,因此自然场景文本相较其他的物体往往具有显著的视觉上下文信息.基于自然场景文本的上述特点,我们可以考虑将前期自底向上方式处理后所获得的文本区域作为种子区域,然后将种子区域的大小、排列方向等信息作为先验知识,为后续将要开展的自顶向下处理方法提供线索,指导其检测窗口的大小以及搜索方向的设定,进而可以兼顾检测效率与检测召回率.

对于第二个问题,近年来基于深度学习的目标检测方法如Faster R-CNN、YOLO、SSD、R-FCN等为解决文本检测问题提供了全新的思路.尽管文本检测属于目标检测中的一个特例,但是简单地把深度学习中的目标检测框架应用于文本检测问题可能会达不到满意的效果.然而,自然场景文本所具有的独特性以及视觉上下文信息使得其具有了其他场景目标所不具备的优势.如果能设法将文本上下文信息融入深度学习框架,有望提升文本检测系统的整体性能;另外,从训练文本分类器的方式来看,目前主要采用了监督学习方法,半监督,弱监督甚至无监督方法鲜有人关注,而事实上,上述学习方式可望在一定程度上减轻方法对大规模训练数据集的依赖.

对于第三个问题,由于受到文本漏检、误检等因素的影响,如果只是单向地通过经验或者统计学习方法来设计单词分割规则,往往难以获取理想的分割结果.然而我们注意到,自然场景文本中的单词绝大部分都是常用单词,尽管单词的总数有几十万个,但是根据Test your vocab网站上两百万份测试的结果,大部分母语为英语人的单词量为20000~35000之间,国内英语专业研究生毕业应掌握单词量也才8000以上,因此我们可以考虑基于常用单词建立字典进而对所分割得到的结果进行对比,(尽管单词误分割后有可能刚好成为一个新的单词,但是这样的几率相对很少),在此基础上可尝试通过引入反馈机制来指导单词分割.比如:如果发生比对错误,则将出错的信息反馈到单词分割处理的前端,在单词分割的前端通过对该出错的单词调整其阈值以获得新的分割结果.此外,在设计自然场景文本检测方法时,我们还应该借鉴计算机视觉与模式识别领域的一些新的研究成果,并挖掘一些技巧性处理办法.

9.2 任务整体层面的思考

尽管自2012年以来,任意方向排列的自然场景文本检测成为了该领域的研究热点,然而我们却发现绝大部分任意方向排列的文本检测方法[15,33,50,131−134]的检测对象仅仅是直线方向排列(即:水平排列、垂直排列以及斜线排列)的文本,只有极少的文献[135,136]对包含弧形排列方向的任意方向排列文本开展了检测研究.对任意方向排列的文本进行检测时将面临两个关键性问题:1)文本区域描述;2)文本行的形成.

1)对于第一个问题,为了适应文本的旋转变化,需要设计文本级别以及文本行级别这两组旋转不变的描述特征.所幸的是,近年来所提出的深度学习方法[15,33,50,131−134]+合成文本数据技术[148−149]已能较好地突破一些传统手工设计的特征[39,101,104]的局限,因此进一步提出更优的深度学习框架是一个有效的解决方法.即便如此,文本行相比其他独立的物体而言,文本具有着特定的空间结构与语义属性,因此文本满足一定的“典型性”与“描述性”特点.根据文本行的组成特点,除了设计更优的深度网络框架以外,我们还可以借助视觉特性好的文本检测结果来提升视觉特性差的文本的检测效果.文献[74]采用自底向上策略从局部特征提取角度来描述文本行区域,为任意方向排列的文本行以及形变文本的检测问题提供了一种思路.

2)对于第二个问题,由于任意方向排列的文本区域其边界框可能是旋转的矩形或者是不规则的四边形,从而导致传统的一般物体检测方法[93,95,175]所采用的矩形检测框很难有效地应对任意方向排列的文本检测问题.与此同时,在文本行形成的过程中连接规则的设计也是一个非常重要的处理步骤,一些基于连接的检测方法(Linking methods)[33,37,150]首先检测单个文本,然后将单个文本通过一定的连接规则融合成文本行,然而该方法有一定的缺点,当出现大量堆叠的文本区域或者文本尺寸太小的情况时,该类方法往往不能获得一个满意的效果.区别于传统的基于连接的文本检测方法,文献[136]针对任意方向排列的文本(包含弧形排列方向)的检测问题提供了一种新的解决思路,该文献提出了滑动线点回归(Sliding line point regression,SLPR)方法.文献[135]在提出基于多边形的弧形方向排列的文本检测方法的基础上,首次推出了包含弧度方向排列文本的数据集(SCUT-CTW1500),从一定程度上为更广泛的任意方向排列的文本检测研究提供了方便.

9.3 领域知识对文本检测性能影响的几点思考

自然场景文本检测属于一种典型的二分类模式识别问题,计算机视觉与模式识别领域中的其他目标检测方法可以为自然场景文本检测提供思路.

9.3.1 视觉注意机制对文本检测的影响

文本在自然场景图像中表现出稀疏性特点,大量的背景区域给真实文本检测带来了极大困难(特别是一些类文本的背景区域).事实上,采用视觉注意机制对特定目标进行显著性检测时,可以在突出特定目标的同时抑制其他背景信息,进而减少背景干扰所带来的虚警.一些研究者[20,79,176−182]对自然场景文本的显著性检测问题展开了研究,文献[176−178]的研究结果表明可以通过构建视觉注意模型来表示文本区域的显著性.文献[180]认为图像中的文本区域并不是所谓“最显著”的区域,因此只使用了文献[183]所提出的视觉注意模型中的强度突出图作为显著图.文献[79]提出了一种文本–注意卷积神经网络(Text-attentional convolutional neural network,Text-CNN),并采用了多任务学习的方式训练Text-CNN模型.在训练的过程中将低级的像素级信息(分割问题)、高级的字符多类信息(62类字符识别问题)以及字符与非字符信息(2类字符分类问题)融合到Text-CNN模型中,从而使得Text-CNN具有强大的识别歧义文本的能力,同时也增强了算法在应对复杂背景时的鲁棒性,最后通过采用训练后的Text-CNN对图像进行处理进而获得显著性图像,在显著性图像中文本区域往往具有高的置信度值,而背景区域所对应的置信度值较低.最近,He等在文献[184]中提出了一种视觉注意模型,该方法通过自动地学习注意图来初步地获得文本区域.区别于大部分文本显著性检测方法,文献[185]关注于检测背景区域,反向思维地将检测出的背景区域去除,从而凸显待检测文本区域.文献[41]则采用了全卷积网络(Fully convolutional network,FCN)直接得到文本区域的显著图(Salient map),然后基于该显著图进行后续处理.通过对上述研究工作的分析我们可以发现,结合自然场景文本的特点合理地设计一个视觉显著性模型将有助于自然场景文本检测问题的解决.

9.3.2 视觉上下文对文本检测的影响

诸如人脸检测、行人检测以及车辆检测等其他物体检测的对象往往是一些独立目标,然而自然场景文本检测通常需要检测一个文本序列.尽管自然场景文本种类多样,由不同文本任意组合而成的文本行区域的视觉特征差异较大,但是我们欣喜地发现:对于某一特定语种其包含的文本种类是有限的,而且文本序列中的相邻文本之间通常具有着独特的上下文信息,比如:相邻文本之间具有相近的高度、颜色、笔画宽度以及均匀的间隔距离等.根据自然场景文本的上述特点,如果我们能合理地利用相邻文本间的上下文信息,无疑将有助于提高文本区域的分类正确性.除此以外,自然场景文本检测的目标是判断给定的图像区域中是否包含文本,并不关心所包含文本的具体种类,因此自然场景文本检测属于二分类模式识别问题,从而为利用视觉上下文信息提供了便利.近年来,一些研究者开始关注自然场景文本视觉上下文信息对文本检测性能的影响,文献[35,64,74,80,184,186−189]通过利用相邻文本间的视觉上下文信息设计了不同的文本检测方法并取得了满意的检测结果.通过对前期研究工作的分析我们可以发现,在深度学习的框架内合理地融入文本视觉上下文信息可望有效地提升文本检测的性能.

9.4 应用层面的几点思考

基于文本的高度抽象描述能力,自然场景文本检测技术具有广泛的应用价值.在应用需求的驱动下,目前自然场景文本检测技术在一些特定领域中获得了应用,比如:智能交通系统(如:美国Hi-Tech公司的See/Car System以及香港Asia Vision Technology公司的VECON-VIS等);基于内容的视频检索系统(如:美国卡耐基梅隆大学的Informedia Digital Video Library[190]以及美国哥伦比亚大学的WebSeek[191]等);可穿戴/便携式视觉系统(美国麻省理工学院的FingerReader[9]以及Goggles[10]等).除了上述应用以外,一些研究者还将自然场景文本检测技术应用到图像理解[192],文种识别[193]等领域.相比自然场景文本检测技术的潜在应用市场,上述应用只是“冰山一角”.

文本具有高层的语义信息,而语义信息往往能有助于解决计算机视觉中的一些传统问题以及拓展新的应用,比如在特定目标(如运动员、汽车)的跟踪与重检测的问题上,我们可以引入运动员的标牌或者汽车的车牌来帮助实现上述任务;再如无人驾驶汽车的辅助导航问题上,我们也可以通过引入自然场景文本检测技术来获得交通标识信息,通过识别交通标识牌的语义信息来提高汽车的智能感知与行驶规划能力;还有无纸化办公方面也可望使用文本检测技术,对于会议后书写在白板上的工作安排,我们只需用智能设备拍照留存与分析处理,系统将根据白板上的文本识别结果来分类相关人员的后续工作.另外,自然场景文本检测技术还可以与音频信息结合起来共同解决诸如“以词搜图”的图片检索、地图定点导航等实际问题.作为一项面向具体应用场景的技术,自然场景文本检测的应用领域将在各种应用需求的驱动下不断拓展、不断成熟.

9.5 其他问题的思考

1)据报道,人脸的识别在大脑中有专用机构[194−195],那么是否在大脑里存在类似的专用机构处理文本的识别问题?尽管目前的深度学习是最接近人脑思维过程,相信神经生物学家未来的研究成果将有助于深入理解大脑的工作原理,进而为构造更有效的文本识别机制提供依据.

2)尽管深度学习在文本表示方面展现出显著的优势,但是自然场景文本相对图片而言其尺寸较小,网络的深度太深可能会对文本识别产生大的影响,从而面临着网络的深度规模如何选取的问题.

3)对于多语种文本检测是否会存在分类性能好且通用的描述特征?通过观察我们发现:如果一个中国小孩不学英文,是不具备检测与识别英文文本的能力的.

10 结束语

自然场景文本检测是计算机视觉与模式识别领域中的一个新兴的研究课题,具有重要的理论意义和实际应用价值.国内外许多学者对该课题展开了大量研究,然而复杂自然环境中所存在的诸多挑战使得该技术与实际实用仍然有一定距离.为了全面分析文本检测中的问题,本文对自然场景文本检测技术的研究背景与意义、发展现状等内容进行了阐述、对该技术的方法进行了详细的梳理和评述,并揭示了它们之间内在联系、优势与不足.与此同时,本文介绍了端对端文本识别技术,并对计算机视觉与模式识别领域中的一些新发展对自然场景文本检测技术的影响进行了介绍,拓宽了研究思路;本文还对一些主流数据库进行了总结和评述,并列举了目前一些主流方法的性能参数;在此基础上,对自然场景文本检测技术的未来发展方向以及该技术的一些潜在的应用领域进行了分析与展望.我们有理由相信,计算机视觉与机器学习领域的进步,将极大地促进自然场景文本检测问题的解决;与此同时,文本检测技术中的关键性问题的突破也将启发计算机视觉相关领域的发展.