视觉显著性的自适应权重立体匹配算法

2017-01-12高浩然

王 冲,潘 晨,高浩然

(中国计量大学 信息工程学院,浙江 杭州 310018)

视觉显著性的自适应权重立体匹配算法

王 冲,潘 晨,高浩然

(中国计量大学 信息工程学院,浙江 杭州 310018)

针对传统算法大多忽略人眼特性,获得的视差图与人眼真实感受之间存在一定差异的问题,提出了一种符合人眼视觉特性的自适应权重匹配算法.该算法首先引入视觉显著性特征,然后对像素权值分配进行改进并提出新的匹配代价度量准则,最后采取左右视差图融合的方法获得最终视差图.相关图像实验表明,改进算法很好地解决了遮挡问题,可精确描述边缘和细节视差;相对于原算法有较大程度的性能提升.

立体匹配;自适应权重;显著性检测;相似性度量;视差图融合

双目立体视觉技术[1]突破了计算机“单眼看世界”的局限性,该技术主要利用双目摄像头观测同一场景,获得左右两幅二维视图,经过处理得到反映三维世界信息的视差图.该技术的关键是左右两幅图之间的匹配,匹配的准确性直接影响最终生成三维视图的质量.因此,获取符合人眼特征的高精度视差图具有重要意义.

匹配算法根据优化方式不同可以分为全局匹配和局部匹配[2].全局匹配算法能获得精度较高的视差图,但计算效率低,不利于实际开发[3];局部匹配算法主要利用对应像素点及其邻域的约束信息进行匹配获得视差图,这种方法执行效率高,且在一个合适的匹配代价下能得到较高的匹配率,在近年来广泛受到研究者的关注.其中,De-Maeztu L[4]提出一种利用像素颜色信息计算自适应权值的匹配方法,提高了原算法的匹配精度.Jyoti Joglekar[5]提出一种基于神经网络的局部匹配算法,提高了原算法的收敛速度.但是,这些自适应权重匹配算法相比于人眼视觉仍然有许多欠缺.比如:它所采用的代价聚合方法只是纯粹的数学计算,并没有考虑到人眼对颜色和亮度的敏感度;在匹配时通常固定一幅图像作为待匹配图像,在另一幅图像中依次寻找对应的匹配点[6].而人类双眼信息传递到人脑外膝体时,会相互交叉后再传递.针对以上几点,本文从三个方面改进自适应权重立体匹配算法.

1)为避免图像中干扰导致的误匹配及视差不连续现象,本文引入彩色图像视觉显著度特征来描述像素点的受关注程度,并抑制全局性噪声.图像显著度特征结合像素颜色、亮度和位置信息,自适应地为窗口内每一个像素分配一个合适的权值.

2)为获得主观感受最优的视差图,考虑人眼对低亮度变化敏感而对高亮度变化不敏感的特性,本文提出一种考虑相对关系的相似性度量方法.

3)考虑到实际拍摄中摄像机左右视角存在一定的偏移量和存在一定遮挡问题的现象.在一幅图中的像素点在另外一幅图中可能无法得到匹配.本文通过交叉左右视图互为待匹配图像,生成左右两幅视差图,通过图像融合获取最终视差图.

1 经典自适应权重立体匹配算法

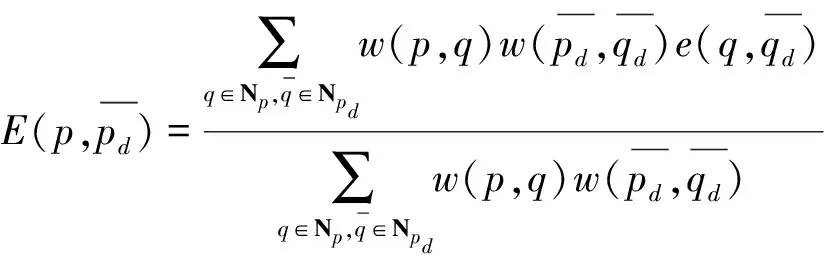

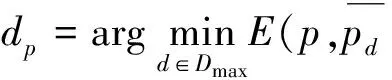

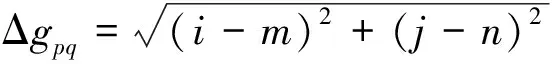

自适应权重算法[7]的核心思想是以待匹配点为中心假设一个固定窗口[8],计算窗口内的点相对中心点的权值大小,窗口内与中心点颜色信息越接近、空间几何位置越接近的点,赋予的权值越大.具体描述如下:以p作为中心待匹配像素,像素q是像素p支持窗口内的一个支持像素,根据格式塔准则,像素q对像素p的支持权值为w(p,q).

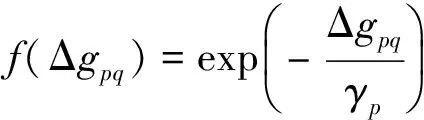

w(p,q)=f(Δcpq)·f(Δgpq).

(1)

(2)

(3)

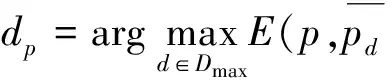

根据WTA(winner take all)局部最优化准则,计算每个像素的最终视差:

(4)

该方法具有较高的精度,但对于权重的定义只是从图像本身固有的特征出发,忽略了人眼主动性的影响,没有很好地表达支持像素对待匹配像素的支持程度.针对以上几点,本文提出三个创新点改进传统自适应权重算法.

2 改进的自适应权重立体匹配算法

2.1 改进的自适应权重策略

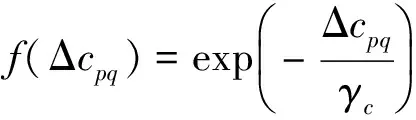

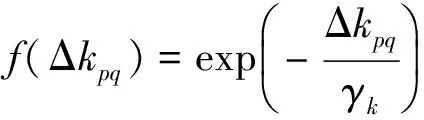

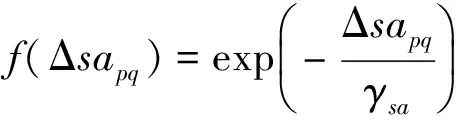

本文综合考虑RGB颜色特征、灰度特征、空间位置特征和图像显著性特征,提出一种新的权重策略.首先直接利用RGB空间代替Lab空间,描述像素颜色特征.然后引入彩色图像显著性特征来描述像素点的受关注程度.再结合像素灰度L和空间位置信息,提出新的支持像素对未匹配像素的支持权重,具体方法如下:

Δcpq=|pR-qR|+|pG-qG|+|pB-qB|,

(5)

(6)

Δkpq=|pgray-qgray|,

(7)

Δsapq=|psa-qsa|,

(8)

(9)

(10)

(11)

(12)

wnew(p,q)=f(Δcpq)·f(Δgpq)·f(Δkpq)·f(Δsapq).

(13)

支持像素q(m,n)与中心像素点p(i,j)的颜色分量分别为qR.qG.qB和pR.pG.pB,灰度值为qgray、pgray,显著度值为qsa、psa,γk、γp、γc、γsa分别表示不同特征差异性参数[10].新的自适应权值wnew(p,q)不仅考虑了图像数据本身特征,还从人类视觉角度考虑了图像显著性对每个支持点的影响.

2.2 新的匹配代价度量

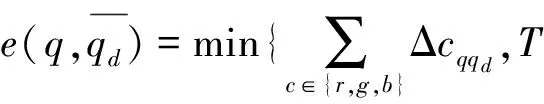

原算法的SAD聚合代价[11]如式(2)、(14):

(14)

SAD算法直接对像素点求差值.利用阈值T找到颜色差别最小的像素对,然后计算该点像素的视差.

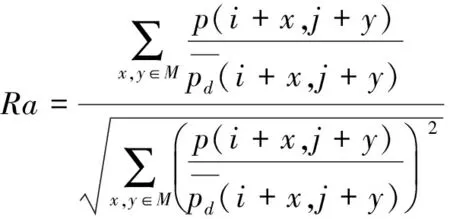

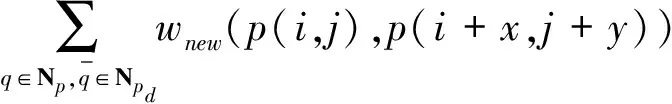

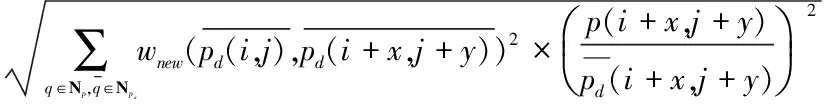

然而,人眼对1-5的低灰度级敏感度为100%,而对250-255的高灰度级的敏感度为2%,灰度值在低灰度范围内的像素点,虽然差值小,但由于此时人眼对这部分较敏感,匹配效果可能与主观视觉效果有一定出入.为了解决这个问题,我们引入Ra,用来表示待配像素点的相关度,如下:

(15)

(16)

得出视差图:

(17)

2.3 左右视差图融合

原自适应权重算法匹配时,选择左右视图中的一幅作为标准参考图,另一幅为匹配图.由于左右两图视角有一定差值,匹配的视差图会存在一定的遮挡问题,匹配结果可能会存在较多误差.本文模仿人类视觉传递过程中的信息交叉原理,提出一种解决方案:

1)指定左视图为参考图,利用新的自适应权重匹配方法得到左视差图,再指定右视图为参考图,得到右视差图;

2)聚合代价越大,像素点越相近,选取左右视差图中聚合代价较大值作为视差值;

3)遍历像素点,计算最终视差图.

左右视差图融合准则如下:

(18)

其中,r_left和r_right表示对应点的相关系数矩阵,disp_left、disp_right表示左右视差图,disp表示生成的最终视差图.

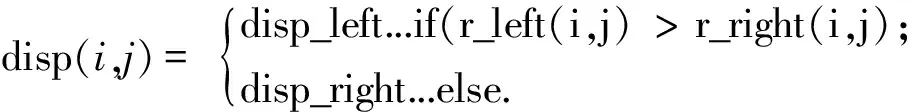

融合后局部放大效果如图1.

图1 左右视差图融合局部放大图Figure 1 Disparity map fusion partial enlarged map

从场景的左、右视图可以看出两视图视角存在一定的差距,按照一幅图作为标准匹配的视差图会存在一定的遮挡问题,边缘部分会存在较多误差.而融合后的视差图在遮挡区域的细节处理在主观上与人眼感受更一致.

2.4 算法框架

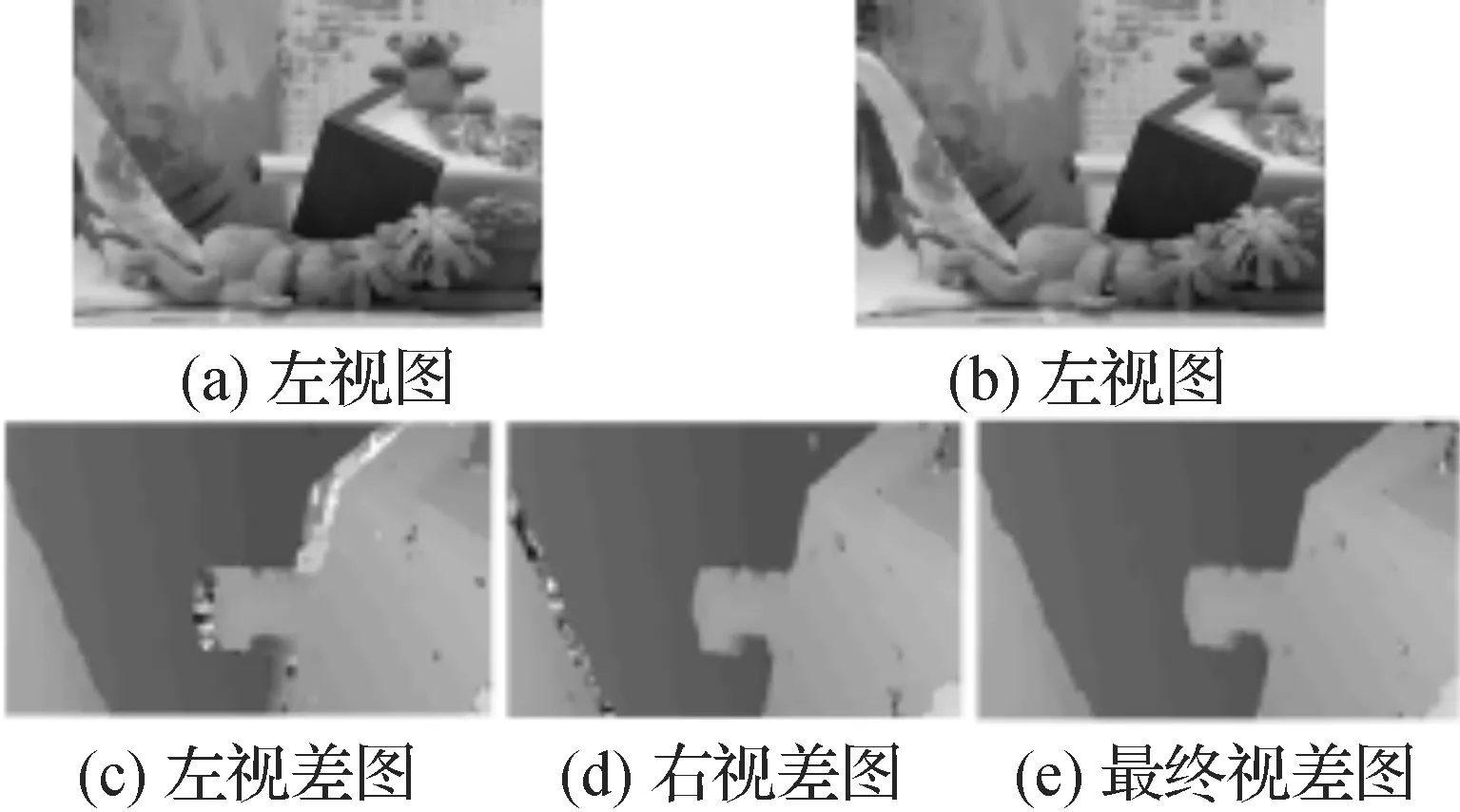

改进的自适应权重匹配算法流程图如图2.

图2 自适应权重立体匹配算法框架Figure 2 Stereo matching framework based on adaptive weights

3 实验结果与分析

本文算法在matlabR2010b软件实现,利用卡内基梅隆大学的Middlebury测试平台提出的立体匹配定量评价标准,分别采用Tsukuba,Venus,Teddy,Cones,Face标准图作为实验对象.统计立体匹配视差图dc与真实视差图[12]dt间的统计误差,获得错误匹配率指标.

(19)

算法获取的视差图与标准视差图对应点的视差绝对值大于δd(通常为1)时,判定为误配.

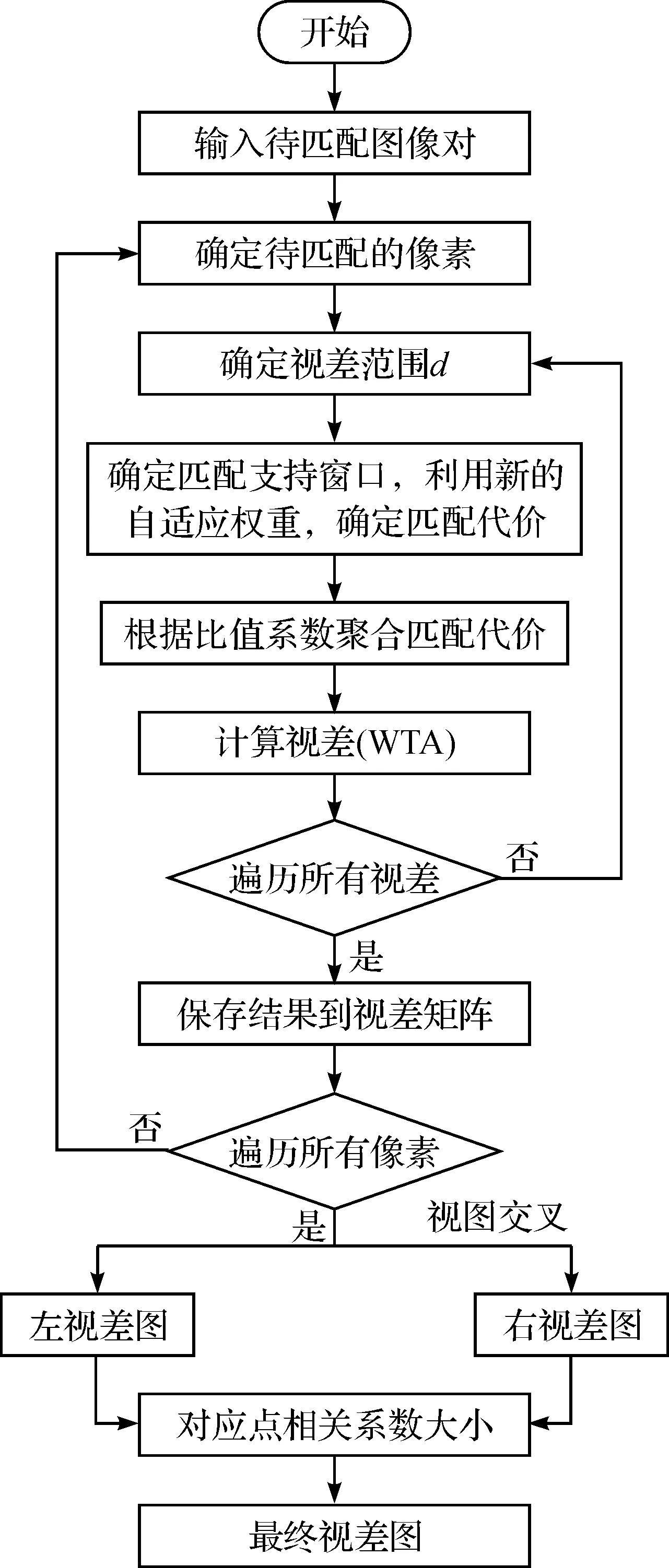

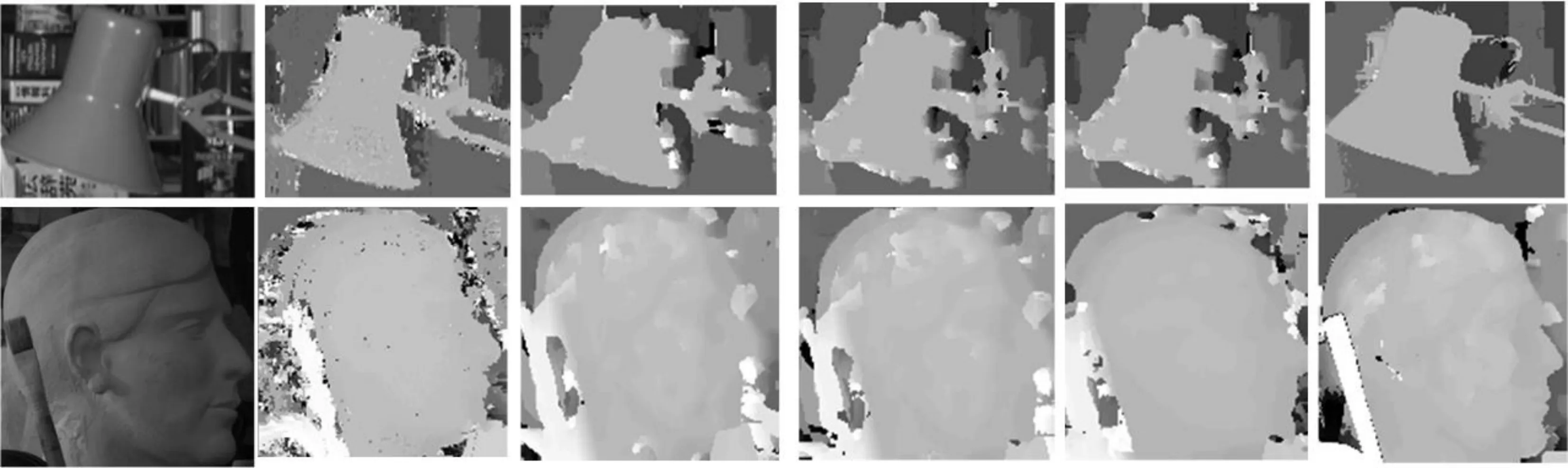

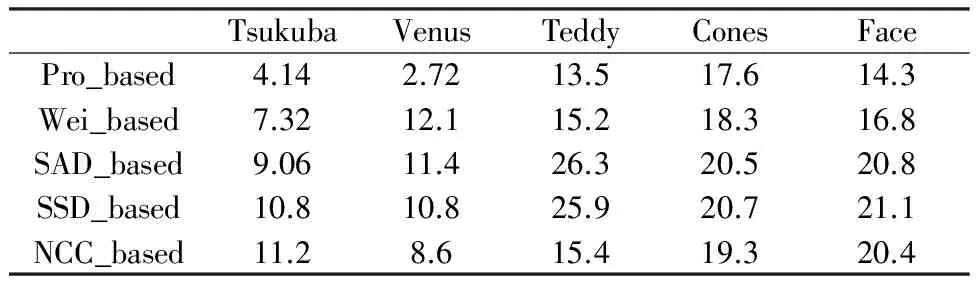

3.1 不同相似性度量函数结果对比

如图3,不同立体匹配算法的视差图表明,SAD和SSD算法只能反映出平坦区域的视差,对于物体边界视差没有明显过渡,且存在较多噪点,在纹理不丰富的区域错配率较高;NCC算法在纹理不丰富区域的视差图与SAD和SSD相比有一定优势,但在微小视差区域和边界处仍存在较多错误;原自适应权重算法选择阈值SAD算法作为对应像素的相似性度量函数,获得的视差图效果比之前两种算法好,但是对于边界的处理,依然不够清晰.相比之下,本文方法视差图边界过渡明显,噪声较小,主观视觉效果最好.

图3五种视差图的错误匹配率(%)如表1,SAD和SSD算法的视差图错配率较高,表明了只考虑绝对差和欧氏距离来衡量待匹配点之间的相似性的不合理性.NCC算法的视差图对比SAD和SSD算法错配率有所降低,表明考虑对应点之间的相关性对视差图精度提高有一定好处.原自适应权重法的错配率比其他算法低一些,表明该方法是当前比较精确方法,但对于细节的处理稍显粗糙.本文方法与其他方法相比,错配率明显降低,表明综合考虑像素颜色、亮度、空间特征以及人眼关注程度等信息可以提高匹配精度.值得注意的是,表1中本文方法的误配率在Cones、Face两图中没有明显的降低.这是由于标准视差图中没有体现出的面部五官细微视差,本文算法精确地描述出来了.因此,误差计算时影响了误配率指标.

图4是图3中Tsukuba、Face两图的视差图局部放大,从Tsukuba模型的对比图中可以看出,本文算法能精确描绘物体边界视差,得到的边缘信息相对完整.从Face模型的对比图可以看出,本文算法能够反映出标准视差图无法反映的五官信息,对微小视差有一定适用性.

自上而下代表:原始图像、标准视差图、原自适应权重法视差图、SAD法视差图、SSD法视差图、NCC法视差图、本文方法视差图 图3 不同相似性度量函数得到的视差图对比Figure 3 Disparity maps of different similarity measure function

自左向右代表:原图、原自适应权重法视差图、SAD视差图、SSD视差图、NCC视差图、本文方法视差图图4 不同算法视差图的局部放大效果Figure 4 Different algorithms partially enlarged disparity map

%

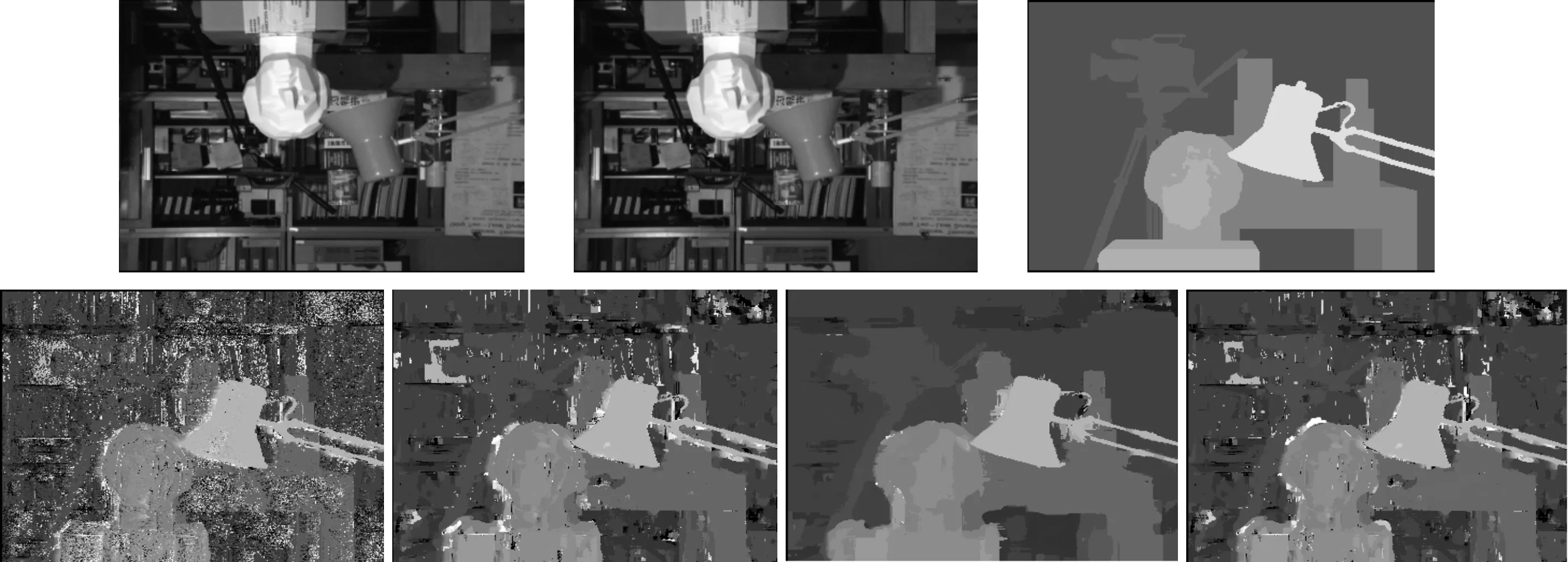

3.2 不同窗口大小结果对比

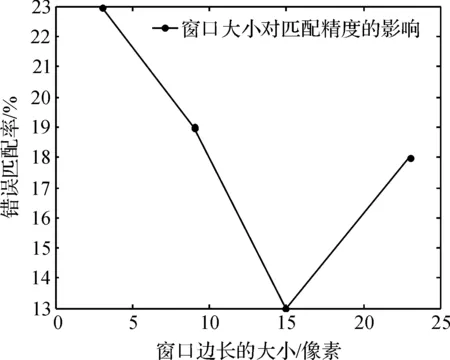

窗宽大小对视差图有影响见图5.通过对比可以看出,当窗宽处于某个合适值时(如15×15),视差图误配点最少,效果最好.窗宽过大或者过小,误配率都会增加,且窗宽越大匹配时间越长.

第1行:左右视图与标准视差图;第2行:从左至右窗宽依次为3×3,9×9,15×15,23×23 图5 不同窗口大小得到的视差图对比Figure 5 Different window size disparity map comparison

图6为上述不同窗口大小的错配率折线图.

从中可以直观看出,当窗口大小为15×15时,均方根误差最小.本文输入的图像大小为384×288,即当窗口大小为图像大小的0.2%时,错误匹配率最低.在本文其他部分实验,也都采取该窗口大小.

图6 窗口大小和错误匹配率的关系Figure 6 Relationships between window size and false match rate

4 结 语

立体匹配是利用二维场景获取三维场景的重要方法,本文提出了一种利用视觉显著性特征改进的自适应权重立体匹配算法.该算法首先根据人类视觉特性提出新的权重策略,利用新的匹配代价度量函数,以及视差图融合等方法,最终得到符合人类主观感受的视差图.实验结果表明,本文算法能够精确描绘图像的边缘与细节特征,并且能够解决左右视图遮挡的问题,由于引入显著性检测作为匹配的主要方法,匹配点数量远远小于传统算法,且相比传统算法复杂度降低,有一定的优越性和研究价值.

[1] 曹之乐,严中红,王洪.双目立体视觉匹配技术综述[J].重庆理工大学学报(自然科学版),2015,29(2):70-75. CAO Zhile, YAN Zhonghong, WANG Hong. Summary of binocular stereo vision matching technology[J]. Chongqing University of Technology(Natural Science),2015,29(2):70-75.

[2] MCCULLAGH B. Real-time disparity map computation using the cell broadband engine[J]. Journal of Real-Time Image Processing,2012,7(2):87-93.

[3] 曾纪国,余国和,谢旭升,等.快速鲁棒的立体匹配方法[J],计算机工程与应用,2013,49(14):196-198. ZENG Jiguo, YU Guohe, XIE Xusheng, et al. Fast and robust stereo matching method[J]. Computer Engineering and Applications,2013,49(14):196-198.

[4] DE-MAEZTU L, VILLANUEVA A, CABEZA R. Stereo matching using gradient similarity and locally adaptive support-weight[J]. Pattern Recognition Letters,2011,32(13):1643-1651.

[5] JOGLEKAR J, GEDAM S S, MOHAN B K. Image matching using SIFT features and relaxation labeling technique: a constraint initializing method for dense stereo matching[J]. IEEE Transactions on Geoscience and Remote Sensing,2014,52(9):5643-5652.

[6] YOON K J, KWEON I S. Adaptive support-weight approach for correspondence search[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2006,28(4):650-656.

[7] XU Y, ZHAO Y, WU F, et al. Error analysis of calibration parameters estimation for binocular stereo vision system[C]//2013 IEEE International Conference on Imaging Systems and Techniques. Beijing: IEEE,2013:317-320.

[8] GU Z, SU X, LIU Y, et al. Local stereo matching with adaptive support-weight, rank transform and disparity calibration[J]. Pattern Recognition Letters,2008,29(9):1230-1235.

[9] XUE T, QU L, WU B. Matching and 3-D reconstruction of multibubbles based on virtual stereo vision[J]. IEEE Transactions on Instrumentation and Measurement,2014,63(6):1639-1647.

[10] BORJI A, SIHITE D N, ITTI L. Quantitative analysis of human-model agreement in visual saliency modeling: a comparative study[J]. IEEE Transactions on Image Processing,2013,22(1):55-69.

[11] GU Z, SU X, LIU Y, et al. Local stereo matching with adaptive support-weight, rank transform and disparity calibration[J]. Pattern Recognition Letters,2008,29(9):1230-1235.

[12] AZIZ M Z, MERTSCHING B. Pre-attentive detection of depth saliency using stereo vision[C]//2010 IEEE 39th Applied Imagery Pattern Recognition Workshop (AIPR). Washington:IEEE,2010:1-7.

An adaptive weight stereo matching algorithm based on visual saliency

WANG Chong, PAN Chen, GAO Haoran

(College of Information Engineering, China Jiliang University, Hangzhou 310018, China)

The traditional stereo matching algorithm rarely considers the characteristics of human eyes, so there is difference between the disparity map and the subjective human feelings. We presented a stereo matching algorithm based on adaptive weight. Firstly, the distinguishing visual images were introduced into the stereo matching algorithm to improve the original algorithm. Then, we proposed a new matching cost criteria. Finally, according to the left and right disparity map fusion, we obtained a disparity map in accordance with human perceptions. Related image experiments showed that the improved algorithm solved the problem of occlusion and accurately described the edges and details of the disparity map. It has better performance compared with the traditional methods.

stereo matching; adaptive weight; saliency detection; similarity measure; fusion disparity map

2096-2835(2016)04-0435-06

10.3969/j.issn.2096-2835.2016.04.014

2016-07-01 《中国计量大学学报》网址:zgjl.cbpt.cnki.net

浙江省自然科学基金资助项目(No.LY13F010004).

TP391

A