移动设备眼动跟踪技术

2016-08-01程时伟陆煜华蔡红刚

程时伟, 陆煜华, 蔡红刚

(浙江工业大学 计算机科学与技术学院, 浙江 杭州 310023)

移动设备眼动跟踪技术

程时伟, 陆煜华, 蔡红刚

(浙江工业大学 计算机科学与技术学院, 浙江 杭州 310023)

摘要:为了在移动设备上开发计算效率和精度较高的眼动跟踪技术,提出从人脸到瞳孔逐级推进的图像处理框架和具体检测方法.采用基于局部二值模式特征的级联分类器,对人脸和非人脸区域进行分类检测.在人脸区域内应用 Haar 特征级联分类器检测人眼区域;并使用模板匹配法在人眼区域内检测瞳孔位置.在此基础上开发基于眼动跟踪的移动设备阅读辅助系统, 根据瞳孔位置的变化定位用户当前阅读的文本行,帮助用户在阅读中断后快速找到阅读起点. 测试结果表明:该系统对视线角度的平均检测精度达到1.17°,能精确定位阅读文本,将用户的平均阅读速度提高到每秒12.42个字,验证了所提出的眼动跟踪技术的实用性.

关键词:眼动跟踪; 瞳孔检测; 人机交互; 阅读辅助

近年来, 随着眼动跟踪技术以及移动智能终端的飞速发展, 面向移动设备的眼动跟踪技术逐渐成为人机交互领域的一个研究热点. 然而受限于移动设备的软硬件配置(如:摄像头分辨率低等),无法实现精确的实时眼动跟踪, 通常只能依靠外部硬件设备的支持.相关研究人员提出了2类方法来实现移动设备上的眼动跟踪.1)使用外接硬件设备提高效率和精度[1-2].例如:额外配置高清摄像头等设备[3]捕捉人眼瞳孔图像及普尔钦斑[4],然后通过标定计算出用户视线在屏幕上的所在位置[5].此类方法由于需要外接其他硬件设备,导致眼动跟踪系统结构和配置变得复杂,且不利于携带,降低了实际应用中的易用性和便携性;2)使用移动设备自带硬件,进行较低精度的眼动跟踪.具体地,根据眼动跟踪的精度级别从低到高又可以分为3个层次:基于行为的眼动跟踪[6]、基于多区域平均的眼动跟踪[7-8]和基于像素的眼动跟踪[9-10].本文针对没有外部软硬件资源支持的情况, 提出一种基于移动设备自身有限计算资源的眼动跟踪方法, 在移动设备上实现较为高效和精确的眼动跟踪.综合考虑软硬件成本、技术可行性、眼动跟踪精度以及应用场景等因素,针对基于行为的眼动跟踪技术展开研究.定义主要应用场景如下:用户在阅读文本时,通常会进行换行,此时视线在屏幕水平或垂直方向将会有较大幅度的变化,导致用户的瞳孔位置也会随之出现较大变化;在此基础上,结合后台记录的已阅读文本行数,可以较精确地判断出用户当前视线所在的行.这类眼动跟踪技术,只有在瞳孔位置和视线方向出现较大幅度变化时,才具有较好的精确性.

1关键技术

由于移动设备自身在软硬件资源方面的限制,其计算性能远不如个人电脑;眼动跟踪技术在图像处理过程中需要占用大量计算资源, 有时还会导致眼动跟踪计算程序崩溃.因此,尽可能减少眼动跟踪程序运行时所占的计算资源,是在移动设备上实现眼动跟踪的关键.

图1 本文所提出的眼动跟踪技术框架Fig.1 Proposed framework of eye tracking technique

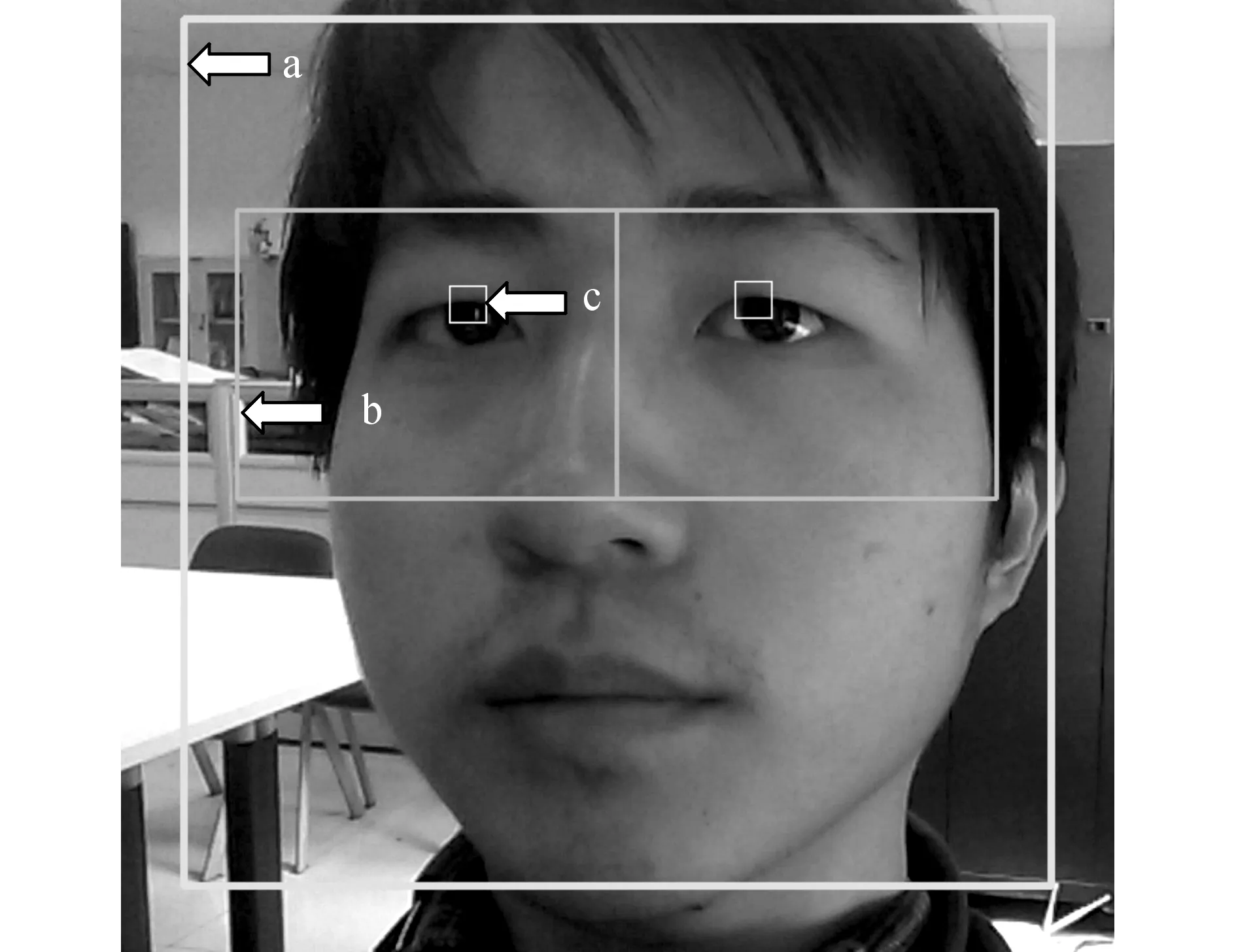

本文提出的眼动跟踪技术主要包括3个步骤:人脸检测、人眼检测和瞳孔检测,主要技术框架如图1所示.若在当前帧图像中未检测到人脸, 则直接开始下一帧图像的检测. 人眼检测和瞳孔检测要先获取图像上的感兴趣区域(regionofinterest,ROI), 然后在ROI内进行检测处理. 该技术可以大幅降低程序对移动设备计算资源的占用, 提升计算资源的利用效率.

1.1人脸检测

人脸检测是图像处理的第一个步骤,主要通过人脸检测分类器实现人脸检测.采用基于局部二值模式(localbinarypattern,LBP)[11-14]特征的AdaBoost级联分类器,对人脸和非人脸进行分类检测.LBP是一种用来描述图像局部纹理特征的算子,通过LBP算法得到图像3×3窗口的LBP值,并用这个值来反映该区域的纹理信息,最终可能获得256个不同的组合.基于LBP的描述方法可以很好地捕捉到图像中的细节,从而更易于获得人脸特征.级联AdaBoost算法是在级联的检测器中不断增加更多的强分类器[15-17].该算法可以很快排除背景区域,从而提高对近似人脸区域的检测效率.

从移动设备计算资源受限的角度考虑,对使用Haar特征分类器[18-20]和LBP特征分类器进行人脸检测的时间消耗进行测试.测试设备采用笔记本电脑(Corei3,CPU2.53GHZ,RAM4GB,Windows7 64位操作系统), 测试图片分辨率为846*826, 分别进行5次测试, 使用Haar算法平均耗时为911.7ms, 使用LBP算法平均耗时为324.5ms. 测试结果表明, 使用Haar特征和LBP特征进行人脸检测的精确度比较接近,但使用LBP特征进行人脸检测的耗时远小于使用Haar特征产生的耗时,可见使用LBP特征进行人脸检测所占用的计算资源较少.为此,本文选用LBP特征分类器在移动设备上进行人脸检测.

此外,在使用LBP特征级联分类器进行人脸检测时,可能在一张图片中检测到多个人脸区域.然而在实际应用中,绝大多数情况下移动设备用户使用前置摄像头所拍摄的图像中,该用户脸部所占区域通常会比其他人脸占据的区域更大.因此,选取人脸矩阵数组中面积最大的人脸区域作为当前用户的人脸区域,并在下一步人眼检测中进行处理.

1.2人眼检测

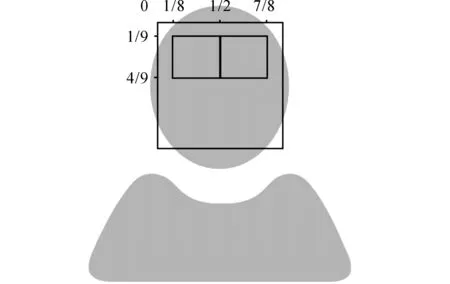

检测到人脸区域后将开始进行人眼检测.为了提高计算效率,首先进行人眼检测区域的预选取,即选取人脸区域的一部分用以检测人眼是否包含其中.如图2所示,在人脸区域中取横向1/8~7/8,纵向1/9~4/9构成当前所需检测的ROI.然后将该ROI平均划分为左右2个子ROI,其中左侧的子ROI命名为“lefteye”, 右侧的子ROI命名为“righteye”.多次实验表明,绝大多数人的人眼位置处于这2个子ROI中.以“lefteye”和“righteye”进行人眼检测区域预选取可以缩小人眼检测范围,降低程序对移动设备计算资源的占用.

图2 预选取检测区域提高人眼检测效率Fig.2 Pre-extracting detection area to improve efficiency of eye detection

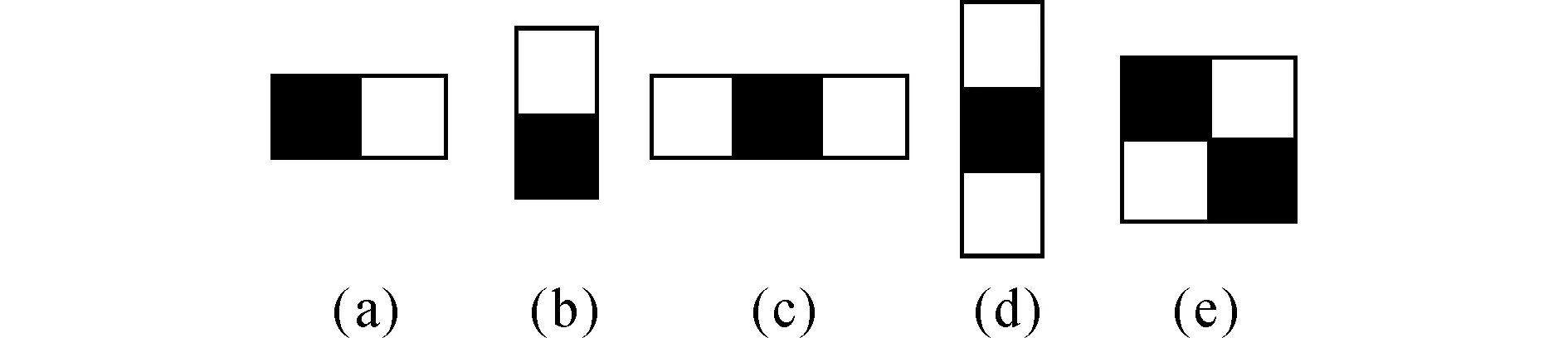

人眼检测区域预选取之后, 则进行正式的人眼检测. 人眼检测与人脸检测类似, 同样使用级联分类器. 但为了更好的检测人眼,提高准确度和可靠性,在人眼检测时选用了Haar特征级联分类器.该分类器由Haar-like特征、积分图方法和级联AdaBoost生成.Haar-like特征是根据区域灰度对比的特点来设计的,图3给出了几种常见的Haar矩形特征[18].

图3 选择Haar矩形特征进行人眼检测Fig.3 Select Haar rectangle features for eye detection

每个矩形特征分为黑白两部分,将图3中任意一个矩形特征放到人眼区域上,人眼特征值v等于白色区域的像素灰度值之和sw减去黑色区域的像素灰度值之和sb.例如,图3(b)中矩形特征的计算公式[18]为

v=sw-sb.

而图3(c)中的计算公式[18]为

v=sw-2sb.

此时将黑色区域的像素灰度值之和乘以2,是为了使2种颜色矩形区域中像素数目一致. 如果将矩形特征放到一个非人眼区域,那么计算出的特征值和人眼特征值是不一样的.所以矩形特征可以将人眼特征量化,以区别人眼和非人眼.

Haar特征值的计算涉及到区域像素灰度值之和的计算,由于图片子窗口众多,若重复计算像素灰度值之和会导致计算量过大,降低计算效率.本文采用文献[15]中的积分图方法计算Haar特征值.积分图方法只须遍历一次图片,就可以求出图片中所有不同区域像素灰度值之和,提高了计算效率.

最后通过级联AdaBoost算法训练得到人眼级联Haar特征分类器.使用Haar特征级联分类器在“lefteye”区域检测左眼,在“righteye”区域检测右眼.最终检测得到的人眼区域将在下一步瞳孔检测中被使用.

1.3瞳孔检测

瞳孔检测分为2个步骤:模板选取和模板匹配.

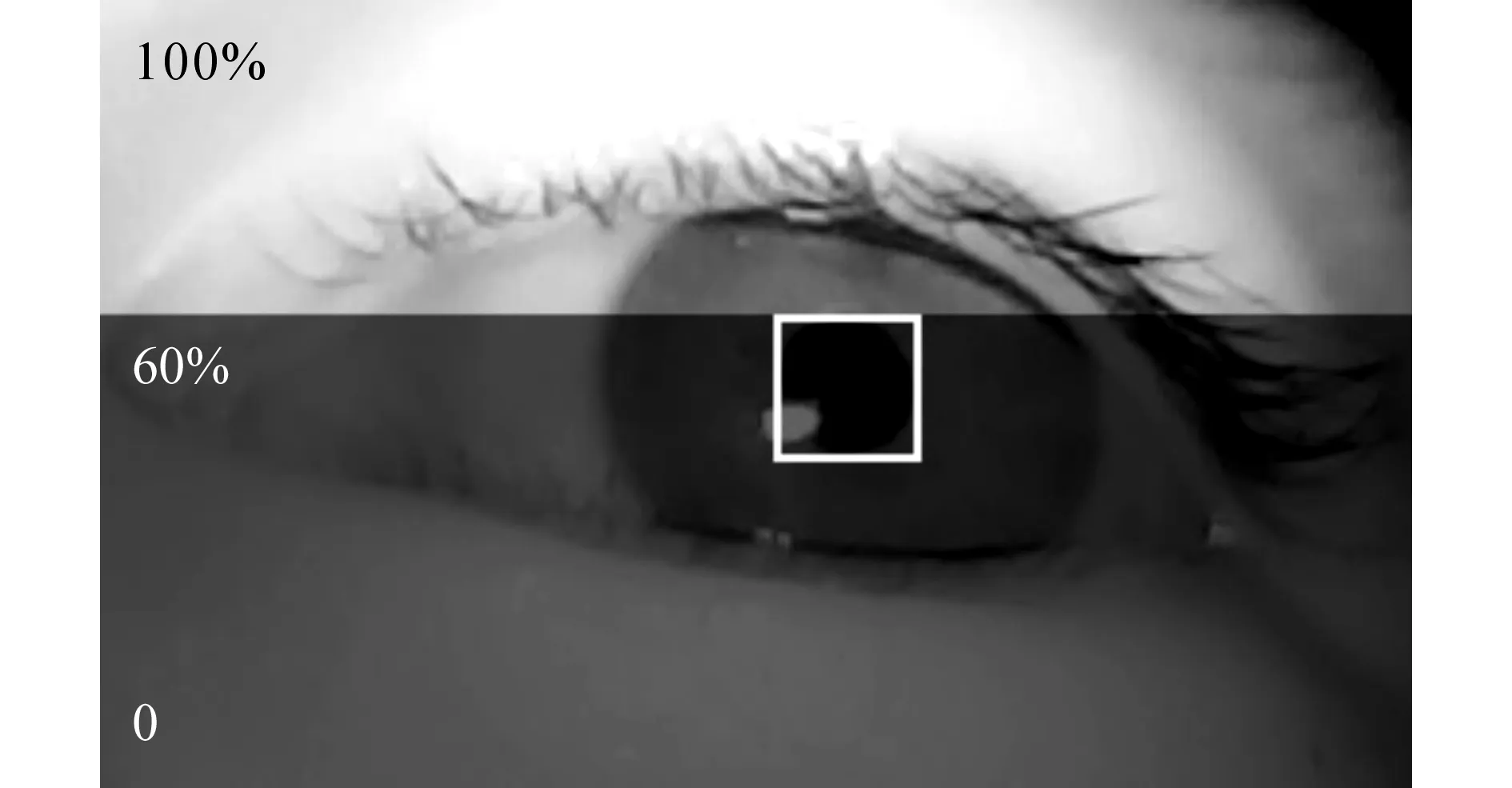

图4 避开睫毛选取瞳孔检测图像模板Fig.4 Exclude eyelash and select image template for pupil detection

1) 模板选取. 对程序开始运行后获取的前5帧图像进行处理(根据经验, 一般情况下前5帧图像中能获取较好的瞳孔模板图像),获取用户的瞳孔模板,用于第二步的模板匹配.第1.2节中人眼检测得到了左眼区域和右眼区域,而瞳孔必然存在于左、右眼中,因此现在只需要在左眼区域和右眼区域中检测瞳孔即可.瞳孔检测的难点在于眼睫毛的干扰,为此本文采取了一种简便方法,即选取人眼区域靠下方的60%区域作为ROI用以检测瞳孔(多次实验表明,靠下方的60%区域能有效排除眼睫毛干扰,同时还能保证该区域包含瞳孔).如图4所示的白色正方形所示,在ROI中选择灰度值最大的像素作为瞳孔中心,以边长为24个像素的正方形区域来建立瞳孔模板(实验表明这样大小的区域能较好地截取瞳孔图像模板),由此获得了左眼瞳孔模板(pupiltemplateL)和右眼瞳孔模板(pupiltemplateR).若获得的瞳孔模板不理想,导致瞳孔检测结果不佳,则可放弃此次选取结果,重新开始选取.

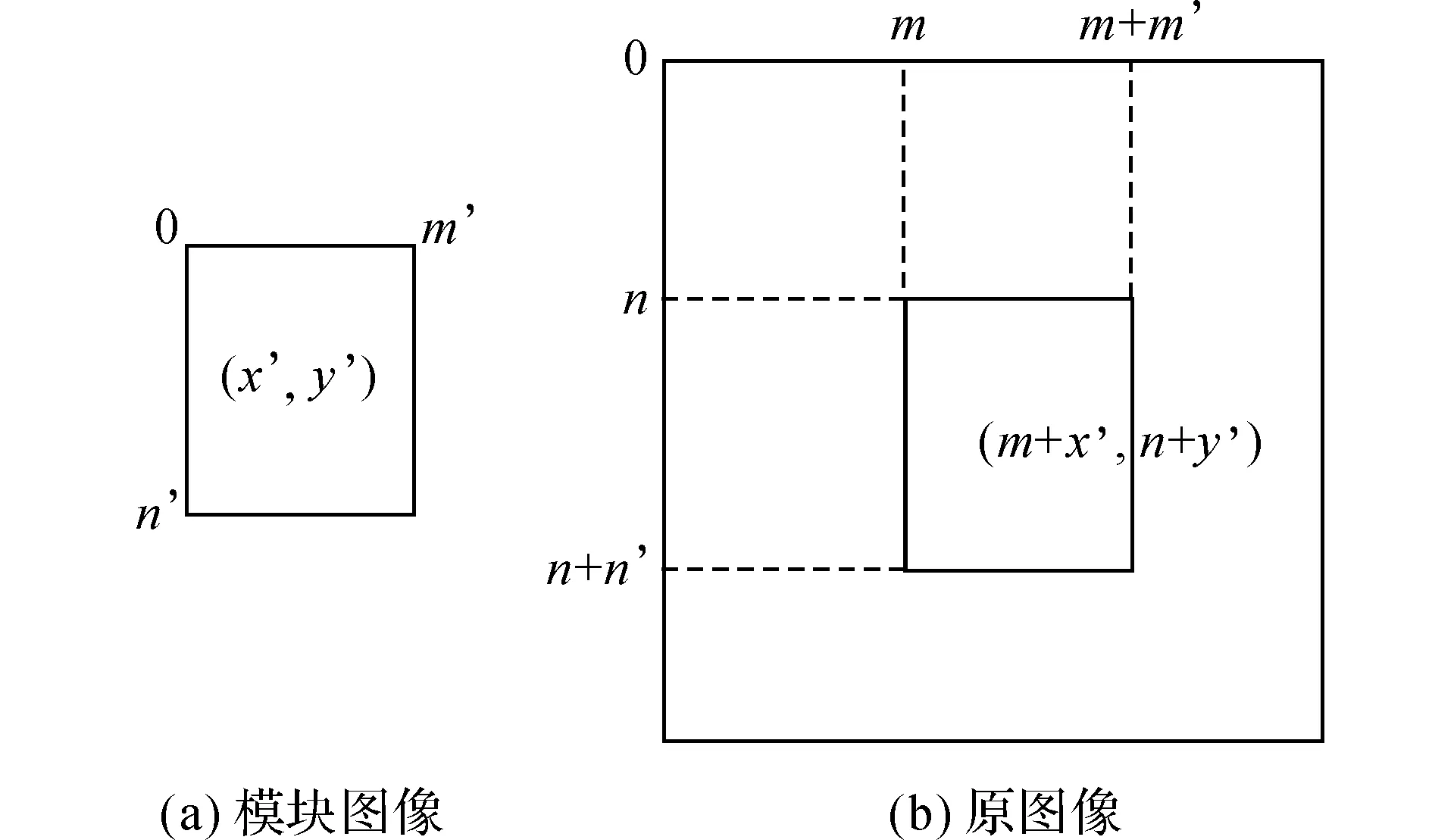

2)模板匹配. 具体采用平方差匹配法[21]进行模板匹配, 即利用原图与模板图像的像素灰度值平方差来进行匹配.模板匹配示意图如图5所示:

图5 用模板匹配法进行瞳孔检测Fig.5 Template matching method for pupil detection

图5(a)和5(b)分别为模板图像、原图像, 通过滑动模板图像与原图像进行比较, 计算原图像不同区域与模板图像的像素灰度值差[13]:

式中:R为平方差匹配结果,R值越小,匹配度越高, 最好匹配结果为0;T(x′,y′)表示模板图像中坐标为(x′,y′)处像素的灰度值;I(x,y)表示原图像中坐标为(x,y)处像素的灰度值.

由于模板匹配运算量较大,为了降低计算量,使用在人眼检测步骤中选取的左眼ROI和右眼ROI进行瞳孔模板匹配,获得左、右眼瞳孔区域.

通过上述步骤可以提高检测结果的稳定性.瞳孔检测结果如图6所示,其中a表示人脸区域、b表示人眼区域、c表示瞳孔区域.

图6 人脸、人眼与瞳孔检测结果示例Fig.6 Results of face、 eye and pupil detection

2应用实例与测试

2.1应用系统

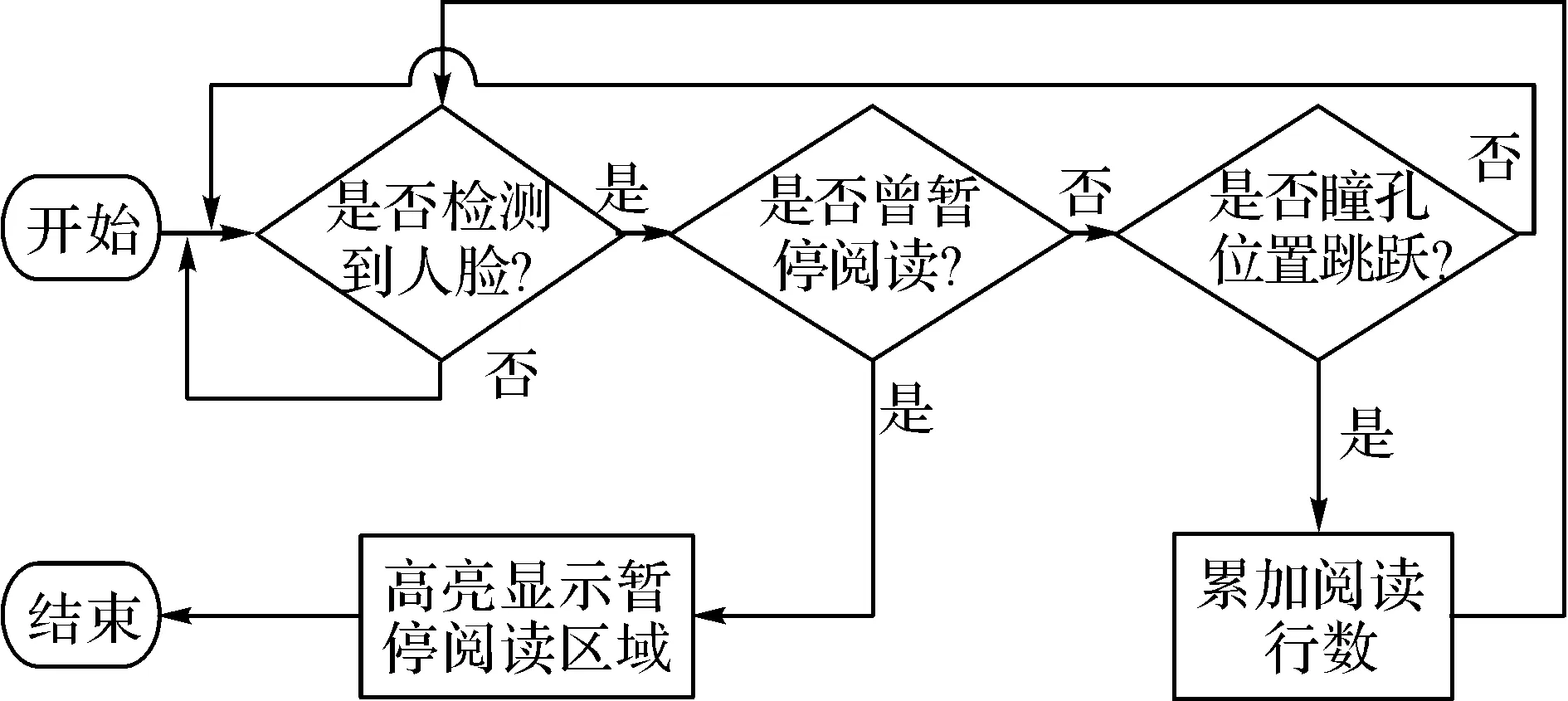

为了验证上述眼动跟踪技术的可行性与有效性,本文设计与开发了基于Android智能手机平台的阅读辅助系统.该系统可以检测出瞳孔位置,并根据瞳孔位置的变化累加阅读行数.如果用户在阅读过程中暂停阅读,视线离开屏幕(没有检测到人脸时,即认为暂停阅读);当视线返回屏幕重新开始阅读时,系统高亮显示暂停阅读时的相关部分(暂停阅读时所处的文本行及其前后2行文字),从而帮助用户快速定位阅读起点,提高用户阅读效率.该系统的基本工作流程如图7所示.

图7 基于眼动跟踪的阅读辅助系统工作流程Fig.7 Flow chart of eye tracking based reading assistance system

系统首先判断是否检测到人脸.为了提高人脸检测的稳定性,设定在每3次图像检测(每次图像检测间隔为300ms)中有2次以上检测到人脸时才判定检测到人脸.然后需要判断用户是否曾暂停阅读:设定参数r, r=1表示检测到人脸, r=0表示没有检测到人脸, r的初始值为0. 设前一个检测周期的人脸检测结果为rb, rb=1表示前一个检测周期检测到人脸, rb=0则表示前一个检测周期没有检测到人脸, rb的初始值为1. 判断用户是否曾暂停阅读具体算法步骤如下.

步骤1:进行人脸检测,更新r和rb值,若r=1则进入下一步;否则,重新开始执行步骤1;

步骤2:若r=rb,用户未暂停阅读,转到步骤1;否则认为用户曾暂停阅读,执行下一步;

步骤3: 判断瞳孔位置是否发生跳跃.

图8 用户阅读过程中由于换行引起的瞳孔跳跃Fig.8 Example of pupil skip caused by line wrap during text reading process

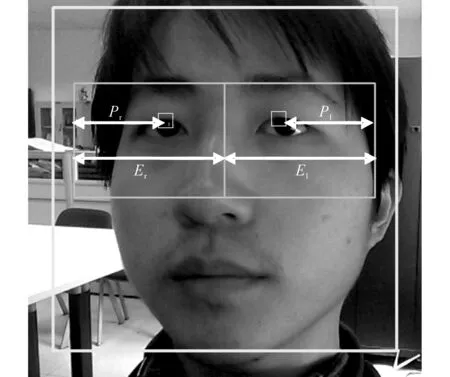

如图8所示为视线在文本上跳跃时与相应瞳孔图像的对应关系.瞳孔位置跳跃是指在阅读文本时(假定文本为水平方向的多行排版,用户从左至右阅读每行文本),用户在读完当前一行时,视线必然从该行结尾(最右侧)跳跃至下一行开头(最左侧),如图8(a)所示.

瞳孔跳跃在摄像头拍摄的图像中具体表现如下:短时间内,瞳孔从跳跃前时刻的位置跳跃至相对偏右的位置(摄像头所拍摄的图像与实际左右相反).图8(b)、8(c)分别为瞳孔跳跃前、后,瞳孔与眼眶的相对位置.图中,瞳孔跳跃前,瞳孔位置相对偏右,而在跳跃后,瞳孔位置向左移动,表明在瞳孔发生跳跃时,瞳孔位置发生明显变化.因此,可以根据瞳孔位置是否发生变化来判断是否发生瞳孔跳跃行为.

图9 根据瞳孔中心位置变化检测瞳孔跳跃Fig.9 Pupil skip detection by detecting change of pupil center position

识别瞳孔跳跃的具体计算如图9所示.获取左(右)瞳孔中心点相对于左(右)眼区域左(右)边框的距离Pl(Pr),以及左、右眼区域宽度El、Er.然后计算瞳孔中心离人眼区域左、右侧的比值Rl=Pl/El,Rr=Pr/Er.Rl和Rr的值在0~1.0. 设定Rlb和Rrb是前一个检测周期Rl和Rr的值.令L=|Rlb-Rl|,R=|Rrb-Rr|,若L和R同时大于0.03(该阈值通过大量实验得到),则认为瞳孔位置发生跳跃,进而判断用户在阅读过程中进行换行;同时累加已阅读的文本行数.如图10所示为用户不使用眼动跟踪时的普通阅读系统界面.

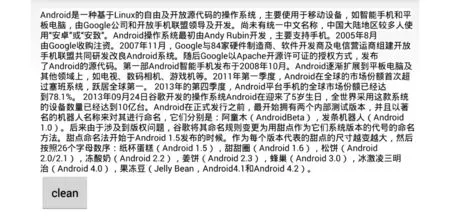

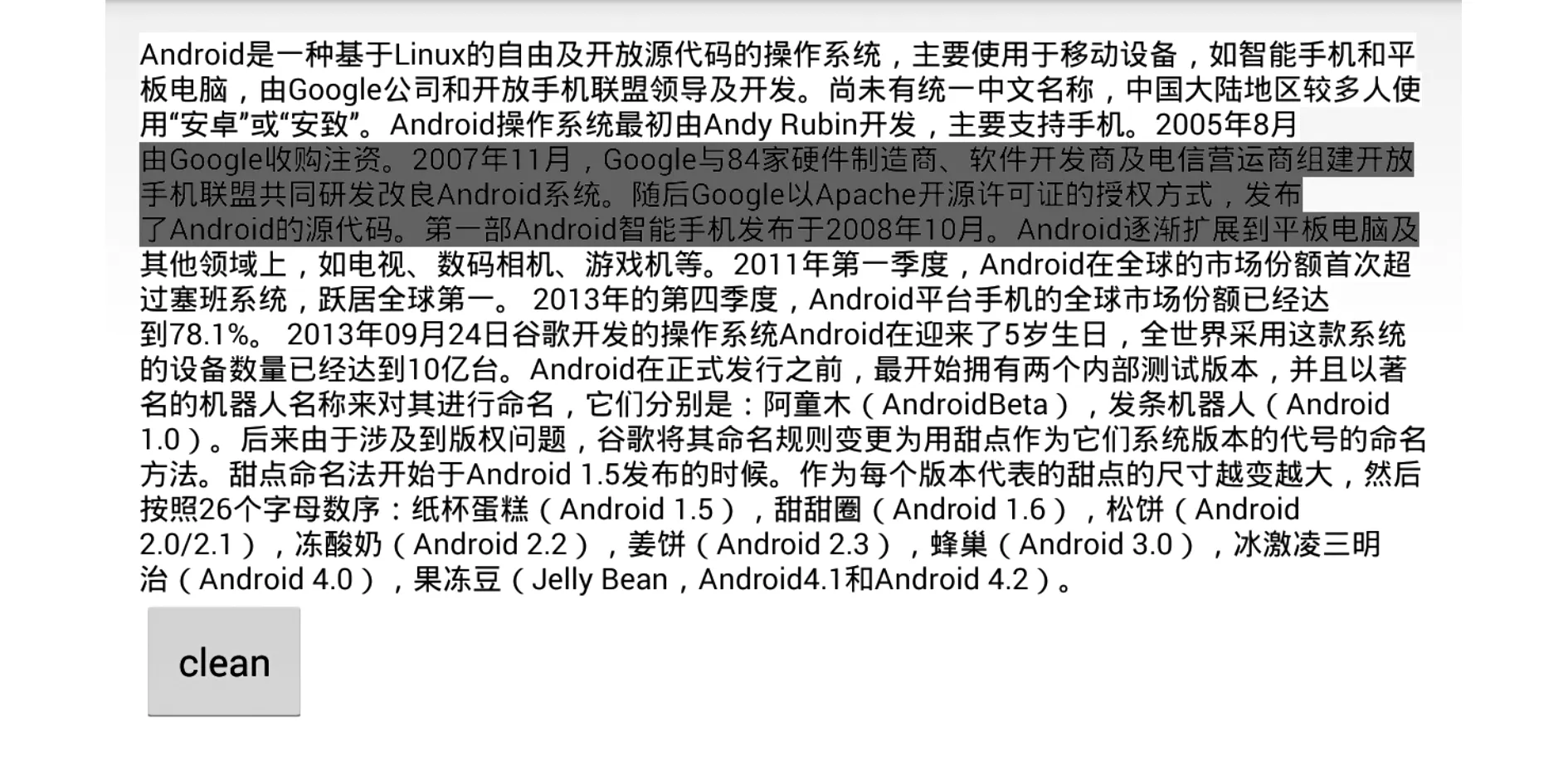

图10 没有利用眼动跟踪的阅读系统界面Fig.10 Reading system interface without eye tracking

图11 利用眼动跟踪高亮显示阅读暂停处Fig.11 Use eye tracking to highlight texts where user paused reading

如图11所示,若用户曾暂停阅读,当重新开始阅读时,使用眼动跟踪的阅读辅助系统将高亮显示用户暂停阅读时所处的一块区域.高亮显示区域的作用是吸引用户视线, 用户视线被吸引后将根据记忆在该块区域(即上下文)寻找重新阅读的起点,即高亮显示区域的作用是减小用户寻找重新阅读起点的范围,帮助用户快速找到阅读起点, 减少耗时,以此来提高用户的阅读效率.

相较于文献[6]选择高亮显示单行文本,本文选择高亮显示暂停阅读时的前后3行文本(暂停阅读时的当前行,以及前后各1行),原因是受限于普通移动设备的前置摄像头像素分辨率,瞳孔识别精度存在一定误差,导致阅读辅助系统对当前视线所处行的判断精度存在误差.因此,为了减少阅读辅助系统由于瞳孔识别误差对用户阅读过程的影响,提高系统的实用性,本文将高亮区域设计成3行.

2.2用户测试

为了验证眼动跟踪阅读辅助系统的有效性,本文对该系统进行了用户测试.实验采取组内测试方法,即用户分别使用阅读辅助系统和普通阅读系统,然后测试阅读速度,特别是在阅读过程中受到干扰需要暂停阅读时的阅读速度.

测试用的阅读材料是在字数、题材和理解难易程度均相似的2段中文短文(用户之前未曾阅读过).测试用的移动设备是一台智能手机,其屏幕大小为5.5英寸,分辨率1 280*720;CPU频率为1.6GHZ, 内存RAM2GB; 操作系统为Android4.3版本;前置摄像头分辨率为500万像素.2段阅读材料在手机屏幕上显示的字号均为14SP(scaledpixel).

共招募10名用户, 其中男性9名, 女性1名, 年龄在23~27岁. 这10名用户随机分成2组, 一组先使用眼动跟踪辅助阅读系统, 另一组先使用普通阅读系统, 然后各组再交换使用另一套系统. 每一套系统随机显示2段阅读材料中的一段,但保证每个用户在不同系统上阅读的材料不同,从而消除学习效应对阅读速度的影响.所有用户在正式测试前先进行短时间的训练,以排除对系统不熟悉导致的误差.训练时使用的阅读材料与正式测试时使用的阅读材料不重复.

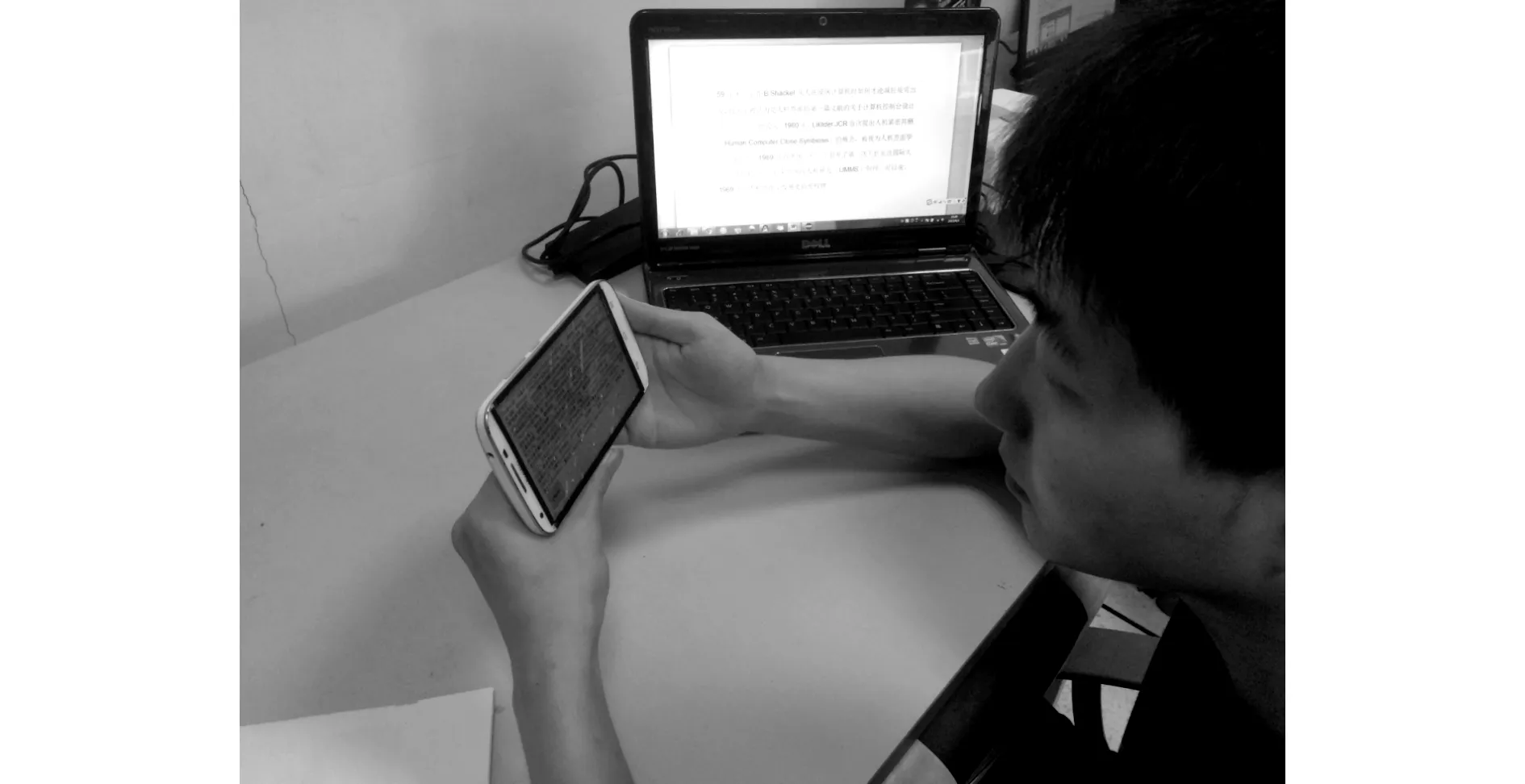

图12 用户在移动设备上进行眼动跟踪辅助阅读的测试场景Fig.12 User test scenario of reading texts on mobile device with eye tracking assistance

用户在移动设备上进行眼动跟踪辅助阅读的测试场景如图12所示.用户双手持手机阅读测试材料;右侧摆放一台个人电脑,显示一段与测试阅读材料无关的文本.用户在手机屏幕上进行阅读的过程中,被要求中断阅读,转而去阅读电脑显示屏上的一段文本,并在阅读完该段文本后,回答一个相关问题(以干扰用户对手机屏幕上所暂停那一行文本的记忆).然后用户的视线重新回到手机屏幕,继续进行阅读.此外,如果是使用阅读辅助系统,则为用户配备一支笔,要求用户在阅读时移动笔尖跟随自己的视线,方便实验人员观察用户实际的阅读进度,以便进行误差分析.

统计所有用户阅读测试文本的时间(排除阅读电脑上文本并回答问题的时间)和使用阅读辅助系统时的误差. 然后计算出所有用户的平均阅读速度(每秒可阅读字数),实验结果表明,在受干扰条件下(即阅读过程被短暂中断),使用阅读辅助系统的平均阅读速度为12.42字/秒(标准差为2.55字/秒),使用普通阅读系统的平均阅读速度为10.74字/秒(标准差为1.39字/秒).进一步,进行独立样本t检验,定义零假设:在受干扰条件下, 使用阅读辅助系统平均阅读速度和使用普通阅读系统平均阅读速度相同. 检验结果t=2.095, p<0.05,故零假设不成立,即可认为在干扰条件下,使用阅读辅助系统的阅读速度和使用普通阅读系统的阅读速度具有明显差异,且前者阅读速度大于后者阅读速度.由此可见,本文开发的阅读辅助系统在有干扰的条件下,对用户的阅读速度有明显的提升.

此外,测试过程中受到手机前置摄像头像素分辨率的限制,以及室内光照和背景环境干扰等问题的影响,造成瞳孔识别产生误差,从而影响阅读辅助系统的识别精度.测试过程中出现阅读辅助系统计算得到的阅读进度(即用户当前视线停留在哪一行文本)与实际阅读进度不匹配的情况,但其平均误差仅为1.10行(标准差为1.10行),且本文选择了高亮显示3行文本,因此降低了因阅读辅助系统识别误差对用户阅读造成的影响.

2.3与其他移动设备眼动跟踪系统对比

文献[1]和[5]采用头戴式外接硬件设备方法实现移动设备的眼动跟踪, 其优点是精确度较高.例如,文献[5]中的眼动跟踪系统平均精度达到2.0°,最高精度达到1.1°.即便如此,移动设备眼动跟踪系统采用外接硬件的方法具有明显缺点,即无法便捷的携带与使用,很难满足日常使用需求.

与文献[7]~[10]中的眼动跟踪系统相比,本文仅采用移动设备自带的前置摄像头,其优点是无须携带外接硬件设备,使用方便,符合移动设备日常使用需求.另一方面,这些眼动跟踪系统的识别精度和准确率较低.例如:文献[7]将手机屏幕划分为2×3网格,系统只能识别屏幕上这6块不同区域.文献[8]将手机屏幕划分为3×3网格,系统只能识别出屏幕上这9块区域,日光照射且静止条件下识别准确率仅有76%.文献[9]的系统在手机固定于桌面时识别准确率为79.1%,而在用户手持手机时识别准确率则降低为53.5%.文献[10]的系统全屏幕测试精度平均值为6.95°,且8位被测者中有3位被测者实验失败.本文系统主要关注于文本的行数识别,在用户测试中,手机屏幕上的文本一共有16行,平均识别误差仅为1.10行(在本文测试条件下换算成视角精度为1.17°),可较精确的识别出这16行文本,具有较高的实际应用价值.

3结语

本文面向移动设备提出了一种眼动跟踪技术,设计与开发了一个基于眼动跟踪的阅读辅助系统.测试表明:该系统能有效定位文本阅读时用户的视线位置,特别是在受干扰的情况下,能帮助用户快速找到暂停阅读时的起点,有效提升阅读速度,具有良好的实际应用价值.

下一步将提高瞳孔检测算法的鲁棒性和精确度,如:利用椭圆拟合算法进行瞳孔的实时检测,以及排除错误瞳孔模板对瞳孔检测的影响.此外,还将研究在不同场景下(例如:在不同光照情况下),如何提高瞳孔检测算法及阅读辅助系统的鲁棒性.

参考文献(References):

[1]GARCIAD,SINTOSI.EyeDROID:GazetrackingcomponentforAndroidSPCL-Autumn2014[J/OL]. [2015-05-13].http:∥www.itu.dk/~tped/teaching/pervasive/SPCL-E2014/draft01handins/02_EyeDROID-%20Gaze%20tracking%20component%20for%20Android.pdf.

[2]NAGAMATSUT,YAMAMOTOM,SATOH.MobiGaze:developmentofagazeinterfaceforhandheldmobiledevices[C]∥CHI′10ExtendedAbstractsonHumanFactorsinComputingSystems.NewYork:ACM, 2010: 3349-3354.

[3]LUKANDERK.Measuringgazepointonhandheldmobiledevices[C]∥CHI′04ExtendedAbstractsonHumanFactorsinComputingSystems.NewYork:ACM, 2004: 1556-1556.

[4]DEUBELH,BRIDGEMANB.FourthPurkinjeimagesignalsrevealeye-lensdeviationsandretinalimagedistortionsduringsaccades[J].VisionResearch, 1995,35(4): 529-538.

[5] 程时伟,孙志强.用于移动设备人机交互的眼动跟踪方法[J].计算机辅助设计与图形学学报, 2014, 26(8): 1354-1361.

CHENGShi-wei,SUNZhi-qiang.Anapproachtoeyetrackingformobiledevicebasedinteraction[J].JournalofComputer-AidedDesignandComputerGraphics, 2014, 26(8): 1354-1361.

[6]MARIAKAKISA,GOELM,AUMIMTI,etal.SwitchBack:usingfocusandsaccadetrackingtoguideusers’attentionformobiletaskresumption[C]∥Proceedingsofthe33rdAnnualACMConferenceonHumanFactorsinComputingSystems(CHI).NewYork:ACM, 2015: 2953-2962.

[7]KAOCW,CHENYW,YANGCW,etal.Eyegazetrackingbasedonpatternvotingschemeformobiledevice[C]∥ProceedingsofInternationalConferenceonInstrumentation,Measurement,Computer,CommunicationandControl.NewYork:IEEE, 2011: 337-340.

[8]MILUZZOE,WANGT,CAMPBELLAT.EyePhone:activatingmobilephoneswithyoureyes[C]∥ProceedingsoftheSecondACMSIGCOMMWorkshoponNetworking,Systems,andApplicationsonMobileHandhelds.NewYork:ACM, 2010: 15-20.

[9]PINOC,KAVASIDISI.Improvingmobiledeviceinteractionbyeyetrackinganalysis[C]∥ProceedingsofFederatedConferenceonComputerScienceandInformationSystems(FedCSIS).NewYork:IEEE, 2012: 1199-1202.

[10]WOODE,BULLINGA.Eyetab:model-basedgazeestimationonunmodifiedtabletcomputers[C]∥ProceedingsoftheSymposiumonEyeTrackingResearchandApplications(ETRA).NewYork:ACM, 2014: 207-210.

[11]OJALAT,PIETIKAINENM,MAENPAAT.Multiresolutiongray-scaleandrotationinvarianttextureclassificationwithlocalbinarypatterns[J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2002, 24(7): 971-987.

[12]LIW,FUP,ZHOUL.Facerecognitionmethodbasedondynamicthresholdlocalbinarypattern[C]∥Proceedingsofthe4thInternationalConferenceonInternetMultimediaComputingandService.NewYork:ACM, 2012: 20-24.

[13]SONGE,PANN,HUNGCC,etal.Reflectioninvariantlocalbinarypatternsforimagetextureclassification[C]∥Proceedingsofthe2015ConferenceonResearchinAdaptiveandConvergentSystems.NewYork:ACM, 2015: 210-215.

[14]EBADIT,KUKENYSI,BROWNEWN,etal.Human-interpretablefeaturepatternclassificationsystemusinglearningclassifiersystems[J].EvolutionaryComputation, 2014, 22(4): 629-650.

[15]VIOLAP,JONESM.Rapidobjectdetectionusingaboostedcascadeofsimplefeatures[C]∥Proceedingsofthe2001IEEEComputerSocietyConferenceonComputerVisionandPatternRecognition.NewYork:IEEE, 2001: 1511-1518.

[16]FREUNDY.Boostingaweaklearningalgorithmbymajority[J].InformationandComputation, 1995,121(2): 256-285.

[17]MAHALINGAMG,KAMBHAMETTUC.FaceverificationwithagingusingAdaBoostandlocalbinarypatterns[C]∥ProceedingsoftheSeventhIndianConferenceonComputerVision,GraphicsandImageProcessing.NewYork:ACM, 2010: 101-108.

[18]LIENHARTR,MAYDTJ.AnextendedsetofHaar-likefeaturesforrapidobjectdetection[C]∥Proceedingsof2002InternationalConferenceonImageProcessing.NewYork:IEEE, 2002: 1900-1903.

[19]REZAEIM,KLETTER.AdaptiveHaar-likeclassifierforeyestatusdetectionundernon-ideallightingconditions[C]∥Proceedingsofthe27thConferenceonImageandVisionComputingNewZealand.NewYork:ACM, 2012: 521-526.

[20]TENGZ,ZHANGB,LIUF.RailwayregiondetectionbasedonHaar-likefeatures[C]∥ProceedingsofInternationalConferenceonInternetMultimediaComputingandService.NewYork:ACM, 2014: 121.

[21] 刘宝生, 闫莉萍, 周东华. 几种经典相似性度量的比较研究[J].计算机应用研究, 2006, 23(11): 1-3.

LIUBao-sheng,YANLi-ping,ZHOUDong-hua.Comparisonofsomeclassicalsimilaritymeasures[J].ApplicationResearchofComputers, 2006, 23(11): 1-3.

收稿日期:2016-02-20.

基金项目:浙江省自然科学基金资助项目(LY15F020030); 国家自然科学基金资助项目(61272308, 61005056).

作者简介:程时伟(1981—), 男, 副教授, 硕导,从事人机交互、普适计算研究. ORCID:0000-0003-4716-4179. E-mail: swc@zjut.edu.cn

DOI:10.3785/j.issn.1008-973X.2016.06.021

中图分类号:TP 391

文献标志码:A

文章编号:1008-973X(2016)06-1160-07

Mobiledevicebasedeyetrackingtechnology

CHENGShi-wei,LUYu-hua,CAIHong-gang

(School of Computer Science and Technology, Zhejiang University of Technology, Hangzhou 310023, China)

Abstract:A hierarchical processing framework and the related detect approaches were proposed, treating images from face to pupil areas in order to develop high efficient and accurate eye tracking technique on mobile device. Firstly, local binary pattern based cascaded classifier was applied to classify face and non-face areas of the image. Then Haar feature based cascaded classifier was used to detect eye areas, and image template-matching method was applied to detect pupil position within eye areas. Finally, an eye tracking reading assistant system was developed, which could detect the change of pupil position and locate the text line where users currently read. The system could help users find the text line to continue reading when they were interrupted. The results of users’ test show that the system has eye tracking accuracy at 1.17° of visual angle in average, and can locate the text lines accurately. The system can help users achieve the average reading speed at 12.42 words per second. The effectiveness of the eye tracking technique was verified.

Key words:eye tracking; pupil detection; human-computer interaction; reading assistance