一种AGMM配准的尺度自适应目标跟踪方法

2015-07-24张立朝毕笃彦余旺盛

张立朝,毕笃彦,杨 源,余旺盛,覃 兵

(1.空军工程大学航空航天工程学院,陕西西安 710038;2.空军工程大学空管领航学院,陕西西安710051;3.空军工程大学信息与导航学院,陕西西安 710077)

一种AGMM配准的尺度自适应目标跟踪方法

张立朝1,毕笃彦1,杨 源2,余旺盛3,覃 兵1

(1.空军工程大学航空航天工程学院,陕西西安 710038;2.空军工程大学空管领航学院,陕西西安710051;3.空军工程大学信息与导航学院,陕西西安 710077)

针对视觉目标跟踪中目标尺度发生变化时容易发生跟踪失败的问题,提出基于不对称高斯混合模型配准的尺度自适应目标跟踪方法.不对称高斯混合模型配准把上一帧和当前帧图像的特征点集分别作为高斯混合模型高斯重心和数据点,并将特征信息与空间信息相融合;通过比较数据点与高斯混合模型高斯重心之间的相似程度,对两帧图像之间的点集进行配准,得到当前帧中可靠的特征点;点集的离散程度充分反映了目标尺度大小,通过仿射变换计算图像离散度比例变化,可以准确地估计出当前帧目标框的位置和尺度.实验表明,该算法对目标尺度变化具有较强的自适应性,并且在发生光照变化、复杂背景时,也可以达到很好的效果.

视觉跟踪;尺度自适应;不对称高斯混合模型配准;仿射变换;特征点集

目标跟踪[1-4]是计算机视觉领域的一个重点问题,也是难点问题.目标跟踪广泛应用于监控、视频编码以及军工领域.如何有效地在视频序列中对感兴趣目标进行有效跟踪,是计算机视觉中一个极具挑战性的课题.存在的挑战有快速目标移动、光照变化、遮挡和复杂背景.

尺度估计一直是目标跟踪的重点问题:在跟踪过程中,目标框尺度关系到下一帧目标位置及尺度的定位.当目标的尺度发生变化时,如何适应目标尺度的变化已成为跟踪任务的重点.目前对目标进行尺度估计的基本方法有:基于Lindeberg尺度空间理论[5];基于仿射变换[6];基于Bhattacharrya系数对尺度求导,得到尺度Mean shift[7];基于粒子滤波[8]的尺度估计,在原始尺度周围进行遍历;也有将Bhattacharrya系数换成Chi squared度量[9],然后在次最好结果的集合中挑选出最好的结果,进行尺度估计;还有在这些方法基础上改进的算法.但是这些尺度算法通常没有充分反映前后帧之间的配准信息,并且也缺乏对目标的特征信息和空间信息的综合描述.在跟踪过程中,目标的尺度可能变大或变小,一般情况下认为相邻两帧尺度变化不大,即目标的尺度随时间变化服从连续分布,为充分利用前后帧的配准关系并融合目标的特征信息和空间信息,笔者引入点集来描述这些信息,采用基于不对称高斯混合模型(Asymmetrical Gauss Mixture Models,AGMM)配准的点集[10]预测.相对于基于运动光流预测的个别点匹配算法[11]易受光照变化的影响,不对称高斯混合模型配准采用在高斯混合模型(GMM)[12]原始空间信息的基础上加入特征信息,并采用点集进行匹配,跟踪结果更准确,也更鲁棒.

笔者采用基于仿射变换的目标尺度估计算法,首先在上一帧目标区域和当前帧目标候选区域检测特征点集;然后利用不对称高斯混合模型配准对目标点集与候选目标点集进行匹配,得到当前帧中可靠的特征点;最后仿射变换计算图像离散度比例变化,准确地估计出当前帧目标尺度.

1 不对称高斯混合模型

1.1 不对称高斯混合模型构建

利用概率密度估计解决两个点集之间的匹配问题.在视频跟踪中,认为前一帧图像的点集为高斯混合模型重心,而当前帧图像的点集为数据点.假设St-1={yj|yj∈R2,j=1,…,m},St={xi|xi∈R2,i=1,…,n},分别为从前后相邻两帧图像中提取特征点集.把集合St-1的元素看做m个高斯混合模型重心,把集合St的元素看做通过高斯混合模型产生的数据点.高斯混合模型概率密度函数为

假定C(Y)是集合St-1中点的运动模型,∀yi∈St-1=yj+C(yj)是第j个高斯成分的新位置.考虑噪声点和局外点,加入归一化分布.将归一化分布的权重表示为1-ω(0≤ω≤1),混合模型为

其中,

p(xi|j)是关于xi的第j个高斯成分;p(o)=1/n,对局外点和噪声点进行建模;pij(i=1,…,n;j=1,…, m)是所有高斯成分的混合系数.在文献[10]中,每一个高斯混合模型成分被认为拥有相同的权重并且pij= 1/m.Θ={C(Y),σ},是运动参数;D是点集维数;σ是高斯成分的方差.

然而,除了考虑点集位置的一致性外,点集之间的特征相似性也是影响对应可靠性的重要因素.如果高斯分布重心与特征空间中的数据点非常相似,那么应该对这个高斯混合模型成分赋予大的权重,这样具有相似特征的点对拥有更多的机会组成一个对应关系.因此,不对称高斯混合模型权重定义为

其中,f(xi)和f(yi)分别表示点xi和yi的特征.

因此,似然函数关于局内点和局外点分布的混合模型为

为了更有效地解决复杂变形的点集配准,利用Tikhonov regularization定义先验概率,为

根据式(5)和式(6),后验概率p(Θ,ω|X)∝L(Θ,ω)p(C).因此,可以通过求解最大后验概率(Maximum A Posteriori,MAP)问题来估计参数Θ和ω.这相当于最小化负的log-posteriorε(Θ,ω):

其中,p(xi|Θ,ω)由式(2)给出.

1.2 期望最大算法求解

期望最大(Expectation-Maximization,EM)算法是一个求解MAP问题的很好算法.利用期望最大算法找出最优的Θ和ω.首先猜想参数的值,然后利用贝叶斯理论计算混合成分的后验概率分布,即算法的expectation或E-step.在M-step,获得新的参数值通过最小化ε(Θ,ω)的期望,即Q(Θ,ω).Q(Θ,ω)可以写为

E-step:通过贝叶斯理论计算混合成分的后验概率分布,即

其中,i=1,…,n,j=1,…,m.

式(9)表示样本xi与yi匹配的概率.概率越小,匹配越不可靠.因此,经过期望最大算法收敛后,匹配的概率可以用来滤除这些不稳定的匹配.给出一个阈值tp,概率小于tp的匹配可以当做非匹配点而移除掉.

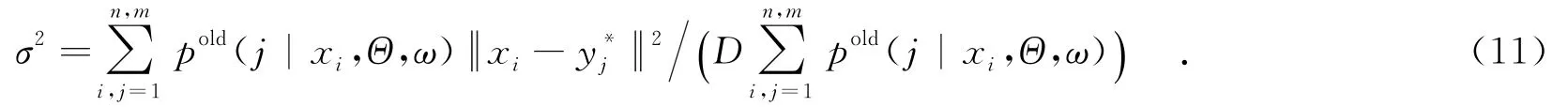

M-step:通过最小化能量函数Q(Θ,ω)更新参数Θ和ω.

其中,1是元素全为1的列向量,P是矩阵,且P(j,i)=p(j|xi,Θ,ω).

2 基于不对称高斯混合模型配准的尺度自适应目标跟踪

2.1 基于仿射变换的尺度自适应

选取2017年1月~10月期间收治的86例行胸、腹腔镜联合治疗的食管癌患者,按随机数字法分为对照组和观察组。对照组:男女性别比为22:21;年龄49~78岁,平均(56.8±6.4)岁。观察组:男女性别比为24:19;年龄49~78岁;平均(56.3±6.4)岁。两组一般资料比较无统计学意义(P>0.05)。

将混合高斯模型获得的点集进行可靠性处理之后,获得比较好的点集,在已知上一帧目标尺度的情况下,通过对这些点集仿射变换,计算出当前帧目标的尺度.经过后验概率p(j|xi,Θ,ω)小于阈值tp的非匹配滤除,留下可靠的匹配点,则第t-1帧图像It-1和第t帧图像It中可靠的匹配特征点分别为S′t-1={yj|yj∈R2,j=1,…,r}和S′t={xi|xi∈R2,i=1,…,r},如图1所示.

图1 匹配特征点

根据图1,分别计算点集S′t-1和S′t的离散度,再利用离散度计算仿射变换因子.

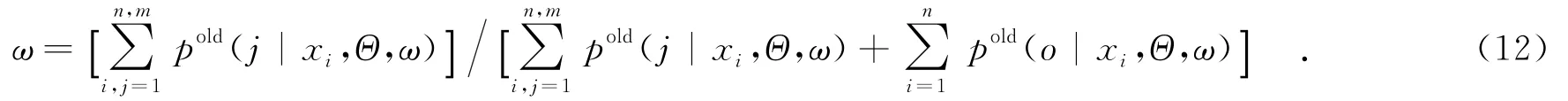

(1)It-1中目标在x和y方向的空间离散度分别为

(2)It中目标在x和y方向的空间离散度分别为

(3)仿射变换因子为

其中,{sx,sy}为目标水平、垂直方向的伸缩参数,{Δx,Δy}为平移参数.

选取匹配点进行仿射变换,考虑到实际中经常遇到的平移和伸缩运动,目标仿射变换模型为

其中,(xt-1,yt-1)和(xt,yt)分别为同一目标特征点分别在图像It-1和图像It中的位置.

当前帧的目标位置中心和目标尺度表示为(O,Obb)t,计算如下:中心点Ot通过上一帧中心点Ot-1加上偏移量计算,即目标框Obbt的宽度wt和高度ht分别通过上一帧Obbt-1的宽度wt-1和高度ht-1乘以伸缩参数{sx,sy}得到,即

2.2 算法流程

基于不对称高斯混合模型配准的尺度自适应目标跟踪算法流程如下.

输入:图像It-1和It,初始目标位置O0,初始目标框Obb0,采样点集S0;

输出:(O,Obb)t,It中匹配点集S′t;

For frame=t

3 实 验

3.1 不对称高斯混合模型配准实验

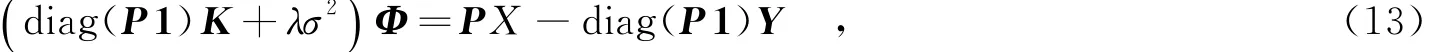

采用Mikolajczyk dataset[13]对不对称高斯混合模型配准的匹配映射进行评估,如图2所示.首先选3对典型的图像对(boat1,boat3),(trees1,trees5)和(bikes1,bikes3),用来说明不对称高斯混合模型算法的匹配表现,一个匹配采用一个带方向的箭头表示.不对称高斯混合模型配准算法不单纯考虑图像的空间信息,同时加入目标的特征信息.文中的特征信息采用尺度不变特征转换(Scale Invariant Feature Transform, SIFT)特征[14],即式(4)的f(xi)与f(yi)利用尺度不变特征转换描述子来计算,采样尺度不变特征转换特征点并在高斯混合模型中加入目标的尺度不变特征转换特征权重.尺度不变特征转换特征提供先验信息,根据式(4),不对称高斯混合模型中高斯混合模型的权重根据尺度不变特征转换描述子匹配程度进行不同程度的调整,对不同的高斯成分赋予不同的权重,减少误匹配点和奇异点,提高正确匹配点的数目以提取到目标更多的特征点,并且能够准确估计目标的旋转及一些尺度的变化.非匹配点过滤阈值tp设为0.3,不对称高斯混合模型算法能够滤除掉绝大多数非匹配特征点而留下准确匹配的特征点.

3.2 跟踪实验

(1)‘CarScale’视频序列.为测试上述算法对目标尺度变化的自适应性,采用的视频序列为Bench Mark数据库[15]中‘CarScale’视频,序列长度为252帧.图3矩形框中标出的为跟踪目标,实验测试了目标由远及近逐渐变大的过程中,本算法对目标尺度变化的自适应性,并与文献[11]使用运动光流仿射变换的TLD算法进行比较.分别挑选了#1、#128、#150、#161、#216和#221等具有代表性的几帧跟踪结果图.可以看出,开始时目标的尺度比较小,TLD算法可以较好地跟踪上,随着目标的尺度不断变大,从第128帧起目标尺度变化已经很大,依赖于检测模板的TLD算法由于目标模板都是初始化的小尺度模板,而得不到及时更新,因此不能适应目标尺度的变大.如图3所示,笔者提出的算法可以及时适应目标尺度的变化,原因在于采用了不对称高斯混合模型配准的匹配跟踪,在不对称高斯混合模型配准的同时考虑目标的空间信息和特征信息,根据目标尺度的变化调整特征权重的大小.选用尺度不变特征转换点作为特征点,主要原因是其具有尺度不变特性并且对光照旋转等变化具有较强的抗干扰性.尺度不变特征转换特征点集的元素个数比较多,这样能够更好地适应目标配准.在进行仿射变换时,点集中特征点主要分布在目标的边缘轮廓上,能够充分反映目标的外观特征,点集之间的离散度之比正比于目标外形轮廓的尺度之比.因此根据上一帧目标的尺度及比例变化因子,利用仿射变换可以非常准确地求解出目标在当前帧中的尺度.从图3中可以看出,当目标的尺度不断变大时,即使受一些光照、复杂背景的干扰,笔者提出的算法也可以准确地跟踪目标.

图2 不对称高斯混合模型配准的匹配映射

图3 TLD算法和笔者提出的算法对‘CarScale’的跟踪结果

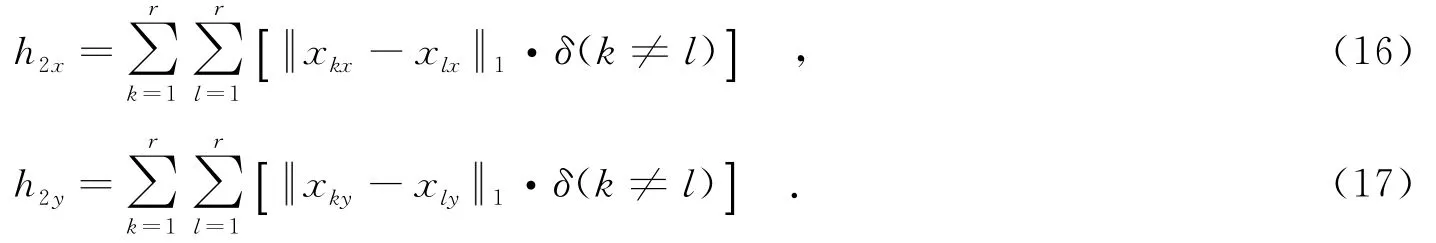

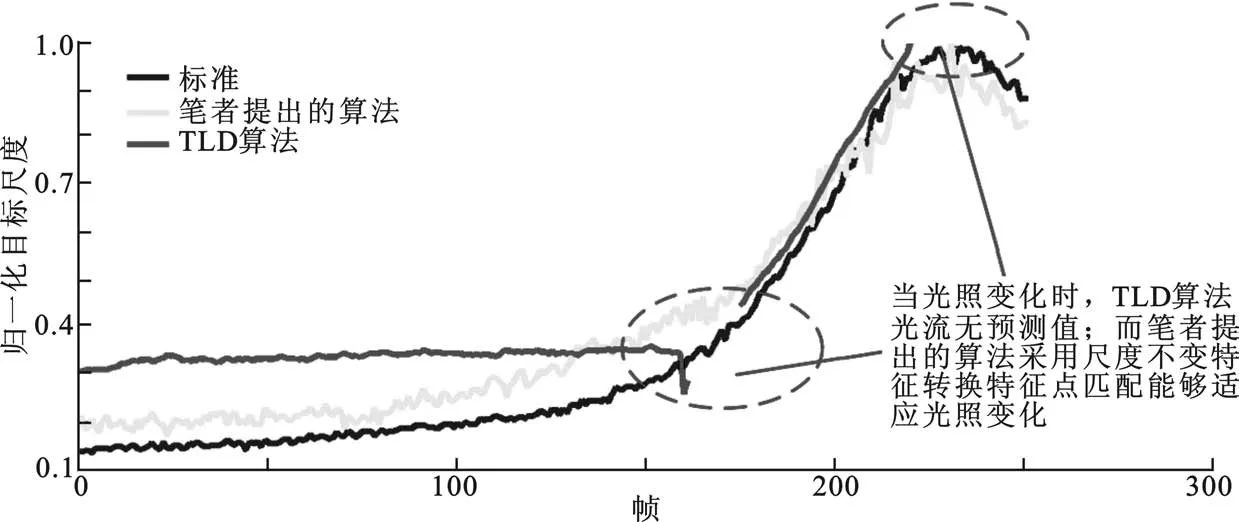

图4主要测试了目标尺度变化时,笔者提出的算法和比较算法对尺度变化的适应性.从图4中可见,虽然两种算法得到的目标尺度变化均反映了目标的变化趋势,但笔者提出的算法得到的目标尺度变化与目标实际的尺度变化贴合较好,而TLD算法计算的尺度均低于目标实际的尺度,且离实际尺度变化曲线较远,在163~175帧和222~252帧处,由于光照变化导致光流无预测值.

图4 目标尺度变化对比

(2)‘Dog1’视频序列.为测试笔者提出的算法对目标尺度变化的自适应性,采用的视频序列为Bench Mark数据库[15]中‘Dog1’视频,序列长度为1 350帧.同样与TLD算法[11]进行比较.实验测试了目标由远及近逐渐变大的过程中,笔者提出的算法对目标尺度变化的自适应性,并与TLD算法中的尺度自适应算法进行了比较.分别挑选了#100、#494、#736、#1154、#1214和#1221等具有代表性的几帧跟踪结果图.当目标的尺度和方向发生较大变化时,TLD算法跟踪效果并不好,跟踪发生漂移并且不能适应尺度变化,如图5所示.同样笔者提出的算法也在‘Dog1’序列上进行测试,可以看出,笔者提出的算法能够适应目标尺度由小变大、再由大变小的过程,并且当目标姿态发生变化时,也会准确地跟踪目标.

图5 TLD算法和笔者提出的算法对‘Dog1’的跟踪结果

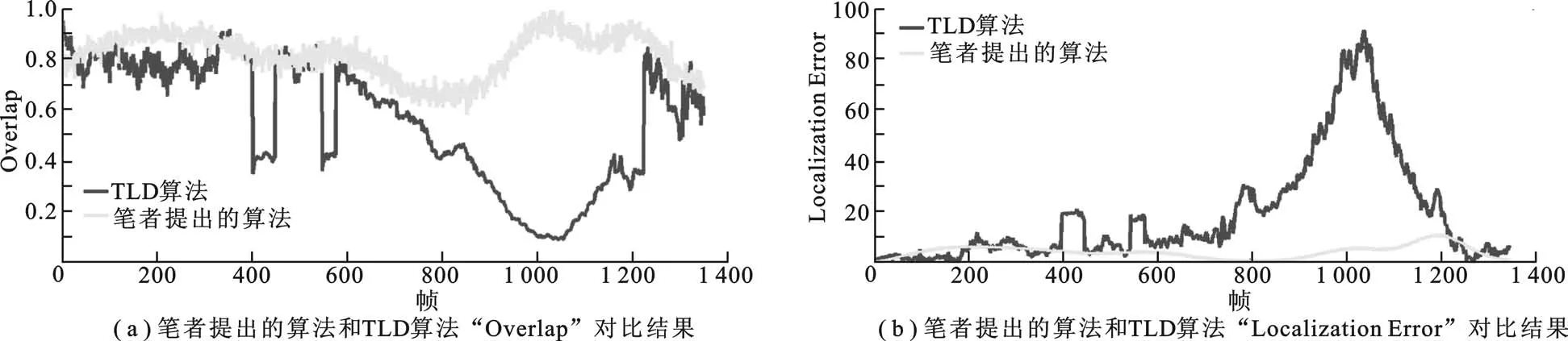

图6为整个‘Dog1’视频序列笔者提出的算法和TLD算法的跟踪性能比较结果.从‘Overlap’和‘Localization Error’[16]曲线图可以看出,在915~1 100帧,当视频尺度增大时,TLD算法由于跟踪模块预测不准并且模板更新不及时,导致不能适应目标尺度的变化,而出现较大的误差,主要体现在‘Overlap’变小、‘Localization Error’变大,即出现波谷和波峰的误差.

图6 视频序列‘Dog1’的比较结果

4 总结与展望

笔者提出基于不对称高斯混合模型配准的尺度自适应目标跟踪算法,在利用不对称高斯混合模型算法进行配准的基础上,计算出各个点集离散度,利用仿射变换对目标进行定位、尺度计算和方向计算.接着处理下一帧时,同样对相邻两帧之间的点集进行配准,然后进行几何仿射变换.如此往复下去,便可自适应地实现视频序列目标尺度和位置的定位跟踪.通过实验,验证了笔者提出的算法对目标尺度变化的自适应性,与目前优秀的算法比较,可以发现笔者提出的算法具有良好的尺度处理能力,并且通过引入尺度不变特征转换特征点,点集配准对光照具有较强的抗干扰性.点集之间离散度之比反映了相邻两帧之间目标尺度之比,通过仿射变换,可以非常准确地自适应目标尺度.

利用不对称高斯混合模型配准时,笔者采用尺度不变特征转换特征点集,可以考虑采用性能优良且速度较快的特征信息:通过哈希投影将实值描述符转化为二值描述子[17],一方面可以降低目标匹配的运算量,提高跟踪速度;另一方面可以降低描述符所占存储空间,提取更多的特征点,从而提高配准的精度.在下一步工作中,笔者将努力解决这个问题.

[1]Smeulders A W M,Chu D M,Cucchiara R,et al.Visual Tracking:an Experimental Survey[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2014,36(7):1442-1468.

[2]Zhong B,Yao H,Chen S,et al.Visual Tracking via Weakly Supervised Learning from Multiple Imperfect Oracles[J]. Pattern Recognition,2014,47(3):1395-1410.

[3]Li X,Hu W,Shen C,et al.A Survey of Appearance Models in Visual Object Tracking[J].ACM Transactions on Intelligent Systems and Technology,2013,4(4):58.

[4]Liu H,Yuan M,Sun F,et al.Spatial Neighborhood-constrained Linear Coding for Visual Object Tracking[J].IEEE Transactions on Industrial Informatics,2014,10(1):469-480.

[5]Collins R.Mean-shift Blob Tracking through Scale Space[C]//Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Washington:IEEE Computer Society,2003:234-240.

[6]彭宁嵩,杨杰,刘志,等.Mean-Shift跟踪算法中核函数窗宽的自动选取[J].软件学报,2005,16(9):1542-1550. Peng Ningsong,Yang Jie,Liu Zhi,et al.Automatic Selection of Kernel-bandwidth for Mean-shift Object Tracking[J]. Journal of Software,2005,16(9):1542-1550.

[7]Vojir T,Noskova J,Matas J.Robust Scale-Adaptive Mean-Shift for Tracking[C]//Lectures Notes in Computer Science:7944.Heidelberg:Springer Verlag,2013:652-663.

[8]Ross D,Lim J,Lin R S,et al.Incremental Learning for Robust Visual Tracking[J].International Journal of Computer Vision,2008,77(1):125-141.

[9]Naik N,Patil S,Joshi M.A Scale Adaptive Tracker Using Hybrid Color Histogram Matching Scheme[C]//Proceedings of the IEEE International Conference on Emerging Trends in Engineering and Technology.Piscataway:IEEE Computer Society,2009:279-284.

[10]Myronenko A,Song X B.Point-set Registration:Coherent Point Drift[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,32(12):2262-2275.

[11]Kalal Z,Mikolajczyk K,Matas J.Tracking Learning Detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,6(1):1-14.

[12]Jian B,Vemuri B.Robust Point Set Registration Using Gaussian Mixture Models[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33(8):1633-1645.

[13]Mikolajczyk K,Schmid C.A Performance Evaluation of Local Descriptors[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2005,27(10):1615-1630.

[14]Lowe D G.Distinctive Image Features from Scale-invariant Keypoints[J].International Journal of Computer Vision, 2004,60(2):91-110.

[15]Wu Y,Lim J W,Yang M H.Online Object Tracking:a Benchmark[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Los Alamitos:IEEE Computer Society,2013:2411-2418.

[16]Everingham M,Van Gool L,Williams C K,et al.The Pascal Visual Object Classes(VOC)Challenge[J].Interational Journal of Computer Vision,2010,88(2):303-338.

[17]Li X,Shen C,Dick A,et al.Learning Compact Binary Codes for Visual Tracking[C]//Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Washington:IEEE Computer Society,2013: 2419-2426.

(编辑:郭 华)

Visual object tracking with the adaptive scale based on AGMM point sets matching

ZHANG Lichao1,BI Duyan1,YANG Yuan2,YU Wangsheng3,QIN Bing1

(1.School of Aeronautics and Astronautics Engineering,Air Force Engineering Univ,Xi’an 710038, China;2.School of ATC Pilot,Air Force Engineering Univ.,Xi’an 710051,China;3.School of Information and Astronautics Navigation,Air Force Engineering Univ.,Xi’an 710077,China)

A visual object tracking method with the adaptive scale based on AGMM(Asymmetrical Gauss Mixture Models)point sets matching is proposed aimed at adaptively following the object’s scale changes, which often cause tracking failure.As the feature point set in the last frame is considered as the GMM centroids and the feature point set in the current frame represents the data respectively,AGMM fuses the feature information and spatial information;by comparing the similarity between data and GMM centroids, we match the point sets between two adjacent frames and obtain the reliable feature points in the current frame;the degree of dispersion between points in the point set accurately reflects the size of the object scale and by using affine transformation,the proportion of the two point sets is computed to estimate the position and scale of the bounding box in the current frame accurately and effectively.Experimental results demonstrate that the method is adaptive to scale change and has advantage in illumination variation and color similar target tracking.

visual tracking;adaptive scale;asymmetrical Gauss mixture models alignment;affine transformation;feature point set

TP391

A

1001-2400(2015)05-0175-08

2014-05-08< class="emphasis_bold">网络出版时间:

时间:2014-12-23

国家自然科学基金资助项目(61202339);博士后基金面上资金资助项目(2012M512144);陕西省自然科学基金资助项目(2012JQ8034)

张立朝(1990-),男,空军工程大学硕士研究生,E-mail:zlichao2012@163.com.

杨 源(1981-),男,副教授,E-mail:yangyuan@126.com.

http://www.cnki.net/kcms/detail/61.1076.TN.20141223.0946.029.html

10.3969/j.issn.1001-2400.2015.05.029