基于时空轨迹跟踪的交通流特性参数检测分析

2015-04-19任建强陈阳舟石建军

任建强,陈阳舟,辛 乐,石建军

(1.北京工业大学 城市交通学院,北京100124;2.廊坊师范学院 计算机系,河北,廊坊065000)

基于时空轨迹跟踪的交通流特性参数检测分析

任建强1,2,陈阳舟*1,辛 乐1,石建军1

(1.北京工业大学 城市交通学院,北京100124;2.廊坊师范学院 计算机系,河北,廊坊065000)

基于视频的交通流检测在智能交通系统中具有重要意义.本文针对广泛采用的低位摄像机,提出了一种交通流特性参数的检测分析方法.首先基于三级虚拟检测线和自适应更新率局部背景建模来快速提取车辆特征点并消除活动阴影对提取精度的影响;然后基于Adaboost(Adaptive Boosting,自适应增强)分类器实现特征点按车分组,并在跟踪过程中根据运动特征相关度消除分组误差,获取高精度的车辆轨迹;进而自动生成多车道轨迹时空图并提取各车道交通流的多种特性参数.实验结果验证了算法的高效性;同时,自动生成的多车道轨迹时空图也为更多的交通信息获取和更深入的交通流特性分析提供了有力支持.

智能交通;交通流特性参数检测;时空轨迹跟踪;低位摄像机

1 引 言

近年来,ITS(Intelligent Transportation Systems,智能交通系统)的研究日益广泛[1].基于视频的交通流监测分析是ITS的重要内容,其研究与应用具有重要的理论意义和实用价值.基于低位摄像机的交通流监测方式具有安装和维护方便的优点,相对于高空架设摄像机[2]和航空摄像机[3,4]方式而言成本更低、可靠性更高、应用更广.

低位摄像机场景中的车辆相互遮挡严重影响交通流检测精度.基于特征点检测与跟踪的方法为问题的解决提供了有效途径,但现有方法对特征点的车辆归属判定精度不理想[5,6],在提取车辆轨迹时的定位误差较大.另外,传统的特征点提取方法多是直接在整幅帧图中进行,提取速度较慢且提取精度易受冗余背景及活动阴影的影响.文献[7]虽然提出了基于虚拟检测线的改进方法,但其特征点分组效率仍有待提高.基于已有工作,本文运用虚拟检测线和自适应更新率局部背景建模相结合的技术高效提取车辆特征点并将Adaboost(Adaptive Boosting,自适应增强)分类器运用到特征点按车分组中,有效解决了上述问题,进而在跟踪基础上自动生成车辆轨迹时空图并完成多种交通参数的高精度自动提取.同时,自动生成的轨迹时空图也为更深入地分析交通流特性提供了有力支持.

2 算法概述

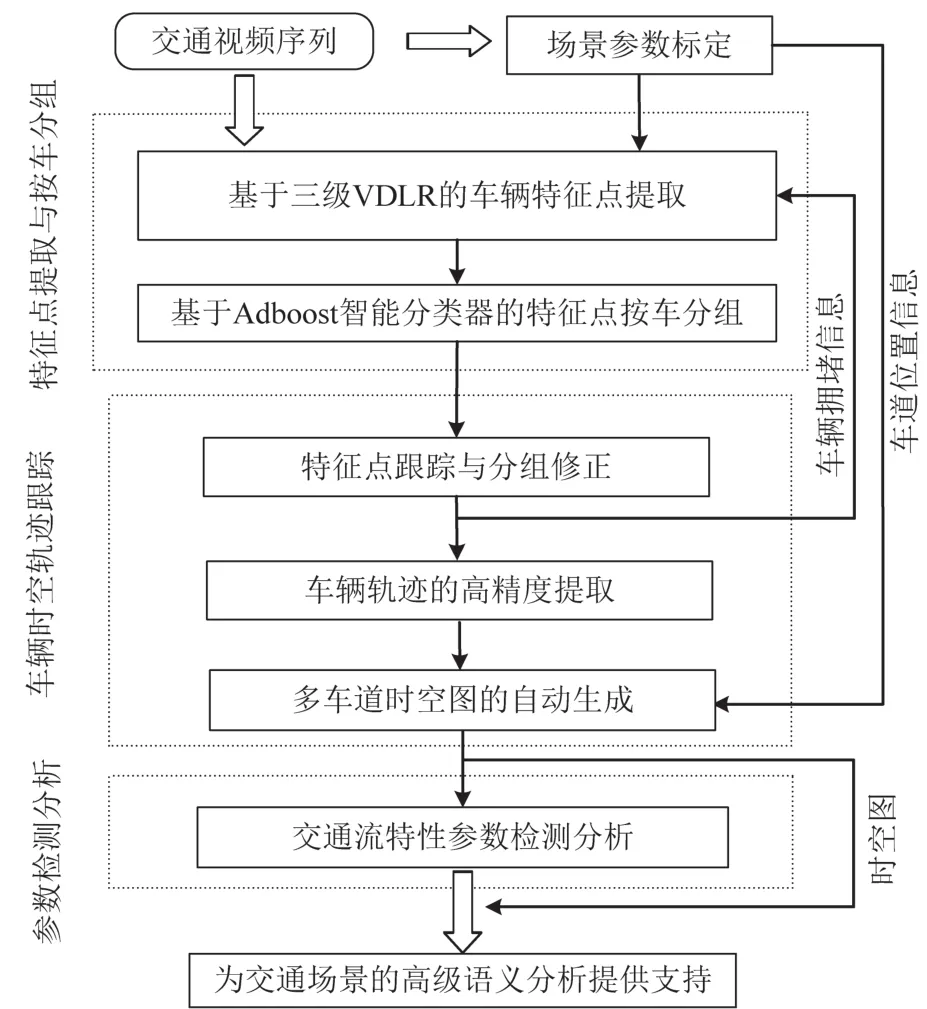

本文方法的总体框图如图1所示,共分四个步骤:

(1)场景参数标定.

主要包括设置路面感兴趣区域及车道位置、标定摄像机参数及在交通流上游设置垂直于车道的三级VDL(Virtual Detection Line,虚拟检测线),只在系统安装时人工完成.

(2)特征点提取与按车分组.

基于三级VDLR(VDL Region,虚拟检测线区域,即以各VDL为中心线、在沿车道方向上取样9像素高度的区域)和自适应更新速率局部混合高斯背景模型来精确提取车辆无阴影前景特征点;同时,基于Adaboost分类器进行车体区域识别和特征点的按车分组,提高分组精度.

(3)车辆时空轨迹跟踪.

对分组后的特征点,在后继帧的图像金字塔中计算稀疏光流并结合局部二元纹理特征进行特征点匹配来实现跟踪.同时基于运动特征相关度对特征点进行分组修正;然后设计了中心垂直最近最长轨迹法提取车辆轨迹,有效消除投影误差;进而为每条车道自动生成纵向(沿车道方向)轨迹时空图并生成含所有车道的横向(垂直于车道方向)轨迹时空图.

(4)基于各轨迹时空图自动提取交通流的多种特性参数.

图1 总体框图Fig.1 Block diagram of the proposed method

3 特征点提取与按车分组

3.1 特征点提取

车辆特征点的提取基于三级VDLR实现,对各VDLR内的每个像素,根据其在最近历史帧中的采样值{X1,X2,…,Xt-1}采用K(K∈{3,4,5})个高斯分布的叠加进行建模,对其新像素值Xt与该点各高斯分布进行匹配并更新高斯分布,更新速率α满足0≤α≤1.实验表明,交通畅通时的α取0.001–0.005能获得好的效果.但考虑到出现交通拥堵时,可能会有排队车辆恰好停在(或非常缓慢的移动在)VDL上,此时若仍按畅通速率更新背景,则会将车辆误判为背景.对此,提出Log-Sigmoid动态自适应更新速率[7]为

式中 α0为畅通时的更新速率;β决定Log-Sigmoid型函数的陡度;l是跟踪程序反馈而来的车体区域特征点组到VDL3的最小像素距离,考虑到车辆之间会存在一定的间隙,在l大于0但小于等于间隙时停止背景更新.此间隙一般不超过1辆车长,本文以场景中车辆的平均长度统计值ξ为间距估计值,ξ基于前两级VDL生成的当前时刻之前的两级FPVI(Foreground Panoramic View Image,前景全景视图)[8]计算得到.FPVI共三级,分别按式(2)将视频在三级VDL上的前景像素信息按时序排列生成.

在得到各VDLR的背景后,基于背景差分法分割活动前景并采用前景与对应位置处的背景局部纹理特征相似性原理[8]有效去除前景中包含的车辆活动阴影.然后,利用文献[9]的方法,在第1级VDLR的局部前景序列中对驶过的车辆进行易跟踪的稀疏特征点提取.鉴于VDLR沿车道方向高度较窄,一级特征点选取不够充分,因此,在第2、3级VDLR上进行逐级递增式补选,很好地保证车辆前景特征点的提取效果.

3.2 特征点按车分组

在目标驶离第3级VDL时,利用Adaboost分类器在原始图像中进行车辆识别并对特征点进行按车分组.Adaboost施用区域由目标在三级FPVI中的团块(下面记为Bk,k∈{1,2,3})匹配情况而定.使用区域左下顶点图像坐标及区域宽度wAda计算

使用区域的高度hAda计算分以下三种情况:

(1)B3、B2和B1均能相互匹配.

(2)B3只与B2、B1之一(记为B')匹配.

式中 y'为B'所在VDL的y坐标;t'为车辆到达B'所在VDL的时刻值.

(3)B2与B1匹配,但与B3均不匹配.

式中 Δh为分离距离修正量,构造为(max(lB3,lB2,lB1)-min(lB3,lB2,lB1))/2,能够有效防止原本粘连的目标在第3级VDL发生分离而引起的目标漏检.

对落在同一车体区域的特征点采用边加权动态图G={V,E,W }表述.其中,V为同车特征点集;E为V中各特征点间的优化边集,采用Delaunay三角剖分法[10]构造;W为边权集,各边权值取为该边所连特征点对的运动特征相关度,初始化为车体区域长度lveh,并在后继跟踪中动态修改.车辆特征点的提取与按车分组结果如图2所示,其中图2(a)圈中的粘连车辆均被Adaboost成功分离,有效保证了算法精度.

图2 车辆特征点提取与按车分组Fig.2 Extracting and grouping results of feature points

4 车辆时空轨迹跟踪

4.1 特征点跟踪与分组修正

对分组后的特征点,在后继帧的图像金字塔中计算KLT(Kanade-Lucas-Tomasi)稀疏光流来进行跟踪.KLT跟踪器要求目标亮度恒定,但在实际场景中车辆特征点很容易受到光照变化等因素的影响.基于大量实验,将ULBP(Uniform Local Binary Pattern,改进的局部二元模式)[11]纹理特征与KLT稀疏光流法进行融合,有效解决跟踪漂移问题.跟踪中若发现第i帧的某特征点在后继帧中的位置发生了变动,则分别以变动前后的两点为中心,在各自的帧图像中分别计算其邻域窗口ULBP特征值并进行匹配.若匹配成功则表明位置变动后的特征点有效;否则,表明发生漂移,将其剔除.

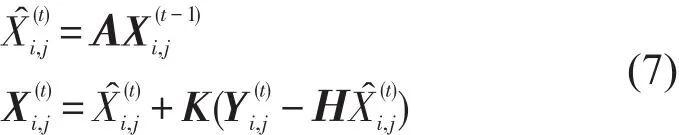

正常行驶的车辆一般可视作刚体,车上特征点在运动方向、速度、加速度等特征上相似度较高,但不同车辆特征点的运动特性差异较大.因此,基于运动特征相关程度动态修改各特征点间的边权值,实现分组修正.实验分析表明,特征点的上述运动相关度可通过彼此距离及其变化率等描述.因此,采用状态空间转移模型表述特征点对的运动关系,对具有边连接的特征点对(i和 j),以表示其在t时刻的运动关系状态向量,其中分别为两点间的像素距离、距离变化速率和变化加速度[7].t时刻状态预测值及修正状态值可由点对在t-1时刻的信息递推得到,具体如下:

式中 Α为转移矩阵;K为Kalman修正矩阵;Η 为观测矩阵;为误差向量,其第一分量表征t时刻的点对距离测量值与预测值的差异,若差异值为正,则表明点对可能出现了分离.为避免误判,此时不直接断开对应的连接边,而是使其减1,当权值减为0断开点对连接,实现分组修正.进而判断这两个特征点,若某点已无任何连接边,则将其作为干扰点剔除.

4.2 车辆轨迹的提取

对每辆车在其驶出感兴趣区域时由其特征点轨迹提取该车轨迹.此时其边加权动态图G={V,E,W}中V保存的是车辆稳定特征点,E中保存着这些特征点间的最优边.事实表明,靠近车辆中心的特征点比边缘特征点往往在E中具有更多的连接边.此处,采用加权平均法[7]计算V中各特征点的分布中心.在确定当前车辆位置时,为尽量减少车辆高度的投影影响,设计了中心垂直最近最长轨迹法,计算V中满足像素坐标的特征点个数κ及各特征点i与的横向欧氏距离 di,p并按升序选出前个点构成分布中心的横向K-近邻点集C,再按式(8)选取第 j个特征点的轨迹作为当前车辆轨迹.

式中 li为特征点i的轨迹长度.

4.3 轨迹时空图自动生成

以第i辆车为例,其轨迹表述为三元组点序列:

式中 xj、yj和 fj分别为第 j个轨迹点的x、y图像坐标及所在帧号;M为轨迹点数.

式中 Fs为帧频;Xj和Yj为当前轨迹点的世界X和Y坐标(可由其像素坐标与摄像机参数矩阵计算得来,此处不详述);XO、YO为起始参考点的世界坐标,本文参考点取为第1级VDL左端点.所得轨迹时空图示例如图3所示.

图3 轨迹时空图Fig.3 Time-space diagrams of vehicle trajectories

5 交通流特性参数检测分析

(1)交通流量.

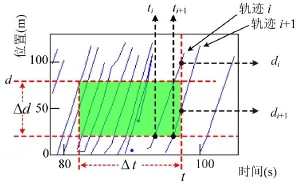

定义为单位时间内通过道路某位置处的车辆数,以当前时刻t为基准、以一定大小Δt为时间窗口,如图4所示,则交通流量为

式中 N(d,Δt)为Δt内通过d处的车辆数.

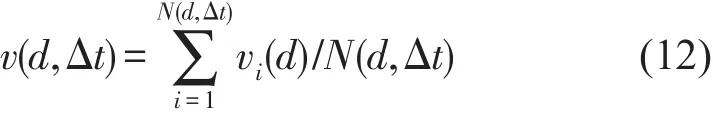

(2)平均流速.

①定点平均流速,即某Δt内通过道路上某d处的所有车辆瞬时速度的均值.

式中 vi(d)为第i辆车在d处的瞬时速度.

②瞬时平均流速,即某时刻t在某Δd内所有车辆瞬时速度的均值.

式中 N(Δd,t)为t时刻Δd内的车辆数,如图4所示.

(3)交通流密度.

①定点交通流密度.

②瞬时交通流密度,即某时刻在单位长度路段内的车辆数.

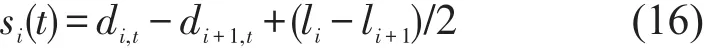

(4)车头距.

①车头间距,即某时刻t相邻两车车头的空间距离.

式中 li、li+1分别为第i、i+1辆车的车长,di,t、di+1,t的含义如图4所示.

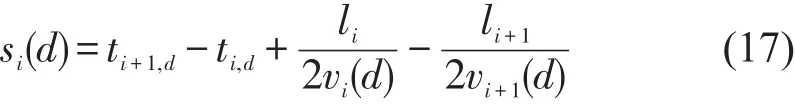

②车头时距,即相邻两车车头通过道路某处d的时间间隔.

式中 vi(d)、vi+1(d)为第i、i+1辆车在d处的瞬时速度;ti,d、ti+1,d如图4所示.

(5)占有率.

①空间占有率,即某时刻t在Δd内旅行车辆长度之和与Δd的比值.

②时间占有率,即Δt内所有通过d处的车辆通过时间之和与Δt的比值.

图4 交通流特性参数计算Fig.4 Traffic flow characteristic parameters calculation

6 实验分析

6.1 实验环境及设置

为验证算法性能,以北京市道路监控网络厚俸桥监控点为例,2014年4月11日起连续采集七天的交通视频对算法进行实验分析,每天分高峰期和非高峰期两种场景各采集1 h视频,共计14 h.摄像机距地高度为7 m,向东沿路面顺车流拍摄京哈高速市内段的南主路交通场景,车道数为4条,拍摄帧频为25帧/s,每帧图像大小为640×480像素.

6.2 实验结果与分析

基于上述视频,对文中各参数进行了检测实验,并将算法结果与人工测量数据进行了对比分析.为便于说明,文中首先选取平均流速这一主要参数的监测结果做详细分析(篇幅所限,其余参数不能详述),然后对全部参数的实验结果进行统计分析.

图5表示了本文算法的平均交通流速监测结果片段与对应的人工监测数据.图5(a)是d为20 m和80 m处第二车道的连续80 s定点平均流速监测数据.分析可见,本文算法在20 m处的定点平均流速的平均测量误差较小,在80 m处的定点平均流速的平均测量误差较大且各时间点的流速检测值的统计均值略高于人工数据统计均值.分析可知,造成这种误差的主要原因在于成像投影变换对检测精度的影响.图5(b)为t等于70 s和150 s时第二车道的连续80 m路段瞬时平均流速监测数据.随着摄像机距离的增大,结果误差也稍有增加,这主要是受到远端车辆遮挡及投影误差的影响而造成.

图5 平均流速监测结果Fig.5 Monitoring results of mean flow speed

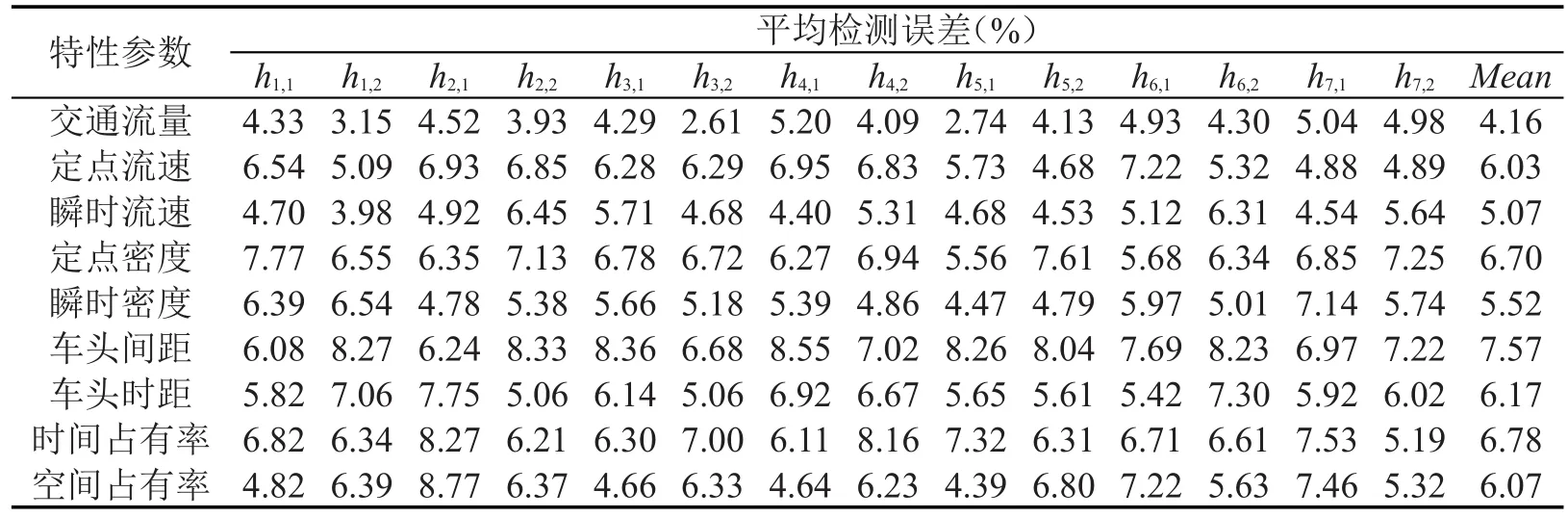

为全面分析算法性能,采用14 h视频中4条车道的全部交通流情况对本文各交通流参数进行了提取实验并与人工测量数据进行对比统计,结果如表1所示.分析可见,所有参数的平均检测误差都在10%以内.

表1 交通流特性参数检测结果Table 1 Detecting results of traffic flow characteristic parameters

7 研究结论

针对ITS中广泛采用的低位监控摄像机,提出一种基于时空轨迹跟踪的交通流参数自动检测算法.三级VDLR自适应更新速率局部背景建模及Adaboost分类器的应用有效提高了特征点提取和按车分组的精度;采用状态空间转移模型表述特征点对的运动关系并消除分组误差有效保证了目标轨迹的提取精度.自动生成的多车道轨迹时空图为交通流的多种特性参数自动并行提取及分析提供了有效平台,也为更多的交通信息获取和更深入的交通监控分析提供有力支持.实验分析验证了算法的有效性.

[1]Zhang J P,Wang F Y,Lin K F,et al.Data-driven intelligent transportation systems:a survey[J].IEEE Transactions on Intelligent Transportation System, 2011,12(4):1624-1639.

[2]杨建国,刘勇,贾凡.从高空摄像中获取车辆瞬态信息和驾驶行为[J].西安交通大学学报.2009, 43(4):116-120.[YANG J G,LIU Y,JIA F.Obtaining transient information of vehicles and behaviors of drivers from high-altitude photography[J].Journal of Xi'an Jiaotong University,2009,43(4):116-120.]

[3]Azevedo C L,Cardoso J L,Ben-Akiva M,et al. Automatic vehicle trajectory extraction by aerial remote sensing[J].Procedia-Social and Behavioral Sciences, 2014,111:849-858.

[4]杜荣义,彭仲仁.无人机逆向车辆检测数据时效性分析[J].交通运输系统工程与信息.2014,14(1):34-40. [DU R Y,PENG Z R.Time effectiveness analysis of UAV vehicle detection data in reverse direction[J]. Journal of Transportation Systems Engineering and Information Technology,2014,14(1):34-40.]

[5]Saunier N,Sayed T.A feature-based tracking algorithm for vehicles in intersections[C]//The 3rd Canadian Conference on Computer and Robot Vision,IEEE,2006: 59-65.

[6]Kanhere N K,Birchfield S T.Real-time incremental segmentation and tracking of vehicles at low camera angles using stable features[J].IEEE Transactions on Intelligent Transportation Systems,2008,9(1):148-160.

[7]Ren J Q,Chen Y Z,Xin L,et al.Lanes detection in video-based intelligent transportation monitoring via fast extracting and clustering of vehicle motion trajectories[J].Mathematical Problems in Engineering, 2014,(14):1-12.

[8]Ren J Q,Xin L,Chen Y Z,et al.Highefficient detection of traffic parameters by using two foreground temporal-spatial images[C]// IEEE International Conference on Intelligent Transportation Systems,Netherlands,2013:1965-1970.

[9]Shi J,Tomasi C.Good features to track[C].IEEE Computer Society Conference on Computer Vision and Pattern Recognition,1994:593-600.

[10]苏志刚,王争,吴仁.面向移动点的稳健动态Delaunay三角剖分技术[J].系统工程与电子技术.2013,35(8):1764-1768.[SU Z G,WANG Z,WU R.Robust dynamic Delaunay triangulation technology for moving points[J].Systems Engineering and Electronics,2013,35(8):1764-1768.]

[11]宋克臣,颜云辉,陈文辉,等.局部二值模式方法研究与展望[J].自动化学报.2013,39(6):730-744.[SONG K C,YAN Y H,CHEN W H,et al.Research and perspective on local binary pattern[J].ACTA Automatica Sinica,2013,39(6):730-744.]

Detection and Analysis of Traffic Flow Characteristic Parameters Based on Time-space Trajectory Tracking

REN Jian-qiang1,2,CHEN Yang-zhou1,XIN Le1,SHI Jian-jun1

(1.College of Metropolitan Transportation,Beijing University of Technology,Beijing 100124,China; 2.Department of Computer Science and Technology,Langfang Teachers University,Langfang 065000,Hebei,China)

Video Based detection of traffic flow has great significance in intelligent transportation systems. For the low angle cameras,a novel traffic flow multi-parameters detection method is proposed in this paper. Three virtual detecting lines and a local background modeling with adaptive learning rate are used to quickly extract vehicle feature points and eliminate the influence of activity shadow.Based on a trained Adaboost (Adaptive Boosting)classifier,the feature points are grouped to vehicles.Then the grouping errors are eliminated based on the motion-similarity of feature points in tracking process and the vehicle trajectories are extracted accurately.After that,the multi-lanes time-space diagrams are generated and the multi-parameters of traffic flow are detected automatically.Experimental results prove the efficiency of the method.In addition,the multi-lanes time-space diagrams can provide strong support for more traffic information acquisition and more in-depth analysis of traffic flow characteristics.

intelligent transportation;detection of traffic flow characteristic parameters;time-space trajectory tracking;low angle cameras

1009-6744(2015)01-0062-07

:U495

:A

2014-10-16

:2014-12-29录用日期:2015-01-04

国家自然科学基金(61273006);国家高技术研究发展计划(“863”计划)项目(2011AA110301);河北省科技支撑计划项目(13210807).

任建强(1978-),男,汉族,河北霸州人,副教授,博士生. *

:yzchen@bjut.edu.cn