一种基于图像的大型车辆车身长度自动测量方法

2014-04-11王文中

袁 涵,汤 进,王文中

(安徽大学计算机科学与技术学院,安徽 合肥 230601)

0 引言

近年来,在我国中型及以上货车(包括微型货车)改装外形尺寸,如换车箱、加长、加高货箱尺寸,超过国标规定的现象比较普遍。据统计,车辆超限超载成为造成道路交通事故的主要原因之一,严重影响国家财产和人民生命安全[1]。因此,除了平时的交通检查外,各地车辆管理所还要求各类车辆进行年检,其中重要的一项就是对车辆外形尺寸的测量检查。目前,主要的测量方法是人工使用钢卷尺、角度尺及标杆等工具进行测量,不仅人工成本高,效率低下,而且误差较大。随着计算机和图像处理技术的发展,为了实现对车辆外形尺寸的非接触自动化测量,一些学者提出了基于机器视觉的测量方法[2-4]。然而,受到应用环境限制,车管所等机动车辆管理部门测量场地环境布置复杂,空间狭窄,对于一般的大型车辆来说,由于车身较长而相机与被测车辆又太近,因而只能拍摄到车身的局部,不能一次将全部车身拍摄完全。因此,传统的机器视觉方法在测量车身尺寸尤其是大型车辆车身长度上不能很好地发挥效用。

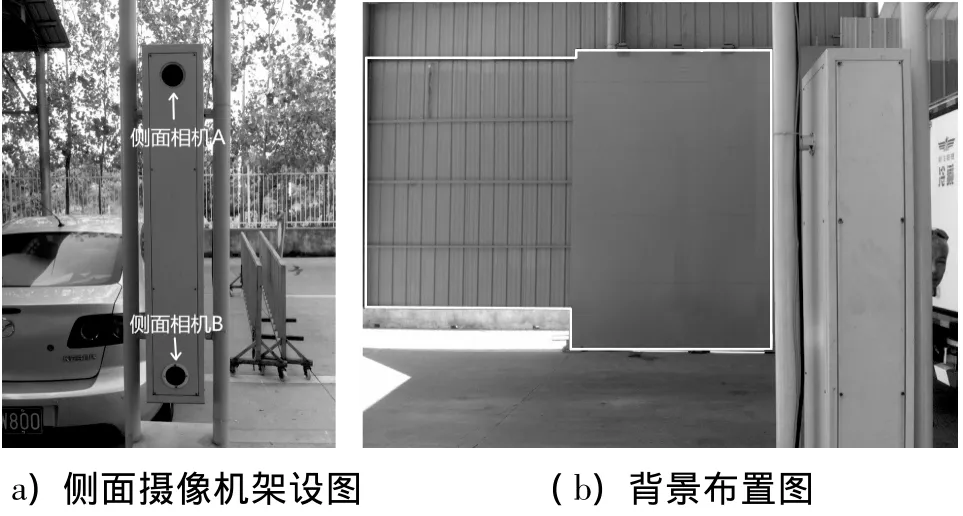

针对以上问题,本文提出一种基于图像的大型车辆车身长度测量方法,并应用于实际车身长度测量,现场的测量环境架设如图1所示。具体的做法是,在测量场地侧面架设两台固定的已标定相机,如图1(a)所示。测量时,让被测车辆尽量匀速平行于相机所在侧面向前驶进,直至驶出测量区域,与此同时控制两台相机同时对车辆进行间歇性抓拍。通过双目测距原理得出被测车辆与相机的距离,选取一台相机拍摄的图像序列进行图像拼接,得出车身侧面全景图,再根据车身在图像上的像素长度和车辆与相机的距离,结合标定数据得出车身长度的实际物理尺寸。

图1 现场(侧面)架设图

1 车身侧面图像拼接

拍摄过程结束后,选取其中一台相机拍摄的图像序列进行拼接。首先对图像序列中的每一幅图像做区域分割,去除背景,提取被测车辆图像,接着提取被测车辆的边缘特征,通过边缘特征匹配方法算出图像序列中相邻两幅图像的平移量,根据平移量即可知道它们之间的重叠区域,最后用一种简单的像素平均方法进行图像拼接得出车身侧面全景图。

1.1 车体图像分割

本文采用单高斯背景模型对背景进行建模。为了降低背景复杂度,提高背景模型的准确性,将正对侧面相机的背景墙涂成一种与常见车辆颜色相区别的颜色(本系统中使用紫色背景),如图1(b)白色线框所示区域。单高斯背景建模的基本思想是,将图像中每一个像素点的颜色值看成是一个随机过程X,并假设该点的某一像素值出现的概率服从高斯分布[5]。在车辆检测开始前,拍摄若干幅背景图片。设 I(x,y,t)表示像素点(x,y)在 t时刻的像素值,μt和σt为该像素的高斯分布期望值和标准差。取第一幅图片作初始化:

通常,取std_init=20。再依次逐一选取剩下的背景图片按下列公式对 μt、σt进行更新:

式中的α为一比例因子,在实际应用中一般取值0.1。

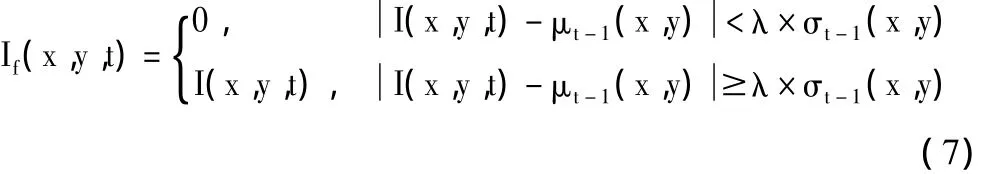

对于测量过程中拍摄的图像序列中的每一张,按下面的公式进行车体初步提取:

式中的λ为阈值系数,在实际应用中一般取值2.0~2.5。由于光照等原因,车体周围会产生阴影,在初步分割提取车身图像时,这些阴影往往被误分为车身,对分割结果产生影响。对此,本文采用一种抗阴影的背景减除算法来消除阴影的影响,得到最终的车体图像。设zb(u,v)表示背景模型中像素(u,v)的颜色均值向量,zr(u,v)表示经过上一步初步分割提取的车辆图像中像素(u,v)的颜色向量,f(u,v)表示上一步分割的结果:f(u,v)=1与f(u,v)=0表示像素(u,v)为车体或背景,使用如下的抗阴影背景减除算法来进一步消除车身周围的阴影,即计算s(u,v):

其中,‖v‖定义为向量v的模,·定义为向量的点积。本系统中τ的值取为0.95。

1.2 车身侧面图像拼接

综合考虑系统对拼接精确性及实时性的要求,本文采用图像边缘特征作为匹配的特征。由于Canny算子是一种优化算子,具有抗噪性较强、定位准的特点[6-7],因此,对上一步得出的分割后的车身图像序列中的每一幅图像做Canny边缘检测,然后使用基于Chamfer距离的轮廓匹配方法[8-9]计算出当图像序列中相邻两幅图像的边缘特征,达到最佳匹配时它们的平移量:

式中,T={(xt,yt)}为模板图像的 Canny边缘点集示集合T的点数目标图像的Canny边缘点集合,dT(xt+Δx,yt+Δy)为E的Chamfer距离变换公式。

根据平移量Δx和Δy即可计算出两幅图片的重叠区域。由于车身侧面图像拼接只要得到车身的长度信息,并不要求图像视觉美观,考虑到系统的实时性要求,因此,本文使用简单的像素平均方法对拼接图像序列进行融合,如式(10)所示。

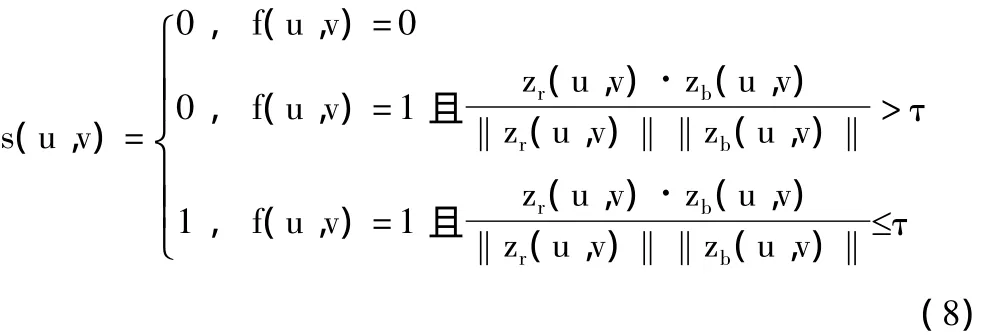

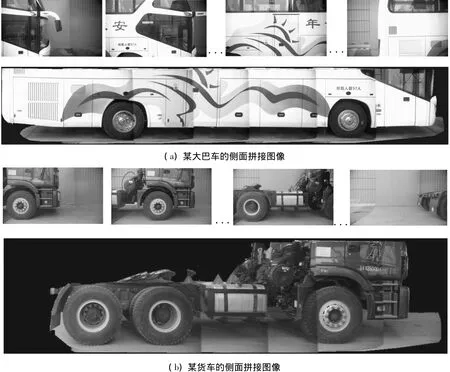

式中,R1表示第一幅图像中去掉重叠部分其余区域的像素,R2表示两幅待拼接图像重叠区域对应的像素,R3表示第二幅图像去掉重叠部分其余区域的像素。车体侧面图像拼接结果如图2所示。

图2 车身侧面图像拼接

2 车身长度测量

在车身侧面图像拼接完成后,即可获取一对在同一水平线上的车头、车尾点的坐标(图像坐标),根据标定得出的单应矩阵将这两点转换为参考平面坐标(物理坐标),并得出这两点在参考平面上的距离(物理距离)。由于参考平面与相机距离在标定阶段已经得出,结合双目测距测得的车身与相机距离,通过简单的比例关系即可得出车身的实际物理长度。

2.1 双目测距

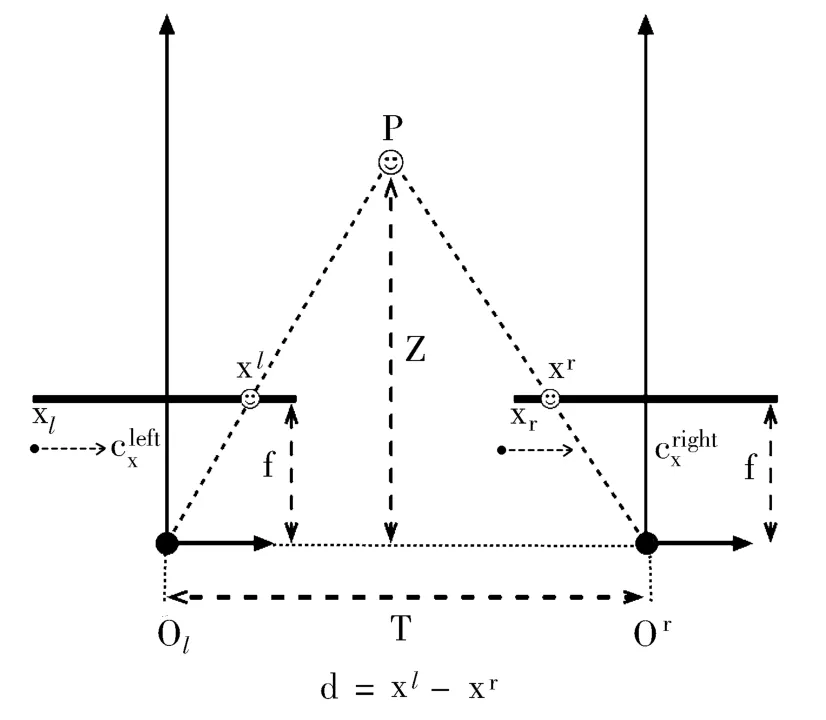

双目测距的原理如图3[10]所示。设空间点P在左右摄像机成像的图像点分别是xl、xr,视差d=xlxr,T是两摄像机的光心距离,即基线距,f是两摄像机的焦距,Z为点P到相机光心的距离。由简单的三角形相似原理,可知:

图3 双目测距原理

摄像机架设固定好后,本文首先采用张正友提出的标定方法对摄像机进行标定[11],得出焦距f等摄像机参数。

当测量过程中的拍摄结束后,从两部相机的图像序列中选取一组同一时刻拍摄的两张车身图像,完成特征匹配及视差计算。本文采用 Harris角点特征[12-16]作为双目测距中图像的匹配特征,并用RANSAC算法[17]完成特征匹配,如图4所示。最后计算出视差d,便可根据公式(10)得到车身与相机的距离ZR。

图4 基于Harris角点特征的图像匹配

2.2 估计图像平面与标定平面之间的单应矩阵

为了得到车身侧面的真实物理尺寸,需要将车身侧面的像素尺寸映射到真实的车身平面上。假设车身侧面近似为一个平面,则这个映射就是相机成像平面与车身侧平面之间的单应变换(Homography)。由于不同车辆与相机的距离不确定,因此,不同车辆对应的单应矩阵是不同的,为了避免对每一辆被测车辆重新标定这个单应矩阵,事先标定出成像平面与某个参考平面的单应变换,然后利用车辆与相机的距离以及参考平面与相机的距离,将这个单应变换转换为成像平面与车辆侧面之间的单应变换。

在实际标定中,将一块棋盘格以尽量垂直于光轴的方式移动到某一位置,将此时棋盘格所在的平面作为参考平面,测出棋盘格与相机的距离ZB。此时,参考平面上的点M=[x,y,z]T与对应的摄像机成像平面上的图像点m=[u,v]T满足以下关系:其中和分别为点M和点m的齐次坐标。给定n(n>3)组对应点{Mi,mi,利用直接线性变换(Direct Linear Transformation)算法[18]计算出单应矩阵HIB。

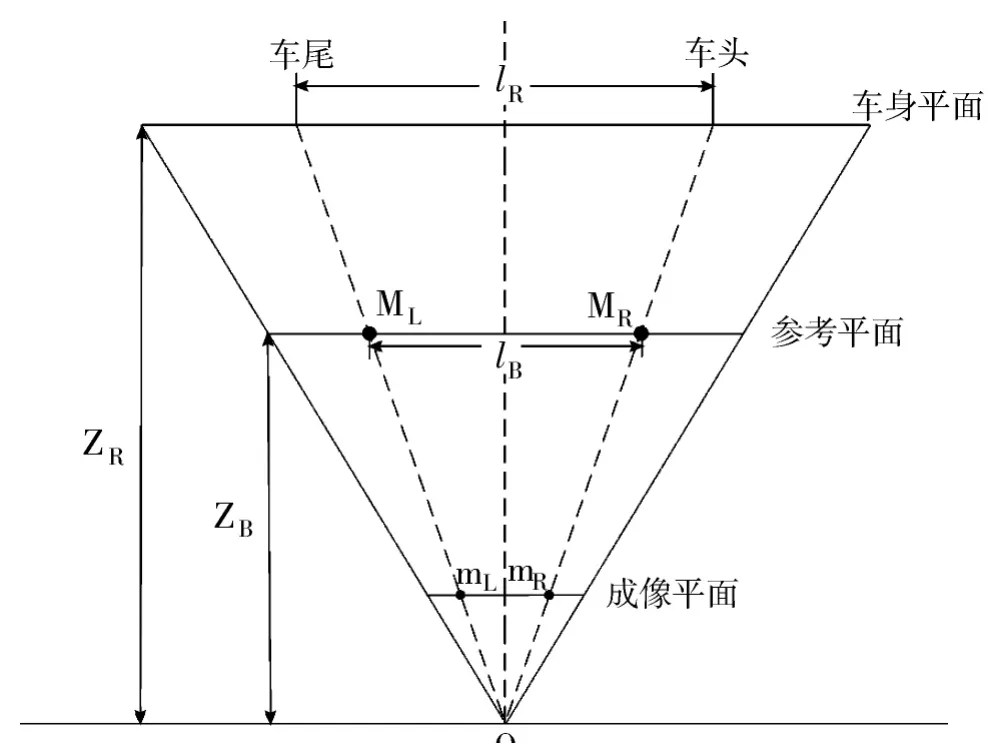

2.3 车身实际长度测量

设mR是车身侧面全景图上车头边缘上一点(通常选取车头边缘的中点)的图像坐标,mL是与其对应在同一水平线上的车尾边缘上一点的图像坐标,则mL、mR在参考平面上的对应点的齐次坐标为=是车身的实际长度,车身在参考平面上的投影长度为lB=‖MR-ML‖,如图5所示。则根据简单的三角形相似原理,有:

其中,ZR是车身与相机的距离,ZB是标定板与相机的距离。

图5 车身长度测量原理

3 实验结果及分析

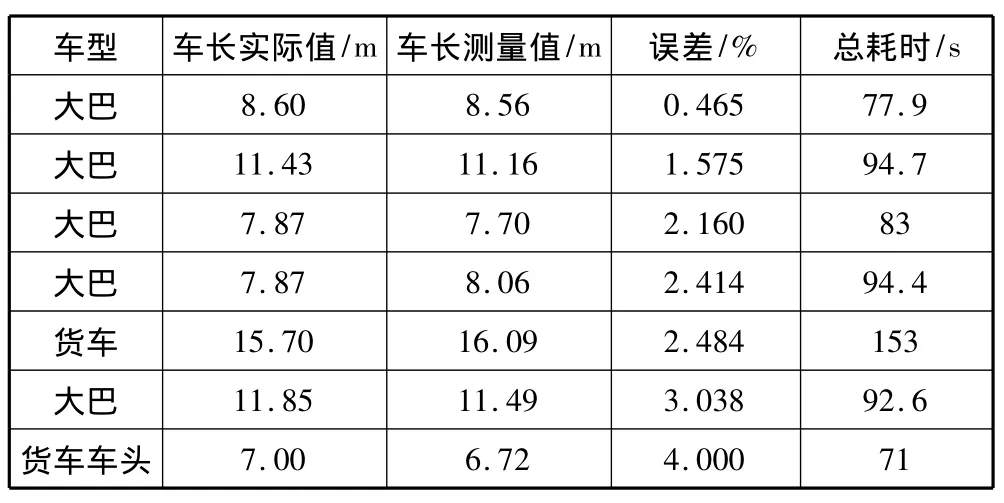

实验采用主频为Core i5-3.0 GHz、内存为4 GB的计算机和普通工业抓拍相机。两部侧面相机的基线为50 cm,背景板与相机的距离为6 m,相机与车身侧面的距离大约在3 m左右。部分测量数据如表1所示。

表1 测量结果及误差

在测量范围方面,由于采用了图像拼接技术,理论上可以对任何尺寸的车辆车长进行测量,实验中测量的最长车身长度为15.70 m,而传统的视觉测量方法由于受到相机有效视场的限制,测量的最长车身长度为6.000 m[18];在测量精度方面,最大绝对误差为39 mm,平均绝对误差为24.29 mm,最大相对误差为4.000%,平均相对误差为2.035%,与传统车长测量方法相差不大;在测量耗时方面,系统平均耗时95.2 s,而一般传统的人工测量车长方法平均需要20多分钟。总体来说,基于图像的大型车辆车身长度测量方法在将测量值与实际值误差控制在合理范围内的情况下,系统测量范围广、耗时较短,满足了车身长度测量的精确性、通用性、实时性要求,达到了测量目的。

4 结束语

本文提出一种基于图像的大型车辆车身长度测量方法,通过图像拼接方法得出完整的车身侧面图像,结合双目测距方法测得车身实际长度。实验结果表明,这种方法具有自动、快速、非接触、误差小、测量范围广的特点,对在测量场地大小受限、测量环境复杂下的大型车辆车身长度测量具有很好的理论意义和应用价值。

[1]昌云宗,刘成江,崔同来,等.公路超限运输的现状及治理[J].山东交通科技,2004(3):94-95,97.

[2]卞小东.基于机器视觉的车辆几何尺寸测量系统研究[J].南京:东南大学,2005.

[3]苏建,翟乃斌,刘玉梅,等.汽车整车尺寸机器视觉测量系统的研究[J].公路交通科技,2007,24(4):145-149.

[4]翟乃斌,苏建,刘玉梅,等.基于计算机视觉的汽车整车尺寸测量系统[J].交通与计算机,2006,24(3):22-26.

[5]RaySaint.背景建模算法(一)——颜色背景模型[EB/OL].http://underthehood.blog.51cto.com/2531780/484191/,2011-01-23.

[6]Canny John.A computational approach to edge detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1986,8(6):679-698.

[7]李娅娅,李志洁,郑海旭,等.图像边缘检测算法的比较与实现[J].计算机工程与设计,2010,31(9):1971-1975.

[8]Belongie S,Malik J,Puzicha J.Shape matching and object recognition using shape contexts[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2002,24(4):509-522.

[9]管伟光,马颂德.统一化的快速距离变换[J].计算机学报,1995,18(8):625-635.

[10]Bradski G,Kaehler A.Learning OpenCV[M].USA:O’Reilly Media,2008:436.

[11]Zhang Z.A flexible new technique for camera calibration[J].IEEE Transactions on Pattern Analysis and Michine Intelligence,2000,22(11):1330-1334.

[12]Harris C G.Determination of ego-motion from matched points[C]//Proceedings of the 3rd Alvey Vision Conference.1987:189-192.

[13]Harris C,Stephens M.A combined corner and edge detector[C]//Proceedings of the 4th Alvey Vision Conference.1988:147-151.

[14]Rohr K.Localization properties of direct corner detectors[J].Journal of Mathematical Imaging and Vision,1994,4:139-150.

[15]Rosten E,Drummond T.Machine learning for high-speed corner detection[C]//Proceedings of the 9th European Conference on Computer Vision.2006:430-443.

[16]Noble JA.Finding corners[J].Image and Vision Computing,1988,6(2):121-128.

[17]Fischler M A,Bolles R C.Random sample consensus:A paradigm formodel fitting with applications to image analysis and automated cartography[J].Communications of the ACM,1981,24(6):381-395.

[18]Hartley R,Zisserman A.Multiple View Geometry in Computer Vision(2nd Ed.)[M].UK:Cambridge University Press,2000.