机器学习应用于在线科学探究中的综述研究

2023-09-06孙社兵张巧荣李田茖

孙社兵 张巧荣 李田茖

摘 要:机器学习近几年来逐渐被应用于在线科学探究活动的自动评价、过程分析等方面,在辅助教师教学、提升学生科学学习效果上发挥了重要作用。机器学习融入并支持在線探究学习活动是未来科学探究走向大规模多场景实践应用的重要技术支撑。为向国内研究者和一线教师提供开展相关研究和教学实践的参考,在三个英文数据库中筛选出了近10年发表的24篇英文文献,总结分析了目前机器学习在在线科学探究中发挥的作用及具体应用,并提出了未来展望。

关键词:在线科学探究;虚拟探究;机器学习;科学教育

中图分类号:TP18;G434 文献标识码:A 文章编号:2096-4706(2023)14-0103-08

Review Research on the Application of Machine Learning in Online Scientific Inquiry

SUN Shebing, ZHANG Qiaorong, LI Tiange

(Henan University of Economics and Law, Zhengzhou 450046, China)

Abstract: In recent years, machine learning has been gradually applied to the automatic evaluation and process analysis of online scientific inquiry activities, and has played an important role in assisting teachers in teaching and improving students' scientific learning effect. It is an important technical support for machine learning to integrate into and support online inquiry learning activities of scientific inquiry to move to large-scale and multi-scene practical application in the future. In order to provide reference for domestic researchers and front-line teachers to carry out relevant research and teaching practice, 24 English literatures published in the past ten years are selected from three English databases. It summarizes and analyzes the role and specific application of machine learning in online scientific inquiry at present, and puts forward future prospects.

Keywords: online scientific inquiry; virtual inquiry; machine learning; science education

0 引 言

世界各地的科学教育标准强调让学生通过探究学习科学的重要性[1]。在我国基础教育改革中,新课程标准也明确提出“科学学习要以探究为核心”[2]。已有研究表明,科学探究学习能够帮助学生理解科学的本质及其推理过程,培养对科学的积极态度[3]。科学探究过程包括从发现问题、猜想假设,到设计实验、收集证据,再到分析论证、交流评估的一系列活动[4]。但在科学学习中,许多科学活动由于其特殊性无法在课堂环境中开展。计算机支持的在线探究环境在科学课堂上发挥着重要作用,为学生提供了使用多种呈现方法探索不同类型科学现象的机会,例如模拟[5]、可视化[6]、增强现实[7]、远程实验室[8]等。以往的研究表明参与在线科学探究活动的学生相比于使用传统学习方法的表现更好[9]。因此,在线科学探究活动成为当前科学教育的重要发展方向之一。

关于学习科学和基于学科的教育研究的文献表明,仅使用计算机支持的在线环境进行探究活动并不一定有助于学生进行科学学习[10]。研究表明,提供基于研究和理论的适当指导、支持,在线环境下的探究活动才有利于改进学生的学习[11]。要为学习者提供有效的支持则需要以其在探究过程中的具体行为和表现作为提供支持的依据,但跟踪和检查学生探究学习的过程是具有挑战性的。之前的研究认为,机器学习是一种有前途的自动化技术,可以辅助教师为探究学习提供及时支持[12]。例如,机器学习可以通过识别学生探究过程中产生的行为数据,在学生出现无效或与探究活动无关的行为时提供支持使其能够专注于探究任务[13]。此外,与多项选择题相比,科学探究中对建构反应式的题目进行回答更能够体现学生的思维和推理过程[14]。而人工对建构反应式题目进行评分需要耗费大量的时间和精力,且无法对学生的回答进行即时的反馈。机器学习可以帮助教师几乎立即评估和解释学生在课堂上的复杂表现,从而支持教师调整教学方案[15]。基于机器学习的自动评分和与分数相适应的个性化反馈或指导也可以通过在线导师系统或自适应系统实时提供给学习者,以指导学生的科学学习[16,17]。

尽管机器学习在在线科学探究中具有巨大的潜力,但目前仍缺少关于机器学习在在线科学探究中应用的系统回顾。Zhai等人的研究综述了机器学习在科学评估中的应用,系统分析了应用于科学评估的机器学习的技术特征、机器学习算法有效性的评估方法以及在科学评估中应用机器学习算法的教学特点[18]。但Zhai等人综述的研究范围为所有使用了机器学习进行科学评估的研究,而没有关注在具体探究过程中机器学习是如何发挥作用的。本研究则将焦点集中在使用机器学习为在线科学探究活动提供支持的研究上。目前,国内在在线科学探究领域应用机器学习的研究较少,以科学探究和机器学习相关关键词的组合在知网检索时得到的中文文献数量屈指可数。因此,有必要对国外相关研究进行综述,分析机器学习在在线科学探究中发挥的作用及具体应用,以期为国内实施相关研究和教学提供指导。本研究对检索出的近十年相关文献24篇英文文献进行系统回顾,并提出以下两个研究问题:

1)机器学习应用于在线科学探究的哪些方面?发挥了什么作用?

2)在线科学探究中采用了哪些类型的机器学习算法?算法的有效性如何?

1 研究方法

1.1 文獻来源

为研究当前机器学习应用于在线科学探究的发展趋势,本研究在Eric、ScienceDirect和Web of Science三个英文数据库检索了2012—2022近十年的相关研究。研究检索关键词为“Scienceinquiry”“Computer-supportedinquirylearning”“Web-basedinquirylearning”

“Virtual science inquiry”“Scientificargumentation”

“machine learning”“automatic scoring”“automatic guidance”和“automatic feedback”,将以上关键词用“And”或“OR”进行组合在数据库中进行检索并将语言限定为英语,最终得到文献636篇。研究者根据指定的纳入/排除标准对文献进行筛选,标准如表1所示。

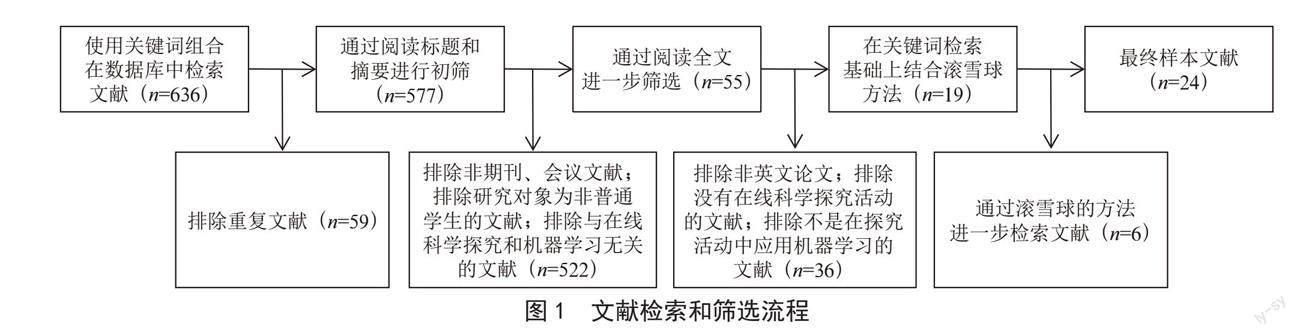

首先,研究者使用Endnote X9软件排除了59篇重复文献。然后使用纳入/排除标准筛选了剩余577篇文献的标题和摘要,并最终保留了55篇文献。之后,通过阅读全文进一步排除了36篇不合格的文献。为扩大样本的代表性,在关键词检索的基础上使用滚雪球的方法追加检索结果,最终纳入24篇文献,文献检索和筛选流程如图1所示。

1.2 文献编码方案

在使用纳入/排除标准筛选出最终纳入文献之后,研究者对这24篇文献进行了编码分析。在快速阅读摘要和分析文献框架的基础上,本研究编码了纳入文献的基本信息,包括文献的作者、发表时间、地区、教育水平、在线科学探究任务的探究主题和探究平台、开发和部署机器学习算法的程序/工具。然后,针对第一个研究问题,编码了机器学习在在线科学探究中应用范围及发挥的作用。最后,针对第二个研究问题,编码了研究中应用的具体的机器学习算法和评估算法有效性的标准。

2 研究结果

2.1 文献基本信息

本研究统计了筛选出的24篇文献的基本信息,如表2所示。

由表2可知,在在线科学探究任务中应用机器学习的研究集中于少数团队。例如,文献[1]、[4]、[6]、[7]是美国伍斯特理工学院学习科学与技术项目的Gobert团队的研究,该团队的主要研究内容是使用机器学习分析学生的日志行为数据为探究过程提供支持;文献[15]、[16]、[18]、[23]和[24]是美国教育考试服务中心和康科德集团的合作团队Lee团队的研究,该团队的研究方向是为学生的科学论证提供自动评分和自动反馈。其他还有中国台湾国立政治大学Chen的团队、加拿大不列颠哥伦比亚大学Fratamico的团队等。此外,这些研究大多数是美国的科研机构,占总研究数量的79.2%。研究对象的教育阶段大多集中在中学,占总研究数量的62.5%,而涉及小学阶段的仅有3项。应用机器学习技术的在线科学探究任务的主题更多地集中在物理学科,一种可能的原因是物理相比于其他学科具有更多的线性因果结构,使得对学生探究技能的评估更加简单[20]。

在24项研究中共使用了12个探究平台开展探究任务。其中使用最多的通用探究平台是WISE(Web-based Inquiry Science Environment)。WISE平台是由美国加利福尼亚大学伯克利分校Marcia.C.Linn主持的科学教育和教育技术研究团队在美国国家科学基金会NSF(National Science Foundation)的资助下开发[41]。WISE有50多个免费的开放式科学探究学习任务,提供各种探究工具帮助学习者以自主探究的方式学习科学知识,同时WISE为教师提供了各种易操作的工具帮助教师监督学生的学习情况、管理学生的学习活动等。WISE系统集成了由ETS开发的c-rater-ML工具,可以利用机器学习为学生提供自动评分与反馈。2015年,华南师范大学对该平台进行了汉化,并被国内多项开展在线科学探究的研究使用[42]。

2.2 机器学习的应用

在对回顾的24篇文献编码后发现,机器学习主要应用于在线科学探究过程中学生的行为数据分析和学生提交的科学论证文本的自动评分和反馈。

2.2.1 在线探究过程学生行为数据分析

基于计算机的在线探究环境可以自动实时记录学生的行为,由于这些日志文件是在学生探究过程中生成的,因此可以根据这些探究行为对探究生成的结果和学生的探究技能进行评估。在回顾的24篇文献中有12篇文献使用机器学习算法处理学生在探究过程中生成的行为数据。其中,Gobert团队的研究使用机器学习算法对学生行为进行预测,研究开发了基于机器学习的探测器,该探测器通过对日志行为数据的分析判断学生是否在正常进行实验并对行为进行预测,以期在学生出现偏离探究实验轨道的行为时,为学生提供帮助使其专注于探究任务[13,21,23,24]。Chen等人的研究使用机器学习识别影响学生学习成绩的关键行为序列,研究在CWISE平台中嵌入基于xAPI(体验应用程序编程接口)的学习记录存储模块,以记录有关学生学习过程的详细数据,并使用序列挖掘算法分析这些行为数据,识别不同学习成绩和探究能力的学习者的学习行为[24,27]。Baker等人的研究使用机器学习中的分类算法开发了与教育相关的无传感器情感模型,将探究行为分类为无聊、困惑、喜悦、专注和沮丧五种情感状态,检查与特定情感状态最密切相关的行为,通过为学生提供自适应个性化指导提高学生参与度和学习能力[20]。

2.2.2 科学论证文本的自动评分与反馈

在24篇文献中,还有12篇文献利用机器学习处理学生在探究过程中生成的文本数据。在科学探究过程的最后阶段,对科学现象做出解释或对自己的猜想进行论证是一种重要的探究产出,用以评估学生对科学现象的理解程度。机器学习的一个重要作用就是对解释或论证的文本进行自动评分并提供与分数相对应的自动反馈。自动评分不但可以节省时间和精力、减少人工评分过程中的错误和偏见,而且可以实现实时不断的连续评分,这时使用人工评分很难达到的效果。例如,Lee团队的研究为学生的论证提供自动评分与反馈,研究结果显示,自动评分与自动反馈能够促进学生的修订行为,提高学生的论证成绩[31,32]。除对解释和论证文本进行自动评分外,Sung等人的研究还使用机器学习对学生的热力学回答进行多标签文本分类以快速评估学生的思维方式[38],在在线学习环境的认知科学领域取得了新进展。在小组合作的在线探究环境中,小组内还会产生一些交流的文本数据,Xing和Zhu等人的研究建立了机器学习模型来自动识别协作环境中产生的大规模的变革性和非变革性讨论,旨在发现小组内的哪些讨论有助于科学学习[35,36]。

2.3 算法及有效性评估

2.3.1 在线科学探究中应用的机器学习算法

基于机器学习的算法可以分为有监督、无监督或半监督,具体取决于训练算法的数据集使用、不使用或部分使用人类专家标签/分数。表3显示了24篇文献中各类算法的使用情况。应用于在线科学探究任务的机器学习算法中,主要使用的是有监督的机器学习算法和无监督的机器学习算法。

对于有监督的机器学习,首先机器从人工标记过的数据中学习,建立算法模型,然后使用该模型推断并做出决策。因为训练数据提供标签并包含机器学习算法要学习的模式,因此被称为有监督的机器学习。在24项研究中,有19项研究使用了有监督的机器学习,占总研究数量的79.2%。其中回归算法使用最为广泛。在回归中SVR(support vector regression)是使用最多的一种回归算法。SVR基于机器学习技术,是专门用于处理具有大量相关预测变量的大型数据集的统计分析方法。ETS开发的自动评分工具c-rater-ML就是使用SVR来建立学生回答与分数之间的关系模型,并识别从文本回答到分数之间的映射。

与有监督的机器学习不同,无监督的机器学习不需要标记数据来训练机器,因此它减少了人力花费。使用无监督的机器学习方法,机器可以根据个别案例特征的共性和差异识别数据集中的潜在结构、分布或模式,以构建算法。在24项研究中有6项研究使用了无监督的机器学习方法,占总研究数量的25%。其中,5项研究使用无监督机器学习方法进行序列挖掘。这些研究希望从学生的日志数据中挖掘出探究的有效行为,以期为学生提供支持。在这5项研究中有3项研究使用的是K-means聚类算法,K-mans以空间中k个点为形心进行聚类,对最靠近他们的对象归类,通过迭代的方法,逐次更新各簇的形心的值,直至得到最好的聚类结果,是最经典的基于划分的聚类方法。例如,Fratamico等人的研究根据交互日志对学生的行为进行聚类,以识别具有相似行为的学生[27]。Chen等人的研究使用聚类算法挖掘出学生探究过程中发生频率足够高的行为,分析这些行为和学习绩效之间的关系,以预测学生的成绩[28,37]。此外,1项研究使用了Bert深度学习方法。Sung等人的研究使用Bert实现了在科学教育的自动化评估中对学生的书面回答进行多标签分类,以识别学生不同的思维方式,相比于传统的机器学习方法SVM取得了更好的分类效果[38]。

半监督的机器学习是指一部分训练数据被标记,另一部分未标记。半监督的机器学习可用于分析输入数据的结构或预测未标记数据中的模式。由于半监督机器学习提高了无监督机器学习的准确性,并克服了为有监督的机器学习准备数据的时间和成本负担,因此它具有很大的潜力。但在本研究筛选出来的24项研究中,没有使用半监督的机器学习算法。

2.3.2 算法的有效性

機器学习中需要评估算法的有效性,即机器为测试数据分配的分数在多大程度上接近人类专家生成的分数。在某种程度上,人类分配的分数被视为评估机器学习性能的“金标准”[16]。在回顾的24篇文献中,机器学习算法的有效性主要依据以下指标进行评估:

1)科恩的kappa值[13]。在24篇文献中,使用最多的有效性指标是科恩的kappa值,有9项研究使用了这一指标。科恩的kappa值范围在-1.0~1.0之间,用于评估机器学习研究中机器分配的分数和人工分配的分数之间的一致程度或可比性。Kappa值为1,说明对于每个回答,机器评分与人工评分是完全一致的,不存在偶然的一致;值为0表示机器评分和人工评分之间的所有一致性都是偶然的;值为负数表示机器评分和人工评分之间的一致性比偶然一致更差。一般认为,科恩的kappa值大于0.75表示人机一致性好,0.40~0.75之间表示人机一致性尚可,小于0.4则表示人机一致性较差[43]。在使用了这一指标的9篇文献中,7篇文献中的使用算法的kappa值在0.41~0.702,只有2项研究的kappa值低于0.4,及大部分机器学习算法的人机一致性取得了令人尚能满意的结果。

2)精确率[13]。精确率指正样本被预测正确的比率,该指标表示机器识别标记数据的有效性。有7项研究使用的有效性指标是精确率。在使用了这一指标的研究中,精确率值在0.7~0.95之间。

3)二次加权的kappa值(QWK)[39]。QWK根据编码员之间的分歧程度,为不同的分歧分配不同的权重,QWK假设变量是在区间尺度上测量的,不适用于名义数据。在使用了这一指标的研究中,精确率值在0.7~0.9之间。

4)A[23]。A是指当给定两个样本,一个标记为正样本,一个标记为负样本,机器能够正确识别每个样本的概率。A的偶然值为0.5。有5项研究使用的有效性指标是A。在使用了这一指标的研究中,精确率值在0.56~0.94之间。

5)召回率[13]。召回率是指预测为正样本的样本中,正确的比例,该指标表示机器识别标签数据的完整程度。有4项研究使用的有效性指标是召回率。在使用了这一指标的研究中,精确率值在0.46~0.94之间。

6)皮尔逊系数r [32]。皮尔逊系数r指机器评分与人工评分之间的皮尔逊相关性,但皮尔逊相关仅适用于区间或比率数据,并不适用于所有研究。有3项研究使用的有效性指标是皮尔逊系数r。在使用了这一指标的研究中,精确率值在0.7~0.72之间。

7)支持度[28]。支持度是评估序列挖掘算法的重要指标,必须设置最小支持度,才能挖掘高于最小支持度的最大顺序模式。有3项研究使用的有效性指标是支持度。在使用了这一指标的研究中,精确率值在0.43~0.79之间。

这些指标通常用于机器学习,以相互补充,并测量机器性能的不同方面[18]。

3 结论与未来展望

机器学习在在线科学探究中具有巨大的应用潜力。文献综述结果表明,当前研究界已经开展了机器学习支持在线科学探究学习的探索,但研究仍处于起步阶段,研究团队相对集中。同时,当前研究仍较少关注低年龄段群体,且多局限在物理和地球科学学科,未有在更多样的科学学科中进行广泛开展与验证。在具体的应用方面,机器学习主要被用来进行行为分析、识别和预测,以及建构类文本的自动评分。在适应性的过程支持、资源推荐、路径导航、个性化反馈方面还未有深入探索。在具体的算法应用中,机器学习算法使用还相对单一,大量研究使用了有监督的机器学习算法,少量研究使用了无监督的机器学习算法,且大多取得了较好的效果,但半监督的机器学习算法却没有得到很好的应用。

为更好地指导我国研究者和一线教育工作者进行科学教育,本研究在总结以往研究的基础上提出以下展望。

3.1 挖掘机器学习应用于在线科学探究的综合支撑潜力

以往的研究已经发现了机器学习在帮助教师监控学生行为、自动指导和提供反馈上具有巨大的潜力[18]。但目前在机器学习应用于在线科学探究的相关研究中,机器学习技术在探究任务中只发挥一种作用,例如识别“跑题”行为或自动评分。很少有研究使用机器学习在探究的各个过程中为学生提供支持。未来的研究可以考虑开发智能系统,将多个机器学习算法集成在智能系统中,在多个方面为学生提供帮助。例如在探究过程中通过识别日志数据给遇到困难的学生提供支持,并在学生提交建构式答案后进行自动评分并结合学生的日志行为数据提供即时的个性化反馈。此外,目前大多数研究将机器学习的应用集中于在科学探究过程中生成的文本的识别和分类,例如对解释和论证进行评分。还需要更多的研究探索学生的在探究过程中情绪、表现、信心等,以提升机器学习的教学潜力。最后,现有机器学习模型在在线科学探究任务中的表现仍有待提升。当前研究中训练样本较少可能是影响模型有效性的原因之一,未来研究中可以考虑收集数量更多、代表学生群体更广泛的数据对模型进行训练以提升模型精度。

3.2 提升机器学习在在线科学探究中的可迁移性

迁移学习是机器学习的一个研究方向,主要研究如何将在一个任务上面学习到的知识迁移到另一个任务上,以提高机器学习模型的泛化性能。目前,在线科学探究中应用机器学习研究的探究主题较为集中,这主要是因为机器学习的可迁移性较差。例如,Lee的团队的5项研究就将机器学习应用主题限定在了地球科学,而没有讨论其模型在其他领域的应用。他们的研究中也指出研究中提出的机器学习模型只适用于本研究的探究主题,要探究模型在其他主题上的表现则需要更多的研究。但Gobert团队的研究将在物理主题中开发的基于机器学习方法的探测器应用于生态学主题,探测器表现出了令人满意的有效性。这说明尽管探究主题之间可能有不同程度的复杂关系,但开发可迁移的机器学习模型是可能实现的。因此,未来的研究中应有更多的研究者开发高性能的通用模型,提升模型的迁移能力,拓展机器学习在在线科学探究中的应用领域。

3.3 加大我国在在线科学探究中应用机器学习的研究力度

目前,我国机器学习技术较为成熟,在线科学探究的研究起步较晚但发展快速[44],但在在线科学探究中应用机器学习的研究相对较少。实现K-12框架[45]和NGSS[46]中指定的评估目标的最大挑战之一是开发利用复杂结构的评估任务,如实践中的认知能力,并在教学中应用评估[47]。在教学实践中,这种复杂的评估任务通常需要花费教师大量时间和精力,如果没有自动化评分等技术的参与,这一挑战不太可能得到完成[48]。因此,我国研究者需要在借鉴国外在线科学探究领域应用机器学习的基础上,使用机器学习的自动化促进我国科学教育改革,帮助教师更好实施科学教学,提升学生科学学习效果。此外,目前国外相关研究在小学阶段的较少,但小学科学教育在培养国民科学素养方面有着不可替代的作用,它不僅能够帮助学生正确认识周围世界,适应学生和生活的需要,还能够帮助学生培养从小独立思考的习惯和勇于创造的意识[49]。且根据皮亚杰的认知发展理论,小学生处于具体运算阶段,其思维活动需要更多的支持。因此在我国未来的相关研究中,要加大利用机器学习自动化为小学生的在线科学探究学习提供支持的研究力度,助力提升小学生科学素养。

4 结 论

机器学习近年来在在线科学探究的教学活动中发挥了重要作用,将机器学习与在线科学探究活动进行深度融合也是未来科学教育的发展趋势。本文通过对众多研究工作的回顾和分析,对机器学习在在线科学探究中的应用进行了分类梳理,总结了在在线科学探究中常见的机器学习方法及算法有效性评估指标。最后本文对我国未来机器学习在在线科学探究中的应用做出了未来展望。可以预见,机器学习在在线科学探究中越来越广泛地应用,能够显著提升教师的教学效率和学生的科学学习水平。

參考文献:

[1] AULIA E,AULIA E V. Improving Science Literacy Skills for High School Students Through Guided Inquiry-Based Learning [C]//Proceedings of the Mathematics,Informatics,Science,and Education International Conference (MISEIC 2019).Surabaya:ATLANTIS PRESS,2019:124-128.

[2] 凌浩.基于科学探究的科技馆科普教育活动研究与实践 [J].科技风,2022(11):37-39.

[3] MARX R W,BLUMENFELD P C,KRAJCIK J S,et al. Inquiry-based science in the middle grades: assessment of learning in urban systemic reform [J].Journal of Research in Science Teaching,2004,41(10),1063-1080.

[4] 董耀,孙伟军,朱行建.要让学生经历完整的科学探究过程——对“牛顿第一定律”教学的思考 [J].物理教学,2021,43(10):47-49+16.

[5] JUSTIN D,UMESH R. The Effect of Simulation-Supported Inquiry on South African Natural Sciences Learners Understanding of Atomic and Molecular Structures [J]. Education Sciences,2020,10(10) :280-280.

[6] Al-BALUSHI S M,Al-MUSAWI A S,AMBUSAIDI A K,et al. The Effectiveness of Interacting with Scientific Animations in Chemistry Using Mobile Devices on Grade 12 Students Spatial Ability and Scientific Reasoning Skills [J].Journal of Science Education and Technology,2017,26(1) :70-81.

[7] JUANA W,RONG R,ZHUO W,et al. Integrating spherical video-based virtual reality into elementary school students scientific inquiry instruction:effects on their problem-solving performance [J].Interactive Learning Environments,2019,29(3) :1-14.

[8] ANDUJAR J M,MEJIAS A,MARQUEZ M A. Augmented Reality for the Improvement of Remote Laboratories:An Augmented Remote Laboratory [J].IEEE Transactions on Education,2011,54(3) :492-500.

[9] DONNELLY D F,LINN M C ,LUDVIGSEN S. Impacts and characteristics of computer-based science inquiry learning environments for precollege students [J].Review of Educational Research ,2014,84(4):572-608.

[10] JOOLINGEN R V W,JONG D T,DIMITRAKOPOULOU A. Issues in computer supported inquiry learning in science [J].Journal of Computer Assisted Learning,2007,23(2):111-119.

[11] SWAAK J,JONG D T. Discovery simulations and the assessment of intuitive knowledge [J].Journal of Computer Assisted Learning,2001,17(3):284-294.

[12] VITALE J M,LAI K,LINN M C. Taking advantage of automated assessment of student-constructed graphs in science [J].Journal of Research in Science Teaching,2015,52(10),1426-1450.

[13] GOBERT J D,PEDRO S M,RAZIUDDIN J,et al. From Log Files to Assessment Metrics:Measuring Students' Science Inquiry Skills Using Educational Data Mining [J].Journal of the Learning Sciences,2013,22(4) :521-563.

[14] KUECHLER W L,SIMKIN M G. Why is performance on multiple-choice tests and constructed-response tests not more closely related? Theory and an empirical test [J]. Decision Sciences Journal of Innovative Education,2010,8(1),55-73.

[15] RAMLA G,S?BASTIEN O,CLAUDE F. LewiSpace: an Exploratory Study with a Machine Learning Model in an Educational Game [J].Journal of Education and Training Studies,2015,4(1) :192-201.

[16] CHRISTOPHER M N,SYTIL K M,MICHAEL G C,et al. Automated analysis of short responses in an interactive synthetic tutoring system for introductory physics [J/OL].Physical Review Physics Education Research,2016,12(1) :010122(2016-03-16).https: //journals.aps.org/prper/abstract/10.1103/PhysRevPhysEducRes.12.010122.

[17] TANSOMBOON C,GERARD L F,VITALE J M,et al. Designing Automated Guidance to Promote Productive Revision of Science Explanations [J].International Journal of Artificial Intelligence in Education,2017,27(4),729-757.

[18] ZHAI X M,YIN Y,PELLEGRINO J W,et al. Applying machine learning in science assessment: a systematic review [J].Studies in Science Education,2020,56(1):111-151.

[19] TING C Y,CHEAH W N,HO C C. 2013. Student Engagement Modeling Using Bayesian Networks [C]//2013 IEEE International Conference on Systems, Man, and Cybernetics.Manchester:2013:2939-2944.

[20] BAKER R S,OCUMPAUGH J,GOWDA S M,et al. Extending Log-Based Affect Detection to a Multi-User Virtual Environment for Science [C]//User Modeling, Adaptation, and Personalization(UMAP).Springer:2014,290-300.

[21] PEDRO M S ,GOBERT J D,BETTS C G. Towards Scalable Assessment of Performance-Based Skills: Generalizing a Detector of Systematic Science Inquiry to a Simulation with a Complex Structure [C]//Intelligent Tutoring Systems(ITS).Honolulu:Springer:2014:591-600.

[22] DONNELLY D F,VITALE1 J M,LINN M C. Automated Guidance for Thermodynamics Essays: Critiquing Versus Revisiting [J].Journal of Science Education and Technology,2015,24(6):861-874.

[23] GOBERT J D,BAKER R S,WIXON M B. Operationalizing and Detecting Disengagement Within Online Science Microworlds [J].Educational Psychologist,2015,50(1):43-57.

[24] GOBERT J D,KIM Y J,SAO P M A,et al. Using educational data mining to assess students skills at designing and conducting experiments within a complex systems microworld [J].Thinking Skills and Creativity,2015,18 :81-90.

[25] GWEON G H,LEE H S,FINZER W. Measuring systematcity of students' experimentation in an open-ended simulation environment from logging data [C]//the Annual Meeting of the American Educational Research Association.2016.

[26] VITALE M J,MCBRIDE E,LINN M C. Distinguishing complex ideas about climate change: knowledge integration vs. specific guidance [J].International Journal of Science Education,2016,38(9):1548-1569.

[27] FRATAMICO L,CONATI C,KARDAN S,et al. Applying a Framework for Student Modeling in Exploratory Learning Environments: Comparing Data Representation Granularity to Handle Environment Complexity [J].International Journal of Artificial Intelligence in Education,2017,27(2) :320-352.

[28] LIN F C,CHEN C M,WANG W F. Learning Process Analysis Based on Sequential Pattern Mining and Lag Sequential Analysis in a Web-Based Inquiry Science Environment [C]//2017 6th IIAI International Congress on Advanced Applied Informatics (IIAI-AAI). Hamamatsu:IEEE,2017:655-660.

[29] PEREZ S,MASSEY-ALLARD J,BUTLER D,et al. Identifying Productive Inquiry in Virtual Labs Using Sequence Mining [C]//Artificial Intelligence in Education(AIED).Cham:Springer,2017,287-298.

[30] ROWE E,ASBELL-CLARKE J,BAKER R S,et al. Assessing implicit science learning in digital games [J].Computers in Human Behavior,2017,76 :617-630.

[31] ZHU M X,LEE H S,WANG T,et al. Investigating the impact of automated feedback on students scientific argumentation [J].International Journal of Science Education,2017,39(12) :1648-1668.

[32] MAO L Y,LIU O L,ROOHR K,et al. Validation of Automated Scoring for a Formative Assessment that Employs Scientific Argumentation [J].Educational Assessment,2018,23(2):121-138.

[33] GERARD L,KIDRON A ,LINN M C. Guiding collaborative revision of science explanations [J].International Journal of Computer-Supported Collaborative,2019,14(2) :291-324.

[34] LEE H L,PALLANT A,PRYPUTNIEWICZ S,et al. Automated text scoring and real‐time adjustable feedback: Supporting revision of scientific arguments involving uncertainty [J].Science Education,2019,103(3):590-622.

[35] XING W L,POPOV V,ZHU G X,et al. The effects of transformative and non-transformative discourse on individual performance in collaborative-inquiry learning [J].Computers in Human Behavior,2019,98:267-276.

[36] ZHU G X,XING W,VITALIY POPOV V. Uncovering the sequential patterns in transformative and non-transformative discourse during collaborative inquiry learning [J].The Internet and Higher Education,2019,41 :51-61.

[37] CHEN C M,WANG W F.Mining Effective Learning Behaviors in a Web-Based Inquiry Science Environment [J].Journal of Science Education and Technology,2020,29:1-17.

[38] SUNG S H,LI C L,CHEN G H,et al. How Does Augmented Observation Facilitate Multimodal Representational Thinking? Applying Deep Learning to Decode Complex Student Construct [J].Journal of Science Education and Technology,2020,30:1-17.

[39] ZHU M X,LIU O L,LEE H S. The effect of automated feedback on revision behavior and learning gains in formative assessment of scientific argument writing [J/OL].Computers & Education,2020,143(C) :103668(2019-08-19).https: //www.sciencedirect.com/science/article/abs/pii/S0360131519302210.

[40] LEE H S,GWEON G H,LORD T,et al. Machine Learning-Enabled Automated Feedback: Supporting Students Revision of Scientific Arguments Based on Data Drawn from Simulation [J].Journal of Science Education and Technology,2021,30:168–192.

[41] 吳伟,赵阳阳,熊耀华.基于网络的科学探究教学:来自WISE的启示 [J].外国中小学教育,2011(2):33-37.

[42] 张新华,刘美博,容梅.WISE项目移植于我国科学教学的实践探索 [J].中国教育信息化,2018(10):23-28+50.

[43] YANG Y W,BUCKENDAHL C W,JUSZKIEWICZ P J,et al. A Review of Strategies for Validating Computer-Automated Scoring [J].Applied Measurement in Education,2010,15(4):391-412.

[44] 吴华君,陈其铁,何聚厚.国内虚拟实验研究的知识图景及态势展望——基于近二十年文献计量的视角 [J].数字教育,2022,8(2):10-19.

[45] National Research Council. A Framework for K-12 Science Education: Practices, Crosscutting Concepts, and Core Ideas [M].Washington,DC:The National Academies Press,2012.

[46] National Research Council. Next generation science standards: for states, by states [M].Washington,DC:The National Academies Press,2013.

[47] ERDURAN S. Developing assessments for the next generation science standards [J].Assessment in Education:Principles,Policy & Practice,2018,25(2):224-226.

[48] BENNETT R E. Educational Assessment: What to Watch in a Rapidly Changing World [J].Educational Measurement:Issues and Practice,2018,37(4):7-15.

[49] 杨晓鹏,梁芳,余翔.小学科学教育“低谷”现象探析——以南昌市部分小学为例 [J].教育导刊,2010(6):80-82.

作者简介:孙社兵(1996—),女,汉族,河南濮阳人,硕士在读,研究方向:教育数据挖掘;通讯作者:张巧荣(1978—),女,汉族,河南郑州人,副教授、硕士生导师,博士,研究方向:数字图像处理、人工智能;李田茖(2001—),女,汉族,河南郑州人,本科在读,研究方向:教育数据可视化。