基于生成对抗网络的服装图像生成研究进展

2023-06-20施倩罗戎蕾

施倩 罗戎蕾

摘要:生成式人工智能正逐步运用在服装零售、电子商务、趋势预测、虚拟现实以及增强现实等服装产业技术中,并广泛覆盖相关品类的服务与产品。深度学习领域,图像生成模型主要包括深度信念网络(DBN)、变分自编码器(VAE)、生成对抗网络(GAN)。文章围绕GAN研究前沿对其变体发展进行分类梳理,将应用于服装领域最为广泛的条件生成对抗网络(CGAN)在Text-to-Image、Image-to-Image、Image-to-Video中的相关研究成果加以介绍,并分析其优化历程、优缺点以及适用类型;列举GAN在服装图像生成中的具体应用,包括服装横幅广告自动生成、个性化服装推荐与生成、服装与图案设计、虚拟试衣;最后针对服装图像生成研究挑战作出总结。研究认为,未来可在多模态生成模型研发、大规模时尚服装数据集构建、服装生成客观评估指标的3个方向展开研究。

关键词:深度学习;生成对抗网络;服装生成;智能广告设计;虚拟试衣

中图分类号:TN941.26

文献标志码:A

文章编号:1009-265X(2023)02-0036-11

图像生成作为计算机视觉研究的热门方向,是实施智能设计的重要手段。早期图像生成主要通过机器提取有效数据特征并进行算法迭代达到目的,结果准确性较大程度上依赖人的专业知识背景,这种基于有限样本统计学原理的“学习”无法取得较大进展。随着深度神经网络的发展,其高层次特征的表达能力使得传统机器学习的缺陷得以弥补。深度学习领域中的生成模型一般可以分为两类,一类是包含玻尔兹曼机及其变体、深度信念网络[1]在内的使用能量函数定义联合概率的模型,另一类是包含变分自动编码器[2]、生成对抗网络[3]在内的基于成本函数的模型[4]。该研究兴起阶段,生成图像建立在模型统计以及物理原理上,生成结果仅限于纹理或诸如人脸这种结构性较强的特定图案。随着研究的深入,利用深度神经网络进行表征学习在生成自然图像方面颇有成效,研究朝着生成高分辨率且逼真、生成图像多样化的方向推进。

人工智能背景下,服装图像自动生成在推动行业数字化进程中发挥着重要作用。本文选取生成对抗网络(GAN)为研究对象,以技术可实施性较强、应用服装领域最为广泛的变体——条件生成对抗网络(CGAN)模型为例,综述其在服装生成中的文字、图像、视频多个模态之间的相互转换进展,横向列举GAN赋能传统服装细分领域技术革新的相关案例,最后总结发展过程中所面临的问题及挑战。以期为时尚界AI研究的相关专家和学者提供理论参考和研究方向,同时予以服装领域相关产业技术升级一定启示。

1深度学习图像生成模型

1.1深度信念网络(Deep belief network,DBN)

DBN是由许多潜变量层构成的概率生成模型,通常是由多个限制玻尔兹曼机(RBM)组成[5]。研究证明DBN是手写数字图像等生成任务的良好模型[6],可在无监督学习下产生高质量图像样本,克服了以往梯度类学习算法易出现的梯度消失问题。Susskind等[7]通过人脸及相关高级描述符(包括面部动作编码系统和身份标签),训练DBN生成显示特定身份和面部动作的逼真人脸,证明了神经网络在表示人脸,同时与高级描述相关联是可能的。Osindero等[8]将横向连接添加到DBN隐藏层,通过实验对照验证添加横向连接能够有效提高DBN数据建模能力,进而生成逼真自然图像斑块。Torralba等[9]利用机器学习技术将Gist图像描述符转换为紧凑二进制码,减少内存占用同时保证图像识别效果,达到使用高效的数据结构处理大量图像进而生成彩色图像。

1.2变分自编码器(Variational auto-encoder,VAE)

VAE是一種无监督图像生成学习框架,具有采样速度快、处理方便、编码网络易接入等优势。Vahdat等[10]提出了一种基于深度可分离卷积和批量归一化生成图像的深层次模型Nouveau VAE,成功应用于256×256像素的高质量图像生成。Yan等[11]将图像建模为前景与背景的组合,提出一种可进行端到端学习的分层VAE生成模型,对人脸和鸟类进行了实验,证明模型能够在属性条件重建和合成中表现出良好的定量和视觉效果。Razavi等[12]扩展并增强了VQ-VAE中使用的自回归先验,并应用在大规模图像中进而生成更具相关性和保真度的合成样本。Cai等[13]提出从粗到细的多阶段图像生成方法,多级VAE将解码器分成两个模块,第一个模块生成草图,第二个模块在此基础上对图像进行细化,进而生成清晰的高质量图像。

1.3生成对抗网络(Generative adversarial networks,GAN)

生成对抗网络自2014年于Goodfellow等[3]提出,随后在图像识别与生成、图像修复、语义分割、风格转换等多领域中的应用研究接连展开。图像生成作为计算机视觉主流研究方向之一,围绕低训练难度、高分辨率、生成样本多样性等多种诉求衍生了丰富的GAN模型变体,使得GAN的发展脉络不断扩展和优化。按照GAN结构变体分类,模型涵盖了深度卷积对抗生成网络(Deep convolutional GAN)[14]、半监督学习生成对抗网络(Semi-supervised learning GAN)[15]、条件式生成对抗网络(Conditional GAN)[16]、拉普拉斯金字塔生成对抗网络(Laplacian pyramid GAN)[17]、边界均衡生成对抗网络(Boundary equilibrium GAN)[18]等。按照GAN损失函数变体分类,主要代表模型有Wasserstein距离生成对抗网络(Wasserstein GAN)[19]、WGAN-GP(Improved training of WGAN)[20]、F散度生成对抗网络(F-divergence GAN)[21]、最小二乘生成对抗网络(Least squares GAN)[22]。

1.4模型对比分析

DBN、VAE、GAN生成原理及优缺点如表1所示。服装领域应用中,DBN在蜡染图案识别[23]、人体部位及服装识别[24]、面部生成[7]、服装分类[25]等均有应用;VAE常应用在电商服装推荐系统[26]、服装设计[27]、风格分类[28]、服装风格迁移[29]等领域;GAN在服装领域中应用更为广泛,例如电商广告生成[30-31];服装搭配推荐[32-33]、服装设计[34-35];虚拟试衣等[36-37]。

深度生成模型将深度神经网络强大的学习表征能力与数理统计、概率论的相关知识结合,近年来取得了显著进步。2006年DBN被提出至2013年、2014年VAE、GAN模型的接连问世,三者之间随着模型可处理的数据样本集不断扩增,其各自的生成能力也随之递进。DBN在拥有足量无标注样本进行数据分布以及潜在特征的总结学习下,能够在小样本数据处理中展现优势,但生成图像的多样性和清晰度较差。VAE更适用于学习具有良好结构的潜在空间,然而生成图像清晰度欠佳。GAN没有变分下界,相较于DBN而言,GAN产生的样本可一次生成,无需重复利用马尔科夫链来完成;相较于VAE,GAN训练偏差小,鉴别器(Discriminator)的良好训练则足以保证生成器(Generator)充分学习训练样本分布。GAN作为业内无监督学习中处理复杂分布问题最为看好的模型,理论上任意可微分函数均可用以构建判别器(D)和生成器(G),训练时无需对隐变量做推断,生成图像多样且分辨率高,可应用场景多,能够带来较高经济价值。近几年,基于GAN的服装图像生成研究热度居高,不断衍生的变体模型正逐步改善以往图像生成所面临的不足。因此,本文以GAN为研究对象,探寻其在服装领域的发展脉络和应用趋势。

2基于多模态转换的服装图像生成

原始GAN存在生成内容随机、无法指定根据随机噪声生成的图像类型等问题,CGAN通过在生成模型(G)和判别模型(D)的建模中引入conditional variabley,从而完成从无监督到有监督模型的改进,实现生成器生成数据类别的指定[16]。相较于医疗、建筑等领域,庞大易得的服装数据集使得深度学习在该领域的发展更加广泛深入,按照数据输入类型和输出类型分类,CGAN实现生成的形式主要有文本转图像、图像转图像、图像转视频。

2.1文本转图像(Text-to-Image)

文本合成图像是指基于给定的文本描述生成所需图像的过程。生成图像分辨率越高,过程越具挑战性,Zhang等[38]提出堆叠式生成对抗网络StackGAN来生成基于文本描述的照片级真实感图像,首次实现基于文本描述的256×256像素图像生成。在此工作基础上,Zhang等[39]随后提出StackGAN++,将原有网络结构扩展成树状,实现多个生成器和鉴别器的并行训练,完成限定性生成到非限定性生成任务的跨越。提高生成图像与输入文本描述的细节关联度是一大关键,Xu等[40]提出注意力生成对抗网络(AttnGAN),在训练生成器的过程中提出深度注意力多模态相似度模型,计算细粒度的图像与文本匹配损失,对复杂场景的文本到图像生成任务颇具参考意义。为减少文本生成服装图像产生的伪影和噪声,解决在模特体形和姿势不变的前提下生成服装纹理与文本描述一致的问题,Zhu等[41]提出分两阶段完成生成任务的FashionGAN,实现穿着指定服装的人物图像的生成。类似生成任务中,Zhou等[42]基于自然语言描述引导人物姿势、服装属性生成,Günel等[43]提出一种以文本为条件的特征线性调制生成对抗网络(FiLMedGAN),能够在保证人体身形姿勢不变的情况下,通过输入不同的描述编辑图像进而产生新的服装。服装在语义分类上具有多个属性,如领型、袖长、图案、颜色、款式等多个类别,Banerjee等[44]提出基于条件和注意力GAN框架(AC-GAN),通过在生成过程中提供文本属性来对服装类别及背景分类。

2.2图像转图像(Image-to-Image)

生成对抗网络在服装设计中应用最广泛的形式即为图像到图像的转换。Pix2Pix作为CGAN的变体之一,是目前已知使用效能较好的图像到图像转换GAN框架,通过引入U-Net架构减轻训练负担并生成细致图像,能够优化单一输入图像对应多个输出问题,解决生成对抗网络模式崩溃[45]。Zhao等[46]扩展Pix2Pix以适应AR中的服装设计任务,提出的两阶段图像生成神经网络的补偿方法降低了条件输入的分布要求。Tango等[47]以Pix2Pix为基准模型,通过引入额外鉴别器和损失函数实现给定的动漫图像到cosplay服装图像的生成。Kwon等[48]基于Pix2Pix模型提出由粗到细的生成对抗网络Rough-to-Detail GAN以解决全局一致性问题,实现时装模特着装的精细生成。CycleGAN和DiscoGAN提出间隔较短,二者均摒弃对配对数据集的依赖性,通过双GAN机制实现图像到图像之间的转换。Fu[49]通过改进CycleGAN 网络实现图像的艺术风格转移,而Kim等[50]提出的DiscoGAN能够发现跨域关系,同样能在保证鞋子和包袋属性不变的情况下实现风格转移。为解决在处理两个以上的域面临可扩展性和鲁棒性限制问题,Choi等[51]提出StarGAN实现单个模型为多个域执行图像到图像之间的转换,该模型在服装设计中恰如其分,例如设计具有相同质感的不同类型服装,然而却存在生成图像缓慢以及不能有效保留输入图像的纹理特征问题,为此Shen等[52]提出GD-StarGAN,将StarGAN生成器的原始残差网络替换为全卷积网络U-net,提升损失函数的稳定性和收敛速度,使得输入与输出的服装图像纹理更为接近。在进一步增强服装纹理合成细节工作中,Xian等[53]提出的TextGAN模型通过细粒度纹理控制实现用户的精细需求。

2.3图像转视频(Image-to-Video)

利用GAN实现图像生成视频通常应用于延时摄影、视频帧预测以及视频动画的制作。面部表情视频预测中,Shen等[54]提出AffienGAN,将每个面部图像与表情强度相关联,并利用潜在空间中的仿射变换,实现从单个静止图像中预测任意时间长度的面部表情视频。为解决视频生成中的人物隐私问题,Maximov等[55]提出一种图像和视频匿名化模型CIAGAN,在消除面部和身体的识别特征的前提下生成可用于任意计算机视觉任务的高质量图像和视频。GAN在服装领域应用最广泛之处便是虚拟试衣。Dong等[56]开发一种基于图像的视频虚拟试穿系统FW-GAN,通过引入流判别器提升时空平滑性,同时在语法一致性损失函数的保障下能够合成任意姿势下穿着所需服装的人物视频。相关工作中,Pumarola等[57]将服装分割输出与时间一致的GAN相结合,通过填充遮挡区域并适应新的光照条件和身体姿势,逐步细化源纹理图使其适应目标人,进而实现参考图像中的服装到目标视频人物上的转移。为解决视频生成模型所需要的服装形状复杂非线性几何表达能力的缺乏问题,Ma等[58]提出MeshVAE-

GAN模型,通过学习3D扫描各类姿势的SMPL着装,首次实现直接修饰3D人体网格并泛化到不同姿势的服装变形。最近的虚拟服装试穿作品在量化所选的单独视觉效果中缺乏细致说明,同时并未指定对实验至关重要的超参数细节,针对此问题,Kuppa等[59]提出采用自下而上的试穿模型ShineOn,旨在阐明每个实验的视觉和定量效果。

对于CGAN而言,通过向生成器(G)中分别输入先验分布中采样出来的样本Z和当前的条件C(条件C可以是有关目标生成的描述性文本或者是包含基本特征的轮廓图),并将生成的对象X和条件C输出到判别器(D),判别器(D)通过评估生成对象X是否真实同时与条件C是否匹配并进行打分,最终即可生成满足目标条件的服装图像或视频。总结发现,基于CGAN的文本、图像、视频之间的多模态转换沿着生成数据精细化、清晰化同时具备高逼真度的方向改进,CGAN生成服装图像及视频研究分类总结如表2所示。Text-to-Image图像生成应用主要有给定模特换装、服装纹理渲染、人物姿势及服装属性生成、服装类别及背景分类;Image-to-Image图像生成多应用在服装设计、服装图像转换、风格迁移、虚拟试衣、流行趋势预测;Image-to-Video视频生成应用有:面部表情视频帧预测、匿名模特视频生成、虚拟试衣。

3服装图像生成相关产业应用

3.1服装横幅广告自动生成

智能生成技术在消费过程中产生的功能价值、社会价值、情感价值以及认知价值中均传递着积极影响[60]。服装作为电商主要销售产品,其横幅广告的大规模个性化生成在大型促销活动中尤为重要,依托智能设计所具有的强大图片生成能力不仅能有效提高服装商家的工作效率,降低店铺运营成本,同时也提升了数据利用率。另一方面,電商服装产品

及其购买体验需能够有效满足消费者的审美和享乐需求,在速度和新颖性方面也在不断逐快逐新,借助生成式人工智能打通全渠道时代电商广告的全链路营销,进而抓住消费者至关重要。阿里巴巴鹿班作为多媒体内容制作的AI辅助工具,通过引入生成对抗网络协助智能生成,其核心在于通过数据集的学习利用机器合成广告并不断调整优化。在其快速生成(一秒钟生成8000张banner)背后,其智能设计中的数据资源调用能够有效解决服装图片流量的问题,进而给商家带来流量红利。此外,大型电商活动中服装产品价格频繁更新,商家手动更改价格面临数字准确性、更新实时性以及操作成本等问题。鹿班通过技术手段赋能系统自动更新价格、智能生成图片并及时更新商品主图,有效清除picasso域名的cdn缓存,解决了服装大促活动中频繁更换横幅广告带来的商品缓存失效和cdn缓存图片低命中率等问题,保障了服装商家营销链路环节运营流畅。

3.2个性化服装推荐与生成

推荐系统是服装电商缩小繁多种类、快速导航的有效工具。Amazon、eBay、淘宝等国内外电商正逐步掌握用户兴趣,基于消费者点击、购买或者交互

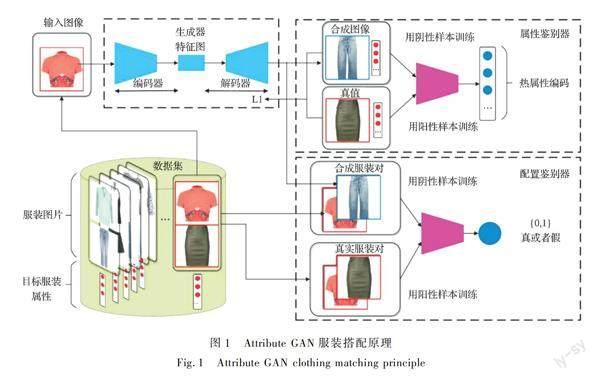

的历史观察使得其网站的服装推荐系统正趋于多样化、准确化。服装领域构建有效的推荐系统主要挑战在于该领域的高度主观性以及服装风格的语义复杂性[61]。研究中,服装智能搭配推荐通常与服装生成紧密结合在一起[62],将GAN添加到推荐系统中可以帮助在线零售商更好地获取消费者需求,核心技术在于对成套服装进行图像分割处理并提取筛选服装视觉、类别、文本特征后,利用生成对抗网络和孪生卷积神经网络(Siamese network)模型[63]自动生成服装搭配结果。推荐系统重点应用于电子商务、服装零售领域,例如适宜尺码服装推荐、日用产品推荐以及基于社交的流行服装推荐[64]。基于电商的大规模服装搭配数据集学习,采用CNN的“视觉感知”推荐器与GAN结合同样可有效生成与用户偏好相一致的多样化服装搭配[61]。研究表明,通过语义属性的服装匹配规则学习,生成对抗网络变体AttributeGAN能够在合成服装的多样性和匹配度上实现一定程度提升[65],其工作原理如图1所示,通过输入属性相关的服装图像,经过对抗训练的鉴别器会预测服装对的匹配与否,最终生成符合消费者审美和穿着习惯的服装搭配。

3.3服装与图案设计

因受众广泛性与数据公开性,与医疗等领域不同,服装领域拥有诸如Deep Fashion、Instagram、Pinterest等庞大数据集,为深度生成提供便利。国内外代表

性电商网站中,Amazon利用深度学习在发现、反应并塑造最新时尚趋势中占据优势,阿里巴巴也相继推出FashionAI项目实现服装行业人工智能革新。智能服装设计中GAN传递着积极作用,CGAN通过在生成器和判别器中添加参数向量y来生成特定条件下或者具备某些特征的图像,通过将不同类目的服装单品标签作为输入条件,目前已经实现了利用CGAN生成涵盖上装、裤装、连衣裙、鞋靴等各种品类的服装。如图2所示,麻省理工学院的研究人员开发一种能够生成时装设计的GAN模型,其独特大胆的生成(例如将普通袖子和喇叭袖设计在同一件服装上、超长的帽子)使得设计结果别有韵味。服装图案生成中,Wu等[66]提出ClothGAN模型进而生成带有敦煌元素的时尚服装,Tirtawan等[67]提出的CGAN模型能够生成蜡染图案服装,延续文化传统的同时丰富了智能服装设计中的图案元素。

3.4走向視频呈现的虚拟试衣

虚拟试衣在电影制作、视频编辑以及线上购物上均具有较大应用价值[56],电商平台中的虚拟试衣能够促进在线零售并减少包装和退货产生的碳足迹。早期虚拟试衣系统主要依靠三维人体扫描和计算机,耗费成本的同时处理繁琐,近年来研究人员利用深度神经网络生成虚拟服装,构建了例如CA-GAN、MG-VTON、FW-GAN等虚拟试衣模型,在自由变换服装[68]、改善图像欠拟合以实时适应人体姿势变化[69]、细化虚拟试衣纹理褶皱细节并赋予其真实性[70]、解决试衣中人体与服装之间干扰遮挡问题[71]的过程中优化递进。购买服装过程中试穿的实时性是一个有效加分项,Pix2surf模型[72]能够将电商网站上的海量服装图像转化为纹理贴图进而映射到三维虚拟衣物模型的表面达到贴合覆盖,进而实现实时虚拟试衣。虚拟试穿不仅在空间上实现2D到3D的跃升,同时实现了基于视频呈现的试衣,能够帮助消费者更加全面多角度地衡量试穿衣物的外观效果。如图3所示,Shineon模型[59]将模特与布料输入到U-net网络中,通过服装变形和试穿双模块机制作用,最终生成用户多角度试穿服装的视频。

4总结与展望

近年来的数字服装研究可具体划分为3个层次:低级服装识别(服装解析、地标检测、姿势估计)、中级服装理解(风格分类、服装检测、属性预测)以及高级服装应用(服装匹配检索、服装图像生成、流行趋势预测)。作为高级服装应用之一,服装图像生成现已取得了显著进展,在DBN、VAE、GAN 3种深度生成模型中,GAN因其低训练难度、高训练效率以及强大的生成能力成为目前图像生成研究的主流方向。围绕消费美学、心理学方面的生成诉求,GAN衍生的各种变体主要基于原模型的结构框架、损失函数予以改进,从而达到改进网络结构、提高模型稳定性、解决训练过程中梯度消失、难以收敛以及容易模式崩溃等问题,实现生成图像清晰多样化并兼具设计美感,有效迎合用户流行趋势和用户喜好,取代设计人员低层次、重复性的劳动进而提高工作效率。然而行业仍面临着诸如生成模型效用单一、服装数据集适用面窄以及缺乏生成评估的客观统一标准等问题,本文基于生成对抗网络应用技术原理以及目前所面临的人工智能技术挑战,提出以下总结:

a) 综合多模态生成的模型研发。深度生成技术在服装领域的应用多在电子商务领域,作为综合文字、图像、语音以及视频的多模态领域,相关研究已经朝着超大规模多模态预训练模型的研发前进,比如2021年阿里巴巴联合清华大学提出的中文多模态预训练及超大规模预训练模型“M6”,已经广泛落地到搜索、推荐、服装文案智能生成、服装设计等多个电商场景中,能够有效实现电商平台中各种服装的文本到图像生成,以及基于服装图片的文本描述,视频生成等。因此综合多个模态之间转换生成的大模型能够有效增强生成效用。

b)大规模服装数据集的集合。作为一种具有弱标签、多领域、多模态的特殊数据,服装数据集的良好表示对服装生成来说至关重要。一般将服装数据集分为单个任务基准数据集和多个任务基准数据集,目前存在着来源数据单一、作用任务局限、数据少以及跨越时间短的问题,缺乏包含多模态数据的统一大规模集合,因此这方面的努力具有广阔前景。

c)进行服装生成评估的客观标准。基于人类偏好或者初始分数是当前服装生成的主要评估指标,存在问题在于前者分数易受偏好个体的主观情感和身处环境的影响,而后者关注点更多地在于图像质量而不是美学因素。因此,建立一种服装生成评估的客观、稳健指标十分必要。

参考文献:

[1]HINTON G E, OSINDERO S, TEH Y W. A fast learning algorithm for deep belief nets[J]. Neural computation, 2006, 18(7): 1527-1554.

[2]DIEDERIK P K, MAX W. Auto-encoding variational bayes[J/OL]. ArXiv,2013:1312.6114. https://arxiv.org/abs/1312.6114v10.

[3]GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]// Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal, Canada, 2014:2672-2680.

[4]PARK T, LIU M Y, WANG T C, et al. Semantic image synthesis with spatially-adaptive normalization[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, CA, USA, 2019: 2337-2346.

[5]KAMADA S, ICHIMURA T, HARA A, et al. Adaptive structure learning method of deep belief network using neuron generation-annihilation and layer generation[J]. Neural Computing and Applications, 2019, 31(11): 8035-8049.

[6]HINTON G E, SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507.

[7]SUSSKIND J M, HINTON G E, MOVELLAN J R, et al. Generating facial expressions with deep belief nets[J]. Affective Computing, Emotion Modelling, Synthesis and Recognition, 2008, 2008(5): 421-440.

[8]OSINDERO S, HINTON G E. Modeling image patches with a directed hierarchy of Markov random fields[C]//Proceedings of the Twenty-First Annual Conference on Neural Information Processing Systems, Vancouver, British Columbia, Canada, 2007: 1121-1128.

[9]TORRALBA A, FERGUS R, WEISS Y. Small codes and large image databases for recognition[C]//Conference on Computer Vision and Pattern Recognition. IEEE, 2008: 1-8.

[10]VAHDAT A, KAUTZ J. Nvae: A deep hierarchical variational autoencoder[J/OL]. ArXiv,2020:2007.03898. https://arxiv.org/abs/2007.03898.

[11]YAN X, YANG J, SOHN K, et al. Attribute2image: Conditional image generation from visual attributes[C]//European Conference on Computer Vision. Springer, Cham, 2016: 776-791.

[12]RAZAVI A, VAN DEN OORD A, VINYALS O. Generating diverse high-fidelity images with vq-vae-2[C]//NIPS'19: Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver Convention Center, Canada, 2019: 14 866-14 876.

[13]CAI L, GAO H, JI S. Multi-stage variational auto-encoders for coarse-to-fine image generation[C]//Proceedings of the 2019 SIAM International Conference on Data Mining. Society for Industrial and Applied Mathe-matics, 2019: 630-638.

[14]RADFORD A, METZ L, CHINTALA S. Unsupervised representation learning with deep convolutional generative adversarial networks[J/OL]. ArXiv, 2015:1511.06434. https://arxiv.org/abs/1511.06434v2.

[15]ODENA A. Semi-supervised learning with generative adversarial networks[J/OL]. ArXiv, 2016:1606.0158. https://arxiv.org/abs/1606.01583v1.

[16]MIRZA M, OSINDERO S. Conditional generative adversarial nets[J/OL]. ArXiv, 2014:1411.1784. https://arxiv.org/abs/1411.1784.

[17]DENTON E L, CHINTALA S, FERGUS R. Deep generative image models using a laplacian pyramid of adversarialnetworks[J]. Advances in neural information processing systems, 2015, 28(1): 1486-1494.

[18]BERTHELOT D, SCHUMM T, METZ L. Began: Boundary equilibrium generative adversarial networks[J/OL]. ArXiv, 2017:1703.10717. https://arxiv.org/abs/1703.10717v4.

[19]ADLER J, LUNZ S. Banach wasserstein gan[J]. Advances in Neural Information Processing Systems, 2018, 31(6): 6756-6764.

[20]GULRAJANI I, AHMED F, ARJOVSKY M, et al. Improved training of wasserstein gans[J]. Advances in Neural Information Processing Systems, 2017, 30(12): 5769-5779.

[21]NOWOZIN S, CSEKE B, TOMIOKA R. F-gan: Training generative neural samplers using variational divergence minimization[J]. Advances in Neural Infor-mation Processing Systems, 2016, 29(12): 271-279.

[22]MAO X, LI Q, XIE H, et al. Least squares generative adversarial networks[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, Italy, 2017: 2794-2802.

[23]HANDHAYANI T, HENDRYLI J, HIRYANTO L. Comparison of shallow and deep learning models for classificationof Lasem batik patterns[C]// International Conference on Informatics and Computational Sciences. Semarang, Indonesia. 2017:11-16.

[24]CHEN Y, XUE Y. A deep learning approach to human activity recognition based on single accelerometer[C]//International Conference on Systems, Man, and Cybernetics. IEEE, 2015: 1488-1492.

[25]LIN X, PENG L, WEI G, et al. Clothes classification based on deep belief network[C]//3rd International Conferenceon Informative and Cybernetics for Compu-tational Social Systems (ICCSS). IEEE, 2016: 87-92.

[26]KIM J. Time-varying Item Feature Conditional Variational Autoencoder for Collaborative Filtering[C]//International Conference on Big Data. IEEE, 2019: 2309-2316.

[27]GU C, HUANG Z, LI S, et al. Apparel generation via cluster-indexed global and local feature representations[C]//9th Global Conference on Consumer Electronics (GCCE). IEEE, 2020: 218-219.

[28]PARK J. Improving fashion style classification perfor-mance using VAE in class imbalance situation [J]. Journal of the Korean Society for Information Technology, 2021, 19(2): 1-10.

[29]LU Z. Digital Image Art Style Transfer Algorithm and Simulation Based on Deep Learning Model[J]. Scientific Programming,2022, 2022(3): 1-9.

[30]LIU K L, LI W, YANG C Y, et al. Intelligent design of multimedia content in Alibaba[J]. Frontiers of Information Technology & Electronic Engineering, 2019,20(12): 1657-1664.

[31]陳伟.生成对抗网络在广告创意图制作中的应用[D].北京:中国科学院大学,2020.

CHEN Wei. Application of Generative Confrontation Network in the Production of Advertising Creative Map[D]. Beijing: University of Chinese Academy of Sciences, 2020.

[32]杨怡然,吴巧英.智能化服装搭配推荐研究进展[J].浙江理工大学学报(自然科学版),2021,45(1):1-12.

YANG Yiran, WU Qiaoying. Research progress of intelligent clothing matching recommendation[J]. Journal of Zhejiang Sci-Tech University (Natural Science Edition), 2021, 45(1): 1-12.

[33]杨争妍,薛文良,张传雄,等.基于生成式对抗网络的用户下装搭配推荐[J].纺织学报,2021,42(7):164-168.

YANG Zhengyan, XUE Wenliang, ZHANG Chuanxiong, et al. Recommendation of users' down-loading collocation based on generative confrontation network[J]. Journal of Textile, 2021, 42 (7): 164-168.

[34]陳涵,沈雷,汪鸣明,等.基于生成对抗网络的书法纺织图案设计开发[J].丝绸,2021,58(2):137-141.

CHEN Han, SHEN Lei, WANG Mingming, et al. Design and development of calligraphy textile pattern based on generative confrontation network [J]. Journal of Silk, 2021, 58(02): 137-141.

[35]曹宝秀.用神经网络自动设计服装[J].中国纤检,2019(4):120-121.

CAO Baoxiu. Automatic clothing design with neural network[J]. China Fiber Inspection, 2019 (4): 120-121.

[36]张颖,刘成霞.生成对抗网络在虚拟试衣中的应用研究进展[J].丝绸,2021,58(12):63-72.

ZHANG Ying, LIU Chengxia. Research progress on the application of generating network in virtual fitting [J]. Journal of Silk, 2021, 58(12): 63-72.

[37]徐小春.深度学习算法在虚拟试衣中的应用[D].无锡:江南大学,2021.

XU Xiaochun. Application of Deep Learning Algorithm in Virtual Fitting[D]. Wuxi: Jiangnan University, 2021.

[38]ZHANG H, XU T, LI H, et al. Stackgan: Text to photo-realistic image synthesis with stacked generative adversarial networks[C]//Proceedings of the IEEE International Conference on Computer Vision. IEEE, 2017: 5907-5915.

[39]ZHANG H, XU T, LI H, et al. StackGAN++: Realistic image synthesis with stacked generative adver-sarial networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 41(8): 1947-1962.

[40]XU T, ZHANG P, HUANG Q, et al. Attngan: Fine-grained text to image generation with attentional generative adversarial networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2018: 1316-1324.

[41]ZHU S, URTASUN R, FIDLER S, et al. Be your own prada: Fashion synthesis with structural coherence[C]//Proceedings of the IEEE International Conference on Computer Vision. IEEE, 2017: 1680-1688.

[42]ZHOU X, HUANG S, LI B, et al. Text guided person image synthesis[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. IEEE, 2019: 3663-3672.

[43]GNEL M, ERDEM E, ERDEM A. Language guided fashion image manipulation with feature-wise transfor-mations[J/OL].ArXiv, 2018:1808.04000. https://arxiv.org/abs/1808.04000.

[44]BANERJEE R H, RAJAGOPAL A, JHA N, et al. Let AI clothe you: Diversified fashion generation[C]//Asian Conferenceon Computer Vision. Springer, Cham, 2018: 75-87.

[45]ZHU J Y, ZHANG R, PATHAK D, et al. Multimodal image-to-image translation by enforcing bi-cycle consistency[C]// Advances in Neural Information Processing Systems. ACM Journals, 2017: 465-476.

[46]ZHAO Z, MA X. A compensation method of two-stage image generation for human-ai collaborated in-situ fashion designin augmented reality environment[C]//International Conference on Artificial Intelligence and Virtual Reality. IEEE, 2018: 76-83.

[47]TANGO K, KATSURAI M, MAKI H, et al. Anime-to-real clothing: Cosplay costume generation via image-to-image translation[J]. Multimedia Tools and Applications, 2022, 2022(4): 1-19.

[48]KWON Y, KIM S, YOO D, et al. Coarse-to-fine clothing image generation with progressively constructed conditional GAN[C]//14th International Conference on Computer Vision Theory and Applications. SCITEPRESS-Science and Technology Publications, 2019: 83-90.

[49]FU X. Digital image art style transfer algorithm based on cycleGAN[J]. Computational Intelligence and Neuroscience,2022, 2022(1): 1-10.

[50]KIM T, CHA M, KIM H, et al. Learning to discover cross-domain relations with generative adversarial networks[C]//International Conference on Machine Learning. PMLR, 2017: 1857-1865.

[51]CHOI Y, CHOI M, KIM M, et al. Stargan: Unified generative adversarial networks for multi-domain image-to-imagetranslation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2018: 8789-8797.

[52]SHEN Y, HUANG R, HUANG W. GD-StarGAN: Multi-domain image-to-image translation in garment design[J]. PloSone,2020, 15(4): 1-15.

[53]XIAN W, SANGKLOY P, AGRAWAL V, et al. Texturegan: Controlling deep image synthesis with texture patches[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2018: 8456-8465.

[54]SHEN G, HUANG W, GAN C, et al. Facial image-to-video translation by a hidden affine transformation[C]//Proceedings of the 27th ACM International Conference on Multimedia. ACM Journals, 2019: 2505-2513.

[55]MAXIMOV M, ELEZI I, LEAL-TAIX L. Ciagan: Conditional identity anonymization generative adversarial networks[C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. IEEE, 2020: 5447-5456.

[56]DONG H, LIANG X, SHEN X, et al. Fw-gan: Flow-navigated warping gan for video virtual try-on[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. IEEE, 2019: 1161-1170.

[57]PUMAROLA A, GOSWAMI V, VICENTE F, et al. Unsupervised image-to-video clothing transfer[C]//Proceedings of the IEEE/ CVF International Conference on Computer Vision Workshops. IEEE, 2019: 0-0.

[58]MA Q, YANG J, RANJAN A, et al. Learning to dress 3d people in generative clothing[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. IEEE, 2020: 6469-6478.

[59]KUPPA G, JONG A, LIU X, et al. ShineOn: Illuminating design choices for practical video-based virtual clothing try-on[C]//Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision. IEEE, 2021: 191-200.

[60]SOHN K, SUNG C E, KOO G, et al. Artificial intelligence in the fashion industry: Consumer responses to generative adversarial network (GAN) technology[J]. International Journal of Retail & Distribution Manage-ment, 2020. 49(1): 61-80.

[61]KANG W C, FANG C, WANG Z, et al. Visually-aware fashion recommendation and design with generative image models[C]//International Conference on Data Mining. IEEE, 2017: 207-216.

[62]YU C, HU Y, CHEN Y, et al. Personalized fashion design[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. IEEE, 2019: 9046-9055.

[63]SUN G L, CHENG Z Q, WU X, et al. Personalized clothing recommendation combining user social circle and fashion styleconsistency[J]. Multimedia Tools and Applications, 2018, 77(14): 17731-17754.

[64]DOKOOHAKI, N. Fashion Recommender Systems[M]. Springer International Publishing, 2020.

[65]LIU L, ZHANG H, JI Y, et al. Toward AI fashion design: An attribute-GAN model for clothing match[J]. Neurocomputing,2019, 341(5): 156-167.

[66]WU Q, ZHU B, YONG B, et al. ClothGAN: Generation of fashionable Dunhuang clothes using generative adversarial networks[J]. Connection Science, 2021, 33(2): 341-358.

[67]TIRTAWAN T, SUSANTO E K, ZAMAN P L, et al. Batik clothes auto-fashion using conditional generative adversarial network and U-Net[C]//3rd East Indonesia Conference on Computer and Information Technology. IEEE, 2021: 145-150.

[68]JETCHEV N, BERGMANN U. The conditional analogy gan: Swapping fashion articles on people images[C]//Proceedings of the IEEE International Conference on Computer Vision Workshops. IEEE, 2017: 2287-2292.

[69]DONG H, LIANG X, SHEN X, et al. Towards multi-pose guided virtual try-on network[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Seoul. 2019: 9026-9035.

[70]LAHNER Z, CREMERS D, TUNG T. Deepwrinkles: Accurate and realistic clothing modeling[C]//Proceedings of the European Conference on Computer Vision. Munich, 2018: 698-715.

[71]YU R, WANG X, XIE X. Vtnfp: An image-based virtual try-on network with body and clothing feature preservation[C]//Proceedings of the IEEE/CVF International Confe-rence on Computer Vision. IEEE, 2019: 10511-10520.

[72]MIR A, ALLDIECK T, PONS-MOLL G. Learning to transfer texture from clothing images to 3d humans[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. IEEE, 2020: 7023-7034.

Research progress of clothing image generation based onGenerative Adversarial Networks

SHI Qian, LUO Ronglei

(a.School of Fashion Design & Engineering; b.Zhejiang Provincial Engineering Laboratory of Fashion Digital Technology,

Zhejiang Sci-Tech University, Hangzhou 310018, China)

Abstract: The depth generation model mainly includes Deep Belief Network (DBN), Variational Self-Encoder (VAE) and Generative Adversarial Network (GAN). GAN, as a popular in-depth learning framework in recent years, constructs two networks G and D which are mutually antagonistic and game, so that they can achieve Nash equilibrium through continuous iterative training and then realize the automatic generation of images. GAN can be applied in many fields, including semi-supervised learning, sequence data generation, image processing, domain adaptation, etc. The image processing field can be subdivided into multiple scenes, such as image generation, image super-resolution, image style transformation, object transformation and object detection. The most widely used and successful part of GAN in image processing is image generation. Clothing image generation based on 5G, big data, depth learning and other technologies can effectively promote the digital development process of apparel e-commerce.

Conditional Generative Adversarial Network (CGAN) implements constraints on sample generation by adding constraint condition Y to GAN. CGAN can direct the generator to synthesize data in a directional way against expected samples. Therefore, CGAN is an effective model to realize automatic generation of clothing images that meet specific needs. During the training, the generator learns to generate realistic samples matching the labels of the training data set, and the discriminator learns to match the correct labels for the identified real samples. At present, the public clothing data sets that can be applied to clothing image generation mainly include Fashion-MNIST, Deep Fashion, Fashion AI, etc. According to the data morphology classification of the input model and the output model, the main forms of CGAN implementation in the clothing field are Text-to-Image, Image-to-Image and Image-to-Video. The three data synthesis forms respectively contain various derived GAN models, which correspond to different clothing generation application scenarios. Text-to-Image aims to generate the required clothing image based on the given description text, which can be specifically applied to a given model change, clothing texture rendering, character pose and clothing attribute generation, clothing category and background classification; Image-to-Image is mostly applied in clothing design, such as clothing pattern design, clothing image conversion (from sketch to cartoon clothing, model to dress), style transfer, virtual fitting, fashion trend forecast, etc.; Image-to-Video is usually applied to facial expression video frame prediction, anonymous model video generation, virtual fitting and other scenes.

In recent years, research on GAN-applied clothing image generation industry is mostly distributed in the field of e-commerce, including automatic generation of clothing banner advertisements, personalized clothing recommendation system, clothing and pattern design, virtual fitting towards video presentation, etc., which greatly enables the upgrading of related digital clothing industry. However, the industry is still facing the problems of single utility of generation model, narrow application of clothing data set and lack of objective and unified criteria for generation evaluation. The research in the future will focus on the research and development of integrated multi-modal generation model, the collection of large-scale clothing data sets, and the development of objective criteria for clothing image generation and evaluation.

Keywords: deep learning; GAN; clothing generation; intelligent ad design; virtual fitting.

收稿日期:20220324網络出版日期:20220613

基金项目:浙江省一般软科学研究计划(2022C35099);浙江省丝绸与文化艺术研究中心培育项目(ZSFCRC20204PY)

作者简介:施倩(1997—),女,河南信阳人,硕士研究生,主要从事数字服装、计算机视觉方面的研究。

通信作者:罗戎蕾,E-mail:luoronglei@163.com