满足不同交互任务的人机共融系统设计

2022-09-30禹鑫燚王正安吴加鑫欧林林

禹鑫燚 王正安 吴加鑫 欧林林

随着自动化与机器人技术的发展,机器人在制造、运输、仓储等许多领域中都得到了广泛应用,然而大部分的机器人仍处在与人完全隔离的环境下进行工作,一方面是为了避免安全上的隐患,另一方面是为了降低系统部署的难度.虽然人机隔离的工作方式能够发挥机器人在运动精度和速度上的优势,适用于一些简单重复性的工作,但对于一些需要复杂判断能力和灵活机动性的工作,目前大部分的机器人很难单独胜任,而且大部分机器人都缺乏在人机共融环境下工作的能力,导致这些工作只能由人来完成[1].为了改变人机分离工作的现状,希望机器人以协助的方式参与到人的生产工作中,负责搬运、夹持、预处理等任务,减少人的负担,提升整体的工作效率.

为了让机器人融入有人参与的工作环境,首先需要解决的是人机之间的安全问题.国际标准化组织提出了4 种实现安全人机协作的方式: 1)安全级监控停止: 当检测到人和机器人同时处于协作区内时,机器人保持停止;2)手动引导: 通过手动引导的装置或设备在协作区内对操作机器人的末端工具使其达到期望的位置和姿态;3)速度与距离监控: 机器人与操作人员时刻保持在一定距离以上,当机器人本身的运行速度越大,需要与人保持的距离也越大;4)功率及力限制: 通过限制机器人本身的力/力矩输出来防止对人的伤害[2-3].针对不同情况的人机交互,Bdiwi 等[4]对国际标准化组织提出的安全模式进行了扩展,根据视觉信息,如触碰、分离、遮挡等定义机器人当前需要符合的行为;Bdiwi[5]对人机协作的交互等级做了更细致的划分,规定了不同交互等级下机器人需要符合的行为和场景内需要被监控的信息.可以看出,实时信息监控对于任何形式的人机协作都是非常重要的.

信息监控包括对机器人运动的监控、受力输出力矩的监控以及人体动作的监控等.要实现机器人的运动监控,需要解决机器人在周边环境中的定位问题.对于固定安装的机器人,可以采用相机手眼标定的方式对机器人在相机坐标系下的位姿进行确定[6];而对于包含移动平台的机器人,根据使用场景的不同,可以采用即时定位与地图构建或定位标记的方式确定机器人的位姿.对于人体姿态的实时估计,目前的方法主要有3 种: 1)基于光学标记的人体姿态捕捉;2)基于惯性传感的姿态捕捉;3)基于图像和卷积神经网络的姿态估计.Vicon 和Optitrack 等公司为基于光学标记的人体姿态捕捉提供了商业化的解决方案: 姿态捕捉的对象需要穿戴特殊服装并粘贴相应的光学标记,通过空间中的多台红外摄像机组对人体动作进行采集.该方法具有较高的精度和响应速度,但由于穿戴方式过于复杂和成本较高等原因不适合工业环境的使用[7].基于惯性传感的方式需要在身上佩戴惯性测量单元(Inertial measurement unit,IMU),Von Marcard 等[8]研究中使用稀疏传感器配置来估计人体姿态,但需要利用一个时间片段内所有的加速度和旋转信息进行优化计算来保证估计的准确率,实时性较差.此外,基于惯性传感器的方法主要的问题在于无法对捕捉人员在空间中的绝对位置进行有效的估计[9].基于图像的姿态估计方法近年发展迅速,其主要原理是利用卷积神经网络对人体肢体、关节进行识别,不需要佩戴任何设备,降低了使用的门槛.Cao 等[10]提出了一种利用单张图像估计多人2D 姿态的方法,在硬件加速的情况下能够达到准实时的效果.结合人体运动学拟合方法.Mehta 等[11]利用卷积神经网络给出了基于单目相机的3D 人体姿态计算方法.基于图像的姿态估计方法很难对误差进行控制,对于遮挡、画面背景、图像输入分辨率等因素较为敏感,而且仅依靠视觉信息很难对肢体的旋转信息做出有效的检测.除以上利用彩色图像进行人体姿态估计的方法,也有利用深度相机的深度图像进行人体姿态识别的研究.Shotton 等[12]提出了基于单张深度图像的3D 人体姿态快速计算方法,但其检测效果也同样容易受到遮挡,光照等因素的影响.

除了人机信息的采集,机器人的灵活控制在人机交互系统中也起到非常重要的作用.灵活的控制策略能够保证机器人对不同交互情况具有良好的适应性[13].Flacco 等[14]提出一种深度图下快速估计多个动态质点之间的距离的方法,并利用距离向量所生成的斥力场实现了机器人的动态避障.Tsai 等[15]研究了7 轴机器人的轨迹规划方法来执行人机共融环境下的工作任务,并通过仿真验证了其轨迹规划方法的可行性.Mohammed 等[16]提出了一种视觉驱动的机器人动态避障方法,并在VR 虚拟空间中进行了实验验证了算法的有效性.目前普遍的机器人控制研究没有对人机交互中任务目标的随机性和工作场景频繁的变化进行充足的考虑,很难保证机器人在动态环境下的控制可靠性.

为了实现安全高效的人机交互,本文对人机共融环境下人与机器人的运动状态估计方法,以及交互系统中机器人的控制方法进行了研究.为了在人机共存的环境下实时获取稳定的人体姿态,采用了多相机和IMU 信息融合优化的方式对人体姿态进行估计,提升了人体姿态估计效果的鲁棒性,避免了单相机视角下对遮挡因素敏感的问题,并通过融合IMU 信息实现了对肢体旋转旋转信息的检测,提供了有效的交互信息.此外,结合机器人本身的运动学特性,设计了机器人的交互控制策略.所设计的控制策略能够提升机器人在复杂环境中工作的安全性,且对不同的任务目标能够灵活的切换,提高了机器人在不同场景下的适应性.

本文的内容组织结构如下: 第1 节提出了人机共融系统的系统设计,第2 节研究了机器人和操作人员的姿态解算方法,第3 节设计了机器人控制策略,第4 节通过若干实验说明了算法和控制方法的有效性和实用性.

1 系统设计

在人机共融系统下工作的机器人,主要起到协助操作人员进行工作的作用.图1 给出的动作跟随、目标指定、动态避障等较为典型人机协作方式,在非接触式人机交互中有较强的应用价值.为了满足上述功能,实现可靠的交互,需要稳定的人体姿态识别算法和灵活的机器人控制策略.

图1 人机交互方式Fig.1 Patterns of human-robot interaction

对于人体姿态估计问题,基于单相机的方法对遮挡、光照、背景等环境因素较为敏感,而且仅基于图像信息很难对人体肢体的旋转信息进行有效的判断.本文拟采用多相机与IMU 信息融合的方法对人体姿态进行估计,以提升人体姿态识别的精度、稳定性和姿态信息的完整性.

对于人机交互应用中的机器人控制,需要使用合适的交互控制策略使得机器人能够适应不同的交互模式下不同的控制需求.本文拟针对不同的交互方式给出相应目标点生成方式,机器人通过对相应目标点进行追踪以实现不同的交互运动;结合模型预测控制,通过建立优化函数,以调整优化参数的方式使机器人适应不同模式下的控制性能要求.

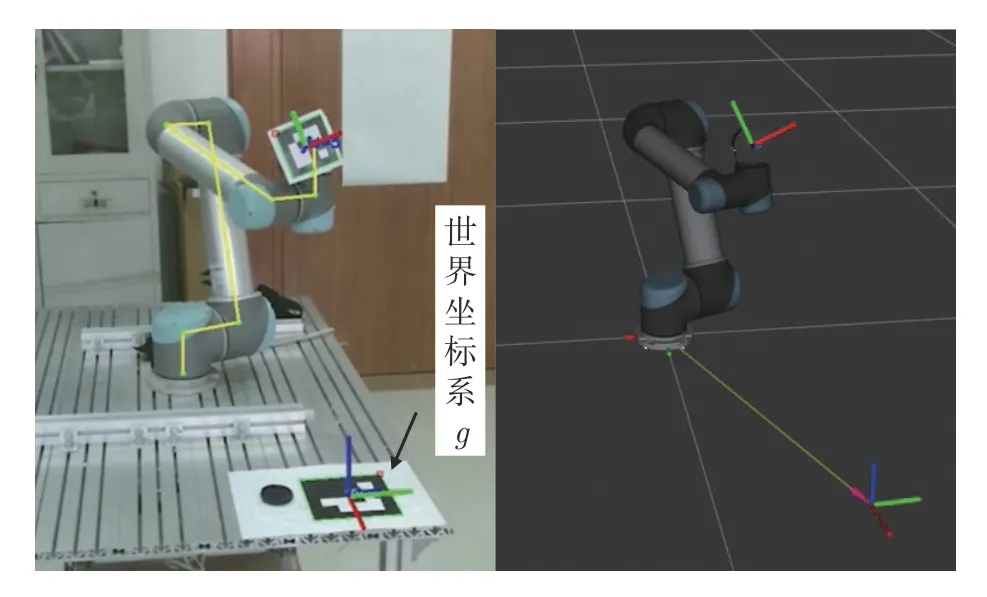

具体的系统设计如图2 所示.机器人的工作空间处于多台固定架设的相机视野下,机器人的坐标系与相机坐标系的变换关系通过机器人手眼标定获得,从而可以通过机器人运动学计算出机器人的运动状态.利用多台相机的2D 人体姿态估计结果和操作人员所佩戴的IMU 的旋转信息,在人体姿态估计模块中通过构造能量函数,对传感器信息进行融合并优化求解出3D 的人体姿态信息.系统通过分析操作人员与机器人的空间关系,并结合当前的交互模式生成机器人的任务目标,机器人的任务目标经过系统修正以保证安全性与合理性.最后,以生成的任务目标为参考,通过模型预测控制器生成机器人的运动指令,最终控制机器人运动完成交互行为.“虚拟环境”作为整个系统信息交换的中枢,存储了当前实时的人机姿态信息,起到信息同步和可视化的作用.在人机交互系统中,基于多传感器融合的人机姿态解算、机器人的目标点生成和修正方法以及灵活的控制策略是本文研究的核心问题.

图2 人机共融系统示意图Fig.2 Overview of human-robot coexisting system

2 基于多传感器的三维人机姿态解算

2.1 虚拟空间的坐标关系描述

在图2 所示的虚拟环境中,利用坐标系来表示空间中人与机器人的状态.人与机器人都被视为独立的刚体运动系统,分别具有各自的基坐标系.对于机器人,基坐标系为机器人的基座坐标系;对于操作人员来说,髋部关节坐标系被视为基坐标系.为了方便对人与机器人之间的位姿关系进行计算和表示,在虚拟环境中还设有世界坐标系,机器人与操作人员的定位信息都基于世界坐标系来表示.虚拟3D 环境中的人机动作捕获主要依靠多台单目相机构成的视觉系统.多台单目相机之间的空间关系采用了标定板进行了标定,最后,所有相机的相机坐标系也基于世界坐标系进行表示.

2.2 机器人的姿态解算

对于固定安装的机器人,其基坐标系与世界坐标系的关系保持恒定,因此只需对基坐标系进行标定,得到机器人基坐标系与世界坐标系之间的固定关系.在相机固定安装的条件下,通过一种基于迭代最小二乘法的机器人手眼标定方法[6],配合视觉标记对固定安装的机器人进行标定,得到相机坐标系c下机器人基坐标系r0的位姿.世界坐标下机器人基坐标系的位姿表示为:

机器人可以被视为串联的刚体连杆运动系统,具有数个串联的连杆,父连杆与子连杆之间由单自由度的旋转关节连接.通过机器人正运动学,可以从基座坐标系对机器人的子连杆坐标系进行推算.机器人子连杆rj相对机器人基座r0的位姿的计算公式为:

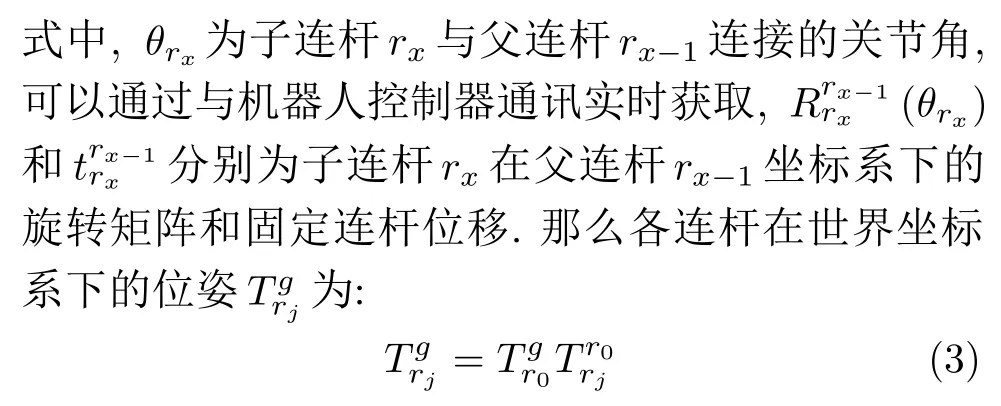

由式(3)可以计算出如图3 所示的机器人在虚拟空间中的运动状态.

图3 机器人动作解算结果Fig.3 Robot pose estimation result

2.3 基于多传感器融合的人体动作解算

在人机交互过程中,需要获得尽可能完整的人体动作信息,同时需要考虑姿态估计的稳定性.一般基于图像的方法容易受到遮挡的影响,而且很难对手掌等部位的旋转信息进行有效的检测.本节建立了人体上肢骨骼模型,并引入了可穿戴的惯性测量单元,配合多台相机进行人体动作的估计.

2.3.1 人体上肢模型的建立

与机器人类似,本系统中,人体也被视为串联的刚体运动系统.在与机器人的交互行为中,人体的上肢动作信息更为重要.为了对人体上肢姿态进行表示和计算,基于文献[17]的数据集,建立了人体上肢的运动学模型,如图4 所示.人体上肢运动学模型为包含10 个连杆的运动系统,其中,根连杆h0(髋部)为人体基坐标系,包含相对世界坐标系表示的姿态和位移其余子连杆hj,j ∈{1,2,···,9}通过球形关节与父连杆连接,相对于父连杆有旋转和常量连杆位移其中,是用于表示球形关节欧拉角旋转量的3 维向量.人体模型中的左肩连杆h2和右键连杆h6同时将胸部连杆h1作为父连杆,区别于机器人的结构,以prt作为父连杆编号.令P(hj) 为连杆hj所有上级连杆的集合,则hj在世界坐标系下的位姿为:

图4 人体上肢骨骼关节点Fig.4 Key points of human upper limb skeleton

2.3.2 能量函数构造

人体动作估计需要融合视觉和IMU 传感器的数据,对θh进行求解.建立θh的目标函数

式中,ER(θh)为人体上肢模型中连杆姿态与IMU测得肢体姿态的误差项,EP(θh)表示视觉传感器测得的人体肢体位置的误差项,EL(θh)为人体关节自由度约束项,αR、αP、αL分别为上述3 项的权重系数.通过最小化E(θh)能够求得融合了视觉信息与IMU 信息的人体动作估计结果θh.

1) IMU 误差项

人体姿态估计中,IMU 佩戴方式如图4 所示,需要在腰部、左手臂、右手臂、左手掌和右手掌佩戴IMU.各个IMU 能够检测自身在世界坐标系下的姿态对应其追踪的肢体连杆hj.在佩戴好IMU 后,肢体连杆坐标系hj与IMU 传感器坐标系Ij存在固定的旋转偏差,该偏差能够在人体姿态估计的初始化阶段通过动作标定计算得出,具体计算方法见式(12).那么肢体连杆hj在世界坐标系下的IMU 测量值表示为:

式中,I为佩戴有IMU 的肢体连杆编号的集合,Γ(·)将旋转矩阵转化四元数并取其向量部分.

2)视觉误差项

式中,Projc(·) 为相机c的3D-2D 投影函数.最后建立视觉误差项:

式中,C为所有相机的集合,J为所有关键点的集合.

3)关节自由度约束项

仅依靠穿戴的IMU 和图像的信息无法很好地保证优化中θh收敛结果的合理性.其主要的原因在于传感器信息的自由度不足,无法完全约束人体模型的关节自由度.例如肩部连杆和胸部连杆的关节信息并没有被IMU 直接观测,主要依靠图像信息进行估计.在建立人体运动学模型时,虽然人体的每一个连杆关节具有3 个自由度,但对于实际的人体,大部分的关节都有着运动方向和角度上的限制,并非所有的关节都能满足3 个自由度上的自由旋转.

通过对人体动作数据集[17]的分析,可以得到各个关节数据分布的均值和标准差,以此建立关节自由度约束项:

式中,J′为除髋关节外所有旋转关节的集合.标准差较大的关节在关节运动限制上有着较大的容忍度;而对于标准差较小的关节,与均值偏差较大的优化结果会导致该项的计算结果显著增大.最小化该项能够使优化求解所得出的姿态更趋近数据集中存在的姿态,从而达到约束关节自由度的效果.

2.3.3 人体姿态的优化求解

式(5)中的IMU 误差项(7)和视觉误差项(9)分别定义了两种传感器在人体姿态优化求解过程中的误差,但由于所对应物理量量纲的不同,以及传感器本身对测量误差的容忍度不同(IMU 一般不会出现较大的测量误差,而基于卷积神经网络的图像数据处理经常出现不合理的输出结果),需要调整各项所对应的权重系数α∈[0,1] 以平衡各项在优化过程中的作用,对于关节自由度约束项(10)同理.

同一时刻的IMU 数据和图像检测数据作为一组传感器数据,对于每一组传感器数据,首先将对式(7)与式(9)进行数据代入,再建立优化目标问题(11),给定优化过程的初始迭代值,并采用Levenberg-Marquardt 法在约束范围内对该非线性问题的最小值解θh进行迭代搜索,最后收敛得到当前人体姿态的计算结果.

在优化问题中给定接近最优解的初始迭代值能够提升梯度下降的效率,并减少求解陷入局部最优的可能性,为此使用前一组数据所求得的姿态结果作为初始迭代值来进行优化问题的求解.而对于优化第一组数据,由于没有上一时刻的结果可以利用,设计了初始化阶段以提供最初的迭代值.在初始化阶段中,预先定义了一个初始姿态(一般为Tpose: 即保持身体直立,双手向两侧平举的姿态),操作人员需要和初始姿态保持吻合,再以初始姿态作为当前优化问题的初始值进行姿态求解,以计算得到第一组数据的姿态估计结果.同时,由于给定了初始姿态,各个IMU 与相应骨骼连杆的固定旋转偏移能够在初始化阶段进行计算:

3 人机共融系统中的机器人控制

在人机交互应用中,机器人以操作人员为中心进行工作,操作人员在交互过程中常常起到指定任务目标的作用.然而,人在交互过程中所给定的目标具有潜在的随意性和不合理性.随意性是指操作人员往往无法直接给出精确的任务目标,而需要给出大致目标后,经过不断的反馈调整最终令操作人员达到满意;不合理性是指,人在指定目标时往往并不考虑机器人自身能力与周围环境等因素,给出的目标容易导致机器人不安全的运动,甚至发生碰撞而导致损耗等情况.在人机交互的过程中,机器人一方面需要对频繁发生变动的目标进行快速的响应,提高交互的效率和舒适度,同时另一方面需要考虑操作人员和自身的安全,对于不合理的目标指令进行修正,并及时对操作人员发出反馈.本节首先对人机交互中不同模式的目标点生成方法进行阐述,随后提出基于边界限制的目标修正和机器人的模型预测控制来解决上述的问题.

3.1 机器人目标点生成方法

在所设计的系统中,机器人在工作状态下始终具有一个任务目标,机器人通过对进行跟踪来达到交互目的.基于第2 节中构建的虚拟环境中得到的信息,对图1 中给出的几种交互方式所对应的的生成方式进行说明.

1)动作跟随模式

式中,I3为3 阶单位矩阵.

2)目标指定模式

如图1(b)所示,机器人的工作环境中一般存在若干操作平面.在虚拟环境中,人体运动模型的手掌连杆能够形成射线矢量与机器人的操作平面相交,若相交点处于操作平面内,则以相交的位置作为机器人的行动目标.在该模式下能够让操作人员方便地对桌面上离散的目标进行指定,命令机器人进行抓取等操作.

3)动态避障模式

系统能够实时地对虚拟环境中机器人的各个连杆与人体的各个连杆的距离进行计算.如图1(c)所示,当机器人处于自主运动状态(指操作人员并无意图控制机器人运动的情况),同时检测到机器人连杆与人体连杆距离过近时,能够触发该模式,通过动态避障算法实时修正,对人体进行避让.本文以人工势场法为启发,设计了基于斥力引力场的避障目标点生成方法: 当人体与机器人距离足够大的情况下,机器人向任务目标运动,目标点对机器人工具坐标系rtool产生引力向量Fo:

式中,δ∈(0,∞)为目标点距离系数,用于调整合成力与生成的目标点之间的线性关系.

3.2 机器人运动控制策略设计

3.2.1 任务目标的修正

图5 机器人运动边界Fig.5 Boundary of robot motion

1)奇异状态边界.理论上,机器人具有以基座为中心,最大臂展R为半径的球形的最大可达工作空间W{R}.但是机器人在达到最大伸展距离时会处于奇异姿态,在奇异姿态下无法保证逆运动学求解的合理性,这将导致机器人的运动方式进入一种难以预估的状态.为了避免奇异姿态的出现,对机器人的工作空间进行了限制.若理论上的机器人最大工作空间半径为R,则令限制后的工作空间半径为R′=0.9R,超出工作空间W{R′}的目标姿态将被重新限制到W{R′}的边界,以此避免了奇异姿态的出现.

2) 静态障碍物边界.除了工作空间W{R′}的限制外,机器人的运动还受到工作空间中静态障碍物的限制,对于体积较大的静态障碍物,如操作台面,货架等,机器人难以通过运动规划对其进行避让,那么系统根据此类障碍物的形状形成边界,在W{R′}的基础上对工作空间进行限制.这些边界的生成需要使用者根据机器人所处的具体环境在虚拟环境中对障碍物进行配置,每个障碍物都设有接触阈值,根据阈值系统会在障碍物周围形成外包络边界,目标姿态将会被限制在包络边界外,以免和环境发生碰撞.

3)自碰撞边界.机器人在运动时也可能会与自身发生碰撞,类似静态障碍物,机器人自身在连杆周围根据接触阈值形成外包络边界,目标姿态将被修正在边界外,防止自碰撞的发生.

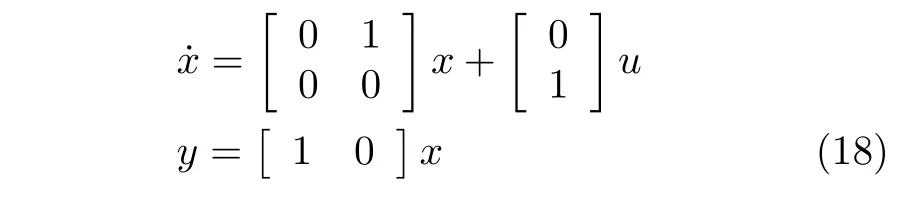

3.2.2 基于模型预测的机器人灵活控制

在人机交互系统中,针对当前不同情况可能有着不同的控制需求.比如在动作跟随模式下,机器人需要快速的响应速度以减小轨迹的跟踪误差,而在近距离的交互过程中,运动过程的柔和度和人机安全更加重要.为了能够灵活地调整机器人的控制策略,使用了模型预测控制分别应用于各个机器人关节.控制器设计如图6 所示,其中,为预测时间窗口Tpre内的机器人的目标关节角序列;目标点的序列经逆运动学求解得出;控制量u为关节角加速度分别为关节位置和关节角速度.单关节预测模型通过输入u对机器人关节状态x=进 行计算,θpre和分别为预测时间窗口Tpre内的关节位置和关节角速度的预测结果序列,机器人的单关节状态空间模型定义如下:

图6 基于单关节模型的预测控制器Fig.6 Model predictive controller based on single robot joint

建立如下的优化问题进行滚动优化:

通过调节qp、qv、qa的大小,能够有效地改变控制侧重的性能指标: 在qp相对较大,qv和qa相对较小的情况下,能够保证机器人具有较好的轨迹跟踪性能;反之,在qv和qa相对较大时,轨迹跟踪的实时性下降,但能够更好地限制机器人的运行速度和加速度,使得机器人的运动更为柔和.针对不同的交互情况可以使用不同的机器人控制策略,同时机器人的运动能够严格保持在最大速度vmax和最大加速度amax的约束之下,从而实现安全灵活的机器人交互控制.

4 系统实现与验证

为了验证所提出的机器人共融系统的性能,设计了若干实验,分别对第2 节提出的人体姿态估计方法的稳定性和第3 节提出的机器人控制策略对动态目标的跟踪性能以及人机共融环境下的人机交互可行性进行了验证.

4.1 系统具体配置

系统中的交互在一对一的情况下展开.使用的机器人为串联6 轴协作型机器人UR5.使用的传感器包含高清相机3 台,5 个可穿戴式IMU.高清相机的图像传输分辨率为1 920 × 1 080,通过USB3.0接口与主机相连.该分辨率下的图像主要用于相机的标定环节,每台相机利用支架架设于交互场景的高处,均匀的分布的场景的周围,主要目的是为了保证相机的视野.在相机经过标定得到内外参数后,在实际实时处理过程中被降采样为960×540 的分辨率.在降采样后,图像在传输和识别部分的延迟都能够得到有效降低.人体2D 关节点的识别使用文献[10]方法,本文使用的主机配置为i7-8700X,Nvidia Titan Xp,在识别环节能够达到25 Hz 的帧率,处理结果有40 ms 左右的延时.

可穿戴式的IMU 使用无线网络与主机进行数据传输,为了方便计算,将IMU 的参考坐标系设为和相机标定得到的世界坐标系保持一致.每个IMU与相应人体连杆的固定偏差通过预设定的初始人体姿态进行标定得到.

UR5 与主机采用socket 通讯方式进行数据传输,主机对UR5 的30002 端口进行数据解析以获取机器人各关节角度θr与角速度,同时对30003端口进行速度指令写入以控制UR5 的运动.

4.2 人体动作估计稳定性实验

单台相机图像处理得到的2D 姿态估计结果常常由于遮挡因素导致识别上的错误,而在与机器人的近距离交互过程当中,遮挡的情况时有发生.本文通过一组时长60 秒的人体姿态数据进行实验,验证了第2.3 节提出的人体姿态解算方法在不同传感器配置下的准确度.实验中所使用的人体姿态求解能量函数(5)的权重系数为:αP=1.0,αR=8.0,αP=5.0,实验结果如表1 所示.需要注意的是,由于人体关节具体位置定义的模糊性,不采用绝对的参考值进行准确率的判断,在姿态估计结果与当前图像大致吻合时即认为该帧数据的估计结果准确,只有当某一帧数据的计算结果和图像本身出现了明显偏差时,该帧数据被视为不准确,判断准确率时不考虑肢体的旋转信息,准确率的计算公式为: 准确帧帧/实验数据总帧数.

表1 不同传感器配置下的人体姿态估计准确率Table 1 Accuracy of human pose estimation under different sensor configurations

由表1 可以看出,相机的使用数量对准确率有着显著的影响,在只使用两台相机的信息时,非常容易出现遮挡导致的结果失真.在使用了第3 台相机后准确率有了很大的提升,偶尔出现的姿态结果失真一般都能够快速恢复正常.IMU 的使用对结果准确率的提升有一定的帮助,其主要的作用在于提供准确的肢体旋转信息.

图7 给出了同一组数据下使用不同传感器配置时的姿态估计情况.相机图像中的圆圈标志为被识别的人体关键点,其半径代表了式(9)中置信度的大小,人体身上标明的骨架信息为姿态估计的结果.使用2 台相机是实现人体姿态捕捉的最小传感器配置,但在信息受到遮挡时就很难得到精确的估计结果.如图7(a)所示,由于没有使用相机3 的信息,导致右手臂的动作无法正确地被估计,可以观察到人体姿态的估计结果与机器人模型发生了位置上的重叠,显然是不正确的.图7(b)中使用了相机3 的关键点信息,右手臂的姿态能够被正确地估计.在使用大于2 台相机时,由于关键点置信度的存在,各台相机得到的信息能够相互补偿,得到更好的结果.使用了IMU 信息的图7(c)中,姿态估计结果得到了进一步的矫正,并解算得出了正确的肢体旋转信息.

图7 不同传感器配置下的姿态估计结果Fig.7 Pose estimation result under different sensor configuration cases

4.3 目标跟踪实验

基于第3.2.2 节给出的模型预测控制方法,采用2 组不同的控制权重qp、qv、qa,对机器人的目标跟踪性能进行验证.目标点的生成使用第3.1 节中的动作跟随模式,模型预测控制的预测窗口为0.5 s,机器人状态的采样频率和机器人控制频率均为100 Hz,机器人的关节角速度限制vmax为1.5 rad/s,角加速度限制amax为3.0 rad/s2,使用的2 组控制权重参数为:

参数组1:qp=5.0,qv=1.0,qa=0.5.

参数组2:qp=3.0,qv=1.5,qa=1.0.

图8 给出了参数组1 对应的机器人各关节的跟踪轨迹.在qp相对较大,qv和qa相对较小的情况下,可以看出机器人能够实时地对轨迹进行跟踪.图9 给出了参数组2 对应的机器人各关节的跟踪轨迹.在qp相对较小,qv和qa相对较大的情况下,机器人的轨迹跟踪有较大的延时,但轨迹跟踪速度较为柔和,且对目标轨迹中的噪声有较好的过滤作用.在不同参数配置下控制都有良好的稳定性和较小的静态误差,根据不同控制性能需求可以选用相应的控制参数对机器人进行控制.

图8 基于参数组1 的机器人各关节目标跟踪轨迹Fig.8 Robot joint tracking result based on parameter 1

图9 基于参数组2 的机器人各关节目标跟踪轨迹Fig.9 Robot joint tracking result based on parameter 2

4.4 人机交互实验

基于本文给出的人机姿态解算方法和机器人控制策略,实现了满足第3.1 节中不同机器人交互模式的机器人交互系统.

基于动作跟随模式实现了机器人遥操作搬运,如图10 所示.本实验根据人体右手手掌位姿,以固定的位移偏差值生成目标,以实现对机器人末端的遥操作.在实验中,操作台面上设有一环状物体和一柱状物体,操作人员利用该模式控制机器人对环状物体进行了抓取并将其套入柱状物体中.使用该模式操作机器人能够保证操作人员视角的直观性,操作人员无需考虑机器人本身的参考坐标系,只需以当前机器人末端位置为准对其进行位姿调整,而且当操作人员进行操作时,无需束缚在固定的操作位置,可以自由走动同时对机器人的姿态进行调整.

图10 机器人遥操作搬运Fig.10 Robot pick-and-place under teleoperation

基于目标指定模式实现了指定物品的递送,如图11 所示.在实验的操作台面上设置了需要递送的毛绒玩具,操作人员用手指定机器人需要抓取的目 标,在机器人移动至物品上方并且经过操作人员确认后,机器人执行抓取操作,并将所持物品交给操作人员.在本实验中,系统利用人体手臂生成的矢量与操作桌面形成的交点来判断机器人需要抓取的物品.

图11 指定物品递送Fig.11 Target pointing and fetching

基于动态避障模式实现了人机共融环境下的机器人主动避让.正常情况下,机器人在自身预设的运动轨迹中工作,如图12(a)所示.当人靠近机器人工作区域并在台面上操作时,阻挡了机器人原本的运行轨迹,系统通过人工势场法对机器人的运动轨迹进行了调整,在不与人体产生冲突的情况下到达了目标位置,如图12(b)所示.

图12 机器人主动避障Fig.12 Active collision avoidance

5 结束语

本文通过对人机姿态解算和机器人控制策略的研究,设计并实现了满足不同交互需求的人机共融系统.为了获取交互系统中的人体姿态信息,建立了人体上肢运动学模型,并基于传感器特性构造了相应的能量函数用于多相机和IMU 信息的融合优化,给出了高稳定性的人体姿态估计方法.针对动作跟随、目标指定、动态避障等人机交互模式,设计了相应的目标点生成方法和目标点修正方法,并采用模型预测控制使得机器人能够通过调整控制参数适应不同的交互需求.结合人机姿态的解算方法和机器人控制策略,对所设计的人机交互系统的性能进行了实验验证.实验结果分别验证了: 本文人体姿态解算方法在局部遮挡条件下的稳定性;机器人控制方法进行动态目标跟踪的平滑性;机器人交互系统在不同交互模式下的有效性.所设计的人机共融能够保证交互时的人机安全以及对不同交互模式的适应性.在今后的研究中,将进一步给出多人情况下的人机交互方法.