基于核心句及句法关系的评价对象抽取

2011-06-14钱玲飞

张 莉,钱玲飞,许 鑫

(1. 南京大学 信息管理系,江苏 南京 210008;2. 南京大学 计算机科学与技术系 国家重点实验室,江苏 南京 210008;3. 华东师范大学 商学院信息学系,上海 200241)

1 引言

随着Internet的迅速发展,人们越来越倾向于在Web上发表自己的观点和评论。相比传统的社会调查方法,从新闻、产品论坛和博客等网络载体上获取评论文本具有方便、快捷和代价小等优点,近年来从主观性文本中抽取观点逐渐成为一个热门的研究课题。对于以抽取观点为任务的意见挖掘技术被广泛应用于如电影、数码相机和汽车等领域,抽取结果有利于人们的决策及商家的反馈改进,也有利于舆情监控,具有较大的应用价值。

Kim和Hovy认为观点(意见)由四个元素组成[1]: 即主题(Topic)、持有者(Holder)、陈述(Claim)和情感(Sentiment),意见挖掘的主要任务是从主观文本中找出评价对象及其判断观点的极性,国际上也有一些相关的评测如TREC Blog Track和NTCIR,而国内第一届中文倾向性分析评测COAE2008[2]即包含了属性级的评价对象(任务3)抽取和篇章级的文本褒贬极性判断。第二届中文倾向性分析评测COAE2009[3]把相关任务推广到了句子级,其任务3为观点句抽取,任务4为观点评价对象抽取,要求输出一个三元组{观点句,评价对象,评价的倾向性}。本文致力于研究从COAE2009的任务4的评测结果来看难度较大的评价对象抽取,如句子“‘老练者’甚至认为互联网是生活中理所当然,不可或缺”,需要抽取的评价对象为“互联网”,而对于任务4的另一子任务即评价的倾向性研究将作为后继的研究目标。

关于评价对象抽取国内外也有较多的研究。文献[4]利用标注观点相关的语义角色来确定观点的持有者和主题;文献[5]使用关联规则挖掘频繁项集作为产品候选评价对象;文献[6,8-9,11,14]均使用了CRFs进行了评价对象抽取,其中文献[6]结合模式匹配方式,文献[8,11]基于词性特征,文献[9]基于属性词和评价词的上下文、词性和语义等特征,文献[14]基于自定义的6个组块如评价对象NP组块、情感表达EM组块等;文献[19]利用层级隐马模型识别产品评价对象;文献[7,10,12-14,16-18]均利用了名词词性组合和NP、VP等组块生成候选评价对象集,然后通过一定的策略缩小候选评价对象的范围,如文献[7]利用语言模型及短语依存树,文献[10]结合情感词位置,文献[12]考虑“强调”和“称”等主张词的影响,文献[13]和文献[16]结合领域和句法规则,文献[17]利用词形和词性模板采用模糊匹配方法进一步获得小范围的候选对象集,再通过双向Bootstrapping方法识别出产品评价对象,文献[18]结合词频、PMI和名词剪枝算法筛选评价对象;文献[15]基于词性、属性词典和用户词典利用CRFs进行评价对象的第一步抽取,在未抽取的句子上再利用NP组块获得候选子集,进一步通过主张词和情感词密度及领域知识等方式获得最终的评价对象。

可以看出,目前抽取评价对象常用两类方法: 一种方法是基于一些语言特征利用HMM或CRFs等机器学习模型进行训练获得模型;另一种方法是先根据NP和VP等句法结构获得候选特征集,然后再利用规则进一步筛选获得最终结果。对于前一种方法需要寻找一些如词性、句法结构和语义等语言特征,一般能获得较高的精确率,但召回率通常较低;而后者需要确定缩小特征范围的规则和模板,通常召回率较高而精确率较低。

2 基于核心句和句法结构的评价对象抽取

鉴于目前常用方法存在的问题,我们试图通过一种能够结合两种方法优点的途径来抽取评价对象。如果基于词性特征,利用机器学习模型进行训练时,由于句子中通常包含不止一个名词或名词词组(评价对象的常见形式为名词或名词组块),学习后并不能获得较高的召回率。例如对于如下两个例句:

例句1: 病毒和黑客也一样,你不知道何时会出现,因此只有平时做好防范工作,当病毒发作或黑客入侵时,才能将损失减到最低限度 (评价对象:病毒和黑客)

例句2: 城市发展说,金光大厦的销售表现能够逆流而上,相信是因为它靠近新加坡管理大学、超级市场、商店和地铁站,并在2001年就可以入住 (评价对象:金光大厦的销售表现)

两个例句中除评价对象外还包含其他的名词或名词词组,如第一个例句中的“你”、“损失”和“限度”等,第二个例句中的“城市”、“它”、“新加坡管理大学”和“超级市场”等。当基于词性特性进行训练时,每个句子中若与评价对象相同词性的短语越多,则建模越困难。为克服这一问题,设想如果能够去掉句子中的一些与评价对象无关的片段后再交由CRFs训练,这样既能进一步提高CRFs的精确率,同时召回率也能得到提升。正是基于这一想法,我们首先提出一种根据规则寻找核心句的方法。

2.1 寻找核心句

所谓核心句即为依据一定的规则将原句进行处理后得到的新句,新句一般为原句的核心片段,如果原句不符合任何规则,则保持不变。通过观察我们发现,部分句子中除以往文献(如文献[12]和文献[15])中提到的若干如“认为”、“听说”和“觉得”等主张词外,还有一些如“据…报道”和“…说”等短语也会影响评价对象的抽取,另外,对于一些由“但是”和“而”等转折词开头构成的句子其评价对象往往位于转折词后面的句子中。例如:

例句3: 据法新社报道,美国专家怀疑造成巨大损失的蠕虫病毒来源是香港,但是调查相当困难,专家认为犹如大海捞针(评价对象:调查)

例句4: 据佳登室内设计装饰的工程设计师郑小姐受访时说,她和黄先生夫妇俩沟通之后,便依照他们的需求进行设计,而最后完成的装修效果,令双方都感到十分满意(评价对象:装修效果)

基于这些语言特征同时考虑到尽量不丢失原句中表示倾向性的短语和句子,在对数据分词和标注词性的基础上我们确定了如下7条规则:

规则1: 删除所有括号及括号内的序列,左括号包含“[”、“【”、“(”和“(”,右括号包含“]”、“】”、 “)”和“)”,左右括号可任意配对;

规则2: 删除“据…报道”序列;

规则3: 若句子以名词或名词词组开头后跟词性为动词的“说”,或者“说”之前含一个形容词,则将包含“说”及其前面的词删除,若“说”后紧跟标点符号,则删除该标点;

规则4: 若句子以名词短语(如机构名、人名和一些专有名词)开头,后面紧跟如认为、相信和觉得等主张词(词性需为动词),则将此名词短语及主张词删除。主张词选用知网的38个主张词;

规则5: 若一个单句(不含标点符号的单个句子)中含“从…来看”或“从…来说”,则删除该序列;

规则6: 若一个单句内中含“当…时”或“当…时候”,且“当”为单独的一个介词,“时”或“时候”为名词,则删除该序列;

规则7: 若句子开头含“但”、“但是”、“而”、“然而”和“不过”这几个转折连词,且转折词后紧跟人名、机构名和外来词等名词或名词短语则删除转折词前的句子及转折词本身,若转折词后不含名词短语则删除时保留整个句子的第一个名词或名词短语;特殊的,若转折词后为“它”、“他”、“她”、“它们”、“他们”、“她们”和“其”等指代词,则同样需要保留整个句子的第一个名词或名词短语并删除指代词;另外若整个句子包含多个转折词,则依据最后一个转折词进行处理。

将句子按照以上7条规则顺序处理后即可利用CRFs模型进行学习。例如对于例句3:

步骤1: 匹配规则2,句子处理后变为“美国专家怀疑造成巨大损失的蠕虫病毒来源是香港,但是调查相当困难,专家认为犹如大海捞针”;

步骤2: 匹配规则4,句子处理后变为“美国专家怀疑造成巨大损失的蠕虫病毒来源是香港,但是调查相当困难,犹如大海捞针”;

步骤3: 匹配规则7,句子处理后变为“调查相当困难,犹如大海捞针”。

例句3的核心句即为“调查相当困难,犹如大海捞针”。

需要指出的是,对于不同的语料,抽取核心句的规则会有所不同。我们随机抽取了新浪网“奇虎360与腾讯纷争”的200条新闻评论,发现规则1、5、6的覆盖率较低,规则7的覆盖率较高。本文旨在提出利用核心句来提高CRFs的精确率,具体核心句的规则设定需具体考虑,如语料在同一个领域,则可寻找更佳的规则以其更好地发挥核心句的作用。

2.2 利用条件随机场模型进行标注

条件随机场模型(简称CRFs)由John Lafferty和Andrew McCallum于2001年提出[20],它是一个在给定观察序列的条件下计算整个观察序列的联合条件概率分布的无向图模型。CRFs是隐马尔科夫和最大熵模型的扩展,它具有两者的优点同时又克服了这些模型的缺点,它不是对单一标记归一化后再进行全局搜索,而是基于整个观察序列求解一个最优的标记序列,避免了标记偏置问题。

CRFs这样的序列化标注模型在命名实体识别任务上具有良好的表现,由于评价对象抽取也可以看成一个序列化标注问题,所以可以利用CRFs进行对象标注。

以往的工作主要是基于词、词性及对象是否在用户词典中出现这些特征利用CRFs进行标注,但是对象是否在用户词典中出现需要在训练时进行额外的人工处理,且用户词典中的词的数目和种类与处理时间及领域均有较大的关联,对于混合领域的对象标注问题并不是一个较好的解决方案;而词和词性信息不够丰富,所以我们试图寻找一种与领域无关的简单且有效的特征。通过观察发现,评价对象的句法模式常常有章可循,我们确定了长度不超过5个词的如下10种句法模式:

模式1: 定中关系+定中关系+定中关系+定中关系+主谓关系(ATT-ATT-ATT-ATT-SBV)

模式2: 定中关系+“的”字结构+定中关系+主谓关系(ATT-DE-ATT-SBV)

模式3: “的”字结构+定中关系+定中关系+主谓关系(DE-ATT-ATT-SBV)

模式4: 定中关系+并列关系+主谓关系(ATT-COO-SBV)

模式5: 定中关系+数量关系+主谓关系(ATT-QUN-SBV)

模式6: 数量关系+定中关系+主谓关系(QUN-ATT-SBV)

模式7: “的”字结构+定中关系+主谓关系(DE-ATT-SBV)

模式8: 定中关系+主谓关系(ATT-SBV)

模式9: 状中结构+主谓关系(ADV-SBV)

模式10: 主谓关系(SBV)

在实际的特征标注过程中,按照从模式1至模式10顺序将这10种句法模式标出,句子中其余不含此模式的位置用默认标记标注。

对于所提出的句法模式,我们同样考察了2.1节中所提到的200条新闻评论,实验结果显示有32%的句子中的评价对象符合这10种句法模式,可以说明模式具有较好的适用性。

3 实验与分析

实验主要有数据预处理、生成核心句和训练集与测试集特征标注并利用CRFs进行训练这三个主要阶段。

3.1 数据预处理

本文采用的数据集为COAE2009任务4已标注的数据,数据集中包含4 000多条句子,涉及体育、电影和手机等多个领域,标注的答案格式为“观点句 评论对象 倾向性”,每个句子只包含一个评价对象,共有三个裁判员参与了标注。

在数据预处理的第一步我们首先根据句子的倾向性缩小了数据集的范围。句子的倾向性包含四种情况: 0(表示无倾向性)、1(表示贬义)、2(表示混合)、3(表示褒义),考虑到后继需要做判断句子褒贬极性的工作且句子的主观性判断方法已经较为成熟,这里我们仅选择了倾向性为贬义和褒义的句子。

进一步考虑到由褒义句和贬义句构成的数据集并不大,我们在其中选择了不少于两个裁判员给出相同评价对象标注结果的句子。经过筛选,符合条件的句子共2 723条,其中最长的句子含字符400多个,最短的句子仅含几个字符。

第三步对句子中的标点符号做了处理,将一些不位于句子结尾的但常被认为是句子结束标记的符号进行了替换,目的是适应分词和词性标注工具标点符号处理的限制。我们使用的哈尔滨工业大学的LTP2.0将包括 “。”、“!”、“;”、“?”、“ ”和“ ”在内的符号均视为句子结束标记符,因此需要将这些符号预先替换为逗号,避免LTP2.0提前截断句子。

3.2 生成核心句

将2 723条句子先用LTP2.0分词并标注词性,然后顺序使用7条生成核心句的规则进行处理,规则处理主要通过自己编写的程序、若干正则表达式及少量的人工辅助判断来完成,同时利用程序进行评价对象是否丢失的判断。具体的处理结果如表1 所示。

7条规则共匹配句子595条次,丢失评价对象的句子51条,其中规则7共匹配292条句子,有37条句子丢失了评价对象;而规则2仅匹配5条句子,未丢失评价对象。

对于匹配句子最多的规则7丢失评价对象的现象相对较多,例如:

例句5: 市场机制的部分引入,使得“内部人”利用国有资源赚取利益名正言顺,并可以此推诿来自政府方面的责任与义务,而国有垄断、权力支持的优势又使它们在市场上没有竞争对手,所向披靡 (评价对象:内部人)

例句6: 失望的媒体和观众对影片毫不留情,恶评如潮,批评它无论情节、表演都一无可取,明年的金酸莓烂片奖,《本能2》已稳操胜券,而莎朗更是金酸莓影后的不二人选 (评价对象:本能2)

例句5和例句6在使用规则7后均丢失了评价对象,通过观察可以发现,例句5中的转折词“而”后其实包含了评价对象“内部人”的指代词“它们”,而例句6的转折词“而”后的名词“莎朗”也可以算作是句子的另一个评价对象。但是虽然本数据集中的句子均只标注了一个评价对象,而类似于例句5和例句6这种一个句子含两个评价对象的情况不多,所以我们没有另行处理,类似这种情况的句子仍然被认为是丢失了评价对象。

在处理中也发生了一个有趣的现象,有些句子在处理后评价对象比原句的标注更精确了。例如:

例句7: 崔永元说他的女儿很可爱,也很乖、很懂事,一点也不吵,也从来不无理取闹

例句7的原评价对象为“他的女儿”,核心句处理后变成了“崔永元的女儿很可爱,也很乖、很懂事,一点也不吵,也从来不无理取闹”。

3.3 标注训练和测试

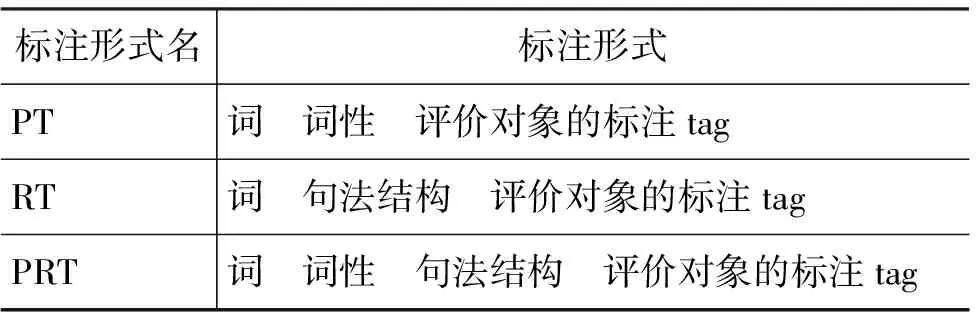

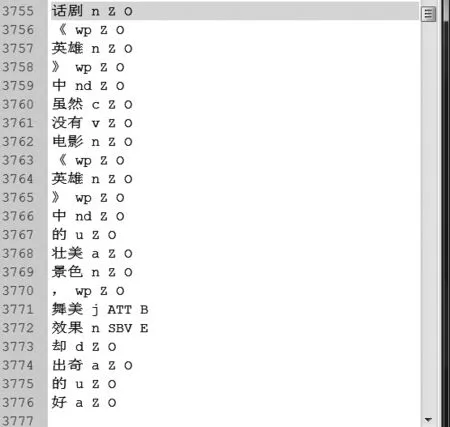

获得核心句后我们对原始数据和核心句分别进行标注,由于核心句的句子结构已发生变化,所以必须要重新处理。首先利用LTP2.0对两类数据集进行分词,然后标注其词性,并利用其句法分析器标注满足10种模式的句法结构,同时也标注了评价对象,评价对象的标注方法使用了IOB2形式,即用B、I、E、O和S分别表示当前词是一个组块的开始、内部、终点、不在任意一个组块中、是一个组块但该组块只有一个词。为了进行对比试验,我们分别设计了如表2所示的三种标注形式。

表2 数据标注形式

例如句子“话剧《英雄》中虽然没有电影《英雄》中的壮美景色,舞美效果却出奇的好”用PRT形式标注后的结果如图1所示。

图1 PRT形式标注例

分别将原数据和核心句的三种标注形式交由CRFs进行学习,我们使用了CRF++-0.53[21],词性和句法结构的模板窗口均设置为[-3,3],PT和PRT的词的模板窗口为[-1,1],RT的词的模板窗口为[-2,2]。另外由于总句子数只有 2 723 条,所以我们选用了5折交叉验证方式。

3.4 实验结果及分析

(1) 实验结果

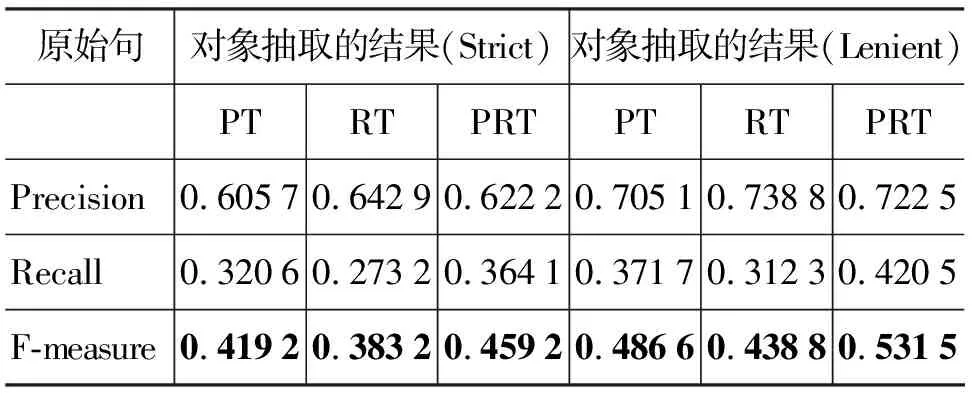

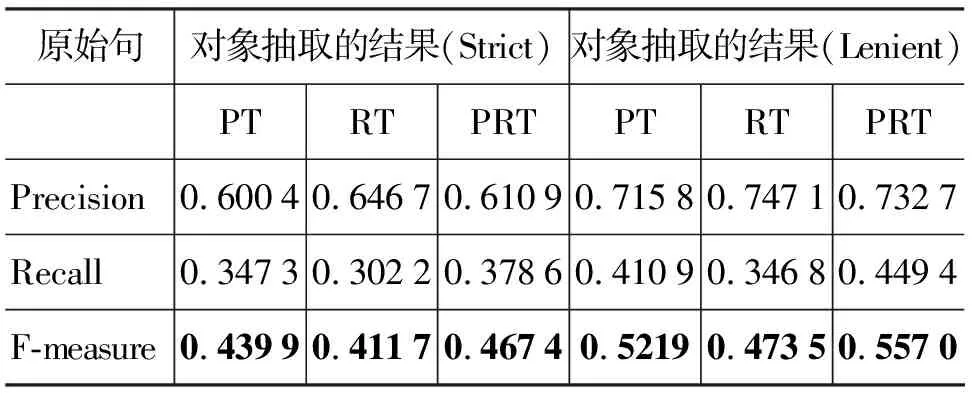

实验结果按照COAE的方式采用精确评测(Strict)和覆盖评测(Lenient)两种形式,其中覆盖评测时如果书名和电影名等整体词只标出一部分的不算正确,除此之外标出部分比原标注对象序列长的也算正确。例如句子“舞台上的董卿是非常温婉清新的,她没有煽情做作的表演,有的只是最真实的表现”,原标注的评价对象是“董卿”,但实际标注时若标出“舞台上的董卿”也算正确。标注结果用P值、R值和F值来表示。原始数据的实验结果如表3所示,核心句的实验结果如表4所示。

表3 原始数据评测结果

表4 核心句评测结果

(2) Baseline

我们分别使用了PT标注形式和 CRF++-0.53的标准模板(Baseline1)以及类似文献[18]中提到的COAE2008评价对象抽取最佳结果方法(Baseline2)作为Baseline。Baseline1覆盖评测结果的P值、R值和F值分别为0.687 1、0.344 4和0.458 6;对于Baseline2,根据文献[18]和以往文献的实验结果发现,不同领域数据属性抽取结果的F值相差很小,所以选择了语料中领域更为专指的“NBA”有关的句子进行了实验,以期获得更好的实验结果。我们采用了文献[18]中的主要方法: 首先识别句子中的名词和名词短语作为候选评价对象,其次利用词频信息和PMI算法进行过滤,所用PMI算法公式为:

PMIa-b=-log(Nab/(Na×Nb))

领域代表词使用“NBA”,分别考察了候选评价对象和“NBA”同时出现的次数与候选评价对象单独出现的次数之比为60%(PMI值为8.22)至30%(PMI值为8.52)之间评价对象的抽取精度,发现在PMI为8.40~8.48之间其P值和R值能达到一个相对高的水平,如果PMI值过低则P值和R值均会较低,如果PMI值过高则P值会较低;同时考虑到“NBA”相关句的所有评价对象的PMI平均值为8.52并呈现两极分化严重的情况,最终以PMI值为8.48时的结果作为Baseline,其覆盖评测的P值、R值和F值分别为29.90%、61.70%和40.28%。另外由于文献[18]中提出的名词冗余方法并不适合本语料,所以此处并未采用。

(3) 实验结果分析

从表3可以看出,单独使用RT标注形式的效果不佳,而使用PRT形式即同时考虑词、词性和句法关系的效果最好。使用自定义的模板以PT标注形式学习后F值提高了2.8%,而以PRT标注形式学习后F值提高了7.29%,证明使用我们提出的10种句法模式结合词性标注进行学习的方法是可行的。

另外对比表3和表4可以看出,不管哪种标注形式核心句实验结果的F值均比原始数据的F值有所提高,PT、RT和PRT标注形式的F值分别提高了3.53%、3.47%和2.55%,其中P值能保持原有水平并略有提高,而R值相对提升多一些,这证明了核心句的思路是正确的。但是由于数据集中的句子包含多个领域,句子形式松散,且有多条句子的长度较长,所以导致核心句处理后评价对象丢失较多;另外又因为本身数据集较小且要考虑不丢失倾向性成分以作为后继倾向性研究,这些因为核心句带来的R值和P值的提高只能是小范围的,无法产生规模效应。如果数据在一个单一领域内且数据量较大,或者所处理的数据形式较为规范,利用核心句进行学习的方法效果将进一步能得到一个较大的提高。

在以上结果的基础上,我们做了后继处理,将核心句中用PRT形式学习后未标注的数据利用PT形式进行再学习,以期进一步提升性能。二次处理后P值为0.720 9、R值为0.469 1、F值为0.595,F值有了3.8%的提高。整个实验过程中性能的提升情况可见表5所示。

表5 实验结果提升比较

通过表5可以看到,通过运用新的模板和添加句法关系进行学习、利用核心句提升R值及二步学习这几个步骤后我们发现,与Baseline1和Baseline2相比,F值分别有了13.64%和19.22%的提高。对于获得COAE2008的覆盖评测下评价对象抽取最佳结果的Baseline2,我们在NBA语料上虽然没有完全按照其方式进行实验,但对其性能提高最显著的PMI算法进行了细致的实验,所以本文实验取得的F值0.595可以在一定程度上说明我们采用的几种方法的融合是可取的。

4 结束语

本文主要研究了如何在句子中抽取评价对象,通过寻找核心句和句法关系特征来更有效发挥CRFs的标注效能,实验结果表明我们提出的方法是可取的,且如果应用在单一领域或语言形式较规范的领域内抽取效果将会有进一步的提升。在后继的工作中,我们将在以下几方面继续开展研究:

1. 修改核心句的规则,进一步提升抽取评价对象的召回率,并考虑将核心句的思路应用到某一个特定领域或文本格式较为规范的新闻语料上;

2. 寻找或修改更合适的句法关系,并同样考察其他领域中句子的词法是否具有领域独特性的结构;

3. 通过观察发现表现句子倾向性的内容绝大多数仍然保留在核心句中,所以后一步需要考虑是否能将核心句和句法关系应用到句子的倾向性分析上;对于倾向性判断将首先考虑抽取观点表达后再判断其极性;

4. 本实验提出的方法适合含多个评价对象句子的属性抽取,后继将进一步研究评价对象抽取中更有挑战性的问题,如评价对象缺失句中评价对象抽取的问题。

致谢

感谢哈尔滨工业大学信息检索研究室为本文研究提供了LTP2.0工具和COAE2009提供的标注语料。

[1] S.-M. Kim and E. Hovy. Determining the Sentiment of Opinions [C]//Proceedings of COLING-04, the Conference on Computational Linguistics (COLING-2004). Geneva, Switzerland, 2004: 1367-1373.

[2] 赵军,许洪波,黄萱菁,等.中文倾向性分析评测技术报告[C]//第一届中文倾向性分析评测论文集.北京:第一届中文倾向性分析评测委员会,2008: 1-20.

[3] 许洪波,姚天昉,黄萱菁,等.第二届中文倾向性分析评测技术报告[C]//第二届中文倾向性分析评测会议(COAE2009)论文集.北京: 第二届中文倾向性分析评测委员会,2009: 1-23.

[4] S.-M. Kim and E. Hovy. Extracting opinions, opinion holders, and topics expressed in online news media text[C]//Proceedings of ACL/COLING Workshop on Sentiment and Subjectivity in Text. Sydney,Australia:2006: 1-8.

[5] Hu, Minqing and Bing Liu. 2004. Mining and summarizing customer reviews[C]//Proceedings of the ACM SIGKDD International Conference on Knowledge Discovery & Data Mining (KDD-2004). Seattle, Washington, USA, 2004: 168-177.

[6] Yejin Choi, Claire Cardie, Ellen Riloff et al. Identifying Sources of Opinion with Conditional Random Fields and Extraction Patterns[C]//HLT/EMNLP’05.Vancouver,Birtish Columbia,Canada, 2005: 355-362.

[7] Qi Zhang, Yuanbin Wu and Tao Li. Mining Product Reviews Based on Shallow Dependency Parsing[C]//SIGIR’09.Boston,MA,USA:2009: 726-727.

[8] 蒙新泛,王厚峰. 基于CRF 的对象抽取及对象抽取的领域特定性研究[C]//第一届中文倾向性分析评测论文集.北京:第一届中文倾向性分析评测委员会,2008: 32-37.

[9] 张姝,贾文杰,夏迎炬,等. 基于CRF 的评价对象抽取技术研究[C]//第一届中文倾向性分析评测论文集.北京,第一届中文倾向性分析评测委员会,2008: 70-76.

[10] 何婷婷,闻彬,宋乐,等. 词语情感倾向性识别及观点抽取研究[C]//第一届中文倾向性分析评测论文集.北京:第一届中文倾向性分析评测委员会,2008: 89-93.

[11] 徐冰,王山雨.句子级文本倾向性分析评测报告[C]//第二届中文倾向性分析评测会议(COAE2009)论文集.北京: 第二届中文倾向性分析评测委员会,2009: 69-73.

[12] 王会珍,张春良,等,观点句和评价对象一体化抽取技术研究[C]//第二届中文倾向性分析评测会议(COAE2009)论文集.北京: 第二届中文倾向性分析评测委员会,2009: 83-91.

[13] 王素格,李红霞,等.中文文本观点分析技术研究[C]//第二届中文倾向性分析评测会议(COAE2009)论文集.北京: 第二届中文倾向性分析评测委员会,2009: 92-101.

[14] 潘凤鸣,王宇轩,等.DUTIR COAE2009评测报告[C]//第二届中文倾向性分析评测会议(COAE2009)论文集.北京: 第二届中文倾向性分析评测委员会,2009: 107-116.

[15] 濮小佳,黄亿华,等.中文倾向性分析及评价对象抽取研究[C]//第二届中文倾向性分析评测会议(COAE2009)论文集.北京: 第二届中文倾向性分析评测委员会,2009: 117-127.

[16] 张玉杰,潘文彬,等.CISTR: 中文文本倾向性分析评测报告[C]//第二届中文倾向性分析评测会议(COAE2009)论文集.北京: 第二届中文倾向性分析评测委员会,2009: 144-152.

[17] 宋晓雷,王素格,李红霞.面向特定领域的产品评价对象自动识别研究[C]//中文信息学报,2010.24,(1),89-93.

[18] 刘鸿宇,赵妍妍,等.评价对象抽取及其倾向性分析[J].中文信息学报,2010,24,(1),84-88,122.

[19] 刘非凡, 赵军, 吕碧波,等. 面向商务信息抽取的产品评价对象识别研究[J].中文信息学报, 2006,20,(1),17-20.

[20] Lafferty, J., McCallum, A., Pereira, F. 2001. Conditional random fields: probabilistic models for segmenting and labeling or sequence data[C]//ICML.2001: 282-289.

[21] http://crfpp.sourceforge.net[CP/OL].