基于多算力融合的数字孪生黄河黄河云设计研究

2024-02-28李自尊

李自尊,冯 建,汤 进

(黄河水利委员会信息中心,河南 郑州 450003)

0 引言

近年来,通过实施电子政务系统、黄河下游防洪非工程措施、黄河水利委员会(以下简称黄委)综合管理信息资源整合与共享等重点项目[1],黄河数据中心云计算服务和大数据治理能力有效增强,初步实现了物理资源的整合共享、灵活管理,提升了应用系统的部署效率,在一定程度上提高了计算资源的复用率[2]。

随着数字孪生黄河的深入开展,业务需求的不断扩展,呈现数据类型更加复杂多样、数据来源更加丰富、计算模型更加复杂融合、计算方式更加多元的特征。算据方面,基于物联网感知终端的站网、视频、遥感、无人机等“天空地”一体化监测数据,以及跨行业交换、地理空间等动态更新的全息数据融合应用成为研究重点,图像、语音、视频、遥感影像等非结构化数据量也由 TB 级向 PB 级跃升[3];算法方面,面向“四预”应用的黄河流域特色水文、水沙动力学、防洪调度、凌情预报等水利专业模型,对预测精度及时效要求不断提升[4]。算据的存储、处理、分析及模型算法运行效率的提升等,均需要高效、稳定、安全的算力支撑保障。

在业务需求发生变化的背景下,现有计算、存储等基础设施资源已无法有效支撑数字孪生黄河建设,主要体现在以下 3 个方面:

1) 计算能力不足。黄河数据中心已有计算资源紧缺,CPU 处在超分比临界点,内存使用率达到 75% 以上;除基础算力外,高性能计算、AI 算力欠缺,难以满足黄河流域水利专业模型计算和数字孪生“四预”等高时空分辨率、高精度、低时延业务场景的需求;同时,黄河流域范围大,距离长,环境复杂[5],单一的集中云部署架构无法满足海量监测数据的高效存储与处理要求。

2) 存储能力不足。随着一体化监测能力的提升,遥感影像、视频、图片等水利数据,呈现海量、高增长、多模态的特征,传统的集中式块、文件等存储模式无法应对指数级别的数据增长量[6]。

3) 云管理能力不足。黄委建设有水害灾害防御、水资源管理与调度、水行政管理、水土保持等众多业务系统。现阶段,大部分业务系统集中部署在黄河数据中心,部分委属单位根据各自业务应用需要,建设有独立的算力基础设施,未与黄河云形成统一的算力框架。现有管理模式在灵活性、用户响应及体验等方面的弊端越发明显。

当前,随着 5G、云计算、人工智能等新一代信息技术的快速发展,数据中心作为各行业信息系统运行的物理载体,已成为经济社会运行不可或缺的关键基础设施,在数字经济发展中扮演至关重要的角色[7]。工业和信息化部出台《新型数据中心发展三年行动计划(2021—2023 年)》,引导传统数据中心向具备高技术、高算力、高能效、高安全特征的新型数据中心演进,推动 CPU 和 GPU 等异构算力提升,支撑各类智能应用[8]。

据统计,2020 年我国算力总规模达到 135 EFlops(每秒百亿亿次浮点运算次数),同比增长 55%,超过全球增速约 16%[9]。《数字孪生流域建设技术大纲(试行)》结合数字孪生流域建设模型平台、知识平台、智能业务等对算力的需求,提出水利行业算力资源发展技术规范,主要包括基础计算与存储、高性能计算、人工智能计算等方面规范。

本研究从多态复杂的治黄大数据及业务应用需求出发,通过对多模态存储模式、多元算力等技术的综合分析,提出融合基础、高性能、智能等计算,集中、分布式存储等多种存储架构,块、文件、对象等多种存储模式的“云边协同”算力资源架构,旨在通过提升多算力融合黄河云的能力,为数字孪生黄河建设提供高效算力支撑。

1 相关技术分析

1.1 多模态存储模式

数字黄河时期,黄河数据中心存储量以 10 TB 级计算,存储的数据以基础和站点监测 2 种结构化数据为主[10]2,数据存储模式采用集中式块存储为关系型数据库提供高速 IOPS(每秒进行读写操作的次数)访问。随着信息采集技术的飞速发展,遥感、无人机、视频图像等数据的融合应用已十分普及,数字孪生黄河数据存储量达到 PB 级以上,数据存储模式也随着存储、网络等技术的发展,针对不同数据类型、场景提供针对性的存储解决方式。数据存储架构主要包括以下 2 种:1) 传统集中式存储。在性能、稳定性和成熟度上有一定优势,主要应用于有数据强一致性要求、高 IOPS、低时延的 OLTP(联机事务处理过程)类业务场景。2) 分布式存储。扩展性好,易管理,面对海量数据存储具有较高性价比,主要应用于海量数据、大数据块、顺序读写、时延不敏感场景。

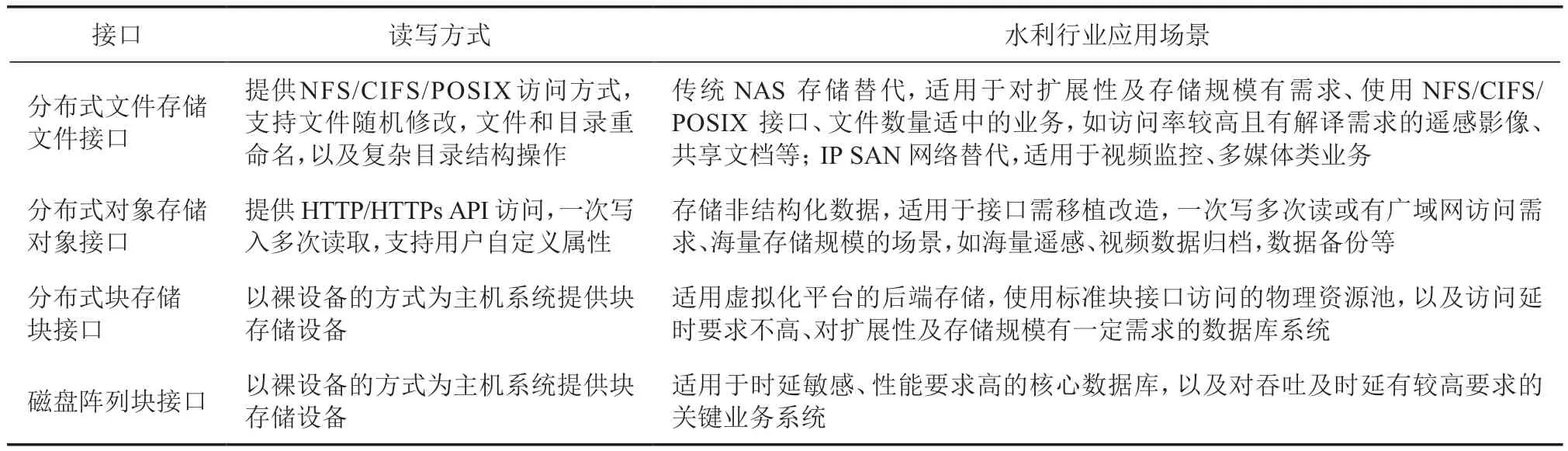

存储模式主要包括块、文件、对象等存储,不同存储模式对应块、文件、对象等接口协议,各接口协议读写方式及应用场景如表1[11]所示。

表1 各接口协议读写方式及应用场景

1.2 多元算力

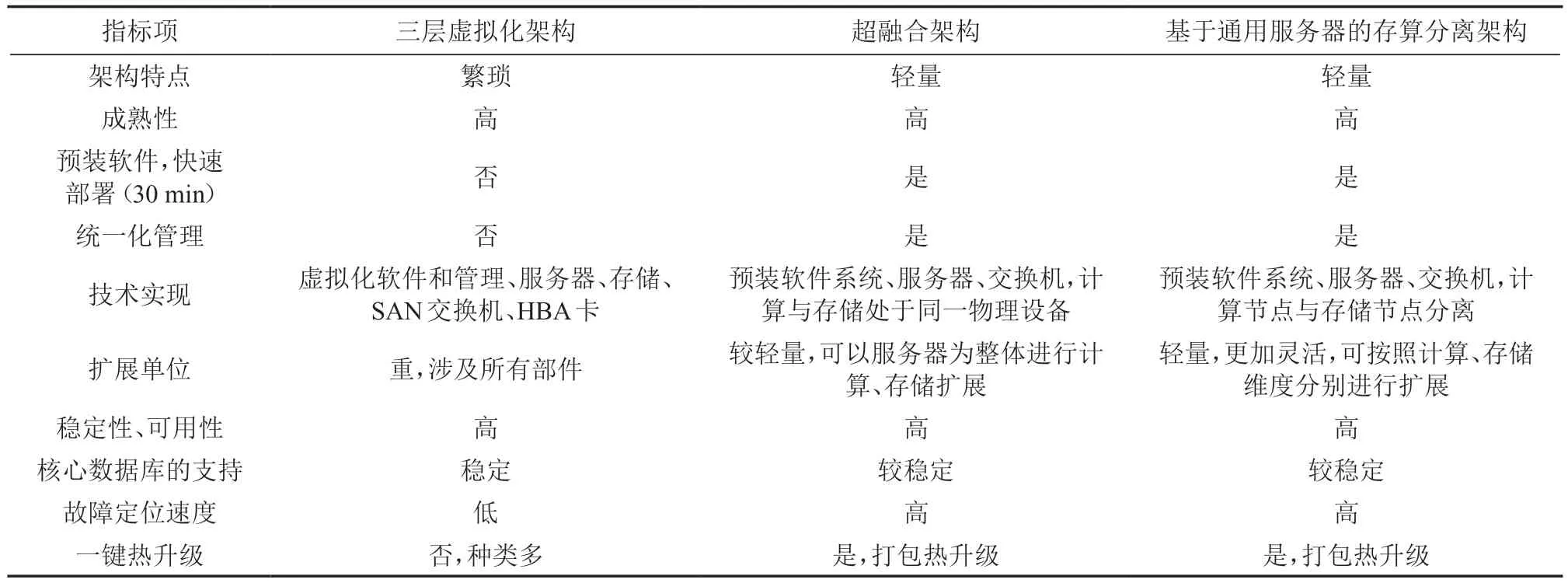

数字黄河时期,基础计算以物理机部署模式为主,并逐步向虚拟化方式部署转变,高性能计算平台浮点运算速度为 3 840 亿次/s,主要为黄委气象水文预报、下游水沙过程演进模拟运算提供计算支撑[10]2。随着算力技术的飞速发展,以云计算方式部署的基础计算已成为主流,云计算架构也由传统“服务器 + 虚拟化 + 集中式存储阵列”的三层虚拟化架构向超融合架构或基于通用服务器的存算分离架构[12]扩展。各架构性能对比如表2 所示。

表2 各架构性能指标对比表

除基础计算外,基于并行处理架构、并行编程模型、分布式计算和大规模数据处理等技术构建的高性能计算集群,可加速数字孪生黄河的模拟和分析过程,提升黄河流域洪水泥沙预报、水沙演进与河势演变、水资源配置等模型运算的运行精度和效率。如李兴等[13]提出采用多节点分布式并行化计算,可有效提高超大时空尺度的地表水流数值模拟效率,提升工程应用能力;刘军志等[14]针对汇流过程提出一种分层的逐栅格汇流算法,利用多线程程序设计方案OpenMP 对同一层中的栅格实现并行计算,选择试验区进行测试,得到较好的加速比和并行效率;赵自雄等[15]将基于网格剖分软件 METIS 网格分区的 MPI并行技术应用于浅水泥沙模型,随着核数的增加,模型性能相比未并行模型可达到 2 个数据级的加速;吕娟等[16]基于超级计算平台和流域实体模型,自主研发可扩展、可移植、统一设计、统一接口的,水文、水动力、泥沙、水生态、水环境、水工程安全运用、水工程统一调度等专业模型,进行水系统智慧模拟。

AI 计算通过机器学习、深度学习、自然语言处理等技术,对黄河生态环境变化、水资源利用、水文泥沙模拟、水土保持监督管理等进行智能分析和预测,如陈嘉靖[17]对基于 CNN(卷积神经网络)的非法采砂监管目标检测算法进行并行化设计,针对目标检测算法中卷积计算较为密集的特点,对检测模型中的卷积层进行分析设计,使得同一个任务加速比达到 3.53。

近年来,随着人工智能和高性能计算的发展,人工智能计算逐渐作为加速计算应用在高性能计算场景中,提升对大规模数据的智能分析和决策支持,如IFMS(综合洪水建模系统)平台中改进的水动力模型支持 GPU 加速计算,数十万个网格在新一代加速器Tesla V100 的 GPU 处理器上可实现秒级计算[18]。

因此,多算力融合黄河云建设须面向新形势下的新需求,融合云计算、高性能计算、多模态存储等新技术,提供面向水利业务复杂应用场景的算力基础支撑。

2 多算力融合黄河云架构

2.1 总体框架

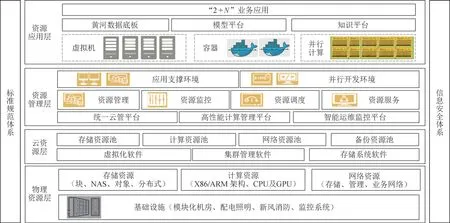

基本设计思路:根据模型计算、AI 计算及海量监测数据汇聚等需求,补充高性能、AI 计算、分布式存储等多元算力,并对多元异构资源采用池化管理,在现有以虚拟机方式提供资源服务的基础上,增加容器、微服务框架、并行计算、AI 计算等算力资源服务,以适应数字孪生建设新形势对稳态、敏态、智能业务的需求,实现算力资源的高效、集约、弹性管理。多算力融合黄河云总体框架如图1 所示。

图1 多算力融合黄河云总体框架

各层级介绍如下:

1) 物理资源层。物理资源层为多算力融合黄河云的基础,融合 CPU 和 GPU 等异构算力的计算资源,包含块、对象、NAS、分布式等多种类型的存储及网络资源。

2) 云资源层。通过虚拟化、集群管理等多种技术手段,将物理资源整合为对上层模型和知识平台及业务应用提供统一资源服务的存储、计算、网络、备份等资源池。

3) 资源管理层。实现对池化资源的统一管理、监控、调度及服务,对上层应用提供统一的应用支撑及并行开发等环境。

4) 资源应用层。即以虚拟机、容器、并行计算等多种形式提供资源运行环境,满足数据底板、模型平台、知识平台的搭建,以及水旱灾害防御、水资源管理与调配等“2 +N”业务应用的运行。

2.2 部署架构

遵循“集约高效、共享开放、安全可靠、按需服务”的设计原则[19],部署多算力融合黄河云。

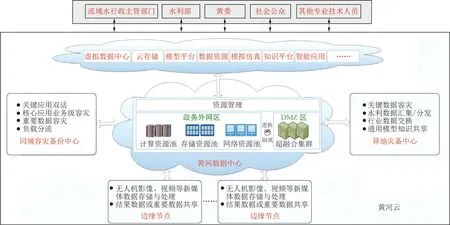

多算力融合黄河云采用“两地三中心”“云边协同”的总体架构进行部署,如图2 所示。“两地”指郑州和异地,“三中心”指黄河数据中心(郑州)、同城灾备中心(郑州)、异地灾备中心(异地)。业务系统生产环境主要集中部署在黄河数据中心(郑州),同城灾备中心(郑州)为业务系统提供同城灾备的同时,还可为数字映射、科学研究、系统研发等提供场景支撑和开发平台,分担黄河数据中心系统业务流量压力;按照国家水利大数据中心整体建设规划,可优先选择将核心数据异地备份至国家水利大数据中心(北京)。同时,根据业务数据流向,依据现有网络,运行环境按照政务外网、DMZ(隔离区) 2 个分区建设,分别承载水利业务智能应用、数字孪生支撑、数据资源等业务和政务系统,以及黄河网等面向社会公众的政务公开系统。

图2 多算力融合黄河云部署架构

无人机影像、视频等新媒体非结构化信息采集端,可根据需要部署边缘云融合一体化基础设施,保持与黄河数据中心网络通畅,仅将结果数据或重要核心数据传送至黄河数据中心云平台,以减轻黄河数据中心云平台存储计算和传输网络的压力,从而与黄河数据中心形成云边协同、可弹性扩展的两级云部署架构,提供物理分布、逻辑集中、协同高效、安全可靠的算力资源。

3 资源池设计

黄河数据中心为孪生平台、业务系统等提供生产运行环境,是多算力融合黄河云的建设核心。从算力资源角度考虑,黄河数据中心资源池主要包括以下 2 种算力:1) 硬算力。主要包括计算、存储、网络等基础设施资源。2) 软算力。须利用先进成熟技术,搭建高可靠、高性能的云计算运行和管理服务体系,提供数据存储、计算能力,满足以数据和计算为中心的多模式计算。黄河数据中心云体系架构如图3 所示。

黄河数据中心 2 个分区介绍如下:

1) 政务外网区。模型平台、知识平台、智能应用等涉及大量计算和海量数据存储的核心业务系统,主要集中部署在政务外网区。政务外网区根据业务应用及数据特点,采用三层虚拟化架构及基于通用服务器的存算分离架构,算力平台涵盖高性能计算集群、基础计算、GPU 服务器、裸金属服务器、分布式存储及集中块存储等。

2) DMZ 区。DMZ 区主要用于接收基于 5G 通信网络或北斗导航系统传输的地面水系统监测数据,黄委政务公开系统及具有移动应用需求的黄河水政执法巡查监控、黄委水事违法案件处置、黄委视频共享等业务应用模块,与政务外网区实现逻辑隔离,通过网络安全设备实现 2 个分区的数据交换。由于 DMZ 区部署应用对算力的需求相对单一且规模较小,因此改变现有基于物理服务器的部署模式,采用超融合技术架构部署超融合虚拟化集群。集群中仅包含通用服务器、网络交换机,以及虚拟化、安全 2 类软件,以虚拟机形式提供计算、存储、网络、备份服务等,可简化运维管理,降低建设成本,提高基础架构平台部署效率。

3.1 计算池设计

随着国产化进程的不断推进,X86 和 ARM 架构CPU 的应用范围逐步扩大,因此,政务外网区计算资源池需要融合 X86 和 ARM 等不同类型架构,涵盖CPU 和 GPU 等异构芯片,充分发挥多类芯片算力特性,兼容适配多种操作系统。计算池具体设计如下:

1) 建设虚拟化计算节点。用于支撑流域水旱灾害防御、水资源管理与调配等“2 +N”业务应用系统部署,以及数据的接收、汇聚、治理、发布与服务等。计算量方面,以业务应用对 vCPU(虚拟 CPU)、内存的需求为指标,考虑适当冗余及资源预留,估算资源总量配置。

2) 建设高性能计算集群。用于水利专业、智能、可视化等模型算法的并行和分布计算及模拟仿真需求,主要包括通用计算、加速计算(GPU 计算节点)、登录、管理等节点及高速互联网络等[20]。通过对相关模型算法算力需求的梳理分析,得到集群实现模型算法目标须提供的算力总和。如将黄河流域划分为具有空间拓扑关系的 8 485 个子流域和 38 720 个等高带,通过时空离散化方法对分布式水文模型实现时间、空间的分层并行计算,当加速比最大达到 8.17[21]时,需要的算力资源为 20 核的 CPU 算力资源;选取宽度约为 0.8 km、长度约为 17 km 的河段作为河道溃坝洪水算例,最高获得 8.0 加速比时,采用 CUDA(统一计算架构)的核心数量至少不低于 2 496 个的算力资源[22]。

3) 建设 GPU 计算节点。为智能遥感解译、视频图像识别分析等提供智能算力,提升问题发现、精准预测、科学决策精度和效率。

4) 建设裸金属计算节点。主要用于部署数据库系统,确保资源独享、数据隔离、性能可靠、可监管及可追溯。

3.2 存储池设计

数字孪生黄河建设实现流域全数字化管理,汇聚基础、监测、业务、空间地理、跨行业共享等海量数据,存储系统须具有海量存储、高扩展能力及高经济性,并支持多种存储模式,以保证数据的存储和访问性能。因此,采用集中存储与分布式存储相结合的方式建设存储资源池。

集中式存储,主要用于虚拟机部署、结构化数据的高效存储,以块存储模式提供较高 IOPS。分布式存储,主要提供块、NAS 文件、对象、分布式文件等存储模式,其中:分布式块存储主要作为集中式块存储的补充,为业务虚拟机部署提供存储资源;NAS 文件存储具有共享需求的非结构化数据,如文件视频等的共享、使用频率较高且具有解译需求的遥感影像等;对象存储模式采用 key-value 的扁平化存储架构,可有效提升数据访问效率,主要用于海量遥感影像、视频、图片等非结构化数据的分层存储及归档;分布式文件存储主要用于大数据分析中大数据文件的存储。

数据最终存在不同的存储介质中,生产环境使用的在线存储介质一般包括 SSD(固态硬盘)、机械硬盘(一般包括 SAS,NL-SAS,SATA 等硬盘)等,存储介质选择及空间计算介绍如下:

1) 存储介质选择。根据数据存储量大小及访问时延要求将存储资源池划分为不同等级。对有较高IOPS 需求的结构化数据,采用 SSD 闪存盘存储;对虚拟机部署及使用频率较高的非结构化数据,根据重要程度选择 SSD 或较高转速的 SAS 盘存储;对使用频率较低的海量历史视频,以及遥感影像、归档、备份等数据,使用容量较大的 SATA 硬盘存储,并采用存储分层技术提升存储性能。

2) 存储空间计算。全息数据的汇集会导致存储空间的需求量大幅增加,因此按照不同数据类型分别计算存储空间需求量。以遥感监测数据为例,统筹业务监测时间与区域等需求,合并可共用资源,将各类数据资源以 2 和 16 m 2 种空间分辨率 GF-1 卫星遥感影像为标准进行数据量测算,16 m 分辨率 GF-1 遥感影像 1 景原始数据、正射影像成果、真彩色成果、切片合计约需要 5.45 GB 存储空间,按照黄河流域重点区域每年遥感监测共需要 39 970 景计算,则需要 213 TB 存储空间,2 m 分辨率 GF-1 遥感影像按照6 300 景计算需要 57 TB 存储空间,5 年存储量合计大约需要 1 350 TB 可用空间。

3.3 资源管理设计

多算力融合黄河云资源管理设计从云服务层级、内容和方式等方面对现有资源管理及服务方式进行优化提升,支持租户级别的资源使用及管理,满足黄委多组织架构下对资源权限配置的灵活性需求;扩充资源服务内容,支持基于容器的敏态开发,快速上线业务创新应用;以全方位运维数据统计分析为数据支撑,优化资源配置,提升资源使用效率。多算力融合黄河云资源管理和服务规划与现有资源管理及服务方式优势对比如表3 所示。

4 结语

本研究提出面向数字孪生黄河建设的多算力融合黄河云部署架构,介绍了高性能、智能等多种计算架构,CPU 和 GPU 等异构芯片,以及集中式、分布式、对象等多种存储模式在数字孪生黄河建设中的应用场景,为多算力融合架构在数字孪生流域建设中的应用提供了理论支持和技术积累。多算力融合架构不仅可为数字孪生流域建设提供高效、安全的算力支撑,还可针对流域组织架构管理实际,灵活管理资源,有效提高算力资源服务的效率及能力。然而,数字孪生流域建设是一项极为复杂的系统性工程,如何有效分配及调度算力资源,使算力资源在模型、智能业务运行中充分发挥效能,以及资源统一编排调度技术在多算力融合场景下的应用研究仍需要不断推进。