基于多尺度卷积神经网络的显著性检测方法

2023-12-25刘鑫松孙劲光

刘鑫松 孙劲光

摘要:在显著性检测技术迅速发展的今天,传统的显著性检测技术对图片提取显著性目标区域时常常遇到难以在复杂的图片中准确地区分物体的内部区域和边界,造成边界模糊、提取精度不佳等问题。针对以上问题,根据卷积神经网络特征提取时会同时产生多个尺度特征的特点,提出了一种基于多尺度卷积神经网络的显著性检测方法。首先,图片经过特征提取模块产生分辨率不同的特征图;其次,由上至下建立多尺度特征连接;然后,采用降维、上采样等方式进行融合特征;最后,提取图片显著目标区域。实验在HKU数据集、ECSSD数据集以及PASCAL-S数据集上设计,结果表明,基于多尺度卷积神经网络的显著性检测网络模型具有较好的显著性检测能力,并具有较高的执行效率。

关键词: 多尺度;卷积神经网络;显著性检测;特征提取;特征融合

中图分类号:TP389.1 文献标识码:A

文章编号:1009-3044(2023)31-0028-03

开放科学(资源服务)标识码(OSID) :

0 引言

在当今互联网飞速发展的时代,计算机视觉在电影、动画、游戏创作、时装设计等方面也快速发展,数字图像已经成为人们重要的沟通桥梁。图片显著性目标检测作为计算机视觉领域的重要组成部分,被广泛应用在当今社会的各个方面。例如,图片自动剪裁[1]、图片重定位[2]、目标识别[3]、人体跟踪等方面均有重要应用。

随着图像处理器的发展,深度学习技术在显著性检测领域得到了越来越多的应用。2015年,Li等人[4]最先在显著性检测中使用深度神经网络,提出一种基于卷积神经网络的多尺度特征的显著性检测方法。该方法利用3个子网络分别提取3个不同尺度的特征,将特征输入网络模型中进行训练测试,最后将不同尺度的图片进行融合,得到最终结果。由于基于深度学习的检测算法大多放弃了中心先验、背景先验等先验方式,只采用卷积神经网络提取图片特征,最终导致输出图片存在边界模糊等问题。为了解决这一问题,Lee等人[5]在显著性检测算法中结合了先验信息,低级特征对高级特征进行补充,通过全联接的神经网络融合,进而得到最终结果。而上述研究均忽略了不同卷积层提取的特征信息之间可能存在的相互联系对显著性检测的重要作用,容易出现不能将显著性目标区域从主体中分离出来、检测结果边界模糊等問题。

为此,本文提出一种基于多尺度卷积神经网络的显著性检测方法,该方法在卷积神经网络的基础上进行改进,在网络结构中增添了多尺度特征连接,能够提取足够且丰富的特征用于检测,防止因为缺少足够特征而造成检测区域边界模糊等问题。同时,面对过多引入全连接层造成模型复杂度和参数量增多的问题,在该方法中去掉了卷积神经网络的全连接层。这样既可以提取更多的特征信息,又能减少计算量、加快运算速度,从而更快更精准地获取图片显著性目标区域。

1 方法模型建立

1.1 方法思路

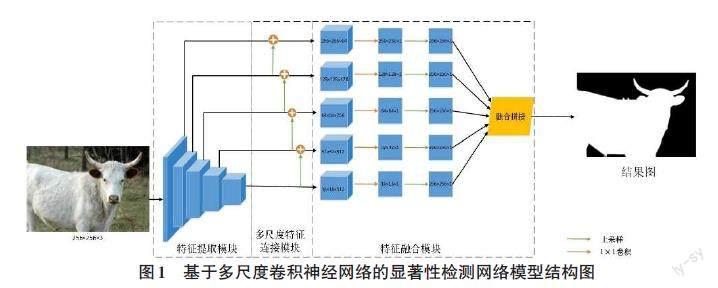

本文提出的基于多尺度卷积神经网络的显著性检测网络模型如图1所示,主体由特征提取模块、多尺度特征连接模块、特征融合模块组成。

1) 特征提取模块,记作:FA。特征提取模块作为网络结构的第一部分,由13个卷积层和5个最大池化层组成。将图片输入网络中,由特征提取模块进行自下而上的特征提取操作,获得5个尺度的特征图,表示为[{F1,F2,F3,F4,F5}]。这5个特征图的空间分辨率按照步长2递减,进行下采样操作。这些特征图越靠近浅层卷积层,空间分辨率越高,越能较好地保留结构和细节信息;但包含的高级语义信息也越少,例如[F2]。相反地,[F5]拥有最小的空间分辨率和最强的语义性,却也具有最少的结构和细节信息。此特征提取过程可定义为:

[Fi=f(i=1nwixi+b),i=1,2,3,4,5] (1)

其中,[Fi]是图片经卷积池化操作后,使用ReLU激活函数进行非线性映射操作得到该层的输出值;[xi]为该层的输入值;[wi]是卷积过程中的权重参数;[b]是偏置值。

2) 多尺度特征连接模块,记作:FC。为了使特征提取模块所提取的多尺度特征图具有更优秀的表示能力,模型将低层特征和与其相邻的上层特征相连接,如图2所示,以实现不同层特征在一定程度上可以互相弥补,由此,低层特征拥有上层特征的高级语义特征,上层特征也拥有了低层特征所包含的丰富细节信息。整个过程从[F5]开始迭代,直到最低层特征图[F1]为止,依次产生[{F'4,F'3,F'2,F'1}],由此产生的4个特征图不仅包含结构和细节信息,也包含了高级语义信息,具有更强的表示能力。此多尺度特征连接过程定义如下:

[F'i-1=f'i(Fi)+fi(Fi-1),i=5,4,3,2] (2)

其中,[F'i-1]为经过多尺度连接操作后的输出值;[f'i]是卷积核大小为[3×3],步长为2的反卷积层,采用双线性插值的方式对特征图[Fi]进行上采样操作,以获得和[Fi-1]相同尺寸的特征图;[fi]是进行以[Fi-1]为输入值的、卷积核大小为[1×1]的卷积操作。

3) 特征融合模块,记作:FM。对于每个经过多尺度特征连接的特征图[F'i(i∈{1,2,3,4})]和[F5],均通过一个[3×3]的卷积层生成特征图[f'i]。再经过一个[1×1]的卷积层进行降维操作,得到5个大小分别为[16×16]、[32×32]、[64×64]、[128×128]和[256×256]像素的特征图。采用反卷积和双线性插值的方法对这些特征图进行上采样操作,目的是使这些特征图与输入的图片具有相同的尺寸大小。因此,设置反卷积的步长分别为16、8、4、2和1,将这些相同尺寸的特征图进行融合拼接。最后在生成预测图阶段采用[1×1]的卷积层进行操作,并使用Sigmoid函数将结果归一化为[0,1]。

1.2 具体实施

完成网络模型的构建后,如何提高网络模型对训练样本集的学习能力成为首要任务,可以通过调整超参数的方法来完成这项工作,然后再通过验证样本集测试生成结果、观察网络模型检测准确率。可调整的超参数主要包括:学习速率、迭代次数、数据批量大小等。

在网络模型的训练阶段,引入多尺度特征显著性检测损失函数来衡量显著性预测结果与对应的真实二值标注图之间的误差。损失函数是作用在全部训练数据上的,取所有样本误差的平均值,而本文多尺度特征显著性检测损失函数由单边损失和融合损失组成,所以最终的损失函数指的是单边损失和融合损失的平均值。在预测任务中交叉熵损失函数是最有效且最常用的损失函数,降低交叉熵损失就是提高网络模型的预测精度,单边损失定义为:

[L(n)side(W,w(n))=-yi∈YyilogPr(yj=1|X;W,w(n))-yi∈Y(1-yi)logPr(yj=0|X;W,w(n))] (3)

其中,[X]作为训练数据,且[X={xj,j=1…X}];[Y]为对应的真实二值标注图,[Y={yj,j=1…Y},y(n)j∈0,1];[Pr]表示第N个阶段i像素点处的预测值,[Pr={yj=1X;W,w(n)}];[W]为其他权重,[w]为第N个阶段输出特征的权重。

在网络模型中添加了融合层去连接每个单边,融合损失被定义为:

[Lfuse(W,w,f)=d(Y,Yfuse)] (4)

其中,[d]表示预测图与真实二值标注图之间的距离;[Yfuse]被定义为:

[Yfuse=n=1NfnA(n)side] (5)

其中,[A(n)side] 为第N阶段的输出值,[A(n)side={a(n)j,j=1…X}];[f]为融合权重,[f={f1…fN}]。

最终采用反向传播和随机梯度下降算法进行网络训练的优化,这也是使基于多尺度卷积神经网络的显著性检测网络模型的总损失达到最小值的过程。模型总损失定义为:

[Ltotal=argmin(Lside(W,w)+Lfuse(W,w,f))] (6)

通过训练,最终选定最佳的网络参数设置。本文采用Adam[6]优化器来训练网络模型,学习率初值设为[10-6],动量为0.9,权重衰减为0.000 2,融合权重初始化为0.2,每一批样本数设为20个,训练迭代次数设为10 000次。

2 实验结果分析

2.1 实验环境设置

本文训练模型时所设置的实验环境如表1所示。

2.2 实验数据集

通过构建基于多尺度卷积神经网络的显著性检测网络模型来验证本文方法的有效性,在HKU数据集、ECSSD数据集以及PASCAL-S数据集上进行训练实验,通过比较实验进行性能评估。其中,HKU数据集包含超过 4 447张图像的大型数据集,且大多数图像具有低对比度并且有多个显著性物体。ECSSD数据集包含1 000张语义上有意义但结构复杂的图像。PASCAL-S数据集[7]包含从PASCAL-VOC[8]分割数据集中选择的850幅真实世界的图像。

2.3 评估指标

为了评估基于多尺度卷积神经网络的显著性检测网络的性能,本文采用2种评估度量方法:F值(F-Measure) 和平均绝对误差(MAE) [9]。

F值是利用准确率和召回率确定的综合定量指标,其计算公式为:

[Fβ=1+β2·P·Rβ2·P+R] (7)

其中,[β]为平衡参数、[P]为准确率、[R]为召回率,同时将[β2]设置为0.3来提高准确度。

平均绝对误差是用来计算模型输出的显著图与真值图之间平均像素的绝对误差,其计算公式为:

[MAE=1h·wi=1hj=1wS(x,y)-G(x,y)] (8)

其中,[h]和[w]分别代表长和高,[S(x,y)]代表显著图,[G(x,y)]代表真实值,[(x,y)]则代表像素点的具体位置。

2.4 实验结果及分析

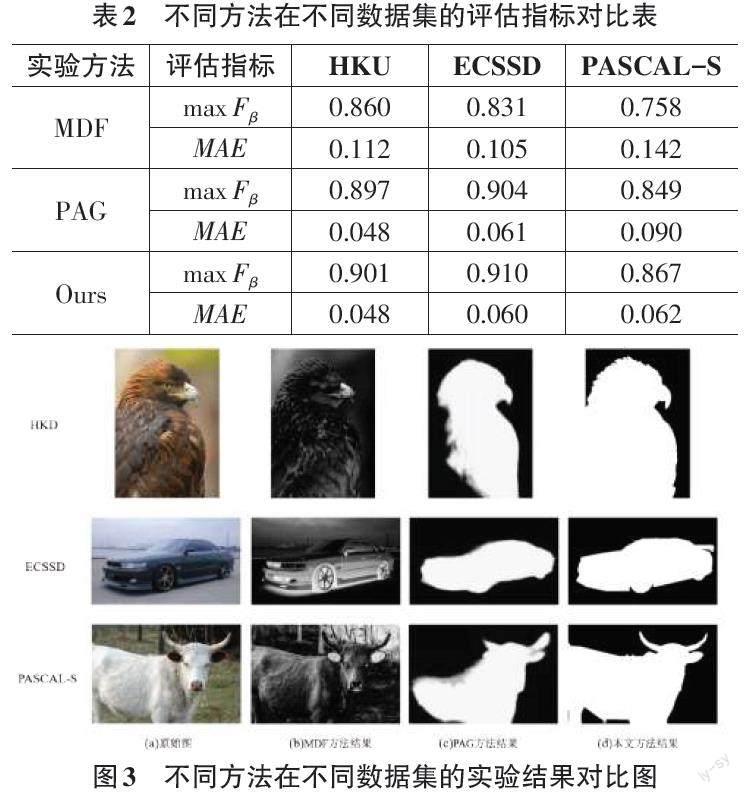

将本文方法与现有的显著性检测方法进行对比,以评价指标表、视觉效果图以及运行时间表的形式展示对比实验结果,对比方法有:MDF[10]、PAG[11]。

评估指标对比结果如表2所示,其中[maxFβ]值越高代表显著性检测越精确,[MAE]值则是越小越好。从表2中可以看出本文模型的[maxFβ]值均高于其他算法,且[MAE]值均低于其他算法。综上,本文模型的性能最优。

图3中给出了3种不同实验方法,在3种数据集上进行对比实验的实验结果。其中,(a)是在数据集中挑选的原始图;(b)是MDF方法结果;(c)是PAG方法结果;(d)是本文方法结果。通过这些實验结果可以看出,基于多尺度卷积神经网络的显著性检测网络模型可以很好地完成对显著性区域的检测,且检测结果具有更清晰的边界。

将本文方法与PAG、MDF方法在运行时间方面进行了比较,结果如表3所示。可以看出,本文方法相比于其他方法更高效,每幅图片的运行时间仅需0.03s。

3 结论

本文在卷积神经网络中加入多尺度特征连接,同时去掉卷积神经网络的全连接层,提出基于多尺度卷积神经网络的显著性检测方法,使用多尺度特征显著性检测损失函数来训练网络。对提取图片的显著性区域应用此方法,可以精准地生成图片显著性目标区域,并能减少生成时间,提升效率。在未来的工作中,笔者将加强对目标区域边缘的优化,加快生成速度,并期望把基于多尺度卷积神经网络的显著性检测网络模型应用在更多其他的目标检测工作中,如多样性目标自由提取,满足用户的自由选择多样化需求等。

参考文献:

[1] 郭迎春,梁云鹤,于明,等.基于图像分块和优化累积能量图的线裁剪算法[J].电子与信息学报,2018,40(2):331-337.

[2] 李恬,柴雄力,吕晓文,等.基于深层特征学习的可压缩感知及缝雕刻的图像重定向[J].光电子·激光,2020,31(5):519-530.

[3] REN Z X,GAO S H,CHIA L T,et al.Region-based saliency detection and its application in object recognition[J].IEEE Transactions on Circuits and Systems for Video Technology,2014,24(5):769-779.

[4] LI G B,YU Y Z.Visual saliency based on multiscale deep features[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2015:5455-5463.

[5] LEE G,TAI Y W,KIM J.Deep saliency with encoded low level distance map and high level features[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2016:660-668.

[6] DIEDERIK P. KINGMA, JIMMY B A.A Method for Stochastic Optimization[C]//Proceedings of International Conference on Learning Representations San Diego,CA,USA.2015.

[7] LI Y,HOU X D,KOCH C,et al.The secrets of salient object segmentation[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.IEEE,2014:280-287.

[8] EVERINGHAM M,GOOL L,WILLIAMS C K,et al.The pascal visual object classes (VOC) challenge[J].International Journal of Computer Vision,2010,88(2):303-338.

[9] BORJI A,CHENG M M,JIANG H Z,et al.Salient object detection:a benchmark[J].IEEE Transactions on Image Processing,2015,24(12):5706-5722.

[10] LI G B,YU Y Z.Visual saliency based on multiscale deep features[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2015:5455-5463.

[11] ZHANG X N,WANG T T,QI J Q,et al.Progressive attention guided recurrent network for salient object detection[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.IEEE,2018:714-722.

【通聯编辑:唐一东】