基于语义引导特征聚合的显著性目标检测网络

2023-11-28王正文宋慧慧樊佳庆刘青山

王正文 宋慧慧 樊佳庆 刘青山

显著性目标检测[1-5]能够对图像中在视觉上最与众不同的对象或区域进行检测与识别.目前,显著性目标检测已经成功地作为许多计算机视觉领域任务的预处理过程,包括目标跟踪[6]、物体识别[7]、语义分割[8]等.

传统方法[9-10]大多依靠颜色、纹理等手工特征或者启发式先验来捕获图像局部细节和全局上/下文.Goferman 等[9]提出一种基于上/下文感知的方法,对目标周围的不同区域均进行检测,并最终基于四个心理学原理简单生成了显著性图.Yan 等[10]设计了一个分层模型,能够对显著信息进行层次分析,并将不同层次的输出进行组合得到最终结果.尽管上述算法取得了一定的成功,但是由于缺乏高级语义信息的参与,在复杂场景中检测显著物体的能力受到了很大限制.

近年来,卷积神经网络得到快速发展.例如文献[11-13]的卷积神经网络所具备的金字塔结构,能够在较浅层拥有丰富的低层边缘细节特征,而较深层则包含了更多语义信息,更擅长定位显著物体的确切位置.基于上述先验,大量基于卷积神经网络的深度模型被相继提出.Hou 等[11]对编码过程中每个阶段都引入了跳跃连接,对特征图进行多层次多角度的聚合连接,输出精确的结果.Li 等[14]将粗纹理的显著图作为前景信息,将图像边界的超像素值作为背景信息,并将两者结合,得到最终的结果.Qin 等[15]设计了一种嵌套的U 型结构,融合了不同感受野大小的特征,能够捕捉更多的上/下文信息.在这些方法中,U 型结构由于能够通过在基础的分类网络上建立自上而下的路径来构建丰富的特征图,而受到了最多的关注.

尽管上述方法相对于传统方法已经取得了很大进步,但是还有很大改进空间.首先,在U 型结构的解码过程中,高层语义信息逐渐传递到较浅层,虽然较浅层获得了显著物体的语义信息,但是位置信息同时也被稀释,造成最终输出的预测图中并不是当前图像中最显著部分,丢失了显著物体准确的空间定位;其次,低层特征拥有丰富的边界信息,但是由于在网络的较浅层,无法获得较大感受野,此时如果只是简单地融合高层特征与低层特征,是无法精确地捕捉图片中显著物体边界的,尤其是小目标.因此,本文考虑在增大低层特征感受野,提高其表征力后,将其送入到高效的特征聚合模块中,以此来细化显著物体的边缘.

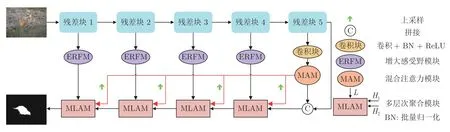

针对上述问题,本文研究了如何在U 型结构中通过高效的特征融合解决这些问题.本文主要贡献包括以下3 个方面: 1)混合注意力模块(Mixing attention module,MAM)对来自第5 个残差层的特征利用注意力机制进行显著性增强,得到更加关注显著物体的语义特征,同时为了解决解码过程中显著物体位置信息被不断稀释的问题,将其作为整个解码过程中的语义指导,不断指导解码过程中的特征聚合,生成更加具体的显著性图.2)增大感受野模块(Enlarged receptive field module,ERFM)可以对来自低层的特征进行处理.低层特征的边缘细节相当丰富,但受限于感受野,无法获得更加全局的信息.因此,考虑加入ERFM,可以在保留原有边缘细节的同时,获得更大的感受野,增强语义信息.3)多层次聚合模块(Multi-level aggregation module,MLAM)是对来自经过上述2 个模块生成特征进行高效聚合,以级联方式不断提取特征中的显著部分,细化显著物体的边缘细节,生成最终的显著图.具体结构如图1 所示.

图1 网络结构图Fig.1 Network structure diagram

1 相关工作

近年来,大量基于全卷积神经网络深度模型[16-17]被相继提出,受益于全卷积神经网络强大的特征提取能力,基于深度学习的方法已经在性能方面超越了大多数基于手工特征的传统方法.文献[18]详细总结了传统方法.本文主要讨论基于深度学习的显著性目标检测算法.

1.1 基于注意力机制的显著性目标检测

注意力机制具有很强的特征选择能力,能够将特征信息进行深度整合,使得网络更加去关注所需的语义信息.根据加工域的不同,注意力机制可以分为空间域注意力和通道域注意力两类,其中空间注意力模块旨在捕获特征图中任意两个空间位置之间的空间依赖性,通道注意力模块旨在捕获任意两个通道之间的通道依赖性.因此,许多学者利用注意力机制进行显著性目标检测.Zhang 等[19]提出一种渐近注意力引导网络的显著性方法,在解码阶段,级联多个注意力模块渐近地生成最终结果.Zhao 等[20]考虑到不同层次的特征所具备的信息并不相同,因此,对来自不同层次的特征,分别设计了不同角度的注意力模块,并对多个结果进行融合,得到最终的结果.Chen 等[21]提出一种反向注意网络,将粗糙的预测图反馈到中间特征层,希望网络可以补全缺失的显著部分.Wang 等[22]设计了一个金字塔注意力模块,通过考虑多尺度注意力来增强显著特征的表征力.上述方法都是对注意力机制的有效使用,本文方法需要生成更加关注显著物体语义信息的高层特征,利用注意力机制可以取得很好效果.

1.2 基于特征聚合的显著性目标检测

大多数对特征进行聚合的方法都是采用编码-解码的框架,其中编码器用于提取多尺度特征,解码器用于聚合特征以生成不同级别的上/下文信息.Wu 等[23]对深层特征进行优化,提高其表征力,并利用双分支结构对特征进行聚合,生成细化后的结果.Deng 等[24]设计一种循环策略,不断聚合来自不同层次的特征,对网络进行细化,增强显著信息.Wang 等[25]提出一个特征打磨模块,通过重复使用该模块,对特征不断细化,聚合来自不同层次的特征,得到最终结果.上述方法都探索了高效的特征聚合方法,虽然有一定效果,但是对于空间细节的捕捉仍然不够,并且在解码过程中,由于缺少高级语义的指导,导致预测出的显著物体位置出现了偏移.本文针对上述问题,设计了多层次聚合模块,使其能够在高级语义的指导下,精确地定位显著物体,并且通过级联多个、多层次聚合模块,可以实现对边缘细节的细化.

2 本文方法

如图1 所示,本文建立一个编码-解码结构.首先,选用ResNeXt101 作为特征提取器,提取图片的各层特征;其次,利用MAM 生成一个全局语义特征,来引导解码过程,通过上采样、卷积和元素累加等操作,将全局语义融合到解码器的各层特征中;接着,编码过程中生成的各级特征通过ERFM 后,生成具备更多边界信息的低层特征;最后,将各级特征一起送入MLAM 进行特征的有效聚合,通过级联方式生成最终的显著性图.

2.1 混合注意力模块

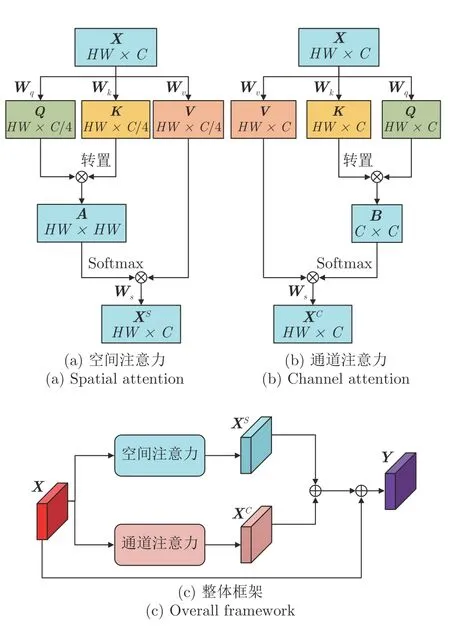

图片送入网络中,经过编码后,会生成一系列具备不同信息的特征.最高层的特征具备最强的语义表征能力,并且在解码过程中,逐渐与低层特征进行融合,最终得到显著图.但是,直接将这种语义信息进行解码融合,会造成许多显著性细节的丢失,原因在于高层特征的不同通道和不同空间位置对显著性计算的贡献是不同的.具体地,不同通道对同一对象会有不同响应,而同一通道的不同空间位置也会包含不同的对象.受文献[26]启发,本文设计了混合注意力模块,该模块分为通道注意力机制和空间注意力机制两部分,用来捕捉不同通道和不同空间位置中最显著的部分,利用这些最显著的语义信息,对高层特征进行有效增强,得到更具鲁棒性的全局语义特征.MAM 模块结构见图2.

图2 混合注意力模块Fig.2 Mixing attention module

2.1.1 空间注意力机制

对于从残差块5 中提取的高层特征,首先,将其宽、高维度展开成一维向量并进行转置,得到二维矩阵X∈RHW×C,C是该特征的通道数,H和W分别是高和宽,HW为高与宽相乘的数量.然后,经过3 个并行的全连接层Wq、Wk和Wv对通道进行降维,分别得到Q=XWq、K=XWk、V=XWv三个矩阵.接着,利用A=QKT得到相关性矩阵,其中,Aij代表Q中第i行与K中第j行的内积,即两个不同空间位置处向量的相关性.并且对相关性矩阵A的每一行利用Softmax 函数进行归一化,约束到(0,1)内.最后,将相关性矩阵A与V相乘,并且经过一个全连接层Ws对通道维度进行恢复,得到空间显著性增强后的特征图XS=AV Ws,最终的特征表达式为:

2.1.2 通道注意力机制

通道维度的操作与上述类似,也是对残差块5提取的特征先沿着宽、高维度展开成一维向量并转置,得到X∈RHW×C经过三个全连接层,输出Q=XWq,K=XWk,V=XWv.考虑到降维会带来过多的信息损失,因此本文算法没有对通道进行降维.然后,通过B=KTQ得到相关性矩阵,其中Bij代表了K中第i列与Q中第j列的内积,即两个不同通道向量的相关性.同样,需要对相关性矩阵B的每一列利用Softmax 函数进行归一化,约束到(0,1)内.最后,将V与B相乘且经过一个全连接层Ws,得到通道显著性增强后的特征图XC=V BWs,最终的特征表达式为:

式中,Wq,Wk,Wv,Ws ∈RC×C.最后合并这两个分支的输出.考虑到残差结构的影响,本文将合并后的特征与输入X进行相加,生成最终特征图Y ∈RHW×C:

式中,“⊕”表示元素级的特征图相加.Y在经过转置并且将维度展开恢复后,送入到后续的模块中.

2.2 增大感受野模块

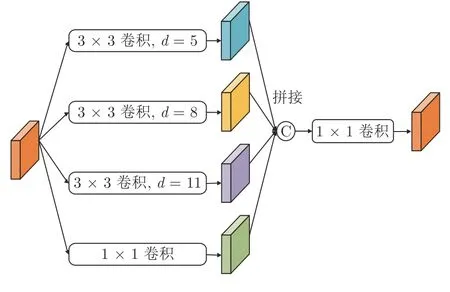

低层特征的边缘细节非常丰富,但由于下采样的次数有限,感受野相对受限,无法捕捉全局的信息.在解码过程中,如果仅仅是简单利用低层特征,虽然边缘的细节信息得到利用,但并没有充分挖掘特征的空间细节.受文献[27]启发,本文设计如图3所示的增大感受野模块.低层特征经过该模块后,在保证边缘细节不丢失的前提下,扩大了感受野,具备了更多空间细节.

图3 增大感受野模块Fig.3 Enlarged receptive field module

首先,对于特征M∈RC×H×W,设计四个并行分支 (li,i=1,2,3,4),其中l1采用一个 1×1 卷积,剩下的三个分支均采用 3×3 卷积,并且对这三个分支设置不同的扩张率.根据低层特征分辨率的不同设置不同的扩张率: 对于分辨率较低的特征设置较小的扩张率,对于分辨率较高的特征设置较大的扩张率.本文最大的扩张率设置为d=5,8,11,并随着特征图的缩小而不断缩小(具体设置见第3.6 节).然后,对四个分支输出进行通道维度拼接,并利用一个 1×1 卷积得到融合后的特征.

2.3 多层次聚合模块

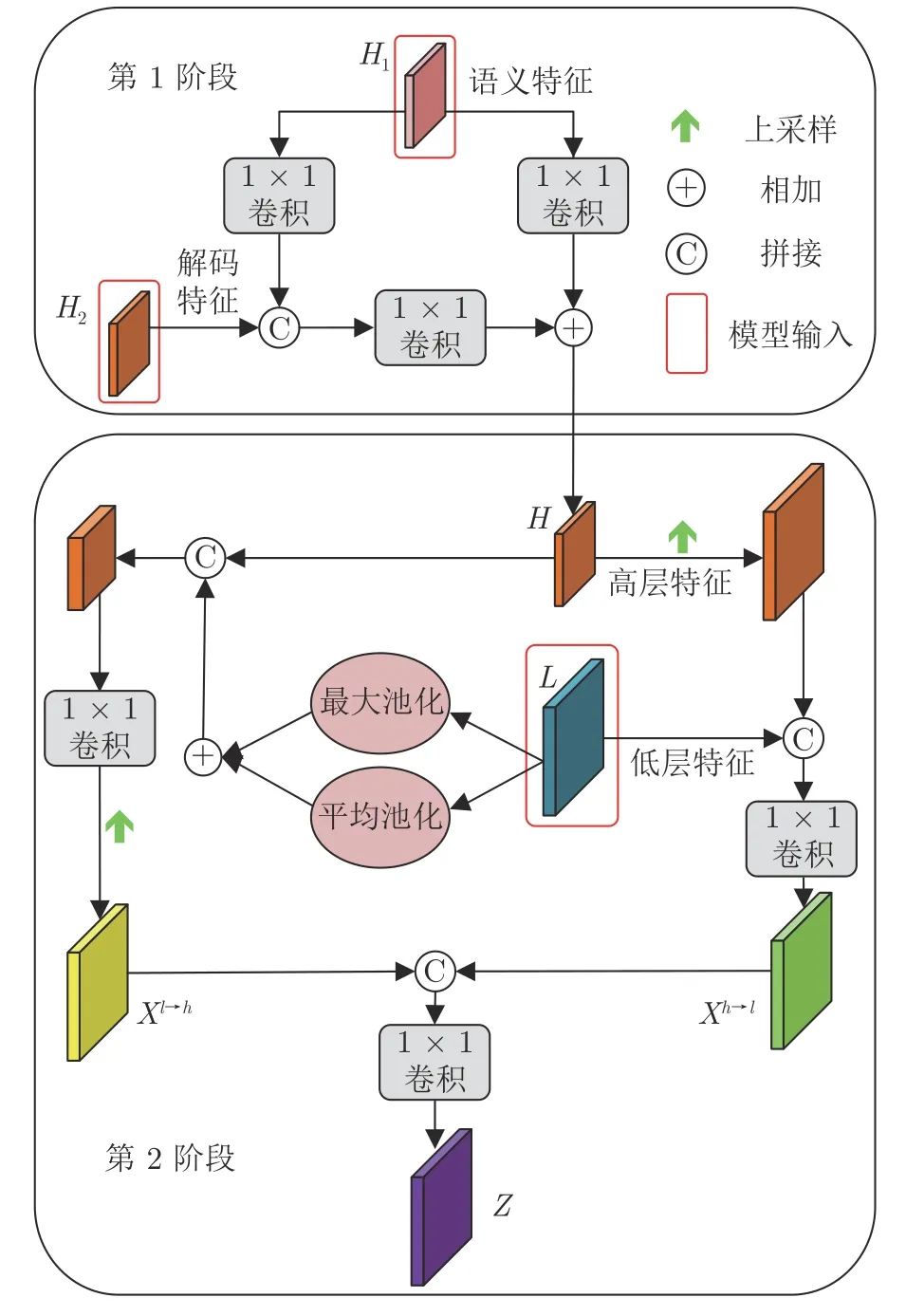

在解码过程中,高效利用每一层的特征尤为关键.以前的研究只对高层特征与低层特征进行简单的拼接融合,得到的结果非常粗糙.因此,本文设计了多层次聚合模块,对来自不同层、不同空间尺度的特征进行有效聚合.该模块的输入分为MAM 生成的语义特征H1,经过ERFM 增强后的低层特征L和当前进行解码的特征H2三个部分.图4 是多层次聚合模块示意图.

图4 多层次聚合模块Fig.4 Multi-level aggregation module

整个聚合过程分为2 个阶段: 第1 阶段是语义特征对当前解码特征的指导融合.首先让H1经过两个并行的 1×1 卷积,第1 个分支与H1在通道维度上进行拼接融合后,与第2 个分支的结果相加完成第1 次融合,得到高层特征H:

式中,fconv(·)指卷积操作,fcat(·)指通道的拼接操作.第2 阶段是第1 阶段融合得到的高层特征H与经过ERFM 增强后的低层特征L的聚合.此阶段分为自下而上和自上而下两个并行分支.自下而上是H向L的聚合,此阶段L不变,H经过一次上采样和一个 1×1 卷积后与L进行通道维度的拼接,得到聚合图Xh→l:

式中,fup(·)指上采样操作.自上而下是L向H的聚合,此阶段H不变,L首先经过一个并行的池化操作,其中最大池化可以提取特征中响应值较大的信息即特征中所包含的显著信息,平均池化可以得到特征的全局信息.经过并行池化后,特征L具备更强的表征力,并且与H有相同的空间尺寸,此时将其与特征H在通道维度上进行拼接,并利用1×1卷积完成融合.然后,对其进行上采样,得到最终的Xl→h:

式中,fmax(·)和favg(·)分别代表最大池化和平均池化操作.最后,对两个分支得到的聚合特征也进行一次聚合:

3 实验设置与结果分析

3.1 训练细节

本文代码是在Pytorch1.5.0 框架下完成,并且使用1 张GeForce GTX2080Ti GPU 进行训练.训练数据使用DUTS[28]数据集中10553张图片.使用Adam[29]优化器进行优化,初始学习率设置为1×104,并且在每训练完成两个周期后衰减一半,批量大小为8.使用ResNeXt101 作为特征提取器提取各层特征,并加载在ImageNet 上预训练的分类权重,作为初始权重.为了减少过拟合的影响,在训练阶段,对图片进行了随机翻转和遮挡,并将图片缩放到 3 20×320 像素后,将其随机裁剪为288×288像素,输入到网络中进行训练;测试阶段,仅将图片缩放到 2 88×288 像素后,输入到网络中进行测试.

3.2 数据集

本文在6 个基准数据集上进行实验,包括DUTSTE[28]、DUT-OMRON[30]、ECSSD[31]、HKU-IS[32]、PASCAL-S[33]和SOD[34].其中,DUTS-TE 与训练集的10 553 张图片同属一个数据集,包含5 019 张测试图片.DUT-OMRON 是最具有挑战性的数据集,包含5 188 张图片,该数据集的难点在于背景非常复杂,对网络预测显著目标有很大干扰作用.ECSSD 相对简单,由1 000 张图片组成,其中显著目标形状与外观有很大差异.HKU-IS 包含4 447 张图片,其中包含多个具有不同类别或外观的显著物体.PASCAL-S 包含850 张图片,图片中物体之间会出现很大程度的重叠.SOD 只有300 张图片,但场景的复杂多变,带来很大挑战.

3.3 评价指标

本文使用平均绝对误差(Mean absolute error,MAE)、Fβ(F-measure)和Sm(Structure measure)作为评价指标.

1)MAE 计算预测的显著图与真实标签之间的差异:

式中,P指预测的显著图,G指真实标签值.

2)Fβ是一种经典且有效的测量指标,通过对查准率(Precision)与查全率(Recall)设置不同的权重来计算:

式中,β2设置为0.3.

3)Sm用来考虑预测的显著图与真实标签之间的全局和局部的结构相似性,该指标的详细介绍见文献[35].

3.4 损失函数

本文使用标准的二元交叉熵损失作为训练的损失函数:

3.5 与其他算法的性能比较

本文与最新10 种基于深度学习的方法进行比较,包括U2Net[15]、PAGR[19]、RAS[21]、CPD[23]、DGRL[36]、MLMS[37]、PoolNet[38]、AFNet[39]、BASNet[40]和ITSD[41].为了指标的公平性,所有指标均在同一评测代码下进行评测,并且所有用于评测的显著图均从作者发布的模型中得出.

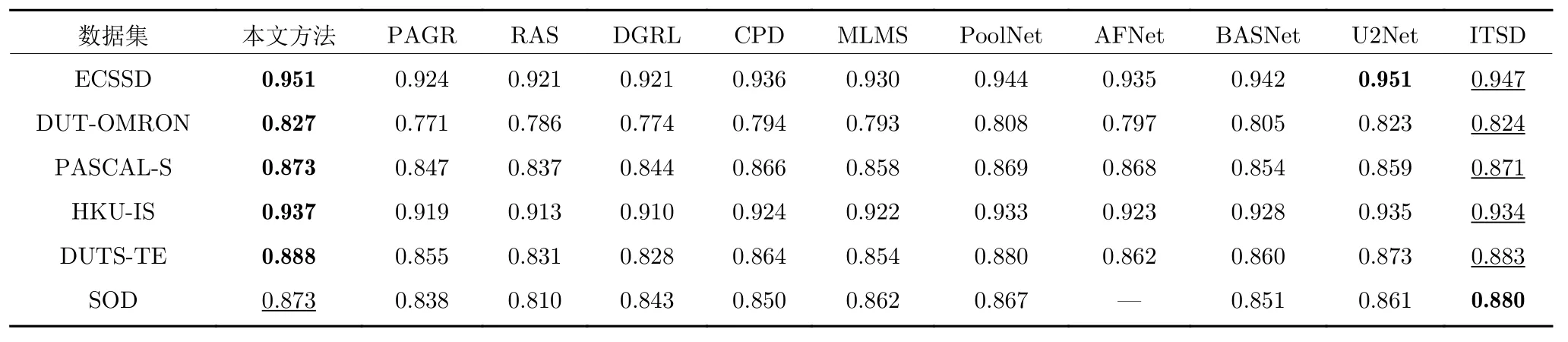

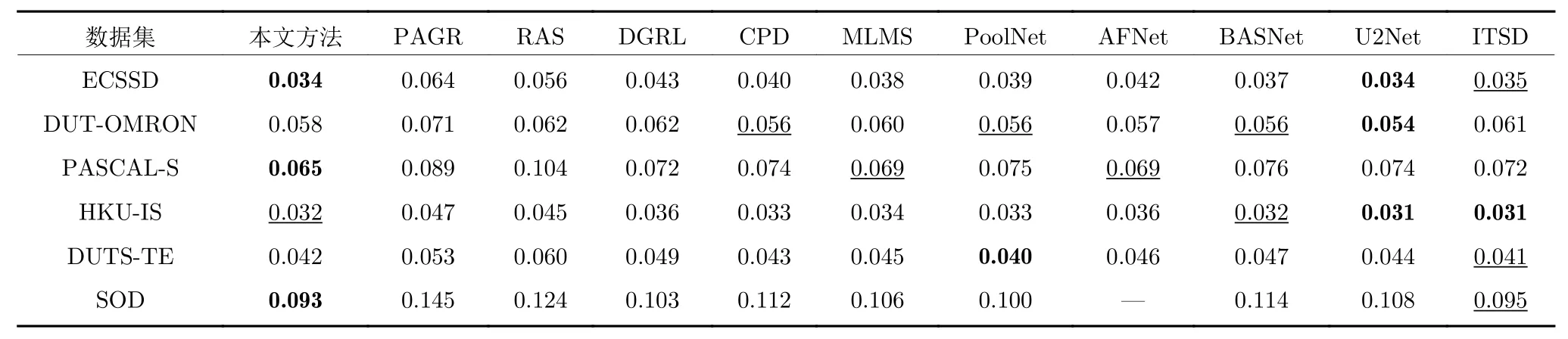

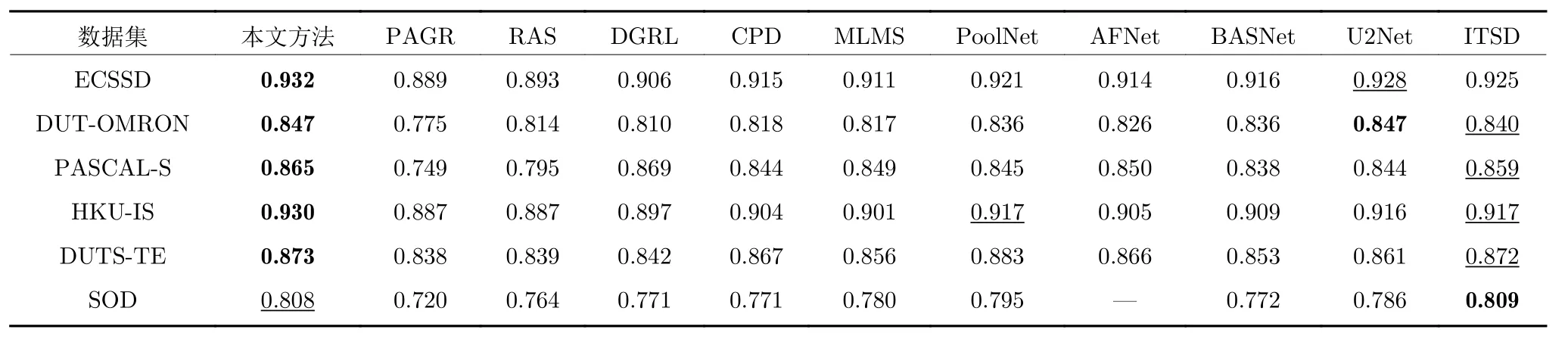

3.5.1 定量分析

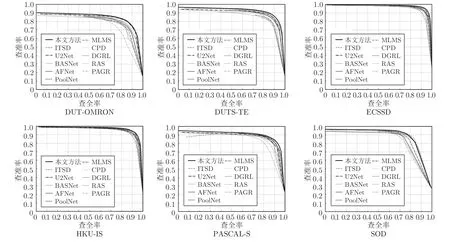

表1、表2 和表3 分别列出了各算法的Fβ、MAE和Sm评价指标结果.本文方法在3 项指标中均表现优异.由表1 和表3 可以看出,本文方法在指标Fβ和Sm上大幅领先于其他方法,即便是次优的ITSD算法,在较难的数据集DUT-OMRON 中,本文也在Fβ指标上领先其0.003,Sm指标领先其0.007.这主要得益于本文多层次聚合模块能够最大限度地保留显著物体的空间信息和边界细节.对于表2 中MAE 指标,本文方法也仅在相对较难的3 个数据集上表现稍有不足,但与第1 名的差距是非常小的,基本保持在0.001~0.002 之间.图5 是各方法的查准率-查全率曲线图,加粗实线是本文方法,由图5可以看出,本文算法性能的优越性.

表1 不同方法的 Fβ 指标结果比较Table 1 Comparison of Fβ values of different models

表2 不同方法的MAE 指标结果比较Table 2 Comparison of MAE values of different models

表3 不同方法的 指标结果比较Sm SmTable 3 Comparison of values of different models

图5 不同算法的查准率-查全率曲线示意图Fig.5 Comparison of precision-recall curves of different methods

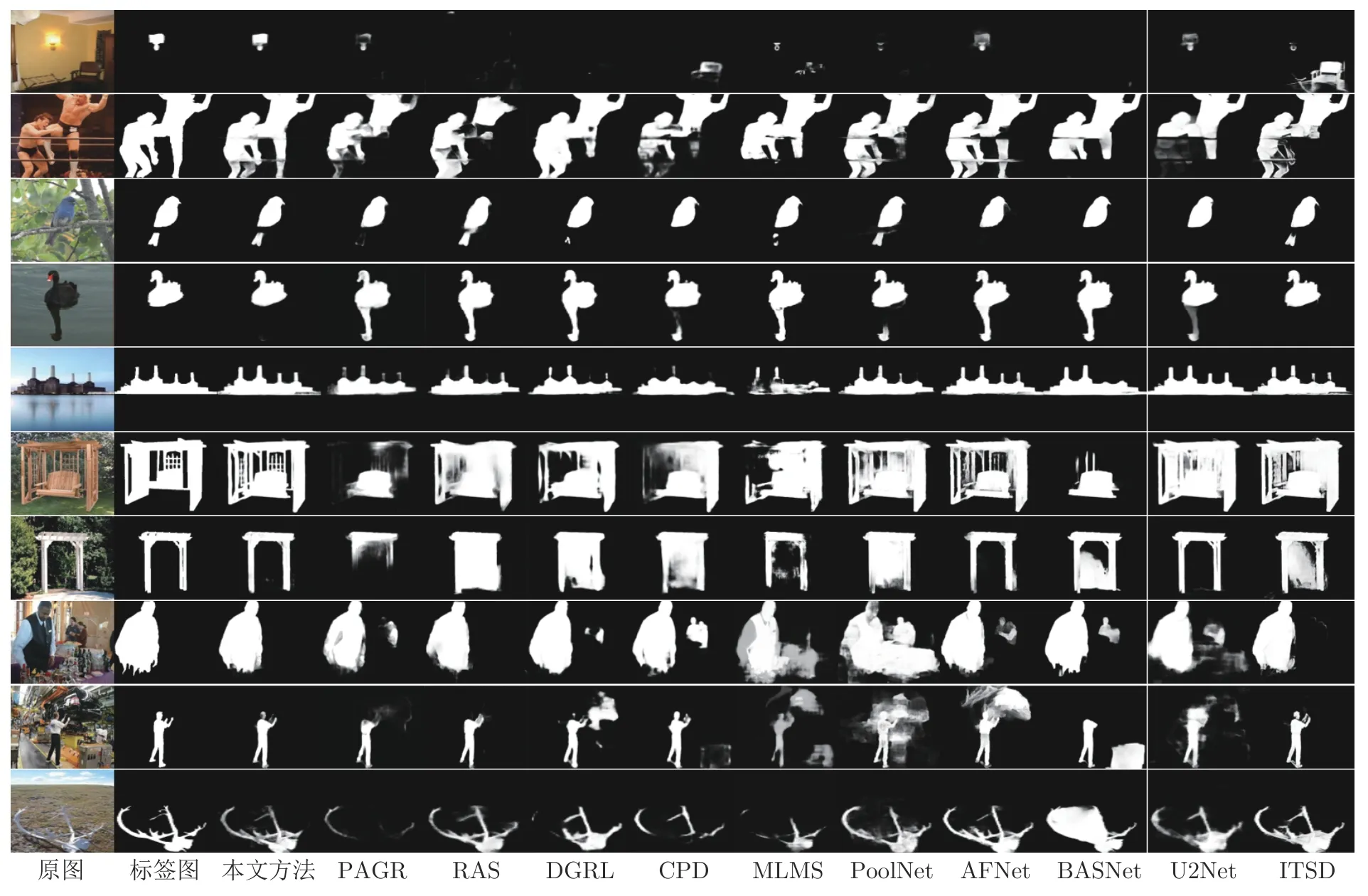

3.5.2 定性分析

图6 是本文方法与其他10 种方法的显著性图.由图6 可以看出,本文方法对显著信息的捕捉明显更强.在第1 行中,即便是指标与本文最接近的ITSD 也将座椅当作显著物体,但是在人类的视觉效果上,明亮的灯与背景的区分度更大,本文方法因为有全局语义指导特征聚合,可以捕捉到壁灯的显著信息.在第2 行中,围绳与人之间有很多交叉,即便是当前性能较好的方法也并没有将目标完整地识别出来,而本文方法由于对低层特征进行了感受野增强,可以捕捉目标周围更多的上/下文信息,能够将全部目标识别出来,但同时也存在围绳部分被识别为人的问题.综上所述,本文算法对于复杂背景下的物体边界并不能很好地细化.但对于背景较简单的物体(如第5 行和最后1 行),本文均能很好地预测出边界轮廓.

图6 不同算法的显著性图Fig.6 Salient maps of different methods

3.6 消融实验

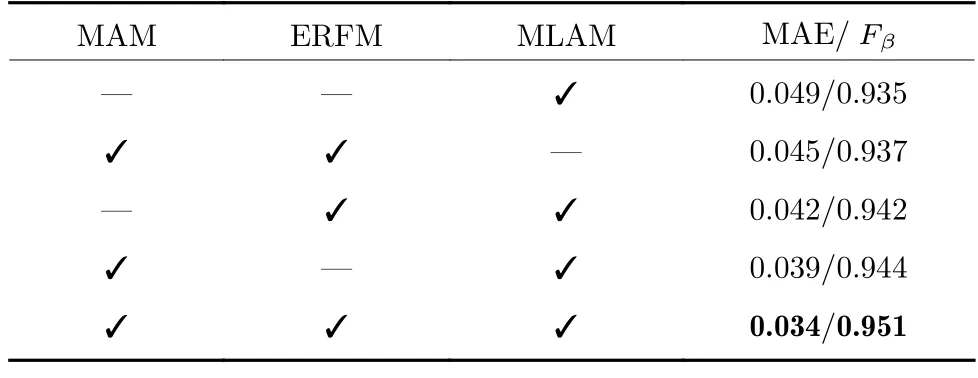

表4 是在数据集ECSSD 上针对各模块的消融实验结果: 1)混合注意力模块.由表4 第3 行可知,当缺少混合注意力模块时,MAE 指标上升了0.008,由此可见,利用该模块生成的全局语义特征引导特征聚合,能够大幅提升聚合性能;2)增大感受野模块.由表4 第4 行可知,MAE 指标上升了0.005,主要是因为缺少了感受野增强,没有充分提取低层特征的空间上/下文信息,不利于细化边界;3)多层次融合模块.由表4 第2 行可知,当用简单的上采样和相加操作代替该模块时,MAE 上升了0.011,说明多层次融合模块聚合方式非常高效.

表4 消融实验结果Table 4 Results of ablation experiment

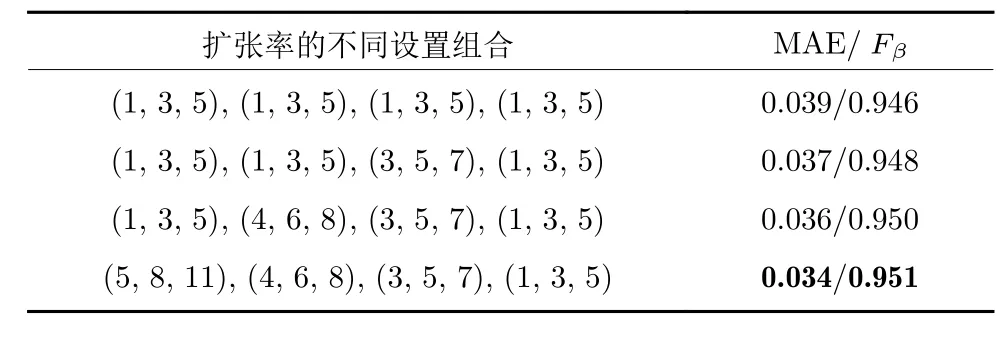

表5 是对ERFM 模块中,不同扩张率设置的对比实验结果.表5 中不同设置组合从左向右依次对应不同分辨率的特征图(见图3),即左边第1 组扩张率对应分辨率最大的特征图,最后1 组扩张率对应分辨率最小的特征图.表5 的第4 行是本文方法的设置.由表5 第1 行可以看出,当扩张率全部设置为(1,3,5)时,与本文方法相比,MAE 上升了0.005,而随着本文方法对分辨率较高的特征图分配更大的扩张率时,MAE 的指标不断降低.实验结果表明,在本文方法中,扩张率的选择是有效的.

表5 ERFM 模块中,不同扩张率设置的对比实验Table 5 Comparative experiment of different dilation rate configurations in ERFM

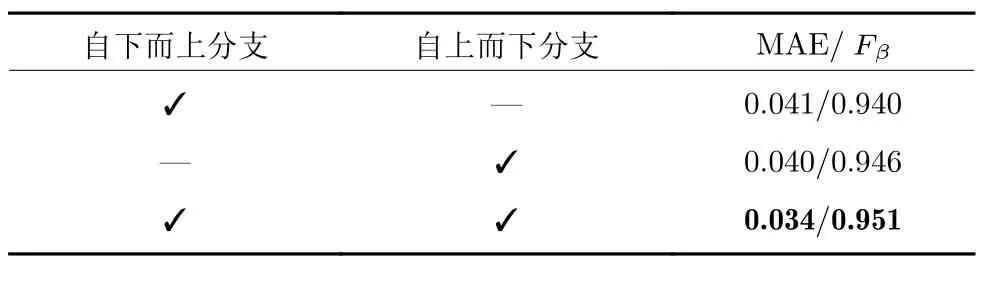

表6 是对MLAM 模块第2 阶段中,自上而下和自下而上两个分支在数据集ECSSD 上的消融实验结果.由表6 第1 行可知,当只使用自下而上分支时,相比两个并行分支均使用时,MAE 上升了0.007;而只使用自上而下分支时,上升了0.006.由此可见,本文方法将两个分支并行使用的方式是有效的,能够对精度有所提升.

表6 MLAM 模块中,两个分支的消融实验Table 6 Ablation experiment of two branches in MLAM

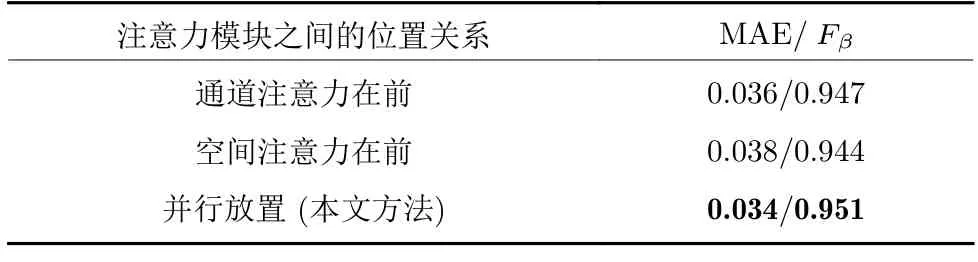

表7 是对MAM 中,注意力模块位置关系的消融实验结果.前2 行是将两个模块串联并考虑其先后位置,第3 行是两个模块并行即本文方法.当通道注意力位置在前时,与本文方法相比,MAE 上升了0.002;当空间注意力位置在前时,MAE 上升了0.004.该实验结果验证了本文将两个模块设置成并行的有效性.

表7 MAM 模块中,注意力模块位置关系的消融实验Table 7 Ablation experiment on the position relationship of attention module in MAM

4 结束语

本文提出一种基于语义引导特征聚合的显著性目标检测算法,主要包括混合注意力模块、增大感受野模块和多层次融合模块3 个模块.MAM 能够生成更佳的语义特征,用来指导解码过程中的特征融合,使得聚合的特征能够更好地定位显著物体;ERFM 能够丰富低层特征所具备的上/下文信息,并将增强后的特征输入到MLAM 中;MLAM 利用MAM 生成的语义信息,对当前解码的特征和ERFM 输出的低层特征进行指导融合,并最终以级联方式逐步恢复边界细节,生成最终的显著图.本文与目前流行的10 种算法在6 个基准数据集上进行了实验比较,由可视化图6 可以看出,本文算法能够有效地保留显著物体的空间位置信息,并且边缘也得到了很好细化.实验结果也验证了本文算法具有领先性能.