基于竞争双深度Q网络的频谱感知和接入*

2023-11-25胡垚林

梁 燕,胡垚林,惠 莹

(1.重庆邮电大学 通信与信息工程学院,重庆 400065;2.信号与信息处理重庆市重点实验室,重庆 400065)

0 引 言

随着无线通信技术快速发展,频谱资源的有效利用问题显得尤为重要[1-2]。传统的静态频谱访问机制不能充分利用授权频带,导致频段浪费。在认知无线电网络(Cognitive Radio Network,CRN)中,主要用户(Primary User,PU)拥有使用授权频谱的优先权,当PU不活动时,可以允许次要用户(Secondary User,SU)机会接入频谱[3]。因而,基于CRN机制提出有效的频谱管理策略对于下一代无线通信网络至关重要[4]。

对频谱的有效利用,首先要解决SU对授权频谱的感知问题。目前,使用深度学习(Deep Learning,DL)或深度强化学习(Deep Reinforcement Learning,DRL)完成频谱感知吸引了广大研究学者的注意。文献[5]提出了一种基于长短期记忆(Long Short Term Memory,LSTM)网络的频谱感知,从频谱数据中学习隐式特征,利用PU活动统计信息提高CRN的性能,在低信噪比下检测性能和分类精度都有提高。但是,文中只研究了单个PU和SU的情况,而且性能的提高是以更长的训练时间和执行时间增加为代价的。文献[6]和[7]提出了单个PU多个SU情况下基于卷积神经网络(Convolutional Neural Network,CNN)的深度学习频谱感知算法。文献[8]将CNN和LSTM一起使用来提高分类精度。文献[9]提出混合频谱感知方案,将能量检测、似然比检验和人工神经网络结合,通过在不同信号上的评估,验证所提方案优于经典的能量检测和改进的能量检测,但是存在训练时间长和计算复杂度高的缺点。文献[10]将融合中心作为智能体,使用DRL改善合作频谱感知的性能。文献[11]使用DRL进行频谱感知并对探索与利用进行平衡设置。

频谱感知阶段进行瞬时频谱状态的检测,而动态频谱接入(Dynamic Spectrum Access,DSA)对检测到的空闲频谱完成机会接入。随着DRL技术的不断发展,其在动态频谱接入领域也得到了较广泛的应用。免模型的DRL方法可以处理动态变化的环境,有效适应复杂的实际模型。文献[12]研究基于DRL的动态多信道访问问题。文献[13]使用深度Q网络(Deep Q-Network,DQN)进行动态信道访问和功率控制。文献[14]将DQN用于动态频谱接入,以分布式方式学习适当的频谱访问策略。文献[15]采用优先经验回放双深度Q学习进行频谱接入,从而提高了系统性能。文献[16]将DQN与进化博弈论结合,提出了一种分布式多用户动态频谱访问的新方法,可以减少次要用户之间的碰撞率,增加系统容量。

综上,现有基于DRL技术对频谱管理策略的研究未能联合考虑频谱感知与频谱接入两个环节,在频谱感知中往往忽略了频谱接入策略对感知结果的影响,在频谱接入中没有考虑频谱感知存在的错误情况。因此,本文在文献[17]的基础上建立频谱感知中存在错误和频谱接入中存在用户碰撞的场景,使用竞争双深度Q网络(Dueling Double Deep Q-Network,DDQN)进行感知和接入问题的完整性研究。竞争DDQN由双深度Q网络(Double Deep Q-Network,DDQN)和竞争深度Q网络(Dueling Deep Q-Network,DQN)优化设计而得,分别利用了两种网络解决过估计问题和学习环境状态真实值的优势。

1 系统模型

假设系统中有M={1,2,…,i,…,m}个PU、N={1,2,…,j,…,n}个SU和C={1,2,…,k,…,c}个信道。假定PU以一定的规则占用一些频谱,SU应该确保在不干扰PU的前提下访问频谱。为简洁起见,不考虑用户的功率控制策略。一般来说,当一个PU占据频谱时,所有SU都不能占用这些频谱,由于硬件和功率限制,每个SU在每个时隙中只能感知一个频谱。SU不知道PU占用频谱的规律,因此需要根据之前的感知结果预测频谱状态。

(1)

频谱感知完成后进行频谱接入。为了成功传输数据,所有SU旨在尽可能频繁地选择空闲频谱。由于频谱切换模式和其他SU的选择未知,因此每个SU每次只能尝试感知和访问不同的频谱,并根据自己的观测尽可能确定频谱模式。通过这种方式,SU可以了解所选频谱处于空闲或繁忙状态,做出是否接入的动作。SU接入后得到回报,回报将反映接入动作的好坏。上述过程重复执行,SU作为智能体,会根据历史学习经验在需要选择信道的下一时间段内预测空闲频谱,进行动态频谱接入。具体模型描述如图1所示。

在无线信道环境中,频谱状态变化描述为部分可观测马尔科夫决策过程(Partially Observable Markov Decision Processes,POMDP)。使用基于学习的方法可以解决POMDP问题。为了完成感知和接入操作,首先要定义深度强化学习的智能体、状态、观测、动作、回报和策略。

1.1 智能体

在CRN中,SU可以在PU未使用频谱空穴时,动态地接入和使用频谱资源,因此将SU作为智能体探索动态变化的信道环境。

1.2 状态

假设每个频谱有两种可能的状态:空闲(用“1”表示)和繁忙(用“0”表示)。“空闲”表示PU未占用频谱(此时PU不活跃),SU可以机会性地访问该频谱;“繁忙”表示频谱被PU占用(此时PU活跃),SU无法访问该频谱。将每个频谱的状态表示为

(2)

所有状态的集合表示为

S={s1(t),s2(t),…,si(t),…,sm(t)} 。

(3)

将每个频谱状态的变化描述为如图2所示的两状态马尔科夫链。图中有两种变化情况:保持当前状态(从0到0或者从1到1)或转移到其他状态(从0到1或者从1到0)。

图2 两状态马尔科夫链

图中p00,p01,p10和p11都是马尔科夫转移概率。将实际无线信道中频谱状态转移过程描述为图3所示。SU应该确保在不干扰PU的情况下访问空闲频谱。一般情况下,当PU占用频谱时,所有SU都不能使用这些频谱。

图3 频谱状态转移过程

1.3 观测

频谱感知中,初始化频谱是空闲或繁忙状态的实际值作为观测数据。

频谱接入中,根据感知结果得到感知错误概率p,因此观测数据是对频谱状态(1-p)的正确反映。因此,将观测定义为

(4)

SU在t时刻进行观测的结果表示为

O={o1(t),o2(t),…,oi(t),…,om(t)} 。

(5)

1.4 动作

频谱感知中,SU选择一个信道的过程就是动作,有几个信道就有几种可选择的动作,但是每次学习只能选择一个动作。

频谱接入中,SU根据频谱感知结果决定保持当前状态或接入频谱,有以下几种情况:

①SU所选频谱是空闲状态,并且没有其他SU选择该频谱,说明SU之间没有碰撞,可以接入频谱,这是DSA最想要达到的状态。

②SU所选频谱被PU占用,此时由于SU感知到的频谱是繁忙状态,因此SU不接入频谱。

③多个SU选择同一空闲频谱,会发生SU之间的碰撞,此时让多个SU都不接入频谱,以此避免发生碰撞情况。

用aj(t)=i表示在t时刻用户j选择接入信道i传输数据(对应情况①),aj(t)=0表示不能接入信道传输数据(对应情况②和③),从而将每个SU的动作表示为

A={a1(t),a2(t),…,aj(t),…,an(t)} 。

(6)

1.5 回报

频谱感知中,根据选择动作获得的状态进行观测和回报的划分。这里的观测是学习到的观测值,也就是一次频谱感知的结果。根据感知结果进行回报的分类,主要有以下几种情况:

1)如果SU执行动作选择了某一信道,得到该信道上的频谱状态是繁忙,那么SU接收信号的计算使用频谱感知模型中的H1。

首先根据PU和SU的位置以及无线信道模型计算PU和SU的距离,在此基础上使用公式(1)第一行求出信号强度(PU信号加噪声信号)。计算检测概率并将这个概率作为阈值,与随机产生的概率值进行对比:

①如果随机产生的概率小于检测概率,观测值就是0,回报值设置为1;

②如果随机产生的概率大于检测概率,观测值就是1,回报值设置为-1.5。

回报为-1.5的设置:将繁忙信道检测为空闲就表示PU未使用信道,此时如果SU接入信道,将会影响PU对信道的使用,这种情况是频谱感知中最不应该出现的,所以设置最低的回报。

2)如果SU执行动作选择了某一信道,得到该信道上频谱状态是空闲,那么SU接收信号的计算使用频谱感知模型中的H0。

因为PU是空闲状态,所以使用公式(1)第二行计算信号强度(只有噪声信号)。计算误警概率,将这个概率作为阈值,与一个随机产生的概率进行对比:

①如果随机产生的概率小于误警概率,观测值就是0,回报值设置为-1;

②如果随机产生的概率大于误警概率,观测值就是1,回报值设置为1。

回报为-1的设置:可用频谱被检测为不可用,这种结果对于之后的频谱接入来说会影响空闲信道利用率,因此设置为一个较低的负值。

综上,将感知信道得到的回报表示为

(7)

频谱接入中,执行动作后根据动作情况获得回报:如果SU选择的频谱是空闲状态,则传输成功,分配正回报;如果SU选择的频谱被占用或者SU之间发生碰撞,则传输失败,回报为零。因此,将接入频谱得到的回报表示为

(8)

得到回报的反馈后,每个频谱状态将根据马尔科夫链改变。在下一时隙SU将感知新的频谱状态进行动态频谱接入。

1.6 策略

频谱感知中,只要感知结果正确,得到的回报就是1。频谱感知的目标是尽可能得出正确的检测结果,在有限时间内对所有感知结果进行累加,累加和越大,说明感知越准确。为方便计算,对累加结果求平均,得到频谱感知正确率。

这一评判指标的计算与平均累积回报的计算方式相同。定义Mi(t)为在时间T内感知的总次数,因此,在时间T内每一次正确感知对总感知的贡献为1/Mi(t),所以感知正确率的计算与回报函数的计算公式相同,定义为

(9)

有限时间T内平均累积回报定义为

(10)

频谱接入的目标是提高频谱利用率,而利用率与选择空闲信道的频率相关,因此将DSA的目标转变为最大程度地增加选择空闲信道的频率。同样使用上述推导过程,将DSA的目标转换为最大化公式(10)中的回报。

综上所述,频谱感知和频谱接入的目标都是最大化式(10)中的回报。找到最优策略π*:S→A就能最大化回报,常用的方法是使用深度强化学习通过计算最佳Q值找出π*。因此,接下来将进行深度强化学习方法的比较,选择一个最佳方法。

2 竞争DDQN框架

通过结合深度学习和强化学习得到的深度强化学习为解决策略相关问题提供了有效思路。DQN利用经验回放机制将历史状态、动作、回报以及下一状态的数据存储在经验回放池中,训练时随机抽取部分数据,消除数据相关性和依赖性的同时减小了值函数估计中的偏差。另外,DQN构建了两个结构相同的网络(当前网络和目标网络)来计算当前Q值和目标Q值,但是使用max函数可能会导致训练目标选择过高的估计值,造成过估计(最终得到的算法模型与实际效果有很大偏差)。

DDQN可以解决过估计问题。与DQN直接在目标Q网络中找各个动作的最大值相反,DDQN使用两个参数不同的网络模型,先在当前网络中找出最大Q值对应的动作,然后利用这个选择的动作在目标网络中计算目标Q值,完成对动作选择和值估计的分开计算,使过估计问题得以解决。

为了进一步提高算法稳定性,竞争DQN对神经网络内部结构进行改进,将动作-状态值分为两部分计算,最后合在一起得到每个动作的Q值,这个值是智能体学到环境状态中的真实值。

综上所述,DQN倾向于选择过高的值,使性能有偏差,DDQN可以解决过估计问题,竞争DQN使算法更稳定。因此设计将竞争DQN和DDQN结合的竞争DDQN,通过优化神经网络结构保证算法的稳定性,使智能体学到更加真实的值。

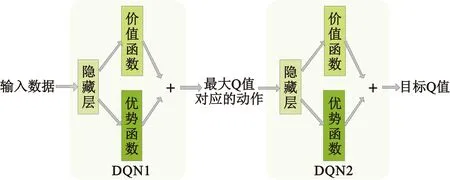

竞争DDQN的结构如图4所示。将竞争DDQN使用的两个神经网络分别定义为DQN1和DQN2。在每个神经网络中加入两个子网络,分别为价值函数网络(用于计算环境本身的价值)和优势函数网络(用于计算选择某个动作带来的优势值)。对价值函数和优势函数的值进行线性组合得到DQN1的输出。DQN1用于选择最大Q值对应的动作,将得到的动作作为输入数据送入DQN2,DQN2使用和DQN1同样的网络结构计算输出目标Q值。

图4 竞争DDQN结构

基于竞争DDQN的频谱感知和接入过程如图5所示,左边是遵循马尔科夫转移过程的信道环境,右边是竞争DDQN。在学习过程中,SU作为智能体在状态s下选择执行动作a,获得回报r并更新状态为s′,将这些数据以(s,a,r,s′)的形式存储到经验回放池中。

图5 基于竞争DDQN的频谱感知和接入

当回放池中有足够的经验样本时,随机提取批量样本,根据状态-动作对计算当前网络中的Q(s,a;θ)值并更新损失函数中的网络模型参数θ-,SU根据更新后的目标网络Q(s′,a′;θ-)值基于状态s′为下一时间步选择动作a′。在频谱感知阶段,SU选择一个频谱进行检测;在频谱接入阶段,SU分析频谱状态。如果频谱空闲,SU可以进行接入并传输数据;如果频谱繁忙,表明此时PU正在传输数据,SU必须重新感知频谱进行接入。重复执行上述过程,完成不同时隙上的频谱感知和接入操作。

竞争DDQN的频谱感知和接入过程如下:

输入:频谱状态数据S={s1(t),s2(t),…,si(t),…,sm(t)}

输出:回报数据R={r1(t),r2(t),…,ri(t),…,rm(t)}

1初始化参数:经验回放池大小D,存储经验样本的最大值M

2初始化网络:当前Q网络和目标Q网络

3 for(inti=1;i<=1000;i++),do://使迭代次数从1到1 000

4 for(intj=1;j<=n;j++),do://对于每个次要用户做循环

5执行感知频谱,得到感知结果

6执行频谱接入

7获得oj,aj,rj,oj+1

8存储(oj,aj,rj,oj+1)到经验回放池,当样本足够时开始训练

9随机提取批量样本(oj,aj,rj,oj+1)进行训练

11梯度下降算法更新损失函数中的网络模型参数yj′←(yj-Q(oj,aj,θ))2

12每隔一定时间步重置Q′←Q

13根据Q值计算回报值大小

14 end

15 end

3 仿真分析

3.1 参数设置

系统模型的详细参数如表1所示。在无线网络环境中,假设有9个SU和8个PU,信道个数设置为8确保每个PU至少有一个信道可以使用。信道状态有两种,分别是0和1。

表1 系统模型详细参数

由于多数许可频带的利用率低,即信道处于空闲状态的概率大,因此p11的值应该高,而p00的值应该低。所以分别从[0.7,1]和[0,0.3]上的均匀分布中随机选择每个信道的状态转移概率p11和p00,然后计算出相应的p10=1-p11和p01=1-p00。

在深度强化学习中使用经验回放可以存储先前的观测数据,并打破数据样本间的相关性,使训练稳定收敛[19]。因此,将经验回放技术用于DQN、DDQN和竞争DDQN并在TensorFlow中实现。竞争DDQN的最终参数确定为一个全连接的神经网络,其中两个隐藏层包含200个神经元。每个神经元的激活函数采用线性整流函数(Rectified Linear Unit,ReLU),计算公式为

f(x)=max(x,0) 。

(11)

应用贪婪策略将随机动作探索概率设置为0.95。当更新神经网络的权重时,从经验回放池中随机抽取10个训练样本计算损失函数,使用自适应矩估计(Adaptive Moment Estimation,Adam)算法更新权重。网络参数的详细信息如表2所示。

表2 网络参数详细信息

3.2 数据生成

训练使用的数据主要是频谱状态数据,是根据文献[17]中的方法生成的,该方法同样在其他基于深度强化学习的文献(比如文献[18])中使用。

信道状态数据产生过程如下:

1初始化 SU数量为N,信道数量为M,总时间为T

2初始化 信道状态数据为0或1,信道状态转移概率为p00和p11

3循环 信道数量从1到M:

4 循环 时间从1到T:

5 对比下一时隙保持当前状态的概率和服从均匀分布的随机采样得到的概率

如果前者大于后者,则保持当前状态;反之,状态改变,更新状态

6 结束循环

7结束循环

根据状态转移概率p11和p00,可以获得频谱状态切换过程。频谱在不同时隙部分状态变化如图6所示,黑色表示频谱在相应时间上是空闲的,白色表示频谱被占用。

图6 频谱状态变化情况

3.3 仿真评价指标

首先是深度强化学习方法的Q值对比(由于DDQN和竞争DDQN方法计算Q值的过程相同,因此这里只对比了DQN和竞争DDQN方法),然后是损失值对比(只有在使用强化学习方法时才会有损失值的计算,因此这里对比了DQN、DDQN和竞争DDQN方法),最后是平均累积回报值的对比(用于衡量感知正确率)。随机接入是作为频谱接入的基准方法加入的。

3.4 仿真结果与分析

图7给出了DQN和竞争DDQN的Q值数据。由于DDQN和竞争DDQN用到的Q值计算方式相同,所以这里只对比竞争DDQN和DQN的Q值。

由图7可知,随着迭代次数的增加,Q值逐渐稳定。竞争DDQN的Q值始终比DQN的Q值小,这是因为DQN中使用max函数可以快速让Q值向最优目标靠近,但是每次都选择最大的Q值容易导致过估计。而竞争DDQN使用两个不同的网络模型参数进行动作选择和Q值计算,解决了该问题。这里注意,Q值是评估动作的价值,即在某个状态下执行某个动作时得到的奖励。根据贪婪算法选择动作时会以大概率选择奖励最高的动作,因此图中大部分Q值是较大的,而Q值突然变小是因为小概率随机选择动作得到的奖励值较小。

图8给出了几种方案损失值对比。DQN、DDQN和竞争DDQN在迭代到第200次时损失均达到稳定,其中DQN的损失值最大,DDQN次之,竞争DDQN损失值最小,说明竞争DDQN相比于DDQN和DQN预测模型更好。

图8 不同方法的损失值对比

采用感知正确率作为频谱感知问题的衡量指标。根据上文分析,感知正确率的计算与平均累积回报值的计算结果相等。因此,以迭代次数作为横轴,平均累积回报值作为纵轴得到每种方法的平均累积回报值大小。由图9可以看出,随着迭代次数的增加,平均累积回报值逐渐增加并维持稳定,其中DQN方法得到的回报结果波动幅度较大,DDQN次之,竞争DDQN结果最稳定。DQN、DDQN和竞争DDQN的平均累积回报分别为0.94,0.96和0.98。也就是说,DQN、DDQN和竞争DDQN方法用于频谱感知时,正确率分别为94%,96%和98%。因此,本文提出的竞争DDQN在进行频谱感知时得到的平均累积回报值最大且最稳定,即感知效果最好。

图9 平均累积回报值对比

根据图9的仿真结果得到DQN、DDQN和竞争DDQN的感知错误率分别为6%,4%和2%,将这三个数据作为动态频谱接入时对频谱进行观测的错误率。图10以随机接入策略为参考基线,对比解决DSA问题时不同接入策略的回报值。其中随机接入策略指没有学习过程,SU在每个时隙开始随机选择频谱,所有频谱的访问概率均相同,由于没有关于信道状态的预测,因此获得的回报最低。图10所示的平均累积回报分别为0.81(随机接入),0.88(DQN),0.89(DDQN)和0.92(竞争DDQN)。从图中看出,相比于DQN和DDQN,竞争性DDQN的回报值最高且最稳定,因此对信道的利用率更好。

图10 平均累积回报值对比

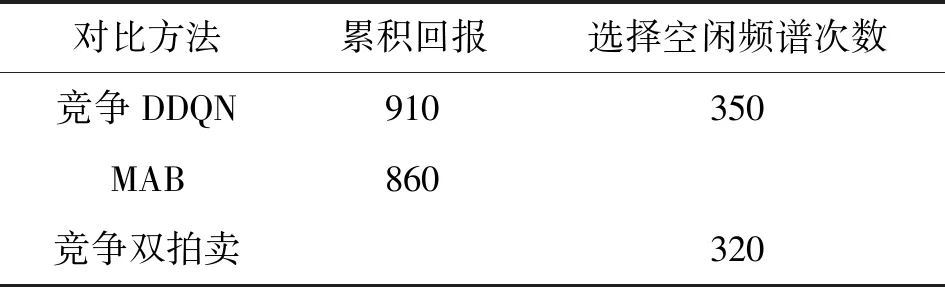

此外,还将本文使用的竞争DDQN方法与多臂老虎机(Multi-armed Bandits,MAB)和竞争双拍卖方法进行对比,对比结果如表3所示。从表中可以可出,对于MAB和竞争DDQN,两者时间复杂度相同,但是竞争DDQN的累积回报更高,所以本文方法更优。而竞争双拍卖方法时间复杂度虽然低,但是它需要信道环境的先验知识,而且信道利用率也没有竞争DDQN高,所以综合对比得到竞争DDQN是MAB和竞争双拍卖中最优的方法。

表3 三种方案对比

4 结束语

对于认知无线电网络中的频谱感知和频谱接入问题,本文首先建立了多用户多信道的存在感知错误和接入碰撞的信道模型,然后设计了一种既能使网络结构优化又能解决过估计问题的竞争DDQN方法,使用该方法完成了频谱感知和频谱接入这两个任务。最后通过仿真,验证了相比于DQN和DDQN,使用竞争DDQN方法进行频谱感知时的感知正确率和动态频谱接入时的信道利用率都得到有效提高。

未来将考虑在SU可以感知的频谱数量有限的情况下,在感知频谱的数量和感知结果的可靠性之间进行权衡。另外,本文所提算法的实用效果还需要在实际的公共数据集上做进一步验证。