基于视觉共享的多无人机协同防碰撞方法

2023-11-20赵晓林张启瑞董家呈陈学宏袁金余

赵晓林,张启瑞,董家呈,陈学宏,袁金余

(1.空军工程大学,西安 710051;2.解放军93525 部队,西藏 日喀则 857060)

0 引言

在战场复杂环境中,无人机的位置信息一般是由GPS 或INS 信号提供[1]。基于GPS 信号(或改进的差分GPS)进行防碰撞的优点在于其精确性,民用GPS 定位的精度可达2 m 之内,军用GPS 定位甚至可达0.5 m,但是受到干扰的可能性很大,如伊朗对于美国无人机的诱骗截获事件,其中猜测之一就是设计出假降落指令诱导美国无人机的降落;基于INS 信号的无人机防碰撞,虽然仅用机载陀螺仪进行加速度、速度的累加,得到现在无人机所处位置,不被外界环境所干扰,但无人机的位置误差也被累计,任务时间越长误差越大[2];由于GPS 与INS 两者之间为互补关系,因此,许多学者研究GPS 和INS组合的方式实现位置的精确度量,在此基础上进行防碰撞的研究[3],但需要注意的是,GPS 技术被掌握在美国,无论是军用无人机还是民用无人机,一旦发生战争,这种技术的垄断对于战争的影响可能是压倒性的。国内为突破GPS 技术的封锁,也对全球定位系统进行了深入的研究,自1994—2003 年BOS 北斗一号系统经历初步探索之后,到2020 年计划的30 颗卫星联合组网,实现定位精度10 m 之内[4]。但是由于发展时间短,并未形成普及性的应用,虽然前景广阔,但现阶段在无人机上的应用较为困难。

视觉传感器由于其自身的无源性和高性价比受到广泛关注,无人机可以依靠视觉信息获取到感知范围内的所有编队无人机信息。视觉共享防碰撞任务就是需要将编队中的个体无人机所感知到的视觉信息进行融合,以融合后整体信息的全局最优化,配置每架无人机的行为,达到集群编队最优的目的。

1 视觉共享防碰撞任务概述

图1 为视觉共享防碰撞任务的示意图,主要包括视觉信息采集、云端视觉共享、编队图像融合、防碰撞算法、策略行为执行以及认知发育学习等模块。

图1 视觉共享防碰撞任务示意图Fig.1 Schematic diagram of visual sharing collision avoidance task

当无人机处于障碍环境中时,每架无人机依靠机载视觉传感器感知视觉范围内的环境信息(包括无人机信息、障碍信息以及环境特征信息);将图像信息进行降维之后,上传到云端视觉共享模块中,在其中进行图像的特征提取、图像融合,每个独立的视觉信息在此拼接融合为整体的环境信息;之后在整体的环境信息基础之上,利用防碰撞算法规划出每架无人机的安全防碰撞路径策略;防碰撞策略生成后,通过策略行为执行模块,将策略指令解码为无人机的实际飞行指令,供无人机飞行;每次防碰撞结束之后,对全过程进行认知发育学习,主要学习两方面的知识,即感知-融合认知发育和障碍-策略认知发育,通过大量的仿真实验,不断提高局部感知信息与全局融合信息之间的匹配生成速度,以及障碍模式和防碰撞策略之间的匹配生成速度,更快为无人机规划出防碰撞指令,保证无人机编队飞行的安全。

2 相关要素模型

为研究基于视觉共享的无人机协同防碰撞,首先需要构建相关的要素模型:双目视觉传感器模型、云端视觉共享控制器模型以及独立个体-交联群体映射关系模型。在相关要素模型基础之上,才能进行深入的研究,并以此构建防碰撞算法。

2.1 双目视觉传感器模型

双目视觉传感器就是一种仿照生物双眼感知原理所设计的三维视觉感知传感器,其同时采集视觉传感器1 和视觉传感器2 中的感知图像,通过计算两幅感知图像之间的差异,结合两个视觉传感器之间的位置差异,来计算图像的深度信息,由此得到障碍物距离自身的位置[5]。

双目相机的模型示意如下页图2 所示。考虑空间中的障碍点P,该点在视觉传感器1 和视觉传感器2 中各自的成像记为PL和PR,两个传感器之间的安装距离(即基线)为b,由于传感器基线的存在,导致障碍点在两个视觉传感器中的成像位置是不同的。假设障碍点P 在传感器1 中的成像坐标为uL,传感器2 中的成像坐标为uR。根据障碍点与两个视觉传感器的几何信息(如下页图2 右图所示),ΔPPLPR和ΔPOLOR是相似关系,则有:

图2 双目相机的模型示意图Fig.2 Schematic diagram of binocular camera model

整理可得障碍物距离视觉传感器之间的距离z:

其中,d 为左右视觉感知传感器获得图像信息的横坐标之差,即d=uL-uR。

根据视差可以估计一个像素与相机之间的距离。视距与距离成反比:视距越大,距离越近。同时,由于视差最小为一个像素,于是双目的深度存在一个理论上的最大值,由f *b 确定。可以得知,当基线越长时,双目能测到的最大距离就会越远;反之,小型双目器件只能测量很近的距离。

2.2 云端视觉共享控制器模型

在无人机获取到自身周围环境信息之后,需要将信息上传到云端视觉共享控制器中,由控制器来处理所有获得的信息,完成个体局部信息的融合,形成全局信息,以此来进行无人机编队控制防碰撞任务。

云端视觉共享控制器模型如图3 所示。若无人机将所感知到的所有环境信息上传云端,不仅占用信息带宽资源,也影响视觉共享控制器的效率。在协同防碰撞中,为最优化配置无人机带宽资源,假设其上传的信息仅有两类:1)个体视觉感知范围内的各无人机相对空间位置信息;2)个体视觉范围内的障碍相对空间位置信息。云端视觉共享控制器在接收到这些同步的信息之后,对其进行融合处理,提取出每架无人机上传的信息特征,并将各信息进行拼接,形成整体的环境信息图,可得到云端共享的整体环境图。以此来完成后续基于全局信息的防碰撞策略算法。

图3 云端视觉共享控制器Fig.3 Vision sharing controller on cloud

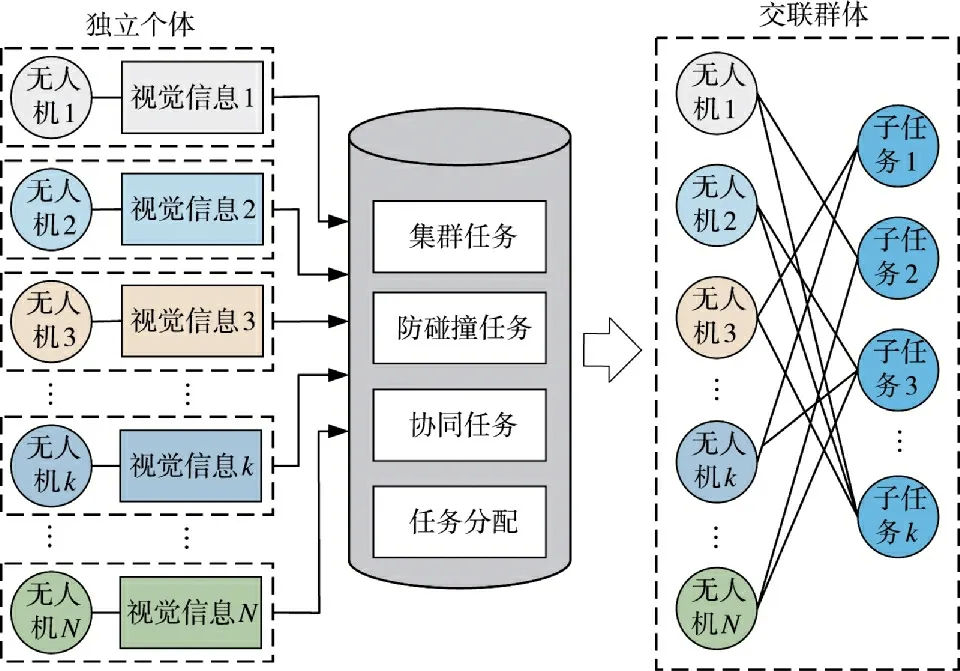

2.3 独立个体-交联群体映射关系模型

群体编队中的无人机是相互交联的,每架无人机之间都有固定的编队关系;同时每架无人机又是相互独立的,需要完成各自的编队跟随、障碍防碰撞等任务。如何在群体飞行过程中,将两者进行统一协调,既保证个体的安全性,又保证群体任务的完成度,是需要进行深入研究的部分。因此,构建独立个体-交联群体映射关系模型,来规划个体与群体之间的协调关系。

如图4 所示,假设每个独立的无人机通过机载视觉传感器所感知到的自身周围信息为对应的局部视觉信息,在对这些信息进行融合的基础上,可以得到基于局部环境信息的全局感知信息,通过集群任务、防碰撞任务、协同任务以及任务分配环节的目的引导,最终形成无人机与子任务之间的交联模型,规划每架无人机对应的任务,从而引导无人机的飞行行为。

图4 独立个体-交联群体映射关系模型Fig.4 Mapping relationship model of individuals-cross linked groups

3 基于视觉共享的多无人机协同防碰撞方法

无人机q 通过机载传感器所感知到的视觉感知信息Iq(x,y,z),其经过特征提取和RGB-HSI 转换后的特征信息为C(Iq)=(Xc,Yc,Zc)。在特征点集(Xc,Yc)任意一点处,其色调、饱和度和亮度在设定阈值范围之内,即:

其中,chmin和chmax为色调的最小最大阈值,csmin和csmax为饱和度的最小最大阈值,cimin和cimax为亮度的最小最大阈值;fh(x,y)、fs(x,y)、fi(x,y)分别为在点(x,y)处的色调函数值、饱和度函数值以及亮度函数值。

如图5 所示,视觉感知特征信息融合拼接的关键主要有两个方面,即保证视觉信息的不变性和保证视觉信息的融合性。

图5 视觉感知特征信息融合拼接示意图Fig.5 Schematic diagram of visual perception feature fusion and splicing

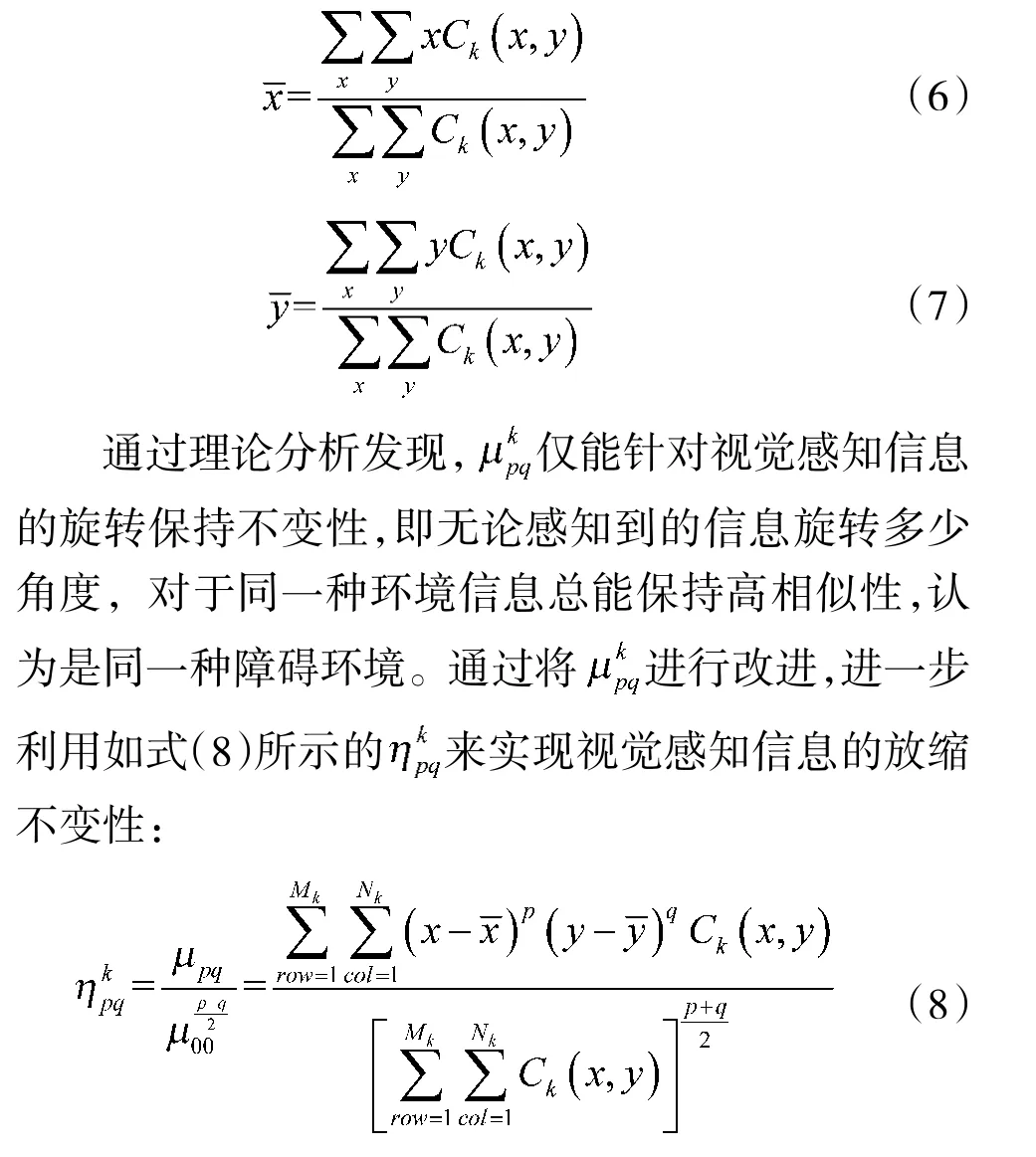

在对于视觉信息的处理中,信息特征的不变性反映了感知信息无论是旋转、放大或者缩小,只要特征一样,均认为是同一特征。这是考虑到无人机在飞行中可能会进行偏航,导致视觉传感器感知到的信息产生旋转,以及感知过程中对于不同距离的障碍进行归一化比较。虽然在同一环境中,但由于无人机的姿态不同、障碍距离的远近不同,形成的视觉信息可能会发生旋转、放缩等[6]。对于特征信息Ck(x,y),定义其(p+q)阶次的导数为:

其中,Mk和Nk表示视觉感知特征信息Ck(x,y)的最大范围,p,q∊{0,1,2,…},分别为特征信息求导的x坐标阶数和y 坐标阶数。

但是C(kx,y)的(p+q))阶次导数仍会随着视觉信息的变化而产生变化,不具有不变性。对于视觉信息,其感知中心的位置一般是固定的,这是由机载传感器所决定的,因此,引入视觉感知中心的参数来对进行改进:

对于任意两个视觉感知信息Ck(x,y)和Cl(x,y),要完成视觉信息的融合任务,如下页图6 所示,关键就是找出两者之间的相似区域并量化进行判断。

图6 视觉信息融合拼接示意图Fig.6 Schematic diagram of visual information fusion and splicing

假设对于不同视觉信息,相互比较的滑动窗口边长为Ltr的正方形,定义在窗口之内视觉信息Ck和Cl之间的相似度为:

其中,sim(Ltr)在窗口Ltr基础上所计算的相似度函数,f(Ck(xa+i,yb+i),Ltr)为在窗口Ltr基础上视觉信息Ck(xa+i,yb+i)所计算的相似度函数值;f(Cl(xc+i,yd+i),Ltr)为在窗口Ltr基础上视觉信息Cl(xc+i,yd+i)所计算的相似度函数值;

将滑动窗口Ltr在各自的视觉信息Ck(x,y)和Cl(x,y)进行遍历,通过计算两者之间差异的最小值,可得最优融合拼接区域:

假设共有N 架无人机参与此次视觉集群编队任务,云端接收到的视觉感知信息共有N 个。将每个视觉信息进行特征提取、不变性判断以及信息融合拼接后,基于个体的局部信息I(x,y,z),形成的全局感知信息为WI(x,y),如图7 所示,可以看出,局部信息是包括障碍距离在内的三维信息,而全局感知信息是以俯视图出现的二维信息,这是由于将个体局部感知到的距离信息转换为了在二维信息上的坐标表示距离。

图7 三维个体局部感知-二维共享全局信息转换图Fig.7 3D individual local perception-2D shared global information transformation diagram

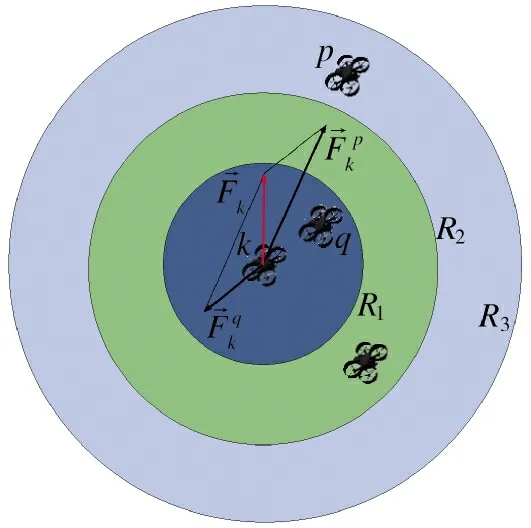

假设无人机可以获取到的全局无人机视觉信息为UWI(如图7 中的黑色无人机),全局障碍视觉信息为BWI(如图7 中的灰色障碍区域)。针对无人机的协同编队防碰撞,由于每架无人机的视觉范围不同,且视觉感知区域内的无人机架数一直处于变化状态(如处于视觉感知边界的无人机,当感知无人机偏转,则可能会感知不到),不能采用定架数无人机编队防碰撞模型。基于视觉共享的无人机编队协同防碰撞,本章采用最近-最远力方法。

假设在全局无人机视觉信息中,无人机k 感知范围内的其余无人机有Mk架,可分别得到Mk架无人机与无人机k 的相对距离矩阵Dk:

为保证无人机相互之间的安全性,需要无人机之间进行防碰撞。无人机对于视觉感知范围内的所有无人机都需要保持安全距离,仅需要无人机k 对于距离自身最近的无人机保持安全距离即可。假设对于任意无人机q∊Mk,若:

其中,min 为取矩阵中最小值。

可以得出距离无人机k 最近的感知范围内的其余无人机为q,其所受到无人机q 的力为:

为保证无人机的协同编队性,需要无人机相互之间的距离不能过远,从而更容易形成紧密编队。此时仅需要无人机k 对于距离自身最远的无人机保持编队距离即可。假设对于任意无人机p∊Mk,若:

其中,max 为取矩阵中最大值。

可以得出距离无人机k 感知范围内最近的其余无人机为p,其所受到无人机p 的力为:

如图8 所示,则无人机k 受到的合力为最近力与最远力之和,即:

图8 最近力-最远力合力示意图Fig.8 Schematic diagram of resultant force of the nearest and farthest force

针对无人机k 视觉感知信息中的障碍,假设该障碍点(xop,yop)为最近障碍防撞点,则无人机k 受到该障碍点对其的斥力Fko为:

其中,β 为障碍物点斥力系数,Dmax为无人机所能感知到的最远障碍距离,即障碍点斥力的最大距离。

在生成无人机的防碰撞策略,即无人机受到的虚拟力之后,无人机并不能直接按照计算出的力进行飞行,此时需要将这种防撞策略转换为能够识别的角度指令,从而最终控制无人机的飞行行为。如图9 所示为无人机控制指令转化示意图,无人机初始受到3 个虚拟力的影响,即最近力、最远力和最近障碍点斥力,其综合形成控制无人机3 个角度(俯仰角、滚转角和偏航角)以及油门大小,这些角度指令高度耦合,将其进行解耦分别形成控制无人机4 个电机指令,最终通过控制无人机电机的转速完成无人机的飞行控制。

图9 无人机控制指令转化示意图Fig.9 Schematic diagram of UAV control command conversion

4 仿真实验与分析

从以下方面来对所构建的算法进行仿真实验与分析,集群中所有无人机的参数设置如表1 所示。

表1 无人机参数Table 1 UAV parameters

4.1 视觉共享控制器仿真与分析

视觉共享控制器主要功能是对特征的不变性判断,以及对单个感知信息的融合拼接形成整体信息。设在200 m×200 m 区域中存在随机运动的20架无人机,每架无人机的感知信息如图10 所示。

图10 各无人机感知信息及其坐标信息Fig.10 Perception information and coordinate information of each UAV

在基于各无人机的感知信息基础上,拟合成全局环境信息如图11 所示。可以看出,个体所感知到的其余无人机信息与融合而成的全局环境信息是一致的,无人机不仅可以上传本机的位置、速度以及偏航角等状态信息,也能上传所感知到的视觉信息到云端的视觉共享控制器中,融合拼接成的全局信息与单机的位置信息相符。

图11 全局环境信息Fig.11 Global environment information

进一步将20 架无人机置于障碍环境中(假设障碍均为的长方形)进行测试。各无人机的视觉感知信息如图12 所示,最终可以融合为障碍环境的全局信息,如图13 所示。可以看出,结合无人机自身的状态信息,在无人机个体环境感知的基础上进行视觉共享融合拼接,能较好地实现对于全局环境信息的掌控,为后续基于全局障碍环境信息的防碰撞提供基础。

图12 障碍环境中各无人机感知信息及其坐标信息Fig.12 Perception information and coordinate information of each UAV in environment with obstacles

图13 全局障碍环境信息Fig.13 Global environment information with obstacles

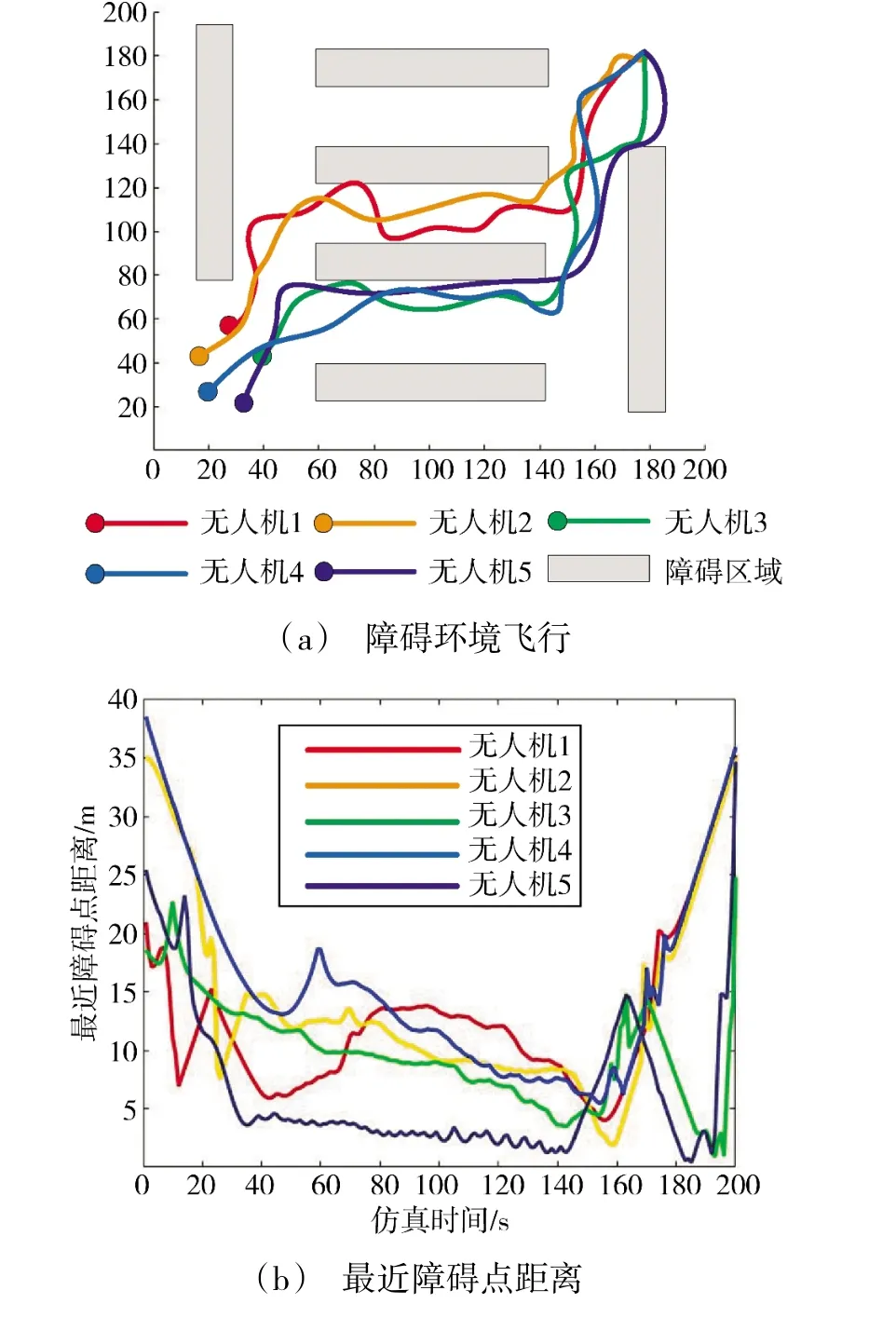

4.2 基于视觉共享的防碰撞仿真实验与分析

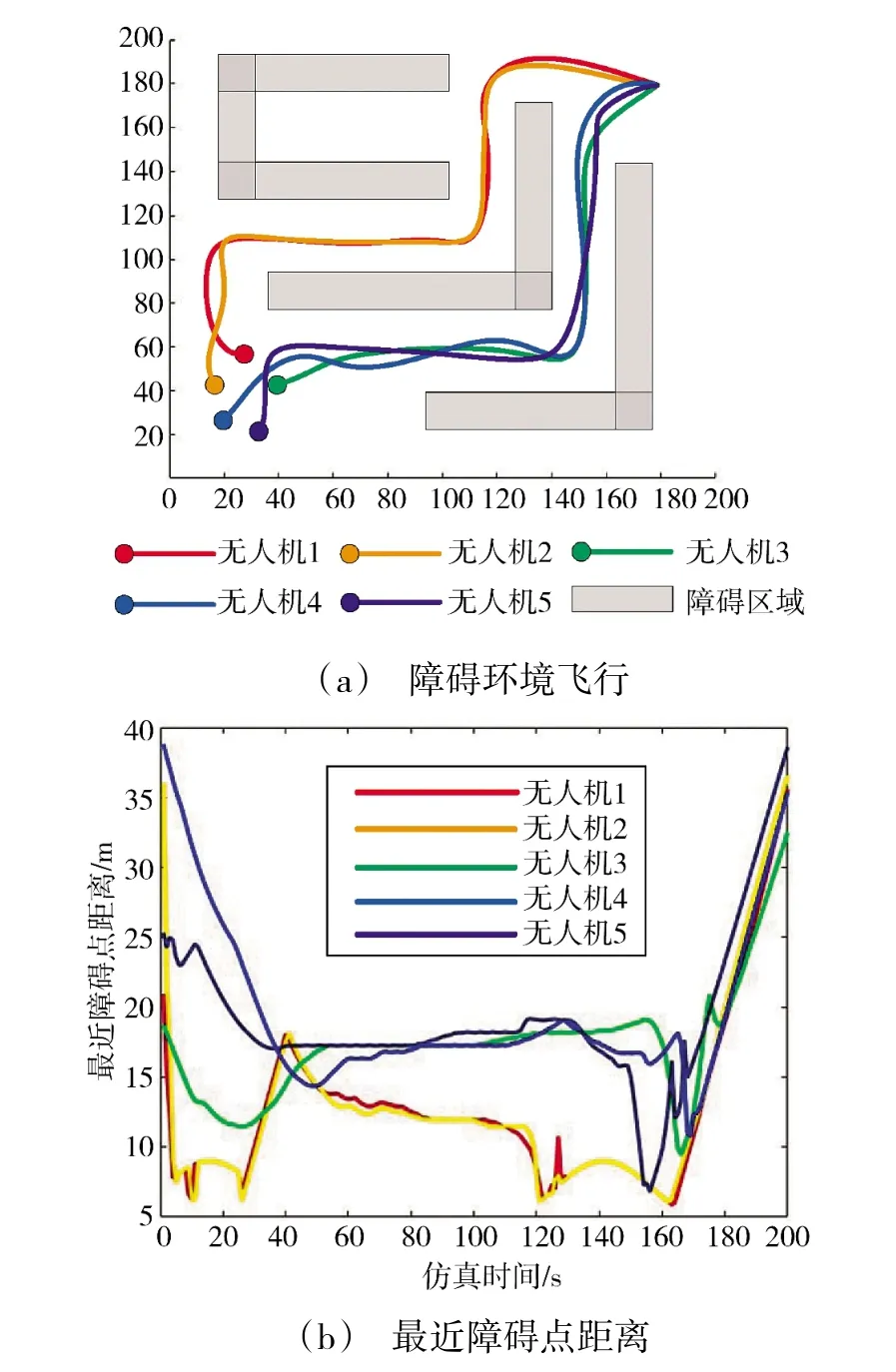

假设有5 架无人机在障碍环境中随机运动,图14~图15 为未应用视觉共享,每架无人机仅依靠自身传感器进行防碰撞的结果图。可以看出,无人机在对视觉感知范围内的障碍进行防碰撞时,会与其余障碍发生碰撞(碰撞时,与最近障碍点距离趋近于0),严重威胁到无人机的飞行安全。

图14 未应用视觉共享仿真实验与分析1Fig.14 Simulation experiment and analysis 1 without visual sharing

图16~图17 为应用本文方法,将所有单机无人机感知到的信息进行融合后,形成整体环境,在此基础上进行的防碰撞。可以看出,与最近障碍点的距离总能保持在一个安全范围(Dmin≥5 m)之上,这是由于其余无人机的感知弥补了单架无人机感知范围的不足。无人机在随机运动的同时,也在对障碍进行着防撞行为,仿照人之间互相协作的思想,利用视觉共享的理念,提高了无人机协同防碰撞的安全性。

图16 应用视觉共享仿真实验与分析1Fig.16 Simulation experiment and analysis 1 without visual sharing

图17 应用视觉共享仿真实验与分析2Fig.17 Simulation experiment and analysis 2 without visual sharing

5 结论

本文考虑实际环境中,无人机视觉感知受限情况下的集群防碰撞,提出基于视觉共享的多无人机协同防碰撞方法。该方法综合利用旋转不变性,放缩不变性以及融合拼接将单架无人机的视觉感知信息综合到一个整体的环境信息中,完成防碰撞策略的制定。下一步将研究三维环境中的视觉共享问题,以及将算法在实际环境中的应用与拓展。