基于深度强化学习的大型活动关键交叉口信号控制

2023-08-23宋太龙贺玉龙刘钦

宋太龙, 贺玉龙, 刘钦

( 北京工业大学北京市交通工程重点实验室, 北京 100124)

大型活动的举办会给场馆周边路网带来具有时段性特点的交通压力,为保证活动的顺利举办,需要对活动场馆周围的路网进行交通管制。交通信号控制作为一种可以在时间以及空间上分配路权的控制方式,设置合理而有效的配时方案不仅可以降低车流的行驶延误,更可以保障区域路网的正常运行,而路网中关键交叉口的高效有序运行又是保证整体路网正常运转的关键[1],当关键交叉口发生拥堵或混乱时,将对周围道路产生负面影响并导致路网通行效率大幅降低,因此针对活动场馆周围关键交叉口的交通信号进行有效控制具有重要意义,活动场馆周围关键交叉口运行状态的优劣不仅影响了大型活动是否可以顺利举办,同时也决定了大型活动条件下路网运行状态的好坏。

相比于日常生活,大型活动举办时期的交通量变化更为迅速,短时聚散现象明显,流量波动大,乘坐公共交通出行需求上升。传统的信号控制方案仅针对各进口道排队信息,没有差异性分析日常出行与大型活动出行的出行特性。

现针对大型活动下的交通出行特征,分析大型活动相关出行者的交通需求,构建以大型活动为背景的场馆路网关键交叉口信号控制方法,在建模过程中,考虑到大型活动的交通运行特点,如短时内人群聚集数量大,搭乘公共交通人数多的特点,通过将信控优化过程中的关键指标从传统的车均延误、停车次数设计为不同出行方式的时间损失,公共交通排队时间等指标,从乘客出行延误的角度出发,在信号配时方案中将保障活动参与者的优先权,并以各进口道排队时间以及交叉口单位时间内的停驶车辆数作为评价交叉口信号配时方案好坏的关键指标,结合三者共同构建以深度强化学习算法-A2C(advantage actor critic)方法为基础的信号控制模型,并将传统的定时控制方法以及其他深度强化学习,如Q-learning、DQN算法作为实验对照组,验证模型的优势。

1 交叉口信号控制研究

随着计算机计算水平以及信息检测技术的提高,目前针对交叉口的信号控制理论研究已经具备了一定的深度,从传统的定时控制发展到基于检测器的感应控制,并逐渐发展到基于实时大数据的自适应控制。

传统的定时控制比较经典的是Webster法、美国的HCM法灯[2];定时控制的方法好处在于可以根据调查得到的历史流量数据,计算不同时段的最优周期以及信号配时并长期产生较好的控制效果。但该方法无法适应短时变化的交通流,且没有充分利用交通流运行的时空规律,导致绿灯时间的空放现象发生。

感应控制相比定时控制更多的是对道路使用情况信息的检测。借助检测器对道路使用情况进行检测,并根据监测数据做出信号灯时长或周期的调整,达到降低交叉口延误的目的。

相比于固定配时和感应配时,自适应交通信号控制方法提高了信号灯的灵活性以及信号控制效率[3],强化学习作为一种可以通过当前环境状态寻求最优控制动作的自适应控制算法,可以很好地通过交叉口的运行状态信息,如交叉口的排队情况、流量大小等,选取应用于下一阶段的最优信号配时,达到降低交叉口整体延误的效果。在自学习算法方面,Q学习算法、SARSA算法是最早一批在交叉口信号控制领域进行应用研究的强化学习方法[4]。宋国治等[5]使用深度Q-learning算法对交叉口进行信号灯配时优化,实验证明,深度Q-learning算法下的信号控制相比于定时控制单车延误更小,绿灯利用率更高;白静静等[6]考虑到SARSA算法在目标选择策略中既考虑新状态下的最优奖励又考虑新状态所带来的风险,因此将其应用于交叉口配时中,结果表明SARSA算法的配时优化效果高于Q学习;李振龙等[7]使用排队消散指数对交通状态进行描述,通过对排队阈值的设计,提高智能体对状态变化的敏感性,达到有效控制的目的。

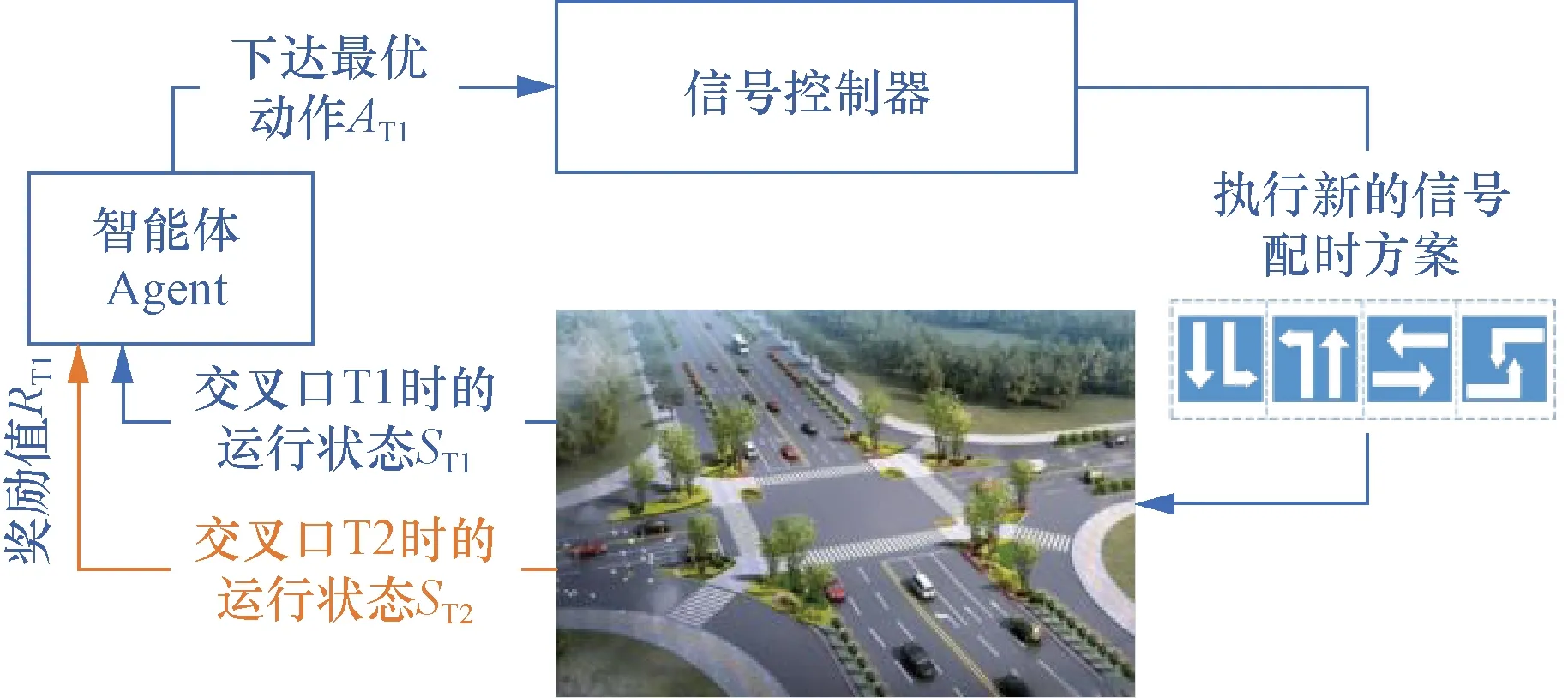

然而,强化学习直接应用于大型交叉口交通信号灯控制会由于环境变化较为复杂导致模型复杂度过高,因此后续研究中逐渐使用深度学习与强化学习结合的方式构建深度强化学习方法[8],达到既可以有效提取交叉口环境的抽象运行状态,又可以准确高效的选取最优动作以进行信号相位以及绿灯时长的优化,强化学习方法应用于信号控制的控制流程如图1所示。

图1 基于强化学习方法的交叉口信号控制流程Fig.1 Signal control flow of intersection based on reinforcement learning method

传统的考虑大型活动的自适应控制方法通常将交叉口内各进口道的检测信息作为环境信息,将车均延误、停车次数以及排队长度作为评价交叉口运行状态的指标[4],并依此建立信号交叉口最优控制模型,求解最优配时方案。贾彦峰等[9]考虑关键路口可能发生的排队溢流现象,提出线轴结合方法优化过饱和交叉口的信号相位,以达到缓解某运行方向排队过长的情况。Li等[10]将交叉口各进口道的队列长度、车辆运行速度定义为状态信息,将车辆的累计延误定义为奖励,构建了基于DQN(deep Q-network)算法的交叉口信号控制方法,实验证明该方法相比为Webster法、Q-learning算法效果更优,车辆延误更低。传统的交叉口优化方案往往以交叉口整体运行效率为目标,在大型活动举办期间,如果仅从各进口道流量进行考虑,不针对分析活动参与者的出行特征以及大型活动相关的车流与社会车流差异性,则构建的信号控制方案是无法适配活动场地周边实际交叉口的出行者通行需求。

2 考虑大型活动特征的A2C信号优化模型

2.1 大型活动交通流运行特征

大型活动场馆周围的路网交通流运行特征变化主要有以下特点:①需求产生时间集中且需求量较大;活动开始以及结束时间场馆周围路网的压力会显著性变化,流量随时间变化曲线如图2所示;②公共交通出行量增加;参加活动的群众以及志愿者普遍采用公共交通作为自己前往活动场馆的出行方式,媒体、部分活动参与者会乘坐活动大客车前往场馆[11];③拥堵存在方向性特征。

图2 流量随时间变化曲线Fig.2 Variation curve of flow over time

2.2 基于A2C算法的信号控制模型构建

A2C算法是在原AC(actor-critic)算法的基础上,对A3C(asynchronous advantage actor critic)算法的改进版本,A3C算法基于异步强化学习思想[12],在原AC算法的基础上加入异步操作,使多个AC结构网络同步运行,但工作组过多导致的内存问题以及环境的初始化不同步,从而使得部分数据存在冗余。A2C算法采用并行架构,每个工作组都会独立的与自己的环境进行交互,且不再依赖于运行效率较低的经验池结构,避免了由经验池抽样不均匀导致的学习经验存在偏置的问题,A2C的算法架构如图3所示 。

Update Collector用于收集参数的更新;Agent为智能体图3 A2C算法架构及交互方式Fig.3 Advantage actor critic algorithm architecture and interaction mode

在本文模型的构建过程中,考虑大型活动背景下出行者数量大且采用公共交通出行的特点,在奖励函数的构建过程中,将公交车、小汽车等车型的等待时间作为参数,其中,将降低公交车出行延误以及等待时间作为主要影响参数;Agent根据当前交叉口环境所提供的各进口道交通状态信息State,执行信号方案,并依据奖励函数的计算值调整动作的执行,以保证智能体在放行方案的选取上实现公交优先,优先满足大型活动出行者的出行需求。

2.2.1 交通状态构建

状态空间是智能体做出动作前可观测到的基础信息,智能体基于状态信息选择最优动作[13]。

因此状态空间的构建应尽可能全面且有效地表示交叉口的运行状态,既要保证信息复杂度较低,也要保证信息的有效性较高,复杂多变且冗余信息较多的状态空间会导致算法无法高效运行[14]。

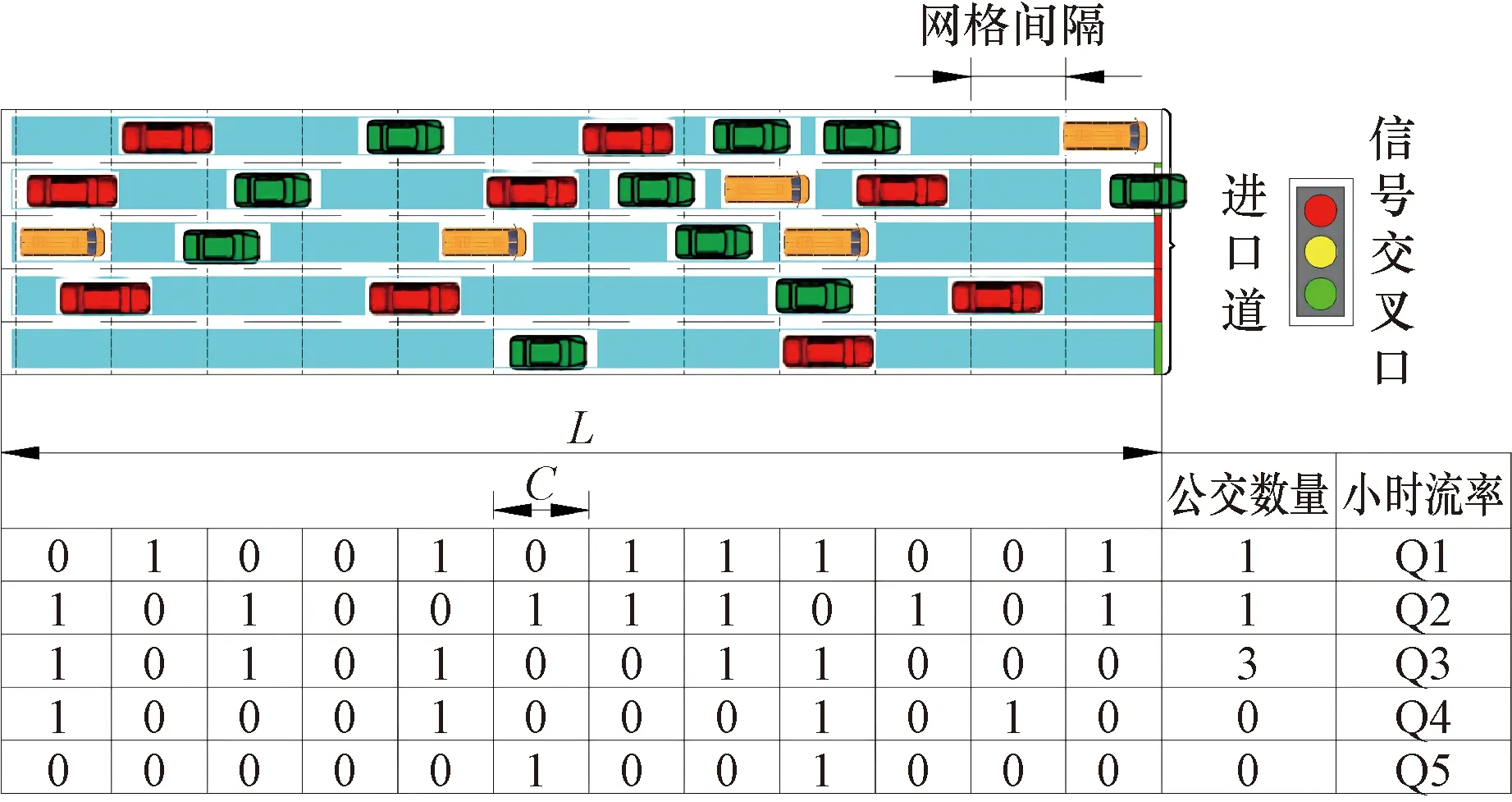

在状态空间的构建中,状态信息在传统的各进口道流量信息的基础上,将各车道的排队情况以及公交车数量考虑在内;状态矩阵构建由以上信息组成,状态空间大小m(2+L/C),其中,M为车道数,L为检测区域长度,C为网格长度,检测网格内存在车辆即为1,否则为0,本文实验中,进口道车道数为22,检测区域长度为60 m,网格长度5 m,状态空间大小22×14。状态空间示意图如图4所示;相比于直接以照片形式将交叉口图像信息作为状态描述的方式更能有效降低状态复杂度,达到降低数据维度、去除冗余信息,加快模型收敛的目的。

Q1~Q5为每车道的小时流率图4 状态空间示意图Fig.4 Schematic diagram of state space

2.2.2 动作空间构建

为保证信号控制过程中满足行人过街时长以及减少绿灯时间设置不合理情况的发生,对模型中交叉口最小绿灯时间以及最大绿灯时间进行约束,从而减少频繁切换相位导致的非稳态交通系统情况发生。

基于强化学习的信号控制中动作主要设为以下两种。

(1)切换相位。将动作空间设置为{0,1},即智能体通过选择是否切换相位作为动作达到对交叉口信号时长的控制,动作的选择往往间隔一定时长[15]。

(2)调整绿灯时长。将信号灯各相位的时长默认为最小绿灯时间,智能体通过对当前相位绿灯时间是否延长t秒作为动作的选择[16],即该相位绿灯时间增加t秒或维持不变,且绿灯时长最大不能超过最大绿灯时间。

本文中智能体的动作设置为对当前相位绿灯时长的调整,进行如下设计。

(1)动作空间由信号放行相位组成,其大小={phase1,phase2,phase3,phase4},当该相位绿灯时间达到最小绿灯时长时,Agent进行动作选择,并从4个信号相位中选择一个放行相位,若与当前放行相位一致,则持续时间1 s;智能体下一动作选择为1 s后[17];

最小绿灯时间Gmin的计算公式为

(1)

式(1)中:LP为人行横道宽度;VP为满足行人过街的平均速度;I为绿灯间隔时间。

(2)当显示绿灯时间不足最小绿灯时间时,智能体无法采用动作将信号切换至下一相位;当显示绿灯时间达到最大设计时长时,强制切换值下一相位。

(3)切换相位时,进行3 s的黄灯显示,并重新判定当前绿灯时长是否满足最小绿灯时间。

将动作空间设置从切换相位与否修改为连续性的调整绿灯时长,虽然增加了模型复杂度,但是提高了绿灯时间的利用率。

2.2.3 奖励函数构建

奖励函数是指智能体在观测交叉口交通状态并根据状态信息采取动作后得到的反馈值[18],即交叉口信号配时变化产生影响的一个判定值,该值用于判定当前交通状态下采用该信号相位的一个好坏程度,在强化学习处理交叉口信号控制的问题中,奖励函数通常选择累计等待时间、累计延误、某一主要进口道的延误、实际车速与车道限速的差值或停车次数等指标。

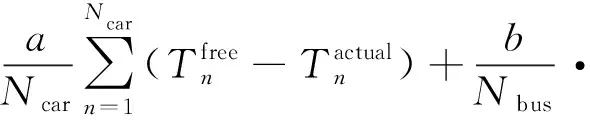

考虑到大型活动举办过程中,活动参与者大多数采取公共交通且需要保证参加活动的准时性的特点,因此对关键交叉口进行信号优化控制建模时,针对奖励函数进行如下设计,奖励函数的指标包括不同车型的平均损失时间,公交排队等待时间、各进口道停驶车辆数、交叉口总延误等[19]。

考虑出行者不同车型的平均损失时间Dp计算公式为

(2)

(3)

单位时间内停驶流量计算公式为

(4)

交叉口总延误计算公式为

(5)

2.2.4 动作选择策略

智能体在动作选择过程中,通常根据Q值,采用贪婪算法以保证每次智能体都会选取到以获取奖励更多为目的的动作[20],但仅采用贪婪算法可能会导致算法迭代过程中动作的选择方案陷入局部最优解。

针对此情况,采用动态ε-greedy策略,在动作的选择过程中,将智能体随机选择下一阶段信号相位的可能性定为ε,将选取当前最优信号相位的可能性定为1-ε,且随着迭代次数的增加,ε值逐渐减小,即为保证训练过程中不会陷入局部最优解,智能体会随着迭代次数的增加,随机选取信号方案的概率降低,选择可以获取更多奖励值的信号相位的可能性增大。计算公式为

(6)

式(6)中:εm为下一仿真步中,动作选择时的随机探索概率;εmin为根据经验设置的最小值;εcurrent为当前仿真步中动作选择时的随机探索概率;m为当前仿真步数;M为总仿真步数。

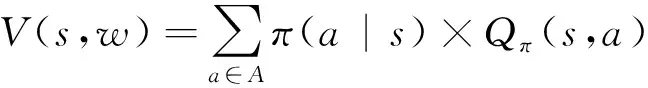

算法引入优势函数思想,优势函数计算公式如式(7)所示,通过对比动作价值函数Qπ(s,a)计算的值与状态价值函数Vπ(s)值的大小,评价Agent采用当前信控相位相比于其他信控相位的优势大小,带有神经网络的动作价值函数Q(s,a,w)以及带有神经网络的状态价值函数V(s,w)计算公式如下。

Aπ(s,a)=Qπ(s,a)-Vπ(s)

(7)

Q(s,a,w)≈qπ(s,a)

(8)

(9)

(10)

算法的损失函数为

(11)

式(11)中:LA2C(w)为A2C算法的损失函数;v(st,w)为使用神经网络计算的t时刻的状态价值函数值,使用梯度下降更新参数w。

3 仿真实验和实验结果

3.1 案例分析

选取SUMO(simulation of urban mobility)软件作为交通仿真的搭建平台,通过设计道路网络模块及构建交通需求模型,并借助Traci接口进行检测器设计以及算法交互,完成仿真实验的设计。本文以北京市海淀区首都体育馆为活动场馆选取周边大型交叉口构建仿真实验场景。

3.1.1 交叉口进口道分布情况

以中关村南大街与西直门外大街辅路所构成的交叉口为实验场地,交叉口渠化情况如图5和图6所示。该交叉口为典型的四岔结构,东西向与南北向同为5进口道,4出口道的配置,其中东西向左转专用车道与直行车道以及右转专用车道比例为2∶2∶1;北进口道在临近路口停车线时最右侧借助道路拓宽手段增加右转空间,为简化模型,左转专用车道与直行车道以及右转专用车道比例设置为

图5 首都体育馆周边交叉口实景图Fig.5 Real scene of intersection around Capital Gymnasium

2∶3∶1;南进口道简化为左转专用车道与直行车道以及右转专用车道比例为2∶3∶1;各方向进口道车道分布情况如表1所示。

表1 交叉口进口道车道分布情况Table 1 Lane distribution of entrance road at intersection

3.1.2 各进口道流量特征

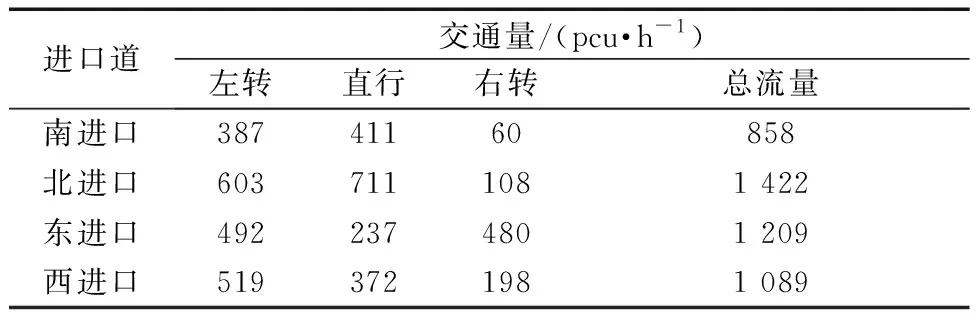

为保证实验具有一定的实际意义且不受疫情封控及其他管控因素的影响,选取2019年西直门外大街-中关村南大街交叉口高峰时段实际调查流量作为输入,流量调查表如表2所示。

表2 交叉口实际调查交通量Table 2 Actual investigated traffic volume at intersection

3.1.3 现状基础信号配时

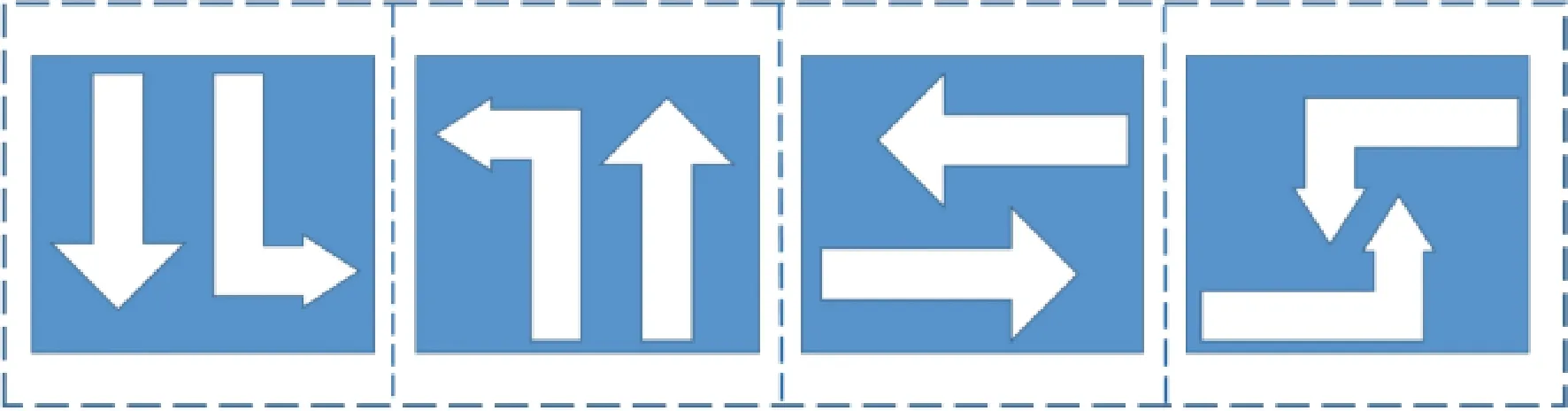

选取晚高峰(17:00—19:00)时段对交叉口信号灯配时进行调查,现状配时方案如表3所示。交叉口初始信号相位如图7所示。

表3 中关村南大街-西直门外大街辅路交叉口现状信号配时方案Table 3 Current signal timing scheme of Zhongguancun South Street-Xizhimenwai Street Auxiliary Road intersection

图7 交叉口信号相位示意图Fig.7 Phase diagram of intersection signal

3.2 设计及仿真结果分析

本文算法参数设计如表4所示。

表4 实验参数设置Table 4 Experimental parameter settings

为验证本文模型的准确性以及有效性,本文分别选择不同类型的信号配时作为对照试验,对照试验组如表5所示。

表5 对照实验组Table 5 Control experimental group

单次仿真步为100 000个时间步,共计200万仿真步。针对不同方案的仿真实验,实验结果如图8~图12所示。

图8 所有实验迭代过程中奖励收敛情况Fig.8 Reward convergence in all experimental iterations

由图8可知,无论是收敛的效率、模型训练过程中的稳定性还是奖励值的获取,本文所构建信号控制方法总是优于DQN算法以及Q-learning算法的控制效果。

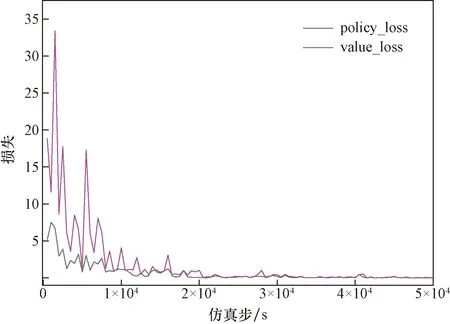

本文算法的policy loss与value loss的收敛过程如图9所示。

图9 基于A2C算法的控制模型值函数与策略函数损失值Fig.9 Loss of control model value function and strategy function based on A2C algorithm

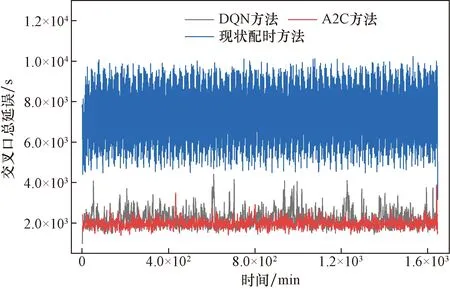

将训练好的交叉口信号控制模型进行测试,以单位时间内(每分钟)交叉口检测区域内的总停驶车辆数以及交叉口各进口道总车辆延误为判定指标,评价各控制方案的优劣性,结果如图10所示。

图10 各控制方案效果对比(以交叉口总延误为指标)Fig.10 Effect comparison of control schemes (with total delay at intersection as index)

本文所构建的模型所产生的行驶延误较小,相比于现状基础配时延误降低约65.7%,相比于DQN算法控制模型交叉口总延误降低约21.4%。

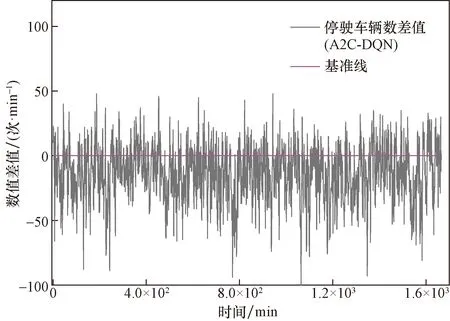

为进一步对比本文模型相比于DQN算法控制模型的性能,将仿真过程中检测器收集的交叉口总延误数据以及每分钟交叉口各进口道的停驶车辆数在时间步上进行差值处理,结果如图11和图12所示,大部分仿真时间内基于A2C所构建的信号控制模型在单位时间产生的延误大小以及停驶车辆数均低于基于DQN算法所构建的信号控制模型,从仿真实验结果数据中将公交车的运行数据进行处理,如图13所示,所有实验组中,本文模型的公交车平均停车次数以及排队等待时间最低,从而验证了本文模型的有效性。

图11 交叉口总延误差值处理情况Fig.11 Processing of total delay difference at intersection

图12 交叉口停驶车辆数差值处理情况Fig.12 Treatment of difference of stopped vehicles at the intersection

图13 公交车运行指标效果对比Fig.13 Comparison of bus operation indicators

4 结论

研究了以考虑大型活动进行为背景的关键交叉口信号控制方法,在构建模型的过程中充分考虑并分析大型活动周边道路的交通流运行规律以及大型活动参与者的出行特征,将以传统深度强化学习为基础的信号控制方法中的控制指标更改为以单位时间内交叉口停驶车辆数为主,不同出行方式平均时间损失以及总延误时间为辅的形式,不仅优化了交叉口的绿灯使用效率,提高了交叉口的运行质量,同时降低了公共交通的出行延误,在一定程度上为大型活动的顺利举办提供了一定的有效措施。仿真实验表明,本文所构建的以深度强化学习方法A2C为基础,考虑大型活动出行特征的方法能有效提高交叉口的运行效率,同时降低了公共交通的延误,有效缓解交通拥堵现象。

但是目前的研究内容仅针对活动场馆的单交叉口,对于活动举办场馆周边的多个关键交叉口的信号协调控制问题,是后续研究的方向。