基于AlphaPose模型的远距离行人头部姿态估计算法

2023-04-29赵思源彭春蕾张云刘海涛胡瑞敏

赵思源 彭春蕾 张云 刘海涛 胡瑞敏

摘要:在公共场所的监控视频中,远距离的行人目标头部区域占比往往较小并且头部区域分辨率较低,仅靠目标检测算法和头部姿态估计模型检测并分类头部特征来判定头部姿态或注视方向存在较大难度.考虑到目前不同分辨率下的人体骨骼关键点估计算法越来越成熟,本研究提出一种利用骨骼关键点和头部姿态之间的关系来进行远距离行人的头部姿态估计算法.该算法首先利用AlphaPose模型检测出二维人体骨骼关键点的全局坐标值,然后根据部分骨骼关键点的坐标值计算出头部朝向象限角度,最后根据预设角度范围计算并可视化出视线落点.目前,尚没有公开发布的可用于远距离行人头部姿态估计的数据集,因此本文建立了一个远距离行人头部姿态系统,以对现有的数据集进行标注,并利用标注的数据集对提出的方法进行测试.结果表明,本文提出的算法可以较精准地判定到远距离行人的头部姿态和注视方向,准确率达到69.7%.

关键词:远距离行人头部姿态估计; 注视方向估计; 人体骨骼关键点检测

中图分类号:TP391.41文献标志码: A

Algorithm for long-range pedestrian head pose estimation

based on AlphaPose model

ZHAO Si-yuan PENG Chun-lei ZHANG Yun LIU Hai-tao HU Rui-min(1.School of Cyber Engineering, Xidian University, Xi′an 710071, China; 2.Artificial Intelligence and Big Data Applications Research Institution, Nanning 530000, China)

Abstract:Pedestrian targets outside the visible distance in surveillance videos of public places have smaller heads and lower head area resolution,it is difficult to determine the head posture or gaze direction only by the target detection algorithm and the head posture estimation model to detect and classify the head features.Considering that the current human skeleton key point estimation algorithms at different resolutions are becoming more and more mature,this paper proposes a head pose estimation algorithm based on the relationship between skeleton key points and head posture for long-distance pedestrian head pose estimation.The algorithm first uses the AlphPose model to detect the global coordinate values of 2D human skeleton key points,then calculates the quadrant angle of the head according to the coordinate values of some skeleton key points,and finally calculates and visualizes the sightline according to the preset angle range.At present,there is no publicly released data set that can be used for long distance pedestrian head pose estimation,so we built a long-distance head pose estimation system to annotate existing data sets.After testing the labeled data sets,the results show that the proposed algorithm can more accurately determine the long-distance pedestrian head pose estimation and gaze direction,with an accuracy rate of 69.7%.

Key words:long-distance head pose estimation; gaze direction estimation; human skeleton keypoints detection

0引言

監控视频给公共场所的安保工作带来了极大的便利,但仍有许多潜在的问题,很多研究者在不同方向对公共场所的监控视频展开研究[1-5].其中,头部姿态估计是一项重要任务,它是指计算机通过对输入图像或视频进行分析、预测来估计头部方向的任务,通过对头部方向的估计可以表达当前行人的注意力方向,来快速锁定目标或敏感区域.

目前,头部姿态估计主要方法可以分为2种:

(1)基于面部关键点的参数化外观模型.基于关键点方法使用面部关键点、几何信息或面部模型来估计头部姿态,首先是获取面部关键点,随后通过PnP算法[6]实现从二维到三维姿态角的回归,构建面部模型与姿态之间的对应关系.基于关键点的方法通常作为上游任务研究,因此,在许多任务中是作为输入的,例如,头部姿态估计[7]、面部对齐[8]等.随着深度学习方法的进步,基于标志点的方法[9,10]也表现出卓越的性能并引起了广泛关注.然而,现有的基于关键点的头部姿态估计方法无法提供高效的性能,主要原因是模型的表达能力欠缺,导致了目前的性能瓶颈.

(2)基于头部图像特征.基于头部图像特征的方法使用头部特征来估计头部姿态,首先是获取头部特征,通过学习分类各个姿态角下的头部特征实现二维图像到三维姿态角转化,构建姿态角特征与姿态之间的对应关系.而基于头部图像特征的方法可以不受角度和面部模型的限制,因此是目前研究的热点.然而,这种基于图像特征的方法需要更高的计算开销,并且需要大量数据来训练网络学习,并且当人物图像在中远距离或者低分辨率情况下并不能很好的进行分类,再者在许多实际应用中,面部关键点仍是多种下游任务的重要中间过程.因此,在多任务应用中,有必要充分利用各种关键点来节省计算量和增加计算的鲁棒性.近年来,使用深度学习技术直接提取各个姿态角的头部特征并进行分类的方法由于其灵活性、准确性及对遮挡和极端姿势变化的鲁棒性的特点,已成为头部姿态估计的主要方法.然而,尽管这几种类型方法[3,11]在其不同的图像数据特征中表现出很好的学习能力,但在监控视频质量参差不齐时,尤其是当行人目标处于远距离时,无论是基于脸部关键点和头部特征的准确率都会下降.

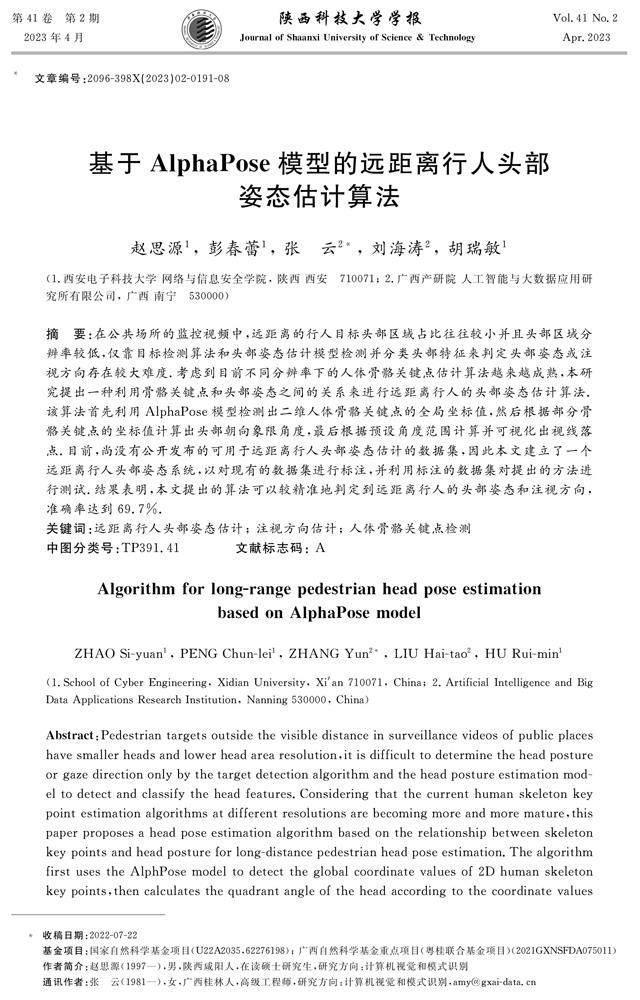

如图1所示,使用深度学习方法直接获取头部特征进行分类得出目标的三维姿态角,其中蓝色线段表示翻滚角,可以表示当前目标头部朝向,红色线段表示俯仰角,绿色线段表示偏航角.图1(a)选用BIWI[12]中部分数据集可视化结果,在近距离面部特征充足时可以准确估计头部姿态,但当面部特征不足时,仍无法判断头部姿态; 图1(b)选用MOT17[13]数据集中监控场景,在远距离场景下,由于面部特征严重不足,导致场景中的面部检测失效,无法像图1(a)中那样准确检测.因此,为在监控视频质量较差和可视距离较短时,快速、准确检测行人目标的头部姿态,本文提出了一种基于AlphaPose[14]模型的远距离行人头部姿态估计算法.随着人体骨骼关键点估计算法越来越成熟[15],所以此算法使用人体骨骼关键点的表示方法来估计头部姿态,来避免图像或视频中部分目标存在头部特征不足的现象,以在远距离外的场景中获得更好的头部姿态结果.

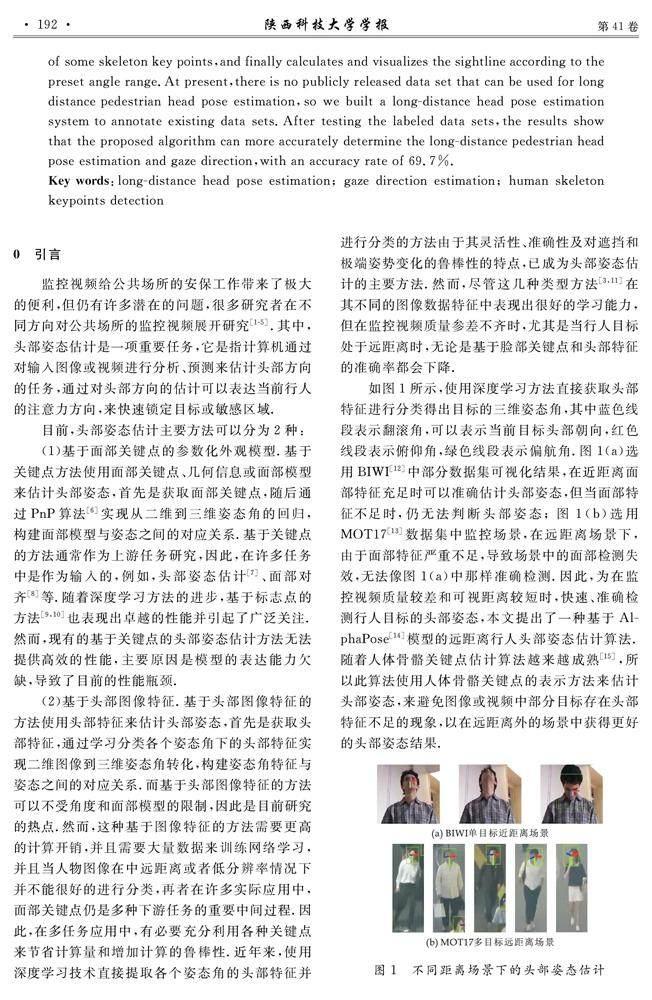

基于这些研究,本文设计远距离的行人头部姿态估计算法,算法流程图如图2所示.该算法基于人体骨骼关键点可以在面部特征模糊情况下很好地估计目标头部姿态.为此,本文所做的贡献如下:

(1)研究远近距离和高低分辨率对姿态估计的影响,并使用本文提出的方法,可以有效解决中远距离和低分辨率图像或视频上头部姿态估计的问题;

(2)提出一种基于人体骨骼关键点直接从图像特征预测头部姿态角的方法,该方法可以直接指示目标当前头部方向;

(3)针对不同场景的头部姿态进行测试,平均准确率达69.7%,验证本文算法的有效性和可行性.

1算法設计及模型原理

本文所提出算法流程,首先利用AlphaPose模型检测出二维人体骨骼关键点,得到其全局坐标值,然后根据鼻部、左右眼部、耳部和肩部关键点的坐标可计算出初始人体面部朝向象限角度,最后本文根据象限角度从预设角度选择,由此得到与坐标系的夹角表示为二维头部姿态角,并于鼻部坐标组成二元组,经过可视化显示头部姿态.

1.1AlphaPose人体骨骼关键点检测模型

人体骨骼关键点对于描述人体姿态,预测人体行为至关重要.基于深度学习的人体骨骼关键点检测方法主要分为2种,即自顶向下和自底向上的检测方法.

(1) 自顶向下方法.以AlphaPose为代表,是一种多阶段的检测模型,首先进行目标检测,识别出图像中所有人体目标,然后对人体目标的每个部位进行关键点检测,最终计算出每个人的姿态.目前,这种方法达到了极高的准确率.

(2) 自底向上方法.以OpenPose[16]为代表,是一种两阶段的检测模型,首先进行关键点检测,识别出图像中所有类别的人体关键点,然后对这些类别关键点进行聚类处理,将同一人的不同关键点连接在一起,从而聚类产出不同的个体.目前,这种方法处理速度快,但在两阶段中都容易受到背景的干扰,检测精度较低.AlphaPose在COCO[17]数据集上的平均精度均值(mean Average Percision,mAP)实现了75%mAP,在MPII[18]数据集上达到了82.1%mAP,而OpenPose只达到了62%mAP和75.6%.为了保证头部姿态算法的可靠性,本文算法在AlphaPose人体骨骼关键点的高精度基础上,进行头部姿态估计算法的设计工作.本文使用其中的7个关键点,分别是:左眼睛、右眼睛、鼻尖、左耳、右耳、左肩及右肩.

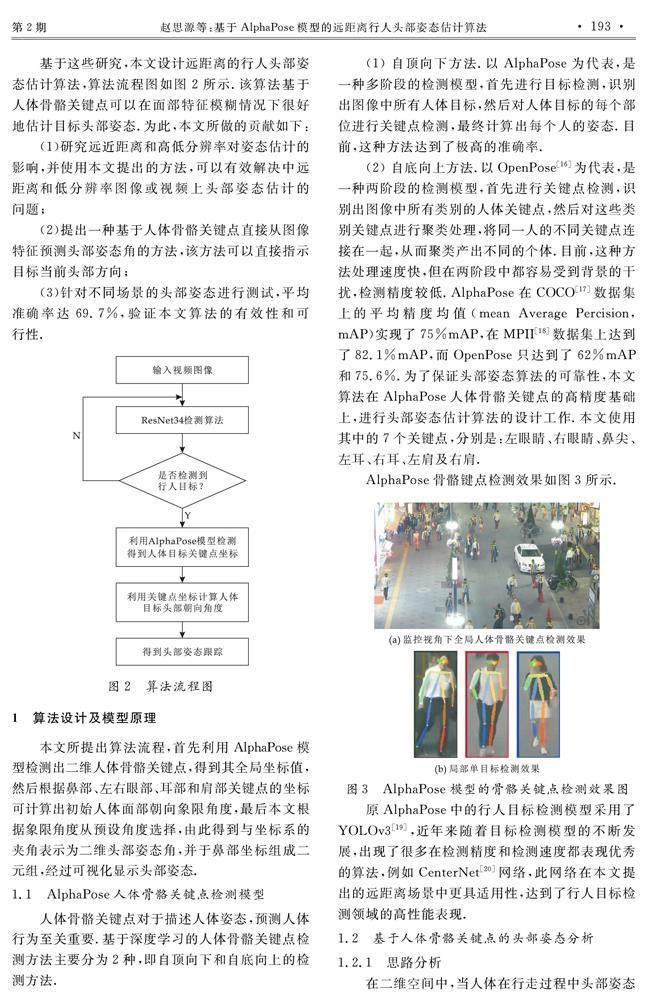

AlphaPose骨骼键点检测效果如图3所示.

原AlphaPose中的行人目标检测模型采用了YOLOv3[19],近年来随着目标检测模型的不断发展,出现了很多在检测精度和检测速度都表现优秀的算法,例如CenterNet[20]网络,此网络在本文提出的远距离场景中更具适用性,达到了行人目标检测领域的高性能表现.

1.2基于人体骨骼关键点的头部姿态分析

1.2.1思路分析

在二维空间中,当人体在行走过程中头部姿态发生改变时,随之最明显的特征变化是头部各部分比例变化.基于人体骨骼关键点的头部姿态估计的关键就在于如何利用人体多个关键点之间的全局坐标信息和相对位置信息,从而建立人体头部姿态估计算法将头部姿态估计建模为关键点之间的变化,检测图像中行人头部姿态.因此在远距离下,基于骨骼关键点的头部姿态估计更具有实际意义.

具体包括:

(1)头部姿态象限估计.利用头部五官关键点之间的距离关系,在二维图像下在头部转动时,利用头部五官和肩部关键点之间的距离关系,来判断头部姿态的象限角.

(2)头部姿态角度估计.由于视频中行人目标较为模糊导致关键点描述有一定的误差,若是在确定头部姿态的象限角之后设定一个头部转向区域范围,当象限角落入某个区域范围之后,取得这个区域的中值代表这个区域的精确姿态角,这样有一定的鲁棒性,并且在视频中可视化会更具有稳定性.

因此,本文提出的基于AlphaPose的可视距离外的头部姿态估计模型结构如图5所示.

首先将视频分割成帧作为输入,特征提取网络DLA-34(ResNet 34 + Deep Layer Aggregation,DLA-34)依次提取视频帧特征,经过检测头对特征中行人目标进行检测分离,然后输入至AlphaPose模中采用单人姿态估计(Single-Person Pose Estimator,SPPE)依次读取行人目标框进行局部姿态估计,结合全局图像得出全局行人目标姿态估计,最后输入至本文设计的二维图像下头部姿态估计算法中经过头部姿态象限估计(Head Pose Quadrant Estimation,HPQE)和头部姿态角估计(Head Pose Angle Estimation,HPAE)处理得到最终头部姿态估计结果.

1.2.2数据处理

1.2.3头部姿态判定

2实验结果与分析

2.1实验环境与数据集

实验所用硬件环境为NVIDIA RTX2080Ti 11GB GPU×2,Intel(R) Core i7-8 700 K CPU @ 3.70 GHz×12,软件环境使用64位Ubuntu 16.04LTS,并配置Python 3.6、CUDA 10.1及Pytorch 1.7深度学习框架.

由于目标没有公开的关于远距离及低分辨率头部姿态估计的数据集,为了验证本文所提出算法的合理性和有效性,本文选取部分异常行为检测代表性的公开图像及视频数据集综合标注测试.

如图8所示,实验数据为隐藏跟踪数据集[4] (Hidden Following Dataset,HFD)选取8段监控视角下多行人场景视频,每段视频包含多人的完整轨迹(从远或近距离出现到消失),视频分辨率为1 920×1 080,每段视频包含5~8人,一共5人参与视频的采集,包括1名女士4名男士,在行走过程中包含多种头部姿态.

2.2头部姿态标注系统

由于目前没有可用于远距离头部姿态估计的公开数据集,且传统图像标注工具,大多只提供身份框及类别标注,缺乏头部姿态标注的功能,直接使用这些工具会产生大量的人工成本,故本文设计了一种基于Tkinter框架的数据管理及标注工具.如图9所示,设计实现了对图像的存储、身份框及头部姿态估计的标注、标注数据管理等功能模块,简化了直接应用传统标注工具的操作,降低了数据标注工作人员的时间成本,提升了数据标注工作的效率.

2.3实验评价标准

2.4結果分析

在HFD数据集中,选取多行人多路径视频图像片段,因部分数据集视频质量效果较差,故选择视频图像集合1、2、4、8、9、10作为实验测试数据集.本文采用先求的每个视频片段的测试结果,最后,求6次测试结果的平均值作为最终结果,保证实验的可靠性,可视化结果如图10所示.图10HFD部分数据集可视化结果为了进一步评价本文提出的方法,实验设置将多分类划分为多个二分类分别对每个角度进行评估,并且将0 °、-45 °、-135 °、180 °分别作为正例得到的统计结果,然后使用精确率P、召回率R及F0.5分数来综合评估各个角度的准确性.表1所示的实验结果表明,本文方法在HFD数据集上0 °F0.5达到了0.661,-45 °F0.5达到了0.732,-135 °上F0.5达到了0.696,180 °上F0.5达到了0.828.

为了进一步验证本文提出方法的性能,本文在HFD数据集上利用公式(10)计算得综合准确率,其结果如表2所示,在HFD数据集上达到了0.697的平均准确率.

其中,数据集10中结果为0.52,如图11所示,其场景中大多数行人目标均为背部朝向摄像头,故经过AlphaPose模型处理结果中鼻部坐标仅能根据左右耳的坐标确定,因此会存在一些误差,除数据集Video-10之外,大部分行人目标均为正常行走姿态.

为了进一步验证本文提出的方法在公开数据集上的表现,本文将与目前流行的头部姿态估计方法HopeNet[3]和FSANet[11]在不同场景下进行对比.

目前流行的头部姿态估计方法,大部分针对近距离单目标场景,在图8所示的远距离多目标中,因头部特征过少,导致在检测阶段,无法有效检测出头部,因此通过实验得到的统计指标评估较差,故实验只进行可视化结果对比.

如图12所示,其中HopeNet和FSANet将头部姿态可视化为三个方向,蓝色表示头部姿态方向,在可视化中将头部姿态方向表示为当前目标身份的颜色,更有助于和身份跟踪结合分析.

由图12(a)可知,当行人目标处于Video-1场景时,由于距离较远HopeNet[3]和FSANet[11]无法检测出大部分行人目标的头部,进而无法做出有效的头部姿态估计,即使检测出行人目标头部,由于分辨率较低无法得到有效的脸部特征,使得头部姿态估计出现较大的偏差,由HopeNet和FSANet得到的头部姿态角蓝色轴均未正确指向头部姿态方向,而本文的方法是基于人体骨骼关键点计算头部姿态,因此可以有效利用更多的特征信息较准确的估计出目标的头部姿态角.

由图12(b)可知,当行人目标处于Video-2场景时,虽然处于近距离,但由于脸部特征不足,使得HopeNet和FSANet方法无法估计目标姿态角,而本文基于骨骼关键点的方法即使在目标侧面时也可以估计目标的头部姿态角.

由图12(c)可知,当行人目标处于Video-10场景时,目标完全没有脸部特征信息,使得基于脸部特征的HopeNet和FSANet方法完全失效,无法估计目标姿态角,而本文基于骨骼关键点的方法在当前场景中可以保证一定的准确率进行头部姿态估计.

3结论

针对现有头部姿态估计方法对监控视角下中远距离外的行人目标无法检测和错误率高等问题,本文提出了一种基于AlphaPose的远距离行人头部姿态估计模型,首先该模型使用AlphaPose对行人目标进行骨骼关键点检测,然后利用部分骨骼关键点判断头部姿态象限角,最终根据预设角度范围确定行人目标在二维场景下的头部姿态角来实现远距离的头部姿态估计问题.本文还设计了一种集成身份框标注和头部姿态的标注系统,并对隐蔽跟踪公开数据集进行标注并进行实验,在多种场景下进行對比,实验结果表明本文提出的模型在不同场景和不同头部方向下都有较高的检测精度.

参考文献

[1] Kohl P,Specker A,Schumann A,et al.The mta dataset for multi-target multi-camera pedestrian tracking by weighted distance aggregation[C]// IEEE Conference on Computer Vision and Pattern Recognition Workshops.Piscataway:IEEE Computer Society,2020:1 042-1 043.

[2] 周同驰,张毫,瞿博阳,等.基于骨骼特征Hough变换的行为识别研究[J].计算机应用研究,2021,38(12):3 831-3 834,3 840.

[3] Ruiz N,Chong E,Rehg J M.Fine-grained head pose estimation without keypoints[C]// IEEE Conference on Computer Vision and Pattern Recognition Workshops.Piscataway:IEEE Computer Society,2018:2 074-2 083.

[4] Xu D,Hu R,Xiong Z,et al.Trajectory is not enough:Hidden following detection[C]//Proceedings of the 29th ACM International Conference on Multimedia.Chengdu:ACM,2021:5 373-5 381.

[5] 王雨生,顾玉宛,封晓晨,等.基于姿态估计的安全帽佩戴检测方法研究[J].计算机应用研究,2021,38(3):937-940,945.

[6] Murphy-Chutorian E,Trivedi M M.Head pose estimation in computer vision:A survey[J].IEEE Trans on Pattern Analysis and Machine Intelligence,2008,31(4):607-626.

[7] Al Haj M,Gonzalez J,Davis L S.On partial least squares in head pose estimation:How to simultaneously deal with misalignment[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE Computer Society,2012:2 602-2 609.

[8] Yang H,Jia X,Loy C C,et al.An empirical study of recent face alignment methods[DB/OL].https://arxiv.org/abs/1511.05049,2015-11-16.

[9] Kazemi V,Sullivan J.One millisecond face alignment with an ensemble of regression trees[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE Computer Society, 2014:1 867-1 874.

[10] Bulat A,Tzimiropoulos G.How far are we from solving the 2d & 3d face alignment problem? (And a dataset of 230,000 3d facial landmarks)[C]//IEEE International Conference on Computer Vision.Piscataway:IEEE Computer Society, 2017:1 021-1 030.

[11] Yang T Y,Chen Y T,Lin Y Y,et al.Fsa-net:Learning fine-grained structure aggregation for head pose estimation from a single image[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE Computer Society, 2019:1 087-1 096.

[12] Fanelli G,Dantone M,Gall J,et al.Random forests for real time 3d face analysis[J].International Journal of Computer Vision,2013,101(3):437-458.

[13] Milan A,Leal Taixé L,Reid I,et al.MOT16:A benchmark for multi-object tracking[DB/OL].https://arxiv.org/pdf/1603.00831.pdf,2016-05-03.

[14] Fang H S,Xie S,Tai Y W,et al.Rmpe:Regional multi-person pose estimation[C]//IEEE International Conference on Computer Vision.Piscataway:IEEE Computer Society, 2017:2 334-2 343.

[15] 馬丹,吴跃.基于全局分组策略的对抗训练在人体轮廓点回归中的应用模型[J].计算机应用研究,2021,38(5):1 544-1 549.

[16] Cao Z,Simon T,Wei S E,et al.Realtime multi-person 2d pose estimation using part affinity fields[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE Computer Society,2017:7 291-7 299.

[17] Lin T Y,Maire M,Belongie S,et al.Microsoft coco:Common objects in context[C]//European Conference on Computer Vision.Cham:Springer,2014:740-755.

[18] Andriluka M,Pishchulin L,Gehler P,et al.2d human pose estimation:New benchmark and state of the art analysis[C]// IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE Computer Society,2014:3 686-3 693.

[19] Redmon J,Farhadi A.Yolov3:An incremental improvement[DB/OL].https://arxiv.org/pdf/1804.02767.pdf,2018-04-08.

[20] Duan K,Bai S,Xie L,et al.Centernet:Keypoint triplets for object detection[C]// IEEE International Conference on Computer Vision.Piscataway:IEEE Computer Society,2019:6 569-6 578.

【责任编辑:蒋亚儒】