基于目标熵的特征引导网络显著目标检测

2022-11-23柳欣

柳欣

(山西工程科技职业大学 信息工程学院,山西 太原 030001)

0 引言

显著目标检测的目的是定位图像中最具有价值的部分[1]。对于许多计算机视觉任务比如图像分类、视频分割和目标跟踪来说,显著目标检测是一个十分有效的预处理步骤,因此在计算机视觉领域成了一个不可忽略的研究方向[2-3]。

传统的显著目标检测方法大多基于低层次的线索和人工特征,但是因为缺乏语义信息,传统方法对复杂场景中突出物体的整体结构检测能力有限。近年来,基于全卷积神经网络(FCNS)的方法,由于其对高层语义建模的高能力,被广泛用于显著性检测。段辉军等提出了一种基于模糊神经网络的深度视频预测模型,能够捕捉动态场景的时空统计信息[4]。Wang等提出了一种由金字塔扩张卷积(PDC)和显著性转移感知卷积长短期记忆网络(SSLSTM)组成的检测模型,它能够通过对人类视觉注意转移行为的建模来捕捉视频显著性动态[5]。Chen等提出了一种协同注意连接网络(COSNET),通过协同注意机制来捕获帧间的时间相关性[6]。尽管这些方法已经取得了预期的效果,但这些方法学习的特征通常缺乏以下能力:1)抑制非显著区域,2)检测具有不同外观区域的显著对象。

为了缓解上述问题,引入单尺度卷积和最大池化层来产生深度特征。余龚斌等从卷积神经网络(Convolutional Neural Networks,CNN)中提取多尺度特征,并估计每个图像超级像素的显著性得分[7]。赵浩光等使用两个CNN将超像素的局部估计和全局建议搜索相结合来预测显著性[8]。但是由于显著目标在尺度和位置上都有很大的变化,这些方法所学习的特征由于视场的限制可能无法处理这些复杂的变化[9]。另外为了提取多尺度的上下文信息,张文明等提出了通过几种不同速率的平行扩张卷积实现特征提取[10]。然而,扩张卷积在卷积核中插入“洞”以扩大感受野,这将导致局部信息的丢失,尤其是当扩张率增加时,这个问题被称为“网格问题”。

为了解决上述方法中存在的问题,提出了一种基于目标熵的特征引导网络显著目标检测方法。首先通过包含高级和低级特性的引导模块使前景和背景区域更加清晰,从而抑制具有“类显著”外观的非显著区域。进一步提出了一种多尺度特征提取模块,该模块采用图卷积网络(Graph Convolutional Network,GCN)实现大区域内的密集连接,有助于模型缓解网格化问题。另外设计了一个目标熵损失函数,有效提升了模型的收敛效果。多个复杂场景数据集实验证明了提出方法的有效性。

1 提出的方法

1.1 整体结构

提出的内容感知指导网络(CAGNet)由三个网络组成:(i)特征提取网络,可捕获多尺度上下文特征,(ii)特征引导网络,它利用高级特征和低级特征的性质来引导特征提取,(iii)特征融合网络,可有效地融合引导特征以生成显著图。结构图如图1所示。

图1 本文所提出的CAGNet的总体架构Fig.1 Overall architecture of CAGNet proposed in this paper

1.2 特征提取网络

1.2.1 搜索主干

本研究以CAGNet中不同的预训练模型作为主干模型 ,其中包括VGG-16[8]、ResNet50[9]、NASNet-Mobile[10]和 NASNetlarge[11],其分别表示为 CAGNet-v、CAGNet-r、CAGNet-m和CAGNet-l。

这些主干用于产生不同抽象层级的特征,为了满足显著性检测任务的需要,删除了这些主干中的所有全连接层。在VGG-16中,最大池化层之后的特性无法引入到抽象级别。因此,在VGG-16中的最后一个最大池化层之后使用具有1024个大小为3×3的内核的卷积层来产生新的层。

所有主干的输出特征图都相对于输入图像重新缩放32倍,根据检测目标图像的像素及尺寸大小,从每个主干网取4个层次的特征图。给定大小为W×H的输入图像,这些特征图的空间大小为W 2n×H/ 2n,其中 n=2,3,4,5。每个主干中不同抽象级别所选层的详细信息如表1所示,特征图的大小显示在括号中。

表1 不同抽象级别的选定层信息Table 1 Selected layer information of different abstraction levels

1.2.2 多尺度特征提取模块

显著对象在不同图像中的尺度和位置有很大的差异。由于尺度的可变性,使用单尺度卷积可能无法获得正确的大小。此外,由于位置的可变性,使用金字塔池作为多尺度特征提取器时由于池的规模较大,会导致重要局部信息的丢失。实现多尺度特征提取器的另一种方法是使用扩张卷积,但是会产生“网格问题”。

为了避免稀疏连接并在特征图中的大k×k区域内实现密集连接,GCN利用k×1+1×k和1×k+k×1卷积的组合有效地实现了k×k卷积,与普通k×k卷积相比,其参数数量更少。此外,为了获取多尺度背景信息,本文利用GCN提出了多尺度特征提取模块(MFEM)。这个模块由不同内核大小的GCN组成,可以学习多个抽象级别的多尺度上下文信息。

如图2所示,MFEM采用3×3平凡卷积和k=7,11,15 的 GCN 提取多尺度特征。“#”符号表示图层过滤器的数量,该图显示了N=2的MFEM。然后,将得到的特征图连接起来以形成多尺度特征。

图2 多尺度特征提取模块Fig.2 Extraction module for multiple scale feature

1.3 特征引导网络

通过使用特征提取网络,可以在多个抽象级别上生成多尺度特征。本文使用四种不同层次的特征提取网络来提取多尺度特征,这些不同的层次有不同的识别信息。高级特征由于视场大,所以其具有语义信息和全局信息。因此,这些特征有助于图像区域的类别识别。而低级特征由于视场小,其具有空间信息和局部信息。因此,低级特征的信息有助于更好地定位显著区域。

基于以上观察,提出了特征引导网络,以更好地利用不同层次的识别能力。特征引导网络由多个引导模块组成,这有助于产生更强大的特征用于显著性检测。如图3所示,引导模块由低级引导模块和高级引导模块组成,C表示输入特征映射的通道数量,而#符号表示层过滤器的数量。该模块将低级特征和高级特征作为输入和输出,从而引导出低级特征和高级特征。

图3 引导模块的示意图Fig.3 Schematic diagram of boot module

在显著性检测中,一些不显著的区域可能具有类似显著性的外观,为了应对这一问题,本文利用较低层次的来引导较高层次的特征。在低层次中,特征提取网络由于其较小的视觉而获得更精细的空间信息,缺乏低层线索的高层特征可以利用其低层特征中的细节作为指导,使显著和不显著区域更容易区分。因此,此网络能够通过引导高级别特征的空间信息,增强显著区与不显著区之间的区别,抑制具有显著样貌的不显著区。

在一些复杂的情况下,显著区域可能有不同的外观,给这些外观不同的区域分配前景标签急需解决。由于高级特征具有较大的接受域,且具有较高的语义信息,因此利用高级特征指导特性引导网络中的低级特征。通过在连接的高级和低级特征上应用激励网络可以生成信道权重来对底层特征映射的信道进行加权。利用高级语义信息,可以引导低级特征产生更多的特征,因此,引导模块对多层次的特征提供内容感知的引导,从而使预测更加准确。

1.4 特征融合网络

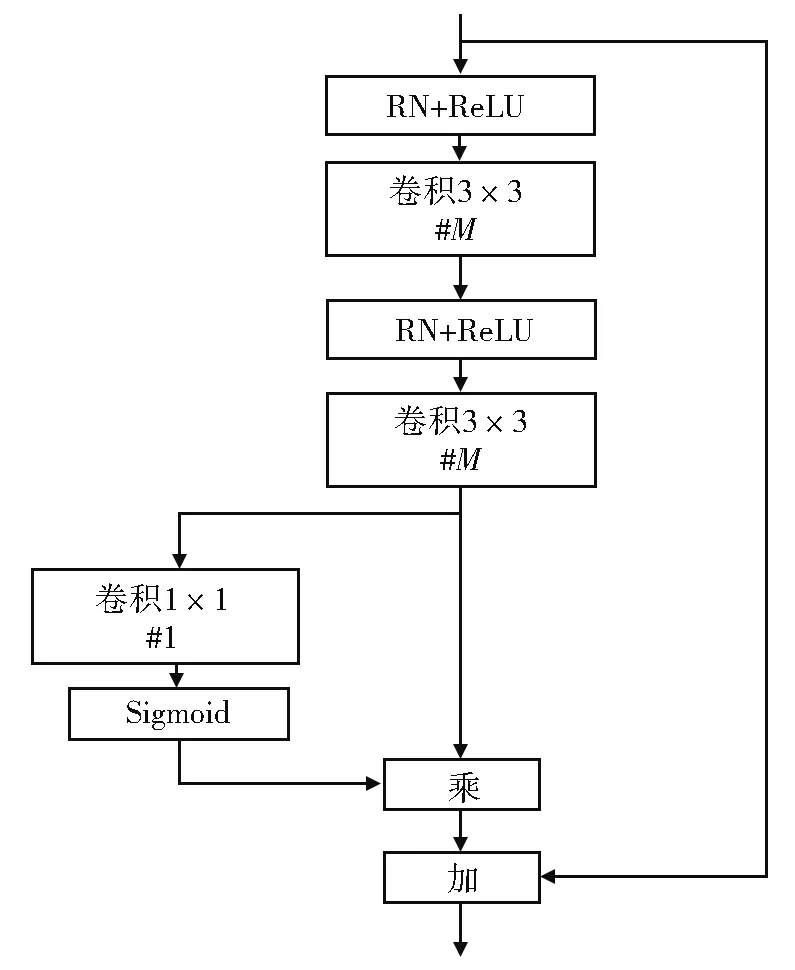

采用特征提取网络和特征引导网络,得到了不同抽象层次的多尺度特征。为了有效地整合这些特征,本文进一步设计了特征融合网络,在该网络中,使用了添加操作来组合不同的特征映射。为了有效地细化这些特征,本文引入了残差细化模块(RRM),如图4所示,“#”符号表示层过滤器的数量。RRM是一个具有空间注意的残差块,该模块用于细化特征,关注显著区域,避免不显著区域干扰。

图4 残余细化模块Fig.4 Residual thinning module

采用多个RRM模块,并在特征融合网络中添加操作,最后利用带有两个1×1核的卷积层,通过softmax激活来得到显著性映射。

1.5 损失函数

在显著性检测文献中,交叉熵损失函数被广泛用于显著性对象的学习。然而,交叉熵损失训练的网络对边界像素的辨识往往置信度较低,导致其性能下降。在本文中,设计了一个损失函数,设 I={Im,m=1,…,M},Sm和 Gm分别为训练图像第m个训练图像的显著性图和第m个训练图像的标准。此设计损失可以写成:

其中 α1,α2和 α3为平衡参数,根据文献[10]中的经验设定:α1=1,α2=0.5和α3=1。LP和 LR可通过式(2)和(3)计算为:

其中P(S,G)和R(S,G)的计算与精度和召回相似:

其中,N为像素总数。在消融分析部分,可以证明本文设计的损失函数优于交叉熵损失函数。

2 实验与分析

2.1 数据集和评估指标

在6个显著性目标检测数据集上对该方法进行了评价。ECSSD包含1000个具有语义的复杂图像,也具有多个不同大小的对象。DUT-OMRON由5168张图像组成,其内容丰富,每一张都有复杂的背景和一两个突出的物体。HKU-IS包含4447张低对比度的图像,其中还包括多个前景对象或触及图像边界的对象。DUTS数据集是目前最大的显著对象检测数据集,包括训练集10 553张图像和测试集5019张图像。PASCAL-s数据集有从PASCAL VOC 2010分割数据集中选择的850幅自然图像。在SOC数据集中,每个显著图像都带有反映现实场景中常见的属性。本文使用该数据集的验证集进行测试。

用6个指标来评估本文的方法的性能,包括 Precision-Recall(PR)曲线,F-measure曲线,平均F-measure(表示avgF)得分,加权F-measure(wF)表示为得分,E-measure(表示为E)得分,和平均绝对误差(MAE)得分[12]。

精度是预测的显著性图中正确显著像素的比例,召回定义为标准的正确显著像素的比例。为了计算精度和召回率,将二值化显著图与标准掩码进行比较。阈值从0到1变化,以生成二进制掩码序列。这些二进制掩码用于计算(精度,召回)对和(f-测度,阈值)对,以绘制PR曲线和F-measure曲线。

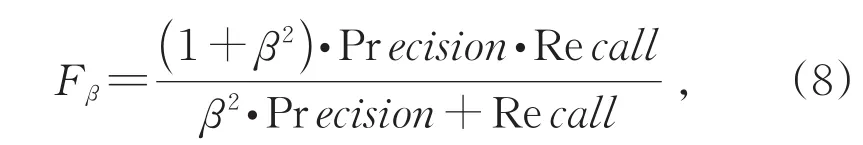

采用文献[13]中提出的阈值法计算F-measure的平均得分。该阈值用于生成二进制映射,用于计算F-measure,F-measure定义为

其中β2设置为0.3时,权重精度比召回率高。采用加权F-measure得分和E-measure得分评估其性能。最后,计算MAE得分作为标准掩码和预测显著性图的像素级绝对差平均值。

使用TensorFlow后台在Keras框架中验证了本文提出的方法。主干模型使用ImageNet权重进行初始化。在此实验中,为了训练和测试,输入图像被均匀地调整为480×480像素。同时为了减少过度拟合,随机使用了两种类型的数据增强:水平填充和旋转。本文使用验证集训练模型,直到训练损失收敛。所有的实验都是使用动量系数为0.9的随机梯度下降法进行,初始学习速率为8×10-3,如果10个时间戳内的训练损失没有得到改善,则将学习速率除以10。本文在NVIDIA 1080 Ti GPU上进行实验。

2.2 对比分析

将提出方法与16种其他方法进行了比较,即 MDF[5]、RFCN[7]、UCF[9]、Amulet[10]、NLDF[12]、DSS[13]、BMPM[14]、PAGR[15]、PiCANet[16]、SRM[17]、DGRL[18]、MLMS[19]、AFNet[20]、CapSal[21]、BASNet[22]和 CPD[23]。

定量评估:5个数据集的P-R曲线和F-measure曲 线 分 别 如 图 5(P 1222)和 图 6(P1223)所示。可以看到,本文提出的方法在所有情况下都优于其他方法。尤其CAGNet-L比其他方法的性能要好很多。表2(P1224)为比较结果,每个设置下的最佳分数和第二最佳分数分别用红蓝显示,所有设置下的最佳分数都用下划线标出。参数总数(记为#Par)的单位为百万。表3(P1225)为基于属性的SOC数据集性能,最好的分数和第二好的分数分别以红色和蓝色显示。在avgF,wF,E-measure和MAE得分方面将本文的方法与其他方法进行了比较,可以看出本文的方法在大多数情况下都排名第一,本文方法CAGNet-L在avgF,wF,E-measure指标上比现有最好的CPD-R方法的5个数据集上平均提升了0.082,0.079,0.041,而MAE则下降了0.015。此外还在SOC数据集上评估基于属性的性能,表3显示了有关SOC的9个属性及其平均值的对比结果。可以看出,本文方法CAGNet-L取得了最好的性能,相对于现有最好的CPD-R方法在在avgF,E-measure指标的5个数据集上平均提升了 0.033,0.031。

表2 各方法的信息及其在5个显著目标检测数据集上的性能比较Table 2The information of various detection methods and the comparison their performance on five salient target detection datasets

表3 基于属性SOC数据集性能Table 3 Performance of attribute-based SOC data sets

图5 本文方法与其他方法在DUTS-TE,ECSSD DOT-OMRON,PASCAL-S和HKU-IS数据集上的PR曲线Fig.5 PR curves of the method propose in this work and other methods on data sets including DUTS-TE,ECSSD,DUT-OMRON,PASCAL-S and HKU-IS

图6 提出的方法与其他方法在DUTS-TE,ECSSD DOT-OMRON,PASCAL-S和HKU-IS数据集上的F-measure曲线Fig.6 F-measure curves of the proposed method propose in this work and other methods on data sets including DUTS-TE,ECSSD,DUT-OMRON,PASCAL-S and HKU-IS

提出的方法包含的参数比现有的方法少而且是端到端,不需要任何后处理步骤。对于内存有限的应用程序来说,这个功能是十分有效的。此外,CAGNet-V在处理480×480的图像时的实时速度为28帧/秒,因此它可以进行较快的计算。

定性分析:图7(P1225)显示了一些定性结果通过提出的模块可以看出,此模型在各种复杂的场景中都能够突出前景区域的内部。此外,此模型能够抑制其他显著性检测方法标记错误的背景区域,因此,通过利用不同的提出的模块,本文的方法能够处理各种复杂的场景。

图7 与其他方法的定性比较Fig.7 Qualitative comparison with other methods

2.3 消融分析

所提出的CAGNet由三个模块组成,包括多尺度特征提取模块(MFEM)、引导模块和残差细化模块(RRM)。在三个大规模数据集,即DUTS-TE、DUT-O和HKU-IS上进行消融分析。

为了研究每个模块的有效性,设置如下基准模型:1)将MFEM模块替换为具有相同数量滤波器的11个卷积,2)从网络中去除引导模块(这意味着多层次特征不会被信道权值和空间权值相乘),3)将RRM模块从模型中移除。结果如表4所示。

引导模块的有效性:在基准网络中添加了“高级引导”模块,“低级引导”模块以及“高级引导”和“低级引导”两个模块(即“引导模块”),分别表示为HG,LG和GM,如表4所示。从表中可以看出,性能得到了提高,这证明了使用引导模块能够使显著和非显著区域更加明显,并抑制具有显著外观的非显著区域,其次可以将前景标签分配给外观不同的显著区域。为了进一步研究本文的引导模块的有效性,在图8中对每个模块进行了可视化比较,第一行和第二行显示高级引导模块(表示为HG)的比较。第三行和第四行显示了对低级引导模块(表示为LG)的比较。可以看出,当在基准网络中加入高级引导模块时,具有显著样外观的非显著区域被抑制。此外,当向基准网络添加低级引导模块时,不同外观的显著区域被标记为显著区域,证明了低级引导模块的引入也能够有效提升检测效果。

图8 引导模块的可视化比较Fig.8 Visual comparison of boot modules

MFEM的有效性:基于上述体系结构,用MFEM模块替换了11个卷积。如表4所示,本文所提出的MFEM对显著性检测有良好的效果,提高了检测结果,这表明提取多尺度特征有助于检测不同尺度和位置的显著对象。

RRM的有效性:为了揭示RRM的效果,将它们添加到前面提到的架构中。从表4可以看出,使用细化模块有助于显著性检测和提高性能。

本文所设计的损失的有效性:为了说明本文设计的损失函数的有效性,使用交叉熵训练CAGNet-V,表4中表示为CE损失函数。从表中可以看出,所设计损失明显优于交叉熵损失。

为了进一步说明MFEM的有效性,在CAGNet-V中采用扩张卷积层(核大小为3,扩 张 率 为 1,3,5,7)来 实 现 MFEM,表 4(P 1226)为扩张卷积。可以看到检测性能下降,这表明MFEM可以通过在特征映射中的一个大k×k区域内实现密集连接来捕获更强大的多尺度特征。本文也采用核大小为3,7,11,15的平凡卷积层来实现CAGNet-V中的MFEM,表4表示为平凡卷积。从这个表中可以看出,与CAGNet-V相比,使用本文提出的MFEM的性能更差。但是,使用本文提出的MFEM的CAGNet-V所包含的参数比使用简单卷积层实现的MFEM的CAGNet-V所包含的参数少(2098万对2703万),这是由GCN的架构设计所导致的。

表4 所提出的不同方法设置在DUTS-TE,DUT-O和HKU-IS数据集上的消融分析Table 4 Ablation analysis of the different method settings on DUTS-TE,DUT-O,and HKU-IS data sets

本文在CAGNet-V上进行了另一个实验,对参数N进行不同设置的训练。结果如表5所示,最好的结果用红色表示,参数总数(记为#Par)的单位为百万。通过考虑性能和参数数量之间的权衡,最终选择了N=8。

表5 不同参数N在DUTS-TE,DUT-O和HKU-IS数据集上的CAGNet-V设置结果Table 5 CAGNet-V results of different parameter N on DUTS-TE,DUT-O,and HKU-IS data sets

3 结论

针对复杂场景中的显著目标检测问题,提出了一种基于目标熵的特征引导网络显著目标检测方法。通过分析在多个复杂场景数据集上的实验结果可以得出如下结论:

(1)提出的方法可以使前景和背景区域更加清晰,并抑制了不确定性。

(2)提出的方法有助于模型缓解网格化问题,充分利用上下文信息,有效提升了检测的精度,并且能够处理各种复杂的场景。

(3)引导模块有助于提取多尺度特征,多尺度特征有助于检测不同尺度和位置的显著对象,细化模块有助于显著性检测和提高性能,基于目标熵的损失函数则有助于模型的收敛。