基于YOLO_X和迁移学习的无人机影像玉米雄穗检测

2022-11-13汪斌斌杨贵军顾寄南许思喆

汪斌斌,杨贵军,杨 浩,顾寄南,赵 丹,许思喆,4,徐 波

·农业航空工程·

基于YOLO_X和迁移学习的无人机影像玉米雄穗检测

汪斌斌1,2,3,杨贵军1,2,3,杨 浩2,3,顾寄南1,赵 丹2,3,许思喆2,3,4,徐 波2,3※

(1. 江苏大学机械工程学院,镇江 212000;2. 农业农村部农业遥感机理与定量遥感重点实验室,北京农业信息技术研究中心,北京 100097;3. 国家农业信息化工程技术研究中心,北京 100097;4. 江苏大学农业工程学院,镇江 212000)

玉米雄穗表型信息的获取对研究玉米长势及产量起着非常重要的作用,为实现复杂田间环境玉米雄穗的精确识别和计数,该研究使用无人机采集试验田的玉米雄穗影像,基于Faster R-CNN、SSD、YOLO_X目标检测模型,使用迁移学习方法实现玉米雄穗的高精度识别,并分析了模型对不同品种和不同种植密度的玉米雄穗检测效果。试验结果表明,基于迁移学习的Faster R-CNN、SSD、YOLO_X的目标检测效果相比于未使用迁移学习的模型有明显提升,其中,迁移学习后YOLO_X的识别精确度为97.16%,平均精度为93.60%,准确度为99.84%,对数平均误检率为0.22,识别效果最好;不同玉米品种对模型的适应性有所差异,其中郑单958对模型适应性最好,Faster R-CNN、SSD、YOLO_X的决定系数2分别为0.947 4、0.963 6、0.971 2;不同种植密度下玉米雄穗的检测效果有所差异,在29 985,44 978,67 466,89 955株/hm2种植密度下,模型对郑单958检测的平均绝对误差分别为0.19、0.31、0.37、0.75,随着种植密度的增加,检测误差逐渐变大。研究为农田玉米雄穗高精度识别提供了一种可靠方法,对玉米表型性状高通量调查具有一定的应用价值。

无人机;目标检测;图像识别;玉米雄穗;迁移学习;深度学习

0 引 言

玉米是重要的粮食作物,其产量对保证粮食安全有重要意义。玉米是雌雄同株的作物,可以进行自花授粉,但是自花授粉不利于优良种子的选育,因此,保证玉米的异花授粉,对育种以及产量提升有重要意义[1-3]。在异花授粉过程中,需要对雄穗进行去除,传统方法主要依靠人工识别去除,费时费力。计算机视觉技术在农作物识别上的应用为准确识别玉米雄穗和高效科学指导去雄工作提供了有效的技术手段。准确获取玉米雄穗的数量信息是快速获知玉米抽雄进度的有力支撑。

近年来,随着无人机遥感技术和计算机视觉技术的发展,农业智能监测系统不断完善[4]。无人机凭借高效、便捷、成本低的优势,在农业数据采集方面赢得许多研究者青睐。计算机视觉技术凭借高效的深度学习算法在图像分类、目标检测、图像分割方面起着越来越重要的作用。国内外研究者基于无人机遥感技术和深度学习算法在玉米雄穗识别方面做了许多研究,如Lu等[5]提出了一种TasselNet卷积神经网络,通过局部回归网络实现了对玉米雄穗的计数,并公开了玉米雄穗数据集。梁胤豪等[6]提出SSD_mobilenet模型最适于部署在无人机机载系统上用于玉米雄穗识别。杨蜀秦等[7]通过改进无锚框CenterNet目标检测模型[8],实现了对尺寸较小玉米雄穗的高效检测。Liu等[9]基于Faster R-CNN网络,通过更换不同的主干特征提取网络对玉米雄穗进行检测,得出残差神经网络(ResNet)作为玉米雄穗的特征提取网络的效果要优于视觉几何组网络(VGGNet)的结论。

虽然国内外研究者对玉米雄穗检测做了许多研究,但由于大田环境的复杂性,包括不同品种玉米以及不同种植密度对模型检测效果的影响,模型的泛化性能较差[10-14]。其次,深度学习往往需要大量的训练样本,这对数据采集工作提出了更高要求。为了避免大量重复性工作,本文提出利用迁移学习作为机器学习的一种方法,将一个任务上训练好的模型应用到新的任务中,从而提高模型的泛化性能[15-17]。Li等[18]基于Faster R-CNN模型和RetinaNet模型,在迁移学习后提高了麦穗计数准确度。万军杰等[19]基于GoogLeNet网络,在迁移学习后提升了病虫害的识别精度。袁培森等[20]提出了一种基于迁移学习的双线性Inception-ResNet-v2网络的菌菇识别方法,在开源数据集和个人数据集上取得了较好的测试效果。

目标检测[21-22]模型目前主要分为1段式(One-stage)和2段式(Two-stage)两类,其中SSD(Single shot multibox detector)网络[23]和YOLO系列网络作为典型的1段式网络,而Faster R-CNN作为典型的2段式网络,广泛应用到农作物检测计数方面[24]。目前YOLO系列包含YOLOv1~YOLOv5以及YOLO_X,其中YOLO_X采用免锚(Anchor Free)机制以及解耦头部(Decoupled Head)等一系列改进,在YOLO系列中目标检测效果表现最佳[25]。因此本文以SSD、Faster R-CNN、YOLO_X为基础,采用迁移学习的方法进行玉米雄穗识别,并探究不同品种玉米和不同种植密度对模型的适应性,以期为高效获取玉米高通量表型信息提供技术支持。

1 材料与方法

1.1 试验场地

试验数据采集于北京市昌平区小汤山国家精准农业研究示范基地(40°20′18′′N~40°23′13′′N,115°50′17′′E~116°29′49′′E),海拔高度36 m。整个试验区有80个小区,每个小区大小为2.5 m×3.6 m,试验选取5个不同的玉米品种:农科糯336(A1)、京九青贮16(A2)、天赐19(A3)、郑单958(A4)、湘糯2008(A5),每种玉米农学性状如表1所示;4个不同的种植密度:29 985,44 978,67 466,89 955株/hm2,2个重复。试验播种日期为2021年6月11日,9月11日收获。

表1 不同品种玉米农学性状Table 1 Agronomic traits of different varieties maize

1.2 数据采集与预处理

采用大疆御系列Mavic 2便携式无人机于2021年8月9日(13∶30-14∶00)对80个试验小区进行影像采集,试验区域分布如图1所示。为了减少光照强度和玉米植株摆动对检测效果的影响,采集数据在多云、无风天气情况下进行,此时所有玉米已进入开花期。无人机搭载2 000万像素哈苏相机,飞行高度为10 m,旁向重叠率和航向重叠率为80%,图像像元分辨率0.2 cm,图像分辨率为5 472像素×3 648像素,共获得549幅玉米雄穗影像。由于每一幅影像尺寸较大,玉米雄穗比较密集且占用的像素区域较小,无法对影像直接训练和检测,为了保证后期的网络训练速度,将采集的影像裁剪成600像素×600像素大小,共获得2 120张玉米雄穗影像。

图1 试验区域分布

为了分析品种和种植密度对模型检测效果的影响,需保证不同品种在不同种植密度下训练和验证的数据量一致,故在训练集和验证集样本区域,每个玉米品种在每个种植密度下雄穗影像各取80张作为训练集,在5个品种和4个种植密度下共获得1 600张影像作为训练集,每个玉米品种在每个种植密度下雄穗影像各取10张影像作为验证集,验证集总数为200张;在测试集样本区域,每个玉米品种在每个种植密度下各取16张雄穗影像,最终得到320张测试集影像。

使用LabelImg软件对得到的玉米雄穗影像数据进行标注,每一幅影像标注之后所保存的XML文件都包含影像的宽度和高度以及通道数,并且会记录目标的类别以及目标边界框的左上、右下的顶点坐标。

1.3 技术路线

本文旨在利用目标检测算法对玉米雄穗进行检测,进而分析不同品种和不同种植密度下玉米雄穗对模型适应性,主要内容如下:

1)玉米雄穗数据集的构建。通过无人机获取实验区玉米雄穗影像,并进行图像裁剪和标注,构建用于试验训练和测试的玉米雄穗数据集。

2)玉米雄穗检测模型构建。构建Faster R-CNN、SSD、YOLO_X模型,并使用迁移学习的方法,对已构建的玉米雄穗数据集进行训练验证。

3)试验结果分析。对使用迁移学习后模型进行精度评价,并对不同品种和不同种植密度玉米雄穗的检测效果分析。

1.4 检测模型

1.4.1 Faster R-CNN模型

Faster R-CNN模型的主干特征提取网络为VGG16,输入图像经过特征提取之后,生成的特征图分别传入区域建议网络(Region Proposal Network, RPN)和感兴趣区域(Region of Interest, ROI)池化层。传入区域建议网络的部分会对候选框做二分类分析,并初步进行边界框回归。传入感兴趣区域池化层(ROI Pooling)的部分将来自区域建议网络(RPN)输出的候选框和特征图固定到全连接网络的输入维度,然后进行边界框回归和分类。图2为Faster R-CNN网络结构图。

注:FEN表示特征提取网络;FM表示特征图;RPN表示区域建议网络;ROI Pooling表示感兴趣区域池化;FC表示全连接层;Reg表示回归;Clas表示分类。下同。

1.4.2 SSD模型

经典的SSD目标检测算法以VGG16作为基础网络模型,将第6层全连接(FC6)和第7层全连接(FC7)替换成卷积层Conv6和Conv7,并去除第8层全连接(FC8),然后再添加卷积层Conv8、Conv9、Conv10、Conv11作为整个模型的特征提取网络。整个特征提取网络从VGG16的卷积层Conv4_3开始,在Conv7、Conv8_2、Conv9_2、Conv10_2、Conv11_2层共获取6个有效特征图,这些特征图大小依次递减,用于检测不同尺度大小的目标。SSD模型引入锚框(Anchor)机制,通过正负样本的筛选,在所有特征图上产生不同尺度和长宽比的锚框,再对目标对象的类别置信度和边界框位置进行回归预测,最后通过非极大值抑制(Non-Maximum Suppression, NMS)实现多尺度的目标检测。SSD网络结构图如图3所示。

注:Detections表示先验框;FM1~FM6表示特征图;NMS表示非极大值抑制。下同。

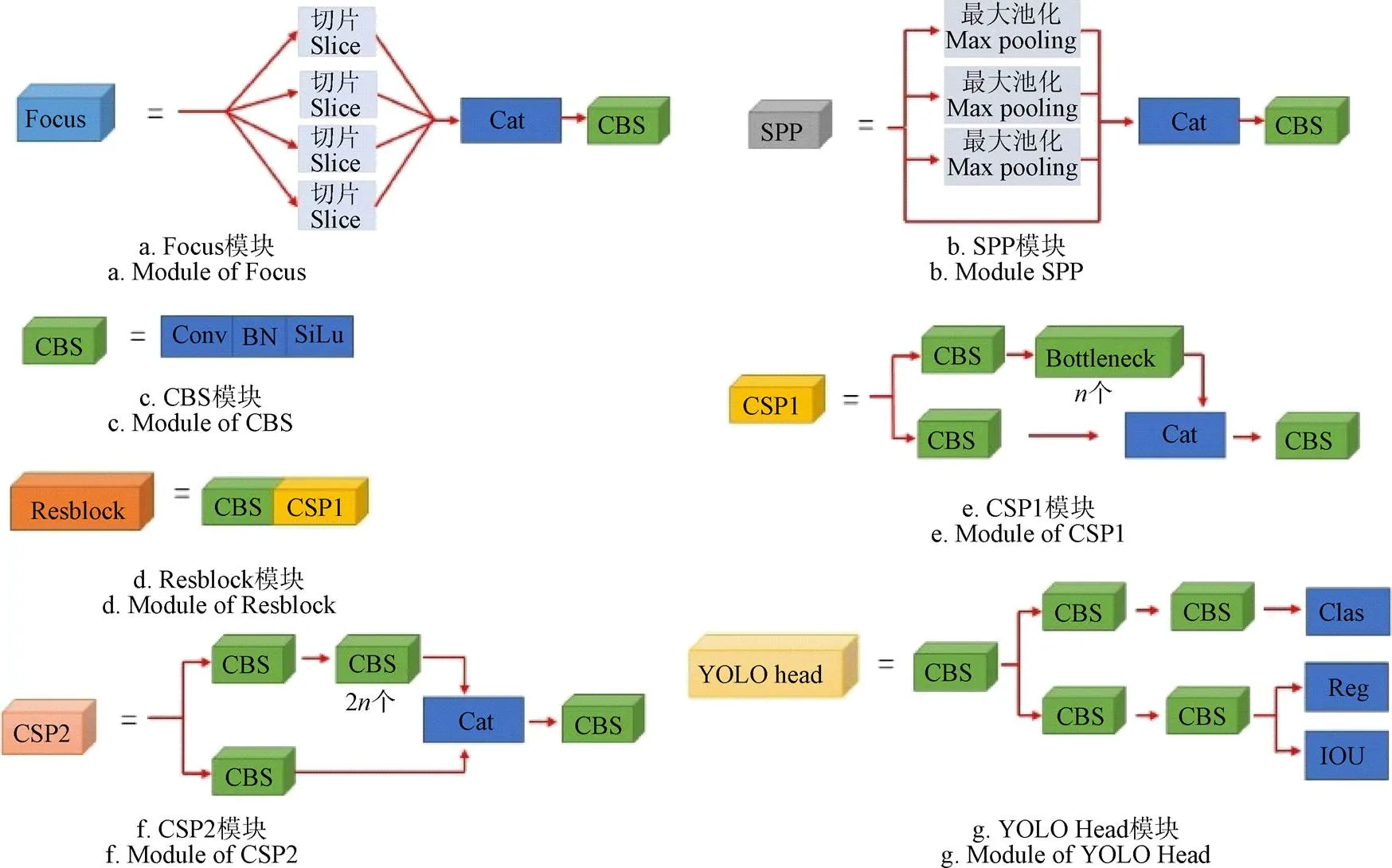

1.4.3 YOLO_X模型

YOLO_X以YOLO_V3[26-27]为基线,主要由主干部分特征提取网络、加强特征提取网络、以及输出端的解耦头部组成。并引入数据增强、免锚和高级标签分配(Sim OTA),YOLO_X总体结构如图4所示,主要模块结构如图5所示。

注:Cat表示通道数叠加;Upsample表示上采样;SPP模块表示空间金字塔池化;CSP1~CSP2模块表示跨级部分连接;YOLO head模块表示输出端检测器;FPN表示特征金字塔;PAN表示像素聚合网络;CBS模块由卷积、批量标准化层、激活函数SiLu组成。下同。

1)主干特征提取网络

YOLO_X中主干特征提取网络引入Focus结构,其结构如图6a所示,输入图像之后,Focus结构对图像的RGB三通道进行切片处理,每个通道扩充为之前的4倍,然后对切片图像进行拼接,其拼接好的图像由之前的3通道变为12通道,再经过卷积操作以后,得到2倍下采样的特征图,Focus结构可以减少网络参数的计算,加快网络运行速度。另外YOLO_X在主干特征提取网络中引入空间金字塔池化(Spatial Pyramid Pooling,SPP)的结构,实现了局部特征和全局特征的融合,丰富了特征图的表达能力,其结构如图6b所示。

2)加强特征提取网络

经过主干特征提取网络后可以获得3个有效特征层,YOLO_X采用特征金字塔和像素聚合网络组合作为加强特征提取网络,对获得的3个有效特征层进行上采样实现特征融合,再次进行下采样实现特征融合,通过2次特征融合,结合不同尺度信息,特征提取效果更好。

3)解耦头部

之前的YOLO系列采用一个耦合在一起的检测头,同时进行分类回归的检测任务。YOLO_X采用的解耦头部将分类和回归2个任务分开进行,对于输入进来的特征层,采用一次卷积进行降维,然后增加2个平行分支,再分别采用卷积操作进行分类和回归,交并比(Intersection Over Union, IOU)分支被添加到回归的分支上,其结构如图6g所示,这种方法一方面提升了网络的收敛速度,另一方面实现了网络端对端的性能。

图5 YOLO_X主要模块结构

1.5 迁移学习

为了使模型效果更好,深度学习图像识别需要大量的数据标注样本,但是数据标注是一项耗时耗力的任务,因此,迁移学习得到越来越多的关注。迁移学习将从一个环境中学习到的特征应用到新环境的学习任务中,与未使用迁移学习的模型相比,预训练模型已经学习到了丰富的特征,可以在数据量比较少的条件下快速训练出结果。本研究基于迁移学习的思想,采用公开的MTC玉米雄穗数据集[5]对Faster R-CNN、SSD、YOLO_X模型进行预训练,将预训练好的模型权重迁移到本文模型中,同时为了加快网络的训练速度,防止权重被破坏,采用冻结主干的方式进行训练。图6为玉米雄穗检测的迁移学习示意图。

在训练之前,需要设置网络模型的参数,本文设置训练轮数(Epoch)为100,批量大小(batch-size)为4,在训练前50轮冻结网络主干,只对后面网络层数进行训练,冻结主干过程中初始学习率为1×10-3,后50轮进行解冻,解冻之后的学习率为1×10-4。学习率的动量为0.9,置信度阈值为0.5,非极大值抑制的阈值为0.3。

图6 玉米雄穗检测的迁移学习示意图

1.6 试验平台

试验环境包含硬件环境和软件环境,其中硬件环境的处理器运行内存16 GB,英伟达GeForce GTX1080Ti显卡,显存11 GB;软件环境为Window10操作系统,Python3.7,Pytorch1.2,Cuda10.0。

1.7 评价指标

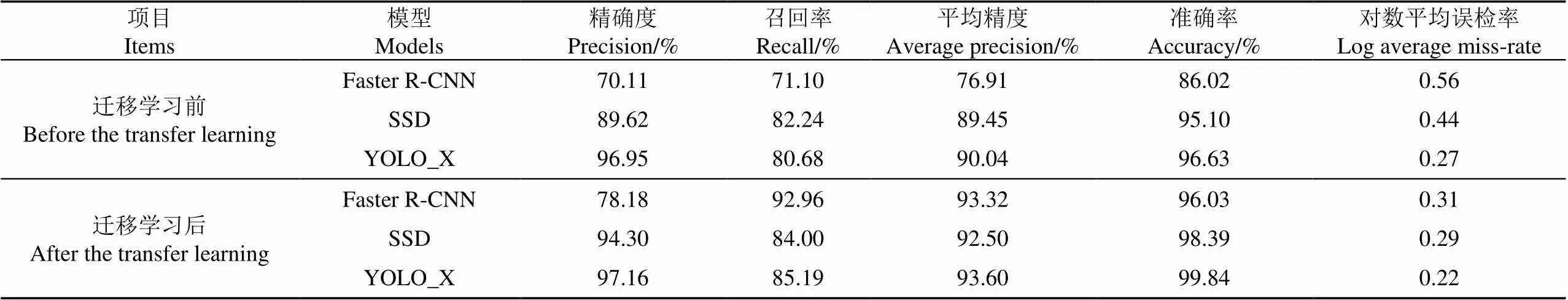

训练结束后对模型性能进行评估,本文采用精确度(Precision,)、召回率(Recall,)、平均精度(Average Precision,AP)、准确度(Accuracy)、交并比、对数平均误检率(Log Average Miss-Rate,LAMR)来评估模型性能,、、AP、Accuracy、LAMR的计算公式[28]如下:

式中TP表示正样本预测为正样本,TN表示正样本预测为负样本,FP表示负样本预测为正样本,FN表示正样本预测为负样本。

式中表示预测框区域,表示真实框区域,IOU的值

表示在检测目标过程中,预测框区域与真实框区域交集和并集的比值。

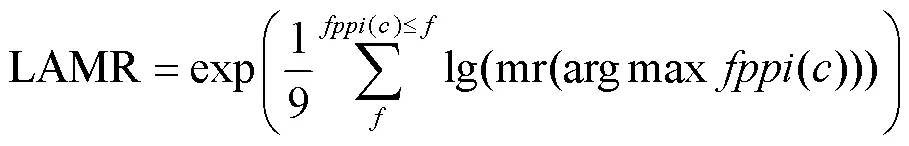

式中对数平均误检率(LAMR)的值越小代表模型的性能越好。()表示每张图片负样本预测为正样本的个数,表示误检的个数,mr表示误检率。

2 结果与分析

2.1 迁移学习对玉米雄穗检测模型的影响

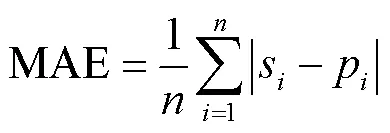

试验选用Faster R-CNN、SSD、YOLO_X目标检测网络。先搭建Faster R-CNN、SSD、YOLO_X网络对制作好的玉米雄穗数据集进行训练,然后使用迁移学习的方式对Faster R-CNN、SSD、YOLO_X网络进行训练。结果如表2所示。由表2可知,相比于未使用迁移学习3种模型,使用迁移学习识别后在召回率和平均精度上有明显提升。Faster R-CNN的召回率、平均精度分别上升21.86、16.41个百分点;SSD的召回率、平均精度分别上升1.76、3.05个百分点;YOLO_X的召回率、平均精度分别上升4.51、3.56个百分点。使用迁移学习前后的Faster R-CNN、SSD、YOLO_X模型对玉米雄穗识别的损失变化如图7所示,从图7可以看出,模型经过迁移学习后,初始损失值更低,说明在模型达到一个稳定的损失值之前,迁移学习后的模型收敛速度更快。

表2 不同模型迁移学习前后的检测效果对比 Table 2 Comparison of detection effects of different models before and after transfer learning

图7 不同模型迁移学习前后的损失变化

由表2可知,使用迁移学习后,Faster R-CNN、SSD、YOLO_X模型对玉米雄穗检测的准确度分别上升10.01、3.29、3.21个百分点,对数平均误检率(LAMR)分别降低0.25、0.13、0.05。图8为部分检测结果,图中共包含16个玉米雄穗。其中,Faster R-CNN正确检测12个,迁移学习后,正确检测14个;SSD正确检测12个,在迁移学习后,正确检测15个;YOLO_X正确检测13个,迁移学习后,正确检测16个,3种目标检测模型在迁移学习后的检测效果均有明显提升。

同时,在使用迁移学习前,Faster R-CNN、SSD、YOLO_X网络的检测效果有明显差异,YOLO_X的平均精度达到了90.04%,比Faster R-CNN和SSD分别高13.13和0.59个百分点,准确率达到96.63%,比Faster R-CNN和SSD分别高出10.61、1.53个百分点。使用迁移学习后,YOLO_X的平均精度AP值达到了93.60%,比Faster R-CNN和SSD分别高出0.28和1.1个百分点,准确率达到99.84%,比Faster R-CNN、SSD高3.81、1.45个百分点,且YOLO_X的对数平均误检率最低,为0.22。YOLO_X相比其他2种网络,在迁移学习前后均表现出更好的识别性能。

图8 不同模型迁移学习前后玉米雄穗识别结果

2.2 品种的检测效果对比

为了验证模型对不同品种玉米雄穗的检测效果,将测试集320张影像按品种分为5组测试集,每个品种有64张影像,各品种都已进入开花期,每个品种对应的雄穗图像如图9所示。基于Faster R-CNN、SSD、YOLO_X模型,对每个品种玉米雄穗进行检测,并对人工标记的真实框数量与模型检测的结果进行线性回归分析,结果如图10所示。

图9 不同品种玉米雄穗

从试验结果可以看出,郑单958在Faster R-CNN、SSD、YOLO_X模型的决定系数2分别为0.947 4、0.963 6、0.971 2,均方根误差RMSE分别为1.089、0.976 3、0.790 6,在5个品种中对模型的适应性最好;京九青贮16的决定系数2分别为0.709 0、0.580 2、0.780 2,均方根误差分别为2.934 2、4.726 9、3.213 7,对模型的适应性最差。在5个品种中,郑单958 、农科糯336、天赐19的检测效果较好,京九青贮16和湘糯2008的检测效果较差。主要原因是由于京九青贮16和湘糯2008穗枝条较细,穗分支较少,更容易存在漏检;而郑单958、农科糯336、天赐19由于穗枝条较大,穗分支较多,特征更加明显,因此更易被检测。YOLO_X对5个品种的决定系数2分别为0.918 6、0.780 2、0.913 3、0.971 2、0.881 8,检测效果最好,说明YOLO_X模型具有很好的检测性能。

2.3 基于迁移学习的YOLO_X模型对不同种植密度的玉米雄穗识别效果

将测试集样本区域获取的320张影像按不同种植密度进行分类,每个品种的不同种植密度下各有16张影像。为了验证基于迁移学习的YOLO_X模型对不同种植密度的玉米雄穗识别效果,将同一品种下的不同种植密度的玉米雄穗影像分别进行检测,并计算平均绝对误差(Mean Absolute Error, MAE),试验结果如图11所示。

从图11中可以看出,不同品种的平均绝对误差值差别较大,相同种植密度下的平均绝对误差值也不一样。在29 985,44 978,67 466,89 955株/hm2种植密度下,模型对农科糯336检测的MAE分别为0.75、1.06、1.25、1.63,对京九青贮16检测的MAE为2.19、2.43、2.91、3.44,对天赐19检测的MAE为0.45、0.63、0.75、1.37,对郑单958检测的MAE为0.19、0.31、0.37、0.75,对湘糯2008检测的MAE为0.79、1.18、1.43、1.5。其中郑单958的MAE明显低于京九青贮16。同一品种,随着其种植密度的上升,其平均绝对误差值也随之变大。该结果表明,基于迁移学习的YOLO_X模型对玉米雄穗的检测精度不仅与种植密度相关,而且与品种相关,主要趋势是随着种植密度的增大,检测误差也逐渐变大,而造成这一现象的主要原因是由于随着种植密度的增大,雄穗之间存在着越来越严重的交叉重叠以及遮挡,容易对检测过程产生干扰。对于不同品种的玉米雄穗,模型的检测效果也有所差异,其中郑单958雄穗分支较大,而且分支数较多,检测误差较小,而京九青贮16雄穗分支较细,分支数较少,检测误差较大,这也验证了不同品种玉米雄穗影响模型检测效果。

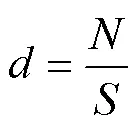

本研究中,每个试验小区面积均为2.5 m×3.6 m。根据玉米雄穗密度估算公式:

式中为玉米雄穗的数量,为检测区域的面积m2,并基于迁移学习的YOLO_X模型对玉米雄穗密度的估算。图12为对玉米雄穗密度估计结果,可以为玉米产量估算提供支持。

图10 不同模型对不同品种玉米雄穗的检测结果

图11 基于迁移学习的YOLO_X对不同种植密度的玉米雄穗识别结果

注:图中数字表示玉米雄穗密度。

3 讨 论

3.1 数据集对迁移学习的影响

在迁移学习过程中,将一个环境中学习到的知识应用到新的环境中来,在理想条件下,原训练集的数据量不仅要大,而且质量也要高,这样在迁移到目标模型中的时,目标模型将包含更多的特征信息。本文使用玉米雄穗MTC公开数据集,是Lu等[5]在2010-2015年间,使用CCD数码相机(E450 Olympus)从中国4个不同的试验点采集的6个品种,记录了玉米从苗期到抽雄期等多个生长期,涵盖的数据量较大,质量也较高,因此将其训练模型迁移到本文使用的数据集后检测精度有了明显的提升,但就迁移学习技术本身来讲,样本量依然有限,特别是在品种,环境条件(光照和遮挡)、尺度(无人机和观测塔)等方面的数据量依然较少,因此该迁移模型仍然仅适用于与其数据分辨率、生长期、光照条件接近的场景。但是单纯地增加数据集会使得计算量增大,耗时较长,实际应用时应用价值降低[29-30]。因此,在实际应用中,针对性地选择预训练模型进行迁移更有助于提高检测效率。未来随着玉米雄穗数据集的扩大,该模型对玉米雄穗识别的泛化性和鲁棒性有望更好。

3.2 影响玉米雄穗检测精度的其他因素

玉米雄穗的检测效果与许多因素有关,在本研究中,部分检测结果中存在预测框数量大于真实框数量,说明在检测过程中存在背景干扰,部分背景图像误检为雄穗,检测结果产生误差;同时,光照强度的影响使得部分雄穗与土壤的颜色差异变小,产生漏检;另外,本试验对玉米品种的株型考虑较少,试验的5个品种,除了郑单958为紧凑型,其余品种皆为半紧凑型。株型不同雄穗的遮挡情况不同,进而影响模型检测效果。除此之外,模型本身也是影响检测效果的重要因素,Liu等[9]通过替换不同的特征提取网络对玉米雄穗进行检测,得出特征提取网络为ResNet101时检测效果最好,因此选取较优的特征提取网络有助于提升检测效果;再者,模型训练参数的设置也会影响模型的性能,Xu等[31]在模型训练时,设置不同的轮数和批量大小,模型的检测效果是不同的。因此,为了使得玉米雄穗的检测模型效果更好,模型训练时的参数选取也是非常重要的。

4 结 论

本研究基于Faster R-CNN、SSD和YOLO_X目标检测网络,采用迁移学习的方式对玉米雄穗进行识别,筛选出最佳的玉米雄穗检测模型,并探究了品种和种植密度对模型检测效果的影响,主要结论如下:

1)相比未使用迁移学习的模型,迁移学习后Faster R-CNN、SSD、YOLO_X模型的平均精度分别提升了16.41、3.05、3.56个百分点,证明迁移学习在玉米雄穗的识别上的有效性;与迁移学习后Faster R-CNN、SSD相比,迁移学习后YOLO_X的精确度为97.16%,平均精度为93.60%,准确度为99.84%,对玉米雄穗的识别效果最好。

2)不同品种玉米雄穗的检测效果有差异,郑单958在Faster R-CNN、SSD、YOLO_X的决定系数2分别为0.947 4、0.963 6、0.971 2,对模型的适应性最好。京九青贮16在Faster R-CNN、SSD、YOLO_X的决定系数2分别为0.709 0、0.580 2、0.780 2,对模型适应效果最差,造成差异的主要原因是不同品种间玉米雄穗的形态有所差异。

3)种植密度会影响模型的检测效果,在29 985,44 978,67 466,89 955株/hm2种植密度下,模型对郑单958检测的平均绝对误差分别为0.19、0.31、0.37、0.75,表明随着种植密度的增大,模型误差也变大。

[1] Gage J L, Miller N D, Spalding E P, et al. TIPS: A system for automated image-based phenotyping of maize tassels[J]. Plant Methods, 2017, 13(1): 1-12.

[2] Huang J, Gómez-Dans J L, Huang H, et al. Assimilation of remote sensing into crop growth models: Current status and perspectives[J]. Agricultural and Forest Meteorology, 2019, 276: 107609.

[3] Lu H, Cao Z, Xiao Y, et al. Fine-grained maize tassel trait characterization with multi-view representations[J]. Computers and Electronics in Agriculture, 2015, 118: 143-158.

[4] Fan B, Li Y, Zhang R, et al. Review on the technological development and application of UAV systems[J]. Chinese Journal of Electronics, 2020, 29:199-207.

[5] Lu H, Cao Z, Xiao Y, et al. TasselNet: Counting maize tassels in the wild via local counts regression network[J]. Plant Methods, 2017, 13(1): 1-17.

[6] 梁胤豪,陈全,董彩霞,等.基于深度学习和无人机遥感技术的玉米雄穗检测研究[J].福建农业学报,2020,35(4):456-464.

Liang Yinhao, Chen Quan, Dong Caixia, et al. Application of deep-learning and UAV for field surveying corn tassel[J]. Fujian Agricultural Journal, 2020, 35(4): 456-464. (in Chinese with English abstract)

[7] 杨蜀秦,刘江川,徐可可,等. 基于改进CenterNet的玉米雄蕊无人机遥感图像识别[J]. 农业机械学报,2021,52(9):206-212.

Yang Shuqin, Liu Jiangchuan, Xu Keke, et al. Improved centerNet based tassel recognition for UAV remote sensing image[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(9): 206-212. (in Chinese with English abstract)

[8] Zhou X, Wang D, Krähenbühl P. Objects as points[EB/OL]. arXiv preprint arXiv 2019: 1904.07850.

[9] Liu Y, Cen C, Che Y, et al. Detection of maize tassels from UAV RGB imagery with faster R-CNN[J]. Remote Sensing, 2020, 12(2): 338.

[10] Maepa C E, Jayaramudu J, Okonkwo J O, et al. Extraction and characterization of natural cellulose fibers from maize tassel[J]. International Journal of Polymer Analysis and Characterization, 2015, 20: 99-109.

[11] Ye M, Cao Z, Yu Z. An image-based approach for automatic detecting tasseling stage of maize using spatio-temporal saliency[C]//MIPPR 2013: Remote Sensing Image Processing, Geographic Information Systems, and Other Applications. Wuhan, China: Society of Photo-Optical Instrumentation Engineers, 2013: 235-242.

[12] Scharr H, Pridmore T P, Tsaftaris S A. Computer vision problems in plant phenotyping[C]// Proceedings of the IEEE International Conference on Computer Vision Workshops. Venice, Italy: Introduction to the CVPPP 2017 Workshop Papers, 2017: 2020-2021.

[13] Kurtulmuş F, Kavdir I. Detecting corn tassels using computer vision and support vector machines[J]. Expert Systems with Applications, 2014, 41(16): 7390-7397.

[14] Kumar A, Taparia M, Rajalakshmi P, et al. UAV based remote sensing for tassel detection and growth stage estimation of maize crop using faster-R-CNN[J]. Computer Vision Problems in Plant Phenotyping, 2019, 3: 4321-4323.

[15] Lu J, Behbood V, Hao P, et al. Transfer learning using computational intelligence: A survey[J]. Knowledge-Based Systems , 2015, 80: 14-23.

[16] 王东方,汪军. 基于迁移学习和残差网络的农作物病害分类[J]. 农业工程学报,2021,37(4):199-207.

Wang Dongfang, Wang Jun. Crop disease classification with transfer learning and residual networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(4): 199-207. (in Chinese with English abstract)

[17] 张瑞青,李张威,郝建军,等. 基于迁移学习的卷积神经网络花生荚果等级图像识别[J]. 农业工程学报,2020,36(23):171-180.

Zhang Ruiqing, Li Zhangwei, Hao Jianjun, et al. Image recognition of peanut pod grade based on transfer learning with convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(23): 171-180. (in Chinese with English abstract)

[18] Li J, Li C, Fei S, et al. Wheat ear recognition based on retinaNet and transfer learning[J]. Sensors, 2021, 21(14): 4845.

[19] 万军杰,祁力钧,卢中奥,等. 基于迁移学习的GoogLeNet果园病虫害识别与分级[J]. 中国农业大学学报,2021,26(11):209-221.

Wan Junjie, Qi Lijun, Lu Zhong’ao, et al. Recognition and grading of diseases and pets in orchard by GoogLeNet based on transfer learning[J]. Journal of China Agricultural University, 2021, 26(11): 209-221. (in Chinese with English abstract)

[20] 袁培森,申成吉,徐焕良. 基于迁移学习和双线性CNN的细粒度菌菇表型识别[J]. 农业机械学报,2021,52(7):151-158.

Yuan Peisen, Shen Chengji, Xu Huanliang. Fine-grained mushroom phenotype recognition based on transfer learning and bilinear CNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(7): 151-158. (in Chinese with English abstract)

[21] Rawat S S, Verma S K, Kumar Y. Review on recent development in infrared small target detection algorithms[J]. Procedia Computer Science, 2020, 167: 2496-2505.

[22] Zou Z, Shi Z, Guo Y, et al. Object detection in 20 years: A survey[J]. arXiv preprint arXiv 2019: 1905.05055.

[23] Liu W, Anguelov D, Erhan D, et al. Ssd: Single shot multibox detector[C]// European conference on computer vision. Springer, Cham, 2016: 21-37.

[24] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 39(6): 1137-1149.

[25] Ge Z, Liu S, Wang F, et al. YOLO_X: Exceeding YOLO series in 2021[EB/OL]. arXiv preprint arXiv:2107.08430, 2021.

[26] Redmon J, Farhadi A. YOLOv3: An incremental improvement[EB/OL]. arXiv preprint arXiv:1804.02767, 2018.

[27] Bochkovskiy A, Wang C Y, Liao H Y M. YOLOv4: Optimal speed and accuracy of object detection[J]. arXiv preprint arXiv: 2004.10934, 2020.

[28] Dollar P, Wojek C, Schiele B, et al. Pedestrian detection: An evaluation of the state of the art[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 34(4): 743-761.

[29] Zhuang F, Qi Z, Duan K, et al. A comprehensive survey on transfer learning[J]. Proceedings of the IEEE, 2020, 109(1): 43-76.

[30] Zhu W, Braun B, Chiang L H, et al. Investigation of transfer learning for image classification and impact on training sample size[J]. Chemometrics and Intelligent Laboratory Systems, 2021, 211: 104269.

[31] Xu W, Zhao L, Li J, et al. Detection and classification of tea buds based on deep learning[J]. Computers and Electronics in Agriculture, 2022, 192: 106547.

UAV images for detecting maize tassel based on YOLO_X and transfer learning

Wang Binbin1,2,3, Yang Guijun1,2,3, Yang Hao2,3, Gu Jinan1, Zhao Dan2,3, Xu Sizhe2,3,4, Xu Bo2,3※

(1212000,; 2,100097,; 3.100097,; 4212000)

Maize tassels play a very important role in the process of maize growth. It is a high demand to realize the accurate identification and counting of maize tassels in the complex field environment. In this study, a complete detection and counting system was established for the farmland maize tassels using Unmanned Aerial Vehicle (UAV) remote sensing and computer vision, in order to promote the application of intelligent agriculture during maize production. The UAV images were also collected during the maize heading stage in the experimental field. Three target detection networks of Faster R-CNN, SSD, and YOLO_X were selected to realize the high-precision recognition of maize tassels using transfer learning. Specifically, the UAV was firstly utilized to collect the RGB images of maize tassels with a height of 10 m on August 9, 2021. Secondly, the UAV images of maize tassels were cut into 600 × 600 pixels. The same number of samples were then selected for the training set, verification set, and test set, according to each variety and planting density. Finally, the weight of training on the public dataset was transferred to the target model using transfer learning. The recognition performance of maize tassel was compared before and after transfer learning. The experimental results show that the average precision, the recall rate, and the accuracy rate of Faster R-CNN target detection networks increased by 16.41, 21.86, and 10.01 percentage points, respectively, compared with the SSD, and YOLO_X. By contrast, the average precision, recall rate, and accuracy rate of the SSD increased by 3.05, 1.76 percentage points, respectively. The average precision, the recall rate, and the accuracy rate of YOLO_X increased by 3.56, 4.51 percentage points, respectively. Among them, the recognition precision, average precision, accuracy, and LAMR of YOLO_X after transfer learning reached 97.16%, 93.60%, 99.84%, and 0.22, respectively, compared with the Faster R-CNN and SSD networks. The best performance was achieved for the detection of maize tassel. In addition, the Faster R-CNN, SSD, and YOLO_X were also utilized to determine the adaptability of the model under the five varieties of maize tassels. The results showed that the maize tassels of Zhengdan958 were easier to be tested, indicating the best adaptability to the model. Nevertheless, there was a low correlation between the true and prediction on the number of frames of Jingjiuqingzhu16 maize tassels, indicating the low detection performance. The training datasets of this variety were then suggested to be expanded and suitable for the model in the future. In addition, five varieties were also tested at four planting densities using the YOLO_X model after transfer learning. The experimental results show that the detection error of the model for the maize tassel significantly increased with the increase in planting density. The density of maize tassel was also estimated to effectively obtain the agronomic phenotype of maize for the prediction of maize yield. A systematic investigation was made to clarify the influence of the difference between varieties and planting density on the model detection. Many factors were determined for the model detection, such as the plant type of maize, the parameters of the model, and the feature extraction network. Therefore, the finding can also provide strong support for the intelligent production of maize and agricultural modernization.

UAV; object detection; image recognition; maize tassel; transfer learning; deep learning

10.11975/j.issn.1002-6819.2022.15.006

S513; TP391

A

1002-6819(2022)-15-0053-10

汪斌斌,杨贵军,杨浩,等. 基于YOLO_X和迁移学习的无人机影像玉米雄穗检测[J]. 农业工程学报,2022,38(15):53-62.doi:10.11975/j.issn.1002-6819.2022.15.006 http://www.tcsae.org

Wang Binbin, Yang Guijun, Yang Hao, et al. UAV images for detecting maize tassel based on YOLO_X and transfer learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(15): 53-62. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.15.006 http://www.tcsae.org

2022-05-11

2022-07-06

国家重点研发计划项目(2021YFD2000100,2019YFE0125300-1);广东省重点领域研发计划项目(2019B020216001)

汪斌斌,助理研究员,研究方向为机器视觉与作物表型信息。Email:3107718860@qq.com

徐波,博士,助理研究员,研究方向为无人机遥感应用,作物表型信息。Email:xub@nercita.org.cn