基于显著性的多波段图像同步融合方法

2022-10-26蔺素珍禄晓飞李大威王彦博

余 东,蔺素珍,禄晓飞,李大威,王彦博

基于显著性的多波段图像同步融合方法

余 东1,蔺素珍1,禄晓飞2,李大威3,王彦博1

(1. 中北大学 大数据学院,山西 太原 030051;2. 酒泉卫星发射中心,甘肃 酒泉 735305;3. 中北大学 电气与控制工程学院,山西 太原 030051)

针对多波段融合图像存在对比度低、显著目标不突出的问题,本文提出了一种基于显著性的多波段图像同步融合方法。首先,近红外图像被用来作为数据保真项,红外图像和可见光图像分别为融合结果提供红外显著信息和细节信息;其次,基于视觉显著的红外显著区域提取方法被用来构造权重图,以克服融合结果显著区域不突出和边缘模糊问题;最后,采用交替方向乘子法(alternating direction method of multipliers, ADMM)来求解模型,得到融合结果。研究结果表明,较于代表性图像融合算法,所提算法能在保留红外图像热辐射信息的同时,保有较好的清晰细节,并在多项客观评价指标上优于代表性算法。

图像融合;多波段图像;显著性;全变分

0 引言

鉴于单个传感器提供信息的有限性,多个不同类型的传感器被用于同一场景同一时刻的数据采集,以获得全面、准确的场景信息。然而,传感器的增加却导致了“信息过载”。图像融合技术在整合互补信息和减少冗余方面发挥着重要作用。其大致可分为:基于空间域方法[1]、变换域方法[2]、深度学习方法[3-4]。空间域方法通常是利用平均或最大权重策略产生融合结果,但是会丢失许多细节。基于变换域的方法通常是将源图像分解,然后手动设计不同的融合规则以分别融合不同层信息,最后重建得到融合结果。常用的多尺度变换的方法包括基于金字塔的算法[5]、基于小波的算法[6]、曲波变换[7]和非下采样轮廓波变换[8]。但是如何选取合适的分解方法和融合规则仍然是一个棘手的问题。近年深度学习被广泛应用于图像融合领域[9-11],但其计算复杂度高,需要大规模数据和强大的硬件支持,可解释性弱,不确定性强,这严重减缓了深度学习方法在图像融合中的进展。

近十年来,基于优化模型的方法被广泛用于图像领域。这些方法不需要大量样本来训练或学习,并且可以在低性能硬件上运行。尽管基于优化模型的方法在图像融合方面取得了进展[12-13],但仍有一些方面需要改进。文献[14-15]中,数据保真项只和红外图像相关,因此融合结果背景更加近似于红外图像。尽管它使用了正则项来尽可能多地保留可见光图像的细节信息,但可能会丢失可见光图像中的显著信息和对比度信息。在文献[16]中,虽然已经针对显著目标的提取的能量函数进行了改进,但是仅仅只是选择红外图像和可见光图像像素高的作为显著区域,所起到的作用有限。

为了解决这些问题,本文提出一种基于全变分的多波段图像同步融合模型。首先,采用近红外图像作为数据保真项,红外图像和可见光图像来分别为融合结果提供细节信息和显著信息,以此建立多波段图像同步融合模型;其次,用基于视觉显著的红外显著区域提取方法来构造权重图,以克服融合结果显著区域不突出和边缘模糊问题。最后,采用ADMM求解模型得到融合图像。

1 基于显著性的多波段图像同步融合方法

1.1 多波段同步融合模型的建立

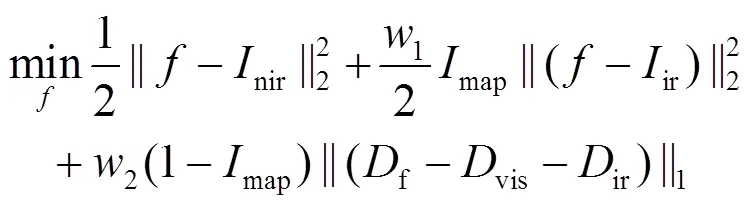

考虑到红外图像的成像原理与热辐射有关,而可见光图像成像原理则与光的反射有关。近红外图像的成像波段介于两者之间,所以成像结果包含热辐射和光反射的元素。故本文将近红外图像作为数据保真项,并依靠红外图像为其提供显著信息,通过可见光图像为其提供更加丰富的细节信息。则所建立的保真项可表示为:

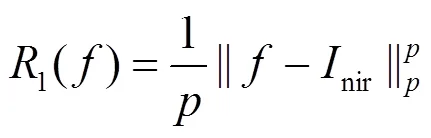

式中:为融合结果;nir为近红外图像;表示采用的范数类型。

所建立的显著区域保真项可表示为:

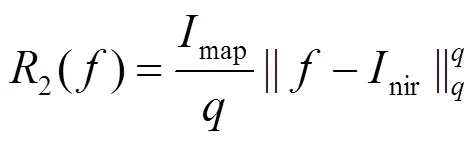

式中:map为显著区域权重;ir为红外图像;表示采用的范数类型。

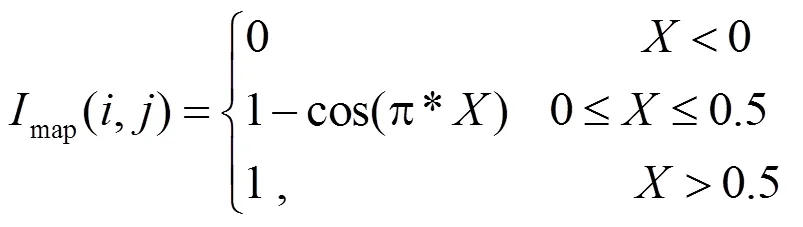

通过显著区域权重可以更好地保留红外图像的热目标,并且所保留的红外目标边缘清晰,不会出现文献[14-15]中模糊问题,显著区域权重构建方法为:

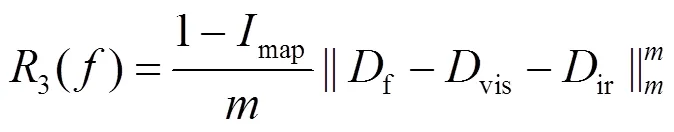

对于背景区域,我们目的是让红外图像和可见光图像中的细节信息能够更加充分地融入到融合图像中,而图像细节信息可以通过梯度进行表征,因此本文所提出的背景保真项为:

式中:表示梯度操作;f,vis和ir分别表示融合图像梯度,可见光图像梯度和红外图像梯度;表示采用的范数类型。

L2范数可以用来描述两幅图像之间的能量相似性,当融合结果与输入的能量差为高斯分布时,通常采用L2范数。因此对于保真项1和2我们采用L2范数即==2。由于图像的梯度在平坦区域通常是不变的或者是变化缓慢的,而在边缘或纹理区域则变化剧烈。因此,其梯度矩阵趋于稀疏,即存在大量的0值。故对于3我们采用更加鼓励稀疏的L1范数。最后,结合公式(1)、(2)、(4),将多波段图同步像融合任务建模为:

式中:1和2是权衡参数。

1.2 求解多波段同步融合模型

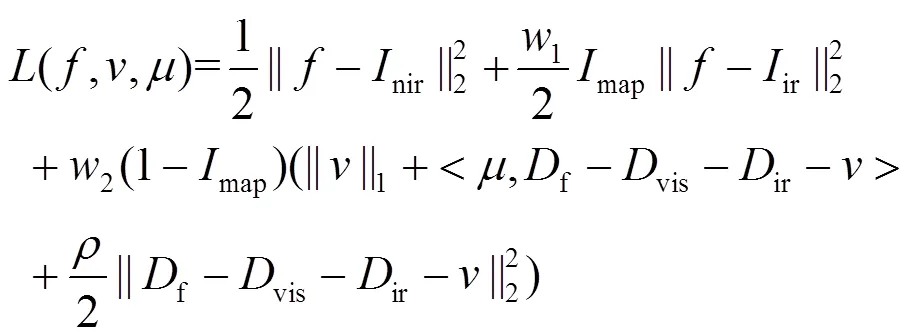

由于L1范数是一个不能直接求解的非凸函数。我们利用ADMM算法,通过变量分离求解无约束公式。首先,引入辅助变量并且让=f-vis-ir来把无约束问题转为受约束问题,并且定义受约束问题的增广拉格朗日函数为:

式中:是拉格朗日乘子;>0为与约束相关的参数。

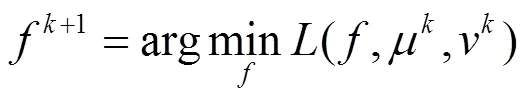

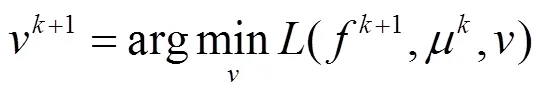

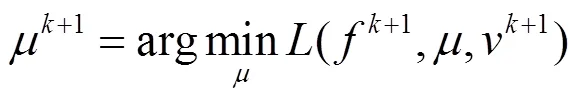

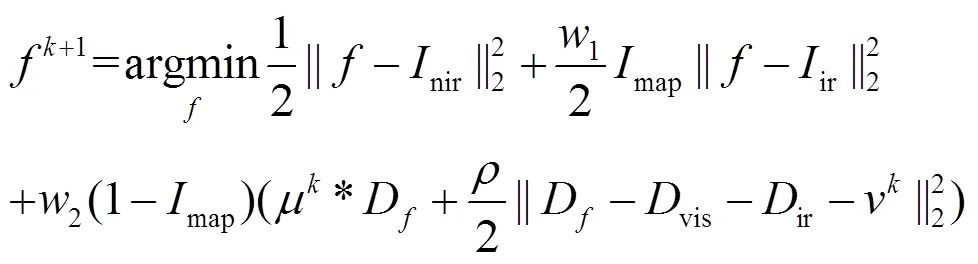

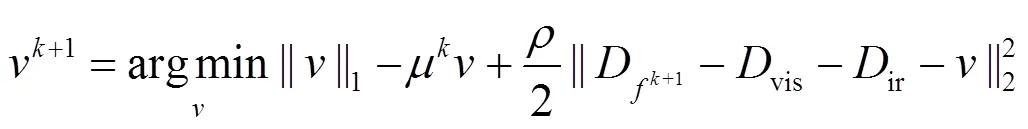

通过变量分离我们可以得到关于、和的3个子问题,它们以如下的ADMM迭代形式编写:

式中:代表迭代的次数。

接下来,我们需要根据每个子优化问题的具体情况分别找到它们的最优解。公式(7)的等价形式如下:

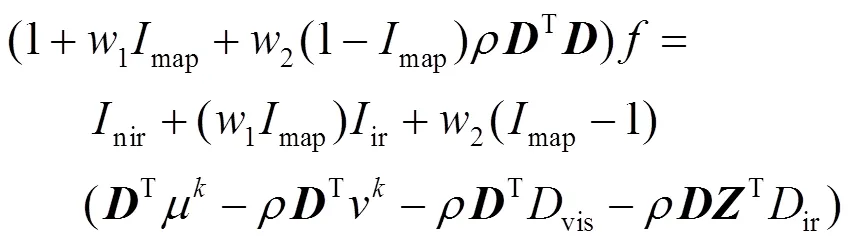

对于子问题,基于一阶最优性条件[17],该解应该满足以下方程式的要求:

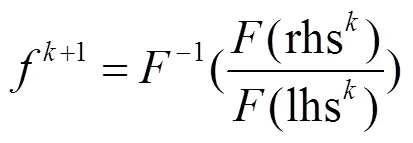

线性方程可以使用快速傅里叶变换求解如下:

式中:rhs=nir+(1map)ir+2(map-1)(Tk-Tk-Tvis-Tir);lhs=(1+1(map+2(1-(map)T);(×)代表快速傅里叶变换;-1(×)代表快速傅里叶逆变换。

公式(8)中的子问题可以写成如下等价形式:

子问题的解是一个封闭解,可以通过应用软收缩算子得到解,即:

而对于拉格朗日乘子,则可以通过下式获得其更新值:

模型求解的优化算法呈现在算法1中:

输入:多波段图像细节层(ir,nir,vis)

1)初始化=0.01,tol=1e-4;

3)用公式(7)更新f+1;

4)用公式(8)更新v+1;

5)用公式(9)更新+1;

6)end while

输出:图像融合结果。

2 实验和结果分析

2.1 数据集和参数设置

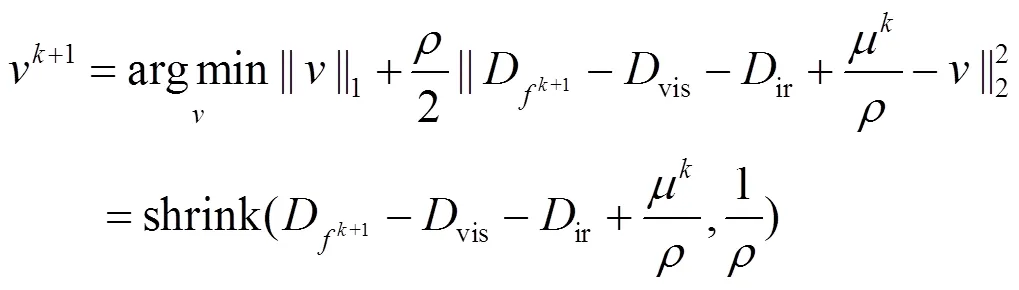

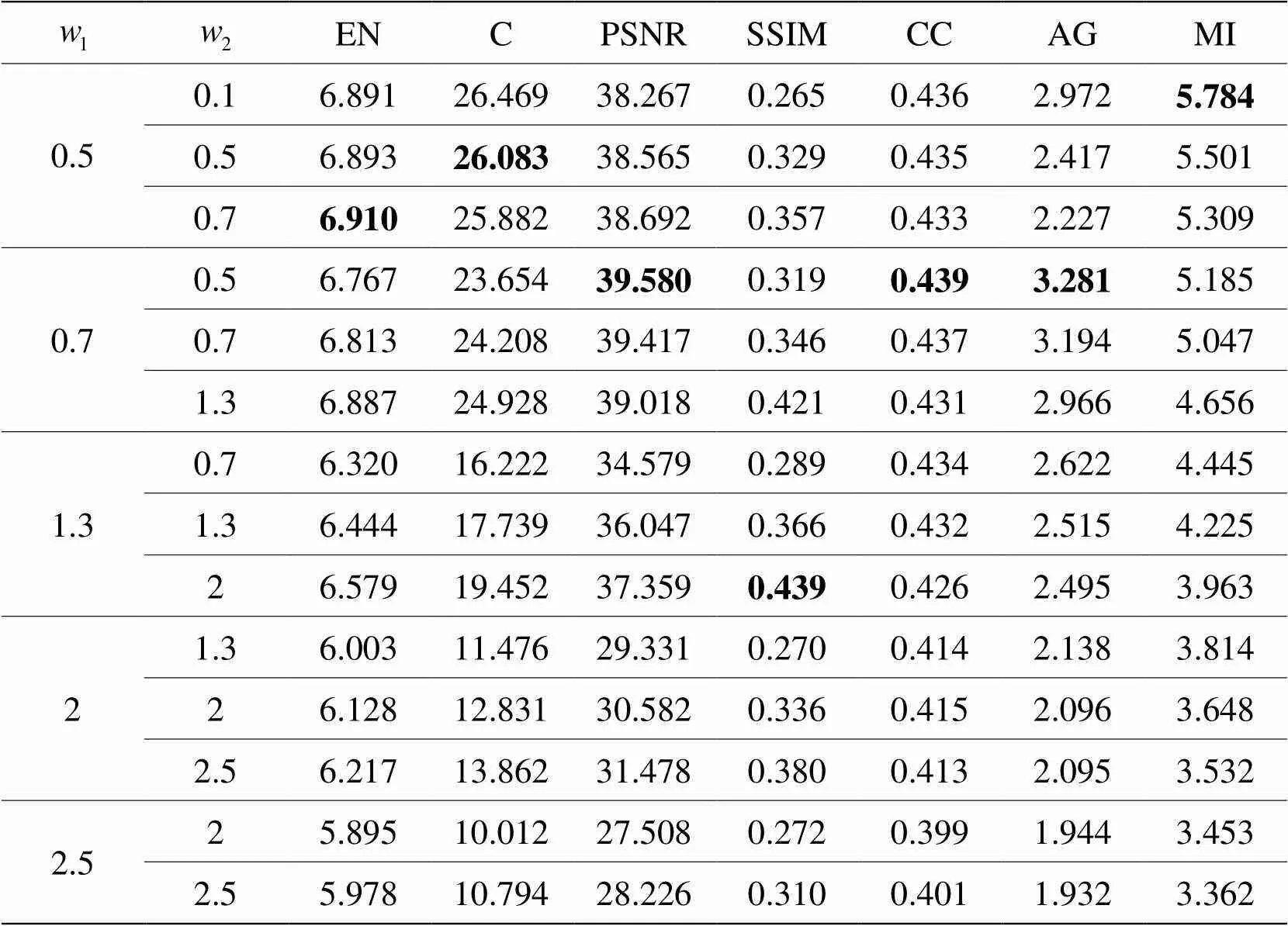

在本节中,我们通过对TNO数据集(包括红外长波、红外短波和可见光3个波段)进行实验,重点验证了所提算法的有效性。在公式(5)中1和2两个参数的取值对实验结果有影响,本文做了对比实验,结果如图2所示。从图可以看出1不变的情况下,2越大,则融合结果越趋近于可见光图像。当2不变的情况下,1越大,则融合结果越趋近于红外图像。故我们对主观评价较好的黄色框内图像进行客观指标评价如表1所示,可以看出当1=0.7,2=0.5时在比较多的指标上取得好的结果。基于这个结果,在接下来的实验中,我们将1设置为0.7,2设置为0.5。

2.2 结果分析

我们将本文方法与8种具有代表性的方法进行定性和定量比较。其中包括4种传统方法和4种基于深度学习的方法。传统方法有(gradient transfer fusion, GTF)[14],(dual tree-complex wavelet transform, DTCWT)[6],(nonsubsampled shearlet transform _ nonsubsampled contourlet transform, NSST_NSCT)[18],(anisotropic diffusion fusion, ADF)[19]。深度学习方法包括(model and data-driven, MDDR)[3],Dual Branch[20],U2Fusion[21],FusionGAN[22]。除了NSST_NSCT和MDDR其他方法都是适用于两个波段图像融合,这里通过两两序贯相融的方式转换为三波段图像融合。考虑到序贯式调用融合模型时,源图像输入顺序不同会有不同融合结果,这里统一选用最好的融合结果进行讨论。

2.2.1 定性比较

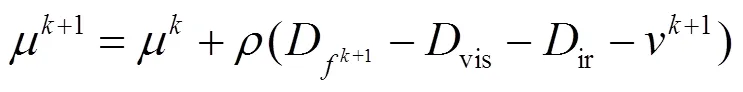

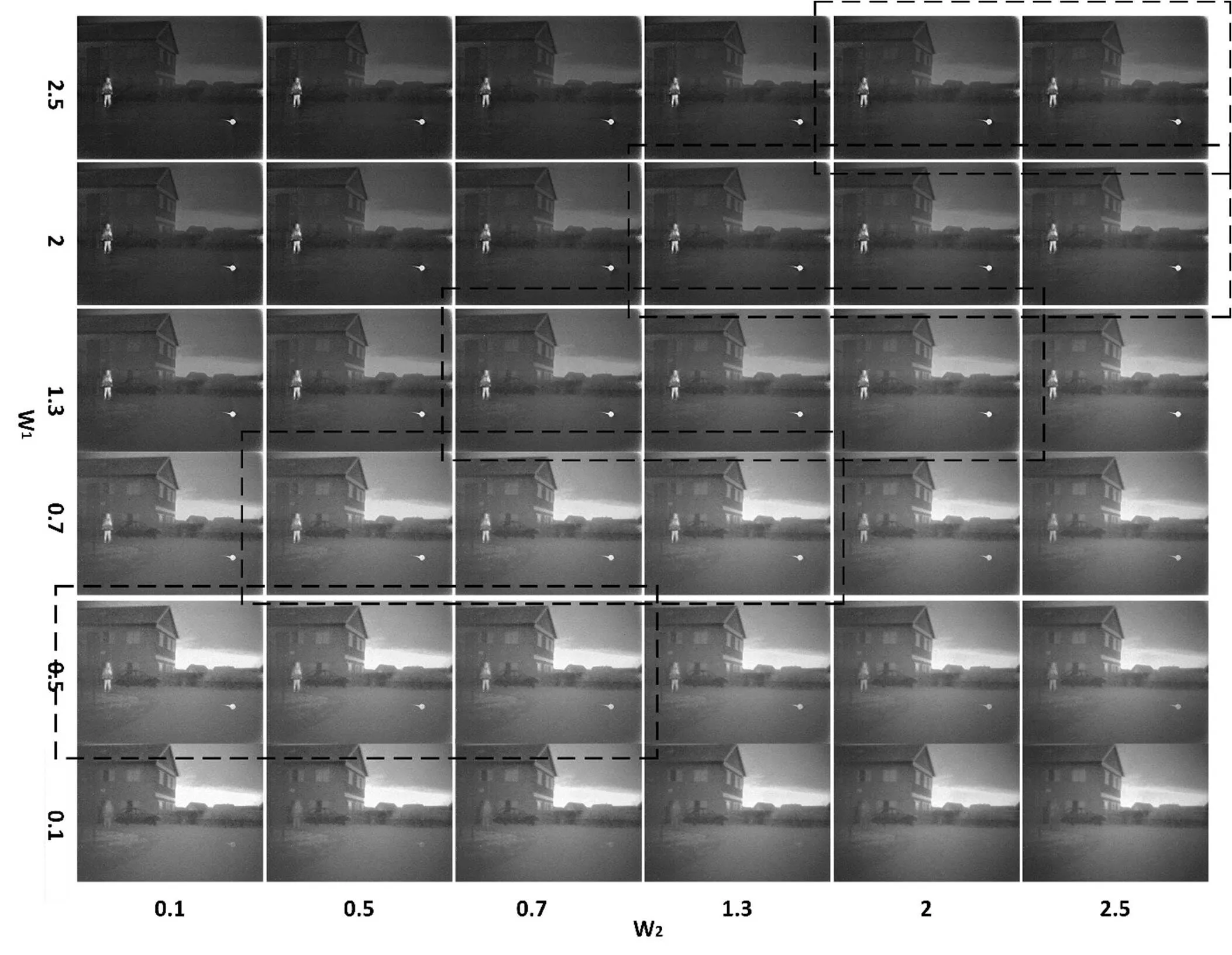

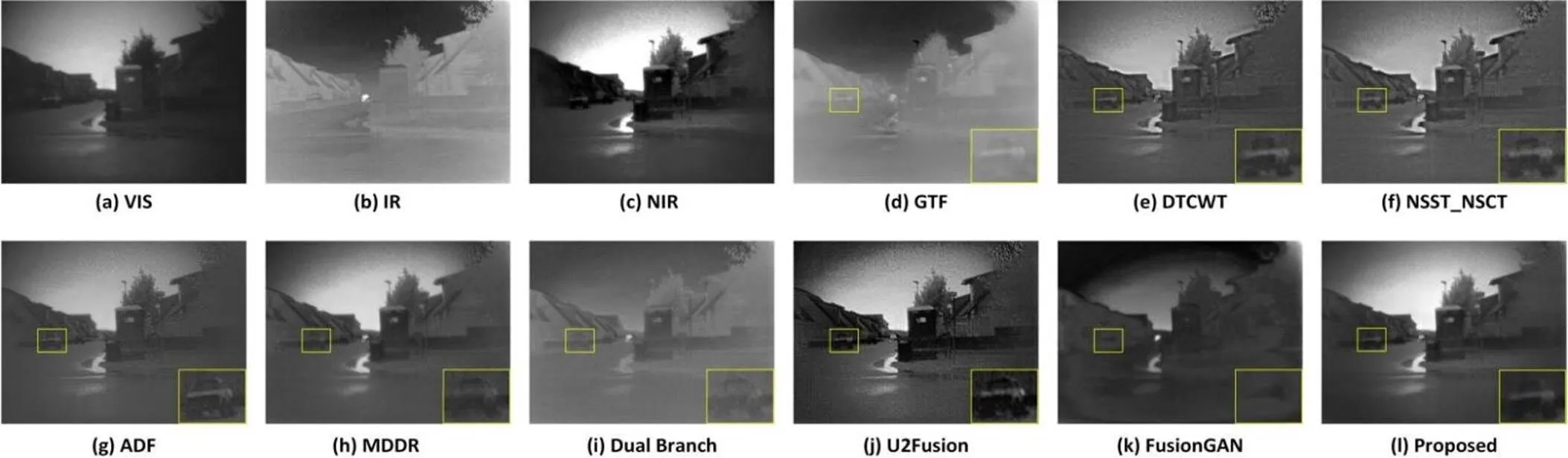

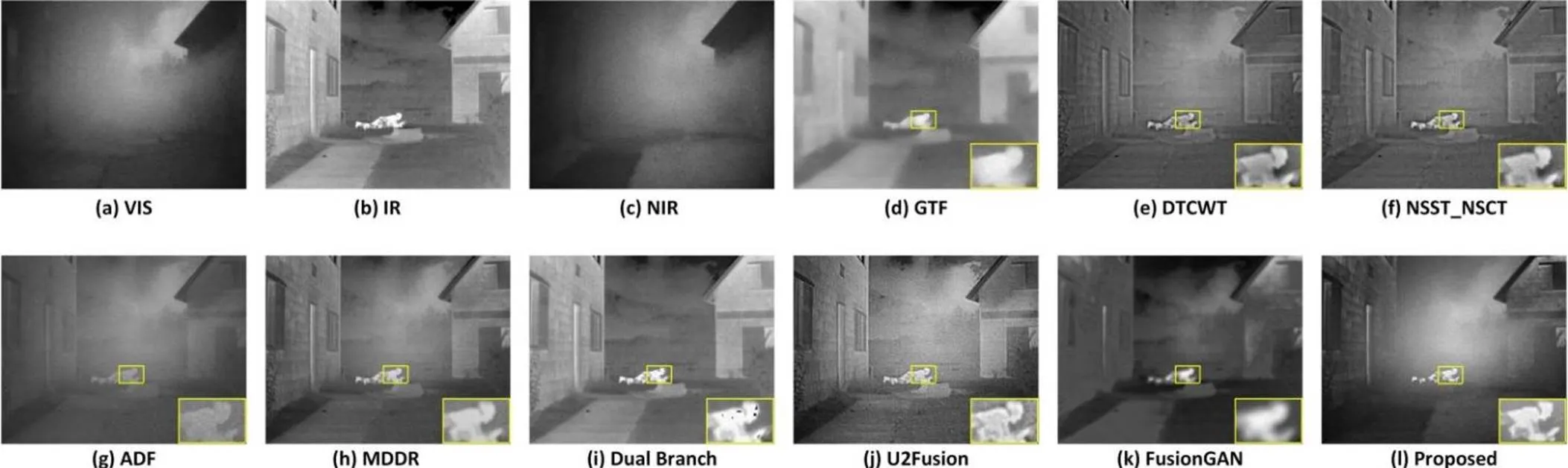

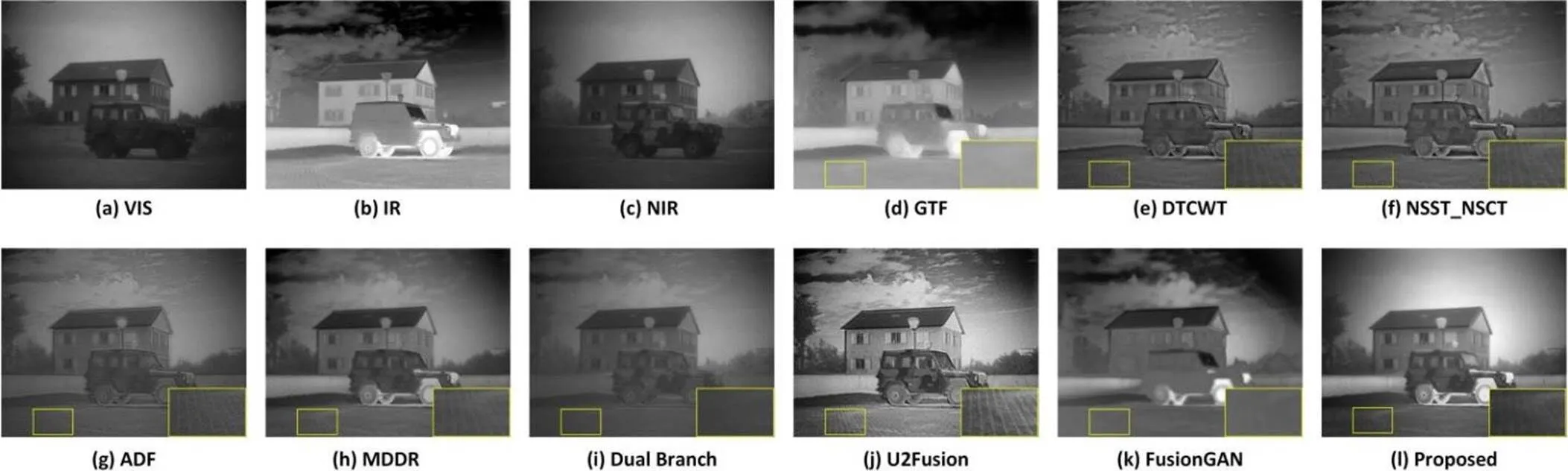

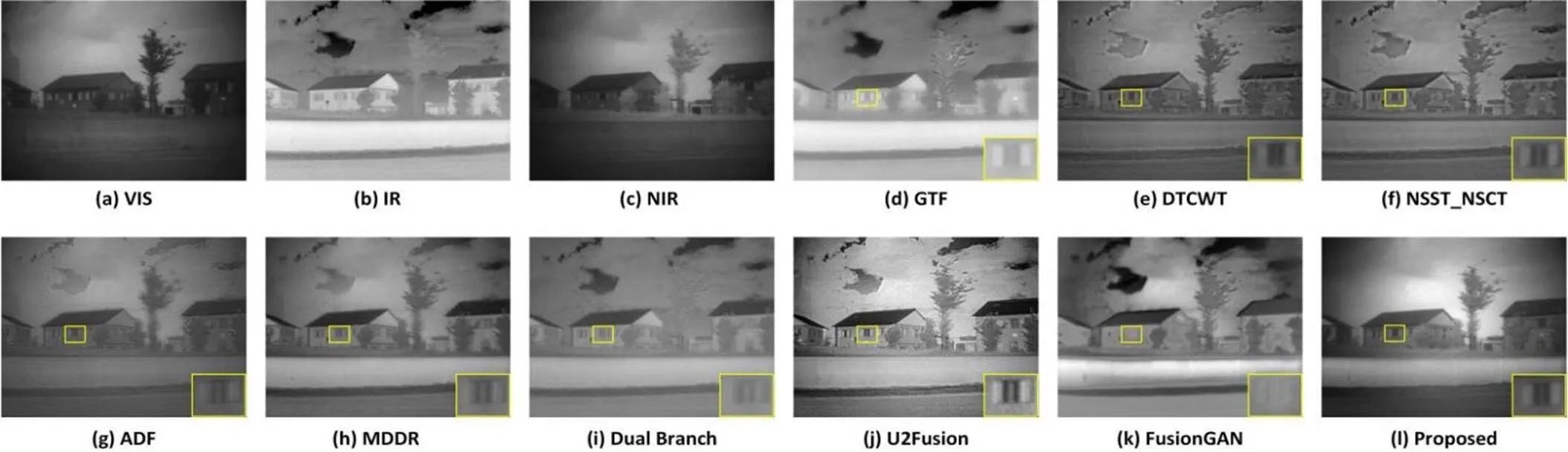

首先进行定性实验。如下显示了5个典型图像对的直观结果。与现有的方法相比,本文方法有3个明显的优势。第一,我们的结果可以清楚地保留和突出红外图像中的显著目标,如图3、图4和图5所示,人物与环境的对比度高,这有利于目标的检测。第二,我们的结果可以很大程度保留原始图像的细节纹理信息,如图6所示,这有利于后续的目标识别和提高识别的精度。第三,我们的结果能够很好地突显图像的对比度,如图7所示,这更加符合人的视觉感受。

图2 不同w1和w2取值融合结果

表1 图2中虚线区域客观评价指标

图4 “Movie_01” 图像融合结果

图5 “soldier_behind_smoke” 图像融合结果

图6 “Marne_04” 图像融合结果

图7 “Marne_06”图像融合结果

FusionGAN和GTF虽然可以很好地突出显著目标,但是从图3和图5可以看出其存在显著目标边缘模糊问题,并且GTF不能很好保留细节信息。U2Fusion虽然能够突出显著区域,并且细节信息也能很好保留,但是融合结果中会引入许多噪声。DTCWT和NSST_NSCT虽然能够很好地保留细节信息但是不能很好突出显著目标。ADF和Dual Branch图像整体对比度低,不够明显。MDDR虽然达到了较好的融合结果,但是清晰度低。相比之下本文提出的方法在突出红外显著目标和保留微小的细节信息上有强的竞争力。

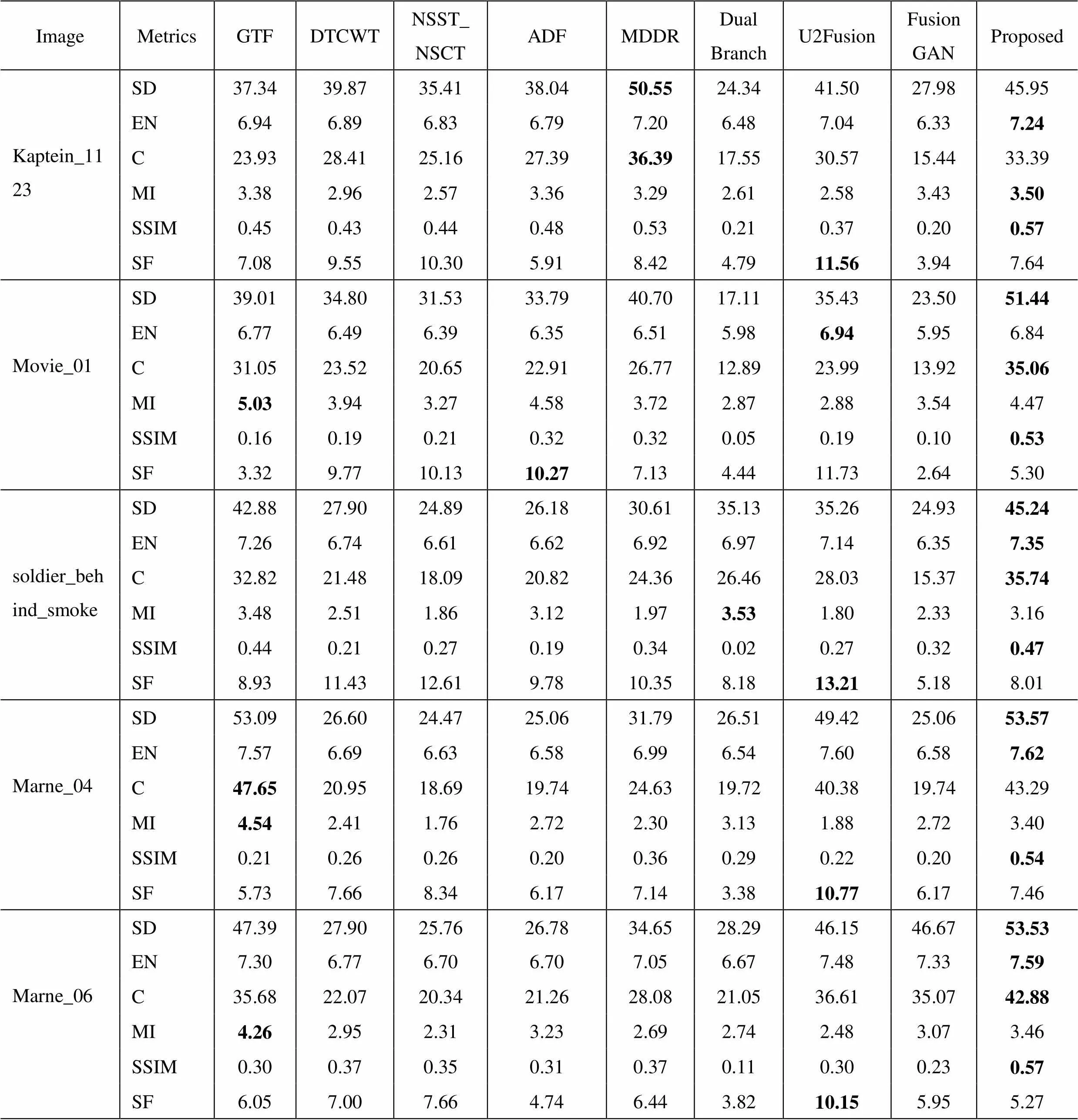

2.2.2 定量比较

为了评价所提方法的有效性,我们比较了所有方法和所提方法在标准差(SD)、熵(EN)、对比度(C)、互信息(MI)、结构相似度(SSIM)和空间频率(SF)这6个指标上的表现。结果如表2所示,其中最佳值为粗体显示。U2fusion在SF指标上都是取得最佳值,但是从图像可以看出U2Fusion的结果噪声比较大,这对SF指标有很大的影响。本文提出的方法在各指标上表现出色,其中SD和EN指标表现好,说明本文方法包含更多的信息,C指标比较高说明我们方法对比度高,SSIM指标表现好说明有更多的源图像信息被传输到融合结果中。这些客观评价都与主观评价相符,说明本文所提出的方法能够很好地保留源图像显著信息和细节信息,并且对比度高,图像更加符合人眼视觉特性。

3 结论

本文提出了一种基于显著性的多波段图像同步融合模型,通过基于视觉显著的红外显著区域提取来构造权重图,对模型进行约束,以克服融合结果显著区域不突出和边缘模糊问题。根据模型特点采用ADMM算法进行模型求解。实验证明了该算法的可行性和有效性。这些实验表明,融合结果能够突出红外显著目标,并且具有丰富的细节,同时保证不会出现伪影或模糊,是一种行之有效的方法。

表2 各算法评价指标

[1] LIU Y, LIU S, WANG Z. A general framework for image fusion based on multi-scale transform and sparse representation[J]., 2015, 24: 147-164.

[2] YU B, JIA B, DING L, et al. Hybrid dual-tree complex wavelet transform and support vector machine for digital multi-focus image fusion[J]., 2016, 182: 1-9.

[3] LIN S, HAN Z, LI D, et al. Integrating model-and data-driven methods for synchronous adaptive multi-band image fusion[J]., 2020, 54: 145-160.

[4] ZHANG H, LE Z, SHAO Z, et al. MFF-GAN: an unsupervised generative adversarial network with adaptive and gradient joint constraints for multi-focus image fusion[J]., 2021, 66: 40-53.

[5] Toet A. Image fusion by a ratio of low-pass pyramid[J]., 1989, 9(4): 245-253.

[6] Lewis J J, O’Callaghan R J, Nikolov S G, et al. Pixel-and region-based image fusion with complex wavelets[J]., 2007, 8(2): 119-130.

[7] Nencini F, Garzelli A, Baronti S, et al. Remote sensing image fusion using the curvelet transform[J]., 2007, 8(2): 143-156.

[8] Vishwakarma A, Bhuyan M K. Image fusion using adjustable non-subsampled shearlet transform[J]., 2018, 68(9): 3367-3378.

[9] LI H, CEN Y, LIU Y, et al. Different input resolutions and arbitrary output resolution: a meta learning-based deep framework for infrared and visible image fusion[J]., 2021, 30: 4070-4083.

[10] ZHANG H, LE Z, SHAO Z, et al. MFF-GAN: an unsupervised generative adversarial network with adaptive and gradient joint constraints for multi-focus image fusion[J]., 2021, 66: 40-53.

[11] MA J, LE Z, TIAN X, et al. SMFuse: multi-focus image fusion via self-supervised mask-optimization[J]., 2021, 7: 309-320.

[12] WANG B, ZHAO Q, BAI G, et al. LIALFP: multi-band images synchronous fusion model based on latent information association and local feature preserving[J]., 2022, 120: 103975.

[13] NIE R, MA C, CAO J, et al. A total variation with joint norms for infrared and visible image fusion[J]., 2021, 24: 1460-1472.

[14] MA J, CHEN C, LI C, et al. Infrared and visible image fusion via gradient transfer and total variation minimization[J]., 2016, 31: 100-109.

[15] MA Y, CHEN J, CHEN C, et al. Infrared and visible image fusion using total variation model[J]., 2016, 202: 12-19.

[16] WANG B, BAI G, LIN S, et al. A novel synchronized fusion model for multi-band images[J]., 2019, 7: 139196-139211.

[17] Ng M K, WANG F, YUAN X, et al. Inexact alternating direction methods for image recovery[J]., 2011, 33(4): 1643-1668.

[18] Moonon A U, HU J. Multi-focus image fusion based on NSCT and NSST[J]., 2015, 16(1): 1-16.

[19] Bavirisetti D P, Dhuli R. Fusion of infrared and visible sensor images based on anisotropic diffusion and Karhunen-Loeve transform[J]., 2015, 16(1): 203-209.

[20] FU Y, WU X J. A dual-branch network for infrared and visible image fusion[C]//25t(ICPR), 2021: 10675-10680.

[21] XU H, MA J, JIANG J, et al. U2Fusion: A unified unsupervised image fusion network[J]., 2020, 44(1): 502-518.

[22] MA J, YU W, LIANG P, et al. FusionGAN: a generative adversarial network for infrared and visible image fusion[J]., 2019, 48: 11-26.

Saliency-based Multiband Image Synchronization Fusion Method

YU Dong1,LIN Suzhen1,LU Xiaofei2,LI Dawei3,WANG Yanbo1

(1.,,030051,; 2.,735305,; 3.,,030051,)

To address the problem of low contrast and inconspicuous salient objects in multi-band image fusion, this paper presents a saliency-based multiband image synchronous fusion method. First, a near-infrared image was used as a data fidelity item, and infrared and visible light images provided salient and detailed information on the results of fusion, respectively. Second, a visual saliency-based infrared salient region extraction method was used to construct a weight map to overcome unsalient regions and blurred edges in the results of fusion. Finally, the alternating direction method of multipliers (ADMM) was used to solve the model and obtain the results of fusion. The research results showed that, compared with a representative image fusion algorithm, the proposed algorithm retained the thermal radiation information of the infrared image while retaining clearer details, and was better in many objective evaluation indicators.

image fusion, multi-band images, saliency, total variation

TP391.41

A

1001-8891(2022)10-1095-08

2022-03-16;

2022-04-25.

余东(1995-),男,硕士研究生,研究方向为图像融合,E-mail:844913898@qq.com。

蔺素珍(1966-),女,教授,博士,硕士生导师,研究方向为红外弱小目标检测,图像融合,E-mail:lsz@nuc.edu.cn。