基于Yolov5s的作业现场阀门规范操作识别方法

2022-05-30赵崇志邢金台董金平

赵崇志,卢 俊,田 源,邢金台,董金平,张 蕾,田 枫

(1.中国石油天然气股份有限公司冀东油田分公司,河北 唐山 063004;2.东北石油大学 计算机与信息技术学院,黑龙江 大庆 163318)

0 引 言

目前,油田阀门的规范操作识别的研究尚未相关报道,阀门规范操作的识别虽然属于行为识别,但是一方面,行为识别拥有其独特的特点,包括处理难度大、数据集样本少、检测速度慢、过于依赖于场景等问题,也使得行为识别与目标检测相比发展缓慢。当前行为识别领域也涌现出了各种不同的技术方法,比如Cao等人[1]提出了用于行为识别的最新OpenPose模型,与RMPE(regional multi-person pose estimation)模型[2]和Mask R-CNN(region-based convolutional neural network)模型[3]相比,该网络模型的优势在于大大缩短了关键点的检测周期,并保持检测精度基本不变。但是,它缺点是参数共享率低、冗余度高、时间成本长、模型太大,仍不能解决实际应用需求。

另一方面,基于深度学习的目标检测技术在识别行为方面展现了其优越性,邢予权使用基于手势识别目标检测的监控场景下抽烟识别,取得了不错的识别效果[4]。王春辉、王全民[5]使用改进的YOLOv3识别学生的“抬头”“低头”“说话”3种姿态,除满足识别的精度外,速度也能满足实时检测。邓永川[6]使用DSC-Net+YOLOv3的漏油检测方法,检测精度达到了96.22%,满足油田企业检测要求。基于以上两方面,该文选用深度学习目标检测方法解决阀门的规范操作识别,不仅保证了识别的精确度,并且速度也达到实时的视频智能监控。

目前,目标检测算法在深度学习领域可以分为两类,一是双阶段目标检测算法,其中包括最具有代表性的Faster R-CNN(faster region-CNN)[7];二是单阶段目标检测算法,代表的有YOLO(you only look once)[8]、单次多框检测(single shot multibox detector,SSD)[9]算法。2016年,Redmon J[8]提出了Yolo算法,可以一次性地识别图片内多个物品的类别和位置,实现了端到端的图像识别,运行速度快。此后,YOLO系列算法[10-12]逐步更新换代,最新提出的YOLOv5s相比于Faster R-CNN不仅速度快而且参数小,仅27 MB。

基于YOLOv5s的网络结构,该文提出了一种采用YOLOv5s深度学习算法的作业现场阀门规范操作识别的模型。自主拍摄阀门操作的数据集,并利用数据增强方式扩充数据集,然后将处理好的数据输入YOLOv5s网络训练,保存最优的训练权重数据,并用作测试集测试。测试结果表明,所用算法模型的检测速度和准确性都达到了油田作业现场的要求,智能监控系统部署后,阀门安全操作监管防护效果很好。

1 作业现场阀门规范操作识别方法

1.1 阀门识别原理

开关阀门是采油工生产中经常进行的最基本的操作内容,正确开关阀门不仅仅是确保人身安全的保障措施,还可以使阀门始终处于良好的使用状态,确保设备的安全运行。正确操作阀门时,人体应位于阀门手轮的侧面,随阀门位置高低不同,身体适当弯曲,头部在阀门侧上方30 cm左右。错误操作最危险的一种就是人体占位不同,应禁止人体直面阀门,这样会危及操作人员的人身安全。正确操作和错误操作阀门如图1所示。二者差别很大,可以使用目标检测进行识别。

图1 阀门操作示意图

油田作业现场工作人员阀门的操作识别主要由数据集获取、模型训练和错误操作报警三部分完成。数据集获取是使用海康威视摄像头采集工作人员阀门操作的视频,接下来将获取到的视频利用python代码逐帧截取成图片,然后对图片进行数据增强和归一化处理;模型训练是指采用YOLOv5s网络训练处理好的数据集,且将训练好的模型用于智能监控视频系统,进行实时的检测任务;错误操作报警是指出现异常操作就进行报警提示,并将异常出现后的第一帧开始进行图片保存和视频保存,以备后续调查备案。识别流程如图2所示。

图2 识别流程

1.2 YOLOv5s网络框架

UItralytics团队在2020年提出了YOLOv5模型,其目标检测速度高达0.007 s,每秒可以处理140帧,同时结构更为小巧,有四个不同的版本[13],使得在模型的快速部署上具有极强的优势,只需简单调节一些网络的深度和宽度即可。与传统的网络相比[14],YOLOv5模型将网络分为检测区和候选区两个阶段,是一种直接利用回归网络实现目标检测的算法[3]。其在大部分目标检测任务中同时兼顾了速度和准确度。YOLOv5s的网络结构如图3所示。

图3 YOLOv5s网络结构

YOLOv5s目标检测网络以Focus结构为主干,而Focus结构,在YOLOv3和YOLOv4中并没有这个结构,其中比较关键是切片操作,并且YOLOv5s有两种CSP模块,一种是CSP1_X结构,其应用于Backbone主干网络,另一种是CSP2_X结构,其应用于Neck网络中,二者结合后进一步增强整个网络的学习能力;YOLOv5s网络颈部是采用PAN和FPN的结构,FPA是自上而下的,将高层特征通过上采样和低层特征作融合得到用于预测的特征图;PAN是一个自底向上的特征金字塔,其自底向上进行强定位特征的提取。二者相互促进,从不同的主干层对不同的检测层进行参数聚合;YOLOv5s头部继续沿用YOLOv4 的检测头,使用颈部的特征来预测边界框和类标签;YOLOv5s使用一个在线的数据增强策略增加输入图像可变性,丰富图像特征信息,包括Mosaic数据增强和自适应锚框计算以及自适应图片缩放。设计的目标检测模型可以实现更高的鲁棒性,同时,采用标签平滑和学习率余弦退火衰减等技术来优化网络训练过程[15]。

3.1 护理质量管理的信息化 信息技术的使用是当前护理质量管理走向科学化的必由之路。通过充分整合搜索引擎技术、数据库技术、分布存储技术等,设计医院护理质量信息化管理软件,包括数据录入、统计分析、实时反馈、重大案例分析、专家在线咨询、工作提醒、危重症护理实时监测、标准查询等护理质量管理资源共享模块,实现全市护理质量评价数据实时监测、动态评价、专家反馈以及护理质量改进的科学决策,研制开发护理风险危机管理系统,建立全市范围的护理安全管理共享平台,从而真正实现护理质量管理的自动化与智能化。

1.3 损失函数

YOLOv5s网络训练中的损失函数由三部分组成:边界框回归损失Lciou、分类的损失Lclass、置信度损失Lconf。当某个边界框内没有目标时,只计算置信度损失Lconf,若存在一个目标时,三个损失同时计算。三种损失函数学表达式为[16]:

通过交叉熵的方法计算置信度损失与分类损失,通过Lciou损失函数计算边界框回归损失,相比传统的损失函数,Lciou损失函数更多地关注预测边框和实际边框二者之间的位置和大小以及距离,进而提高了预测边框的准确度和速度。

2 数据预处理

2.1 数据采集

该文使用的是一个自制数据集,其被用在在作业现场阀门规范操作识别模型上,使用油田现场专业的海康威视摄像头拍摄工人对阀门操作,拍摄视频剪辑后,通过python代码处理视频获取每帧的照片,按1∶1的正样本和负样本选取2 000张阀门操作照片。

由于收集到的数据量很小,为了避免模型的过度拟合,提高模型的泛化能力,使用了随机角度旋转和随机亮度增强的方法以及大小不等的黑色遮挡策略扩充数据样本,因此训练后的网络模型能够满足栏杆遮挡,不同姿势的阀门操作识别需求,其数据增强示例见图4。

图4 数据增强

通过数据增强获得阀门操作图片5 000张,包含随机黑块遮挡、随机方向选择、随机亮度变化下阀门操作图片。图片数据中有两类阀门操作图片,总计2 500张正确操作图片,2 500错误操作图片,可以保证数据的丰富性,以及正负样本的平衡。

2.2 数据标注

在训练YOLOv5s 模型之前,应该对处理后的数据集进行标签标注。在实验中,使用了标签标注工具LableImage,设置正确操作阀门标签为operation,错误操作阀门标签为error operation,标签标注后被保存为xml数格式的文件,两个类别阀门操作的图片标签标记信息如图5所示。

图5 数据标注

标注后保存的xml标签内容见表1。表格中每一行的数据代表一个标注边框的位置信息,其中x、y、w、h分别代表标注框中心点的x 轴及y轴方向的坐标位置以及标注框的宽和高。实验进行模型训练,随机划分75%的数据集作为训练集,25%作为测试集。

表1 数据标注

3 试验与分析

3.1 试验配置

训练平台的参数配置越高,图形计算能力更强,模型训练的效果会更好。为了使模型达到良好的训练效果,在GPU上对YOLOv5s网络进行训练,YOLOv5s网络模型的训练平台的配置信息如表2所示。

表2 训练平台配置

处理好的自制数据集传入神经网络进行训练,训练设置的超参数如表3所示。

表3 超参数设置

3.2 模型评估

损失值是指由损失函数计算出的样本预测值和真实值之间的误差。损失值越小,预测效果越高。在网络训练结束后,会生成完整的训练日志,取日志中的部分数据进行折线图绘制,得到损失值折线图如图6所示。

图6 损失值曲线

从图6损失值曲线可以看出,随着迭代次数的增加,损失值开始逐渐减少。经过300次的迭代,损失值稳定在0.01,这证明网络模型的训练效果良好。

3.3 检测效果

为了验证模型的检测效果,在200张测试集上测试,得到如表4所示结果,结果表明YOLOv5s无论是在准确率还是mAP上,YOLOv5s表现能力更好。

表4 不同算法对比

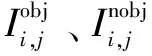

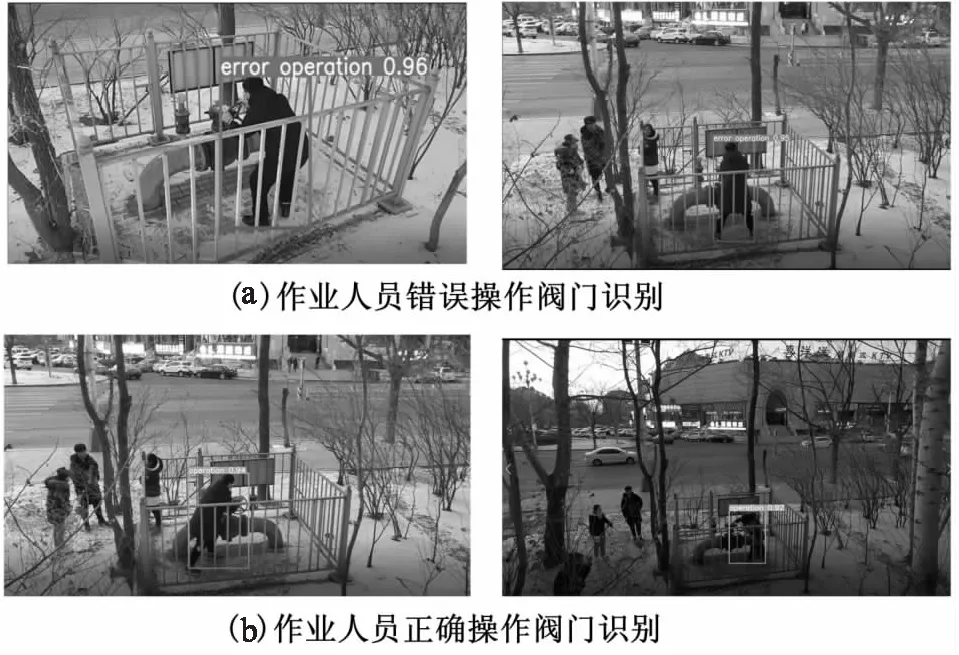

为验证基于YOLOv5s的作业人员阀门规范操作模型的可行性和实时检测能力,所以将模型嵌入到油田智能视频监控系统,使用海康威视相机在线获取作业人员阀门操作视频流,网络模型对获得的视频流进行实时检测,检测的效果见图7。

图7 检测效果图

由图7可知,该模型完成了对作业人员错误操作阀门的检测任务,检测准确率达到93%,能达到实时检测,能够满足智能监控系统下的作业人员阀门操作的识别。

4 结束语

为了解决人工的监控手段不能对阀门操作错误行为及时进行检测和发出预警,使得危险事故不能在较短时间之内得到有效妥善的处理的问题,文中提出了一种基于YOLOv5s 网络的作业现场阀门规范操作识别的模型,自己制作阀门操作数据集,通过图像增强方法解决阀门周围的栏杆遮挡问题,保证了数据集的丰富性。训练后的模型实际检测效果很好,检测准确率达到了93%,检测速度能达到实时的效果。