分级特征反馈融合的深度图像超分辨率重建

2022-05-28张帅勇刘美琴林春雨

张帅勇 刘美琴 姚 超 林春雨 赵 耀

近年来,深度信息在计算机视觉领域的应用越来越广.在远程医疗、无人驾驶以及安防监控等领域,深度信息可以显著地提升产品的性能.然而,受采集设备的限制,采集的深度图像分辨率比较低,如Mesa Swiss Ranger 4 000 采集的深度图像的分辨率仅为176×144,微软Kinect V2 采集的深度图像的分辨率为512×424,均难以满足实际需求.因此,如何由低分辨率深度图像重建高分辨率的深度图像已经成为当前多媒体领域的研究热点之一.

与深度图像相比,同一场景下的高分辨率纹理图像更容易获取,且二者之间存在着高度关联的结构相似性.因此,许多学者利用同一场景下高分辨率纹理图像所包含的先验信息,引导完成深度图像的超分辨率重建过程.如:在早期阶段,一般采用低通滤波器[1-8],这类方法实现简单,却会过滤掉大部分的高频信息,导致重建的深度图像出现边缘模糊现象.基于优化表示的方法[9-16]设计了相应的优化函数和正则项,约束边缘信息,充分考虑了深度-纹理的边缘相似性,但是手工设计的优化函数并不具有普适性,且求解最优化问题耗时巨大,难以满足实际应用的需求.

近年来,基于深度学习的方法在深度图像超分辨率重建领域的应用越来越广,按照是否利用纹理图像的引导信息大致可分为两类:单深度图像超分辨率算法和纹理图像引导的深度图像超分辨率算法.与图像超分辨率算法[17-21]类似,单深度图像超分辨率算法[22-23]通过构建卷积神经网络,学习从低分辨率深度图像到高分辨率深度图像的非线性映射关系,实现深度图像的超分辨率重建;基于纹理图像引导的深度图像超分辨率算法[24-29]通常采用上采样或者下采样的方式,获取丰富的层次特征,利用对应尺度下纹理图像提供的引导信息,完成深度图像的重建过程,如:Hui 等[25]构建了金字塔结构,输入的低分辨率深度图像经逐级采样后得到多尺度的特征表示,再融合对应尺度的纹理特征;Guo 等[29]采用U-Net 结构对插值后的深度图像进行编码,在解码过程中融合对应尺度的纹理特征.这两种特征融合结构以串联方式从低尺度到高尺度地逐步重建高分辨率的深度图像,均可以提取丰富的层次特征信息,却未能有效利用多尺度特征间的关联性进行特征融合.

针对以上问题,本文充分考虑了不同尺度间深度图像与纹理图像的结构相似性,提出了一种基于分级特征反馈融合策略的深度图像超分辨率重建算法,并相应地设计了一种端到端的分级特征反馈融合网络(Hierarchical feature feedback network,HFFN).HFFN 网络采用了并行结构,结合单深度图像重建网络和深度-纹理融合特征增强网络分别提取深度图像和纹理图像的深层特征,获取深度图像与纹理图像隐含的结构信息;改进的金字塔结构,可以构建不同尺度下深度-纹理的分层特征表示;设计了一种分级特征的反馈式融合策略,实现并行金字塔不同层特征的反馈融合,搭建起不同尺度间深度-纹理特征信息传递的桥梁,充分挖掘不同尺度间深度-纹理的结构相似性;结合深度-纹理边缘特征,获取深度图像的边缘引导信息,生成边缘引导图像;采用残差学习的方式,将边缘引导图像与单深度图像重建网络的重建结果相加,以进一步提升深度图像的重建质量.实验结果表明,与对比方法相比,本文算法获得了高质量的深度图像重建结果.

本文的组织结构如下:第1 节简要回顾了深度图像的超分辨率重建算法;第2 节具体介绍了HFFN网络的整体框架;第3 节详细给出了对比实验及分析结果;第4 节总结全文.

1 相关工作

深度图像超分辨率重建算法主要包括基于滤波、优化表示和深度学习三类.

1.1 基于滤波的深度图像超分辨率算法

基于滤波的深度图像超分辨率算法大多利用低通滤波器,在上采样过程中采用与深度图像点-点相关的纹理图像的高频信息,恢复深度图像的边缘信息.如,Lei 等[3]利用深度-纹理间的相似性,构建了一种三边上采样滤波器;Yang 等[4]利用同场景纹理图像确定了像素上采样过程中的权值,提出了一种自适应权值滤波的深度图像超分辨率算法;Lu 等[5]在稀疏深度样本的指导下分割纹理图像,恢复每个子图像中的深度值,利用了纹理边缘与深度边缘之间的依赖关系;He 等[6]通过建立引导图像与输出之间的线性关系对目标图像进行引导滤波,相比双边滤波器保留了更多的边缘细节;Barron 等[7]提出了一种新的边缘感知平滑算法双边求解器,实现纹理图像引导下的深度图像快速超分辨率重建;Yang 等[8]面向三维视点合成,利用深度-纹理相似性构建了像素级的置信度计算方法,构造了基于置信度的联合引导滤波器,不仅考虑了深度像素间的平滑性,而且融入了深度-纹理的相似性,提高了深度图像上采样的性能及合成视点的质量.

1.2 基于优化表示的深度图像超分辨率算法

基于优化表示的深度图像超分辨率算法是构建一种深度-纹理的联合表示,以字典或稀疏表示的方式学习深度-纹理间的映射.如,Diebel 等[9]用马尔科夫随机场 (Markov random field,MRF)将低分辨率深度图像与高分辨率纹理图像集成后进行上采样操作;除应用MRF 以外,An 等[10]通过正则项局部误差均值自适应地计算平衡正则项和保真项的正则化参数矩阵,较好地保持了边缘信息;Park 等[11]采用非局部方法对深度图像进行正则化,改善了深度图像的细节;Yan 等[12]采用非局部均值算法先获取初始上采样深度图像,再利用边缘检测算法对其优化,提高了深度图像的重建质量;Yang 等[13]采用自适应回归模型,通过纹理图像的引导自动生成超分辨率深度图像;Ferstle 等[14]提出了一个深度图像超分辨率重建的凸优化问题,利用纹理图像计算出各向同性扩散张量,指导深度图像的上采样过程;Li 等[15]基于加权最小二乘法和快速全局平滑技术,提出了一种分层、多遍的全局优化框架,避免了不必要的纹理复制伪影;Kiechle 等[16]构建了一种双模共稀疏分析模型,能够捕捉到纹理图像与深度图像之间的相互依赖关系,实现深度图像的超分辨率重建.

1.3 基于深度学习的深度图像超分辨率算法

近年来,卷积神经网络在图像超分辨率重建领域取得了显著的成就.Dong 等[17]首次提出了端到端的SRCNN (Super resolution convolution neural network) 网络,直接学习从低分辨率到高分辨率的映射关系,解决了基于深度学习的图像超分辨率重建问题;Shi 等[18]和Lim 等[19]改进了SRCNN,加深了网络的深度;Zhou 等[20]和Zhang 等[21]利用了递归残差网络,在提高超分重建质量的同时限制了模型参数,有效降低了计算复杂度.

不同于直接堆叠卷积层,Huang 等[22]采用基于深度密集残差网络实现金字塔结构的深度图像超分辨率重建网络,利用不同层次特征逐步重建高分辨率的深度图像;Song 等[23]利用通道注意力机制,实现了深度图像超分辨率重建网络,从粗到细地恢复深度图像的高频分量;Zhao 等[24]提出了纹理-深度条件生成对抗网络,学习纹理图像和低分辨率深度图像之间的结构相似性;Hui 等[25]提出了多尺度引导卷积网络MSG (Multi-scale guided convolutional network),利用丰富的分层纹理特征,消除了深度图像重建后存在的模糊现象;Zuo 等提出了纹理引导增强的残差稠密网络RDN-GDE[26](Residual dense network for guided depth enhancement)和多尺度融合残差网络MFR-SR[27](Multi-scale fusion residual network for depth map super resolution),探究如何利用纹理图像提供的多尺度引导信息,逐步指导深度图像的上采样重建;Ye 等[28]提出了渐进的多分支聚合网络PMBA (Progressive multi-branch aggregation network),利用多分支融合方式逐步恢复退化的深度图像;Guo 等[29]提出了深度图像超分辨率重建网络DepthSR (Hierarchical features driven residual learning for depth map super resolution),利用U-Net 残差深层网络,获取多尺度的结构信息,完成深度图像的超分辨率重建.

2 分级特征反馈融合网络

2.1 网络结构

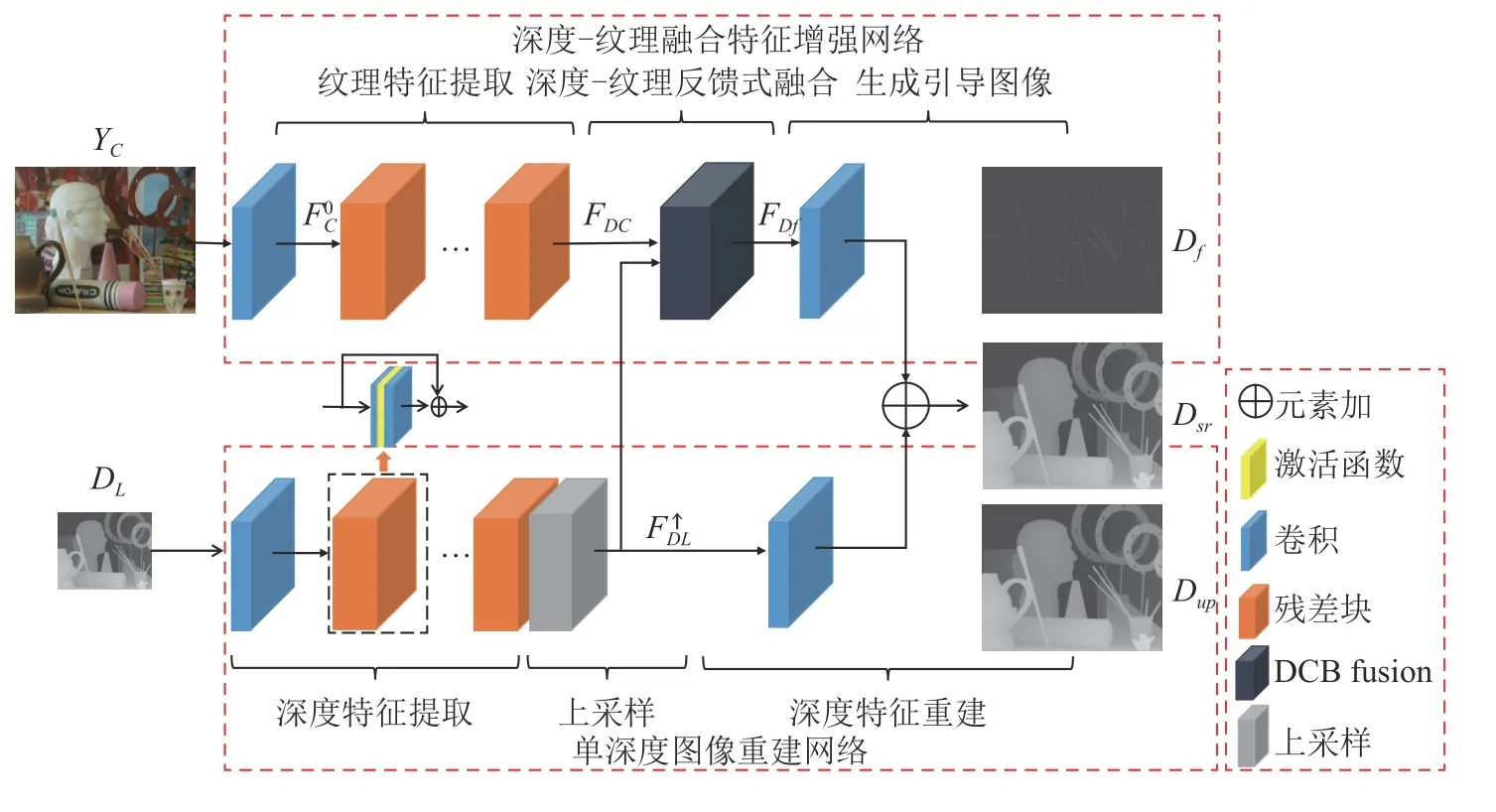

本文提出的分级特征反馈融合网络HFFN(如图1 所示)采用并行结构,由单深度图像重建和深度-纹理融合特征增强两个子网络构成.首先,两个子网络分别提取低分辨率深度图像和高分辨率纹理图像的深层特征,构建深度-纹理的深层特征表示.其次,利用并行金字塔结构,设计深度-纹理反馈式融合模块(Depth-Color feedback fusion module,DCF),提取深度-纹理在不同尺度下的结构信息,构建深度-纹理的多尺度分层特征表示;应用反馈式融合策略,挖掘不同尺度下深度-纹理隐含的关联性,生成包含多级感受野的边缘引导信息.最后,由边缘引导信息生成的边缘引导图像,与单深度图像重建网络的重建结果相加,实现深度-纹理的引导重建过程,获得纹理图像引导的高分辨率深度图像的重建结果.

图1 分级特征反馈融合网络Fig.1 Hierarchical feature feedback network

2.2 深度-纹理深层特征表示

由于深度图像和纹理图像表征的内容不同,采用同一网络将难以区分所提取的纹理图像和深度图像的信息.因此,HFFN 网络利用单深度图像重建网络和深度-纹理融合特征增强网络,提取低分辨率深度图像DL和高分辨率纹理图像YC的深层特征FDL和FDC.子网络的特征提取模块均由一个卷积层和M个残差块[19]组成,每个残差块包含一个线性整流激活函数 (Rectified linear unit,ReLU)和两个卷积层.

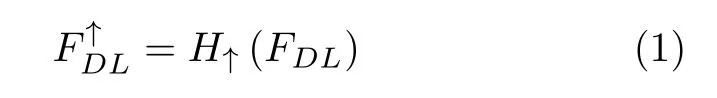

为了降低运算复杂度,特征提取阶段的输入为低分辨率的深度图像,在特征融合阶段,深度图像和纹理图像的深层特征会出现空间不匹配的问题.因此,深度图像的深层特征FDL需经上采样操作后才能与纹理特征FDC融合,以便学习二者的相关性.单深度图像重建网络采用亚像素卷积层[18]H↑上采样FDL,生成与纹理图像空间一致的深层特征,构建相应的深度-纹理深层特征表示,如式(1)所示:

2.3 深度-纹理反馈式融合模块

由文献[25-29]可知,多级别的感受也可以获取丰富的层次特征信息.因此,本文构建深度-纹理反馈式融合模块DCF,提取深度-纹理的分层特征表示,并利用分级特征反馈融合策略,充分融合深度-纹理在不同尺度下的特征,生成包含多级感受野的边缘引导信息,如式(2)所示:

其中,HDCB表示深度-纹理反馈式融合函数.

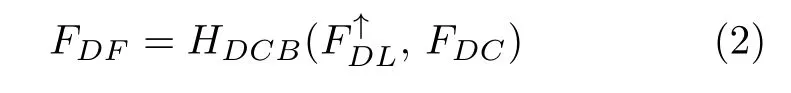

该模块包含多尺度分层特征构建子模块和特征融合反馈子模块,如图2 所示,图中的数字表示通道的数量.其中,多尺度分层特征构建子模块提取在不同尺度下的结构特征信息,构建深度-纹理的分层特征表示;融合特征反馈子模块对不同尺度下的结构特征进行融合反馈,丰富融合特征包含的结构信息.

图2 深度-纹理反馈式融合模块Fig.2 Depth-Color feedback fusion module

2.3.1 多尺度分层特征构建子模块

多尺度分层特征构建子模块通过并行金字塔结构获取深度-纹理图像的多尺度分层特征,以并行的方式构建深度-纹理的分层特征表示.为了避免因层数过高引起深度图像边缘结构的退化现象,多尺度分层特征构建子模块选用三层金字塔(1≤j ≤3)结构.具体地,第j-1 层的分层特征通过卷积提取其边缘结构信息,并利用最大池化层构建深度图像和纹理图像第j层的分层特征和,如式(3)和(4)所示:

多尺度分层特征构建子模块将并行金字塔每一层构建的分层特征传递到金字塔的下一层,以提供不同感受野下深度-纹理的层次特征信息.

2.3.2 特征融合反馈子模块

如何利用上文构建的多尺度分层特征获取深度图像的边缘引导信息,是重建高质量深度图像的关键.大多数算法[25-27]采用级联某一尺度下的深度特征和纹理特征的方式生成融合特征,显然无法有效利用深度-纹理图像间的结构相似性.因此,本文构建的特征融合反馈子模块基于分级特征反馈融合策略,在不同层间传递结构信息,并利用卷积自适应地分配不同层特征融合时的权重系数,用于提高不同尺度间特征的相容性.

其中,Wr和br分别表示生成边缘引导信息FDF时卷积的权重和偏置.

应用反馈式融合策略,特征融合反馈子模块可以挖掘不同尺度下深度特征与纹理特征潜在的关联性,生成包含多级感受野的边缘引导信息.

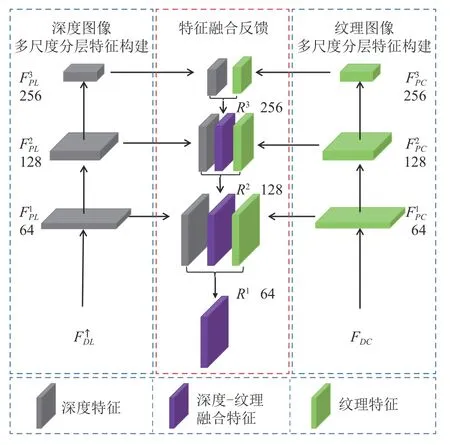

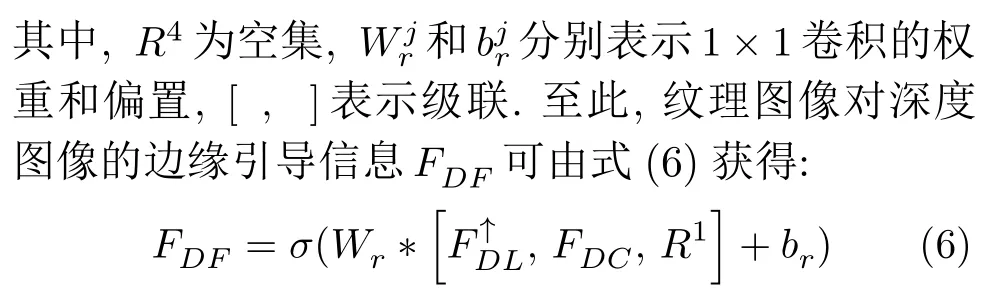

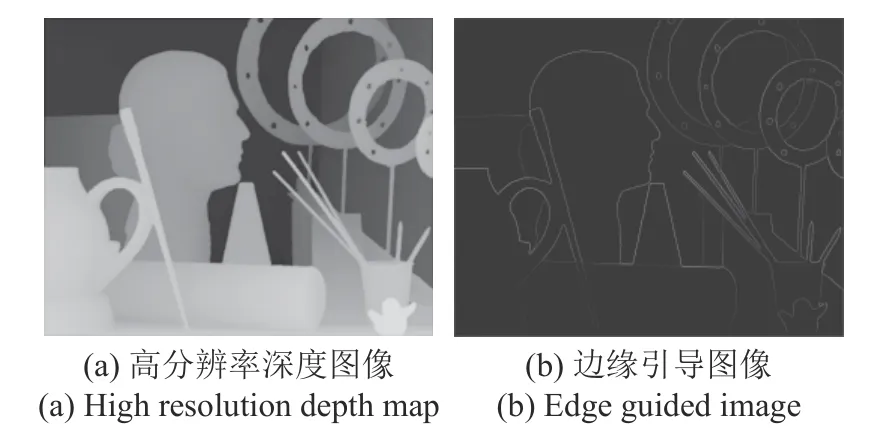

2.4 深度-纹理的引导重建

在构建单深度图像重建网络的基础上,本文算法通过深度-纹理融合特征增强网络生成深度图像的边缘引导图像,引导深度图像的重建过程.单深度图像重建网络的重建结果DUP如图3(a)所示,由提取的深度特征生成;深度-纹理融合特征增强网络的重建结果DF如图3(b)所示,包含丰富的边缘信息.

图3 特征重建结果Fig.3 Feature reconstruction results

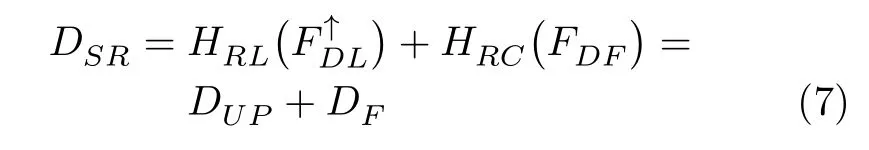

HFFN 网络采用残差学习的方式将DUP与DF相加,得到深度图像的超分辨率重建结果DSR,利用边缘引导图像进一步增强深度图像的边缘细节信息,如式 (7) 所示:

其中,HRL(·)表示高分辨率深度图像重建函数,HRC(·)表示边缘引导图像生成函数.

2.5 实现细节

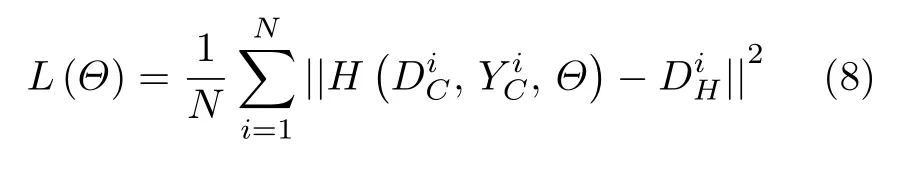

除标记参数的卷积层以外,HFFN 网络其他部分卷积核的大小为k=3,通道数为C=64,采用经典的均方误差(Mean square error,MSE) 作为训练模型的损失函数,如式 (8) 所示:

其中,Θ表示网络学习到的参数,H表示重建模型,N表示每批的训练样本数,N=16,初始的学习率lr=1×10-4,且在第60 个和第120 个周期时lr减半,共训练200 个周期.HFFN 网络采用ADAM 算法[30]进行优化,参数设为β1=0.9,β2=0.999,ε=1×10-8.本文实验在PyTorch 框架下使用一块NVIDIA 2080Ti 的GPU 卡完成.

3 实验

3.1 实验说明

训练集:本文采用与文献[22,25,29]相同的数据集,包含34 对来自于 “Middlebury 2001 Datasets”[31]、“Middlebury 2003 Datasets”[32]和 “Middlebury 2014 Datasets”[33](分辨率最小为432×368、最大为2 300×1 992)以及58 对来自于 “MPI Sintel depth”数据集[34](分辨率为1 024×436)的深度-纹理图像.其中,82 对深度-纹理图像作为训练集,10 对深度-纹理图像作为验证集.

测试集:为了评估不同算法的性能,本文从“Middlebury 2003 Datasets”[35]和 “Middlebury 2005 Datasets”[32,36]上选取10 对深度-纹理图像作为测试集.参考文献[25-27],测试集分为A (Art、Books、Moebius)、B (Dolls、Laundry、Reindeer)、C (Tsukuba、Venus、Teddy、Cones)三个部分.

数据处理:本文将原始深度图像DH经双三次插值算法下采样得到DL.在训练阶段,选取比例因子分别为2×、3×、4×、8×时,原始深度图像DH和纹理图像YC被分割成大小为128、144、128、128的块,对应的低分辨率深度图像DL被分割成大小为64、48、32、16 的块,并利用随机旋转和翻转操作扩大数据集.在训练阶段,HFFN 网络的输入为纹理图像和深度图像的Y 通道,输出为单通道的高分辨率深度图像.在测试阶段,采用均方根误差(Root mean square error,RMSE)和峰值信噪比 (Peak signal to noise ratio,PSNR)评价网络的超分辨率重建性能.

3.2 消融分析

3.2.1 参数分析

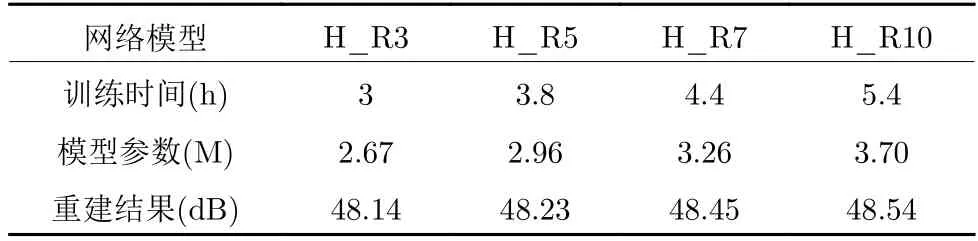

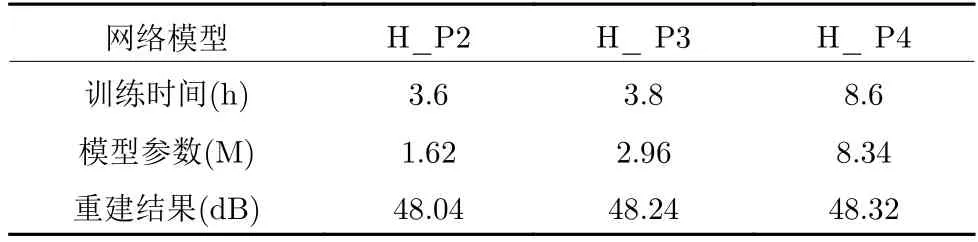

当比例因子为 4×时,本文评估特征提取模块残差块的数目、金字塔层数对HFFN 网络性能的影响分别如表1、表2 所示.

表1 残差块数目对HFFN 网络性能的影响Table 1 Influence of the number of residual blocks on the performance of HFFN

表2 金字塔层数对HFFN 网络性能的影响Table 2 Influence of pyramid layers on the performance of HFFN

在表1 中,网络模型H_R3、H_R5、H_R7、H_R10 分别表示Basic 网络中有3、5、7、10 个残差块,且金字塔层数为3.由表1 可知,随着残差块数目的增加,HFFN 模型重建结果的PSNR 值也随之增加.同时,残差块数目的增加也带来了网络模型训练时间和参数量的增长,如:模型H_R7 和H_R10比H_R5 的训练时间提高了0.6 h 和1.6 h、参数量提高了0.30 M 和0.74 M.因此,设置残差块超参不仅需要考量重建结果的PSNR 值,也需考虑模型的训练时间和参数量.

在表2 中,金字塔层数为2、3、4 对应的网络模型分别为H_P2、H_P3、H_P4,残差块数目为5.可以看出,模型H_P4 比H_P3 重建的PSNR 值提高了0.08 dB、参数量增加了5.38 M、训练时间增加了4.8 h;而模型H_P3 比H_P2 重建的PSNR值提高了0.20 dB、参数量增加了1.34 M、训练时间增加了0.2 h.

因此,在模型性能的验证阶段,本文均衡考虑了HFFN 模型的重建质量、计算复杂度及训练时间等因素,设置残差块数目为7、金字塔层数为3,不仅可以保证深度图像高分辨率重建质量,还可以控制网络模型的参数规模和训练时间.

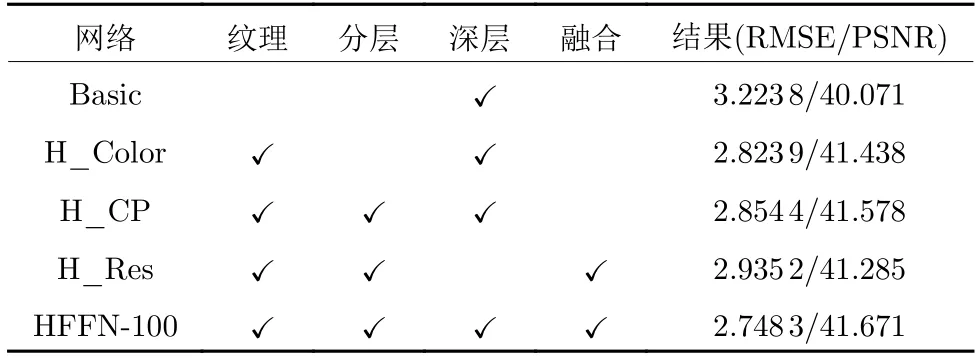

3.2.2 模型分析

为了验证HFFN 各部分的性能,本文将模型分为纹理、分层、深层和融合四部分.其中纹理表示引入纹理图像的先验信息;分层表示利用金字塔结构获取多尺度分层特征;深层表示采用深层网络提取深度-纹理图像的特征;融合表示加入自适应特征融合算法.基准网络Basic 包含五层残差块的单深度图像超分辨率重建网络,结构与文献[19]类似,相应构建的H_Color、H_CP 和H_Res 网络的配置及实验结果如表3 所示.

由表3 可知,对比Basic 网络、H_Color 网络、H_CP 网络和HFFN-100 网络的重建结果,HFFN-100 网络的性能最优,说明纹理图像、并行金字塔结构以及反馈式融合策略在深度图像超分辨率重建中的有效性;此外,H_Res 网络与HFFN-100 网络的实验结果表明,通过多层网络提取深度-纹理图像的深层特征,有利于挖掘深度图像与纹理图像隐含的关联性.

表3 消融分析结果Table 3 Results of ablation study

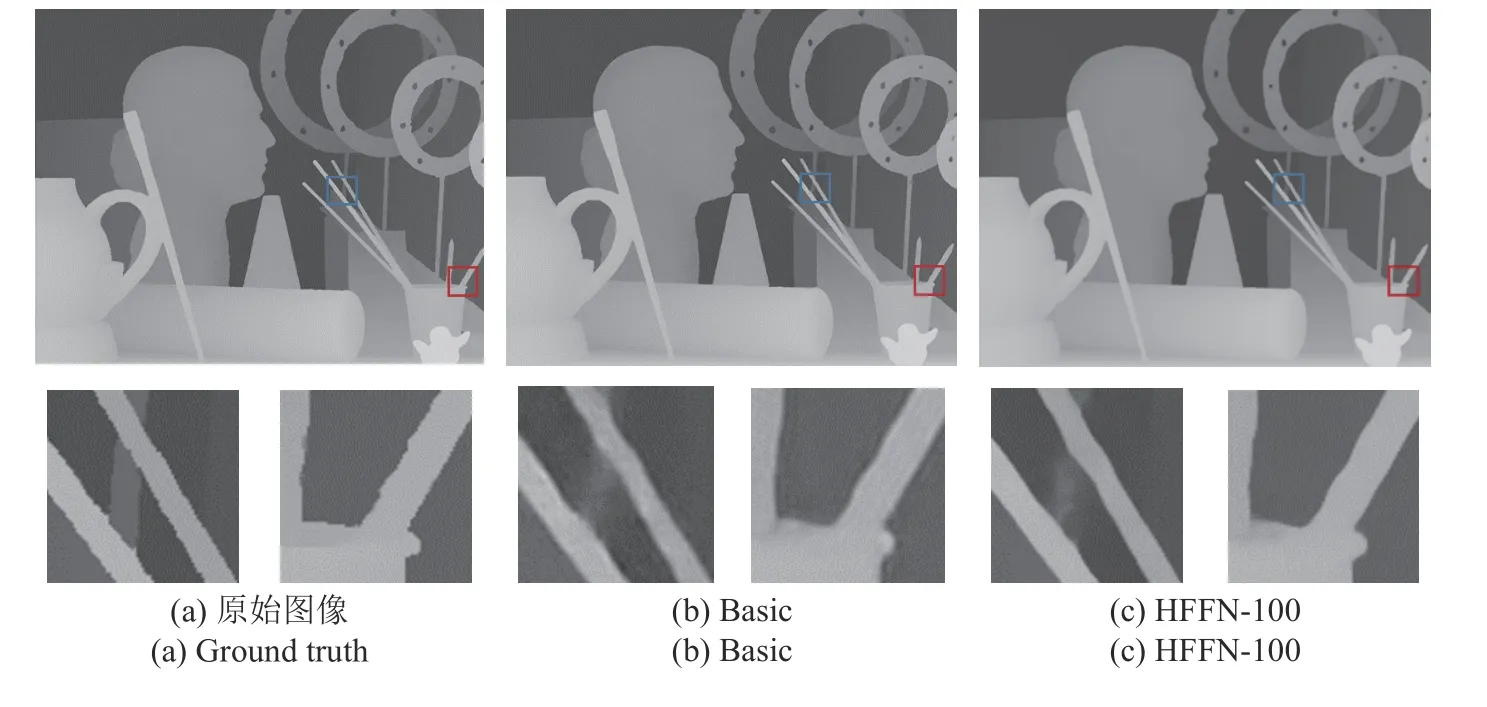

本文对比Basic 网络和HFFN-100 网络在 “Art”上的重建结果,以验证纹理图像在深度图像超分辨率重建中的作用,如图4 所示.由于缺失纹理图像提供的引导信息,Basic 网络的重建结果出现了伪影和噪点,见图4(b);图4(c)为HFFN-100 网络的重建结果,保留了更多的边缘细节信息.

图4 “Art”的视觉质量对比结果Fig.4 Visual quality comparison results of “Art”

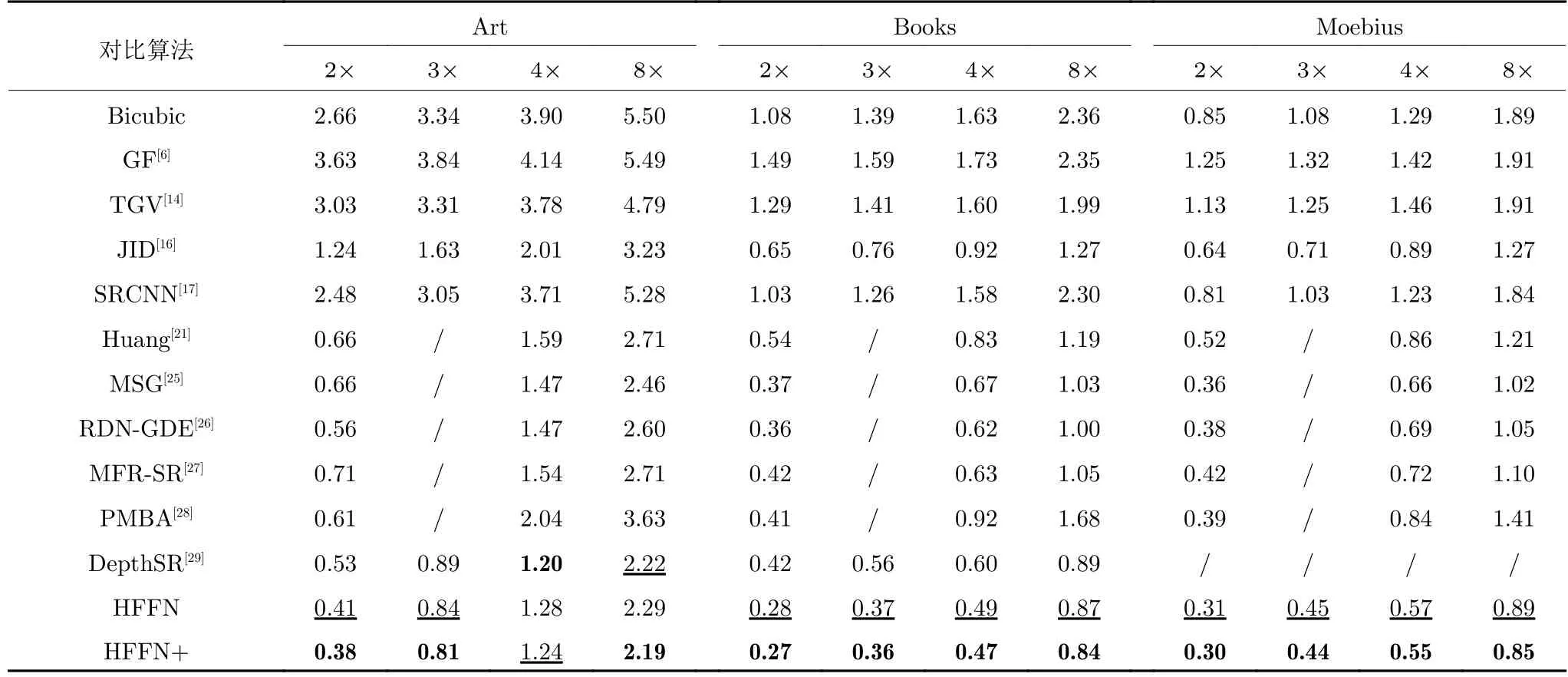

3.3 实验结果

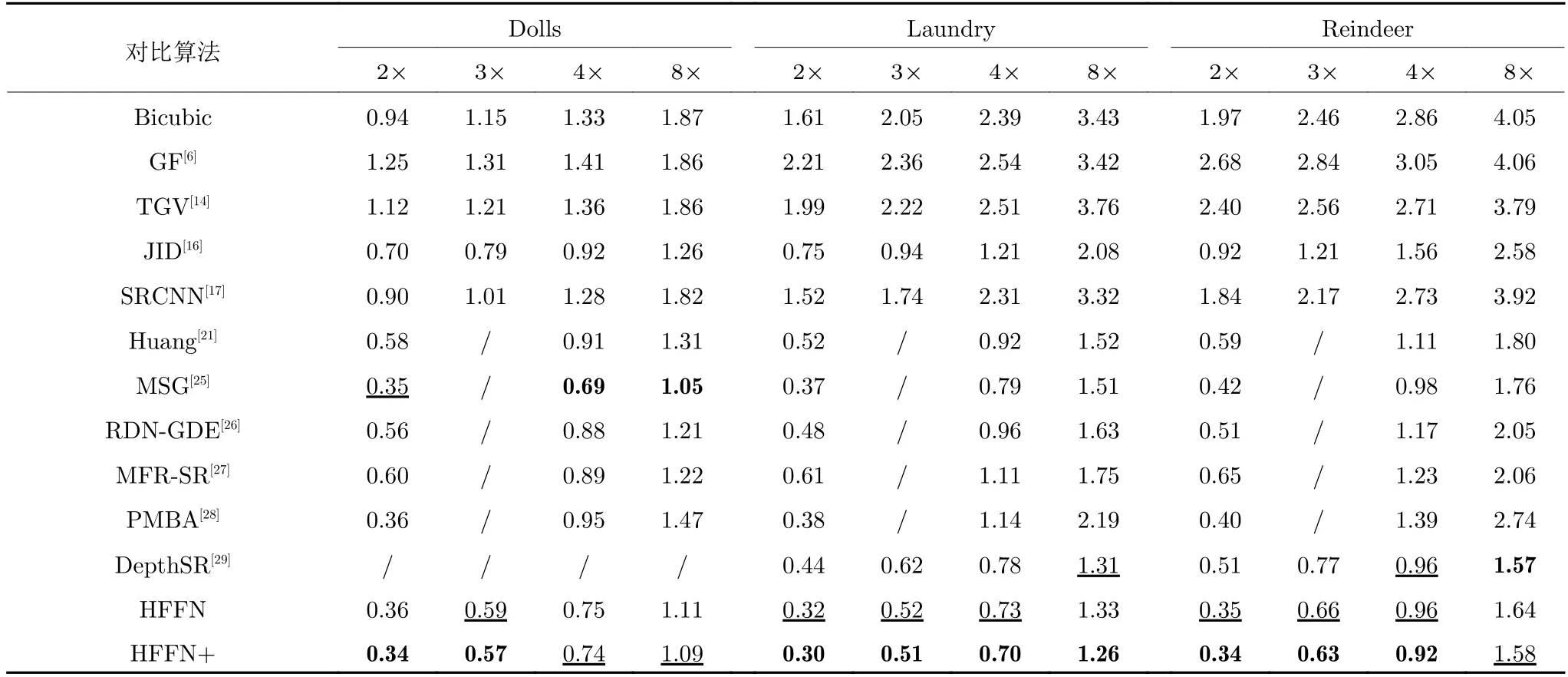

实验对比算法为:传统算法(Bicubic、GF[6]、TGV[14]、JID[16])和基于深度学习的超分辨率算法(纹理图像超分辨率算法SRCNN[17]、单深度图像超分辨率算法Huang[21]、纹理图像引导下的深度图像超分辨率算法MSG[25]、DepthSR[29]、MFR-SR[27]、RDN-GDE[26]、PMBA[28]),HFFN+表示在HFFN 算法中引入Self-Ensemble[37]方法.当比例因子为 2×、3×、4×、8×时,深度图像超分辨率重建的客观质量对比结果如表4 到表6 所示.实验结果的最优值用粗体表示、次优值用下划线表示.

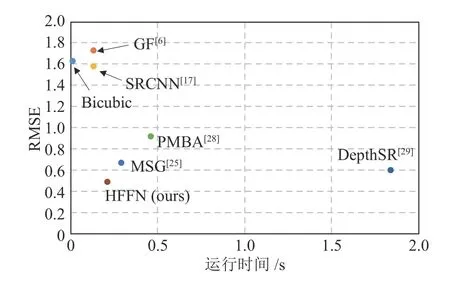

由表4 可知,当比例因子为 2×、3×、4×、8×时,所提算法在 “Books”和 “Moebius”上的重建结果均优于对比算法.其中,HFFN 算法重建 “Books”的RMSE 值比Bicubic 算法降低了0.8 (2×)、1.02(3×)、1.14 (4×)、1.49 (8×);HFFN 算法重建“Books”的RMSE 值比GF[6]算法降低了1.21 (2×)、1.22 (3×)、1.24 (4×)、1.48 (8×);与Huang[21]提出的算法相比,HFFN 算法重建 “Books”的RMSE值降低了0.26 (2×)、0.34 (4×)、0.32 (8×);与PMBA[28]算法相比,HFFN 算法重建 “Books”的RMSE 值降低了0.14 (2×)、0.45 (4×)、0.87 (8×).随着放大比例因子的增加,本文提出的HFFN 算法明显优于传统算法GF[6]、单深度图像算法Huang[21]和纹理图像引导的算法PMBA[28],RMSE 值之差也越来越大,验证了HFFN 算法融合不同尺度下深度-纹理结构相似性的优势.当比例因子为4×时,各算法在 “Books”上的RMSE 值与运行时间如图5所示.由图5 可知,综合考虑运行时间和重建质量,HFFN 算法取得了最优的结果.

表4 测试数据集A 的客观对比结果 (RMSE)Table 4 Objective comparison results (RMSE) on test dataset A

图5 各算法重建 “Books”的RMSE 值走势图Fig.5 The trend of the RMSE for “Books”

由表5 可知,与MFR-SR[27]算法相比,HFFN算法重建 “Laundry”的RMSE 值减少了0.29 (2×)、0.38 (4×)、0.42 (8×),与PMBA[28]算法相比,HFFN算法重建 “Laundry”的RMSE 值降低了0.08(2×)、0.44 (4×)、0.93 (8×),与DepthSR[29]算法相比,HFFN算法重建 “Laundry”的RMSE 值减少了0.12(2×)、0.10 (3×)、0.05 (4×);与Huang[21]提出的算法相比,HFFN 算法重建 “Reindeer”的RMSE 值减少了0.25 (2×)、0.15 (4×)、1.16 (8×),与RDNGDE[26]算法相比,HFFN 算法重建 “Reindeer”的RMSE 值降低了0.17 (2×)、0.25 (4×)、0.47 (8×).RDN-GDE[26]算法、MFR-SR[27]算法以及Depth-SR[29]算法都是利用金字塔结构获取丰富的层次特征信息,而HFFN算法改进了金字塔结构、实现深度-纹理的反馈式融合、有效利用了多尺度特征间的关联性,其重建结果优于以上对比算法.同时,考虑到模型参数以及运行时间的影响,HFFN 网络只采用了三层金字塔结构,而DepthSR[29]算法在UNet 结构的基础上进行了四次下采样,并且与对应尺度下输入金字塔提取的特征进行级联,相比HFFN 网络获取了更丰富的层次特征,更有利于大比例因子的重建.因此,当比例因子为 8×时,HFFN网络重建 “Laundry”和 “Reindeer”的RMSE 值相比DepthSR[29]算法增加了0.02 和0.07.由上述实验结果可知,HFFN算法的重建结果总体上优于对比算法,验证了HFFN算法在深度图像超分辨率重建任务中的有效性.

表5 测试数据集B 的客观对比结果 (RMSE)Table 5 Objective comparison results (RMSE) on test dataset B

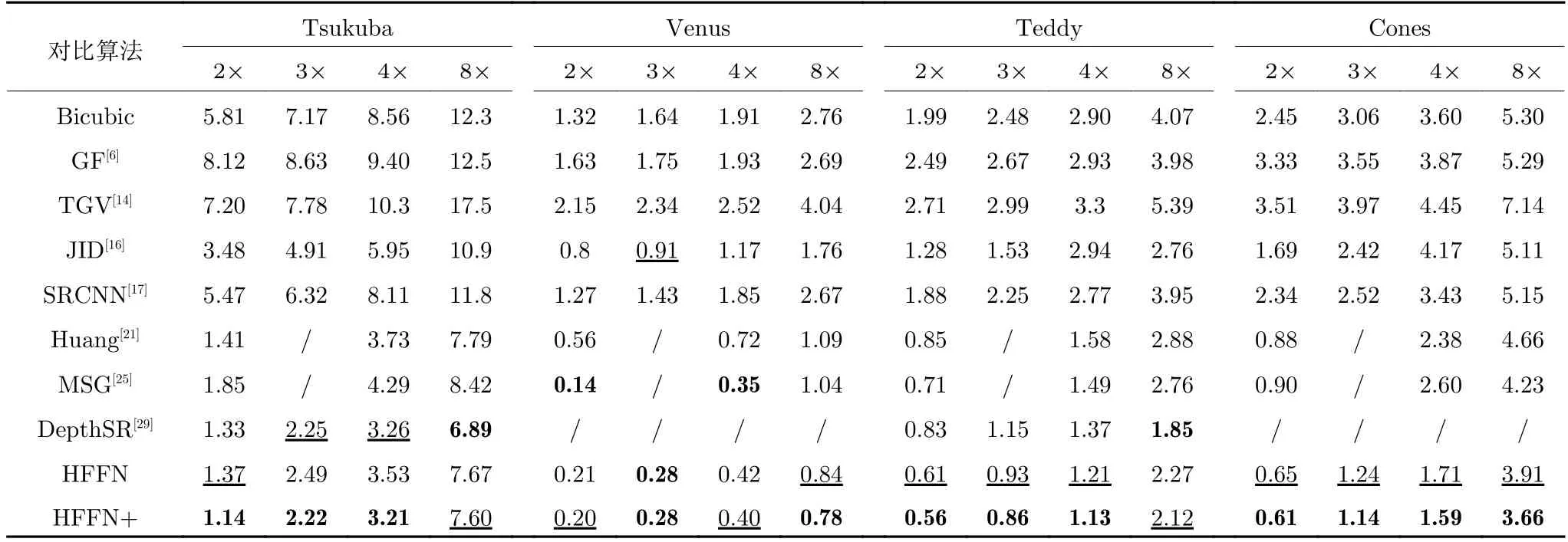

由表6 可知,HFFN 算法重建 “Cones”的RMSE值均优于比较算法.与DepthSR[29]算法相比,HFFN算法重建 “Teddy”的RMSE 值减少了0.27 (2×)、0.22 (3×)、0.16 (4×);与MSG[25]算法相比,HFFN算法重建 “Teddy”的RMSE 值减少了0.1 (2×)、0.28 (4×)、0.49 (8×),上述结果表明了HFFN 算法采用反馈式融合策略,充分融合了不同尺度下的深度特征和纹理特征,其重建深度图像 “Cones”和“Teddy”上的RMSE 值优于对比算法.由表4 到表6可知,HFFN+算法在测试集的重建结果均优于HFFN算法.因此,采用Self-Ensemble[37]方法可以进一步提升HFFN 算法的重建质量.

表6 测试数据集C 的客观对比结果 (RMSE)Table 6 Objective comparison results (RMSE) on test dataset C

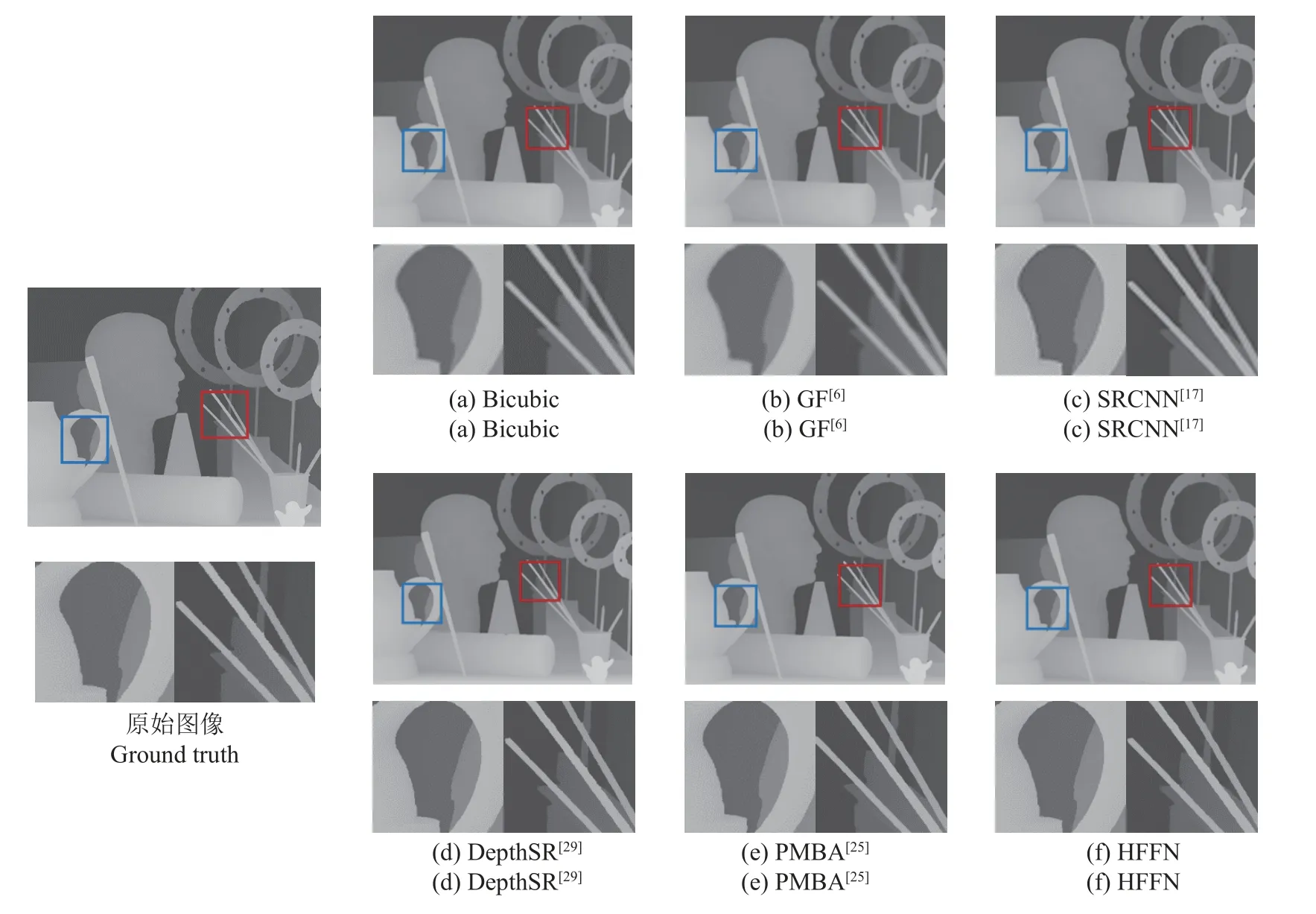

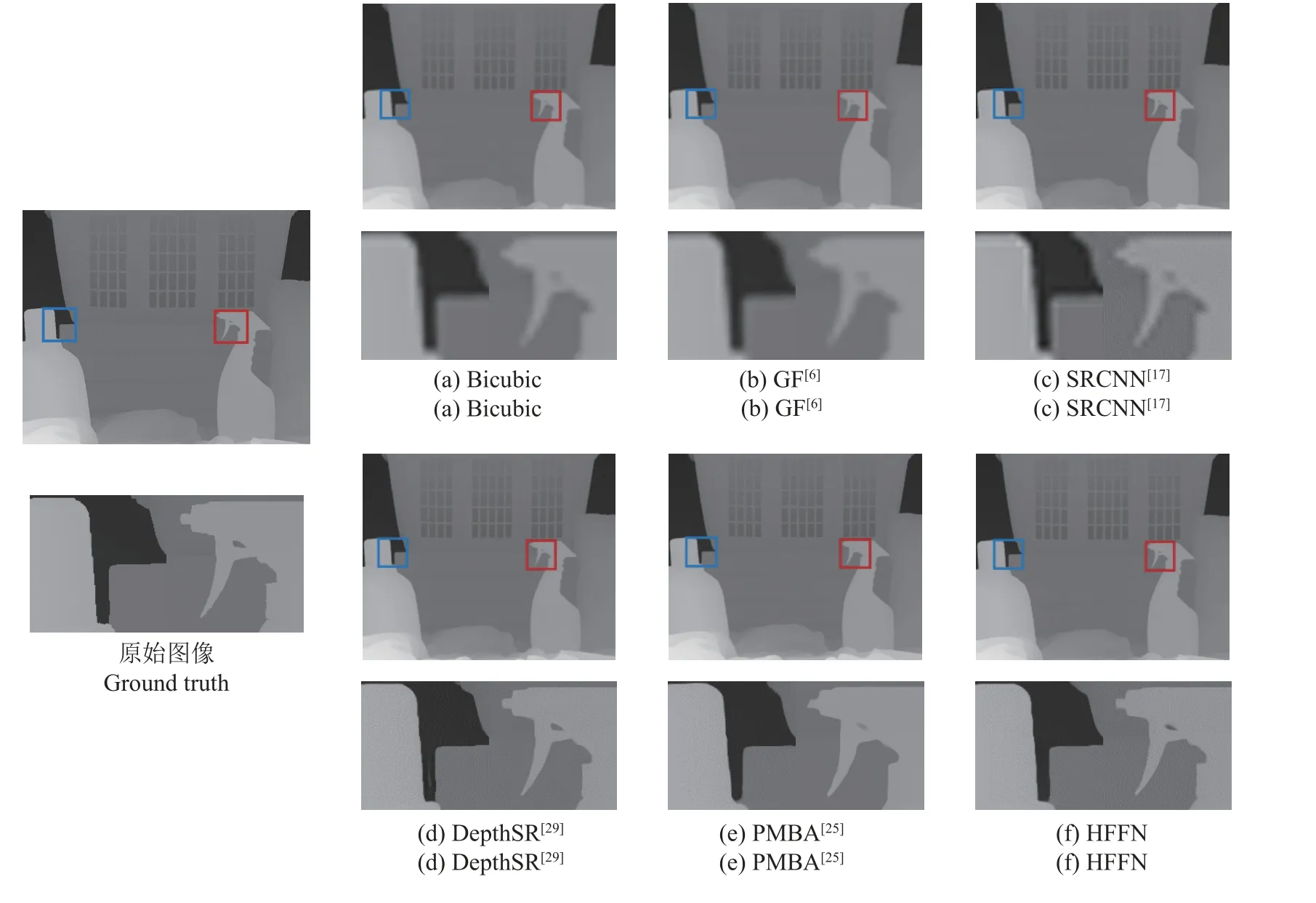

当比例因子为 4×、8×时,HFFN 与Bicubic、GF[6]、SRCNN[17]、DepthSR[29]、PMBA[28]算法在测试图像 “Art”和 “Laundry”上超分辨率重建的对比结果分别如图6 和图7 所示.

图6 4 × 尺度下测试图片 “Art”的视觉质量对比结果Fig.6 Visual quality comparison results of “Art” at scale 4×

图7 8 × 尺度下测试图片 “Laundry”的视觉质量对比结果Fig.7 Visual quality comparison results of “Laundry” at scale 8×

由图6 可知,与基于滤波的Bicubic 算法、GF[6]算法以及基于深度学习的单图像超分辨率算法SRCNN[17]相比,基于纹理图像引导的DepthSR[29]算法、PMBA[28]算法和HFFN 算法在重建过程中融合了纹理图像提供的引导信息,指引深度图像的重建过程,其重建结果有着清晰的边缘.

由图7(d)框中区域可知,DepthSR[29]算法在深度图像 “Laundry”上的重建结果出现了原始深度图像上不存在的白色条纹,可能是由于DepthSR[29]算法在解码过程中只融合浅层的纹理特征,纹理图像中包含的纹理信息干扰了深度图像的重建过程;如图9(f)蓝框区域所示,HFFN 算法利用深层网络充分挖掘了纹理图像的结构信息,并利用反馈式融合策略获得了包含多级感受野的边缘引导信息,重建结果未出现白色条纹,避免了纹理图像内部纹理信息的干扰.

3.4 计算复杂度分析

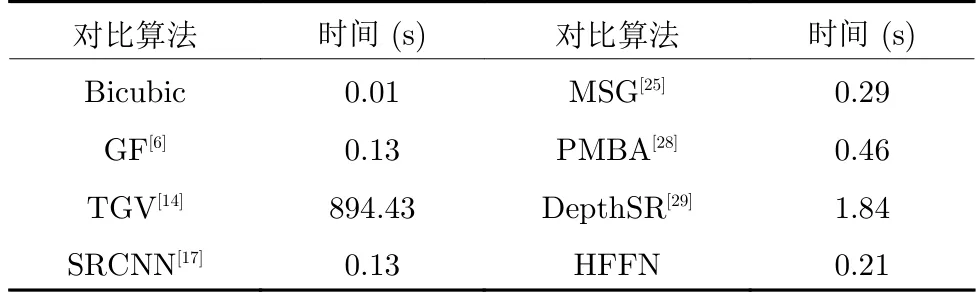

本文对比HFFN 与Bicubic、GF[6]、TGV[14]、SRCNN[17]、MSG[25]、PMBA[28]、DepthSR[29]的计算复杂度.在Intel(R)E5-1620v4,3.5 GHz,32 GB RAM、NVIDIA GeForce GTX 2080Ti 12 GB 计算平台上,各算法将低分辨率深度图像(264×324)重建为高分辨率深度图像(1 056×1 296) 的平均运行时间,如表7 所示.

表7 平均运行时间Table 7 Average running time

由表7 可知,基于滤波的Bicubic 算法、GF[6]算法,运行时间分别为0.01 s、0.13 s,相比其他算法运行时间最快、计算复杂度最低;基于优化表示的TGV[14]算法在CPU 上的运行时间达到了893 s,时间消耗最大;得益于GPU 计算资源的优势,基于深度学习的SRCNN[17]算法、MSG[25]算法、Depth-SR[29]算法、PMBA[28]算法和HFFN 算法的运行时间分别为:0.13 s、0.29 s、1.84 s、0.46 s.在这些网络结构中,SRCNN[17]只使用了3 层卷积层,计算复杂度最低;DepthSR[29]利用了4 层输入金字塔提取不同尺度下的结构特征,再与U-Net 结构中对应尺度的特征进行级联,提取各层的特征信息,增加了模型参数量、降低了运行速度;HFFN 网络采用了3 层并行金字塔结构、有效利用深度-纹理多尺度间的相关性,在提升深度图像重建质量的同时,控制了模型的参数量和计算复杂度.

4 结论

本文提出了一种基于分级特征反馈融合策略的深度图像超分辨率重建算法,并构建了端到端的分级特征反馈融合网络.在提取深度-纹理图像的深层特征的基础上,该算法利用并行金字塔结构构建深度-纹理在不同尺度下的分层特征表示,提取深度-纹理在不同尺度下的结构信息;进而,应用反馈式融合策略,融合不同尺度下的结构特征,生成包含多级感受野的边缘引导信息,引导深度图像的超分辨率重建过程.与其他算法相比,实验结果验证了所提算法的有效性.