两阶段分析的异常簇团宫颈细胞检测方法

2022-05-25梁義钦赵司琦王海涛何勇军

梁義钦 赵司琦 王海涛 何勇军

摘要:异常细胞检测是宫颈癌智能辅助诊断的关键技术,直接影响着检测系统的性能。但宫颈异常细胞大多以簇团的形式存在,细胞相互粘连、复杂多样,给异常细胞检测带来了挑战。为解决这一问题,本文提出了一种两阶段簇团宫颈异常细胞检测方法。该方法在第一阶段采用YOLO-v5目标检测网络,利用可变形卷积替换网络中的标准卷积,使卷积核的大小和位置可以根据当前病理图像内容进行动态调整,以适应不同簇团宫颈细胞的形状、大小等几何形变。在第二阶段利用监督对比学习网络学习正、异常簇团宫颈细胞之间的特征差异,实现高准确率的正、异常簇团宫颈细胞分类。实验表明,簇团宫颈细胞召回率达到89.69%,相比基线网络YOLO-v5提升了1.43%,正、异常簇团宫颈细胞分类准确率达到87.81%,相比基线网络ResNet提升了10.31%。

关键词:簇团宫颈细胞分类;目标检测;对比学习

DOI:10.15938/j.jhust.2022.02.010

中图分类号: TP315.69

文献标志码: A

文章编号: 1007-2683(2022)02-0076-09

Two-stage Detection Method for Abnormal Cluster Cervical Cells

LIANG Yi-qin ZHAO Si-qi WANG Hai-tao HE Yong-jun

(1.School of Computer and Technology, Harbin University of Science and Technology, Harbin 150080, China;

2.The First Affiliated Hospital of Harbin Medical University, Harbin, 150001, China)

Abstract:Abnormal cell detection is a key technique for intelligent assisted diagnosis of cervical cancer, which directly affects the performance of the detection system. However, most cervical abnormal cells exist in the form of clusters. Cells adhere to each other, complex and diverse, which brings challenges to abnormal cell detection. To solve this problem, we proposed a two-stage detection method for cluster cervical abnormal cells. In the first stage, we use YOLO-v5 target detection network. The standard convolution in the network is replaced by deformable convolution. The size and location of convolution kernel can be dynamically adjusted according to the current pathological image content, so as to adapt to the shape, size and other geometric changes of cervical cells in different clusters. In the second stage, the supervised contrastive learning network is used to learn the feature differences between positive and abnormal clusters of cervical cells, so as to achieve high accuracy classification of positive and abnormal clusters of cervical cells. The experimental results show that the recall rate of cluster cervical cells reaches 89.69 %, which is 1.43 % higher than that of baseline network YOLO-v5. The classification accuracy of positive and abnormal cluster cervical cells reaches 87.81 %, which is 10.31 % higher than that of baseline network ResNet.

Keywords:cluster cervical cell classification; target detection; contrastive learning

0引言

宮颈癌是最常见的妇科恶性肿瘤之一。近年来其发病趋于年轻化,已成为威胁女性健康的严重问题。根据GLOBOCAN 2018年全球癌症观测数据库显示[1],在2018 年全球大约有570000例宫颈癌病例与311000例死亡病例,死亡率达到 54.56%,早诊断早治疗是应对这一问题的有效手段。目前宫颈癌诊断依赖于人工阅片,工作量大、效率低、诊断准确率高度依赖专业人员的技术水平,导致宫颈癌发病率、死亡率居高不下。因此,采用人工智能技术辅助医生做病灶位置初筛、宫颈癌前辅助诊断具有重要意义。

在实际宫颈癌前筛查中,异常的宫颈细胞大多拥挤成团,簇团宫颈细胞中包含了丰富的诊断信息。而现有研究大多针对单个宫颈细胞的定位与识别,缺乏针对簇团宫颈细胞的相关研究,充分利用簇团宫颈细胞中包含的丰富的诊断信息是提升智能诊断准确率的关键。针对宫颈细胞病理图像的分析,目前常用的方法[2-4]是结合医生的经验设计大量的手工特征来描述细胞的形状、纹理和外观,然后将生成的特征通过特征选择做进一步处理,最后输入到各种分类器(例如随机森林、SVM、softmax回归、神经网络等)中执行分类。由于细胞病理图像内容复杂、细胞之间形状和外观的差异大、细胞质边界的对比度差以及细胞之间的重叠,簇团宫颈细胞中的细胞或细胞核的分割仍然是一个未解决的问题。为避免手工特征难提取、细胞和细胞核难分割问题,目标检测方法可较好实现簇团宫颈细胞的定位与分类。R-CNN[5]是第一个将深度学习广泛用于目标检测的方法。R-CNN 遵循传统的目标检测思路。首先生成区域提议框,再对每个区域提议框提取特征向量,然后使用线性SVM分类,最后对每个区域提议框使用边界框回归进行目标检测。为了提高R-CNN的效率,Fast R-CNN[6]使用RoI池化,统一了图像分类和边界框回归。并且使用softmax 代替了SVM,以及提出了多任务损失函数。但是Fast R-CNN中的提取框与R-CNN中的提取框相同,都采用了不能在GPU上运行的选择性搜索算法。相反地Faster R-CNN[7]提供了一个区域提议网络(region proposal network,RPN)来查找目标区域,并且可以在 GPU 上运行整个目标检测网络以提高效率。Faster R-CNN已成功应用于细胞检测任务。Liu Y等[8]使用自建的循环肿瘤细胞(circulating tumor cell,CTC)数据集训练了Faster R-CNN模型来检测肿瘤细胞,为了提高检测效率,文中减小了检测图像的面积,并增加了锚框的数量。Qiu W等[9]使用Faster R-CNN检测红细胞。此方法首先使用Faster R-CNN查找细胞位置,然后使用ResNet进行分类。Kaushik S等[10]采用Faster R-CNN和Yolo檢测乳腺癌细胞,并验证了目标检测的有效性。Liang Y等[11]引入了Faster R-CNN来检测宫颈癌,并使用对比检测训练策略来提高准确性。由于分类多,训练数据少,其准确率低至 26.3%,召回率达 35.7%,无法满足实际应用的需要。

相比两阶段目标检测算法, 单阶段目标检测算法的结构简单、计算高效, 同时具备不错的检测精度, 在实时目标检测领域中具有较高的研究和应用价值。例如YOLO-v1[12]直接在输出层回归边界框的位置和边界框所属类别,使其检测速度能满足实时应用。针对YOLO-v1漏检率高的问题,单次多边框检测网络[13](single shot multiBox detector,SSD)在多尺度的特征图上进行目标检测,提出了与两阶段网络相似的有锚框方法,不但确保了较高的检测速率,而且降低了漏检率。YOLO-v2[14]结合SSD的特点,骨干网络采用Darknet19进行特征提取,并且去掉了全连接层,同样引入了锚框方法,实现以不同尺寸的图像训练网络,解决了YOLO-v1准确率低的问题。YOLO-v3[15]通过融合多标签分类预测、跨尺度预测、Darknet53等多种先进方法改进了YOLO系列。YOLO-v4[16]和YOLO-v5融合了更多的技巧,实现了速率和精度比较均衡的目标检测网络。郑欣等[17]提出利用ResNet50模型作为YOLO-v2网络的基础特征提取模块,实现簇团宫颈细胞的识别与分类,识别准确率为75.9%。周佳琳[18]在原有SSD网络模型的基础上,结合正反向特征融合对低层级高分辨率的特征图进行改进,加入中心损失改善类内差别大于类间差别的现象,在其自建数据集上mAP达到81.53%。

由于单阶段目标检测网络没有专门生成候选框的子网络,无法将候选框的数量减小到一个比较小的数量级,导致了绝大多数候选框都是背景类,即负样本。大量的负样本会覆盖少量的正样本的损失,从而导致模型退化,分类准确率低。因此,本文提出一种两阶段分析的异常簇团宫颈细胞检测方法,首先利用改进的YOLO-v5网络检出尽可能多的簇团宫颈细胞,然后利用有监督对比学习网络[19](supervised contrastive learning,SupContrast)实现更精确的正、异常簇团宫颈细胞分类。因为在检测出来的目标上进一步分类,大大减少了簇团宫颈细胞的分析数目,所以本方法相比现有的目标检测方法,在相对较少的数据量上既加快了检测速度,又提升了检测精度。

1异常簇团宫颈细胞检测方法

1.1异常簇团宫颈细胞检测方法主体流程

子宫颈细胞病理学诊断系统(the bethesda system,TBS)定义了单个宫颈细胞的诊断标准,然而实际获得的细胞病理图像中宫颈细胞大多粘连成团,簇团宫颈细胞包含了大量的诊断信息。但是宫颈细胞图像内容丰富,情况复杂,通过传统机器学习方法难以精确提取正、异常簇团宫颈细胞之间的特征差异,现有的深度学习方法也难以精确分割出单个宫颈细胞进行分析诊断。利用目标检测网络进行簇团宫颈细胞的定位与分类时,难以平衡其召回率和准确性。

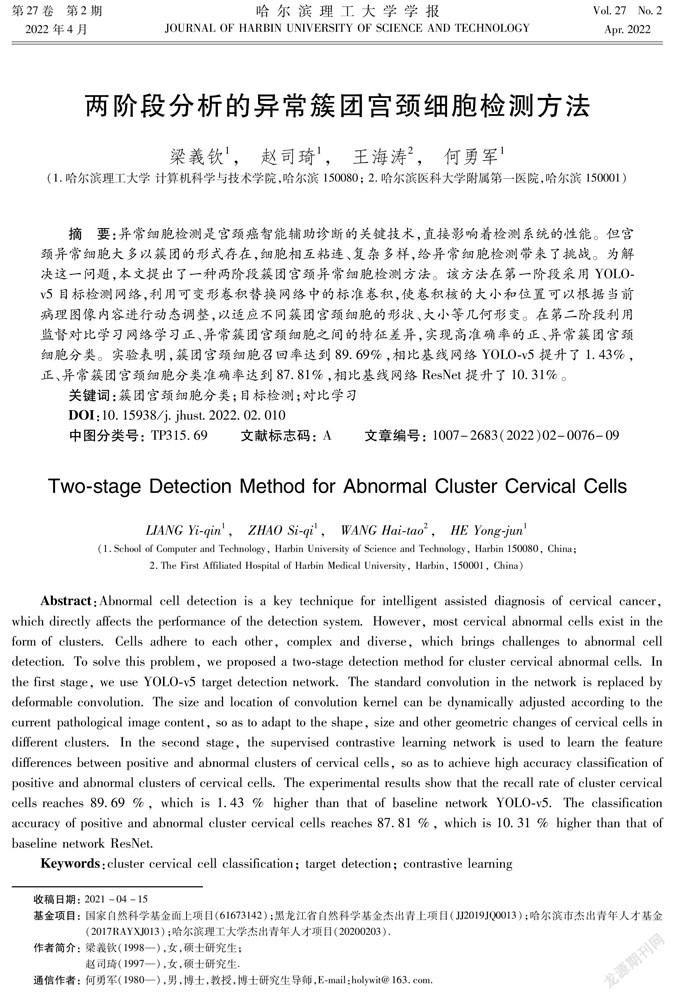

因此,我们提出了一种两阶段分析的异常簇团宫颈细胞检测方法,整体流程如图1所示。第一阶段利用改进的YOLO-v5算法快速发现并定位单张全景病理切片扫描图像(whole slide images,WSI)中的粘连簇团宫颈细胞;第二阶段利用分类器对第一阶段检测出的簇团宫颈细胞进行正、异常簇团宫颈细胞分类,该分类器是利用对比学习方法训练所得。

1.2第一阶段网络结构

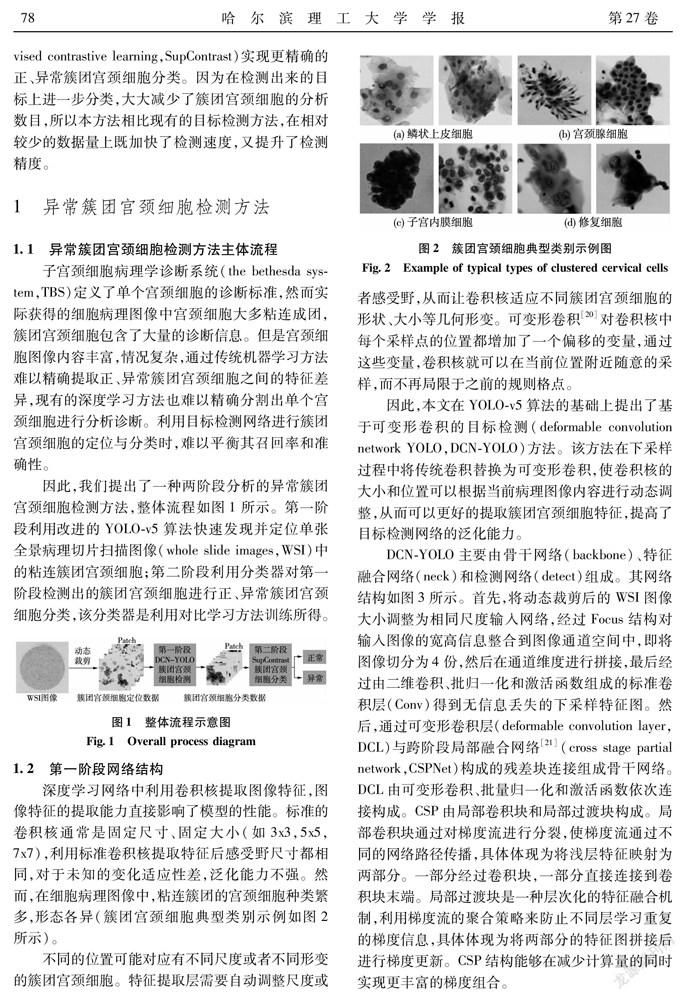

深度学习网络中利用卷积核提取图像特征,图像特征的提取能力直接影响了模型的性能。标准的卷积核通常是固定尺寸、固定大小(如3x3,5x5,7x7),利用标准卷积核提取特征后感受野尺寸都相同,对于未知的变化适应性差,泛化能力不强。然而,在细胞病理图像中,粘连簇团的宫颈细胞种类繁多,形态各异(簇团宫颈细胞典型类别示例如图2所示)。

不同的位置可能对应有不同尺度或者不同形变的簇团宫颈细胞。特征提取层需要自动调整尺度或者感受野,从而让卷积核适应不同簇团宫颈细胞的形状、大小等几何形变。可变形卷积[20]对卷积核中每个采样点的位置都增加了一个偏移的变量,通过这些变量,卷积核就可以在当前位置附近随意的采样,而不再局限于之前的规则格点。

因此,本文在YOLO-v5算法的基础上提出了基于可变形卷积的目标检测(deformable convolution network YOLO,DCN-YOLO)方法。该方法在下采样过程中将传统卷积替换为可变形卷积,使卷积核的大小和位置可以根据当前病理图像内容进行动态调整,从而可以更好的提取簇团宫颈细胞特征,提高了目标检测网络的泛化能力。

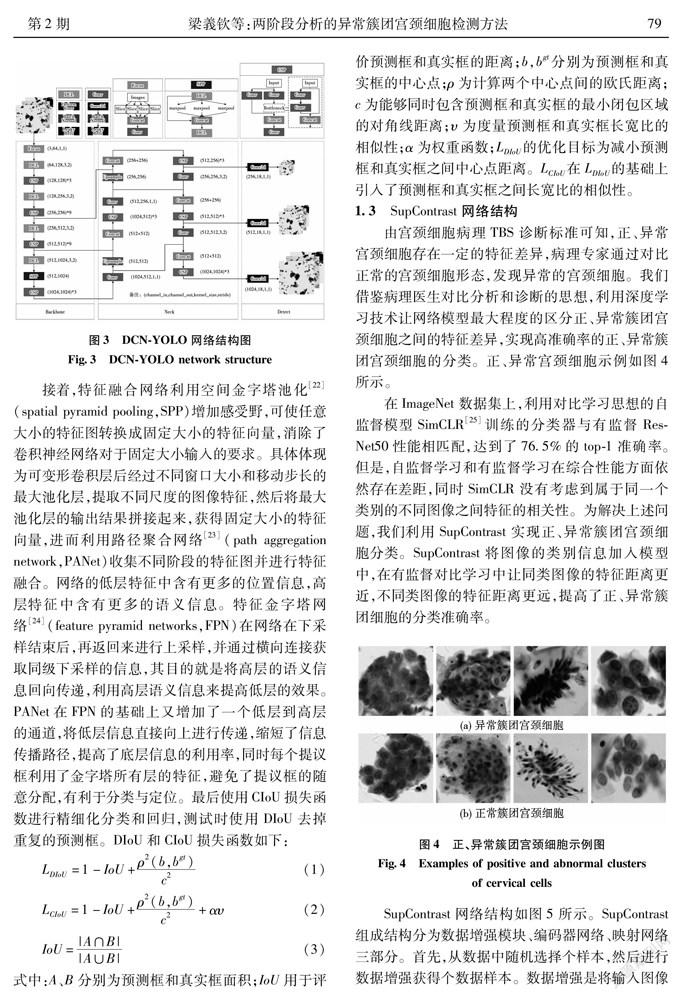

DCN-YOLO主要由骨干网络(backbone)、特征融合网络(neck)和检测网络(detect)组成。其网络结构如图3所示。首先,将动态裁剪后的WSI图像大小调整为相同尺度输入网络,经过Focus结构对输入图像的宽高信息整合到图像通道空间中,即将图像切分为4份,然后在通道维度进行拼接,最后经过由二维卷积、批归一化和激活函数组成的标准卷积层(Conv)得到无信息丢失的下采样特征图。然后,通过可变形卷积层(deformable convolution layer,DCL)与跨阶段局部融合网络[21](cross stage partial network,CSPNet)构成的残差块连接组成骨干网络。DCL由可变形卷积、批量归一化和激活函数依次连接构成。CSP由局部卷积块和局部过渡块构成。局部卷积块通过对梯度流进行分裂,使梯度流通过不同的网络路径传播,具体体现为将浅层特征映射为两部分。一部分经过卷积块,一部分直接连接到卷积块末端。局部过渡块是一种层次化的特征融合机制,利用梯度流的聚合策略来防止不同层学习重复的梯度信息,具体体现为将两部分的特征图拼接后进行梯度更新。CSP结构能够在减少计算量的同时实现更丰富的梯度组合。

接着,特征融合网络利用空间金字塔池化[22](spatial pyramid pooling,SPP)增加感受野,可使任意大小的特征圖转换成固定大小的特征向量,消除了卷积神经网络对于固定大小输入的要求。具体体现为可变形卷积层后经过不同窗口大小和移动步长的最大池化层,提取不同尺度的图像特征,然后将最大池化层的输出结果拼接起来,获得固定大小的特征向量,进而利用路径聚合网络[23](path aggregation network,PANet)收集不同阶段的特征图并进行特征融合。网络的低层特征中含有更多的位置信息,高层特征中含有更多的语义信息。特征金字塔网络[24](feature pyramid networks,FPN)在网络在下采样结束后,再返回来进行上采样,并通过横向连接获取同级下采样的信息,其目的就是将高层的语义信息回向传递,利用高层语义信息来提高低层的效果。PANet在FPN的基础上又增加了一个低层到高层的通道,将低层信息直接向上进行传递,缩短了信息传播路径,提高了底层信息的利用率,同时每个提议框利用了金字塔所有层的特征,避免了提议框的随意分配,有利于分类与定位。最后使用CIoU损失函数进行精细化分类和回归,测试时使用DIoU去掉重复的预测框。DIoU和CIoU损失函数如下:

式中:A、B分别为预测框和真实框面积;IoU用于评价预测框和真实框的距离;b,b分别为预测框和真实框的中心点;ρ为计算两个中心点间的欧氏距离;c为能够同时包含预测框和真实框的最小闭包区域的对角线距离;υ为度量预测框和真实框长宽比的相似性;α为权重函数;L的优化目标为减小预测框和真实框之间中心点距离。L在L的基础上引入了预测框和真实框之间长宽比的相似性。

1.3SupContrast网络结构

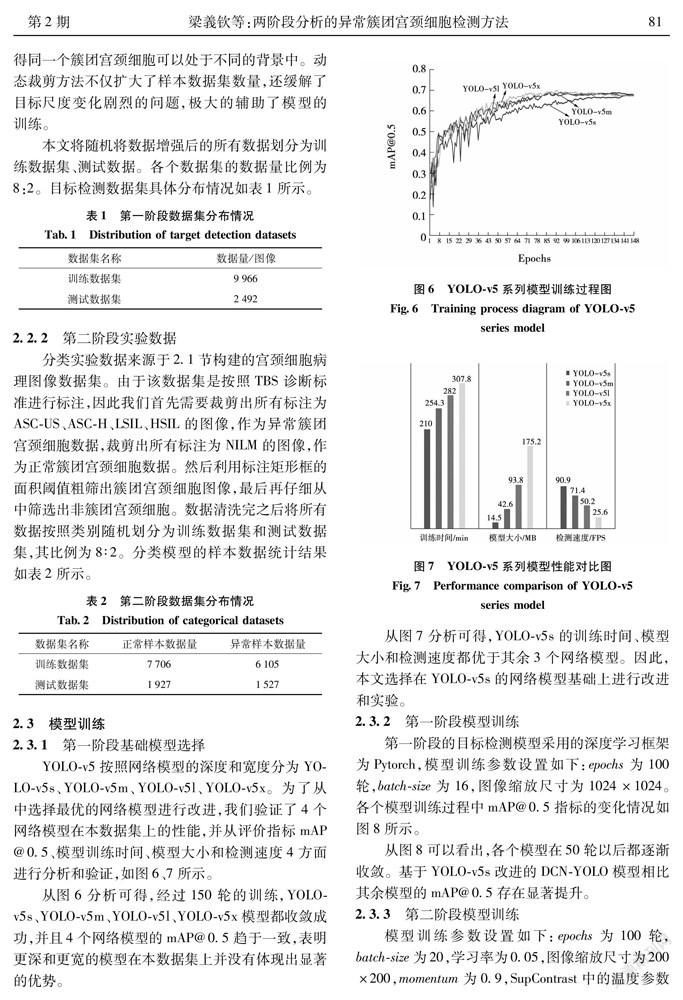

由宫颈细胞病理TBS诊断标准可知,正、异常宫颈细胞存在一定的特征差异,病理专家通过对比正常的宫颈细胞形态,发现异常的宫颈细胞。我们借鉴病理医生对比分析和诊断的思想,利用深度学习技术让网络模型最大程度的区分正、异常簇团宫颈细胞之间的特征差异,实现高准确率的正、异常簇团宫颈细胞的分类。正、异常宫颈细胞示例如图4所示。

在ImageNet数据集上,利用对比学习思想的自监督模型SimCLR[25]训练的分类器与有监督ResNet50性能相匹配,达到了76.5%的top-1准确率。但是,自监督学习和有监督学习在综合性能方面依然存在差距,同时SimCLR没有考虑到属于同一个类别的不同图像之间特征的相关性。为解决上述问题,我们利用SupContrast实现正、异常簇团宫颈细胞分类。SupContrast将图像的类别信息加入模型中,在有监督对比学习中让同类图像的特征距离更近,不同类图像的特征距离更远,提高了正、异常簇团细胞的分类准确率。

SupContrast网络结构如图5所示。SupContrast组成结构分为数据增强模块、编码器网络、映射网络三部分。首先,从数据中随机选择个样本,然后进行数据增强获得个数据样本。数据增强是将输入图像生成两张随机增强的子图像,这两张子图像代表原始数据的不同视图。数据增强分为两个阶段:第一阶段是对数据进行随机裁剪,然后将其调整为原分辨率大小;第二阶段使用了3种不同的增强方法,具体包括自动增强、随机增强和Sim增强,依次进行随机颜色失真和高斯模糊。然后,编码器对数据增强后的每对子图像进行特征提取,再使用池化层得到一个2048维的表征向量h。编码器网络主要由一些骨干网络组成,用于图像的特征提取和表示,并将增强后的图像映射到表征空间。接着,映射网络将表征向量h经过两层非线性多层感知器(multi-layer perceptron,MLP)映射成128维表征向量z,使得编码器网络可以学习到更好的表征特征。然后,利用有监督对比损失进行相似度计算,让同类图像的表征向量彼此接近,让不同类图像的表征向量彼此远离,从而实现类别的划分。最后,利用交叉熵损失函数训练一个线性分类器。

SupContrast损失函数是对自监督对比损失函数的推广,SupContrast损失函数拓展了正样本的数量,将所有标签信息相同的子图像都视为正样本。其损失函数的表达式为

式中:·为内积操作;z为i样本对应的表征向量,z是A(i)样本集合中某个样本对应的表征向量,z是P(i)样本集合中某个样本对应的表征向量,表征向量由编码映射后得到;A(i)为下标为i之外的其他所有样本组成的集合;τ为温度参数;P(i)为正样本集合,包含下标为i的样本和与i样本相同类别的所有样本;|P(i)|为正样本集合的大小。相比自监督对比损失函数,SupContrast损失函数具有以下特性:①使用了大量的正样本,包含数据增强得到的正样本和类别标签一致的正样本;②保留了对于负样本的求和,噪声样本越多,对比效果越明显;③自监督对比损失函数的梯度激励从难以区分的正、负样本之间学习特征差异。

2实验与分析

2.1簇团宫颈细胞数据集构建方法

本文采用的典型宫颈细胞病理筛查病例来源有:①阿里天池大赛之宫颈癌风险智能检测比赛数据;②第三方检验中心;③哈尔滨医科大学附属第二医院。阿里天池大赛数据是经过专业医师标注的宫颈细胞病理图像,其中阳性病例500例,阴性病例300例,第三方检验中心和哈尔滨医科大学附属第二医院提供由LCT(liquid-based cytology test,液基薄层细胞学检查)制片技术制作宫颈细胞病理涂片,我们利用WISLEAP-10扫描仪获得宫颈细胞病理图像,并从中筛选出200例标本质量合格、扫描图像清晰的宫颈细胞病理图像,其中阳性病例100例,阴性病例100例。最后邀请专业病理医生对病理图像进行正、异常宫颈细胞的标注。经过统计可知,我们一共获得的标注数据有600例阳性病例图像,100例阴性病例图像。

病理筛选规则及数据标注说明如下:①正常簇团宫颈细胞标注图像来源于阴性病例,疑似病变的簇团宫颈细胞标注图像来源于阳性病例;②筛选病理图像时,主要排除了样本质量不合格、扫描图像不清晰、细胞颜色层次不鲜明、细胞重叠率高、出血区域大、干封和干燥宫颈细胞病理图像;③由于本文主要探索粘连簇团宫颈细胞的相关内容,因此着重挑选宫颈细胞相对密集,簇团细胞数量相对较多的病理图像;④标注类别为:正常和异常。

2.2数据准备

2.2.1第一阶段实验数据

在深度学习中,网络模型对样本数据量要求较高,训练数据集的规模在一定程度上决定了模型的性能。但是在实际中,病理医生标注的高质量的粘连团簇宫颈细胞数据十分有限。利用数据增强方法扩大数据量是提高模型效果和泛化能力的重要手段。

目标检测样本数据需要固定尺寸,而大小不一的簇团宫颈细胞在固定图像尺寸内会导致目标尺度变化较大,目标相对于图像面积的比值波动范围较大,不利于模型学习簇团宫颈细胞特征。因此,本文利用动态裁剪方法进行WSI图像裁剪。根据目标大小以不同的概率选择裁剪大小:对于小目标,大概率使用较小的裁剪;对于大目标,大概率使用较大的裁剪;对于同一个簇团宫颈细胞可进行多次裁剪,使得同一个簇团宫颈细胞可以处于不同的背景中。动态裁剪方法不仅扩大了样本数据集数量,還缓解了目标尺度变化剧烈的问题,极大的辅助了模型的训练。

本文将随机将数据增强后的所有数据划分为训练数据集、测试数据。各个数据集的数据量比例为8:2。目标检测数据集具体分布情况如表1所示。

2.2.2第二阶段实验数据

分类实验数据来源于2.1节构建的宫颈细胞病理图像数据集。由于该数据集是按照TBS诊断标准进行标注,因此我们首先需要裁剪出所有标注为ASC-US、ASC-H、LSIL、HSIL的图像,作为异常簇团宫颈细胞数据,裁剪出所有标注为NILM的图像,作为正常簇团宫颈细胞数据。然后利用标注矩形框的面积阈值粗筛出簇团宫颈细胞图像,最后再仔细从中筛选出非簇团宫颈细胞。数据清洗完之后将所有数据按照类别随机划分为训练数据集和测试数据集,其比例为8∶2。分类模型的样本数据统计结果如表2所示。

2.3模型训练

2.3.1第一阶段基础模型选择

YOLO-v5按照网络模型的深度和宽度分为YOLO-v5s、YOLO-v5m、YOLO-v5l、YOLO-v5x。为了从中选择最优的网络模型进行改进,我们验证了4个网络模型在本数据集上的性能,并从评价指标mAP@0.5、模型训练时间、模型大小和检测速度4方面进行分析和验证,如图6、7所示。

从图6分析可得,经过150轮的训练,YOLO-v5s、YOLO-v5m、YOLO-v5l、YOLO-v5x模型都收敛成功,并且4个网络模型的mAP@0.5趋于一致,表明更深和更宽的模型在本数据集上并没有体现出显著的优势。

从图7分析可得,YOLO-v5s的训练时间、模型大小和检测速度都优于其余3个网络模型。因此,本文选择在YOLO-v5s的网络模型基础上进行改进和实验。

2.3.2第一阶段模型训练

第一阶段的目标检测模型采用的深度学习框架为Pytorch,模型训练参数设置如下:epochs为100轮,batch-size为16,图像缩放尺寸为1024×1024。各个模型训练过程中mAP@0.5指标的变化情况如图8所示。

从图8可以看出,各个模型在50轮以后都逐渐收敛。基于YOLO-v5s改进的DCN-YOLO模型相比其余模型的mAP@0.5存在显著提升。

2.3.3第二阶段模型训练

模型训练参数设置如下:epochs为100轮,batch-size为20,学习率为0.05,图像缩放尺寸为200×200,momentum为0.9,SupContrast中的温度参数为0.7,SupContrast中的编码器采用了不同深度的编码器,分别为ResNet-18、ResNet-34和ResNet-50。基线分类网络ResNet使用了官方预训练模型。第二阶段各个分类模型训练过程中分类准确率如图9所示。经过有监督对比学习预训练后的SupContrast在线性分类器最初训练则开始收敛,并且,不同编码器得到的SupContrast模型在训练阶段的分类准确率都高于基线ResNet分类模型。由此表明,对比学习不同类别间特征的差异性可提高分类的准确率。

2.4实验结果分析

2.4.1第一阶段网络实验结果分析

为验证第一阶段中不同目标检测模型的性能,我们利用测试数据集对已训练的YOLO-v5s、SSD-300、 Faster RCNN、Deformable DETR[26]、DCN-YOLO模型进行测试,各个目标检测网络的测试结果如表3所示。

目标检测中使用平均精度均值(mean average precision,mAP)来评估检测准确度,mAP@0.5为交并比阈值为0.5时的平均精度均值,其值越大证明目标检测模型检测准确度越高。召回率为预测正确的正实例占所有实例的比例。DCN-YOLO的mAP@0.5和召回率相比SSD-512、Faster R-CNN、Deformable DETR、YOLO-v5s均存在显著提升。表3不同目标检测模型的性能對比分析表明DCN-YOLO利用可变形卷积可以提取到不规则信息,增强了簇团宫颈细胞的特征表示,提高了第一阶段模型的检测准确率。同时,较高的簇团宫颈细胞的检出率可降低宫颈癌前筛查病理片的漏诊率,这对自动阅片系统具有重要意义。

2.4.2第二阶段网络实验结果分析

为验证第二阶段的分类网络相比基线分类网络ResNet的性能差异,我们利用分类测试数据集对已训练好的SupContrast-ResNet18、SupContrast- ResNet34、SupContrast-ResNet50、ResNet-18、ResNet-34、ResNet-50模型进行测试。不同分类模型的F1值和精确率如图10所示。

精确率为预测正确的正实例占所有正实例的比例。F1值为分类模型的精确率和召回率的调和平均值,F1值越高表明分类模型的精确率和召回率差异较小。由图10分析可得,相同深度的SupContrast模型相比ResNet模型的F1值和精确度存在显著提升。由此表明SupContrast通过对比正异常簇团宫颈细胞之间的特征差异可有效提高其分类准确率。

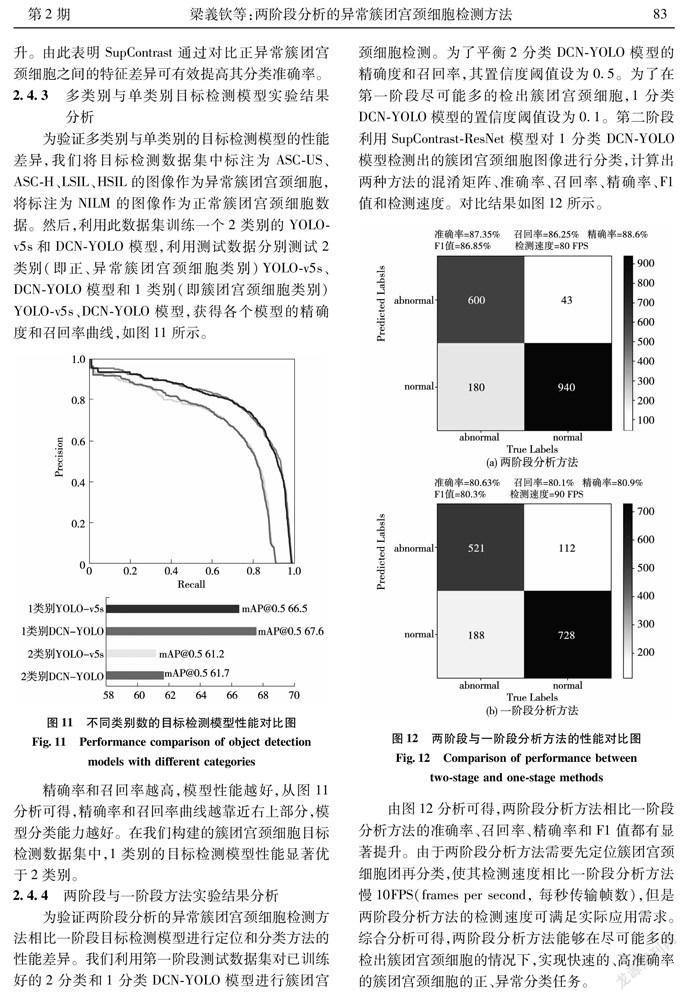

2.4.3多类别与单类别目标检测模型实验结果分析

为验证多类别与单类别的目标检测模型的性能差异,我们将目标检测数据集中标注为ASC-US、ASC-H、LSIL、HSIL的图像作为异常簇团宫颈细胞,将标注为NILM的图像作为正常簇团宫颈细胞数据。然后,利用此数据集训练一个2类别的YOLO-v5s和DCN-YOLO模型,利用测试数据分别测试2类别(即正、异常簇团宫颈细胞类别)YOLO-v5s、DCN-YOLO模型和1类别(即簇团宫颈细胞类别)YOLO-v5s、DCN-YOLO模型,获得各个模型的精确度和召回率曲线,如图11所示。

精确率和召回率越高,模型性能越好,从图11分析可得,精确率和召回率曲线越靠近右上部分,模型分类能力越好。在我们构建的簇团宫颈细胞目标检测数据集中,1类别的目标检测模型性能显著优于2类别。

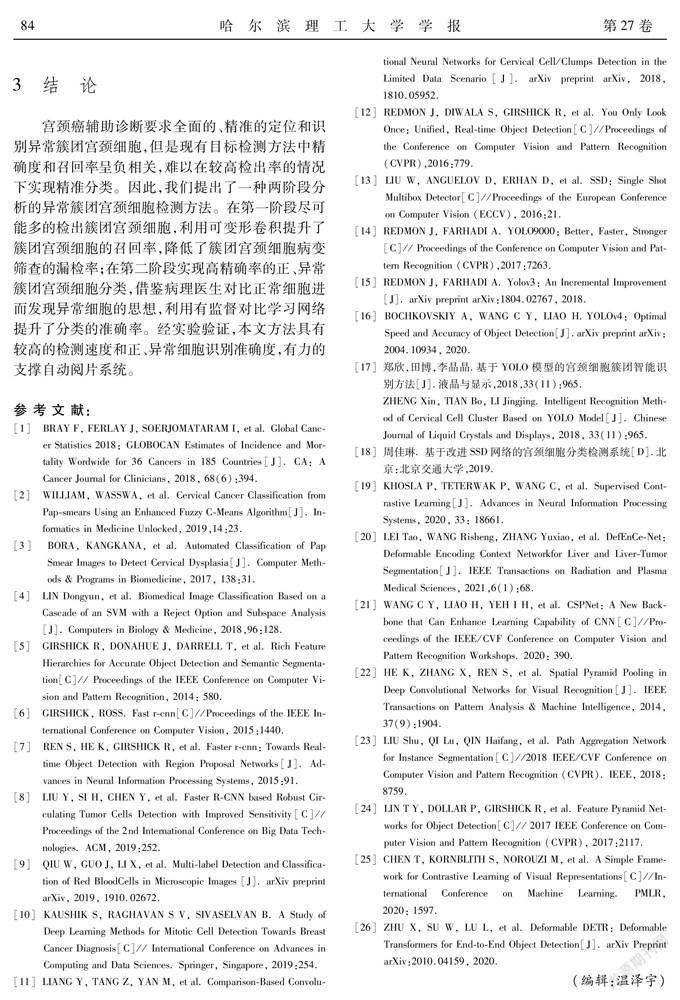

2.4.4两阶段与一阶段方法实验结果分析

为验证两阶段分析的异常簇团宫颈细胞检测方法相比一阶段目标检测模型进行定位和分类方法的性能差异。我们利用第一阶段测试数据集对已训练好的2分类和1分类DCN-YOLO模型进行簇团宫颈细胞检测。为了平衡2分类DCN-YOLO模型的精确度和召回率,其置信度阈值设为0.5。为了在第一阶段尽可能多的检出簇团宫颈细胞,1分类DCN-YOLO模型的置信度阈值设为0.1。第二阶段利用SupContrast-ResNet模型对1分类DCN-YOLO模型检测出的簇团宫颈细胞图像进行分类,计算出两种方法的混淆矩阵、准确率、召回率、精确率、F1值和检测速度。对比结果如图12所示。

由图12分析可得,两阶段分析方法相比一阶段分析方法的准确率、召回率、精确率和F1值都有显著提升。由于两阶段分析方法需要先定位簇团宫颈细胞团再分类,使其检测速度相比一阶段分析方法慢10FPS(frames per second, 每秒传输帧数),但是两阶段分析方法的检测速度可满足实际应用需求。综合分析可得,两阶段分析方法能够在尽可能多的检出簇团宫颈细胞的情况下,实现快速的、高准确率的簇团宫颈细胞的正、异常分类任务。

3结论

宫颈癌辅助诊断要求全面的、精准的定位和识别异常簇团宫颈细胞,但是现有目标检测方法中精确度和召回率呈负相关,难以在较高检出率的情况下实现精准分类。因此,我们提出了一种两阶段分析的异常簇团宫颈细胞检测方法。在第一阶段尽可能多的检出簇团宫颈细胞,利用可变形卷积提升了簇团宫颈细胞的召回率,降低了簇团宫颈细胞病变筛查的漏检率;在第二阶段实现高精确率的正、异常簇团宫颈细胞分类,借鉴病理医生对比正常细胞进而发现异常细胞的思想,利用有监督对比学习网络提升了分类的准确率。经实验验证,本文方法具有较高的检测速度和正、异常细胞识别准确度,有力的支撑自动阅片系统。

参 考 文 献:

[1]BRAY F, FERLAY J, SOERJOMATARAM I, et al. Global Cancer Statistics 2018: GLOBOCAN Estimates of Incidence and Mortality Wordwide for 36 Cancers in 185 Countries[J]. CA: A Cancer Journal for Clinicians, 2018, 68(6):394.

[2]WILLIAM, WASSWA, et al. Cervical Cancer Classification from Pap-smears Using an Enhanced Fuzzy C-Means Algorithm[J]. Informatics in Medicine Unlocked, 2019,14:23.

[3]BORA, KANGKANA, et al. Automated Classification of Pap Smear Images to Detect Cervical Dysplasia[J]. Computer Methods & Programs in Biomedicine, 2017, 138:31.

[4]LIN Dongyun, et al. Biomedical Image Classification Based on a Cascade of an SVM with a Reject Option and Subspace Analysis[J]. Computers in Biology & Medicine, 2018,96:128.

[5]GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580.

[6]GIRSHICK, ROSS. Fast r-cnn[C]//Proceedings of the IEEE International Conference on Computer Vision, 2015:1440.

[7]REN S, HE K, GIRSHICK R, et al. Faster r-cnn: Towards Real-time Object Detection with Region Proposal Networks[J]. Advances in Neural Information Processing Systems, 2015:91.

[8]LIU Y, SI H, CHEN Y, et al. Faster R-CNN based Robust Circulating Tumor Cells Detection with Improved Sensitivity[C]// Proceedings of the 2nd International Conference on Big Data Technologies. ACM, 2019:252.

[9]QIU W, GUO J, LI X, et al. Multi-label Detection and Classification of Red BloodCells in Microscopic Images [J]. arXiv preprint arXiv, 2019, 1910.02672.

[10]KAUSHIK S, RAGHAVAN S V, SIVASELVAN B. A Study of Deep Learning Methods for Mitotic Cell Detection Towards Breast Cancer Diagnosis[C]// International Conference on Advances in Computing and Data Sciences. Springer, Singapore, 2019:254.

[11]LIANG Y, TANG Z, YAN M, et al. Comparison-Based Convolutional Neural Networks for Cervical Cell/Clumps Detection in the Limited Data Scenario[J]. arXiv preprint arXiv, 2018, 1810.05952.

[12]REDMON J, DIWALA S, GIRSHICK R, et al. You Only Look Once: Unified, Real-time Object Detection[C]//Proceedings of the Conference on Computer Vision and Pattern Recognition (CVPR),2016:779.

[13]LIU W, ANGUELOV D, ERHAN D, et al. SSD: Single Shot Multibox Detector[C]//Proceedings of the European Conference on Computer Vision (ECCV), 2016:21.

[14]REDMON J, FARHADI A. YOLO9000: Better, Faster, Stronger[C]// Proceedings of the Conference on Computer Vision and Pattern Recognition (CVPR),2017:7263.

[15]REDMON J, FARHADI A. Yolov3: An Incremental Improvement[J]. arXiv preprint arXiv:1804.02767, 2018.

[16]BOCHKOVSKIY A, WANG C Y, LIAO H.YOLOv4: Optimal Speed and Accuracy of Object Detection[J].arXiv preprint arXiv:2004.10934, 2020.

[17]郑欣,田博,李晶晶.基于YOLO模型的宫颈细胞簇团智能识别方法[J].液晶与显示,2018,33(11):965.

ZHENG Xin, TIAN Bo, LI Jingjing. Intelligent Recognition Method of Cervical Cell Cluster Based on YOLO Model[J]. Chinese Journal of Liquid Crystals and Displays, 2018, 33(11):965.

[18]周佳琳. 基于改进SSD网络的宫颈细胞分类检测系统[D].北京:北京交通大学,2019.

[19]KHOSLA P, TETERWAK P, WANG C, et al. Supervised Contrastive Learning[J]. Advances in Neural Information Processing Systems, 2020, 33: 18661.

[20]LEI Tao, WANG Risheng, ZHANG Yuxiao, et al. DefEnCe-Net: Deformable Encoding Context Networkfor Liver and Liver-Tumor Segmentation[J]. IEEE Transactions on Radiation and Plasma Medical Sciences, 2021,6(1):68.

[21]WANG C Y, LIAO H, YEH I H, et al. CSPNet: A New Backbone that Can Enhance Learning Capability of CNN[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. 2020: 390.

[22]HE K, ZHANG X, REN S, et al. Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2014, 37(9):1904.

[23]LIU Shu, QI Lu, QIN Haifang, et al. Path Aggregation Network for Instance Segmentation[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2018:8759.

[24]LIN T Y, DOLLAR P, GIRSHICK R, et al. Feature Pyramid Networks for Object Detection[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017:2117.

[25]CHEN T, KORNBLITH S, NOROUZI M, et al. A Simple Framework for Contrastive Learning of Visual Representations[C]//International Conference on Machine Learning. PMLR, 2020: 1597.

[26]ZHU X, SU W, LU L, et al. Deformable DETR: Deformable Transformers for End-to-End Object Detection[J]. arXiv Preprint arXiv:2010.04159, 2020.

(編辑:温泽宇)