基于视觉显著性和感知相似性的全参考图像质量评价方法

2022-05-14王茜郑斌军孔玲君顾萍

王茜,郑斌军,孔玲君,顾萍

基于视觉显著性和感知相似性的全参考图像质量评价方法

王茜1,郑斌军1,孔玲君2,顾萍2

(1.上海理工大学,上海 200093;2.上海出版印刷高等专科学校,上海 200093)

图像质量评价(IQA)旨在使用计算模型自动衡量和评价图像质量,以代替人类视觉系统的主观意见,并应用到相关实际问题中。首先将参考图像与失真图像进行输入,使用视觉显著性模型计算图像局部相似度的特征映射,并在质量得分池化阶段作为加权函数,同时,针对视觉显著性图作为单一特征映射的不足,增加了梯度幅度,然后将图像进行颜色空间的转化提取颜色特征,最后分配相应的权重来计算图像相似度。在4个大型数据集上的对比测试显示,在保持适度计算复杂度的同时,VSPSI相比其他有代表性的模型在预测精度上得到了一定的提升,特别是在TID2013数据集上的SROCC达到了0.905 5。研究结果表明,VSPSI是一个性能优良的IQA方法,在不同数据集和不同失真类型中都有良好的表现,具有较强的鲁棒性,可胜任多类失真图像的客观质量评价,同时可通过优化视觉显著性模型进一步提升VSPSI的性能。

图像质量评价;视觉显著性;人类视觉系统

图像质量评价(Image Quality Assessment, IQA)是视觉研究、图像和视频处理领域最基本但也是最具挑战的任务之一,通常用于图像采集、图像恢复、图像压缩、多媒体流处理等领域[1]。图像质量评价方法分为2类:基于人类视觉系统(Human Visual System, HVS)的主观评价和利用计算机模拟人类主观判断的算法的客观评估。人眼主观评价虽是图像质量的最终标准,但费时、烦琐,无法在日益剧增的图像信息流中进行实时质量评估,因此,人们对开发客观IQA方法的需求越来越迫切。根据参考图像可用性,客观IQA方法可分为全参考(Full Reference, FR)、半参考(Reduced Reference, RR)和无参考(No Reference, NR)。文中主要研究全参考图像质量评价(Full Reference Image Quality Assessment, FR–IQA),用于评价失真图像相对于其参考图像的感知质量。

作为传统的保真度指标,峰值信噪比(Peak Signal to Noise Ratio, PSNR)或均方误差(Mean Squared Error, MSE)可以较好地评价具有相同内容和失真类型的图像质量,且因计算方式简单而被广泛使用,但当涉及到多幅图像或多种失真类型时,由PSNR或MSE预测的图像质量得分与人眼主观质量评级之间并没有很好的相关性[2],受此限制,学界提出了许多IQA模型以达到与HVS有更好的相关性[3-6]。结构相似性(Structure Similarity, SSIM)指标[7]、多尺度SSIM(Multi–Scale SSIM, MS–SSIM)[8]和信息加权SSIM(Information Weighted SSIM, IW–SSIM)[9]在评价图像质量时都基于这样一个假设:HVS自适应地从视觉场景中提取结构信息,结构相似性的度量可以近似于感知到的图像质量。Sheikh等[10]提出了视觉信息保真度(Visual Information Fidelity, VIF),将FR–IQA问题视为信息保真度问题,并通过计算失真图像与参考图像中共有的信息量对保真度进行量化。Larson等[11]认为HVS评估参考图像和失真图像的图像质量时执行2种不同的策略,提出了基于最明显失真(Most Apparent Distortion, MAD)的IQA方法,在文献[12]中提出的特征相似性指标(Feature Similarity, FSIM)使用相位一致性和梯度幅度来计算图像的局部相似度,这2个特征在表征局部的图像质量方面有良好的互补性。Liu等[13]认为图像的梯度信息可以有效地捕捉对比度和结构的变化,提出了一种基于图像梯度相似性度量(Gradient Similarity Based Metric, GSM)的FR–IQA方法。Bae等[14]提出结构对比度质量指标(Structural Contrast Quality Index, SC–QI),该指标可以较好地描述具有结构失真类型的各种图像特征的全局和局部的质量感知。在文献[15]中,作者指出来自超像素的视觉特征更贴近人眼的感知质量,提出了基于超像素相似性度量(Super Pixel Based Similarity, SPSIM)的IQA方法。

前述的研究结果印证了这样一个事实,即图像的梯度相似性度量对IQA模型十分重要,但梯度相似性是图像低级特征的表达,无法完美反映HVS的主观感受,因此构建一个从HVS感知角度出发的图像特征尤为重要。近年来,建立有效的视觉显著性(Visual Saliency, VS)模型引起了学界的广泛关注[16-25],通过合理的VS模型计算出VS图可以模拟HVS对图像局部区域的显著性感知。在视觉感受上,VS与IQA是本质相关的,都是HVS对图像的感知方式,因此研究者们近年来一直在尝试将VS信息纳入到IQA模型中,以提高其性能[26-27]

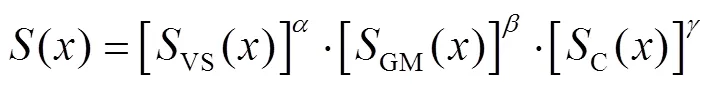

在文中,认为适当地结合VS信息对IQA模型十分有益,通过判断VS图的变化和感知质量下降的关系,提出一种基于图像视觉显著性和梯度相似性度量(Visual Saliency and Perception Similarity Index, VSPSI)的IQA方法。首先使用视觉显著性检测算法绘制出参考图像和失真图像的显著性图,计算2幅图像的视觉显著性相似度。接着利用图像的梯度幅值(Gradient Magnitude, GM)相似度测量图像的结构失真。针对公开数据集中关于颜色失真类型如饱和度失真和对比度失真,使用图像的色度信息计算色度相似度并设定了一个权重使模型具有更好的泛化性能。最后将上述3个图像相似度映射进行合并,认为VS映射不仅可以作为得分池化阶段的加权函数,还可以作为特征映射来表示图像局部区域的感知质量,原因是HVS可感知的图像质量失真会导致图像的视觉显著性图发生可测量的变化,因此在VSPSI中,图像的VS映射有双重作用:表征图像局部质量得分映射,以及在合并最终质量得分时作为图像局部区域对HVS重要性的加权因子。文中探索使用了几种不同的VS模型,并为VSPSI选择了最适合的模型,最后在4个公开数据集上进行了验证。

1 VSPSI方法

1.1 原理分析

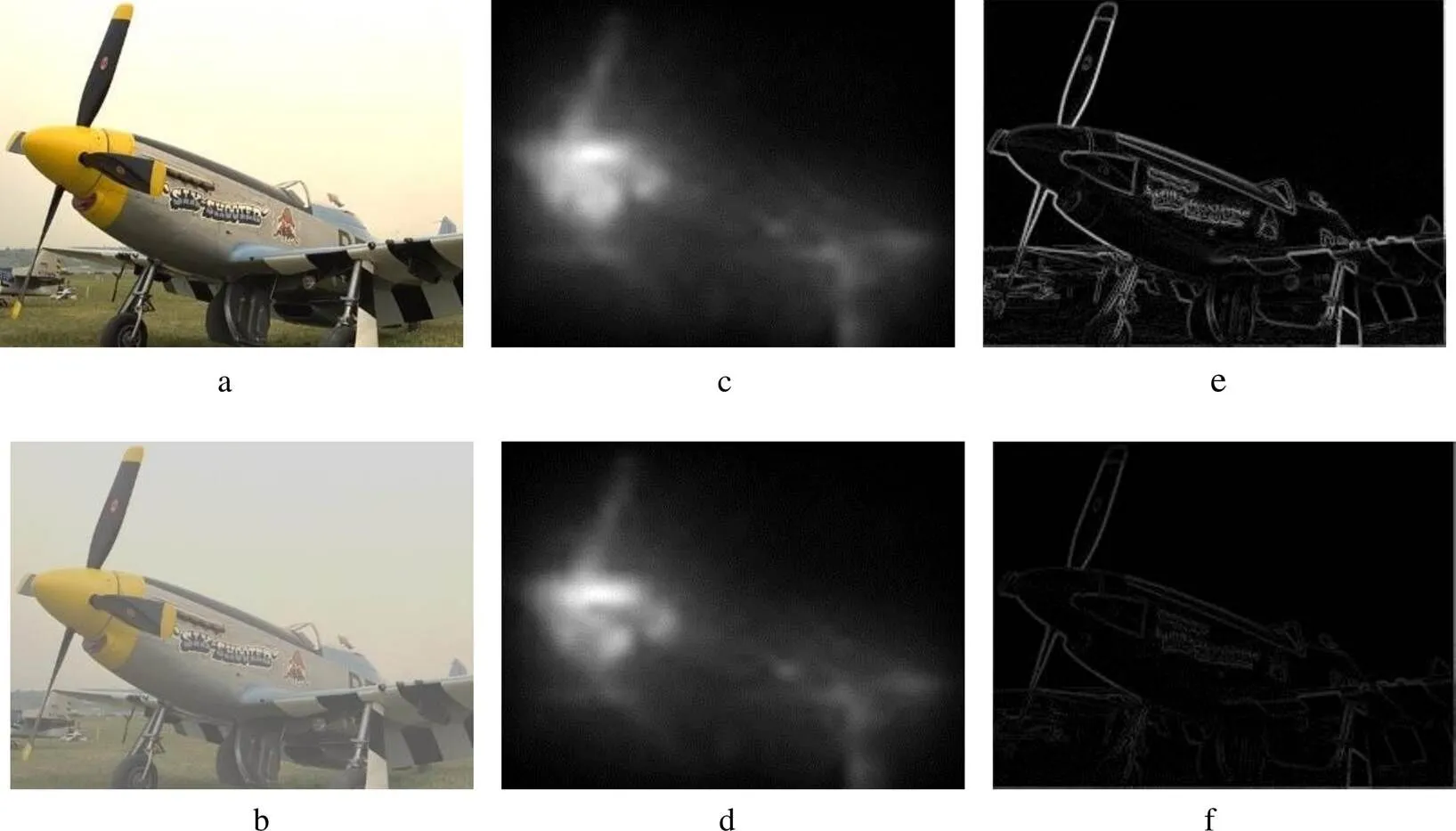

Zhang等[12]指出可感知的图像质量下降会导致图像的低级特征发生可感知的变化,见图1。图1的原始数据来自TID2013,图1a为参考图像,图1c、e为2种图像失真程度,图1b、d、f分别为图1a、c和e的视觉显著性图。其中图1b和d之间MSE值(Mean Squared Erro)为7.30,而图1b和f之间的MSE值为240.02。显然,在大多数情况下由图像低级特征构建的VS图的变化可以反映图像的失真程度,因此,文中使用VS作为表征图像局部质量的一个指标。

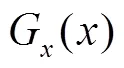

视觉显著性模型不能反映出对比度变化(Contrast Change, CTC)的失真类型,这是因为在图像像素处的VS值是反映其相对于周围像素区块的显著性,难以表征图像的绝对对比度,然而图像局部区域的对比度变化确实会对HVS的感知造成影响,见图2。图2a是参考图像,图2b是其失真版本,失真类型是对比度降低。图2c和d分别是使用GBVS[28]从图2a和b中计算得到的VS图,可以明显地观察到图2b的质量低于图2a。图2c和d之间未能观察到显著差异,即视觉显著性图无法较好地反映由图像对比度降低所导致的图像质量下降程度,所以可利用常见的GM来弥补VS的对比度感知缺陷。图2e和f分别为图2a和b通过Scharr算子计算得到的GM图,直观地可以觉察到明显的差异。这表明GM图在反映图像对比度损失方面拥有良好的能力,因此GM和VS相辅相成,两者共同反映HVS评价图像质量的不同方面。

1.2 颜色空间转换

图1 参考图像的不同失真程度及其对应的显著性

图2 参考图像及其失真图像的视觉显著性图和梯度幅度

1.3 图像局部相似度计算

式中:、和为3个参数用于调节VS、GM和颜色特征的重要性。

1.4 池化策略

前面得到2幅图像之间每个位置的局部相似度()后,就能获得其整体相似度,最终通过池化操作获取失真图像相对于参考图像的质量得分。最常见的池化策略是平均池化,即简单地将整体相似度取均值来获得质量得分。平均池化假设图像每个位置在估计整体图像质量中具有相同的重要性,然而平均池化忽略了这样一个事实,即一幅自然图像在视觉场景中有各种局部结构,当图像发生失真时,不同局部结构会产生不一样的梯度衰减。例如,JPEG2000压缩带来的失真包括模糊、振铃和块效应,模糊失真在图像平坦区域造成的质量衰退比在纹理区域造成的质量衰退更少,而块效应在图像平坦区域比在纹理区域造成的质量衰退更多。

2 实验结果

2.1 数据集和评价指标

在4个大规模且可公开访问的数据集(分别为TID2013[30]、TID2008[31]、CSIQ[12]和LIVE[32])上验证VSPSI,这4个数据集的主要信息见表1。通过对原始图像添加不同类型和程度的畸变处理来获得失真图像,如JPEG2000压缩、加性白噪声和高斯模糊。这些失真反映了广泛的图像缺陷,例如边缘平滑、随机噪声和块伪影等。观察员在给定的条件下对这些数据库中的每个图像进行评价,最终汇总形成平均主观得分(Mean Opinion Scores, MOS)或差异平均主观得分(Differential Mean Opinion Scores, DMOS)用来衡量失真图像的主观评价结果。

图3 VSPSI算法流程

表1 IQA数据集信息

Tab.1 Benchmark datesets for IQA

IQA使用客观模型计算得到的图像质量得分与图像主观评价结果(MOS)之间的相关程度进行评价。常用的评价指标有4个,分别是Spearman秩序相关系数(Spearman Rank Order Correlation Coefficient, SROCC)、Kendall秩序相关系数(Kendall Rank Order Correlation Coefficient, KROCC),Pearson线性相关系数(Pearson Linear Correlation Coefficient, PLCC)和均方误差(Root Mean Squared Error, RMSE)。SROCC、PLCC和RMSE分别度量预测单调性、预测线性和预测准确性。KROCC评价质量得分与MOS之间的相似程度。为计算PLCC值和RMSE值,需应用回归分析来提供客观得分和MOS之间的非线性映射。对于回归分析,使用Sheikh等[32]建议的函数,见式(8)。

式中:1,…,5为被拟合参数;为原始得分;ƒ()为经回归后的IQA得分。

2.2 参数优化

表2 在TID2013数据子集上,VSPSI使用不同VS模型获得的SROCC值

Tab.2 SROCC values obtained by VSPSI using different VS models on TID2013 sub-dataset

文中VS的作用有2个:作为计算图像局部相似度的特征映射;在质量得分池化阶段作为加权函数来表征图像局部重要性。接下来,在TID2013数据集上的消融实验将展示VS的有效性。使用SROCC作为性能指标,当VS仅作为计算图像局部相似度的特征映射,然后使用简单的平均池化策略进行质量得分汇集,则SROCC值为0.881 3。当VS仅作为质量得分池化阶段的加权函数(该情况下只使用梯度幅度图和颜色特征来计算图像局部区域相似度),则SROCC值为0.890 1。当VS同时作为特征映射和加权函数时,SROCC值为0.905 3。消融实验显示,为更好发挥VS的作用,它应当被用作特征映射和加权函数。

2.3 性能对比

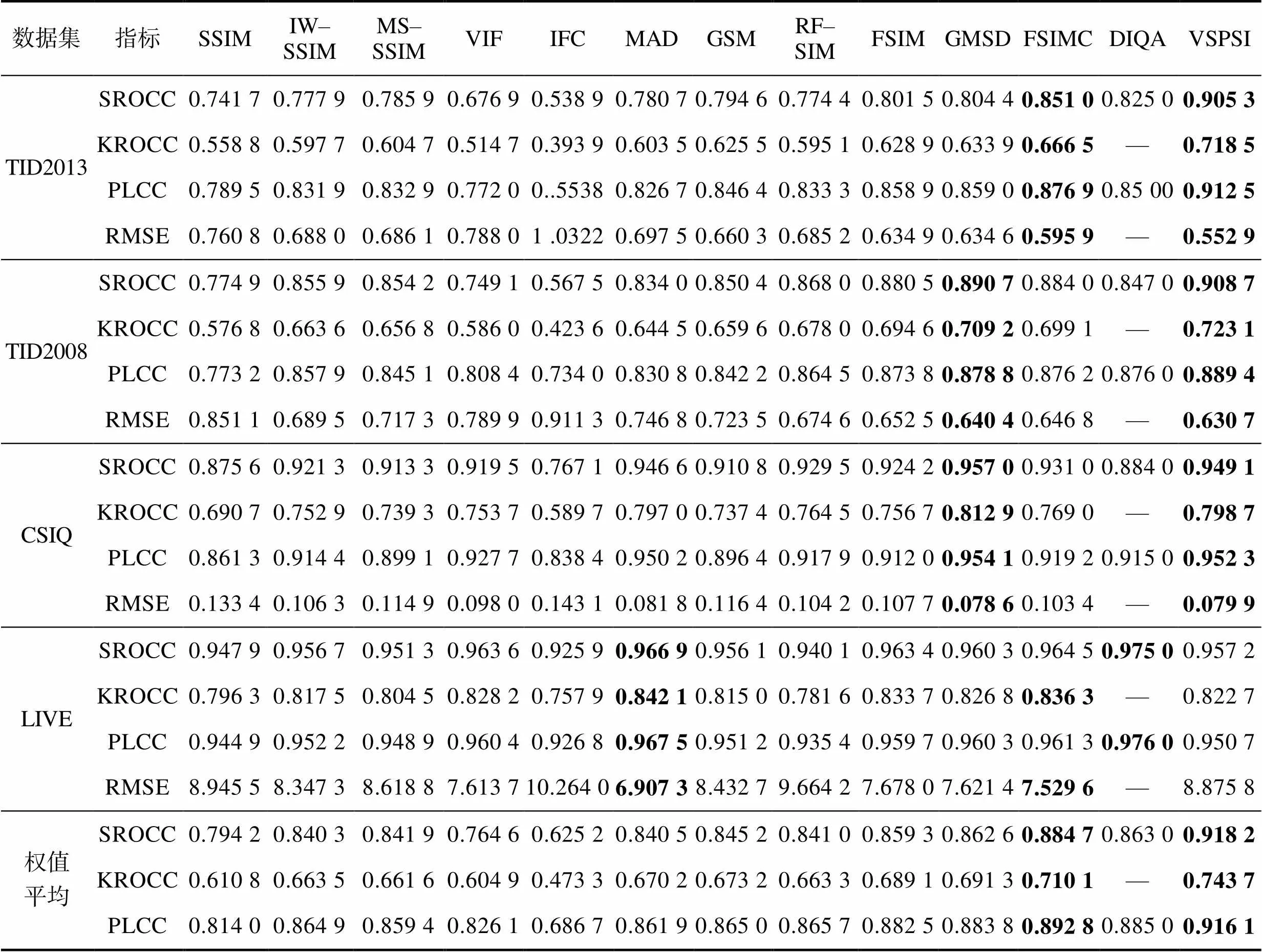

将VSPSI与其他11种有代表性的IQA模型进行比较,包括SSIM、IW–SSIM、MS–SSIM、VIF、IFC[38]、MAD、GSM、RF–SIM[39]、FSIM、GMSD[40]、FSIMC、DIQA[41]。表3列出了上述IQA在不同数据集上的性能指标包含SROCC、KROCC、PLCC、RMSE。每个性能指标对应最好的2个结果将以粗体突出显示。此外,根据Wang等[9]的建议,在表3中补充了上述IQA在4个数据集上加权平均的SROCC值、KROCC值和PLCC值,以更好地对其性能进行评价,分配给每个数据集的权重取决于该数据集中拥有的失真图像的数量。

从表3可出看出,VSPSI在所有测试数据集上都表现良好,尤其是在2个大型数据集(TID2013和TID2008)上的性能优于所有的参照对象,即使在LIVE数据集上表现不是最好,但模型性能也只比最好的结果稍微差一些。对照之下,其他模型可能在某些数据集上取得了良好的性能,但是在另外的数据集上无法提供可观的结果。例如,MAD模型在LIVE数据集上取得了最好的性能,但是在TID2013和TID2008数据集上的表现相当差。需要注意的是,VSPSI获得的指标性能排前二的数量最多(14次),而FSIM和GMSD分别只有9和7次。同时,在经过加权平均后,VSPSI与其他IQA相比获得了最好的性能。综上,VSPSI在测试数据集上获得了最佳的总体表现,其预测的客观得分与主观评价的相关性比其他IQA方法更加一致。

表3 IQA模型在4个基准数据集上的结果

Tab.3 IQA results on 4 benchmark datasets

IQA在TID2013预测的客观得分与主观评价得分的散点图见图4(DIQA因未提供全部源代码,故无法展示散点图而只罗列文献中的数据),TID2013数据集是目前具有较高权威性的IQA评价数据集,图4中显示的曲线是由式(8)进行非线性拟合得出的。从图4可以看出,与其他IQA相比,VSPSI的客观得分与主观评价得分具有高度的相关性。

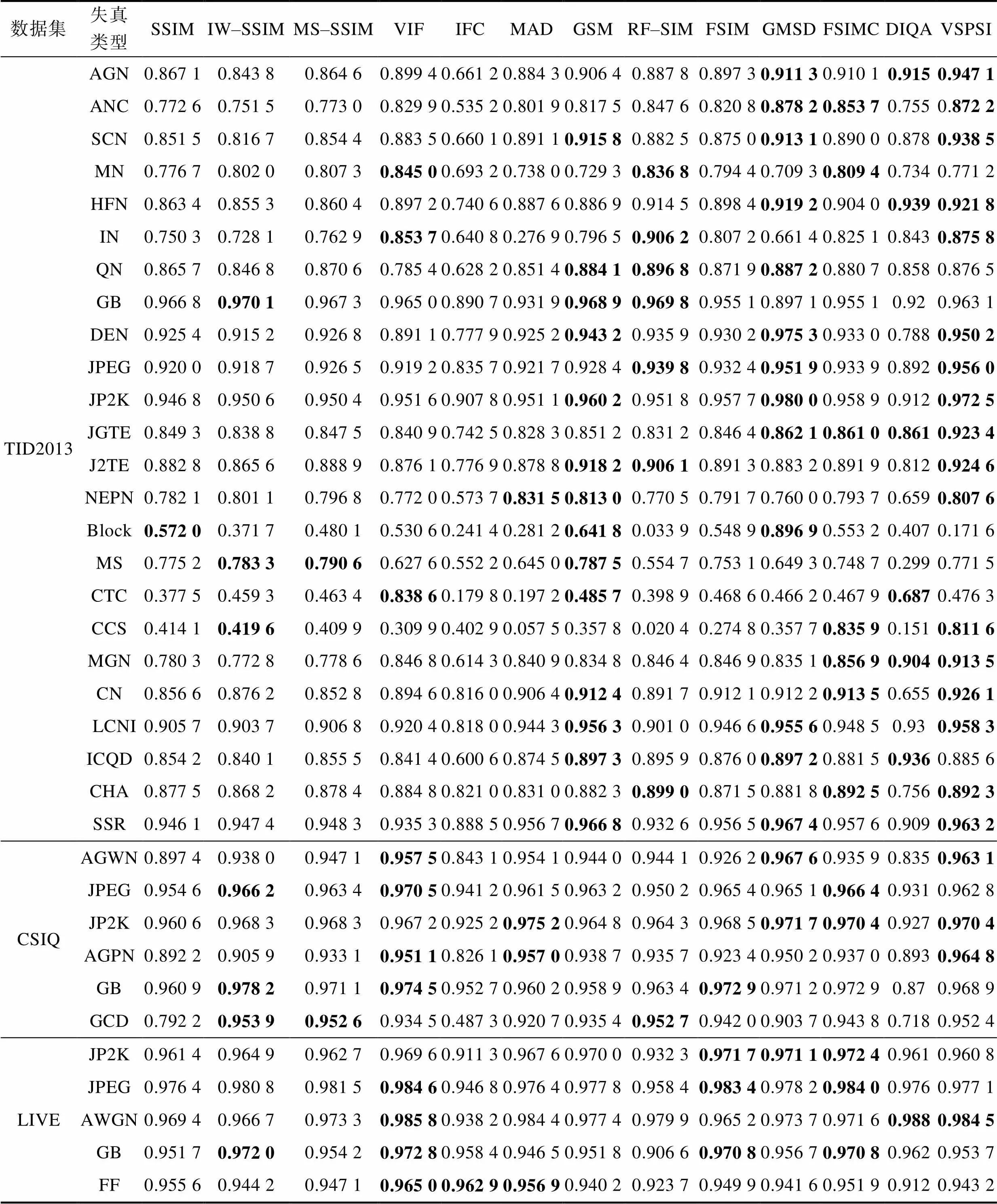

2.4 不同失真类型的性能对比

为更全面地评价IQA预测特定类型失真导致的图像质量降低的能力,测试了上述IQA应对每种失真类型的性能,使用SROCC作为衡量的指标,测试结果罗列在表4中。3个数据集一共有35组失真图像,对这3个数据集和每种失真类型测试生成最高SROCC值的前3个IQA模型,同样用加粗高亮表示(TID2013为TID2008的扩展补充,故只对TID2013数据集进行测试)。统计得出排名前3的IQA模型分别是VSPSI(21次)、GMSD(16次)和GSM(14次),同样地可以使用KROCC、PLCC、RMSE得出类似的结果,因此得到结论:当失真是属于单一特定类型时,VSPSI的表现最好,GMSD和GSM其次,VSPSI、GMSD和GSM的性能比其他IQA模型表现更佳。此外,VSPSI在不同数据集和不同失真类型中都有良好的表现,具有较高的精度和较强的鲁棒性。

图4 TID2013数据集上通过IQA预测获得的得分与主观MOS拟合的散点图

表4 IQA对单一失真类型的性能比较

Tab.4 Performance comparison of IQA for individual distortion types

2.5 计算成本

IQA的运行速度也是一个评价模型好坏与否的重要因素。实验运行环境为WIN10专业版系统,32 GB内存,图形计算卡是GTX1080Ti(11 GB显存),使用Intel Core i9–9900k处理器,软件为PyTorch1.91+ Cuda11.1+cuDnn8.2.1和Matlab R2019b。测量每个IQA计算一对分辨率为384×512彩色图像(取自TID2013数据集)相似性的时间成本,并在表5中进行展示。可以看出VSPSI是排名前6的IQA模型,具有适中的时间复杂度。GMSD最快是因为其仅使用亮度通道计算。与其他IQA模型如IW–SSIM、VIF、MAD相比,VSPSI分别快了2.7倍、5.6倍和7.3倍。综上,VSPSI在计算精度和时间复杂度之间取得了较好的平衡。

表5 IQA模型和其运算时间

Tab.5 Time cost of each IQA

3 结语

文中提出了一种新的IQA方法,即VSPSI。它由3个特征模块组成,分别为视觉显著性、梯度幅度和颜色特征。在VSPSI中,视觉显著性有双重作用:在计算图像局部相似度时作为特征映射;在得分池化阶段作为加权函数来表征图像局部区域的重要性,并使用梯度幅度和颜色特征来弥补视觉显著性作为单一特征映射的缺陷。在4个大型公开数据集上测试了VSPSI,并与其他11种有代表性的IQA进行了比较,结果表明VSPSI在预测精度方面拥有良好的表现。在4个数据集上的SROCC值都超过了0.9,在最权威数据集TID2013中的SROCC值达到了0.905 3,同时还保持了适度的计算复杂度。VSPSI是一个开放的框架,可通过优化视觉显著性模型进一步提升VSPSI的性能。同时,可开展VSPSI方法的实际应用研究,如艺术品复制质量评价领域。

[1] TALEBI H, MILANFAR P. NIMA: Neural Image Assessment[J]. IEEE Transactions on Image Processing, 2018, 27(8): 3998-4011.

[2] WANG Zhou, BOVIK A C. Mean Squared Error: Lot it or Leave It? a New Look at Signal Fidelity Measures[J]. IEEE Signal Processing Magazine, 2009, 26(1): 98-117.

[3] WOOJAE K, ANH-DUC N, SANGHOON L, et al. Dynamic Receptive Field Generation for Full-Reference Image Quality Assessment[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2020, 29: 4219-4231.

[4] NGUYEN A D, KIM J, OH H, et al. Deep Visual Saliency on Stereoscopic Images[J]. IEEE Trans Image Processing, 2019, 28(4): 1939-1953.

[5] AHN S, CHOI Y, YOON K. Deep Learning-Based Distortion Sensitivity Prediction for Full-Reference Image Quality Assessment[C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021: 344-353.

[6] FANG Yu-ming, YAN Jie-bin, LIU Xue-lin, et al. Stereoscopic Image Quality Assessment by Deep Convolutional Neural Network[J]. Journal of Visual Communication and Image Representation, 2018, 58: 400-406.

[7] WANG Z, BOVIK A C, SHEIKH H R, et al. Image Quality Assessment: From Error Visibility to Structural Similarity[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2004, 13(4): 600-612.

[8] WANG Z, SIMONCELLI E P, BOVIK A C. Multiscale Structural Similarity for Image Quality Assessment[C]// The Thrity-Seventh Asilomar Conference on Signals, Systems & Computers, 2003, 2: 1398-1402.

[9] WANG Zhou, LI Qiang. Information Content Weighting for Perceptual Image Quality Assessment[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2011, 20(5): 1185-1198.

[10] SHEIKH H R, BOVIK A C. Image Information and Visual Quality[J]. IEEE Transactions on Image Processing, 2006, 15(2): 430-444.

[11] LARSON E C, CHANDLER D M. Most Apparent Distortion: Full-Reference Image Quality Assessment and the Role of Strategy[J]. J Electronic Imaging, 2010, 19(1): 1-21.

[12] ZHANG Lin, ZHANG Lei, MOU Xuan-qin, et al. FSIM: A Feature Similarity Index for Image Quality Assessment[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2011, 20(8): 2378-2386.

[13] LIU An-min, LIN Wei-si, MANISH N. Image Quality Assessment Based on Gradient Similarity[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2012, 21(4): 1500- 1512.

[14] BAE S H, KIM M. A Novel Image Quality Assessment with Globally and Locally Consilient Visual Quality Perception[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2016, 25(5): 2392-406.

[15] SUN Wen, LIAO Qing-min, XUE Jing-hao, et al. SPSIM: A Superpixel-Based Similarity Index for Full-Reference Image Quality Assessment[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2018, 27(9): 4232- 4244.

[16] YANG S, LIN G, JIANG Q, et al. A Dilated Inception Network for Visual Saliency Prediction[J]. IEEE Transactions on Multimedia, 2019, 22(8): 2163-2176.

[17] WANG Hao-xiang, LI Zhi-hui, LI Yang, et al. Visual Saliency Guided Complex Image Retrieval[J]. Pattern Recognition Letters, 2020, 130(C): 64-72.

[18] VIJAYAKUMAR T, VINOTHKANNA R. Retrieval of Complex Images Using Visual Saliency Guided Cognitive Classification[J]. J Innov Image Process (JIIP), 2020, 2(2): 102-109.

[19] JIANG Feng-ling, KONG Bin, LI Jing-peng, et al. Robust Visual Saliency Optimization Based on Bidirectional Markov Chains[J]. Cognitive Computation, 2021, 13(1): 69-80.

[20] HE S, TAVAKOLI H R, BORJI A, et al. Understanding and Visualizing Deep Visual Saliency Models[C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 10206-10215.

[21] CHAO F Y, ZHANG L, HAMIDOUCHE W, et al. Salgan360: Visual Saliency Prediction on 360 Degree Images with Generative Adversarial Networks[C]// 2018 IEEE International Conference on Multimedia & Expo Workshops (ICMEW), IEEE, 2018: 1-4.

[22] NASIRIPOUR R, FARSI H, MOHAMADZADEH S. Visual Saliency Object Detection Using Sparse Learning[J]. IET Image Processing, 2019, 13(13): 2436-2447.

[23] QIN Yao, FENG Meng-yang, LU Hu-chuan, et al. Hierarchical Cellular Automata for Visual Saliency[J]. International Journal of Computer Vision, 2018, 126(7): 751-770.

[24] YI Xiang, WANG Bing-jian, ZHOU Hui-xin, et al. Dim and Small Infrared Target Fast Detection Guided by Visual Saliency[J]. Infrared Physics and Technology, 2019, 97: 6-14.

[25] LIU N, ZHANG N, WAN K, et al. Visual Saliency Transformer[C]// Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021: 4722-4732.

[26] JIA Hui-zhen, ZHANG Lu, WANG Tong-han. Contrast and Visual Saliency Similarity-Induced Index for Assessing Image Quality[J]. IEEE Access, 2018, 6: 65885-65893.

[27] ZHANG Lin, SHEN Ying, LI Hong-yu. VSI: A Visual Saliency-Induced Index for Perceptual Image Quality Assessment[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2014, 23(10): 4270-4281.

[28] HAREL J, KOCH C, PERONA P. Graph Based Visual Saliency[C]// Neural Information Processing Systems, Cambridge, 2007: 545-552.

[29] ZHANG X, WANDELL B A. A Spatial Extension of CIELAB for Digital Color‐Image Reproduction[J]. Journal of the Society for Information Display, 1997, 5(1): 61-63.

[30] PONOMARENKO N, IEREMEIEV O, LUKIN V, et al. Color Image Database TID2013: Peculiarities and Preliminary Results[C]// European Workshop on Visual Information Processing (EUVIP), IEEE, 2013: 106-111.

[31] PONOMARENKO N, LUKIN V, ZELENSKY A, et al. TID2008-A Database for Evaluation of Full-Reference Visual Quality Assessment Metrics[J]. Advances of Modern Radio Electronics, 2009, 10(4): 30-45.

[32] SHEIKH H R, SABIR M F, BOVIK A C. A Statistical Evaluation of Recent Full Reference Image Quality Assessment Algorithms[J]. IEEE Transactions on Image Processing, 2006, 15(11): 3440-3451.

[33] HOU X, ZHANG L. Saliency Detection: A Spectral Residual Approach[C]// Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2007: 1-8.

[34] JONG S H, PEYMAN M. Static and Space-Time Visual Saliency Detection by Self-Resemblance[J]. Journal of Vision, 2009, 9(12): 15.1-27.

[35] HOU Xiao-di, HAREL J, KOCH C. Image Signature: Highlighting Sparse Salient Regions[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(1): 194-201.

[36] ZHANG L, GU Z, LI H. SDSP: A Novel Saliency Detection Method by Combining Simple Priors[C]// 2013 IEEE International Conference on Image Processing. IEEE, 2013: 171-175.

[37] TANG H, CHEN C, PEI X. Visual Saliency Detection Via Sparse Residual and Outlier Detection[J]. IEEE Signal Processing Letters, 2016, 23(12): 1736-1740.

[38] RAHIM S H, CONRAD B A, GUSTAVO D V. An Information Fidelity Criterion for Image Quality Assessment Using Natural Scene Statistics[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2005, 14(12): 2117-2128.

[39] ZHANG L, ZHANG L, MOU X. RFSIM: A Feature Based Image Quality Assessment Metric Using Riesz Transforms[C]// 2010 IEEE International Conference on Image Processing, 2010: 321-324.

[40] XUE W, ZHANG L, MOU X, et al. Gradient Magnitude Similarity Deviation: A Highly Efficient Perceptual Image Quality Index[J]. IEEE Transactions on Image Processing, 2013, 23(2): 684-695.

[41] KIM J, NGUYEN A D, SANGHOON L. Deep CNN-Based Blind Image Quality Predictor[J]. IEEE Trans Neural Netw Learning Syst, 2019, 30(1): 11-24.

Full Reference Image Quality Assessment Based on Visual Saliency and Perception Similarity Index

WANG Qian1, ZHENG Bin-jun1, KONG Ling-jun2, GU Ping2

(1. University of Shanghai for Science and Technology, Shanghai 200093, China;2. Shanghai Publishing and Printing College, Shanghai 200093, China)

Image Quality Assessment (IQA) is designed to use computational models to automatically measure image quality in line with the subjective assessment of the human visual system and to apply them to relevant practical problems. Firstly, the reference image and the distorted image are input, and the visual saliency model is used to calculate the feature mapping of the local similarity of the image, which is used as the weighting function in the quality score pooling stage. At the same time, in view of the deficiency of the visual saliency map as a single feature mapping, the gradient amplitude is increased, then the image is transformed into the color space to extract the color features, and finally the corresponding weight is allocated to calculate the image similarity. Results the comparative test on four large data sets shows that while maintaining a moderate computational complexity, vspsi has improved the prediction accuracy compared with other representative models. In particular, the SROCC on the tid2013 data set reaches 0.905 5. The results tell that VSPSI is an IQA with excellent performance. It has good performance in different data sets and different distortion types, and has strong robustness. It can be used to assess the objective quality of multi class distorted images. At the same time, the performance of VSPSI can be further improved by optimizing the visual saliency model.

image quality assessment; visual saliency; human visual system

TN911.73

A

1001-3563(2022)09-0239-10

10.19554/j.cnki.1001-3563.2022.09.032

2021–10–25

一流专科高等职业教育专业建设项目(2020ylxm–1)

王茜(1994—),女,上海理工大学硕士生,主攻艺术复制品质量客观评价。

孔玲君(1972—),女,博士,上海出版印刷高等专科学校教授,主要研究方向为图文信息处理与色彩再现,数字印刷及质量评价等。

责任编辑:曾钰婵