基于多人人脸检测的裸眼三维内窥镜显示系统

2022-02-14冷一林许召辉

【作 者】冷一林,许召辉

1 上海大学通信与信息工程学院,上海市,200444

2 中航华东光电(上海)有限公司,上海市,201114

0 引言

21世纪,外科发展主要方向是细致微创,微创外科手术凭借创伤小、减轻患者痛苦、术后恢复快、降低医疗成本等诸多优点逐步取代了开放式手术,在早期的内窥镜手术领域中得到了广泛应用。医生受到二维图像引导的术野限制,缺乏对距离的精确估计,一定程度上增加了手术的不确定性并对病患的生命安全带来一定风险[1-3]。人体体腔为三维结构,三维显示技术可在微小创口上还原人体内的立体视野,真实反映进行手术的操作空间,可促进镜下解剖的正确理解和操作,脏器间距离的正确把握,以及镜下缝合等细致操作的实现[4],从而协助医生精确实施手术、提高手术质量、减轻患者创口痛苦、缩短术后康复时间,拓展内镜外科的适应性。微创手术可视化发展经历了从二维平面显示技术到三维立体显示技术的过程。当前三维内窥镜手术采用了多样成像系统的三维内窥镜和佩戴式三维显示设备,改善了二维内窥镜图像在深度信息上的缺乏,降低了医生操作手术器械的难度,提高了手术的准确性[5]。

培训医生学习三维成像系统下的手术操作时,显示器需要针对多人进行显示角度的调整,以达到最优的视频教学效果,利用Adaboost级联器和主动形状模型主动形状模型(Active Shape Model,ASM)的传统人脸识别方法[6]在有遮挡的人脸和侧脸识别上表现较差,引入在目标识别方面表现优异的YOLO(You Only Look Once)v5深度学习算法对教学场景下的多人脸进行聚类并计算人脸密度中心,调整显示器的光栅,能够有效改善因三维显示器较窄的视角而低效的手术教学。

1 裸眼三维内窥镜显示系统设计

裸眼三维内窥镜显示系统给术者提供双目视角下获得的微创手术场景深度信息,在长时间的手术过程中能有效缓解术者的姿态疲劳和视觉疲劳,协助更精准地操作手术器械,减少术区周围组织的损伤,但是受限于裸眼三维显示观看视角小的问题,从三维内窥镜显示系统的后端显示角度出发,将一种能够实时跟踪人眼位置,实时调整显示输出的机制加入显示终端,保证深度信息的有效展示与自然教学观看方式的实现。

1.1 裸眼三维内窥镜显示系统硬件组成

裸眼三维内窥镜显示系统硬件主要由摄像采集模块、人脸检测模块、裸眼三维显示模块组成。摄像采集模块采用摄像头对教学场景进行实时拍摄录制,将带有学员人脸的视频流传入人脸检测模块,人脸检测模块使用神经网络对带有人脸的图像进行人脸检测,将人脸密度中心传送给裸眼三维显示模块,最后经过计算获得需要调整的光栅角度,控制调整三维显示。

裸眼三维显示模块包含TFT-LCD液晶面板、狭缝式光栅和液晶光栅驱动,驱动部分的现场可编程逻辑门阵列(Field Programmable Gate Array,FPGA)3D信号处理板接收串口传送的像素排列方式进行处理,控制对应液晶光栅图像子像素进行重新排布,动态改变最佳视点区域来实现自适应三维显示的效果。

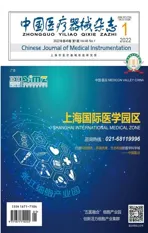

三维显示部分采用狭缝式光栅自由立体显示技术进行三维显示,该技术是目前最为成熟的三维立体显示技术,相较于体三维和全息显示,其性能更稳定,受环境干扰影响小,目前也是最为普及的裸眼三维显示技术。狭缝式光栅自由立体显示技术是基于双目视差原理的三维立体显示技术[7],其显示器主要由平板显示屏和光栅精密组合而成,左右眼视图交错排列在显示屏上,光栅将两类左右眼视图的光线进行分光,使得观看者位于合适区域范围时,其左右眼能接收到对应的左右视图,然后经由大脑处理,将图像融合成能够进行三维感知的图像,使得观看者获得立体感知。狭缝光栅自由立体显示原理,如图1所示。

图1 狭缝光栅自由立体显示原理Fig.1 Slit grating autostereoscopic display principle diagram

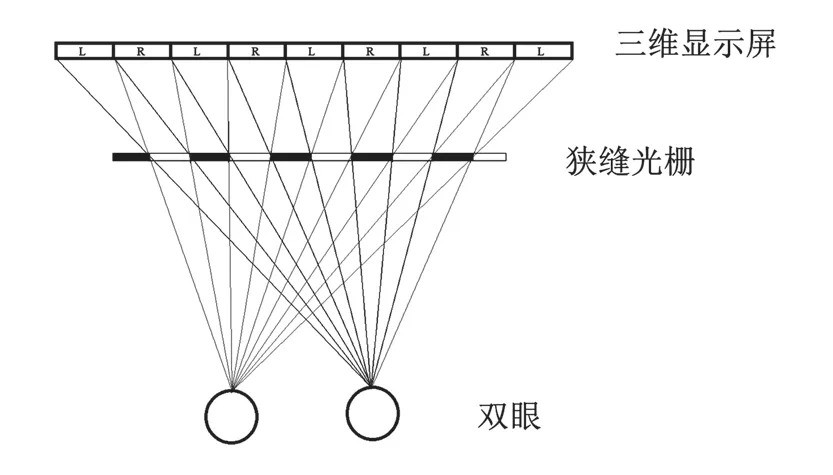

我们依据提出的显示需求结合狭缝式光栅原理设计的裸眼三维内窥镜显示器的主要参数,如表1所示。

表1 三维显示模块主要参数Tab.1 Main parameters of 3D display module

1.2 裸眼三维内窥镜显示系统软件组成

在设计的裸眼三维内窥镜显示系统使用过程中,医生可通过操控软件与内窥镜裸眼三维显示系统进行交互。系统的软件功能包括显示通道的管理和人脸实时检测两个功能,如图2所示。

图2 裸眼三维内窥镜显示系统软件功能Fig.2 Glasses-free 3D endoscope display system software function

1.2.1 显示通道选择模块

考虑到教学场景下从二维显示到三维显示的手术学习过程需要一个学习的过渡期,模块引入2D/3D切换选择,教学者可以根据需求,通过光路的选择功能,选择当前显示方式是二维或三维显示,以便教学的时候前后对照;同时也引入了左视点图像和右视点图像的切换显示,适时可切换来进行具体病灶的查看和手术教学,提高教学效率。

1.2.2 人脸实时检测模块

普通的光栅式三维显示器存在最佳视区较窄、易串扰的问题,在手术教学环境下,使尽量多的学习人群获得最佳视区能够大大提高教学效果。人脸实时检测模块对前置摄像头采集到的图像进行实时人脸检测,精确标记图像中的人脸坐标并计算人脸密度中心,FPGA结合中心坐标和最佳视区进行计算,进行排图调整,实时更新最佳视区的中心角度,让更多的人获得最优观看效果。

在手术教学过程中,人脸的角度、光照方向、遮挡面积以及背景比较复杂,谷东兴等[2]提出的基于类哈尔特征的AdaBoost目标检测改进算法在人脸检测率上达到94.33%,检测速度大于200 帧/s,在简单环境下的人脸检测表现较好,速度也很快,但当人脸角度和姿势复杂多样,环境光照变化时,其检测精度大大降低,鲁棒性较差。

为解决这一问题,本研究在人脸检测模块引入基于深度学习的YOLOv5s人脸检测模型。YOLOv5s具有模型小,仅27 MB大小,速度快,能达到每秒140帧。选用该模块,人脸识别速度将会得到显著提高。

YOLOv5s在结构上分为输入层(Input),主干层(Backbone),颈部层(Neck)和检测层(Head)。

输入层包括马赛克(Mosaic)数据增强、自适应图片缩放和自适应锚定框计算三部分,它们使模型学会在更小的范围内识别对象,并将推理速度提高了37%。

主干层是网络检测的主干,主要提取图像的高中低层的特征。该网络主要是采用了隔行采样拼接结构(Focus)和跨阶段局部网络结构(Cross Stage Partial Network,CSPnet),降低算力消耗,提高速度的同时将梯度的变化集成到特征图中,实现更丰富的梯度组合和更少的计算量。

颈部层采用了路径聚合网络(Path Aggregation Network,PANet)结构,该结构生成的特征金字塔使得顶层特征图也可以获得底层带来的丰富位置信息,由此加强了网络特征融合的能力,提升了物体的检测效果。

检测层对图像特征进行预测,依据目标大小进行分类输出三组特征图,生成边界框并预测类别。在网络训练时,三个特征图解码的边界框全部送入打标签函数,进行后一步的标签以及损失函数的计算,而在网络进行测试时,网络会选取一个置信度阈值来过滤掉低阈值边界框,经过非极大值抑制(Non-maximum Suppression,NMS)后输出整个网络的预测结果。

这里的损失函数为GIoU(Generalized IoU Loss)损失函数[8],它把交并比(Intersection over Union,IoU)设为回归的,在保持原有反映锚框相交关系的同时,解决了IoU无法反映两个框距离远近的问题,表达式如式(1)所示。

其中IoU(A,B)表示预测框A与真实框B的交并比,C为A和B的最小包围框。

1.2.3 中心视图调整模块

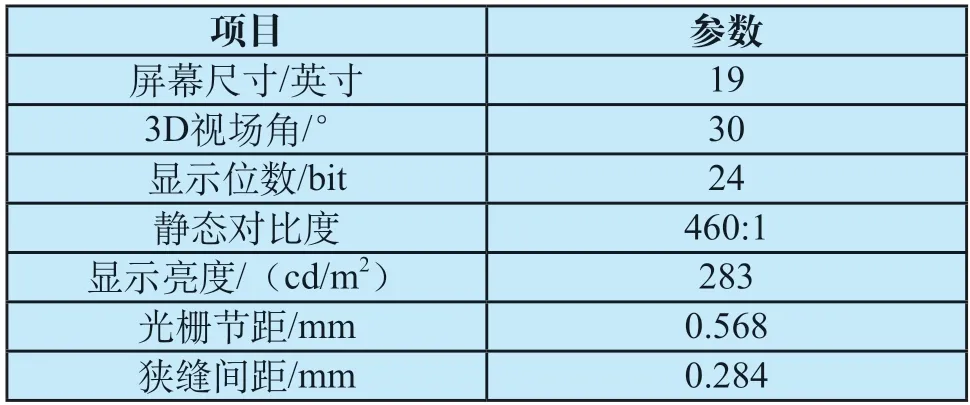

调整视图需要根据人脸密度中心的空间位置进行计算对显示器像素排列方式进行计算,传输给裸眼三维显示模块的FPGA硬件驱动部分,实现最佳视角的调整,减少眩晕,提高手术教学效率。立体显示视图中光栅调整示意,如图3所示。

图3 立体显示视图中光栅调整示意Fig.3 Schematic diagram of grating adjustment in stereo display view

本模块根据谷东兴等[2]的工作进行设计,将人脸实时检测子模块获得的人脸坐标进行聚类,获得了画面中人脸密度中心的空间位置坐标E(x,y,z),D为左右眼视区的中心间距,f为光栅到屏幕的距离,故可根据人眼位置z点计算E点水平方向左右眼视区的中心间距:

设n为中间变量,表示间距的倍数:

R为光栅透光比例,由上式可知中心点的位置变化为:

若求Xmove为负,则需反向调整:

根据式(2)(4)(5),可计算出对应像素的移动单位:

故对应像素移动ex个单位即可实现视区的调整,获得最优的视场显示角度。

2 试验与结果

为了验证我们设计的系统性能,对本系统的各个模块进行单独的功能验证实验,分为显示通道选择模块、人脸识别模块及中心视图调整模块实验。

2.1 显示通道选择模块实验

本实验对裸眼三维显示器进行显示视图的切换,分为2D/3D视图和左右视图切换。在显示器下方有“2D/3D”、“L”和“R”按钮,“2D/3D”按钮控制2D/3D视图的切换,“L”和“R”控制左右视图的切换,两者显示效果,如图4所示。

图4 2D/3D显示和左右显示视Fig.4 2D/3D display and left and right display view

2.2 人脸识别模块实验

2.2.1 实验数据及实验平台

本研究的实验数据是裸眼三维手术教学场景下的人脸检测的数据,根据其特性选用了人脸识别领域公认的评测方法与标准FDDB[9]对网络进行预训练,为进一步提高网络性能,选用了数据量丰富的WiderFace[10]数据集对网络进行训练,同时采集了100帧手术教学场景下的人脸图片对训练结果进行测试。

FDDB数据集共包含2 845张图片,包含彩色以及灰度图,其中的人脸总数达5 171个[9]。WiderFace共有32 203张图片,人脸个数共393 703个。两个数据集的人脸都在比例、角度、遮挡方面具有高度可变性[10]。测试集的100帧图片中有1 409张人脸,人脸角度、比例、遮挡情况复杂多样,均满足手术教学应用场景,对于模型具有较好的测试效果。

人脸检测模块选用Pytorch进行网络架构,使用GeForce GTX Titan XP GPU,i9-9900K CPU进行运算。

2.2.2 训练方法及验证

网络模型训练阶段,初始学习率设置为0.000 1并进行自适应调整,权重的衰减系数为0.000 5,批处理大小为64,交并比阈值为0.6。当损失趋于稳定时,自适应降低学习率,可减少模型过拟合的问题,逼近最小值。经过训练,迭代次数达到350左右时,模型的损失趋于稳定状态,训练集的准确率为97.88%,检测速度为135帧/s,满足了高精度和实时性的要求。算法性能对比,如表2所示。

表2 算法性能对比Tab.2 Algorithm performance comparison

2.3 中心视图调整模块实验

鉴于目前尚未有关于裸眼三维显示视角调整评价的标准,这里参考国际电信联盟对显示器的画面对比度和亮度进行测试所制定的标准,通过三维模式下显示器最大亮度范围和最高对比度的角度与实际人脸密度中心的对照,可验证本系统的视角调整效果。裸眼三维显示器的亮度与对比度测量图,如图5所示。

图5 亮度及对比度测量图Fig.5 Brightness and contrast measurement chart

在普通2D和3D显示状态下,显示器视场角大于30°,静态对比度大于460:1,三维显示亮度大于283 cd/m2。经实验可得,开启人脸检测并调整显示器光栅时,人脸密度中心位置与显示器的亮度中心偏差在1.4 cm范围内,与对比度最高处位置偏差在1.7 cm范围内,实现了系统的视场调整功能,满足应用需求。

3 讨论与总结

目前裸眼三维显示技术因具有特殊的深度信息,正飞速应用到临床手术中,医生从传统二维的显示转到三维显示进行手术,在这一过程中,需要进行一段时间的学习,为提高手术教学场景下的教学与学习的效率,我们提出了一种裸眼三维手术教学显示系统,它通过显示器前置摄像头和轻量化高性能的YOLOv5s人脸检测技术实时计算显示器前的人脸密度中心,经由图像处理系统中FPGA信号处理板,接收串口传送过来的排图命令,控制对应液晶光栅图像子像素进行重新排布,动态改变最佳视点区域来实现自适应三维显示的效果,将最佳视点区域调整到人数较多的角度,减少在教学过程中的图像串扰,使尽量多的人获得最佳视觉体验,提高教学效率。