融合深度特征和FHOG特征的尺度自适应相关滤波跟踪算法

2021-12-22孙博王阿川

孙博 王阿川

摘 要:为了解决核相关滤波跟踪算法在复杂场景下跟踪效果差的问题,提出了一种融合深度特征和尺度自适应的相关滤波目标跟踪算法。首先,通过深度残差网络(ResNet)提取图像中被跟踪区域的深度特征,再提取目标区域方向梯度直方图(FHOG)特征,通过核相关滤波器学习,分别得到多个响应图,并对响应图进行加权融合,得到跟踪目标位置。其次,通过方向梯度直方图(FHOG)特征,训练一个PCA降维的尺度滤波器,实现对目标尺度的估计,使算法对目标尺度发生变化有很好的自适应能力。最后,根据响应图的峰值波动情况改进模型更新策略,引入重新检测机制,降低模型发生漂移概率,提高算法抗遮挡能力,在标准数据集OTB100中与其他7种目标跟踪算法进行比较。结果表明,相比原始KCF算法,改进后的KCF算法精准度提升了29.4%,成功率提升了25.9%。所提算法实现了对跟踪目标位置的精准估计,提高了尺度自适应能力和算法速度,增强了算法抗遮挡能力。

关键词:计算机图像处理;目标跟踪;核相关滤波;深度特征;多尺度;抗遮挡

中图分类号:TP391 文献标识码:A

doi:10.7535/hbkd.2021yx06006

Scale-adaptive correlation filter tracking algorithm fusing depth features and FHOG features

SUN Bo, WANG Achuan

(College of Information and Computer Engineering,Northeast Forestry University,Harbin,Heilongjiang 150040,China)

Abstract:Aiming at the problem of poor tracking by the kernel-related tracking filter algorithm in complex scenes,proposed a correlation filter target tracking algorithm combining depth features and scale adaptation.Firstly,the deep residual network (ResNet) was used to extract the depth features of the tracked area in the image,and then the target area directional gradient histogram feature (FHOG) was extracted,and multiple response maps were obtained through the kernel correlation filter learning,and were performed weighted fusion to obtain the tracking target position.Secondly,a PCA dimensionality reduction scale filter was trained through the directional gradient histogram (FHOG) feature to realize the estimation of the target scale,so that the algorithm had a good adaptive ability to the change of the target scale.Finally,according to the peak fluctuation of the response graph,the model update strategy was improved and the re-detection mechanism was introduced to reduce the probability of model drift and improve the anti-occlusion ability of the algorithm.Compare with other 7 target tracking algorithms in the standard data set OTB100.The experimental results show that the accuracy of the original KCF algorithm is improved by 29.3%,and the success rate is improved by 25.3%.The proposed algorithm achieves accurate estimation of tracking target position,improves the scale adaptive ability and the speed of the algorithm and enhances the anti-occlusion ability of the algorithm.

Keywords:

computer image processing;target tracking;kernel correlation filtering;depth feature;multi-scale;anti- occlusion

視觉目标跟踪一直是计算机视觉领域的热点研究问题,随着技术的发展,目标跟踪技术被广泛应用于无人飞行器、智能交通系统、智能监控系统、虚拟现实等领域。在跟踪过程中,目标被遮挡,环境中的光照条件、目标尺度发生变化等原因会导致跟踪效果较差。针对该类问题,众多学者对跟踪算法进行了一些研究。

由HENRIQUES等[1]提出的核相关滤波跟踪算法(kernel correlation filter,KCF),通过提取图像方向梯度直方图(HOG)特征,利用循环矩阵在频域可对角化的特点,使得矩阵运算转化为向量间点乘运算,加快了运算速度,但该方法的不足在于没有对目标尺度变化进行处理,无法做到尺度自适应。自适应颜色属性跟踪方法(CN)[2],通过将RGB空间的特征转化到11维颜色空间,使算法的输入特征更加丰富,跟踪精度得到了提高。判别式尺度空间跟踪(discriminative scale space tracker, DSST)[3]算法,引入了位置滤波器与尺度滤波器,2个滤波器相互独立,通过尺度滤波器完成对目标的尺度估计。Staple算法[4],使用HOG特征和COLOR特征2种互补的特征因子对目标进行学习,弥补了尺度变换和光照对跟踪效果造成的影响。尺度自适应相关滤波器SAMF算法[5],利用尺度池的方法完成对目标的自适应跟踪。sKCF[6]算法在KCF算法基础上增加了自适应高斯窗口函数和尺度估计。但上述算法在遇到背景杂乱、目标快速运动、光照变化、被遮挡和尺度变化等问题时,会出现不同程度的跟踪精度下降,甚至目标丢失的问题。

随着深度学习技术的发展,图像深层次的语义信息[7] 得以被挖掘,在目标跟踪、图像分割[8]等领域得以应用。HCF[9]跟踪算法在核相关滤波跟踪算法的基础上,选取多层深度特征代替HOG特征,并利用浅层网络特征进行跟踪定位,提高了跟踪精准度。Siam R-CNN算法[10] 提出了一种新的实例挖掘策略,提高对相似目标的鲁棒性 。C-COT[11]算法是对深度学习和相关滤波算法的改进,通过立方插值和Hessian矩阵,解决了算法在连续空间域训练的问题。

针对上述问题,本文提出一种融合深度特征和FHOG特征的尺度自适应相关滤波跟踪算法。将深度特征与FHOG特征融入核相关滤波跟踪框架,利用尺度滤波器完成对目标尺度的估计,通过PCA降维大幅缩减尺度滤波器的特征维度,减少尺度估计环节的耗时;再根据响应图的峰值波动情况判断目标是否被遮挡,在目标被遮挡或丢失后利用DPM模型重新检测目标位置;最后根据响应图峰值波动情况与最大响应值改进模型更新策略。

1 KCF算法

KCF算法的主要流程如下:先利用循环矩阵对跟踪区域进行正负样本采样,提取样本HOG特征,训练滤波模板;再利用多项核函数计算目标区域和待选区域的相似度,得出响应图,响应图中峰值位置即为跟踪目标位置。

1.1 训练分类器

设训练样本为xi,对应标签为yi,线性分类器为f(x)=wTxi,训练分类器的目的是通过样本xi,找到最佳的滤波模板系数w,使得f(xi)与标签yi平方误差和最小,分类器的损失函数如式(1)所示:

minw∑i(f(xi)-yi)2+λ‖w‖2,(1)

式中:λ为正则项。

通过引入映射函数φ(x),将数据映射到高维度空间,此时w可表示为φ(xi)的线性组合,如式(2)所示,并且可以使用核函数进行求解。

w=∑iαiφ(xi)。(2)

對分类器求解,如式(3)所示:

α=(k+λI)-1y,(3)

式中:I为单位矩阵;y为样本对应标签矩阵;k为核矩阵;α表示系数。

利用循环矩阵以及傅里叶逆变换对式(3)在频域中进行求解,如式(4)所示:

α=F-1F(y)F(k)+λ,(4)

式中:F-1表示傅里叶逆变换。

1.2 位置检测

在下一帧图像中,z为跟踪目标候选窗口区域图像样本,则z的回归值如式(5)所示:

f(z)=wTz=∑iαiφ(x)Tφ(z)=αTkzx,(5)

式中:kzx是z和x的核相关;αT为α的转置向量;x为训练样本向量;φ(x)为训练样本特征向量;φ(z)为候选窗口样本特征向量。

将式(4)代入式(5),得到分类器的响应输出,如式(6)所示:

f(z)=α⊙kzx=F-1[F(α)⊙F(kzx)],(6)

式中:⊙代表点乘,最大响应点为跟踪目标中心位置。

1.3 更新分类器

由于目标不断运动会导致外观模型发生变化,直接影响跟踪效果,因而需要不断更新滤波器与外观模型:

xi=(1-η)xi-1+ηxi,(7)

αi=(1-η)αi-1+ηαi,(8)

式中:xi为外观模型;αi为分类器系数;η为学习率。

2 融合深度特征与FHOG特征的改进KCF算法

针对复杂环境下相关滤波跟踪算法的跟踪精度和鲁棒性的问题,采用HOG特征的KCF目标跟踪算法,由于提取特征单一,可能会导致跟踪出现漂移,甚至跟踪失败的问题。由于FHOG特征对目标运动模糊,光照变化描述较好,深度特征有较好的局部纹理表达能力,包含更多的语义信息,能很好地识别目标形变,所以本文提出将FHOG特征与深度特征进行加权融合替代原有KCF算法的单一特征,完成对目标的精准定位。在跟踪过程中目标尺度可能会不断变化,KCF算法无法对目标做到自适应尺度估计,本文通过提取多个尺度样本,训练尺度滤波器,完成对目标尺度的估计,从而改变目标模型更新机制,提高跟踪精度。

2.1 特征融合

2.1.1 目标区域深度特征提取

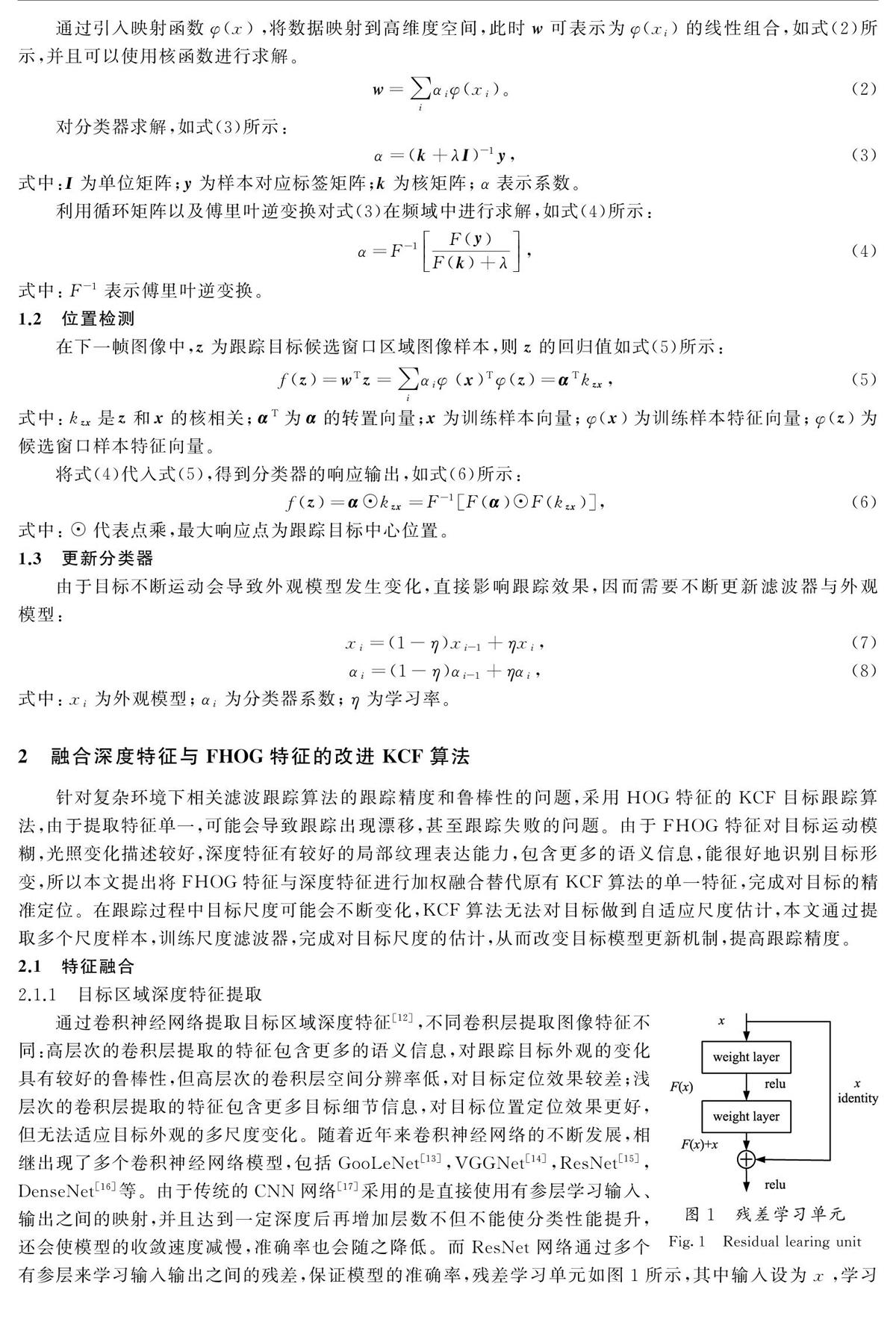

通过卷积神经网络提取目标区域深度特征[12],不同卷积层提取图像特征不同:高层次的卷积层提取的特征包含更多的语义信息,对跟踪目标外观的变化具有较好的鲁棒性,但高层次的卷积层空间分辨率低,对目标定位效果较差;浅层次的卷积层提取的特征包含更多目标细节信息,对目标位置定位效果更好,但无法适应目标外观的多尺度变化。随着近年来卷积神经网络的不断发展,相继出现了多个卷积神经网络模型,包括GooLeNet[13],VGGNet[14],ResNet[15],DenseNet[16]等。由于传统的CNN网络[17]采用的是直接使用有参层学习输入、输出之间的映射,并且达到一定深度后再增加层数不但不能使分类性能提升,还会使模型的收敛速度减慢,准确率也会随之降低。而ResNet网络通过多个有参层来学习输入输出之间的残差,保证模型的准确率,残差学习单元如图1所示,其中输入设为x,学习的特征为H(x),学习的残差为F(x)=H(x)-x,最终的学习特征为F(x)+x,当模型中的残差为0时,相当于做了恒等映射,网络模型不会因为层数的增加而再出现退化问题,性能不会随之下降,因此本文采用ResNet网络模型对跟踪目标进行特征提取。

ResNet共有5种不同结构,包括ResNet-18,ResNet-34,ResNet-50,ResNet-101,ResNet-152。结合各个模型的泛化能力以及模型的演算速度等因素,本文选用在ImageNet上训练结果top1(识别准确率)达到75%的ResNet-50网络模型来提取跟踪目标的深度特征。选取ResNet-50中Conv2-1与Conv4-1两层特征,其中Conv4-1包含更多语义信息,能够很好地识别目标的形变,浅层的Conv2-1能够对跟踪目标进行精确定位,再将每个卷积层提取的深度特征调整为固定尺寸。

2.1.2 目标区域FHOG特征提取

HOG特征提取:首先,将图像灰度化,利用Gamma校正对图像进行归一化,计算图像每一个像素的梯度;其次,将图像划分成若干个cell,计算每个cell的梯度特征;最后,将cells组成block,将block中的cells的梯度特征串联得到block的梯度特征,将所有block的梯度特征进行串联就是图像的HOG特征。

FHOG[18]是在HOG特征的基础上进行了一些改进。首先,对跟踪目标区域方向敏感(0~360°)和方向不敏感(0~180°)的像素级特征进行映射;其次,对其进行归一化与截断处理,得到27+4=31维特征向量。在31维特征向量中,包含18维对方向敏感的特征,9维对方向不敏感的特征以及4维累加特征。FHOG特征能够详细描述目标边缘信息,并且对局部形状信息表现效果较好,对于光照强度的变化具有很好的鲁棒性。

2.1.3 融合深度特征与FHOG特征

采用ResNet-50中Conv2-1与Conv4-1提取跟踪目标区域的深度特征,同时提取目标区域的FHOG特征。每个特征在频域中的响应计算公式如式(9)—式(11)所示:

fConv2-1(z)=F-1[F(kzxConv2-1)⊙F(αConv2-1)],(9)

fConv4-1(z)=F-1[F(kzxConv4-1)⊙F(αConv4-1)],(10)

fFHOG(z)=F-1[F(kzxFHOG)⊙F(αFHOG)],(11)

式中:fConv2-1(z),fConv4-1(z),fFHOG(z)分别代表待检测窗口样本z的Conv2-1特征、Conv4-1特征及FHOG特征对应的响应图;α代表每个特征对应分类器的解;kzx代表训练样本对应的特征向量x与下一帧候选区域样本z的核相关。

將3个特征响应图谱进行加权融合,如式(12)所示:

f(z)=λ1fConv2-1(z)+λ2fConv4-1(z)+λ3fFHOG(z)。(12)

式中:λ1,λ2,λ3为特征融合系数,在实验过程中发现,3个响应图进行融合,采用不同权重,效果不同,不同权重下的跟踪结果对比如表1所示。通过大量实验得出改进算法融合权重λ1=1,λ2=0.5,λ3=0.7。f(z)为最终融合后的响应图,峰值位置即为跟踪目标中心位置。算法的主要结构如图2所示。

2.2 目标尺度自适应估计

本文所提算法通过训练一个一维相关滤波器作为尺度滤波器,完成对跟踪目标的尺度估计。首先,依据目标中心位置进行采样,提取S个不同尺度样本。采用尺度估计的目标样本尺寸参数选择原则,如式(13)所示:

anP×anR, n∈-S-12」…S-12」,(13)

式中:滤波器的总级数用S来表示,S决定n的取值范围,本文提取S=33个不同的尺度样本;P代表前一帧的宽;R代表前一帧的高;」代表向下取整;a为尺度因子,尺度选择的步长受到尺度因子的影响,本文尺度因子a取值为1.01。 其次,对每个尺度样本提取FHOG特征,利用特征向量训练尺度滤波器;最后,经过滤波器得到的响应图谱中响应值最大的点为目标最佳尺度。尺度滤波器的模板为M,N,如式(14)和式(15)所示:

M=F(yei)⊙(F(xei))*,(14)

N=∑dk=1(F(xkei)⊙(F(xkei))*),(15)

式中:xei代表样本;d是样本的FHOG特征维度;xkei为样本的k维特征;样本xei对应标签为yei;F为傅里叶变换;⊙代表点乘;*表示共轭。

尺度滤波器响应输出对应的公式如式(16)所示:

y∧e=F-1(∑dk=1Mk⊙F(ze)N+λ),(16)

式中:F-1为逆傅里叶变换;λ为正则项。

2.3 基于PCA的尺度特征降维

尺度滤波器需要对33个尺度样本S的每个特征维度都进行一次快速傅里叶变换,在一定程度上降低了跟踪算法的速度。利用主成分分析法(PCA),对FHOG特征进行降维,在不损失图像特征的前提下,减少计算量,加快跟踪速度。

主成分分析法通过坐标的旋转与平移变换,将一组相关变量投影到不相关的低维子空间中,达到降维目的。具体过程如下。

首先,通过式(17)将坐标原点平移至样本数据的中心,让原本相互独立的样本大致相关。

S(i)=S(i)-mean(S(i)),(17)

式中:S(i)为第i个尺度样本的FHOG特征展开。为了避免图像噪声引起数据偏移,将协方差矩阵E进行特征分解,同时将投影矩阵Pm的每行设置为E对应的特征向量,减少数据偏移的影响。协方差矩阵特征值分解如式(18)所示:

E(i,j)=S(i)S(j)T。(18)

其次,利用投影矩阵Pm将S(i)投影到低维空间,对尺度样本S(i)的31维FHOG特征降维,在保证不损失图像特征信息的同时,减少尺度处理环节的耗时,提升算法速度。

2.4 改进的模型更新策略与重新检测

针对模型更新环节,传统KCF算法在每一帧跟踪结束后,都会对模型进行更新,这种更新策略的弊端在于,一旦跟踪目标被遮挡,遮挡信息就会更新到模型中,污染模型[19],而响应图的峰值波动反映了跟踪精确度的高低。本文通过计算平均峰值相关能量[20](average peak-tocorrelation energy,APCE)观察响应图峰值波动程度,APCE主要反映了响应图的峰值和各点响应值的关系。通过APCE值判断目标是否被遮挡,APCE表示方式如式(19)所示:

APCE=|fmax-fmin|2mean∑w,h(fw,h-fmin)2,(19)

式中:fmax,fmin,fw,h分别代表最大响应、最小响应和第w行、h列的响应。

本文设置APCE阈值为L1。当L1高于阈值时,表明跟踪效果良好,目标未被遮挡,则无需重新检测;当低于阈值时,说明跟踪目标被严重遮挡或丢失,此时停止对模型更新,开始重新检测。本文采用DPM模型[18] 作为重新检测机制,利用待跟踪序列第一帧提供的跟踪目标的bounding-box(位置,尺寸)获取正负训练样本,训练DPM模型。DPM模型重新检测具体步骤为1)构建待检测图像HOG特征金字塔;2)通过滑动窗口的方式计算每个子模型的响应值,与模型中阈值进行比较;3)采用非极大值抑制的方法去除重复检测,得到最终检测结果,完成对目标的重新定位。

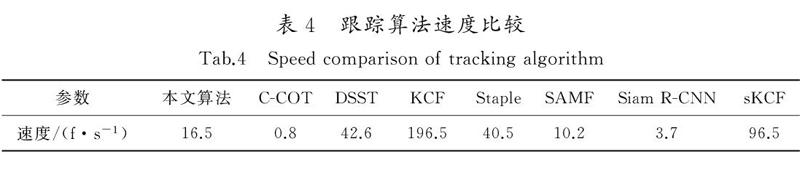

为了解决当目标被遮挡或丢失时,干扰信息被错误地更新到模型中,导致跟踪出现漂移的问题,本文设置2个阈值L2,L3(L2 式(20)为更新策略。 η=0.02, APCE>L1&fmax>L3,0.01, APCE>L1&L2 通过改进更新模型策略引入重新检测机制,减少不必要的模型更新,加快了跟踪速度,提高了跟踪算法的精准度。 2.5 算法步骤 本文算法步骤如下: 1)获取视频序列第一帧中跟踪目标的位置与尺度信息,提取深度特征与FHOG特征训练位置滤波器,提取多個尺度样本训练尺度滤波器。 2)找到下一帧视频序列的待检测区域,利用ResNet卷积神经网络获取待检测区域Conv2-1与Conv4-1两层深度特征,同时提取其FHOG特征。 3)将深度特征与FHOG特征分别通过滤波器运算,得到对应的响应图fConv2-1,fConv4-1,fFHOG,然后,对3个响应图进行加权融合,确定跟踪目标精确位置。 4)对跟踪目标提取33个不同的尺度样本,提取样本的FHOG特征并做PCA降维处理,将特征经过尺度滤波器运算,完成对目标的尺度估计。 5)确定目标位置与尺度,根据平均峰值相关能量(APCE)判断是否更新滤波器模板,若小于阈值L1,则停止更新,利用DPM模型重新检测跟踪目标;若高于阈值L1,则根据fmax选择学习率η进行更新。 6)依次重复步骤2)—步骤5),直至完成对全部视频序列的跟踪。 3 实验结果与分析 3.1 实验环境 实验硬件环境为IntelCore i5-9600kf CPU,主频4.8 Hz,NVIDIA RTX2080 GPU,内存32 GB配置的计算机。软件运行的环境为Windows10操作系统,使用Matlab2017a为开发平台,正则项λ=10-4,采用标准数据集OTB-100[21]对本文算法进行实验。 3.2 评价指标 为了评估目标算法性能,在实验中采用中心位置误差(center location error,CLE)和重叠率(overlap precision,OP)2个评估参数对跟踪结果进行评价,重叠率如式(21)所示: OP=area(AT∩AG)area(AT∪AG),(21) 式中:AT为算法跟踪框;AG为标准跟踪框。 中心位置误差如式(22)所示: CLE=(xm-xn)2+(ym-yn)2,(22) 式中:xm,ym为算法跟踪目标中心位置;xn,yn为标准中心位置。 3.3 定量分析 将本文改进算法与Staple,C-COT,DSST,KCF,SAMF,Siam R-CNN,sKCF 7种典型目标跟踪算法在OTB-100上进行测试对比,选用OTB-100中10种属性来衡量算法性能:SV(scale variation)代表尺度变化、IPR(in-plane rotation)代表旋转、OCC(occlusion)为遮挡、OV代表目标超出视野范围、BC(background clutters)代表背景杂乱、LR(low resolution)代表分辨率低、IV(illumination variation)代表光照发生变化;MB(motion blur)代表模糊、FM(fast motion)代表快速运动、OPR(out-of-plane rotation)代表图像外旋转。实验结果如表2和表3所示,其中表2表示算法各属性跟踪精准度,表3表示算法各属性下跟踪成功率。由表2和表3可以看出,在不同干扰因素下本文算法都能表现出优越的跟踪性能,并且在遮挡条件下的精准度与成功率分别为0.895和0.653,均高于其他对比算法。这主要是由于所提算法改进模型更新策略,提高了算法的抗遮挡能力。综合以上分析可得,在遮挡条件下,改进算法具有较高的跟踪精准度,在应对复杂环境下具有较好的鲁棒性。 将本文所提算法和其他7种算法在OTB-100视频序列进行测试,得出成功率曲线与精准度曲线如图4所示,本文所提算法精准度为0.876,成功率为0.650,相比原始KCF算法精准度提升了29.4%,成功率提升了25.9%。与近年来结合深度学习的目标跟踪算法相比,精准度上高于C-COT 算法,略低于Siam R-CNN算法;与KCF的改进算法(sKCF)比较,在精准度与成功率上均高于该算法。 3.4 定性分析 为了测试算法对于跟踪目标旋转、遮挡、形变、光照、尺度变化的鲁棒性,本文选取了OTB-100中的Soccer,CarScale,Skiing,Ironman 4条视频序列对算法进行测试实验。同时与Staple,C-COT,DSST,KCF,SAMF,Siam R-CNN ,sKCF 7种算法进行比较,即每种算法在4条视频序列上均运行一次,跟踪结果如图5所示,以下对不同视频序列下各个算法跟踪效果进行分析。 1)Skiing序列中,目标区域光照发生变化、目标出现形变、快速运动、目标旋转出图像边界等问题,第21帧目标周围区域光照发生变化,并且运动目标出现旋转,KCF,DSST等算法均出现跟踪偏移、失败的情况,本文算法仍能对目标进行持续跟踪,第65帧,目标尺度缩小,本文算法对目标调整到最佳尺度。可见本文算法对光照、形变、旋转具有很好的鲁棒性。 2)Soccer序列中,目标出现光照、尺度变化,目标被遮挡,并且跟踪目标又出现了运动模糊现象,背景杂波现象。第127帧,背景出现杂波,光照发生变化,Staple算法跟踪失败,KCF和DSST算法出现漂移,本文算法持续跟踪。第210帧,目标出现运动模糊,本文算法能够有效地跟踪目标。第300帧,目标光照发生剧烈变化,DSST算法虽然能定位目标位置,但对目标尺度估计不准确。 3)CarScale序列中,目标出现尺度变化、遮挡等现象,在230帧与252帧,本文算法与Siam R-CNN算法对目标尺度估计较好,其他算法对目标的尺度变化处理结果较差,KCF算法无法对目标尺度进行估计。 4)Ironman序列中,目标出现光照、形变、遮挡、运动模糊,目标部分出現在视野外,背景出现杂波等现象。第102帧目标周围光照发生剧烈变化,DSST,KCF算法跟丢目标,Staple算法出现跟踪漂移,本文算法因改进模型更新策略并引入重新检测机制,对遮挡问题处理较好,所以能够准确地跟踪到目标。 3.5 算法速度 8种算法在OTB100视频序列测试的平均速度如表4所示,与其他7种算法相比较,本文所提算法速度为16.5 f/s,与近年来结合深度学习的综合性能较好的目标跟踪算法(C-COT,Siam R-CNN)相比,高于C-COT算法的0.8 f/s和Siam R-CNN算法的3.7 f/s,主要原因在于本文所提算法在尺度估计环节对特征进行PCA降维,减少了尺度估计环节计算耗时,提高了算法的速度。但与传统相关滤波算法速度相比略有下降, 主要原因是提取目标区域深度特征,提高目标精确位置的同时,导致计算量增大,算法实时性有所下降,本文算法在跟踪速度上还有待作进一步的改进。 4 结 语 针对复杂环境下单一特征和尺度估计导致的目标跟踪精度低、成功率差等问题,本文在核相关滤波算法框架的基础上,提出了一个融合深度特征和FHOG特征的尺度自适应相关滤波跟踪算法。提取图像的深度特征与FHOG特征,通过加权融合的方式将不同特征的响应图进行加权融合,得到目标的精确位置;通过建立尺度滤波器完成对目标尺度的估计,利用PCA降维大幅减少尺度滤波器的特征维度,减少了尺度估计环节的计算耗时。引入平均峰值相关能量(APCE)来判断目标遮挡或丢失情况,并用DPM模型重新检测,使算法具备一定的抗遮挡能力。改进模型更新策略,通过平均峰值相关能量和最大相关响应共同决定模型更新策略,减少在目标被遮挡或丢失等条件下对模型的错误更新,使模型更新更为准确。从实验结果上看,相较于原始KCF算法,本文算法的精准度和成功率有较大提升,并且在遮挡条件下有较好的跟踪效果。 但是,本研究尚存在一些不足,由于增加了深度特征,同时考虑尺度变化,使得算法的速度略有下降。未来将对算法速度进行改进,在保持准确率与成功率的同时,提升算法的跟踪速度。 参考文献/References: [1] HENRIQUES J F,CASEIRO R,MARTINS P,et al.High-speed tracking with kernelized correlation filters[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(3):583-596. [2] DANELLJAN M,SHAHBAZ KHAN F,FELSBERG M,et al.Adaptive color attributes for real-time visual tracking[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.[S.l.]:IEEE,2014:1090-1097. [3] DANELLJAN M,HGER G,SHAHBAZ KHAN F,et al.Accurate scale estimation for robust visual tracking[C]//Proceedings of the British Machine Vision Conference.[S.l.]:BMVA Press,2014.doi:10.5244/C.28.65. [4] BERTINETTO L,VALMADRE J,GOLODETZ S,et al.Staple:Complementary learners for real-time tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).[S.l.]:IEEE,2016:1401-1409. [5] LI Y,ZHU J K.A scale adaptive kernel correlation filter tracker with feature integration[C]//Computer Vision-ECCV 2014 Workshops.Cham:Springer International Publishing,2015:254-265. [6] MONTERO A S,LANG J,LAGANIRE R.Scalable kernel correlation filter with sparse feature integration[C]//2015 IEEE International Conference on Computer Vision Workshop (ICCVW).[S.l.]:IEEE,2015:587-594. [7] 睢丙東,张湃,王晓君.一种改进YOLOv3的手势识别算法[J].河北科技大学学报,2021,42(1):22-29. SUI Bingdong,ZHANG Pai,WANG Xiaojun.A gesture recognition algorithm based on improved YOLOv3[J].Journal of Hebei University of Science and Technology,2021,42(1):22-29. [8] 刘娜,岳琪琪,陈加宏,等.搜索区域和目标尺度自适应的无人艇海面目标跟踪[J].光学精密工程,2020,28(3):671-685. LIU Na,YUE Qiqi,CHEN Jiahong,et al.Search area and target scale adaptive sea surface object tracking for unmanned surface vessel[J].Optics and Precision Engineering,2020,28(3):671-685. [9] MA C,HUANG J B,YANG X K,et al.Hierarchical convolutional features for visual tracking[C]//2015 IEEE International Conference on Computer Vision(ICCV).[S.l.]:IEEE,2015:3074-3082. [10]VOIGTLAENDER P,LUITEN J,TORR P H S,et al.Siam R-CNN:Visual tracking by re-detection[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).[S.l.]:IEEE,2020:6577-6587. [11]DANELLJAN M,ROBINSON A,SHAHBAZ KHAN F,et al.Beyond correlation filters:Learning continuous convolution operators for visual tracking[C]//Computer Vision-ECCV 2016.Cham:Springer International Publishing,2016:472-488. [12]陈辉东,丁小燕,刘艳霞.基于深度学习的目标检测算法综述[J].北京联合大学学报(自然科学版),2021,35(3):39-46. CHEN Huidong,DING Xiaoyan,LIU Yanxia.Review of target detection algorithm based on deep learning[J].Journal of Beijing Union University(Natural Sciences),2021,35(3):39-46. [13]SZEGEDY C,LIU W,JIA Y Q,et al.Going deeper with convolutions[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).[S.l.]:IEEE,2015:1-9. [14]SIMONYAN K,ZISSERMAN A.Very Deep Convolutional Networks for Large-scale Image Recognition[DB/OL].[2014-09-04].https://arxiv.org/abs/1409.1556. [15]HE K M,ZHANG X Y,REN S Q,et al.Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).[S.l.]:IEEE,2016:770-778. [16]HUANG G,LIU Z,VAN DER MAATEN L,et al.Densely connected convolutional networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).[S.l.]:IEEE,2017:2261-2269. [17]劉佳真,陈勤霞,艾斯卡尔·艾木都拉.融合相关滤波和CNN的点状目标跟踪技术研究[J].激光与红外,2021,51(2):244-249. LIU Jiazhen,CHEN Qinxia,ASKR Hamdulla.Research on point target tracking technology based on correlation filtering and CNN[J].Laser & Infrared,2021,51(2):244-249. [18]FELZENSZWALB P F,GIRSHICK R B,MCALLESTER D,et al.Object detection with discriminatively trained part-based models[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,32(9):1627-1645. [19]刘坤,于晟焘.基于卷积神经网络的云雾遮挡舰船目标识别[J].控制与决策,2021,36(3):661-668. LIU Kun,YU Shengtao.Obscured ship target recognition based on convolutional neural network[J].Control and Decision,2021,36(3):661-668. [20]WANG M M,LIU Y,HUANG Z Y.Large margin object tracking with circulant feature maps[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).[S.l.]:IEEE,2017:4800-4808. [21]WU Y,LIM J,YANG M H.Online object tracking:A benchmark[C]//2013 IEEE Conference on Computer Vision and Pattern Recognition.[S.l.]:IEEE,2013:2411-2418. 收稿日期:2021-09-10;修回日期:2021-11-19;责任编辑:王淑霞 基金项目:黑龙江省自然科学基金(C201414) 第一作者简介:孙 博(1996—),男,吉林吉林人,硕士研究生,主要从事图像处理方面的研究。 通讯作者:王阿川教授。E-mail:wangca1964@126.com 孙博,王阿川. 融合深度特征和FHOG特征的尺度自适应相关滤波跟踪算法 [J].河北科技大学学报,2021,42(6):591-600. SUN Bo,WANG Achuan. Scale-adaptive correlation filter tracking algorithm fusing depth features and FHOG features [J].Journal of Hebei University of Science and Technology,2021,42(6):591-600.