超像素梯度流与元胞机融合的视频显著图检测

2021-10-14张荣国贾玉闪刘小君李晓明

张荣国,贾玉闪,胡 静,刘小君,李晓明

(1.太原科技大学 计算机与技术学院,太原 030024;2.合肥工业大学 机械工程学院,合肥 230009)

视觉显著性检测是一种应用于图像及视频上的人工智能技术,它可以将大量图像或视频中引人注意的目标对象提取出来,应用这一技术分析处理海量的图像及视频将成为时代发展的趋势。显著性检测方法大致可以分为两类:一类是由数据驱动的显著性检测方法,一类是模拟人类大脑驱动的显著性检测方法。由于技术发展的限制,现在还无法准确地模拟出大脑的运作机制,也就无法实现大脑驱动下的显著性检测,因此现有的显著性检测方法大多是由数据驱动的显著性检测。目前显著性检测方法发展越来越成熟,已被应用到对象识别、目标重定向、图像视频压缩等多个领域中[1-2]。

随着大数据时代的到来,人们需要处理的数据量越来越多,视觉显著性检测技术也由对图像的静态检测技术向动态的视频显著性检测技术转变。视频显著性检测是指从视频序列中检测出最引人注目的对象。Mahadevan等[3]将中心—周围方法应用到视频领域,该方法将颜色、强度、方向上的特征线性组合在一起,并和动态纹理模型相结合,以此生成显著图,提出的方法在动态视频场景中有好的表现。Cui等[4]将谱残差方法扩展到了视频域中,提出了一种时间谱残差方法,依据傅立叶频谱分析将动态视频显著目标与背景分离。Liu等[5]在视频显著性检测中应用信息论的知识进行显著性检测,用时空视频帧卷的信息表示显著值,他将信息论的知识扩展到了动态视频检测中。Xi等人[6]的方法将背景先验知识应用到了动态视频显著性检测中,使用背景先验知识检测不同时间状态下的背景区域,使用测地线距离提取空间上的显著目标,最后将时间状态上得到的显著图和空间状态下得到的显著图融合得到最终状态下的显著图。如今很多人将卷积神经网络应用到显著性检测中,Jiang等人提出的DeepVS模型是一种基于深度学习框架针对动态视频场景的显著性检测方法[7-8]。该方法由目标子网和运动子网组成的运动卷积神经网络(OM-CNN)来预测DeepVS的帧内显著性。在OM-CNN中,提出了交叉网络掩码和层次化特征规范化,将目标子网的空间特征和运动子网的时间特征结合起来。

对于视频显著性来说,由于某些场景的复杂性,如背景的高纹理或前景与背景之间的低颜色区分性,仅依靠静态的空间特征不能进行有效的检测,特别是在动态背景中会产生较大的误差;而运动对象的时间运动特征单独使用,也不能够很好地解决视频显著性目标的检测问题。为此,我们提出了将视频输入帧的空间信息特性与动态对象的时间运动特性相结合的视频显著性检测方法:超像素梯度流场与元胞自动机结合的视频图像显著性检测方法,通过梯度流场引入时间运动特性,通过元胞自动机引入空间位置特性;实验结果表明,这种时空特征相结合的方法可以得到更加准确的视频显著图。

1 超像素梯度流场元胞自动机融合的显著图

1.1 视频帧图像超像素分割预处理

给定输入视频序列,首先要获得每个帧的超像素,使用SLIC方法将每帧图像进行超像素分割[9-10],得到的超像素保留了原视频的结构信息,同时也有效地忽略了不想要部分。

(1)

(2)

(3)

(4)

采用大位移运动估计算法[11]来计算光流。设vk为Ik′的光流场,然后计算vk的光流梯度大小:

(5)

Mk(x)=

(6)

将包含图像基本结构信息的超像素赋予初始显著值,在图像边界上的超像素是背景的概率更高,所以先将图像边界上的超像素假设为背景区域,将边界上的超像素赋予接近零的显著值,对于剩下的超像素,将其初始化为统一的显著值。

1.2 梯度流场预估显著图

每帧图像中的对象边缘或轮廓保留为超像素之间的边界,这些边界和空间颜色的不连续性揭示了视频帧的重要内容。在具有复杂的纹理和背景区域中,仅使用颜色不连续性特征并不能充分地区分出显著对象来。在光流场中突然变化的像素通常会引起人们的更多关注,所以合理地添加运动特征将有助于显著区域检测。运动的物体可能是具有非常小的光流或者背景是动态的,仅依靠运动特征就会导致错误的结果。为此给出一种融合空间颜色和光流场两种特征的时空显著性估计方法。

根据前面的分析,将空间颜色特征和运动特征融合到显著性检测当中,这种方法比仅依靠空间或运动特征的方法更加准确。当光流通过当前帧时,光流值将随相应时空梯度场值增加。假设帧Ik的大小为n×m,光流从帧的左右上下四个侧面进入,并在相反方向的侧面结束,其梯度流Fl、Fr、Ft、Fd,可分别定义如下:

(7)

(8)

(9)

从左到右的梯度流Fl的光流值通过时空梯度场时将增加。基于梯度流,构建如下的梯度流场T:

(10)

从(10)中,可以得出在x处的梯度流场T值是在x处的M值再将加上其4个相邻区域的最小光流值。但是,由于仅考虑4个邻域,因此梯度流场T会受到其邻域异常值的影响。T对某些噪声也很敏感,因为梯度流仅考虑同一直线上的所有点,并且梯度流无法通过这些有噪声的点。因此,重新定义在(9)中的梯度流值定义如下:

(11)

这样,梯度流值就考虑了所有周围的(2t+1)梯度流值。当t=0时,可以将(9)视为(11)的特例。通过实验发现,将t的值设置为2较为合适。

(12)

对于输入视频序列,可以观察到相邻帧之间的视觉背景区域是一致的,可以假设一帧中的视觉背景区域在下一帧中也是背景区域。基于此,重写(4)如下:

(13)

(14)

将参数η的值设为给定值,当区域梯度流场值小于该值时,会将该区域视为背景区域。

1.3 元胞自动机预估显著图

在元胞自动机中,每个元胞是由SLIC算法生成超像素来表示的,每个超像素的显著性值在0到1之间连续分布。元胞的邻域类似于图论中z层邻域的概念,元胞的2层邻域不仅包含第一层相邻元胞还包含了与相邻元胞有公共边界的第二层元胞。更新原则不是只基于邻域的信息,还将基于特征空间中邻域与元胞之间的相似性影响也考虑进来。

卷积神经网络最后一层中的特征编码对象包含了图像高级特征,而中间层包含了图像的低级特征,将两种特征结合在一起的方法更加有效。为此本文使用全卷积网络(FCN-32s)来提取图像的编码。由于卷积网中的下采样和池化操作,FCN框架中每个卷积层的输出的结果都不相同,需要裁剪特征图及调整输入图像大小,然后进行简单的线性组合。超像素之间的相似性可计算如下:

(15)

决定元胞下一状态的影响因素不仅是元胞当前的状态,还包含了元胞邻域的状态,两者共同决定元胞的下一状态。任何一对超像素的相似性可以通过特征空间中的测地线距离来测量。对于有n个超像素的显著图,构造影响因子矩阵F∈Rn×n.F中的每个元素fij定义为超像素i对j的影响因子:

(16)

其中超像素i的深度特征表示为ri,g(ri,rj)等同于测量的深度特征上的加权距离。σf是控制相似强度的参数,NB(i)是元胞i的邻域的集合。为了归一化影响因子矩阵,度矩阵D=diag{d1,d2,…,dn}被构造出来,其中di=∑jfij.最后,行标准化影响因子矩阵可以被表示为F*=D-1·F.

如果超像素与特征空间中的所有相邻元胞都不相同,它的下一个状态会更多地受当前状态影响。如果一个元胞与它的邻域相似,它应该被当前状态所吸收。为此,建立一个联通矩阵C=diag{c1,c2,…,cn}来促进所有元胞之间的更新。每个元胞的联通性被定义为:ci=1/max(fij).

因此它与其邻域的最大相似度成反比。由于ci表示当前状态的联通性,将其标准化为ci∈[b,a+b],其中[b,a+b]⊆[0,1]:

(17)

在元胞自动机模型中,所有元胞将根据更新规则同步更新其状态,基于影响因子矩阵F*∈Rn×n和联通矩阵C*∈Rn×n定义的同步更新规则如下:

s(t+1)=C*s(t)+(I-C*)F*s(t)

(18)

1.4 最终显著图

通过光流场可以得到视频中显著对象的运动信息,利用元胞自动机的自动更新原则可以得到每帧上粗略的显著图。为了得到更加准确显著图,将视频中的动态运动信息和静态空间信息都考虑进去,将两种信息进行融合以此得到最终视频上的显著图,如下所示:

(19)

最后,通过设置固定阈值将显著图像进行二值化处理。

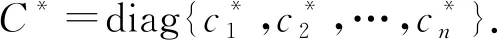

2 算法流程

超像素梯度流场与元胞自动机融合的视频图像显著性检测方法步骤如表1:

表1 超像素梯度流与元胞机融合的视频显著图检测

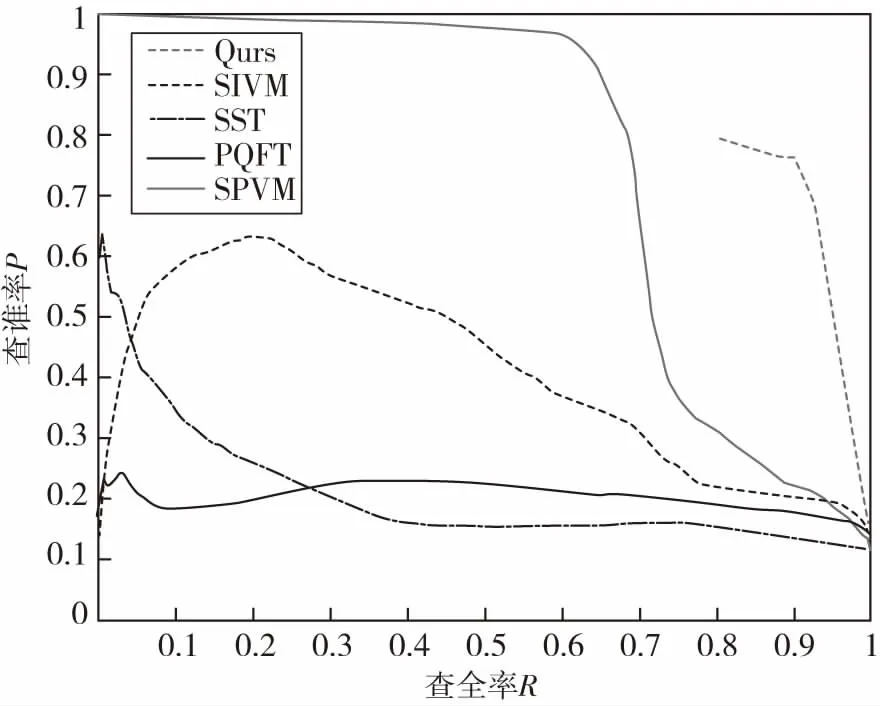

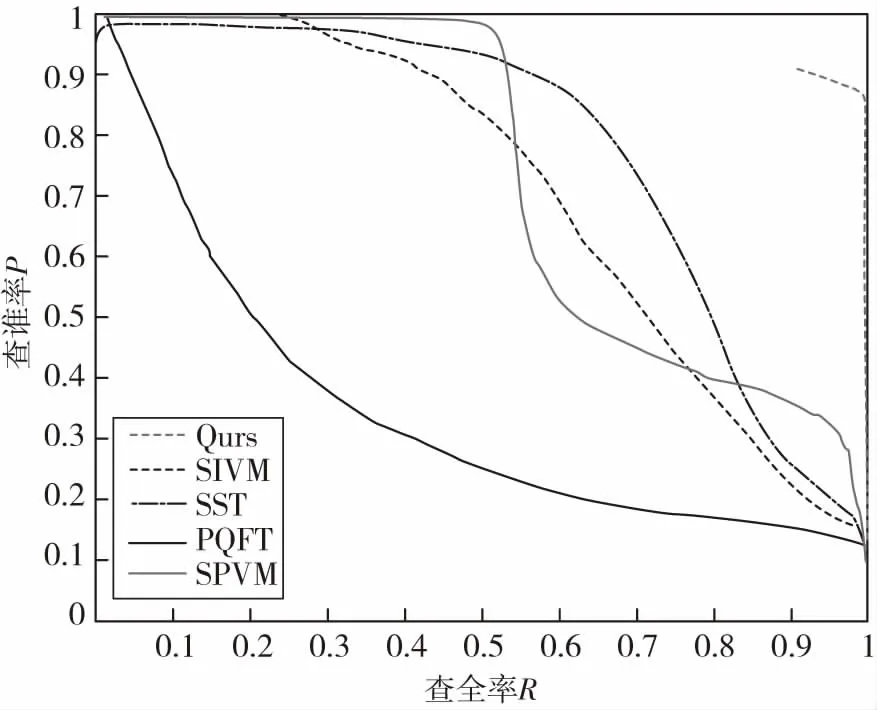

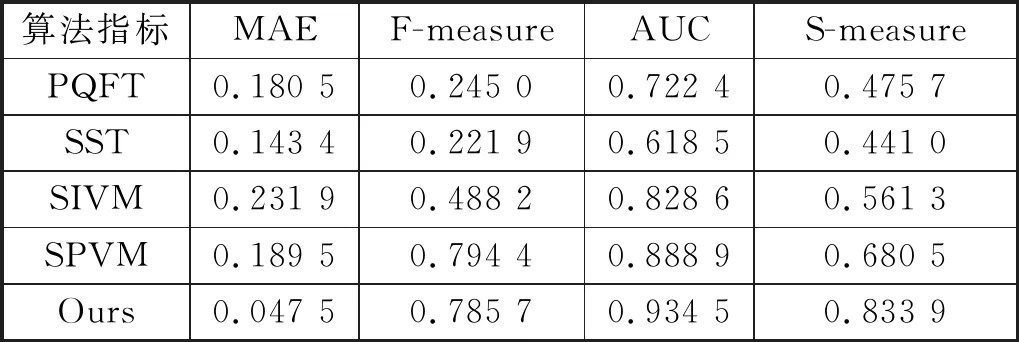

3 实验结果及分析

为了说明本文方法的有效性,在ViSal数据集[12]上进行测试。将本文所提方法与现有的4种方法PQFT[13]、SST[14]、SIVM[15]、SPVM[16]进行对比实验,使用PR曲线、AUC、MAE、F-measure和S-measure值5种评估指标进行性能评估[17],实验运行软件环境为MATLAB,运行系统为Windows 7,处理器为Inter Core i5 3.10Ghz CPU,运行内存为4 GB.

图1到图6是ViSal数据集上在bird视频上进行检测的效果图,并将检测的部分原视频帧和PQFT方法、SST方法、SIVM方法、SPVM方法和我们所提方法进行检测的效果图进行了对比,图7是bird视频帧上的金标准显著图。

图1 ViSal数据集bird视频原图

图2 PQFT在ViSal数据集bird视频结果

图3 SST在ViSal数据集bird视频结果

图4 SIVM在ViSal数据集bird视频结果

图5 SPVM在ViSal数据集bird视频结果

图6 Ours在ViSal数据集bird视频结果

图7 ViSal数据集bird视频真实显著值GT

图8 ViSal数据集panda视频原图

图9 PQFT在ViSal数据集panda视频结果

图10 SST在ViSal数据集panda视频结果

图11 SIVM在ViSal数据集panda视频结果

图12 SPVM在ViSal数据集panda视频结果

图8到图13是ViSal数据集上在panda视频上进行检测的效果图,并将检测的部分原视频帧和PQFT方法、SST方法、SIVM方法、SPVM方法和本文所提方法进行检测的效果图进行了对比,图14是panda视频帧上的金标准显著图。

图13 Ours在ViSal数据集panda视频结果

图14 ViSal数据集panda视频真实显著值GT

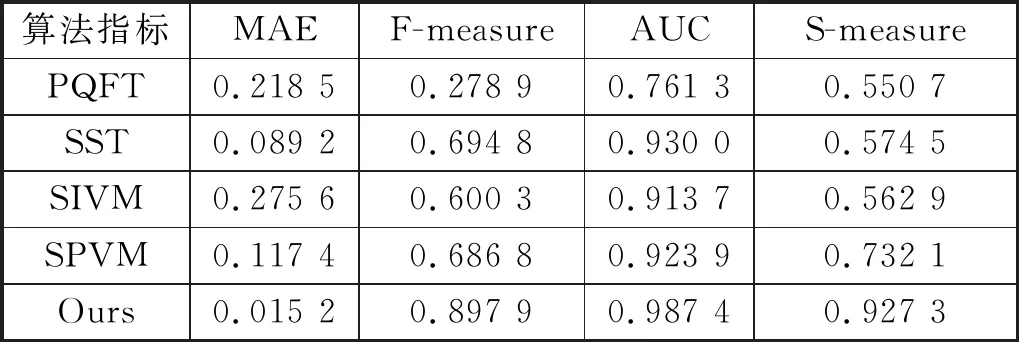

通过上述检测效果图,可以看到本文方法可以有效地抑制复杂的背景区域,突出显著目标。为了进一步说明本文算法的性能,用5种评估指标和现有的4种算法进行对比实验。图15和图16是Visal数据集上bird视频和panda视频上进行检测的PR曲线效果图,表2和表3是ViSal数据集上bird视频和panda视频上进行检测的MAE、F-measure、AUC、S-measure四种评估指标得出来的评估数据。从这些曲线图和数据表中可以清晰地发现本文方法在视频显著性检测的多个性能指标上都有良好的表现。

图15 ViSal数据集bird视频PR图

图16 ViSal数据集panda视频PR图

表2 ViSal数据集bird视频测试结果

表3 ViSal数据集panda视频测试结果

4 结论

本文提出的超像素梯度流场与元胞自动机融合的视频图像显著性检测方法检测效果更佳。该方法使用颜色梯度和光流梯度构建了时空梯度场,根据时空梯度场得出了梯度流值。通过卷积神经网络获得了超像素的深度特征信息,将超像素的深度特征应用到了元胞自动机中,根据自定义规则从而自动迭代更新出显著图。将融合了时空信息的粗略显著图和元胞自动机的粗略显著图进行融合得到了最终的显著图。通过实验对比结果,表明本文方法具有更高的准确性,能够抑制复杂的背景,从而突出显著对象。但是本文只是做了对单目标对象的研究,在多目标上还需要进一步研究。