多重注意力特征融合网络对中文评价情感分析

2021-08-24张索宇吕心怡

王 勇,张索宇,吕心怡

1(重庆理工大学 人工智能学院,重庆 401135)

2(重庆理工大学 计算机科学与工程学院,重庆 400054)

1 引 言

现今,大量带有情感色彩的评价文本在各种网站上呈指数级地增长,如何从这海量数据中获取有价值的信息显得越来越有必要.情感分析(Sentiment Analysis)任务作为自然语言处理中一项基础工作,非常适用于此类场景,值得研究者们进一步探究.情感分析又称情感分类,以挖掘或检测出文本的主观意见和情感倾向为目标.

情感分析的方法主要分为3种即传统方法、机器学习方法和深度学习方法.众多研究发现通过深度学习的方法对文本情感分析具有更长远的应用前景.传统文本情感分析需要用到人工构建的情感词典.ShePherd等人首次使用文本数据来构建语义词典.

基于机器学习的文本情感分析通过建模提取特征的方法自动判别情感极性.Pang等[1]在英文电影评价数据上运用机器学习模型来处理二分类的文本情感分析任务.情感分析的基础任务即是利用语言模型合理地表示文本,作为模型的输入.较早提出的传统语言模型有词袋模型[2]、向量空间模型,此类语言模型忽略了上下文语义关系.分布式的词向量表示方法(Distributed Representation)通过构造词向量空间,将所有词映射成短向量后以空间距离来衡量相似性.分布式表示方法的运用,相较传统语言模型在抽象词语特征时更为科学合理.Mikolov等[3]以分布示表示方法为理论基础提出了连续词袋(Continuous Bag-of-Words,CBOW)和跳字(Skip-gram)语言模型.

近年来,深度学习方法的运用极大地推动了对于自然语言处理(Natural Language Processing,NLP)任务研究的发展.其中的经典模型卷积神经网络(Convolution Neural Network,CNN)具备很好的学习非线性、高维和复杂映射关系的能力,充分利用了多层感知器的结构.Kalchbrenner等[4]在自然语言处理中使用了CNN神经网络,提出了一种动态卷积的方法以解决对不同长度文本的处理问题.Kim[5]提出的英文文本分类模型首先对文本进行预处理后进行词嵌入,通过卷积神经网络实现分类任务.循环神经网络[6](Recurrent Neural Network,RNN)因具有适用于对序列特征进行抽象学习的特点而被普遍应用于语音识别、机器翻译和情感分析等自然处理任务中.RNN的改进优化模型为长短时记忆网络[7](Long Short Term Memory,LSTM).其中的“门”结构使LSTM可以对信息进行添加和删除,同时对每一层的隐藏状态更新,这一特殊机制使其在长距离信息学习方面具有独特的优势.由于理解文本需要上下文特征信息,研究者在LSTM的理论基础上提出能获取上下文特征信息的双向长短时记忆网络[8](Bidirectional Long Short Term Memory,BiLSTM).LSTM网络模型参数较多且结构复杂,对其结构简化后的门限循环单元[9](Gated Recurrent Unit,GRU)不仅提高了模型训练效率且有良好的实验效果.关于CNN和RNN融合模型的研究,Pinheiro等[10]在多个深度学习任务中运用循环卷积神经网络.近年来融合RNN和CNN的方法[11]较多地应用于NLP任务中.

随着对深度学习的不断研究,其中兴起的研究点便是将注意力机制(Attention)应用于自然语言处理中.Google mind团队[12]将Attention机制和RNN网络模型相结合,对图像进行分类.Bahdanau等[13]在机器翻译任务中加入Attention后提升了翻译效果.随后,自然语言处理子任务如文本分类[14]、文本摘要[15]等也越来越多地引入了注意力机制.而自注意力机制[16]首先被应用于Google最新的机器翻译模型中.

2 相关工作

2.1 词向量

本文采用Glove[17]词向量模型来训练生成文本词向量,而Glove是在Word2vec[18]词向量模型上进行了改进.Word2vec包括连续词袋(CBOW)模型和跳字(Skip-gram)模型.CBOW模型构建原理为上下文词语预测中心词语,而Skip-gram模型构建原理为中心词语预测上下文词语.两种理论模型均为由输入层、映射层、输出层组成的多层神经网络.对于Skip-gram模型,V(W(x))作为中心词语W(x)的向量表示也即模型的输入.同时设窗口大小为4,则上下文词语W(x-2)、W(x-1)、W(x+1)、W(x+2)的向量表示分别为V(W(x-2))、V(W(x-1))、V(W(x+1))、V(W(x+2)).Skip-gram模型的理论依据是通过对中心词语W(x)的条件概率值的计算来得出上下文词向量,其理论见公式(1):

P(V(Wi)|V(W(x)))

i∈{x-2,x-1,x+1,x+2}

(1)

(2)

2.2 门限循环单元(GRU)

GRU是由传统循环神经网络(RNN)的理论思想改进优化出的一种网络结构.其能通过简化的门结构学习文本的序列化特征,减少了训练参数且有效提高了训练效率.

RNN对序列信息处理比较有效但易出现梯度消失和梯度爆炸的问题.而LSTM由于具有细胞状态这一概念,使其能够通过不同的门结构对细胞状态中的信息进行相应的操作.即是由门结构这一特殊机制来选择性地对序列特征进行抽象学习.然而LSTM网络结构较为复杂,时间成本较高.GRU对LSTM的结构作出了优化,门结构的数量减少的同时结合了隐藏和细胞状态.GRU的具体计算过程如公式(3)所示:

(3)

2.3 高速公路网络

高速公路网络[19](Highway Network)作为一种前馈网络(Feedforward Network),对深层神经网络模型训练的收敛起到了优化的作用.

多层神经网络进行训练时,通过反向传播算法[20](Back Propagation,BP)与梯度下降的方法来更新模型权值,以不断优化模型的训练效果.而深层神经网络由于模型结构较深在训练时易产生梯度消失,导致不能得到正确的训练模型效果.研究者以此为研究方向提出了高速公路网络,其原理类似于残差网络(Residual Network)同时又借鉴了GRU的门控机制.其允许一部分输入数据直接通过不做任何转换而另一部分需要进行非线性变换.这两部分的比例由输入数据和权值矩阵计算得到.如公式(4)所示:

(4)

可以看出,Highway网络的输出由两部分组成.t表示传送门,c表示携带门,c为1-t.σ为激活函数,Wt和Wh均为权重的矩阵,bt和bh则为偏置项.

3 相关模型理论

3.1 文本特征融合

由于中文评价的文本序列长度不固定,且单一神经网络提取的特征较为单一,对文本情感语义的表征不全面.因此本文考虑通过特征融合的方法,在解决长距离依赖问题的同时获取更广泛的情感语义信息.

本文通过多尺度宽卷积结构(MWC)充分提取文本局部特征,同时构建自注意力(Self-Attention)词向量矩阵模型获取词语间的关联特征.将两类不同类型的特征融合后输入双向门限循环单元(BiGRU)学习文本序列化特征.

启发于Kim的textCNN模型适用于对局部特征进行抽象的特点,本文采用了多尺度的卷积核.同时采取宽卷积的策略,来充分获取文本局部特征.输入的句子可表示为S={x1,x2,…,xn},卷积操作见公式(5),卷积核大小为l·k.

Ci=Conv(W·xi:i+l-1+b)

(5)

W表示卷积核.l表示卷积核尺寸,将其设定为不同的大小,以提取多种尺度的特征向量.xi:i+l-1为i到i+l-1个词向量构成的句子,b为偏置项,通过卷积后提取的特征矩阵见公式(6):

C=[C1,C2,…,Cn-l+1]

(6)

考虑到某些局部重要情感语义特征对文本情感分析准确率的影响,应尽可能全面地对文本特征进行提取.因此本文采用了宽卷积(Wide convolution)策略.图1展示了本文所构建的MWC模型结构,通过补零法对词向量矩阵进行填充.使用多个不同尺度的卷积核(Convolution filters),宽卷积则从填充后的向量矩阵的有效行开始.

图1 多尺度宽卷积网络模型

情感文本属于序列信息,其语义情感特征与上下文语境相关,因此本文采用双向门限循环单元(BiGRU),通过前向传播层和后向传播层来提取前文和后文信息以获得文本上下文的序列化特征.

CNN抽象出文本局部特征,自注意力词向量矩阵模型输出关联特征.将两种不同类型的文本特征进行融合后输入BiGRU进行序列化特征学习,从而全面充分地提取情感语义信息.

3.2 多重注意力特征融合模型(MTA-CBG)

本文在特征融合方法获取广泛文本特征的同时,通过多重注意力分别构建词语级和句子级的关联特征,提取中文评价文本的深层情感语义特征信息.

中文评价情感分析通常将传统词向量作为输入,并未考虑词语在不同语境中具有不同含义的问题.本文提出的自注意力词向量矩阵是通过自注意力机制(Self-Attention)对语义词向量赋予不同的权重,突出关键信息.

注意力机制主要是表征了查询(Query)同键值对(Key-Value)的对应关系.自注意力机制是一种特殊的注意力而其基础结构即为缩放点乘注意力(Scaled Dot-Product Attention).如公式(7)所示,计算缩放点乘注意力时首先对Query和Key点乘,再除以一个维度为k的开方数以调控点积在一个合理的范围.然后进行归一化操作,并屏蔽部分干扰项,最后再乘Value.

(7)

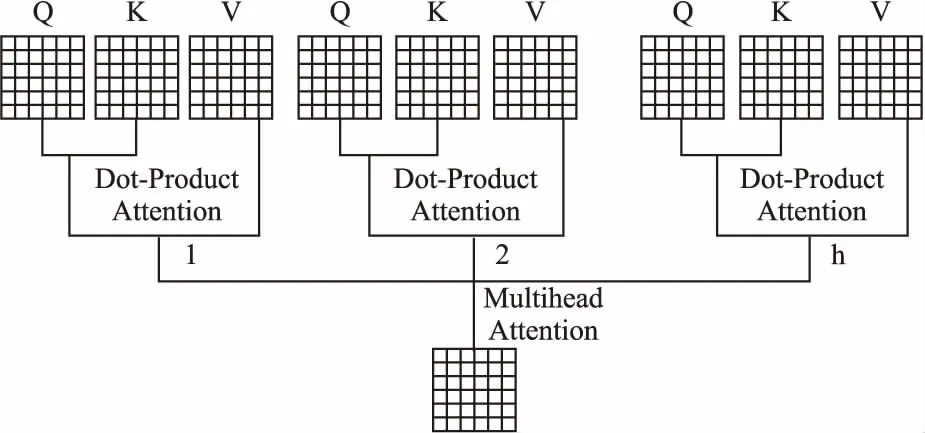

多头注意力(Multihead-Attention)为自注意力机制的关键算法,其求解过程为:

1)将query、key、value做线性变化

Att=f(q,k,v)

(8)

2)做h次点乘注意力,将输出合并

multiH=concat(Att1,Att2,…,Atth)

(9)

3)对输出做线性变化

Output=f(multiH)

(10)

多头注意力算法的特点在于每个词之间都要计算相关度,通过这一机制即对词语进行了关联.并且其中的mask操作屏蔽掉了部分不应读取的信息,在一定程度上排除了干扰项.因此本文采用自注意力机制对训练的文本词向量赋予不同的权重,保证对重要词语关联特征提取的准确性.

本文所构建的自注意力词向量矩阵模型如图2所示.由于自注意力机制中每个词语间都要做相关度计算的特点,因此其query、key、value相同且均为进行词嵌入后的词向量矩阵.模型内部结构中,首先构建文本的序列(query)、键(key)、值(value)3个向量矩阵,然后做h次缩放点乘注意力.将缩放点乘注意力合并,构成多头注意力后得到自注意力词向量矩阵.

图2 自注意力词向量矩阵

本文构建了多重注意力的方法,将特征融合模型提取的向量Vt作为高速注意力网络(Attention-Highway)的输入.通过注意力机制对重要情感语义特征进行筛选并优化深层神经网络训练的收敛效果.

如图3所示,将BiGRU学习的文本序列化特征输入注意力层,输出句子级的关联特征.然后由权值矩阵和偏置项决定一部分特征直接通过高速公路网络,另一部分则做非线性变化.最后将两部分特征融合作为经过注意力机制筛选后的深层文本情感语义特征.

图3 高速注意力网络

注意力机制如公式(11)所示:

(11)

首先通过tanh函数得到文本特征Vi的隐层表示hi.然后采用softmax函数生成注意力权值αi.最后将αi赋予文本特征Vi,通过构建句子级关联特征筛选重要情感语义信息.其中WA为权重矩阵而bA为偏置项.

本文所构建的MTA-CBG网络模型结构如图4所示.

图4 多重注意力特征融合网络模型结构

多重注意力特征融合网络模型结构流程如下:

1)文本词向量矩阵作为多重注意力特征融合网络模型MTA-CBG的输入.

2)构建Self-Attention词向量矩阵,提取词语间的关联特征.

3)构建多尺度宽卷积网络(MWC)提取文本局部特征并与词语关联特征融合.

4)将融合特征输入双向门限循环单元(BiGRU)学习文本序列化特征.

5)将序列化信息输入改进的高速注意力层(Attention-Highway)抽象出深层情感语义特征.

4 实 验

4.1 实验环境及数据集

本文实验环境如表1所示.

本实验数据集有两部分,第1部分为酒店评论数据集,其为谭松波老师收集整理的非平衡语料,正面负面评价分别有7000条和3000条.首先对该语料进行预处理,通过jieba分词和去除常用中文停用词进行清洗后,从中选取正面评价3000条和负面评价构成平衡数据集.然后以9:1的比例将该平衡数据集随机划分为训练集和验证集.第2部分为在京东电商平台爬取的购物评价语料.对该语料进行预处理后,得到平衡的网购评价数据集.其中训练集共18000条,测试集1990条.以上数据集情感标签均分为正负两类,其中正面情感标签标注为1,负面情感标签标注为0.表2展示了两部分数据集正负面评价示例和预处理后的情况.

表2 数据集示例

4.2 实验参数及评价指标

为验证和测试在中文评价文本情感分析方法及模型的效果,需要对所提方法的有效性进行验证.在情感分析中通常将准确率(Accuracy)和F1值(F1-score)这两个综合评价指标作为参考.同时也包括精准度(Precison)和召回率(Recall),F1值可由精准度和召回率通过公式(12)计算得到:

(12)

文本情感分析的有效性与实验参数的设置密切相关,具体的参数设置如表3所示.

表3 实验参数

其中Embedding_size表示设定的词向量维度,本文通过Glove语言模型训练得到100维的文本词向量.Filter_sizes和Num_filters为CNN参数中的卷积核大小和卷积核数量.将卷积核大小分别设为3、4、5且每种卷积核数量设为200.Hidden_unit为BiGRU隐藏层神经元数.其他为训练参数,共训练20个epochs,学习率设为0.001.采用Dropout方法和L2正则化防止过拟合.

4.3 对比实验及结果分析

本文设置了多组对比实验来验证所构建的中文评价文本情感分析模型的有效性.比较单一神经网络模型、特征融合网络模型、注意力机制对情感分析效果的影响.

1)CNN:采用文献[5]中的CNN模型;

2)SA-CNN:参考文献[16]中的Self-Attention机制即将赋予自注意力权重的词向量输入CNN;

3)BiGRU:参考文献[9]GRU结构,采用BiGRU模型;

4)BiGRU+C:BiGRU和CNN并行的融合网络模型;

5)C-BiGRU-A:CNN、BiGRU链式结构单层注意力模型;

6)MTA-CBG:本文所提的多重注意力的特征融合神经网络模型.

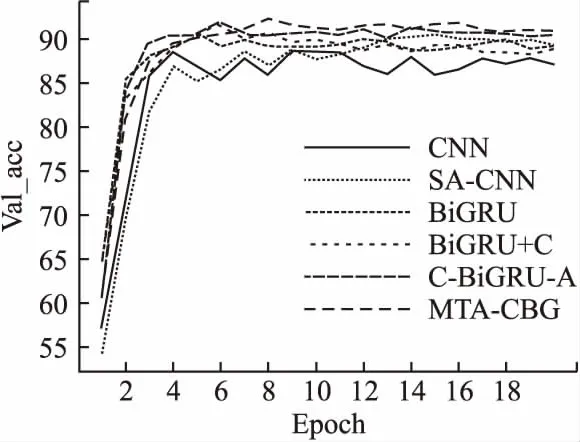

本文将所构建的多重注意力特征融合神经网络模型MTA-CBG分别与单一CNN网络、加入自注意力的SA-CNN网络、单一BiGRU网络、CNN和BiGRU融合网络模型、CNN和BiGRU链式结构的单层注意力模型进行对比实验.第一部分实验以酒店评价为训练验证数据集,通过对验证集准确率(Val_acc)进行比较分析,调整超参数,寻找最优解.图5显示了6组对比实验的验证集准确率变化情况.

图5 验证集准确率曲线

由图5可以看出,单一CNN和单一BiGRU虽然能快速求得较优解但准确率偏底,CNN模型曲线趋势不够平稳.加入自注意力后,SA-CNN模型验证集准确率提高,且曲线趋势有了一定的改善.融合模型BiGRU+C能求得更优解,有较高的验证集准确率,但训练效果不够稳定.与单层注意力模型C-BiGRU-A相较,本文所提的MTA-CBG模型求得了最优解,准确率更高.且当模型训练收敛后验证集准确率能保持在较高的水平,可见本文所提方法实验效果更好.

本文第2部分实验以网购评价为训练测试数据集,从而进一步验证所提方法对中文评价文本情感分析的效果.图6给出了6组对比实验在网购评价数据集上正确分类出的正面和负面评价条数.为了直观地表示各组模型在正确分类数上的差别,取纵轴坐标原点为800.

图6 正确分类条数

从图6可以看出,正确分类出的正面评价数高于正确分类出的负面评价数.分析这是由于中文评价文本的特点造成的.对于正面评价,表现出的正面情感一般是较为明显和积极的.而对于负面评价,其所表达出的负面情感通常比较内敛和隐晦.因此对于中文评价情感分析,就需要对文本中所蕴涵的深层情感语义信息进行提取,以提高情感分析模型的效果.相较CNN,通过自注意力机制获取了更多词语间关联信息的SA-CNN模型评价正确数有一定提高.单一神经网络模型CNN和BiGRU正确分类数较少的原因是在于提取的文本特征较为单一.CNN善于对局部特征的提取而BiGRU适用于学习文本序列化特征.相较单一神经网络,特征融合模型BiGRU+C和单层注意力模型C-BiGRU-A正确分类数进一步提高,得益于提取的特征较为全面充分.而本文所构建的MTA-CBG模型在正面评价和负面评价上均有最高的正确数,且数量较为均衡.可见本文针对中文评价文本的特点所提出的多重注意力特征融合方法,能有效地对深层情感语义特征进行提取,提高情感分析的准确性.

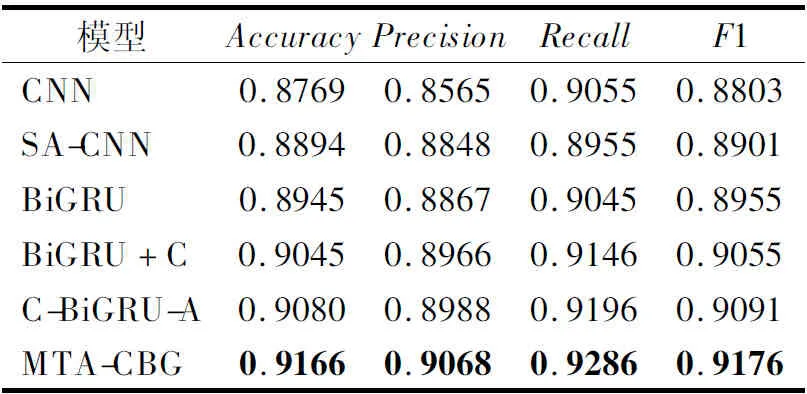

表4展示了6组对比实验在网购评价数据集上的测试结果.实验模型的主要评价指标为准确率Accuracy以及F1值.根据实验结果,MTA-CBG模型在测试集上的准确率达到了91.66%,F1值为91.76%,均高于其他模型.证明本文所提方法是非常有效的,构建的多重注意力特征融合网络模型在中文评价文本情感分析上取得了更好的效果.对比CNN,SA-CNN在引入自注意力机制后准确率和F1值均得到了提高.通过Self-Attention获取词语间关联信息后,输入CNN提取局部关键特征,情感分析效果得到了提升.相较单一神经网络模型,特征融合网络BiGRU+C和单层注意力网络C-BiGRU-A实验评价指标更高.这是由于中文评价文本长度跨度区间较大,单一神经网络模型不能有效地提取全部文本特征.以上两种模型结合了两种不同网络的特点,所提取的特征能较好地表征文本所蕴含的信息,但容易忽略深层情感语义特征.针对以上一系列问题,本文构建了MTA-CBG模型.在两组中文评价数据集上的实验证明了本文所提多重注意特征融合方法的有效性.

表4 对比实验测试结果

5 结 语

本文提出通过多重注意力的特征融合方法构建了MTA-CBG神经网络模型,用于对中文评价文本情感分析.该模型通过自注意力机制Self-Attention对Glove词向量赋予不同权重,构建自注意力词向量矩阵,获取词语级关联特征.采用多尺度宽卷积结构MWC提取文本局部特征,将两类特征融合后输入双向门限循环单元BiGRU学习文本序列化特征.由于自注意力机制中的多头注意力与多尺度宽卷积结构能很好的并行化,因此在构建词语级的关联特征的同时,通过多重注意力构建文本句子级关联特征.最后输入改进的高速注意力层Attention-Highway提取深层情感语义信息.通过实验比较分析证明本文所提方法提高了中文评价文本情感分析的准确率Accuracy和F1值.但仍存在不足,本文模型作为输入的文本词向量是基于传统分布式语言模型所训练出来的语义词向量,之后将对如何在词向量中添加情感信息作进一步研究.