基于自编码器的多视图属性网络表示学习模型

2021-04-20王慧敏

樊 玮,王慧敏,邢 艳

(中国民航大学计算机科学与技术学院,天津 300300)

0 引言

随着互联网的进步与发展,信息网络成为生活中最为常见的一种信息载体,对信息网络的研究与分析具有极高的学术价值和潜在应用价值。网络中最基本的元素为节点和边,边可以连接任意两个节点,能够体现两个节点之间的关系。在有关网络的研究中,一个重要的问题就是如何合适地表示网络信息。

网络表示学习从原始网络中去除噪声和冗余信息,自动识别出网络中有价值的信息进行保存,并将这些信息编码到低维、稠密、连续的向量空间中,以获得节点表示向量。网络表示学习广泛应用于网络应用任务中,如节点分类[1]、节点聚类[2]、链接预测[3]、可视化[4]等。

早期的网络表示学习方法通过构造特征矩阵得到网络表示向量,但这些方法通常时间复杂度较高,随着数据规模的增大,性能会变得很差。随着深度学习方法的发展,涌现出大量基于神经网络的表示学习方法,但这些方法没有充分利用节点属性信息或挖掘节点之间的隐藏属性网络结构,导致网络信息利用并不充分。

为了更好地利用节点属性信息,本文提出了一种基于自编码器的多视图属性网络表示学习模型(Auto-Encoder based Multi-View Attributed Network Representation learning model,AE-MVANR),具体框架如图1 所示。该模型利用网络结构信息和节点属性信息构造两个视图:将网络的拓扑结构信息作为拓扑结构视图(Topological Structure View,TSV);通过计算节点间相同属性共现频率,构造属性结构视图(Attributed Structure View,ASV)。将TSV 和ASV 有效融合,深度挖掘不同节点间的内在联系。在TSV 和ASV 上,分别利用随机游走算法得到若干节点序列,再将序列输入到基于长短期记忆(Long Short-Term Memory,LSTM)网络的自编码器中训练,最终得到融合了结构信息和属性信息的节点表示向量。

为了更好地验证本文所提算法AE-MVANR 的性能,在几个真实数据集上分别进行了分类和聚类任务。实验结果表明,AE-MVANR 性能优于网络表示学习中常用的仅基于网络结构与基于网络结构和节点属性信息的网络表示学习方法。

1 相关工作

传统的网络表示学习方法是指基于谱方法的网络表示学习方法。该类方法利用数据的谱特征构建关系矩阵,通过计算关系矩阵的前k个特征向量来得到k维的节点表示向量。谱特征一般为特征值或特征向量,关系矩阵的构建至关重要,由特定的方法设计,一般为邻接矩阵、节点相似度矩阵、拉普拉斯矩阵等。例如,局部线性嵌入(Locally Linear Embedding,LLE)[5]假设节点从同一个流行空间中采样得到,且每个节点可由其近邻点的线性加权组合构造得到。LLE 使用邻接矩阵作为关系矩阵,保持了高维数据原有的拓扑结构。拉普拉斯特征映射(Laplacian Eigenmaps,LE)[6]假设高维空间中的两个相似节点,在低维表示向量空间中距离也应该相近。LE 同样使用邻接矩阵作为关系矩阵,反映了数据内在的流形结构,解决了LLE对噪声敏感的问题。然而,基于谱方法的网络表示学习方法求解过程复杂,并且需要将关系矩阵整体存于内存中,时间和空间复杂度较高,因此难以应用于大规模网络中。

随着深度学习的发展,无监督表示学习方法在自然语言处理领域得到广泛的学习与应用。Word2Vec[7-8]将单词转化为词向量,不仅挖掘了单词之间的语义关联,使得语义上相似的词语的词向量也具有较高的相似度,而且在一定程度上也挖掘了单词之间的抽象关系。受Word2Vec启发,DeepWalk[9]利用随机游走策略在网络中获得一系列节点序列,然后将每个节点序列视为一个句子输入到Skip-Gram模型中,通过最大化预测节点上下文的概率学习该节点的低维向量表示。相较于基于谱方法的网络表示学习方法,DeepWalk 算法不再使用关系矩阵,使得时间复杂度大幅降低,能够适用于大规模网络的表示学习。基于DeepWalk,大规模信息网络嵌入(Largescale Information Network Embedding,LINE)[10]进一步挖掘了网络中节点之间的关系。LINE 将节点之间的直接连接关系定义为一阶相似性,将存在共同邻居却不直接相连的节点关系定义为二阶相似性。通过引入二阶相似性,LINE 极大缓解了网络中的数据稀疏问题,最大限度地保留了局部网络结构和全局网络结构。不同于DeepWalk 中类似深度优先的随机游走策略,node2vec[11]结合深度优先和广度优先方法,使抽样的路径能更大程度上同时保存网络的局部特征和全局特征。

不同于以上基于浅层神经网络的网络表示学习算法,GraRep[12]构造并分解了K个状态转移概率矩阵,将全局网络结构信息融入到网络表示学习的过程中。结构深层网络嵌入(Structural Deep Network Embedding,SDNE)[13]利用深度神经网络捕捉节点之间的高度非线性关系,并将自编码器的中间层作为节点的向量表示,获得的节点表示向量因此包含了网络局部和全局结构特征。

然而,上述方法都只利用了网络的拓扑结构信息,忽略了网络中节点的属性信息。基于矩阵分解的网络表示方法可以将网络结构信息和其他信息有效地融合在一起。结合文本信息的DeepWalk(Text-Associated DeepWalk,TADW)[14]基于矩阵分解框架将节点的文本特征引入了网络表示学习;加速属性网络嵌入(Accelerated Attributed Network Embedding,AANE)[15]同样基于矩阵分解框架,通过属性相似度矩阵和邻接矩阵将属性信息和网络结构信息融合到网络表示学习过程中;二值化属性网络嵌入(Binarized Attributed Network Embedding,BANE)[16]利用Weisfeiler-Lehman 核方法编码网络结构和节点属性信息,生成相似度矩阵,通过分解该矩阵,得到二进制的节点表示向量。

随着网络规模的增大,基于矩阵分解的网络表示学习方法的时间复杂度也急剧上升,因此难以应用于大规模网络中。神经网络具有融合不同信息的特性,因此许多学者转而研究基于神经网络的网络表示学习。最大边缘DeepWalk(Max-Margin DeepWalk,MMDW)[17]在DeepWalk的基础上将标签信息融入到网络表示学习过程中;深度属性网络嵌入(Deep Attributed Network Embedding,DANE)[18]利用图卷积神经网络(Graph Convolutional Network,GCN)学习属性网络中的节点表示向量;自翻译网络嵌入(Self-Translation Network Embedding,STNE)[19]利用基于双向LSTM 的自翻译机制实现了网络结构和内容信息的无缝融合;属性社交网络嵌入(Attributed Social Network Embedding,ASNE)[20]将社交网络中丰富的节点属性信息融入到网络表示学习过程中;多视图网络嵌入(Multi-View network Embedding,MVE)[21]使用自注意力机制为网络中不同视图下的多个节点表示向量投票,最终得到结果最优的节点表示向量;不同于MVE 的投票方式,基于生成对抗网络的多视图网络嵌入(Generative Adversarial Network for Multi-view network Embedding,MEGAN)[22]使用生成器将不同视图下的节点表示向量进行融合。

然而,以上大多数方法都只是简单将节点的属性信息作为特征矩阵,没有根据属性信息进一步挖掘节点之间的隐含联系。TADW[14]在矩阵分解框架下,将节点的文本信息转化为文本特征向量矩阵;上下文感知的网络嵌入(Context-Aware Network Embedding,CANE)[23]利用卷积神经网络对一条边上两个节点的文本信息进行编码;Net2Net[24]基于自翻译机制,使用LSTM 融合节点的结构特征和文本特征。但是以上方法挖掘的属性信息均为文本信息,而非离散化的二值数值。为充分挖掘离散数值属性信息,本文提出了一种基于自编码器的多视图属性网络表示学习模型(AE-MVANR)。

2 AE-MVANR模型

2.1 相关定义

定义1属性网络。给定一个属性网络G=(V,E,X),其中V={v1,v2,…,vn}表示网络中节点的集合,n=|V|表示网络中节点的数量;E={eij}表示网络中边的集合,m=|E|表示网络中边的数量;X∈Rn×t表示所有节点的属性矩阵,Xi表示节点i的属性向量,维度为t。

定义2属性网络的表示学习。给定属性网络G,属性网络表示的目的是学习一个映射函数f:i→yi∈Rd且i∈V。其中,d是向量维度且d≪|V|,向量yi和yj的关系能够反映出G中节点i和j的关系。

定义3拓扑结构视图(TSV)[25]。该视图由属性网络G生成,能够反映网络中节点间原有的边关系。TSV=(V,A),其中,A表示邻接矩阵,Aij取值为1 或0。若Aij=1 则表示节点i和节点j之间存在连接关系,否则表示两节点之间不直接相连。

定义4属性结构视图(ASV)[25]。该视图挖掘节点间属性信息,通过节点相似性矩阵S构造而成。ASV=(V,S),其中,S是节点的相似性矩阵,为对称矩阵。0 ≤Sij≤1 表示节点vi和vj之间的相似性程度,值越大说明节点间的相似性越高。

2.2 AE-MVANR整体框架

AE-MVANR 深度挖掘不同节点间属性的内在联系,通过属性特征探索节点之间隐含的结构关系,其整体框架如图1所示。属性网络G有4 个节点和3 条边,每个节点有6 个属性。AE-MVANR 首先根据网络中节点间固有的连边关系,得到TSV,根据节点的属性信息挖掘隐含结构信息构造属性结构视图ASV;然后,分别在两个视图上执行随机游走算法,得到基于TSV和属性结构视图的节点序列;最后,将序列输入到基于LSTM 的自编码器中,通过训练不断迭代,得到融合了结构和属性特征的节点表示向量。

图1 AE-MVANR框架Fig.1 Framework of AE-MVANR

2.3 属性结构视图的构造

邻接矩阵A体现了网络中节点固有的拓扑结构。然而,网络中不直接相连的节点也会存在一定的相似关系。例如图1 中,节点1 和节点2 之间没有连边,节点2 和节点3 有连边。分析它们的属性特征可以发现,节点2和节点3拥有一个共同属性(属性d),同样地,节点1 和节点2 也拥有一个共同属性(属性d),据此可推断出节点1 和节点2 具有较高的相似性。

为了更加全面真实地刻画网络中节点之间的关系,AEMVANR 利用节点间相同属性的共现频率作为衡量节点相似性的指标,对网络中隐藏的属性结构信息进行深度挖掘。如式(1)~(2)所示,两个节点间属性的共现频率越高,表明两个节点越相似。根据节点间的属性共现频率可进一步构造生成节点相似性矩阵S,具体构造方法如算法1所示。

其中:第1)~5)行计算了节点属性共现矩阵F,此时Fij≥0;第6)行将F进行归一化,此时0≤Fij≤1;第7)~10)行对每个节点筛选了与其共现频率最高的前c个节点,本文默认c取网络平均度avgk的上整;第11)行返回节点相似性矩阵S。

AE-MVANR 通过节点间的属性共现频率计算生成节点相似性矩阵S,并根据该矩阵构造生成ASV,参数c的取值意味着每个节点最多可添加c条边,此举不仅挖掘了隐藏属性网络的结构信息而且极大简化了ASV。如图1 所示,ASV 中有4个节点和4条边。

2.4 随机游走算法

节点相似性矩阵S体现了节点之间的隐含属性结构关系,是对邻接矩阵A的重要补充。为了充分利用网络中原拓扑结构信息和隐含的属性结构信息,AE-MVANR 在TSV 和ASV上分别采用随机游走算法[11]进一步提取网络中节点之间的关系。具体策略如式(5)~(7)所示。

式(5)表示在给定当前节点i,访问下一个节点j的概率。其中:πij是节点i和节点j未归一化的转移概率;Z是归一化常数;wij是节点i和节点j之间边的权重;Sij是节点i和节点j之间的相似度;distance(k,j)是节点k和节点j之间的最短距离。参数p控制回到原节点的概率,p越高访问原节点的概率越低。q控制跳到其他节点的概率:若q>1,随机游走倾向于广度优先;若q<1,随机游走倾向于深度优先。

AE-MVANR 将TSV 和ASV 分别输入到该随机游走算法中,可得到基于两个视图的节点序列;然后把这两种序列输入到基于LSTM 的自编码器中进行训练;最终可得到融合结构信息和属性信息的节点表示向量。

2.5 基于LSTM的自编码器

为了更好地捕捉节点序列的先后关系、网络结构信息和节点属性信息,AE-MVANR 采用基于LSTM 的自编码器作为网络表示学习模型,基于LSTM的自编码器结构如图2所示。

图2 基于LSTM的自编码器结构Fig.2 Framework of LSTM-based auto-encoder model

如图2 所示,自编码器由三部分组成:输入层、隐藏层和输出层。输入层和隐藏层之间为编码过程,隐藏层和输出层之间为解码过程。输入层和输出层具有相同规模。AEMVANR 采用LSTM 构造编码解码过程。LSTM 是一种时间循环神经网络,适用于处理和预测时间序列中间隔和延迟非常长的重要事件,详细介绍可参见文献[26]。

如图1 所示,AE-MVANR 首先将在原拓扑结构视图和隐藏属性结构视图获得的节点序列向量化,经LSTM 编码,获得一种通用的编码表示,然后经过解码获得输入序列的重构,最后通过最小化重构误差函数不断优化学习效果,并提取隐藏层中的信息作为节点的表示。AE-MVANR 定义的目标函数如式(8)~(12)所示:

由于网络的稀疏性,输入向量非零元素远远少于零元素。式(8)对零元素引入惩罚项,其中⊙指Hadamard 乘积。为防止函数过拟合,式(11)引入正则化的L2 范数,式(12)进一步采用权重参数α来权衡两个不同的部分。

3 实验与结果分析

3.1 数据集

本文采用两个规模不同的网络数据集WebKB和citeseer,其中WebKB 包含4 个小数据集texas、washington、cornell 和wisconsin。由于本文讨论的是无向网络的节点表示学习,所以将这些数据集中的有向网络转化为无向网络。经处理后的各数据集的相关统计信息说明如表1 所示。其中,t代表属性维度,#label代表标签个数,avgk表示网络的平均度。

表1 数据集详细信息Tab.1 Detailed information of datasets

3.2 对比方法

为了评估本文所提算法AE-MVANR 的性能,本文实验中分别与七种现有的网络表示学习方法和两种基于AEMVANR改进的算法进行了比较。

3.2.1 基于拓扑结构的网络表示学习算法

1)DeepWalk[9]。该算法利用随机游走策略在网络中获得一系列节点序列,然后将每个节点序列视为一个句子,输入到Skip-Gram 模型中,通过最大化预测节点上下文的概率学习该节点的低维向量表示。

2)node2vec[11]。该算法基于DeepWalk 模型,结合深度优先和广度优先方法,使抽样的路径能更大程度上同时保存网络的局部特征和全局特征。

3)LINE[10]。该算法基于DeepWalk 模型,进一步挖掘了网络中节点之间的关系。它将节点之间的直接连接关系定义为一阶相似性,将存在共同邻居却不直接相连的节点关系定义为二阶相似性。通过引入二阶相似性,LINE 极大缓解了网络中的数据稀疏问题。

4)SDNE[13]。该算法使用深层神经网络对节点间的非线性关系进行建模,更好地捕捉了网络中高阶非线性特征,最终将深层自编码器的中间层作为节点的表示。

3.2.2 综合运用拓扑结构和节点属性的网络表示学习算法

1)TADW[14]。该算法基于矩阵分解,将富含文本属性信息的矩阵加入到矩阵分解的过程中,最终得到融合了两种信息的节点表示向量。

2)ASNE[20]。该算法将结构信息和离散属性信息同时输入深度神经网络,并采用前融合对两种信息进行深度融合,学习每个节点的低维表示向量。

3)STNE[19]。该算法基于seq2seq 的模型框架,利用双向LSTM的自翻译机制将内容信息序列翻译为对应的结构序列,从而将内容信息和结构信息无缝融合到隐藏层的潜在向量中,可更加高效地表示节点。

3.2.3 基于AE-MVANR改进的相关算法

1)AE-MVANR(RW)。为了验证随机游走算法对于AEMVANR 的影响,本文将随机游走算法部分删除,得到其删减版本AE-MVANR(RW)。

2)AE-MVANR(AE)。为了验证基于LSTM 的自编码器对于AE-MVANR 的影响,本文将基于LSTM 的自编码器替换为自编码器,得到其简易版本AE-MVANR(AE)。

3.3 参数设置

为保证算法对比的公平,本文将WebKB 数据集中节点表示向量维度统一设置为d=64,citeseer 数据集中节点表示向量维度统一设置为d=128,其余参数设置为默认值。

AE-MVANR 参数设置:每个节点添加的边条数c=3,节点序列条数w=1,节点序列长度l=10。WebKB 数据集批次大小b=32,迭代次数r=30;citeseer 数据集批次大小b=64,迭代次数r=50。

3.4 实验环境

硬件环境为Intel Core i5-2400 CPU@3.10 GHz,4.00 GB内存;软件环境为ubuntu18.04.2 LTS系统,Python 3.7.1。

3.5 节点分类

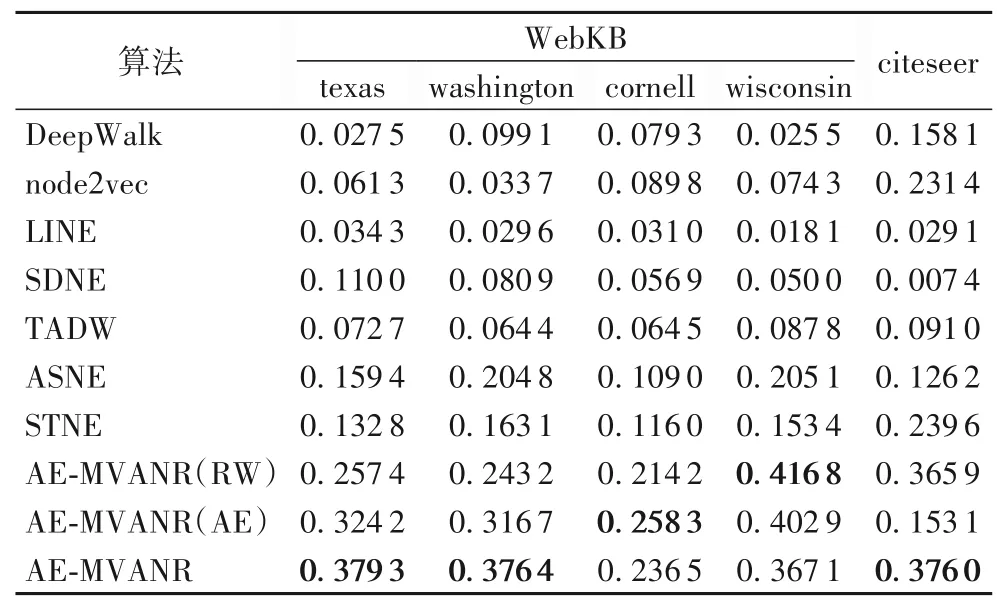

节点分类指利用已分类节点的信息,为未分类节点标记一个类别,它是节点特征学习效果衡量的一个常见任务。为了评估算法准确性,本文将实验数据集随机且独立地分为训练集和测试集,将数据中的70%用作训练集,剩余数据用作测试集。采用逻辑回归(Logistic Regression,LR)作为分类算法,评价准则采用准确率(Accuracy)。表2 是各算法在WebKB和citeseer数据集上的分类结果。

表2 不同算法的节点分类准确率对比Tab.2 Node classification accuracies of different algorithms

从表2 中可以看出,AE-MVANR 及其相关算法在WebKB数据集中准确率均优于对比算法,在citeseer 数据集中和TADW 算法表现相同。这可能是因为WebKB 的网络规模较小,AE-MVANR 及其相关算法深度挖掘到的隐藏网络结构信息在较大程度上补充了其原拓扑结构信息的不足。AEMVANR(RW)在cornell 数据集中准确率优于AE-MVANR,在wisconsin 数据集中准确率与AE-MVANR 相同,这可能是因为这两个数据集的网络密度较小,随机游走算法在这两个数据集中得到了较多的冗余节点序列信息,反而导致AE-MVANR表现不佳。相较于AE-MVANR 和AE-MVANR(RW),AEMVANR(AE)在WebKB 和citeseer 数据集上表现较差,这可能是因为基于LSTM 的自编码器能够更好地挖掘节点之间的潜在结构关系。

3.6 节点聚类任务分析

节点聚类将网络中的节点划分为若干集群,使得同一集群内的节点相似而不同集群的节点相异。本文采用经典的聚类方法K-means 方法对各个数据集进行聚类实验,WebKB 的聚类个数设为5,citeseer的聚类个数设为6。评价指标采用标准化互信息(Normalized Mutual Information,NMI)、轮廓系数(Silhouette Coefficient)和戴维森堡丁指数(Davies Bouldin Index,DBI)。其中,NMI 的取值范围是0 到1,值越大表明聚类结果越好;Silhouette Coefficient 的取值范围是-1 到1,值越大表明聚类结果越好;DBI 的取值最小是0,值越小表明聚类结果越好。聚类结果分别如表3~5所示。

表3 展示了不同算法在WebKB 和citeseer 数据集上的聚类效果,评价指标为NMI。可以看出,AE-MVANR 在texas、washington 和citeseer 数据集上聚类效果明显优于其他算法。AE-MVANR(AE)在cornell 数据集中表现最佳,这可能是因为该数据集网络密度较小,在随机游走算法中得到了较多的冗余节点序列信息,然而这些冗余信息更加突出了节点间的聚类特征。AE-MVANR(RW)在wisconsin 数据集中表现最佳,这可能是因为AE-MVANR 在随机游走算法中得到了较多的冗余节点序列信息,使得基于LSTM 的自编码器在训练过程中受到影响,因此导致AE-MVANR表现欠佳。

表3 不同算法的节点聚类结果的NMITab.3 NMI performance of node clustering results of different algorithms

表4 展示了不同算法在WebKB 和citeseer 数据集上的聚类效果,评价指标为Silhouette Coefficient。可以看出,AEMVANR 在texas 数据集上聚类效果明显好于其他算法。AEMVANR(RW)在cornell、wisconsin 和citeseer 数据集上表现最佳,这可能是因为这三个数据集的网络密度较小,而AEMVANR(RW)没有随机游走算法过程,不必对大量重复冗余序列进行训练,结果反而更好。AE-MVANR(AE)在washington 数据集上表现最佳,这可能是因为washington 数据集的网络平均度较高,随机游走算法可以更加全面地捕捉网络中的信息。

表4 不同算法的节点聚类结果的Silhouette CoefficientTab.4 Silhouette Coefficient performance of node clustering results of different algorithms

表5 展示了不同算法在WebKB 和citeseer 数据集上的聚类效果,评价指标为DBI。可以看出,AE-MVANR算法在texas和cornell 数据集上聚类效果明显优于其他算法。AE-MVANR(RW)在wisconsin 数据集中表现最佳,这可能是因为该数据集网络密度较小,AE-MVANR(RW)缺少随机游走过程,使得LSTM 在训练过程中没有出现过拟合现象。AE-MVANR(AE)在washington 数据集中表现最佳,这可能是因为随机游走算法在平均度较高的网络中可以更加全面地捕捉信息。

表5 不同算法的节点聚类结果的DBITab.5 NMI performance of node clustering results of different algorithms

总结以上聚类实验可以看出:DeepWalk、node2vec、LINE和TADW 算法表现较差,这可能是因为它们不适合聚类任务;结合外部信息的网络表示模型TADW、ASNE、STNE 在大多数数据集上的聚类效果优于基于网络结构的网络表示算法DeepWalk、node2vec、LINE、SDNE,这也在一定程度上表明综合运用拓扑信息和属性信息比仅利用拓扑信息更能保持网络结构及网络信息。

3.7 参数敏感性分析

为了验证AE-MVANR 的参数敏感性,本文对节点表示向量维度d、节点序列条数w和构造ASV每个节点添加的边条数c的取值进行对比分析,并基于WebKB 数据集做分类实验。图3 给出了它们对分类准确率的影响。从图3 可看出:texas数据集随着d的增长,准确率逐渐趋于稳定,说明texas对参数d的敏感性较低;washington、cornell和wisconsin 三个数据集随着d的增长,准确率浮动在一定范围内,但没有明显规律,说明这三个数据集对参数d较为敏感。

随着w的增加,wisconsin 和washington 数据集的准确率并无明显上升,而texas 和cornell 的准确率有较明显的上升,这可能是因为wisconsin 和washington 中节点的平均度较高,随机游走算法可以在序列条数较少时获得较为全面的网络结构信息,当序列条数变多时,冗余信息反而增加;而texas 和cornell 中节点平均度相对较低,随机游走算法在序列条数增多时可获得更多网络结构信息。

随着c的增加,texas、washington、cornell、wisconsin 数据集的准确率没有受到影响。这可能是因为数据具有稀疏性,相似性较高的节点对较少,所以当c取值较小时,也可以获得较全面的网络结构信息。

图3 WebKB上参数敏感性对分类结果的影响Fig.3 Influence of parameter sensitivity on classification results on WebKB

4 结语

本文提出了一种基于自编码器的多视图属性网络表示学习模型AE-MVANR,该模型利用属性网络中的网络结构信息和节点属性信息分别构造拓扑结构视图和属性结构视图,基于拓扑结构视图和属性结构视图深度挖掘不同节点间的内在联系。然后利用随机游走算法在两个视图上分别获取节点序列,再通过基于LSTM 的自编码器进行训练,最终得到融合了结构信息和属性信息的节点表示向量。分类和聚类实验结果表明,AE-MVANR 学习到的节点表示向量能更好地保持网络的不同特性,更好地完成后续任务。

现阶段由于服务器配置限制,只在中小规模数据集上对本文算法进行了验证,在后期的工作中,将引入更大数据量的数据进行性能展示。