自主武器系统对当代战争伦理的挑战*

2021-04-09杜雁芸

张 煌 杜雁芸

伴随着自主武器系统攻击事件的频发(1)2018年8月,委内瑞拉总统马杜罗遭遇无人机炸弹袭击;2019年9月,沙特阿美公司油田遭遇胡赛武装无人机群攻击;2020年1月,伊朗“圣城旅”指挥官苏莱曼尼少将被美国“收割者”无人机刺杀;2020年11月27日,伊朗顶级核物理学家穆赫辛·法赫里扎德被由人工智能技术远程控制的自主机枪击毙。,全球范围内新一轮自主武器系统军备竞赛也在如火如荼地展开。研发、使用自主武器系统存在的问题与潜在风险,日益成为国际社会关注的焦点。包括联合国秘书长、联合国军控委员会负责人、红十字国际委员会负责人和欧洲议会议长在内的国际政要,坚决反对致命性自主武器的研制和使用,对其可能引发的人道主义灾难表达深切的忧虑(2)Stephen Goose,“The Case for Banning Killer Robots: Point”,Communications of the ACM,Vol.58,No.12,2015,pp.43-45.。2018年7月,超过2400名AI领域科学家发表《致命性自主武器系统宣言》,承诺“将不参与也不支持致命性自动武器的开发、制造、贸易或使用”,并呼吁各国政府和政府领导人“利用强大的国际规范、法规和法律打击致命性自动武器”(3)Future of Life Institute,“Lethal Autonomous Weapons Pledge”,https://futureoflife.org/lethal-autonomous-weapons-pledge/,2021-01-23.。这是自1955年《罗素-爱因斯坦宣言》发表以来,国际社会再次针对一项武器,出现如此声势浩大、旗帜鲜明的和平主义行动,由此也引发学界围绕自主武器系统攻击的正义性展开一系列战争伦理追问。目前,国内学界围绕自主武器系统的战争伦理研究,主要聚焦于无人机等半自主武器系统作战的正义性分析(4)参见钱铖、石斌《“雄蜂”的阴影——美国无人机作战对当代战争伦理的挑战》,《世界经济与政治》2013 年第8期;梁亚滨《武装无人机的应用:挑战与影响》,《外交评论(外交学院学报)》2014年第1期;张煌、刘轶丹、张鹏:《无人机作战的伦理困境》,《伦理学研究》2015年第2期。,对于自主化程度更高的完全自主武器系统的战争伦理讨论,除了董青岭在《新战争伦理:规范和约束致命性自主武器系统》一文中做了具有开拓性意义的研究之外(5)董青岭:《新战争伦理:规范和约束致命性自主武器系统》,《国际观察》2018年第4期。,更进一步的专题研究仍然暂付阙如。国外学界特别是美国学者关于这一问题的研究成果相对丰富一些,相关讨论涉及伦理、法理以及技术规制等多个层面(6)Arkin Ronald ,“The Case for Ethical Autonomy in Unmanned Systems”,Journal of Military Ethics,Vol.9,No.4,2010; Michael C.Horowitz ,“The Ethics & Morality of Robotic Warfare: Assessing the Debate over Autonomous Weapons”,Daedalus,Vol.145,No.4,2016; Aaron M.Johnson and Sidney Axinn,“The Morality of Autonomous Robots”,Journal of Military Ethics,Vol.12,No.2,2013.,但由于国家立场、意识形态、价值观念层面的差异,加之自主武器系统的不断发展以及作战方式的不断创新,现有的研究远未达到完善的地步。本文在界定自主武器系统并梳理其作战应用历程的基础上,从经典正义战争理论的分析框架出发,系统讨论当前各类自主武器系统作战应用对于“开战正义”“交战正义”和“战后正义”相关伦理准则所构成的挑战,同时,展望未来完全自主武器系统的军事应用前景,就其对战争伦理体系可能造成的进一步冲击,做出具有前瞻性的评估与探讨。

一、自主武器系统的定义及其发展历程

当前,学界普遍认为,自主性是自主武器系统的典型标签,因此主要围绕武器的自主性对自主武器系统进行定义。2012年11月,美国国防部出台了发展自主武器的官方文件——《国防部指令3000.09》(武器系统中的自主性),将自主武器系统定义为“在激活后无需进一步人工输入就可以自主选择目标和交战的武器系统”(7)US Department of Defense,“Autonomy in Weapon Systems”,https://fas.org/irp/doddir/dod/d3000_09.pdf,2021-01-23.。虽然美国国防部对自主武器系统给出了官方定义,但是,当前学界对于自主性在武器系统中的具体体现,仍然存在一定的分歧与争议。特里克·德·格里夫(Tjerk de Greef)等人认为,自主武器系统是一种“算法决定一切、自主行动且以无需人类干预方式运行的武器系统”(8)Tjerk de Greef,Kees van Dongen,et al.,“Augmenting Cognition: Reviewing the Symbiotic Relation Between Man and Machine”,Foundations of Augmented Cognition ,Vol.4565 ,2007.。希瑟·罗夫(Heather Roff)提出,可以从三个方面来衡量武器系统的自主性程度:即自我机动性、自我指导性和自我决定性(9)转引自 Michael C.Horowitz,“When Speed kills: Lethal Autonomous Weapon Systems,Deterrence and Stability”,Journal of Strategic Studies,Vol.42,No.6,2019。。奥斯汀·怀亚特(Austin Wyatt)进一步指出,自主武器系统的自主性,还体现为能够“以超出人类期望的方式学习并扩展其杀戮功能和能力”(10)Austin Wyatt,“Charting Great Power Progress Toward a Lethal Autonomous Weapon System Demonstration Point”,Defence Studies,Vol.20,No.1,2020.。综合以上定义,笔者认为,真正意义上的自主武器系统是一种拥有完全自主权的杀人机器,在人工智能技术的驱动下,它能够自主完成整个攻击流程,即自主运用传感器搜索潜在目标的数据信息,通过数据分析自主识别、锁定目标,自主评估使用武力的后果并自主作出攻击决策。

自主武器系统是人工智能技术推动武器装备创新发展最新和最典型的案例之一,它在军事领域的横空出世,引发了“人-武器”相互关系和战斗力生成机理的颠覆性转变,其发展历程体现了武器系统由“非自主-半自主-完全自主”的演进趋势。

传统战争是“人类中心化”的战争。从冷兵器时代开始,人类操控武器作战就是战争对抗模式的基本特征,武器必须要与人紧密结合才能够形成战斗力。 伴随人类战争由冷兵器战争向热兵器战争再到信息化战争的演进,武器装备的作用半径和毁伤能力不断增长,但人类作为武器装备操控者的角色和地位始终没有发生改变。

人工智能技术的发展及其军事应用,使得人在作战系统中的地位日益由“人在回路内”向“人在回路上”转变,人类从居于系统之中的操控者转变为居于系统之上的监督者。阿富汗战争中,美国使用“捕食者”无人机对基地组织和塔利班头目进行“定点清除”式攻击,揭开了无人化反恐战争的序幕。在此后的十余年间,基地组织重要头目阿尔哈特希、“自由者大会”头目奥马尔·霍拉萨尼、巴黎《查理周刊》恐怖袭击事件策划人纳赛尔·安西、“伊斯兰国”头目阿布·巴克尔·巴格达迪、伊朗高级将领卡西姆·苏莱曼尼等人尽皆命丧于无人机之手。作为美军执行定点清除行动的利器,察打一体的“捕食者”“收割者”无人机,实质上是一种有人监督的半自主武器系统,已经具有自主导航定位、自主识别目标和半自主火力打击的能力,人类实时监控无人作战系统的运行,可以在必要的时候对武器系统进行干预和接管。

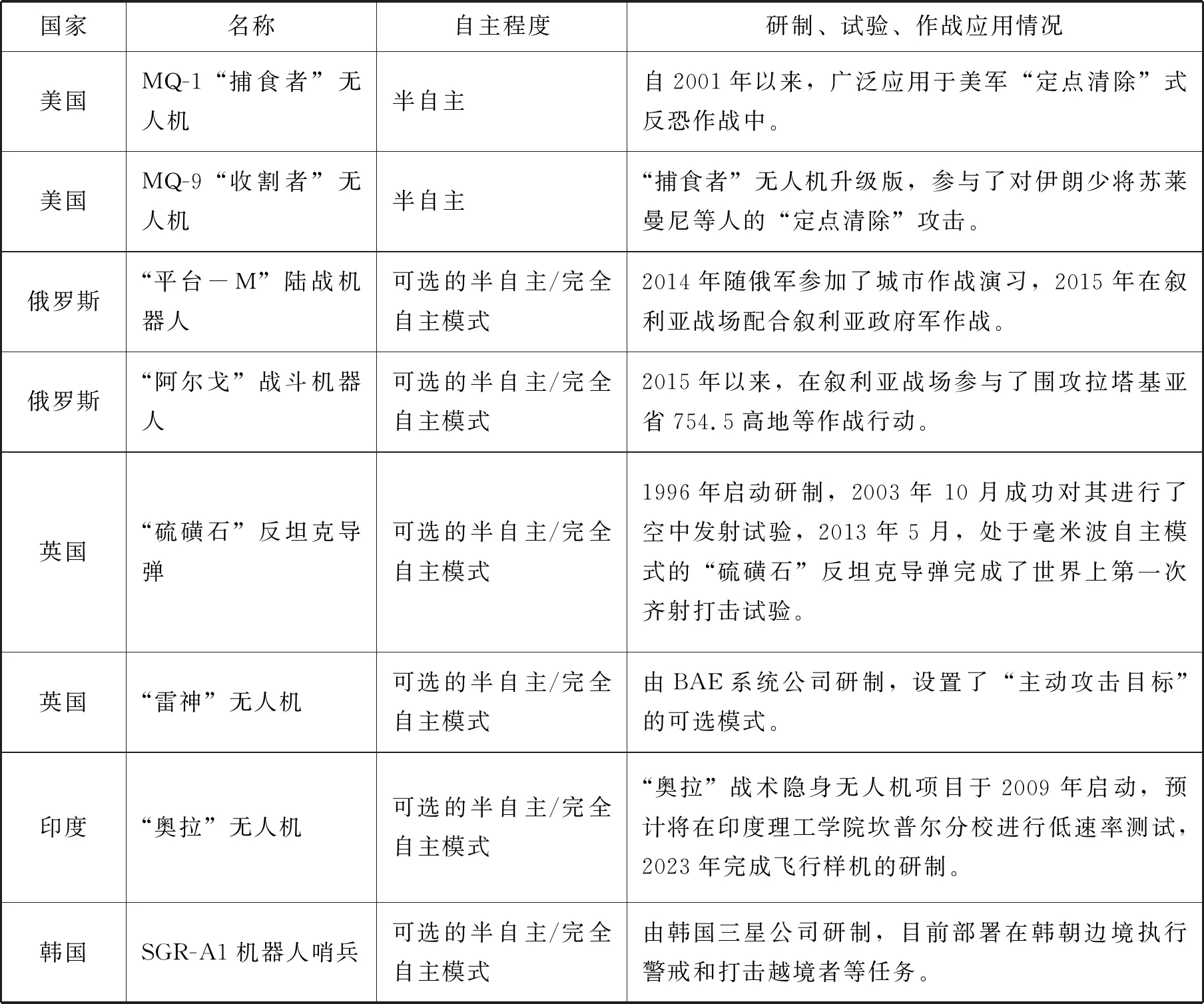

完全自主武器系统的出现,彻底颠覆了人类作为武器操纵者和致命行为执行者的历史。2017年,国际非政府组织“自主武器系统禁令运动”对外公布了一段视频。一群由人工智能技术驱动的机器“杀人蜂”闯入教室,通过人脸识别方式,将十余名正在上课的学生瞬间击杀,场面极度血腥。虽然视频中的杀人场景是由计算机模拟而成,但在现实世界中,各军事强国围绕自主武器系统的军备竞赛已在如火如荼地展开。早在2012年11月,美国国防部就出台了发展自主武器的官方文件——《国防部指令3000.09》,规定了研发半自主和自主武器的通用原则(11)US Department of Defense, “Autonomy in Weapon Systems”,https://fas.org/irp/doddir/dod/d3000_09.pdf,2021-01-23.,并实施了联合无人空战系统、高自主性远程反舰导弹、X-47B无人机、“快速轻量化自主”以及“拒止环境协同作战”等一系列自主武器技术和装备研发项目(12)[美]保罗·沙瑞尔:《无人军队:自主武器与未来战争》,朱启超等译,世界知识出版社2019年版,第111-130页。。目前,美军已装备无人机7000多架,在伊拉克、阿富汗战场上投入运用的地面轮式机器人超过12000个(13)[美]保罗·沙瑞尔:《无人军队:自主武器与未来战争》,朱启超等译,世界知识出版社2019年版,第7页。。与美国自主武器的发展相同步,在2015年的叙利亚战争中,俄罗斯军方就开始将整建制的半自主机器人投入战场。2017年7月,俄罗斯军工制造商卡拉什尼科夫联合企业宣布,他们即将发布基于神经网络的全自主作战模块(14)Russian News Agency,“Kalashnikov Gunmaker Develops Combat Module Based on Artificial Intelligence”,https://tass.com/defense/954894,2021-01-23.。俄罗斯人工智能专家梅德韦杰夫·米哈伊尔预言,2030年俄罗斯军队将主要由自主机器人组成(15)Kelsey D.Atherton,“Russian Roboticist Sees All-But-Lethal Autonomous Weapon Systems by 2030”,https://www.c4isrnet.com/unmanned/2018/09/17/russian-roboticist-sees-all-but-lethal-autonomous-weapon-systems-by-2030/,2021-01-23.。除美、俄以外,诸如英国的“雷神”无人机和“硫磺石”反坦克导弹、印度的“奥拉”无人机以及韩国的SGR-A1机器人哨兵等,都是具有自主作战能力的武器系统(见表1)。

表1当前各国自主武器系统研发、应用情况一览表(16)参见[美]保罗·沙瑞尔《无人军队:自主武器与未来战争》,朱启超等译,世界知识出版社2019年版,第111-130页。

随着各国军队自主武器系统的自主程度越来越高,使用频次越来越密集,由此产生的人道主义灾难事件和战争伦理危机也越来越多。其中,美国无人机反恐造成的伦理危机和人道主义灾难,成为全球舆论和国际社会的热点话题。“9·11”事件以来,美军以反恐名义,长期在阿富汗、巴基斯坦、伊拉克、索马里、也门以及叙利亚等主权国家领空范围内执行无人机“定点清除”任务,殃及大量无辜平民。据统计,自2004年以来,美军仅在巴基斯坦一国,就使用无人机进行了408起反恐袭击,造成包括大量平民在内的3000多人丧生(17)Jamil Bhatti,“News Analysis: Latest U.S.Drone Strike in Pakistan May Further Escalate Bilateral Tension”,http://www.xinhuanet.com//english/2017-09/18/c_136617222.htm,2021-01-23.。围绕美军无人机反恐的正义性与合法性问题,伦理学界和法学界已经进行过广泛讨论。2020年1月3日,美军在伊拉克使用无人机击毙了伊朗少将苏莱曼尼,这是美国首次针对主权国家的重要军事领导人实施“定点清除”行动,使得此次刺杀事件在正义性方面面临更多、更尖锐的争议。2020年11月27日发生的伊朗核科学家遇刺事件,又引发了国际社会对于自主武器系统匿名攻击问题的关注。自主武器系统的隐秘性使得强权国家领导人相信,依靠自主武器系统实施远程打击不需要承担战争责任且毫无风险可言,也使得这种匿名攻击的战争伦理后果比以前更难评估。由于各军事强国竞相研发、部署和使用自主武器系统,智能化时代的军事对抗日益呈现出“去人类决策”“去人类中心化”的发展趋势。作为人工创造物,自主武器系统正在取代人类的战争主体地位,开始控制战争,进而对传统的战争伦理观念构成强有力的冲击与挑战,人类战争向着失控的方向发展。

二、自主武器系统与“开战正义”

正义战争理论认为,战争的正义性应当体现在目的、手段和责任三个方面,必须实现“开战正义”“交战正义”和“战后正义”的统一。“开战正义”是实现战争正义的起始点,主要是探讨国家诉诸战争权利的正义性问题。依据经典正义战争理论以及相关国际法规定,影响“开战正义”的伦理原则主要包括“正当理由”“合法权威”“正当目的”“成功的可能性”“相称性”和“最后手段”六个方面(18)左高山、李建华:《战争镜像与伦理话语》 ,湖南大学出版社2008年版,第31页。。

当前,对于自主武器系统引发战争伦理风险的探讨,主要是将其作为一种战争手段,分析其在交战过程中的手段正义性问题以及体现“战后正义”的责任分配问题,也有少数学者关注到战争手段对于战争目的的反向影响。德国达姆施塔特工业大学的马蒂亚斯·恩格勒特(Matthias Englert)等人认为,自主武器系统在作战手段中的道德应用,也是将价值观和行为准则输入智能化作战平台的控制系统(19)Matthias Englert,Sandra Siebert and Martin Ziegler,“Logical Limitations to Machine Ethics with Consequences to Lethal Autonomous Weapons”,Computer Science,No.11,2014.。自主武器系统的军事应用,特别是智能化情报分析和作战辅助决策系统的出现,将机器意志渗透到开战决策之中,反向影响了战争决策者看待战争的价值观念与行动操守,从而对“开战正义”的伦理原则构成冲击与挑战。具体而言,自主武器系统对于“开战正义”的挑战,主要体现在对“正当理由”“合法权威”以及“最后手段”三个原则的挑战。

(一)自主武器系统对“正当理由”原则的挑战

在正义战争理论体系中,“正当理由”是维系“开战正义”的首要原则。正义战争理论对正当理由原则有严格的限定,即唯一正当的开战理由是针对外敌侵略进行自卫。自主武器系统的军事应用,冲击了自卫作为开战正当理由的唯一性。

一方面,当前自主武器系统作战应用所展现的低成本和高效率,导致技术先发国家不断弱化“正当理由”的伦理标准。较之传统作战平台,目前各类半自主和完全自主武器系统不仅具有平台无人、造价低廉等优势,而且可以通过匿名攻击规避战争责任,其在经济、政治以及人员安全方面的成本优势,使其被广泛应用于高技术局部战争、反恐作战等行动中。以美国的无人机反恐为例,迈克尔·沃尔泽(Michael Walzer)认为:“较之其他杀伤形式,无人机容易太多了,以至于让我们产生不安。它是既诱人又危险的技术手段。它使我们的敌人比以往更脆弱,而我们的士兵没有任何风险。……但技术太好,使用的标准就会逐步放松。”(20)Michael Walzer,“ Just & Unjust Targeted Killing & Drone Warfare”, Daedalus,Vol.145,No.4,2016.察打一体的武装无人机,不仅强化了西方军事强国打赢反恐战争的手段优势,也相应降低其发动战争的物质成本与道德成本,导致少数霸权国家弱化约束开战正义的道德准则,以所谓“预先防卫”的名义,滥用开战权利。

美国使用无人机刺杀苏莱曼尼的军事行动即是一个典型的例子。关于刺杀苏莱曼尼的原因,特朗普在2020年1月13日发表的个人推文中表明心迹:“苏莱曼尼是否对美国进行袭击并不重要,因为他过去的可怕经历!”(21)转引自Alex Hobson,“An Eye for an Eye Doesn’t Make Americans Safer”,Foreign Policy,No.2,2020。这是对特朗普复仇心态的直接表述,也意味着在特朗普政府认同的开战理由中,自卫已经不是具有优先级的理由。而特朗普在白宫的讲话中也指出:“如果任何地方的美国人受到威胁,我准备并采取任何必要的行动。特别是指伊朗。”(22)National Security & Defense,“Remarks by President Trump on the Killing of Qasem Soleimani”,https://www.whitehouse.gov/briefings-statements/remarks-president-trump-killing-qasem-soleimani/,2020-09-01.只要受到“威胁”而非遭受实质性伤害就可以“采取任何必要的行动”,意味着在强大技术优势的加持下,美国反恐战争日益在战略上迷失,“预先防卫”驱使下的反恐战争在全球呈扩大化趋势,从而使国际安全环境陷入更为严峻的形势之中。

另一方面,未来完全自主武器系统的军事应用,将使得机器意志贯彻到开战决策之中,导致维系“开战正义”的“正当理由”原则面临更严峻的挑战。

伴随军事智能化的发展,自主武器系统参与战争决策的程度日益加深。早在1990年,美军作战实验室进行实战化仿真的推演结果,形成了以“左勾拳”为核心的低风险、低伤亡作战方案,这也成为促成美国老布什政府作出海湾战争决策的关键依据(23)俞中明、杨旭:《海湾战争地面决战的运筹分析》,中国系统工程学会军事系统工程委员会第七届年会论文集,1995年,第54-57页。。“9·11”事件以来,美国等人工智能技术先发国家构建了“棱镜”等智能化大数据分析平台(24)Aiesha Y.Khudayer,Rasha M.Abdulsalam,et al.,“Impact of NSA-PRISM to National Information Security Strategy & Policy”, International Journal of Information and Communication Technology Research,Vol.4,No.1 ,2014.,运用大数据挖掘、模拟仿真、兵棋推演等技术手段预判可能存在的国家安全威胁,以此作为先发制人发动军事行动的凭据。当前,以美军为首的北约国家在针对伊斯兰极端宗教组织的反恐战争中,广泛应用人工智能技术预判恐怖威胁,通过对过往恐怖袭击的时间、空间、人员、装备以及政治诱因、宗教诱因、民族诱因等历史信息进行关联分析,预测未来可能发生的恐怖袭击事件和锁定恐怖嫌疑人。美军针对潜在恐怖嫌疑人实施先发制人的“特征攻击”,即目标一旦被自主武器系统认定具有恐怖分子的某些行为特征,美军就可以在未经国会批准的情况下实施“斩首”行动(25)Daniel Byman,“Why Drones Work:The Case for Washington’s Weapon of Choice”,Foreign Affairs,Vol.92,No.4,2013.。

未来,智能化战争决策系统自主能力的深度发展,可能进一步推动开战决策模式由机器辅助决策向机器代替人决策的颠覆性转变,由此也引发对开战理由公开性与透明性的质疑。依据正义战争理论,正当的开战理由不仅是合法的,而且应当是公开透明、为公众所理解的。自主武器系统一旦掌握开战决策权,将导致公开的开战程序日益被隐秘的算法、模型和运算程序所取代,以各类算法、模型为基础的军事威胁评估系统被视作严格保护的机密,这些不透明、不接受质疑、难以被理解的算法和模型被用于战争决策,而国际社会和普通民众根本无法了解决策程序的具体运行规则,很难对其决策结果的正义性提出质疑。

(二)自主武器系统对“合法权威”原则的挑战

自主武器系统对于“开战正义”的挑战,同样体现为对“合法权威”原则的冲击。正如美国宾夕法尼亚大学的亚伦·约翰逊(Aaron M.Johnson)所指出的:“自主武器系统引发了诸多伦理问题,但最核心的问题是将决定人类生命的权利由人转交给机器。”(26)Aaron M.Johnson and Sidney Axinn,“The Morality of Autonomous Robots”,Journal of Military Ethics,Vol.12,No.2,2013.作为开战正义的重要原则,“合法权威”原则规定战争是国家与国家之间的行为,主权国家和联合国是发动正义战争的合法权威。自主武器系统的军事应用,使得各类智能化作战平台取代人类进行战争筹划与决策成为可能,不仅颠覆了传统作战模式,也冲击了“合法权威”原则的道义基础。以韩国三星公司研发的SGR-A1机器人哨兵为例,据国际电气和电子工程协会的报道,这款部署在韩朝边境的武装哨兵机器人,一旦切换至完全自主攻击模式,将会掌握生杀予夺的权力,自主攻击所有越境的入侵者(27)Jean Kumagai,“A Robotic Sentry for Korea’s Demilitarized Zone”, IEEE Spectrum,Vol.44,No.3,2007.。

更值得关注的是,自主武器系统一旦掌握自主开火权,成为发动战争的“合法权威”,可能增加“意外战争”爆发的风险。“意外战争”是指由于核打击方面的错误评估、错误判断、错误警报或核事故而引发的军事危机,甚至导致核战争的爆发。在传统的危机预警模式下,人在系统的回路之中,既是危机反应的最终决策者,也是危机处理最后的“保险装置”。新美国安全中心高级研究员保罗·沙瑞尔(Paul Scharre)指出:“人类并不完美,但他们能够同情对手并考虑全局。与人类不同,自主武器无法理解其行动的后果,也无法在战争的边缘悬崖勒马。”(28)[美]保罗·沙瑞尔:《无人军队:自主武器与未来战争》 ,朱启超等译,世界知识出版社 2019年版,第357页。冷战期间,美苏双方多次收到错误的核攻击信息,得益于人类的理性判断和人机双重检查机制,双方最终选择了克制而非升级的应对策略,避免了核战争的意外爆发。自主武器系统的军事应用,可能带来危机预警模式的革命性变化。在危机处理规程中,自主武器系统通过目标识别提取匹配算法规则的有效信息,自主进行具体分析和判断。这种由算法主导的自主预警模式,虽然在一定程度上提升了国家危机预警的速度和效率,但是,由于将人类从危机预警的系统回路中剔除出来,人机双重检查制度和重新考虑机制无法实现。迈克尔·哈斯丘(Michael E.Haskew)认为:“使用自主武器的国家会在危机方程式中引入一个超出其直接控制范围的变量。”(29)转引自[美] 保罗·沙瑞尔《无人军队:自主武器与未来战争》,朱启超等译,世界知识出版社2019年版,第345页。人类干预缺失造成的不可控性与算法运行的不可控性双重叠加,进一步增加了危机的不稳定性和发生“意外战争”的风险。

(三)自主武器系统对“最后手段”原则的挑战

在传统的“开战正义”标准之下,战争作为解决国际争端的一种手段,受到严苛的条件约束,即战争必须是政治、外交手段穷尽之后的最后选择。这是由于战争作为国之大事,关乎国家、民族的生死存亡,战争失败的沉重代价,决定了战争手段的运用只能是不得已而为之。近年来,国际上自主武器系统攻击事件频发,对于美国等军事强国而言,低成本、高效率且可以保证攻击方绝对安全的各类自主武器系统,已经日益将战争变成一架“无风险”“零伤亡”的机器,进而使得战争从“最后手段”蜕变为“最优手段”。概而言之,由人工智能技术驱动的自主武器系统对于“最后手段”原则的挑战,具体体现在三个方面:

首先,自主武器系统挑战了“最后手段”原则成立的前提条件。费尔巴哈在《宗教的本质》中指出:“人类的恐惧多源自于未知。”战争作为人类处理纷争的最后手段,也是源于交战各方对战争结果的未知。在信息技术不发达的古代,人们无法准确预知战争的胜负,处于“战争迷雾”笼罩下的政府对战争的决策必然是慎之又慎。人工智能技术以及自主武器系统的军事应用,使得战争的结果在一定程度上从“未知”变为“已知”。人工智能科技领域的突破性进展和军事应用,催生了战争工程、兵棋推演以及作战实验室等一系列战争预判与评估手段。利用上述科技领域的最新进展,推演战争的进程并预测战争的结果,成为智能化战争的重要特征。借助人工智能技术的风险评估、推演和研判功能,少数霸权国家在预知战争结果的情况下,可以将遥远的、不确定的军事威胁评估为确定的、迫在眉睫的战争前景,并以此作为滥用“预先自卫权”和发动“预防性战争”的现实凭据。同时,利用自主武器系统攻击的低成本、零风险以及隐秘性等优势,这些国家可以逃避“尸袋综合症”带来的国际、国内舆论压力,从而在轻易逾越战争门槛的同时占据道义制高点。

其次,自主武器系统打破了逐渐升级的“最后手段”使用模式。对于战争与政治的关系,克劳塞维茨(Carl Von Clausewitz)在《战争论》中有过精辟的论述:“战争是政治通过另一种手段的继续。”从时间关系上来看,这句话也说明政治手段与战争手段之间存在一个前后接续的关系。传统的战争往往经历由照会、声明、磋商、谈判和斡旋等低成本政治外交手段,再向军事渗透、介入、威慑、干预、打击等高成本、高风险战争手段逐渐升级的过程。各类自主武器系统以其“无人化”“非接触”的打击优势,颠覆了逐渐升级的手段使用模式。特朗普政府在没有掌握确凿证据的情况下,就使用无人机击毙伊朗军事领导人苏莱曼尼,也反映了在解决国际争端中,较之暴力程度更低但程序繁琐、时间冗长的政治、外交手段,能够一锤定音且毫无风险的自主武器系统显然更受到政治家的青睐。

最后,自主武器系统进一步挑战了维系“最后手段”原则的均衡性基础。“最后手段”原则成立的基础,在于敌对双方力量总体上处于均势状态,从而使他们审慎思考未来战争的残酷性和取得战争胜利的惨重代价。正如美国内战时期著名将领罗伯特·李(Robert Lee)所言:“战争残酷是件好事,否则人们真的会爱上战争。”于尔根·奥特曼(Jürgen Altmann)等学者指出,自主武器系统的军事应用,进一步打破了国际军事竞争的战略稳定性(30)Jürgen Altmann and Frank Sauer,“Autonomous Weapon Systems and Strategic Stability”,Survival,Vol.59 ,No.5,2017.。自主武器系统实现人与武器的实质性分离,极大提升作战效率,同时使己方战争伤亡无限趋近于零。美军正在实施的“第三次抵消战略”,就是试图利用人工智能技术和自主武器系统的质量优势,抵消战略对手在传统信息化作战力量上的数量优势。未来,具备人工智能的“无人军团”,可能成为世界一流军队的“标配”,从而进一步拉大国际间军力差距,在国际军事力量博弈中塑造强者恒强、弱者愈弱的格局。

三、自主武器系统与“交战正义”

“交战正义”又称战争手段正义,主要体现为交战过程中攻防双方如何规制作战手段的使用方式,使其符合伦理道德规范的要求。随着各国加大对自主武器系统的研发投入,其在交战过程中的自主性不断提升。譬如,英国军方研发的“雷神”无人机,设置有主动攻击目标的可选模式,可在战场上自主搜寻和攻击敌对目标(31)[美]保罗·沙瑞尔:《无人军队:自主武器与未来战争》,朱启超等译,世界知识出版社 2019年版,第120页。;韩国军方部署的SGR-A1机器人哨兵,可以使用弱光摄像头和模式识别软件锁定敌人,并在必要的时候自主决定开火射击(32)Jean Kumagai,“A Robotic Sentry for Korea’s Demilitarized Zone”,IEEE Spectrum,Vol.44,No.3,2007.;俄罗斯军方装备的“平台-M”陆战机器人,可以在智能化系统控制下自主收集情报、搜索和摧毁固定及移动目标(33)[美] 保罗·沙瑞尔:《无人军队:自主武器与未来战争》,朱启超等译,世界知识出版社 2019年版,第125页。。上述具有高度自主性的武器系统引发了国际社会的关注,自主武器系统能否在交战过程中遵循战争伦理规范,成为当前国内外学者争议的焦点。一旦完全不受约束的自主武器系统取代人类成为战争唯一主体,必将挑战维系“交战正义”的基本伦理原则,可能导致人类社会面临前所未有的自我毁灭风险。自主武器系统在交战中的伦理风险,具体体现在以下几个方面:

(一)自主武器系统对“区分原则”的挑战

“区分原则”是体现“交战正义”的一项基本原则。正如沃尔泽所指出的:“在任何情况下都不能攻击非战斗人员,永远不能将其作为军事行动的目标。”(34)[美]迈克尔·沃尔泽:《正义与非正义战争:通过历史实例的道德论证》,任辉献译,江苏人民出版社2008年版,第140页。“区分原则”强调交战各方必须对攻击目标严格加以区分,以达成对平民特别是老弱妇孺、俘虏和丧失战斗能力者等弱势群体的保护。

自主武器系统带来了战场区分模式的革命性变化。在传统战争模式下,区分目标由人类完成,自主武器系统利用算法取代人力主导的区分方式,即通过计算机编程的方法,将区分规则转化为自主武器系统能够理解的一组算法,由此也引发了学界的广泛质疑。2018年5月,3100多名谷歌员工联名抵制军用无人机作战项目Maven,成为震惊全球的科技伦理事件(35)Rahul Kalvapalle,“What is Project Maven? The Pentagon AI project Google Employees Want Out of”,https://globalnews.ca/news/4125382/google-pentagon-ai-project-maven/,2021-01-23.。这一事件的爆发,集中反映了学界对于算法区分模式潜在风险的忧虑。

史蒂文·乌姆布雷洛(Steven Umbrello)一针见血地指出,机器算法区分存在区分目标的盲区,无法可靠地区分合法与非法目标(36)Steven Umbrello,“The Future of War: Could Lethal Autonomous Weapons Make Conflict More Ethical?”,AI & Society,Vol.35,No.1,2019.。在他看来,并非所有的区分标准都可以转化为算法植入机器之中。当前,军服、武器装备等一系列明确标识可以设置区分规则,然而,在近期爆发的几场高技术局部战争和反恐作战中,为应对北约国家的军事打击优势,对手采取寓军于民的方式,军事目标缺乏明显的视觉标识,这给自主武器系统执行区分任务带来巨大挑战。

特罗·卡尔皮(Karppi Tero)等人进一步指出,自主武器系统难以胜任涉及目标主观情绪的区分任务(37)Karppi Tero,Böhlen Marc and Granata Yvette,“Killer Robots as Cultural Techniques”, International Journal of Cultural Studies,Vol.21,No.2,2018.。譬如,对于自主武器系统而言,区分投降信号的真伪比区分军民困难得多,因为传递投降信号的方式、方法和途径呈现巨大的多样性。人类对于投降信号的识别源于自身的经验、阅历和主观感受,难以通过编程方式转化为可供机器区分操作的算法。

此外,钱铖等人认为,自主武器系统在贯彻区分原则方面还存在跨文化环境障碍,美军在无人机反恐作战中,将是否携带管制武器作为区分恐怖分子的重要特征,忽视了中亚地区游牧民族成年男性有随身佩戴刀具的文化传统(38)钱铖、石斌:《“雄蜂”的阴影——美国无人机作战对当代战争伦理的挑战》,《世界经济与政治》2013年第8期。。事实上,任何区分操作都是在具体的地域环境、文化环境和宗教环境中进行的,将自主武器系统置于跨文化环境的陌生战场,可能造成识别区分操作的失误。

在笔者看来,即便技术的发展使得上述区分盲区不复存在,以自主武器系统取代人类来区分目标,在道义上仍是难以接受的,因为它违背了确立“区分原则”的初衷。“区分原则”作为战争伦理规约的重要内容,它所体现的根本精神就是对人类生命权利的尊重。沃尔泽提及的“裸兵”案例启示我们,无论对于目标的识别多么契合“区分原则”,我们都需要在残酷的战争决策中留有道义的余地,以彰显敬畏生命、怜悯弱者的人性光辉(39)“裸兵”的案例是沃尔泽在《正义与非正义战争:通过历史实例的道德论证》中摘录罗伯特·格里福斯一战回忆录的一段:“在后方支援线,我打了个盹,刚醒过来,从射击孔透过望远镜看去,大约700码外一个德国人。他正在德国的第三线洗澡。我讨厌向一个没有防卫的人射击,就把步枪递给了一个中士。”。一旦自主武器系统可以自行决定敌人生死,就会从根本上抹去人性在战场上的存在感,进而可能带来重大伦理风险。这种伦理风险并非主要由算法区分的运行错误所导致,而是因为算法区分剥夺了人类决定同类生死的权利和尊严,践踏了“珍视生命、同情弱者”的社会价值观念。在一个由自主武器系统主宰杀戮的社会,人类缺乏对杀戮行为的道德负担,其结果必然使杀戮变得毫无人性。

(二)自主武器系统对“相称性原则”的挑战

在正义战争理论中,“相称性原则”是“区分原则”的重要补充。“相称性原则”强调在针对合法目标进行攻击时,也必须视目标和作战环境的具体情况,选择使用相称的作战方式和暴力手段,避免过度杀伤和重复伤害(40)周桂银:《国际政治中的外交、战争与伦理》,南京大学出版社2018年版,第287页。。

在技术乐观主义者眼中,自主武器系统堪称满足“相称性原则”的典范:一是空间相称,依托人工智能技术实现目标自主锁定,精确限定作战区域,选择性杀伤目标,最大限度避免“附带伤害”;二是时间相称,以美国X-47B无人机为代表的自主武器系统,能够实现“半小时覆盖全球”的快速打击,避免“马拉松”式消耗战;三是伤亡相称,“自主武器系统”实现人与武器的实质性分离,且按照智能作战推演优化作战方案,使实际伤亡无限趋近于零。基于此,美国智库兰德公司宣称,比起传统军事力量,自主武器系统能更好地遵循“相称性原则”(41)Lynn E.Davis,Michael J.McNerney,et al.,“Armed and Dangerous?UAVs and U.S.Security”,RAND,2014.。

相对于美国军方的乐观主义态度,伦理学界以理性的态度分析问题,指出自主武器系统虽然在数据处理与速度计算方面拥有人类难以比拟的优势,但在进行相称性的道德评估方面仍存在诸多瓶颈。

沙瑞尔从简单环境与复杂环境的比较视角指出,自主武器系统仅能评估太空、深海、极地等简单环境下的相称性问题,却难以在复杂环境下遵循相称性原则。他认为:“在人口稠密地区遵循相称性原则变得困难得多。……这将要求机器扫描目标周围的平民区域,估计潜在的附带损伤,然后判断是否应该进行攻击,这个过程很难实现自动化。”(42)[美]保罗·沙瑞尔:《无人军队:自主武器与未来战争》,朱启超等译,世界知识出版社2019年版,第288页。在复杂环境下,权衡军事目标价值与预期平民伤亡之间的相称性关系,涉及极其复杂的道德推理和评估能力,这是当前自主武器系统难以做到的。

钱铖等人从物理伤害与心理伤害的视角指出,军事行动既要在物理毁伤层面满足相称性原则,也需要在心理伤害层面满足相称性原则。自主武器系统能够对物理毁伤进行精确评估,进而衡量物理层面的相称性问题,却难以准确评估对敌国民众造成的持久性心理创伤,他们将美国无人机“定点清除”行动给所在国家民众带来心理层面的创伤称之为“雄蜂的阴影”( the Shadow of the Drone)(43)钱铖、石斌:《“雄蜂”的阴影——美国无人机作战对当代战争伦理的挑战》,《世界经济与政治》2013年第8期。。在笔者看来,“雄蜂的阴影”反映了当前美国利用自主武器系统反恐面临的道德困境。在某些西方媒体的宣传解读下,无人机等半自主或自主作战平台是以精准的物理摧毁来占据道义的制高点,媒体大肆宣扬依托无人机清除恐怖分子首领的“辉煌战果”,却刻意掩饰阿富汗、也门、索马里、叙利亚等反恐区域内民众反美情绪日益高涨、恐怖主义源头难以清除以及“三股势力”活动愈演愈烈等一系列问题。可以想象,在未来自主武器系统成为执法工具的时代,当局者可能对其快捷高效的执法能力赞誉有加,而普通民众也会对“机器人暴政”产生强烈的心理恐惧。

奥特曼等人从战术和战略的视角指出,自主武器系统即便在战术层面能够遵守相称性原则,在战略层面也难以遵循相称性原则。针对少数美国学者提出的利用“蜂群”攻击敌对国家的核武器输送系统,提升美国弹道导弹防御能力的方案,他们认为,自主武器系统执行的任务虽然只是小规模战术行动,但是可能造成战略影响(44)Jürgen Altmann and Frank Sauer,“Autonomous Weapon Systems and Strategic Stability”,Survival,Vol.59,No.5,2017.。一旦自主武器系统与核武器攻防技术深度融合,就必然会增加核战略对手之间的紧张和不信任,进一步刺激各国优先发展“先发制人”的自主武器系统,降低核大国之间的战略互信,威胁全球核战略稳定性。

在笔者看来,技术乐观主义者片面强调“自主武器系统”在简单环境、物理毁伤以及战术层面遵循“相称性原则”的优势,刻意忽视其在复杂环境、心理伤害以及战略层面违背“相称性原则”的问题,反映出对“相称性原则”内涵的曲解。沃尔泽指出:“我们要把‘造成的伤害’——这想必不仅包括对个人的直接伤害,也包括对人类长期利益的伤害——与伤害对胜利目标的促进作用加以权衡比较。”(45)[美]迈克尔·沃尔泽:《正义与非正义战争:通过历史实例的道德论证》,任辉献译,江苏人民出版社2008版,第118页。在沃尔泽看来,“相称性原则”在时间维度包括两方面含义:一方面是短期相称性,另一方面是长远相称性。自主武器系统在简单环境、物理毁伤以及战术层面的行为影响都是短期的,而在复杂环境、心理伤害以及战略层面的行为影响将是长期持续的。两者相较,维护人类长期利益的持久和平无疑更为重要。

四、自主武器系统与“战后正义”

“战后正义”又称战争责任正义。人类既是享有发动战争权利的主体,又是承担战争责任的主体。正如沃尔泽所指出的:“责任分配是对正义论的重要检验。……只要我们准确地指出责任者或者我们的责任分配和道德判断符合战争的实际经验,并对战争的所有痛苦保持敏感,就会极大地增强正义论的力量。如果最终无人负责,在战争中就没有任何正义可言。”(46)[美] 迈克尔·沃尔泽:《正义与非正义战争:通过历史实例的道德论证》,任辉献译,江苏人民出版社2008版,第261页。“战后正义”主要关注人类应当承担的战争责任,具体体现在战后秩序重建、侵略罪行审判、战争赔偿以及制裁等战争责任分配问题。在智能化战争模式下,伴随自主武器系统的出现与应用,人作为战争的责任主体从作战系统中脱离出来,将生死决定权委托给机器。对于这一变化,马库斯·舒尔茨克(Marcus Schulzke)、斯瓦蒂·马利克(Swati Malik)、邦尼·多彻蒂(Bonnie Docherty)等战争伦理学者认为,自主武器系统无法识别、承担责任并接受惩罚,原有的战后正义规约难以约束一场完全由机器人来进行的战争(47)Marcus Schulzke,“Autonomous Weapons and Distributed Responsibility”,Philosophy & Technology,Vol.26,2013;Swati Malik,“Autonomous Weapon Systems: The Possibility and Probability of Accountability”,Wisconsin International Law Journal,Vol.35 ,No.3,2018;Bonnie Docherty,“Mind the Gap: The Lack of Accountability for Killer Robots”,http://autonomousweapons.org/mind-the-gap-the-lack-of-accountability-for-killer-robots/,2021-01-23.,相应的伦理风险体现为:

(一)人与武器分离引发的“问责空白”风险

在传统战争模式下,人类作为军事行动的遂行者和武器的直接操控者,其所从事的战争行为与其导致的后果之间存在清晰的对应关系。依据正义战争理论,如果有可以辨认的战争罪行,就必定有可以辨认的罪犯。伴随自主武器系统的军事应用,人类在战争系统中的定位由“人在回路内”逐渐向“人在回路上”乃至“人在回路外”转变,作战主体与作战手段之间的距离日益拉大,当前西方军事强国广泛使用的“捕食者”“收割者”等半自主武装无人机,就是典型的“平台无人,体系有人”作战模式。无人机操控员在千里之外实现对目标的远程打击,他们在感官上与战场隔绝可能导致其行为与责任的分离。正如纽约大学法学系教授菲利普·阿斯顿(Philip Alston)所指出的:“作战人员通过计算机按键与远程视频反馈来实施打击,因此存在以游戏心态来杀人的风险。”(48)Philip Alston,“Study on Targeted Killings”,A/HRC/14/24/ADD.6,New York: United Nations,General Assembly,2010,p.25.可以预见,一旦真正意义上的自主武器系统大规模投入战场,人类将从瞄准和击杀的作战链条中被移除,这会从根本上改变人与战争、人与杀戮之间的关系,也将彻底打破正义战争理论所强调的“战争罪犯”与“战争罪行”之间的对应关系。美国亚利桑那州立大学的希瑟·罗夫(Heather Roff)和卡内基梅隆大学的大卫·丹克斯(David Danks)指出:“人类对于自主武器系统的信任源自于人类对其行动可预测性的判断。”(49)Heather M.Roff and David Danks,“‘Trust but Verify’: The Difficulty of Trusting Autonomous Weapons Systems”,Journal of Military Ethics,Vol.17,No.1,2018.如果自主武器系统错误的杀戮行为超出了人类可以预料的范围,人类就可能产生不需要对杀戮行为负责任的情绪,这种“问责空白”可能会导致更多的杀戮和痛苦。

(二)责任主体构成的复杂性带来的责任“转嫁”风险

自主武器系统的作战应用,不仅会造成机器难以代替人类承担战争责任的“问责空白”,而且可能导致战争责任的分配困境。传统战争模式下,责任主体构成相对简单,主要由政治家、军队指挥官和士兵等特定对象构成。自主武器系统研发链条的复杂性和高技术密集性,促使程序员、算法工程师、数据工程师以及自主武器装备生产商等新兴责任主体出现,自主武器系统研发过程的复杂性与作战应用过程的复杂性双重叠加,导致战争责任分配面临巨大的困境,甚至可能出现责任“转嫁”的风险。一方面,自主武器系统的所有国可以通过匿名攻击的方式,使得自主武器攻击难以溯源,导致被攻击国家的盲目猜测,进而逃避战争罪责。譬如,2010年发生的“震网”病毒攻击伊朗核电站事件以及2020年发生的伊朗核科学家遇刺事件,都是采取自主武器系统匿名攻击的方式,使得攻击者可以逃避战争责任的追究;另一方面,敌对国家也可以利用智能化作战平台对作战网络的高度依赖,采取电磁干扰、木马植入、黑客入侵等方式,操控其进行大量违背人道主义准则的军事行动,而将罪责转嫁给智能化作战平台的所有国。2011年,伊朗电子战专家成功俘获美军RQ-170“哨兵”无人机的案例,说明在自主武器领域,技术先发国家与后进国家一样,都可能面临战争责任“转嫁”的风险。

(三)军人存在感缺失导致的责任文化沦丧风险

当前,学界对于自主武器系统的战争责任正义研究,主要是从伦理规约的层面,探讨人工智能技术的军事应用给战争责任分配带来的挑战以及如何应对这种挑战。然而,在笔者看来,实现战争的责任正义,不仅要靠法律法规和伦理原则的约束,更需要将承担战争责任作为一种文化进行传承。正如美国五星上将道格拉斯·麦克阿瑟所述:“军人必须承担保护弱者和没有武装者的责任。这是他担任这个神圣职务的根本理由。”(50)转引自[美]迈克尔·沃尔泽《论战争》 ,任辉献等译,江苏人民出版社2008年版,第33-34页。军人作为一种社会尊崇的职业存在的道德基础,就在于军人以自我牺牲的精神替代平民承担更大的责任与风险。军人具有“保家卫国”“不怕牺牲”“英勇杀敌”等武德精神,正是责任文化传承的鲜明体现。一旦自主武器系统取代人类成为战争主体,战争将会进入“后英雄主义时代”,各类自主武器系统承担绝大部分的作战风险,战争中的军人被置于比平民还要安全的境地,他们将不再被期待具备过人的勇气和大无畏的精神,从而在无形中瓦解了确认军人职业身份的道义根基,也意味着军人“武德精神”的终结。

结 论

自主武器系统在军事领域的广泛应用,将军事智能化的广阔前景展现在世人面前,同时,也使得人类战争较之以往任何时刻都更为接近失控的边缘。这种由自主武器系统带来的失控风险,贯穿于开战、交战、战后的整个战争过程之中,体现为对战争伦理规约的颠覆性挑战。

在“开战正义”层面,自主武器系统所展现的巨大军事价值,导致“开战正义”伦理原则的弱化,进而降低了开战门槛并增加了爆发“意外战争”的可能性。首先,“正当理由”原则日益由抵御侵略的被动自卫弱化为主动先发制人的“预先防卫”。“无风险”“零伤亡”的自主武器系统攻击,促使少数霸权国家无视“开战正义”对于“正当理由”原则的严苛限制,导致“预先防卫”权利的滥用和预防性军事打击的频繁发生。其次,开战“合法权威”日益由主权国家的国家意志转向智能化自主武器系统的机器意志。人类依赖智能化作战指挥决策系统进行战争决策,从本质上来说就是一种基于技术信任的授权,将本应归属于主权国家的开战权利让渡给机器,导致国家意志可能被机器意志操控。再次,战争作为“最后手段”日益向“最优手段”转变。自主武器系统强化了技术先发国家在“反恐战争”和高技术局部战争中的优势,促使少数霸权国家将遥远的、不确定的军事威胁评估为确定的、迫在眉睫的战争前景,频频以自主武器攻击的方式逾越战争门槛,使全球安全与战略稳定性面临更加严峻的挑战。

在“交战正义”层面,自主武器系统取代人类成为战争主体,冲击了维系“交战正义”的“区分原则”和“相称性原则”。一方面,对于遵循“区分原则”而言,自主武器系统以计算机算法区分取代人力区分,彻底颠覆了传统的战场区分模式,同时也使得作战行动遵循“区分原则”面临新的挑战。自主武器系统的算法区分,只能利用军服、武器装备等明显的视觉标识来设置区分规则,从而造成一系列区分盲区。同时,基于计算机算法的区分模式将决定人类生命的权利交给冰冷的机器,导致人类对战场杀戮行为缺乏道德责任感。另一方面,对于遵循“相称性原则”而言,自主武器系统只能评估简单战场环境、物理毁伤方面以及短期战术层面的相称性问题,却难以评估涉及复杂战场环境、心理层面伤害以及长期战略层面的相称性问题,从而在本质上背离了“相称性原则”的道义要求。

在“战后正义”层面,非人化的自主武器系统难以替代人类成为承担战争责任的主体。首先,自主武器系统没有能力为自己的犯罪行为感到内疚,因此难以承担战争责任。自主武器系统的作战应用,导致战争责任主体日益呈现人机分离和责任主体多元化的发展趋势。承担战争责任作为维系人类“战后正义”的伦理规约,难以适用于一场自主武器系统作为责任主体的战争。自主武器系统在法律上不能够视为自然人,如果强行用约束人类战争行为的规范生搬硬套,必然会造成问责缺位的责任鸿沟,进而造成战争中犯错不受惩罚的文化在军队盛行,并可能导致战时行为的极端非人化。其次,即便理论上人类应当承担“杀手机器人”的罪责,然而真正实现责任到人仍然面临诸多瓶颈。机器人的罪行需要在设计者、生产者、管理者、使用者、监督者等诸多主体之间进行“责任分摊”,进而容易引发“责任扩散”,责任如何在诸多主体之间进行公正的分配也缺乏明确的标准,并且可能造成责任“转嫁”的风险。最后,一旦自主武器系统替代军人承担战争责任,也将在无形中瓦解社会对于军人职业身份认同的道德基础,甚至导致军人“武德精神”的消弭。