结合主题信息聚类编码的文本摘要模型

2021-01-19魏媛媛倪建成吴俊清

魏媛媛,倪建成,高 峰,吴俊清

(曲阜师范大学 软件学院,山东 济宁 272000)

0 引 言

在当今信息爆炸的时代,人们在享受数据共享便利的同时,也被越来越多的数据困扰,如何利用计算机技术帮助用户在最短的时间内了解最多最有用的信息成为一个研究热点,因此自动文本摘要技术应运而生。自动文本摘要是利用计算机按照某种规则自动地将文本或文本集转换成简短摘要的一种信息压缩技术。按应用技术的不同,可分为抽取式和生成式。抽取式文本摘要是利用计算机技术从原文中抽取出一些关键的词或句子,根据其重要程度组合成摘要;生成式摘要技术要求计算机对文本进行理解,将原文本的语义和内容进行压缩转述、总结为摘要,生成的词汇可能不属于源文本,其生成方式更接近于人类思维。近年来,深度神经网络在机器翻译、图像处理等领域不断发展且趋于成熟,自动文本摘要技术因此得到启发,借助于深度神经网络的生成式文本摘要技术上取得了突破性的进展。

综合当前研究发现抽取式摘要实现简单、主题不易偏离、适应性广,但其灵活性差且在语义理解方面考虑较少,无法建立文本段落中完整的语义信息。生成式文本摘要拥有更强理解和生成文本的能力,但存在信息编码不充分、摘要生成过程缺乏关键信息的控制和指导、摘要偏离主题等问题。针对这一系列的问题,该文将传统的抽取式文本摘要方法与基于深度学习的生成式文本摘要方法相结合,采用结合主题信息的方式来更好地辅助摘要的生成。本模型在哈尔滨工业大学深圳研究生院智能计算研究中心提供的大型中文短文本摘要数据集(LCSTS)[1]上进行实验,并在Rouge标准评价体系下对模型生成的摘要进行评估,实验结果表明本模型能够有效地提升摘要质量。

1 相关工作

1.1 传统的抽取式文本摘要

传统的抽取式文本摘要技术从20世纪50年代开始兴起,以统计学为支撑,依靠文章中的词频、位置等信息生成摘要。最为经典的摘要算法有基于统计的Lead-3算法、TextRank[2]算法和Padmakumar and Saran提出的以聚类的方式完成摘要。其中聚类生成摘要的方法是以句子为单位进行编码得到句向量,使用K均值聚类[3]与Mean-Shift聚类进行关键句聚类,将距离各质心最近的N个句子作为摘要。

1.2 生成式文本摘要

从2013年起,基于深度神经网络的生成式文本摘要研究兴起,机器翻译等领域的序列到序列(seq2seq)模型[4]被应用到文本摘要的研究中。最初摘要模型中的编码解码器均采用递归神经网络(RNN)[5],并起到了一定的作用。考虑到RNN不能处理长期依赖的问题,后期摘要模型改进大都采用RNN的变体,如基于长短时记忆网络(LSTM)或门控制循环单元(GRU)网络的编码器解码器模型。

1.3 注意力机制

基于seq2seq模型的生成式文本摘要基本模式是先将源句子编码成一个固定维度的向量C,然后通过解码器逐个字符解码生成目标句子。其中,编码到解码的信息是由中间语义向量C传递,过长的文本会导致模型编码过程中对文章信息的记忆损失,进而无法完全地表示整个序列的信息[6],因此Rush等人[7]将注意力机制引入到文本摘要模型,对句子的不同部分赋予不同的权重来生成目标序列。引入注意力机制的编码解码模型,使得生成新序列的准确度提高,解码端在生成新的目标序列时,可参照编码阶段的隐藏向量。

而后,Zhou等人[8]发现单纯引入注意力机制的seq2seq摘要模型中存在生成摘要与原文本的对应关系弱、摘要偏离主题等问题。

基于上述研究,该文构建了一种结合主题信息聚类编码的文本摘要生成模型。模型使用双向长短时记忆(Bi-LSTM)神经网络作为编码器,使用常规的长短时记忆(LSTM)网络作为解码器,在seq2seq模型的基础上引入主题信息对注意力机制的权重进行修正,通过对非关键词进行降权来生成包含段落/文档主题信息的语义向量表示,使生成的摘要更贴合主题。

2 结合主题信息聚类编码的文本摘要生成模型

结合主题信息聚类编码的文本摘要生成模型包含三大部分,编码层、解码层与修正注意力机制层。模型主要架构及图形说明如图1所示。

图1 结合主题注意力机制的编码解码模型

2.1 词嵌入层

对实验数据进行预处理,将数据预处理阶段得到的数据{wi|i=1,2,…,l}使用word2vec训练,得到其向量表示e(wi),将其作为模型输入。

2.2 编码层和解码层

模型使用双向长短时记忆神经网络(bidirectional long short-term memory networks,Bi-LSTM)作为编码器,依次从源文本接收每个单词的嵌入表示编码得到各时间步的隐藏层向量hi,以计算注意力矩阵Wa和上下文信息Ct。

图2 编码层结构

(1)

(2)

(3)

(4)

st=LSTM(e(yt-1),st-1,Ct)

(5)

当解码出时,停止解码。解码层结构如图3所示。

图3 解码层结构

2.3 结合主题信息的注意力机制

为使生成的语义编码Ct包含确切的主题信息,该文将主题信息引入到模型中,计算输入层隐藏状态向量hi的主题相关性大小。模型中注意力矩阵Wa由Bahdanua注意力[9]权重矩阵Wa'与主题权重矩阵Wa''计算得到。

2.3.1 Bahdanua注意力机制

(6)

eit=a(st-1,hi)

(7)

其中,st-1为解码器第t-1时刻的隐藏向量,Wa为引入主题信息修正后得到的权重矩阵。

2.3.2 主题信息聚类编码

主题注意力机制的关键思想是通过加强关键词对生成句子、文档表示过程的影响,来降低生成摘要偏离主题的概率。计算模型输入与主题信息kj,j=(1,N)的相关性得到主题权重矩阵Wa'',将主题信息联合注意力机制纳入到模型中,对非关键信息降权,定位于主题相关的输入,生成上下文信息Ct。

高度凝练文本的主题,快速获取文本的核心内容,首先需要对输入数据进行关键信息提取。聚类是发现数据内在关联结构的一种技术,该文利用词向量聚类[10]的方式,根据词向量之间的相似度进行主题信息聚类,将文本中的词作为一个节点,模型对输入数据编码后得到隐藏向量hi,使用K均值聚类计算输入文本的质心[11],质心对应的向量为该输入文本的主题信息。具体步骤如下:

(1)预训练期间,利用Stanford corenlp对数据分句分词处理,通过word2Vec得到其向量表示si=(e(wi1),e(wi2),…,e(wim)),其中m为句子中的词语数,i为句子数i=[1,n]。

(2)实验将单个文本D作为聚类对象,进行词向量聚类,根据文本中词向量之间的相似度聚为若干簇,使用K均值聚类计算输入文本的质心。考虑到实验数据集给定的摘要对长度大小,实验设置主题聚类的类别N=5。将得到的质心K={k1,k2,…,k5}对应的向量为该输入文本的主题信息,代表句子的整体表达方向。

文本向量间的相关性可通过向量夹角的余弦值表示,模型将余弦相似度[12]作为主题相关性度量方式,将输入文本与主题信息K在词向量空间中的余弦相似度值作为该输入的主题相关性权重。利用余弦相似度将输入词的隐层向量与主题信息kj,j=[1,5]进行相似度计算,取其平均值作为该输入词的临时权重,即:

(8)

(9)

(10)

3 实 验

3.1 实验数据

模型在LCSTS数据集上进行实验,该数据集是从新浪微博中爬取过滤得到的,已被广泛应用于文档摘要。数据集为人工标记过的短文本-摘要对,得分范围为1到5,得分高低代表短文本与相应摘要之间的相关性大小。数据集可分三部分,第一部分有2 400 591对短文本-摘要数据;第二部分有10 666对,是从第一部分中随机抽取得到的;第三部分有1 106对,这部分数据不包含在第一部分和第二部分中。

本实验遵循Hu[1]实验中的数据集设置,选用第一部分的数据作为训练集,第三部分的3分以上数据作为测试集,第二部分的3分以上数据作为验证集。

3.2 实验设置

在数据预处理阶段,词之间用空格隔开,将实验数据转化为模型可理解的形式,并加入四种字符,其中

实验使用ROUGE工具包进行模型评估,该方法是当前使用最广泛的摘要评价标准。考虑到本实验的摘要类型,选用ROUGE-N和ROUGE-L进行摘要效果评价。ROUGE-N是一种面向n元词召回率的评价方法,是由一系列的评价方法组成,根据该文的研究内容选取其中的ROUGE-1和ROUGE-2作为评价标准。Rouge-L则考虑参考摘要与模型生成摘要的最长公共子序列的匹配度。

3.3 实验结果及分析

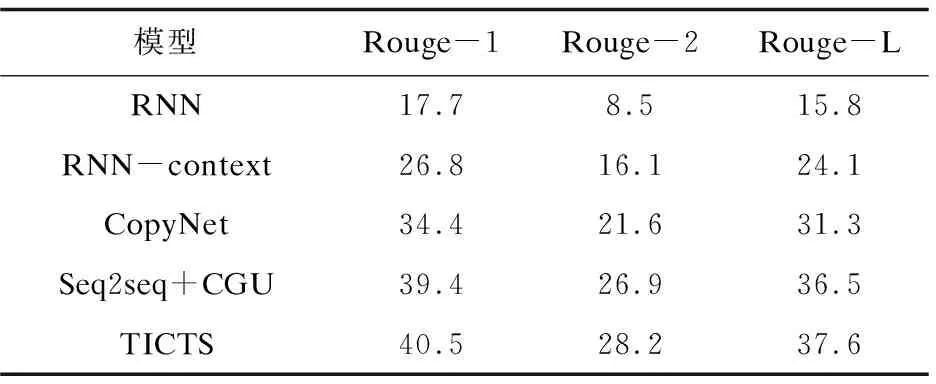

实验详情如表1所示,其中:

RNN和RNN-context是Hu等提出的基于RNN的seq2seq模型,其中RNN为未引入注意机制,使用编码器的最后一个隐藏向量作为解码器的输入的seq2seq模型。RNN-context为在RNN的基础上引入注意机制将所有的隐藏状态相结合作为解码器的输入,两组模型均采用GRU网络。

CopyNet[14]是基于注意力具有拷贝模式的seq2seq模型,将传统的生成模式和拷贝模式混合起来构建了新的模型。

Seq2seq+CGU是Lin等[13]提出的带卷积门控单元(CGU)的seq2seq模型。

TICTS为文中模型,引入主题信息对编码阶段的注意力机制进行权重修正,编码端采用Bi-LSTM网络,解码端采用LSTM网络。

表1中的结果为ROUGE-1、ROUGE-2与ROUGE-L的Average-F分数,从表中可看出该模型在ROUGE评价指标上的得分均优于其他对比模型,表明引入主题注意力机制可提高文档摘要性能,生成的摘要与参考摘要的相似程度更高。结合主题注意力机制的seq2seq模型在生成中间语义向量时对输入数据进行主题相关性加权求和,弥补了编码时主题信息不足的问题,实验说明增加主题信息含量能够有效提高摘要效果,更贴近参考摘要。

表1 实验结果

表2为模型摘要样例,从表中可以看出,本模型生成的摘要对原文信息进行了较为完整的关键信息提取,主题信息表述完整,摘要质量更高,使得摘要内容更加丰富。

表2 模型摘要样例

4 结束语

通过生成式文本摘要任务的学习与研究,针对当前文本摘要生成模型中存在的上下文语义信息利用不充分、主题相关度不高等问题,将生成式文本摘要和传统的抽取式文本摘要方法的各自优势相结合,提出一种结合主题信息聚类编码的文本摘要生成模型,通过融合主题信息以提高模型生成摘要的主题相关性,实验在一定程度上优于基线模型。但模型仍存在改进空间,如在今后的工作中可采用BERT[14]对词向量进行预训练,增强对文本信息的编码[15-18]利用以生成更好的摘要;解码部分可结合拷贝机制[19]以解决摘要生成过程存在的未登录词问题。