基于AlexNet的注意力机制网络研究

2021-01-15任楚岚孙佳楠张阳

◆任楚岚 孙佳楠 张阳

基于AlexNet的注意力机制网络研究

◆任楚岚1孙佳楠1张阳2

(1.沈阳化工大学计算机科学与技术学院 辽宁 110142;2.辽宁中医药大学附属医院 辽宁 110032)

本文采用引入人类视觉系统的注意力机制对AlexNet网络模型进行改进,通过融入注意力机制对AlexNet注意力机制网络进行研究,并通过CIFAR-10数据集进行实验对比验证。实验对比结果表明,AlexNet注意力机制网络模型比传统AlexNet网络模型具有更好的分类效果,其分类准确率提升了2%。

深度学习;注意力机制;卷积神经网络

自2006年起,深度学习因其强大的自动提取特征能力、复杂模型构建能力和图像处理能力出现在了人们的视野之中。它是一种使用多层复杂结构或由多重非线性变换构成的多个处理层进行数据处理的方法[1]。近年来,深度学习方法由于其在数据分析处理上的特点已经被广泛应用于各种领域,尤其是在语音识别[2-3]、图像识别[4-5]等领域已经取得了突破性进展。

深度学习作为机器学习中一种较好的方法,是机器学习的重要组成部分。它主要在于建立一个模拟人类脑部进行分析学习的神经网络,用以模仿人脑的机制来解释和分析数据,例如图像,文本和声音等。本文将选用AlexNet网络模型对已有数据进行基础训练,并融入了注意力学习机制,通过对原有模型的改进,提高其准确率。

1 基本概念

1.1 卷积神经网络

随着深度学习技术的快速发展,特别是卷积神经网络(convolutional neural network,CNN)技术在图像处理和自然语言处理等领域取得了显著成效,越来越多的领域都开始尝试使用卷积神经网络技术来解决问题。卷积神经网络是一种多层次的网络模型,是神经认知机的推广形式。

卷积神经网络的历史可以追溯到20世纪60年代,由于Hubel和Wiesel[6]通过对猫脑视觉皮层的研究,发现了一系列复杂的“感受野”,其只受某些特定区域刺激的响应,接受局部信息,继而提出了卷积神经网络的概念。CNN是对BP神经网络的一种改进,虽然它们都是采用前向传播输出计算值,利用反向传播调整权重和偏置。但CNN在层与层之间采用局部连接,而BP神经网络采用的是全连接。卷积神经网络有一个输入层,每一层都接收上一层的输入,直到输出,其基本结构主要是由输入层、卷积层、池化层(也称为降采样层)、全连接层以及输出层构成[7]。

卷积层作为输入层后的第一层,旨在提取输入的特征表示。卷积层是由多个特征图组成,每个特征图由多个神经元组成,每个神经元通过卷积核与上一层特征图的局部区域相连。卷积核是一个带权值的矩阵,用于提取和计算不同的特征映射。卷积所得的输出可由如下公式表示:

yj=∑iwij*xi+bj(1)

式中:Xi为输入特征图,Yi为输出特征图,权值记为Wij,bi是其偏置参数。

池化层(降采样层)是在卷积层之后,旨在通过降低特征映射的分辨率(降维和抽象)来实现移位不变性。池化层同样由多个特征图组成,它的每个特征图唯一对应于其前一个卷积层相应的特征图,且不会改变特征图的个数。常用的池化方法有最大池化和平均池化。最大池化是把区块中元素的最大值作为函数的输出,提取特征平面的局部最大响应。平均池化是将计算得到的区块中所有元素的算术平均值作为函数的输出,提取特征平面局部响应的均值。

在经过多次卷积层和池化层后,卷积神经网络通常会连接一个或者多个全连接层[8]。全连接层将当前层的每个神经元与其前一层中的所有神经元相连接,以产生全局语义信息。全连接层可以整合卷积层或池化层中具有类别区分性的局部信息。为了提升整个网络的性能,每个神经元的激励函数一般采用ReLU函数。卷积神经网络的最后一层是输出层。对于分类问题而言,经常会使用softmax函数进行逻辑回归分类,返回输入图片所属某一类别的概率;对于回归问题,会返回具体的数值。

1.2 注意力机制

注意力机制的概念主要源于模仿人视觉的注意力形式。人脑在接收外界信息时,并不会处理所有信息,而是只关注重要的信息,这有助于过滤干扰信息,提高信息处理效率[9]。在人视觉感知中,由于处理整个视野的能力有限,人们通常将注意力集中在特定区域,以关注需要的信息。然后,将此信息用于指导下一个聚焦点[10-11]。受人视觉系统始终专注于视觉数据某一部分的启发,人们进行了许多尝试,包括图像分类和生成、唇读和语义分割等[12]。

2 实验

2.1 数据集

本文数据集采用的是国际认可的标准数据集CIFAR-10。该数据集包括飞机、汽车、鸟类、猫、鹿、狗、蛙类、马、船和卡车这十大类现实世界中的真实物体。该数据集共有60000张彩色图像,这些图像是32*32的,共分为10个类,每类6000张图。这里面有50000张用于训练,构成了5个训练批,每一批10000张图;另外10000张用于测试,单独构成一批。测试批的数据里,取自10类中的每一类,每一类随机取1000张。抽剩下的就随机排列组成了训练批。

2.2 传统AlexNet网络与实验

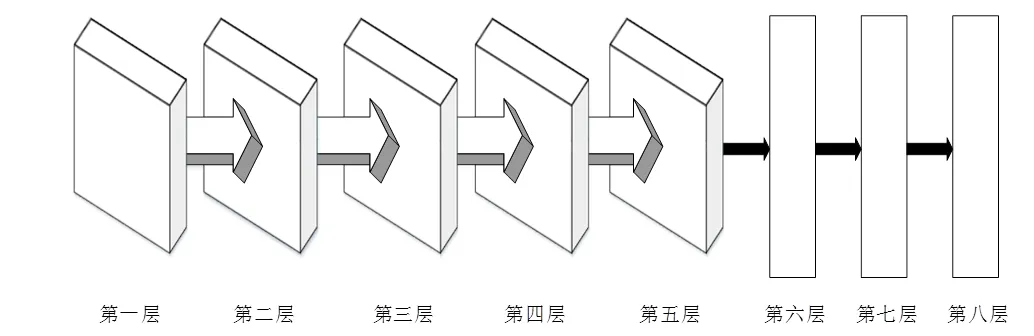

AlexNet是由Alex Krizhevsky等人[13]在2012年的ImageNet比赛中使用并命名的,由于其优秀的图像识别能力,将正确识别率提高了一倍有余,成功夺得了那年的冠军并再次引起了人工智能和深度学习的热潮。本次实验以AlexNet作为原始的网络模型进行训练测试。AlexNet拥有8层结构,在图片识别上具有出色的效果,其具体的网络结构如图1所示。

图1 AlexNet网络结构图

AlexNet网络模型的第一层到第五层结构是卷积神经网络,第六层到第八层为传统神经网络。第一、二层的结构相似,都使用了卷积、ReLU、池化、归一化操作。第三层和第四层的结构类似,使用了卷积和ReLU操作。第五层与三、四层相比,多了池化操作,分别为卷积、ReLU和池化。再将前五层操作后的结果传递到传统神经网络中,在最后的三层均使用全连接网络结构。

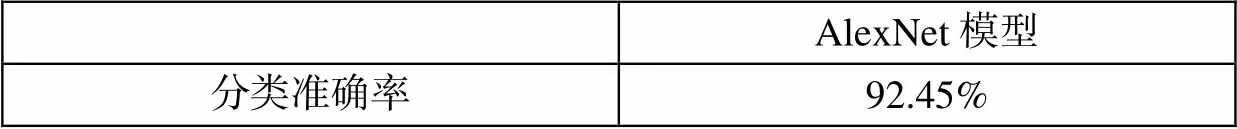

使用AlexNet网络模型对已有数据进行的分类结果如下表1所示。

表1 AlexNet网络模型的分类结果

2.3 基于AlexNet网络的改进和实验

对于数据图像的分类识别问题,图片中往往存在着无效信息,如何摒弃这些无效信息,关注特定的信息,是提高网络模型分类效率和分类准确率的关键。因此,为了对AlexNet网络模型进一步探讨,本文引入了注意力机制的概念,在传统AlexNet网络模型的基础上,增加了注意力层,将其融入AlexNet网络模型结构中,成为AlexNet注意力机制网络模型。其具体的网络结构如图2所示。

图2 AlexNet注意力机制网络结构图

与传统的AlexNet网络模型相比较,AlexNet注意力机制网络模型在输入层和第一层之间加入了一层注意力层。使用AlexNet注意力机制网络模型对已有数据进行的分类结果如下表2所示。

表2 AlexNet注意力机制网络模型的分类结果

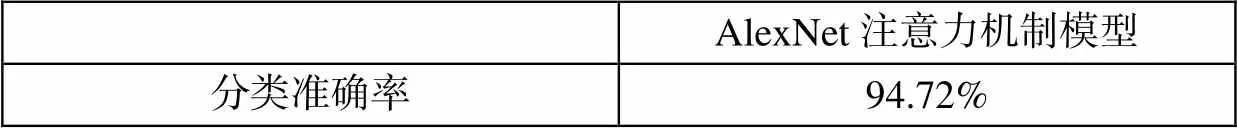

2.4 实验结果对比

两种网络模型的实验分类结果对比如下表3所示。

表3 两种网络模型的实验分类结果对比

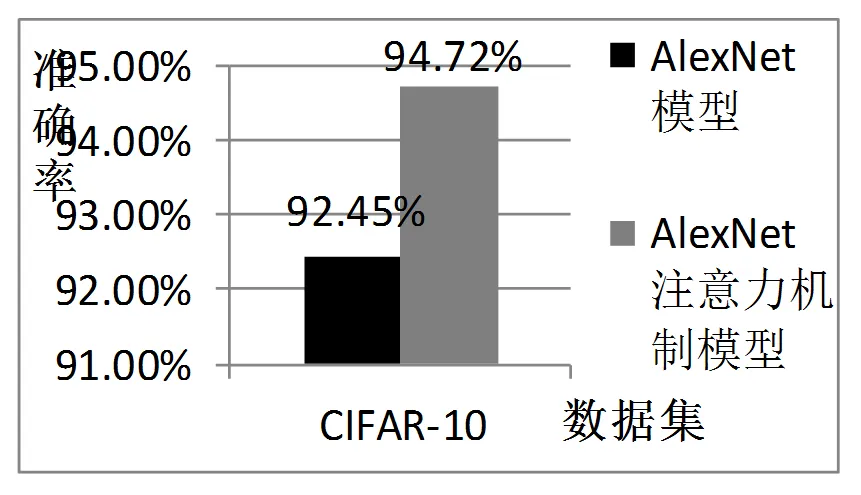

两种网络模型的准确率对比图如图3所示。

图3 两种网络模型的准确率对比图

通过实验结果对比可以看出,融入注意力机制的AlexNet网络模型比传统的AlexNet网络模型的准确率有了明显的提高。

3 结语

本文通过引入注意力机制,对基于AlexNet的注意力机制网络进行了研究。通过融入注意力机制的AlexNet网络模型与传统的AlexNet网络模型的实验对比表明,改进后的网络模型具有更高的分类准确率,为卷积神经网络进一步的研究提供了可能。

[1]Schmidhuber,Jürgen. Deep Learning in Neural Networks:An Overview[J]. Neural Netw,2015,61:85-117.

[2]Hinton G,Deng L,Yu D,et al. Deep neural networks for acoustic modeling in speech recognition:the shared views of four research groups. IEEE Signal Processing Magazine,2012, 29(6):82-97

[3]Mikolov T,Deoras A,Povey D,et al. Strategies for training large scale neural network language models. 2011 IEEE Workshop on Automatic Speech Recognition and Understanding (ASRU),2011:196-201

[4]Farabet C,Couprie C,Najman L,et al. Learning hierarchical features for scene labeling. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(8): 1915-1929

[5]Krizhevsky A,Sutskever I,Hinton G E. Imagenet classification with deep convolutional neural networks. Advances in Neural Information Processing Systems,2012:1097-1105

[6]Hubel D H,Wiesel T N . Receptive fields,binocular interaction and functional architecture in the cat"s visual cortex[J]. The Journal of Physiology,1962,160(1):106-154.

[7]陈超,齐峰.卷积神经网络的发展及其在计算机视觉领域中的应用综述[J].计算机科学,2019,46(03):63-73.

[8]刘方园,王水花,张煜东.深度置信网络模型及应用研究综述[J].计算机工程与应用,2018,54(01):11-18+47.

[9]Leng J,Liu Y,Chen S . Context-Aware Attention Network for Image Recognition[J]. Neural Computing and Applications,2019(4).

[10]Xiong,C.,Shi,X., Gao,Z.et al.Attention augmented multi-scale network for single image super-resolution. Appl Intell (2020).

[11]Zhu Y,Liu G . Fine-grained action recognition using multi-view attentions[J]. The Visual Computer,2019(12).

[12]Emami H,Aliabadi M M,Dong M,et al. SPA-GAN:Spatial Attention GAN for Image-to-Image Translation[J]. 2019.

[13]Krizhevsky A,Sutskever I,Hinton G .ImageNet Classification with Deep Convolutional Neural Networks[J]. Advances in neural information processing systems,2012,25(2).