模态自适应权值学习机制下的多光谱行人检测网络

2021-01-12陈莹,朱宇

陈 莹,朱 宇

(江南大学 轻工过程先进控制教育部重点实验室,江苏 无锡214122)

1 引 言

行人检测是自动驾驶、智能视频监控等领域的核心技术,要求能适应全天候及各种场景的变换。传统行人检测的输入源是可见光模态,可见光图像在光照充足的情况下,能提供丰富的视觉信息,一旦环境改变,提供的视觉信息会非常有限,所以传统的行人检测极易受到不良光照及恶劣天气的影响。为了解决这一问题,一种能同时应用红外和可见光两种模态信息的多光谱行人检测技术应运而生。红外模态作为多光谱行人检测的另一输入源,其使用红外成像技术提供的红外图片在黑暗条件下可以较好地显示出人体,弥补可见光模态的不足,但通常在光照较好时,其表现力不如可见光图片,因此这种动态变化要求检测过程中能够有效地融合利用多模态信息。

近年来,针对多光谱行人检测中的多模态信息融合问题,文献[1]研究了卷积神经网络不同融合时期(前期,中间,后期)以及同一融合方法直接堆叠对实验结果的影响,得出利用中间层特征直接堆叠策略可以最大限度地整合红外和可见光信息。Konig 等[2]使用Faster R-CNN 框架[3]中的区域建议生成网络和随机森林算法协同完成检测,采用文献[1]的融合方式,但在后续训练中同时使用到融合后的特征层以及原始双流的两模态特征层。文献[4]采用一种新型无监督行人检测方式,在特征融合部分沿用特征堆叠策略。Song 等[5]将像素级图像融合与基于卷积神经网络的行人检测算法结合。然而这几种算法均未能关注到每种模态对检测任务的贡献不同,无法有效地适应环境的动态变化。Lee 等[6]考虑到上述算法[1-2,4]中特征堆叠策略的不足,在特征融合时加入特征关联层,但侧重的是对模态特征进行特征加强,未充分考虑模态与模态之间的关系,文献[7-8]考虑到不同光照条件下每种模态融合的权重不同,设计了一个光照感知网络,模拟白天黑夜照明情况,但结果的优劣过于依赖光照感知网络。

针对上述问题,本文提出了一个基于多模态自适应权值学习融合机制的行人检测网络。首先将两种模态的图片送入双流多光谱行人检测框架中,再分别从两流提取特征送入自适应权值学习融合网络中,网络根据每种模态的贡献差异,学习到每流特征的权值,因此两流特征加权融合得到融合特征,然后在融合特征的基础上生成新的特征金字塔,同时为减少行人负样本数量,采用了一种丰富行人先验信息的策略,完成行人检测任务。

2 基于多光谱信息融合的行人检测

2.1 问题分析

在多光谱行人检测中,红外和可见光两种模态表现出来的特征不同[9]。可以为行人检测提供互补的信息。因此多光谱信息的融合方式尤为重 要 ,目 前 有 直 接 堆 叠 策 略[1-2,4],特 征 关 联 策略[6]等。

直接堆叠策略直接在输入时或在训练过程中选定某一层对两模态做通道堆叠,即两模态之间按1:1 的权重进行融合,未考虑不同模态对任务的不同影响,易丢失有效特征信息[10],影响检测性能。特征关联策略提取某一层双流特征并相乘,将相乘后的特征再与原始特征堆叠作为融合特征。该策略虽然对特征信息进行了加强,也考虑到模态之间的交互性,但还是未完全考虑到两模态在不同场景下对任务的贡献比重不同,同时在融合时这两种策略均只是选择了某一特定层,而忽视了剩余特征层的重要性。

图1 红外和可见光图像对Fig. 1 Infrared and visible image pairs

如图1 所示,第一列和第二列分别是可见光和红外图片,每一行的图片均是在同一场景和时刻拍摄的,图中用绿框标出了同一目标在两张图像上的差异(彩图见期刊电子版)。当光照充足,四周无遮挡时,可见光图像(a)上的行人显示得较为完整,而对应红外图像(b)上目标却不能被分辨出来。同样在白天,可见光图像(c)上的目标由于被树荫遮挡,无法显示出完整的人形,而红外图像(d)能区分出行人和背景。由此可见,不同情况下,检测网络对两模态的依赖程度存在着较大差异,因此需要一种融合策略能自适应环境改变,根据检测任务学习两个模态的差异性,从而为两个模态分配相应权重。

2.2 网络框架

结合以上问题,以及多光谱行人检测是目标检测中的一个特殊任务,需要针对其在输入的多源性以及检测行人任务的单一性两方面搭建合适的基础框架。本文选用Li 等[11]提出的FSSD(Feature Fusion Single shot Multibox Detector)框架作为检测的基础框架,并将其扩展为双流。FSSD 级联原始检测器SSD[12]中不同尺度的特征层,以融合高层语义信息和低层细节信息,这是因为SSD 对于高分辨率的低层特征没有再利用[13],而这些层对于检测类似行人这样的小目标很重要,这也是本文算法选择FSSD 的主要原因。

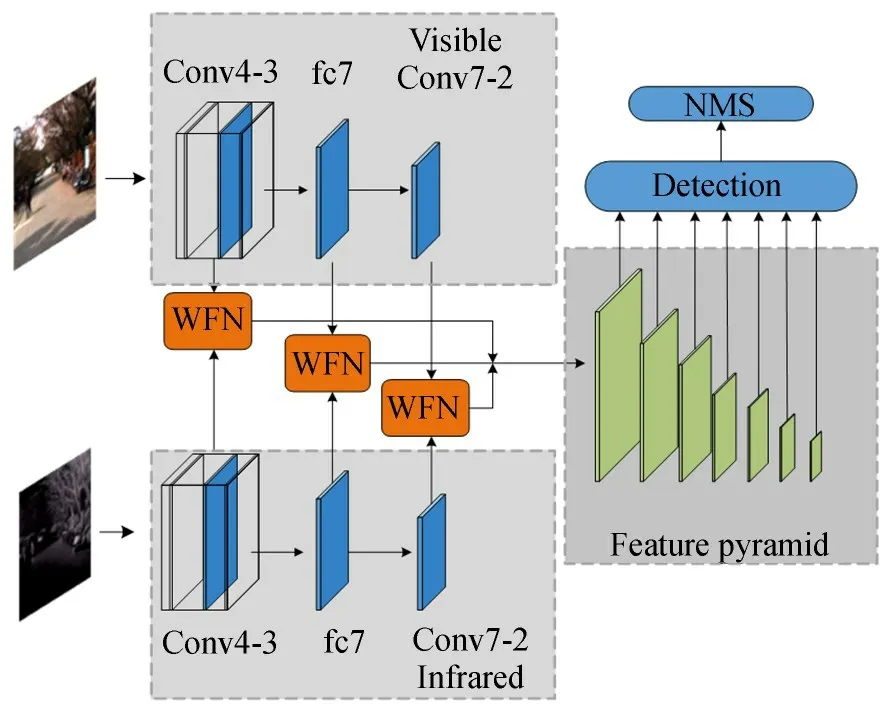

网络框架如图2 所示,512×512,对齐的可见光和红外图片先经过前向传播的两分支网络提取特征,再将特征送入权值学习融合网络(Weight-learning Fusion Network,WFN)完成加权融合,然后利用融合特征生成特征金字塔用于行人的分类和回归,最终的检测结果会经过非极大 值 抑 制(Non-Maximum Suppression,NMS)层。下面介绍网络的组成。

图2 多光谱行人检测框架Fig. 2 Multispectral pedestrian detection network framework

2.2.1 可见光和红外分支

红外分支与可见光分支的网络结构完全相同,均是以在ImageNet 上预训练的VGG16 网络为基础网络。在特征提取阶段,文献[11]中提出尺寸小于10×10 的特征层可提供的信息较少,因此本文选取VGG16 网络的conv4-3 和fc7 特征层,两层尺寸分别为64×64,38×38,并添加了19×19 的conv7-2 层,得到可见光分支的三个特征 :f1,f2,f3,及 对 应 的 红 外 分 支 的 三 个 特

2.2.2 模态融合部分

模态融合主要利用WFN 完成模态的加权融合,本文将在2. 3 节介绍WFN 模块。该部分首先将提取得到的三组对应特征送入WFN,进行模态加权融合,得到加权融合后的三个高低层特征F1,F2,F3,并对三个特征进行尺寸归一化,即先利用1×1 的卷积核对三个特征进行通道降维,再使用双线性插值法将尺寸归一化为64×64,最后级联这三个特征得到特征Fc。具体操作如式(1)~式(2)所示,其中i表示层数,i= 1,2,3,ΦW表示经过WFN 完成的加权融合操作,ΦC表示级联操作,Γi指对特征的尺寸归一化操作。

2.2.3 特征金字塔

特征金字塔部分用于完成行人目标的分类以及检测框的定位和回归。与原始FSSD 不同,本文算法是对两模态融合后的融合特征Fc,而不是对单一流的特征操作,以获得更多模态之间的交互信息。具体操作是采用下采样方法,即利用7 组3×3 的卷积核和relu 的组合操作实现,生成图1 右侧的特征金字塔。

2.3 自适应加权融合网络

针对2. 1 节提出的问题,受文献[14]中RGB图与深度图融合方法的启发,本文在双流检测网络中对双流融合机制进行设计,提出自适应权值学习融合网络。该网络可以自适应关注两个模态的重要信息,从而学习并分配权重,强化对重要信息的学习。 本文对从两个分支对应的conv4-3,fc7,conv7-2 层提取到的三组特征对都嵌入了WFN 模块,以充分利用每一层的特征。第三部分的实验证明了选取该融合时机的有效性。

图3 权值学习融合网络Fig. 3 Weight-learning fusion network

网络框架如图3 所示,图中左侧第一个框是直接堆叠方法,即级联融合,网络输入为尺寸相同 的 可 见光 和 红 外特 征fi和fi′(i表 示 层 数,i=1,2,3),级联融合是做简单的通道堆叠操作,从而得到通道堆叠后的特征Sfi,在直接堆叠融合算法中,之后的训练直接应用特征Sfi。本文则是对特征Sfi进行加权操作,得到一组权重矩阵,然后分别与原始特征相乘,得到分别加权后的两个特征,再级联得到最终加权融合后的特征Fi。该网络主要由以下两个部分组成。

2.3.1 加权部分

该部分由3×3 卷积和sigmoid 激活函数组合完成加权操作。其中3×3 的卷积操作是为了在分离特征Sfi时,进一步加深特征的深度。分离出的两组特征再经过sigmoid 激活函数得到对应权重矩阵wi,w′i,如式(3)~式(4)所示。其中C1,C2表示卷积核的权重,b1,b2表示卷积核的偏差,

sigmoid 函数输出在(0,1)之间,输出范围有限,优化稳定。两个权重矩阵wi,w′i各自代表了每个模态对网络的贡献。当光照充足,可见光模态对网络的贡献较大,相应wi就越接近于1,wi′则接近0;相反,当网络更依赖红外模态时,wi′ 接近1,wi则接近0,且wi,wi′ 是由网络自主学习得来,可以自适应外界环境的动态变化。将获得的权重矩阵与原始特征相乘,那么加权后的两个特征就分别代表了模态最优特征。

2.3.2 级联部分

自适应加权融合网络中有两个部分应用到了级联(concat),第一次是将输入的一组特征fi,fi′级联。第二次是将加权后的特征级联,并使用1×1 的卷积核降维,得到加权融合后的特征Fi。

2.4 丰富行人先验信息

FSSD 是单阶段的检测算法[15],没有双阶段目标检测器Faster-RCNN 的候选区域生成阶段[16],而是采用了先验框(Prior boxes)机制预设不同大小的先验框。FSSD 设置了五种不同宽高比的先验框,以检测出不同大小的各种目标。但是行人检测只有行人一个目标,不同宽高比的先验框不仅增加了网络的计算量,还给行人目标的检测带来了干扰信息。

如图4 所示本文统计了kaist 多光谱行人数据集[17]中训练集的行人实例的宽高比,由此在本文中将宽高比简化成0. 41。同时因为我们在网络训练过程中只采用行人实例高度大于50 的图片,所以针对先验框的尺寸也进行了重新设置,并为了应对行人拥挤的场景,在水平方向增加先验框的密集度,如图5 右所示(图5 左是原始先验框设置)。

图4 宽高比统计Fig. 4 Statistics of aspect ratio

图5 先验框设置Fig. 5 Prior boxes settings

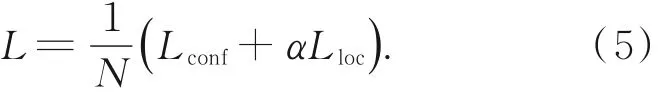

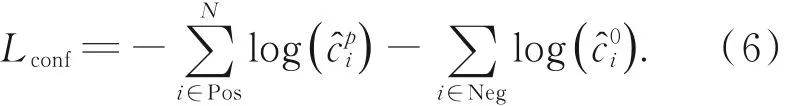

2.5 损失函数和优化方法

网络的损失函数是位置和分类损失的加权和,如式(5)所示。 其中,N是匹配的先验框数量,α是两损失的加权值,本文使用文献[12]中的默认设置,将α设为1。

分类损失如式(6)所示是softmax 损失。指网络输出的第i个样本框为p类的置信度其中t=1 时代表分类为行人,t=0时则为背景。

位置损失如式(7)所示是正样本(i∈pos)的真实框g和预测框l偏移量的smooth-L1 损失,(cx,cy)是框的中心点坐标,w,h分别是框的宽和高。是第i个预测框和第j个标注框的偏移量的定义如式(8)所示,其中d是先验框。

本文采用随机梯度下降算法,以提高训练速度,加快网络学习进程。

3 实验结果与分析

3.1 实验配置

本文提出的算法是在深度学习框架Pytorch下完成的,实验所使用环境Ubuntu14. 0,CUDA8. 0. 61,python3. 6,硬件配置为TITAN XP。网络的初始学习率为0. 000 5,冲量为0. 9,权重衰减项为0. 000 5。

3.2 数据集与评价指标

本实验使用的公开数据集是kaist 多光谱数据集,该数据集是目前为止国内外最大型,且能提供成对配准标注的红外和可见光图像的多光谱行人检测数据集,包含95 328 对,103 128 个密集标注的,交通场景下的红外可见光图像对,且图像尺寸均为640×512。为与其他算法[4-9,18]保持数据一致性,本文沿用文献[1]的处理方式:在训练集中去除严重遮挡以及行人高度<50 的行人实例,得到最终用于训练的7 904 张训练图片。测试集使用原数据集划分的2 252 张图片,包含白天和夜晚拍摄的图片。

网络训练时为了维持正负样本的平衡,正负样本比例设置为1∶3,并为了增强网络的泛化能力,采用了数据增广策略。

实验计算对数空间下[10-2,100]的平均漏检率(Log-average Miss Rate,MR)来比较算法性能。MR 值越小,则算法性能越优。同时在空间对数坐标下绘制的missrate-FPPI 曲线图[19]也用来评估算法的性能,该曲线图横坐标是平均每张图片中负样本被检测为正样本的数量(False Positives Per Image,FPPI),纵坐标是指在实际为正的样本中,未被正确检测出来的概率,即漏检率(Miss Rate)。 曲线越低,代表的算法性能越优。

3.3 消融实验

3.3.1 多模态信息的重要性及互补性

本部分比较了单支可见光,红外以及双支多模态网络的性能。表1 是三种网络在白天,夜晚及全天的检测性能,其中多模态网络整体获得了26. 96% 的MR 值,分别比只使用可见光模态和红外模态的单流网络减少了12. 91% 和11. 28%,可以发现利用多模态信息的双流检测网络的检测性能更优。

对比表1 的两个单模态网络在白天黑夜的MR 值大小以及图6~图7 的missrate-FPPI 曲线(蓝色代表红外分支,紫色代表可见光分支,彩图见期刊电子版)的高低,可以看出,在白天,单支可见光比单支红外网络性能更优;而在夜晚的大部分场景下,单支红外比单支可见光网络性能更优,验证了两模态的互补性。

表1 不同模态的MR 值Tab. 1 MR values of different modals (%)

图8 是在kaist 数据集上的检测实例(彩图见期刊电子版)。(红色框代表真实标注框,绿色框代表网络输出的检测框,从左到右分别为(a)原始标注,(b)单支可见光模态,(c)单支红外模态,(d)双支多模态以及(e)Fusion-RPN[2]。 关于与Fusion-RPN 算法的比较将在3. 4 节介绍)相邻的两行是同一组可见光和红外图片,第一组是在夜晚拍摄,第二组和第三组均为白天拍摄。由几组图片可以看出,单独使用某一分支网络只能在白天或黑夜一种情况下性能更优,并不能适应环境变化,双支多模态网络明显性能更优化稳定,进一步验证了上文的结论,佐证了多模态自适应融合实验的可行性。

图6 两分支在白天的检测结果Fig. 6 Detection results of the two branches during the day

图7 两分支在夜晚的检测结果Fig. 7 Detection results of the two branches during the night

3.3.2 多模态融合实验

两模态的正确融合可以大幅度提升检测性能,然而两模态正确融合的关键就是如何融合和何时融合。针对这两个关键问题,本文做了如下两组实验。

3.3.2.1 选取融合时机

本文为了更有效地融合多光谱信息,更好地发挥WFN 模块的优势。本部分研究了两种不同时机嵌入WFN 模块的方案。图9 表示(a),(b)两种嵌入WFN 模块的策略。

融合时机(a):先逐层加权自适应融合,再对融合后的三个特征进行高低层级联,获得最终的用于生成特征金字塔的融合特征。

图8 检测实例Fig. 8 Detection examples

融合时机(b):先在每一单独分支对三层特征进行高低层级联,再对分别来自两流的高低层级联特征做加权自适应融合操作,获得最终的用于生成特征金字塔的融合特征。

本文选择融合方式(a),是因为逐层融合可以充分利用每一层的特征信息,让网络充分学习更多两模态之间的信息,相较融合方式(b),减少了特征信息丢失的可能性。表2 是两种方式在Kaist 数据集上的MR 值,本文选择的融合方式(a)的MR 值比融合方式(b)低了1. 09%,图10(ours 和fusion b)也展示了两种方式的missrate-FPPI 曲线图,显然,融 合 方 式(a)的性能较优。

3.3.2.2 选取融合方法

本文通过实验比较了直接堆叠和自适应权值学习两种融合方法的优劣,实验结果如表3 和图10(ours 和stack)所示,显然,采用自适应权值学习融合方式可以显著提高网络性能。

图9 两种融合时机Fig. 9 Two fusion stages

表2 不同融合时机的MR 值Tab. 2 MR values of different fusion stages

3.4 算法的整体性能

为验证算法的先进性,将本文算法与当前先进 算 法ACF+T+THOG[17],Fusion-RPN[2],YOLO-TGB[18],DSSD-HC[6],TS-RPN[4]在Kaist数据集上进行了MR 值的比较,结果如表4 所示。可以看出本文提出的算法MR 值为26. 96% 与当前最优方法Fusion-RPN(29. 73%)相比,降低了2. 77%,与baseline 算法相比分别降低了27. 84%,与最新的三种算法相比分别降低了4. 24%,7. 36%,3. 7%。

表4 不同方法在Kaist 数据集上的MR 值Tab. 4 MR values of different methods on the Kaist dataset

为了进一步验证本文算法的领先性,如图10所示,挑选了当前采用直接堆叠策略的最优算法Fusion-RPN,和ACF+T+THOG(baseline)两种算法绘制missrate-FPPI 曲线图,由图10 可以看出,本文提出的算法(ours)曲线是明显低于另两种算法的。同时图8 也对比了本文算法(d)和Fusion-RPN 算法(e)在kaist 数据集上的检测实例。观察两个算法在第一组和第二组图片上的检测结果,可以发现本文算法不仅能框出更多使用直接堆叠的Fusion-RPN 算法漏检的行人目标,而且对已分类出的行人目标的定位也更加准确。因此本文的自适应权值融合方法可以有效提升行人检测性能,优于其他算法。

4 结 论

本文根据自动驾驶,智能视频监控等领域对行人检测能适应全天候及各种场景变化的要求,提出了基于多模态信息融合权值学习的行人检测网络,首先分析了当前一些融合方法,融合时机存在的问题,然后介绍了本文算法提出的双流行人检测框架以及权值学习融合网络的各部分组成和工作原理,并通过实验验证本文算法的先进性。实验结果证明:相比目前采用直接堆叠的最优算法以及当前先进算法的漏检率,本文算法获得了较低的漏检率:26. 96%,基本能为行人检测提供互补的模态信息,满足行人检测自适应场景变化的需求。