基于U-net和YOLOv4的绝缘子图像分割与缺陷检测

2021-01-04唐小煜黄进波冯洁文陈锡和

唐小煜,黄进波,冯洁文,陈锡和

(广东省量子调控工程与材料重点实验室∥广东省光电检测仪器工程技术研究中心∥物理国家级实验教学示范中心∥华南师范大学物理与电信工程学院,广州 510006)

绝缘子是一种特殊的绝缘部件,实现电气绝缘和机械固定,保证输电线路的可靠运行,在架空输电线路中起到重要作用. 近年来,无人机技术已被广泛应用于电力设施及线路的巡检任务中,但由于无人机拍摄图像数目多,人工标注工作量大、效率低,且人眼的疲劳容易导致漏标或错标. 鉴于此,开展对绝缘子采集图像进行自动化识别与缺陷检测的研究具有重要意义.

在复杂背景绝缘子串的分割方面,黄新波等[1]提出基于红蓝色差和改进K-means算法的航拍绝缘子分类识别方法;刘永权等[2]提出一种结合颜色特征和形状特征的支持向量机图像处理方法,实现了对绝缘子的分割. 上述基于传统分割技术采用特征提取器结合分类器的方法,不仅识别速度较慢,而且精度较低. 梁耀等[3]针对复杂背景下的图像分割问题,利用模糊高斯混合模型和树叶图像的颜色信息提出Grab Cut算法实现自动分割,但不适合对多张独立目标的图像分割. 近年来,深度学习已被应用于图像分割领域,高金峰等[4]使用Faster R-CNN[5]模型实现对绝缘子串的语义分割,该方法提高了识别精度,但由于网络参数冗余,导致训练时间长,图像分割精度仍有待提升.

在自爆绝缘子缺陷的检测方面,陈文浩等[6]基于传统的目标检测算法,将图像RGB的颜色空间转换为LAB的颜色空间来避免光照影响,采用最大类间方差法进行阈值分割,然后进行形态学运算,通过获取绝缘子对应位置的像素值来定位绝缘子自爆点的坐标. 在深度学习方面,王梦[7]通过训练基于vgg16和Resnet-101的Faster R-CNN模型,采用基于连通区域、直线拟合、形态学图像处理方法,实现了对绝缘子定位和自爆缺陷的检测,缺陷检出率为0.89,检测精度有待提高.

进一步探究更优的绝缘子分割提取和缺陷检测方案十分必要. U-net[8]模型常被用于医学图像的语义分割,特征融合算法因而具有很高的分割精度. 而航拍绝缘子的图像与医学影像的图像特点有一定的相似性,因此U-net模型可被用于绝缘子的高精度提取. 在目标检测领域中,YOLO模型[9]因具有较高的检测速度、良好的检测精度和兼容多种硬件平台等优点而备受青睐. 航拍自爆绝缘子的实时检测对检测速度提出了很高的要求,因此,本文采用YOLOv4[10]模型实现了对自爆绝缘子缺陷的高精度自动检测.

1 基于U-net的绝缘子分割算法

1.1 U-net基本原理

基于深度学习的图像分割算法主要有2种核心框架:一种是基于卷积神经网络(CNN)特征编码对图象进行特征提取的框架;另一种是基于全卷积网络(FCN)的上采样/反卷积分割框架. 前者在卷积和池化过程中易丢失图像细节,且采用全连接层获取类别概率的方式导致不能标识每个像素类别,因此无法做到精确分割;而后者在CNN基础上把全连接层改为卷积层,在多次池化操作前加入了上采样,解决了精确分割问题,但边缘提取效果不佳.

U-net借鉴了FCN网络,该网络结构包括收缩路径和扩展路径2个对称部分:收缩路径的网络与普通卷积网络相同,使用3×3的卷积和池化下采样,得到浅层特征和深层特征,捕捉像素间的关系;扩展路径的网络则与收缩路径网络基本对称,使用3×3卷积和上采样,上采样时通过级联的方式将深层特征和浅层特征结合起来,以实现对图像中待分割部分进行精准定位的目的. 这种特征融合操作充分利用了浅层特征和深层特征,可达到更好的分割效果(图1).

图1 U-net模型框架

1.2 U-net训练和优化

1.2.1 绝缘子分割评价指标 对绝缘子串珠分割精度采用 Dice系数进行评价. Dice系数是一种集合相似度的度量函数,如果Dice接近1则说明预测结果与专业人士标注的结果相符. 计算公式如下:

(1)

其中,A为专业人士标注的区域,B为算法分割所得到的区域.

1.2.2 模型训练框架及参数设置 网络模型参数的设置影响网络的性能以及训练速度. U-net模型采用pytorch框架搭建. 参数设置:训练批量大小为4,学习率为10×10-6,网络分辨率为512×512,最大批数为50.

1.2.3 模型训练优化 实验中的绝缘子航拍图像目标小,背景复杂,边界模糊,为了获取较多的高分辨率信息,对图像进行优化调整:

(1)在每次卷积计算后进行批规范化(Batch Normalization),以避免梯度弥散,提高模型的泛化能力,使网络允许更高的学习速率从而加速收敛.

(2)采用二元交叉熵损失函数(BCEWithLogitsLoss),以提高损失数值的稳定性. 计算公式:

(2)

ln=-Wn[yn·lgσn+(1-yn)·lg(1-σn)],

(3)

其中,n为批量大小,xn为输入矩阵,yn为目标矩阵,Wn为权重矩阵,ln为损失输出值.

(3)采用RMSprop优化器,用以修正摆动幅度,提高网络函数的收敛速度.

(4)为充分利用高分辨率图像的像素信息,实验中通过滑动窗口将一张完整图像切分为若干子图,采样后将子图送入U-net模型进行预测,然后对预测的子图进行形态学滤波,最后合并子图,实现更高精度的分割(图2).

图2 绝缘子串珠分割的流程图

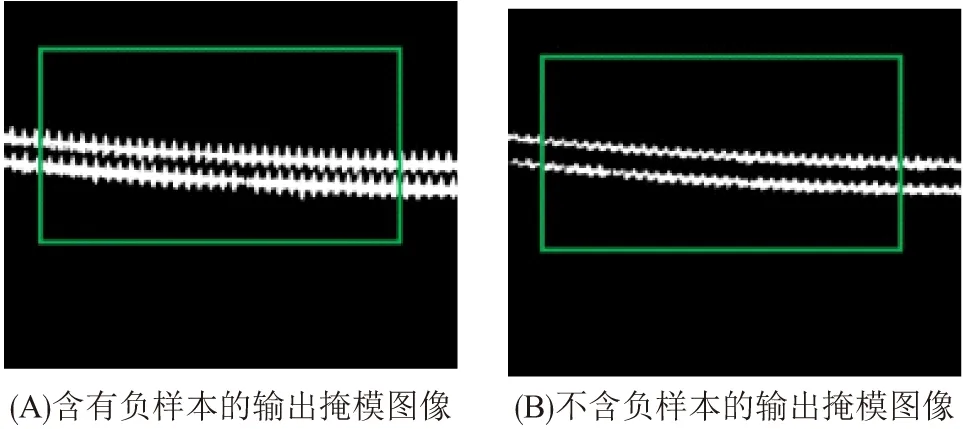

1.2.4 “过拟合”问题的改进 (1)对输入图像进行归一化处理,即利用图像的不变矩阵寻找一组参数,使其能够消除其他函数对图像变换的影响,转换成唯一的标准形式以抵抗仿射变换,归纳统一样本的统计分布性. (2)在神经网络中添加丢弃机制(dropout),dropout是指在网络训练期间根据一定的概率将神经单元暂时从网络中失活. 实验发现,当dropout 概率等于0.5时的拟合效果最好. (3)为数据集增加负样本,其作用是提高模型的纠错能力,将引入负样本和不含负样本的数据集分别送入模型训练. 测试集输出结果(图3)表明:在引入负样本后的模型在测试集中表现良好,但不含负样本的模型在测试集中表现不佳,出现“过拟合”问题.

图3 不同数据集的分割结果

2 基于YOLOv4的绝缘子缺陷检测

2.1 YOLOv4基本原理

基于深度学习的目标检测算法分为两大类:一类是two-stage检测算法(R-CNN);另一类是one-stage检测算法(YOLO系列). 前者在检测精度上占优势,后者则在检测速度上占优势. YOLO的核心思想是将目标检测视为单一的回归问题,直接在输出层回归边框坐标和所属类别. 将输入图像统一成448 px×448 px的尺寸后送入CNN网络进行特征提取和目标预测. 另外,以往的目标检测多采用滑动窗口技术,将图像目标检测问题转化为图像分类问题,缺点是窗口尺寸不一致且数量大,运算量庞大. 而YOLO则将输入图像分成S×S个网格,每个网格用于预测物体中心落入该网格的物体,该做法大大减少了模型的运算量,进一步提高模型的检测速度.

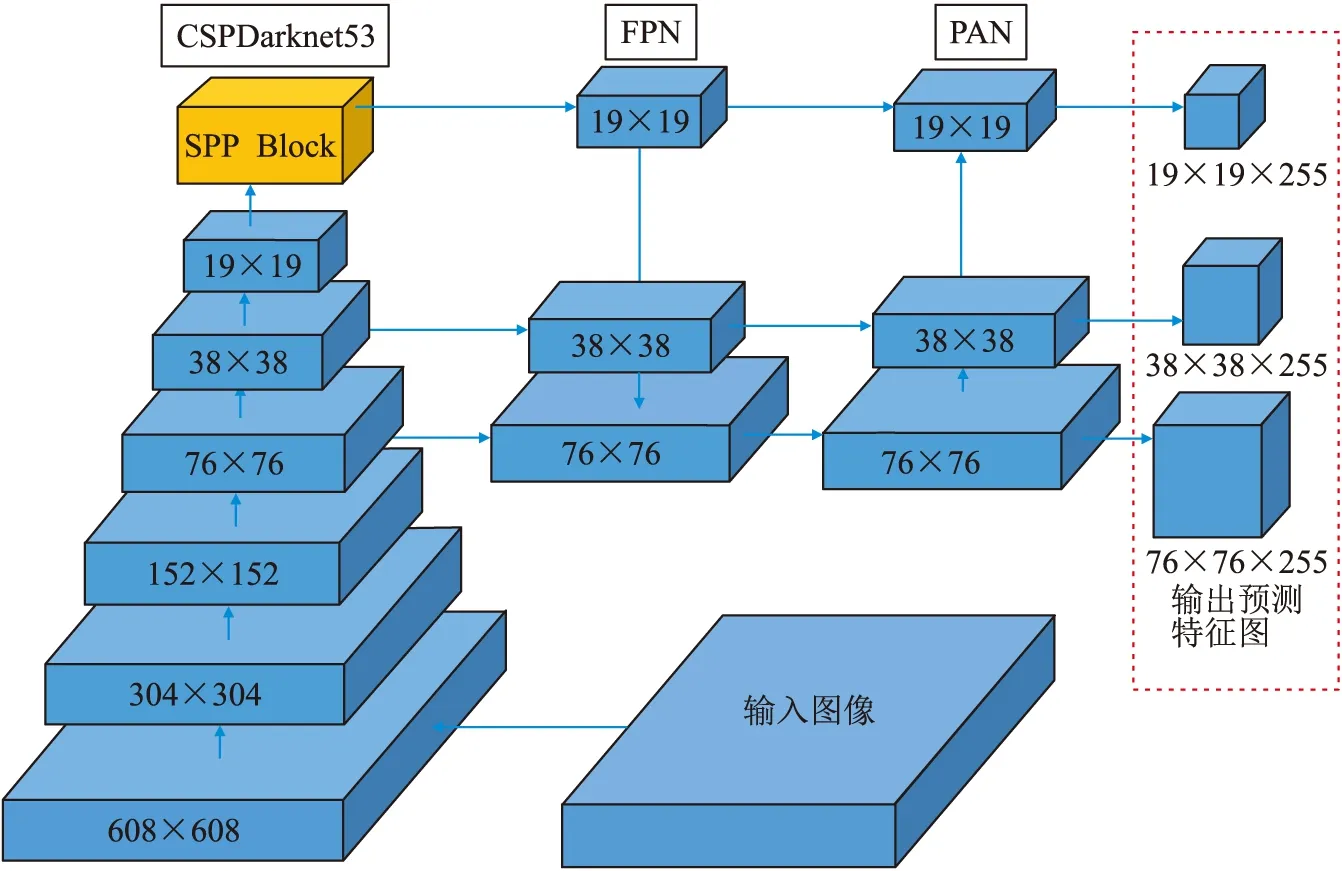

YOLOv4相较YOLO以往版本更新了众多改进方法(图4),其骨干网络采用CSPDarknet53[11],并在CSPDarknet53上增加了深卷积网络的空间金字塔池(SPP)块[12],共包含72个卷积层和1个全连接层,采用3×3卷积核. 针对不同级别的检测器,挑选PAN[13]作为对不同骨干层进行参数聚合的方法,并将PAN快捷连接的相加改为串联. 优化方法还包括马赛克数据增强、提出了自对抗训练,即让神经网络反向更新图像,对图像进行改变扰动后继续训练、采用Mish激活函数和优化损失函数等操作,使其在目标检测中具有更好的表现能力.

图4 YOLOv4 框架

2.2 YOLOv4训练和检测

2.2.1 绝缘子缺陷检测评价指标 采用平均重叠度IOU 评价模型预测边界框的精度. IOU的意义是候选框C与原标记框G的重叠度,IOU越接近1表示预测结果越接近正确结果. 计算公式:

(4)

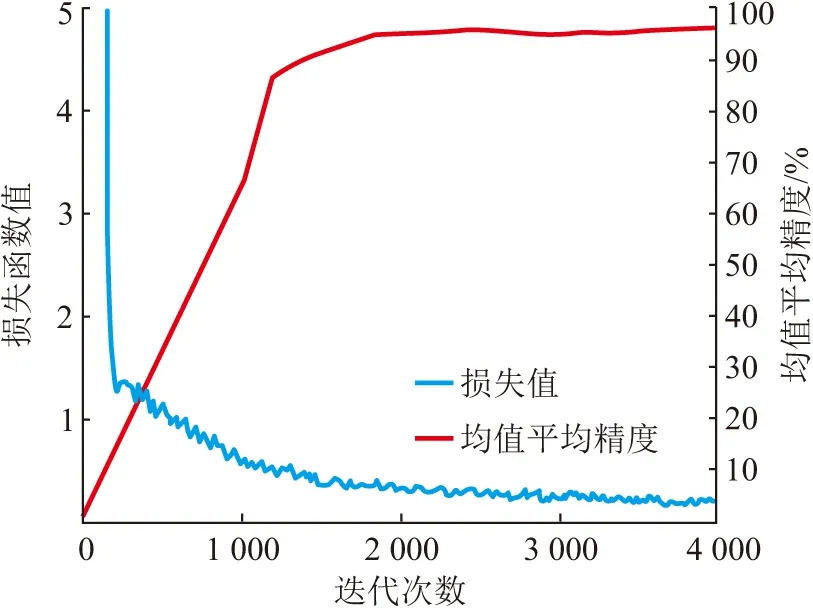

2.2.2 模型训练及参数设置 YOLOv4模型采用基于darknet框架. 本文训练均使用GPU为NVIDIA GTX 1080Ti,CPU为Intel i7-7800X,内存为16 G的硬件环境. 训练参数设置如下:训练批尺寸为64,学习率为10×10-3,最大迭代次数为4 000. 选取分辨率864 px×864 px的训练网络. 同时在训练时引入与正样本相当的负样本,一定程度提高了模型的鲁棒性,训练过程如图5所示.

图5 训练过程损失值和均值平均精度曲线

均值平均精度(Mean Average Precision,MAP)是目标检测领域的一个重要衡量指标,表示对目标检测中每个类别的平均精确率求和后再取平均. 结果表明:采用YOLW4模型可使数据集的训练损失迅速收敛,map达到较高水平.

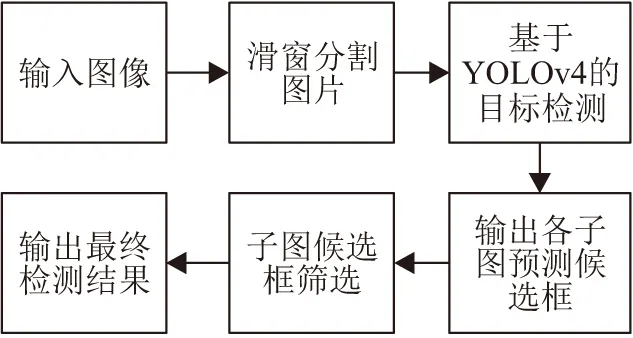

2.2.3 检测优化 针对无人机航拍的绝缘子图像分辨率高、背景复杂、目标小等特点,本文提出“切分-识别-合成”检测方案(图6),以解决预测图像直接输入YOLOv4模型时被严重压缩的问题,以及特征提取效果不理想导致目标检测精度低的问题. 选择适合模型检测的滑窗尺寸,对高分辨图像进行切分操作,滑窗移动步长为窗口边长的一半,即相邻滑窗重叠率(Overlap Rate)为0.5,确保特征出现在切割边缘时,缺陷绝缘子能在某个邻接滑窗被完整保留,从而避免因切割被破坏而无法识别的情况. 将切分的子图分别送入模型进行检测,可识别自爆绝缘子区域,并获得对应的预测边界框坐标. 通过保留置信度在0.8以上的边界框,对每个子图预测的结果进行筛选,再根据预测边界框的相对位置、大小等信息,

图6 绝缘子缺陷检测流程图

对边界框回归和坐标修正,剔除属于同一缺陷绝缘子的重复边界框,保留最优预测结果,将结果边界框标记在原图中.

3 实验结果分析

3.1 数据集处理结果

本文数据来源于第八届泰迪杯全国大学生数据挖掘挑战赛,由广州智能装备研究院有限公司提供(https:∥www.tipdm.org/bdrace/tzbstysj/20200228/1637.html). 数据包含无人机航拍原图、对应的绝缘子掩模图和绝缘子自爆标签. 对源数据进行如下操作,以获取训练样本.

(1)对源数据集进行2次不同尺度的滑窗切分,切分示意图如图7所示. 滑动窗口大小分别为1 024 px×1 024 px与2 048 px×2 048 px,相邻滑窗重叠率为0.5. 一方面扩充数据集,另一方面在训练时充分利用图像的像素信息.

图7 滑动窗口切分示意图

(2)对切分后的掩模图进行连通域计算,对切分后的绝缘子自爆标签进行自爆区边界完整性的检测,剔除因滑窗切割而导致绝缘子自爆区域结构破坏的图像,同时将筛选后的切割图像、掩模图和绝缘子自爆标签对应保存.

(3)将上述得到的切割图像、掩模图和绝缘子自爆标签,对图像进行随机缩放、平移、翻折、旋转以及亮度调节等基本变换,进行数据的增强、数据集的扩充操作.

(4)对增强后的图像进行正样本和负样本数量的均衡操作,将得到的照片划分为训练集、验证集和测试集.

通过数据分析和处理,累计获得了总计4 337的样本数据,将其用于绝缘子的语义分割训练,其中包含2 311个正样本(包含绝缘子区域的图像)和2 026个负样本(不包含绝缘子区域的图像);获得总计4 296的样本数据,将其用于绝缘子的自爆缺陷识别,其中包含2 372个正样本和1 924个负样本.

3.2 优化U-net的绝缘子分割结果

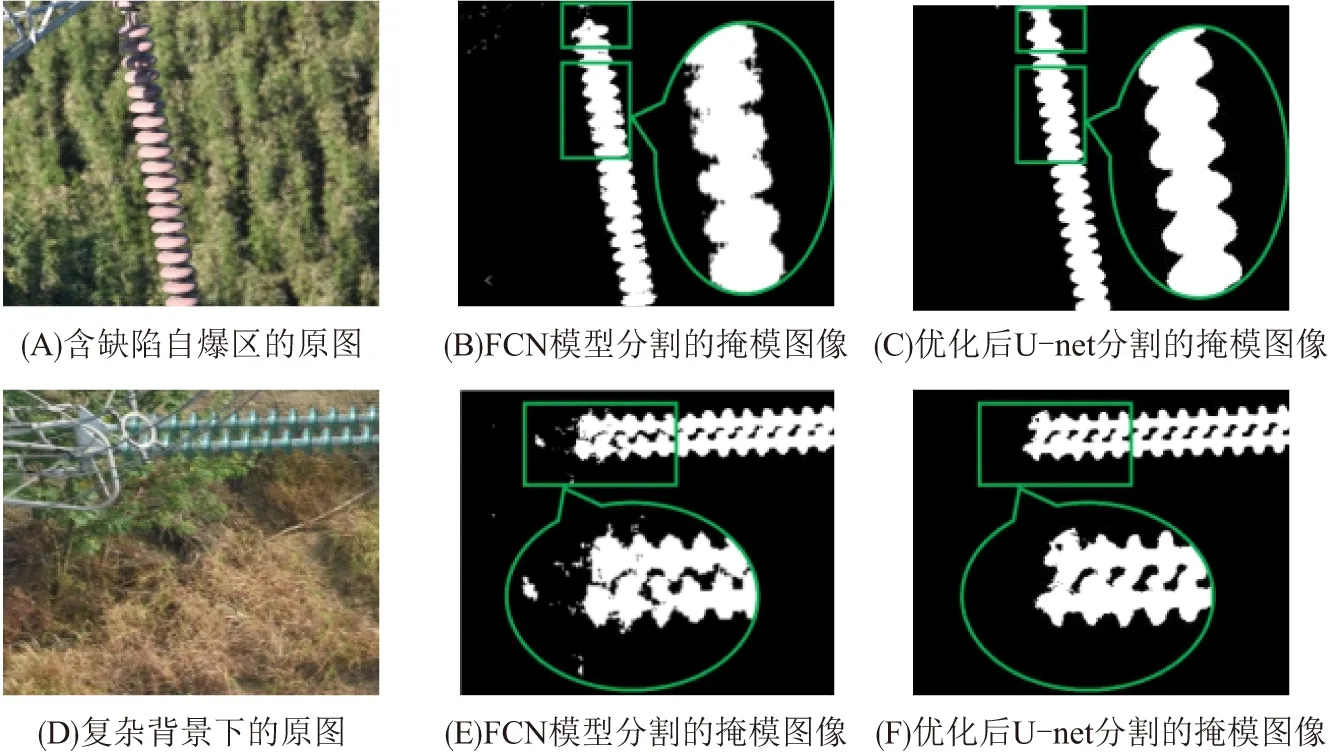

在基本模型训练参数相同的情况下,模型优化前和优化后训练过程如图8所示. 经算法改进和增强后,数据集训练损失曲线震荡减轻并得到较好的收敛. 为评估优化后U-net模型的性能,本文在包含缺陷自爆区和复杂场景的图像中,将FCN模型与优化后的U-net模型实验结果进行对比(表1),得到两者的分割结果(图9).

当缺陷区域背景较复杂、光线较暗时,FCN对绝缘子区域不能较好响应,而U-net能精确地完成分割;当图像出现复杂的前景与背景时,U-net能较好地完成对绝缘子的分割,而FCN模型对复杂区域的边界分割结果较差. 与FCN模型的性能相比,U-net模型能较好地应对不同环境(光线、复杂的前景与背景),具有较强的泛化能力.

图8 训练损失曲线与测试Dice系数曲线

表1 FCN和优化后U-net的效果对比Table 1 The comparison of results between the FCN model and the optimized U-net model

图9 FCN模型与优化后U-net模型的分割效果对比

3.3 优化YOLOv4的绝缘子缺陷检测结果

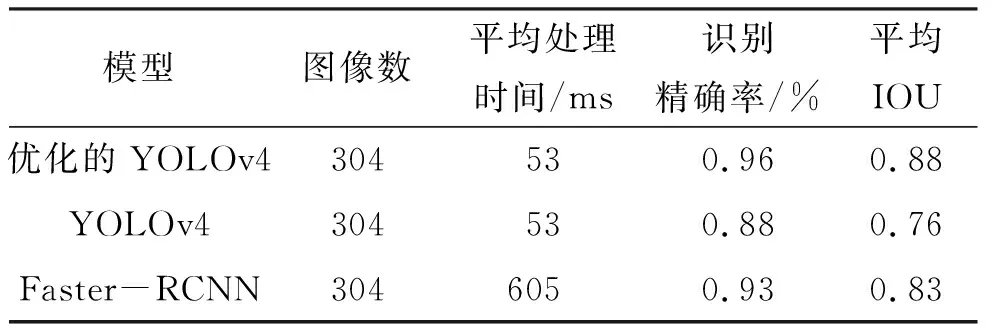

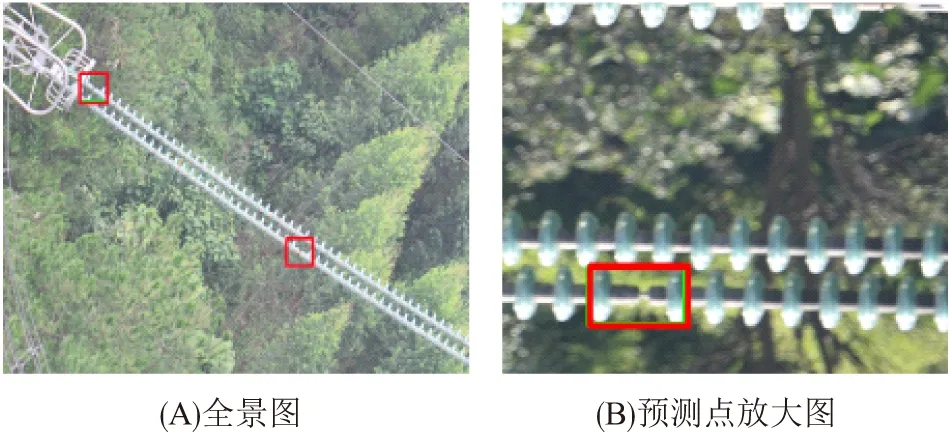

为验证优化后YOLOv4的有效性,将其与优化前的YOLOv4和Faster-RCNN进行对比(表2). 复杂背景下YOLOv4部分检测效果如图10所示,红色框为预测结果,绿色框为正确结果.

表2 检测优化前后的性能

图10 优化后测试的效果图

从表2的识别准确率和平均IOU可见,经过检测优化后的YOLOv4在识别精度上大幅提升,且检测速度远远快于Faster-RCNN;检测优化后的YOLOv4也能很好应对复杂背景的绝缘子图像的检测(图10),进一步验证了本文模型的可靠性与实用性.

4 结论

针对高分辨率航拍图像中绝缘子的分割提取和自爆缺陷检测的问题,提出了基于深度学习模型的解决方案. 该方案包括:(1)采用优化后的基于U-net模型获取绝缘子区域掩模图像,实现绝缘子的识别与提取;(2)构建基于YOLOv4模型获取缺陷绝缘子的位置信息,实现自爆绝缘子的检测. 结果表明:本方案识别精度和模型鲁棒性良好,采用第八届泰迪杯全国大学生数据挖掘挑战赛的测试数据集验证,本模型具有可靠性和实用性. 该成果获得了2020年第八届泰迪杯数据挖掘挑战赛全国一等奖. 该方案对实现电力系统运维的智能化、保证电力系统的安全和稳定提供了参考,具有较高的应用价值.